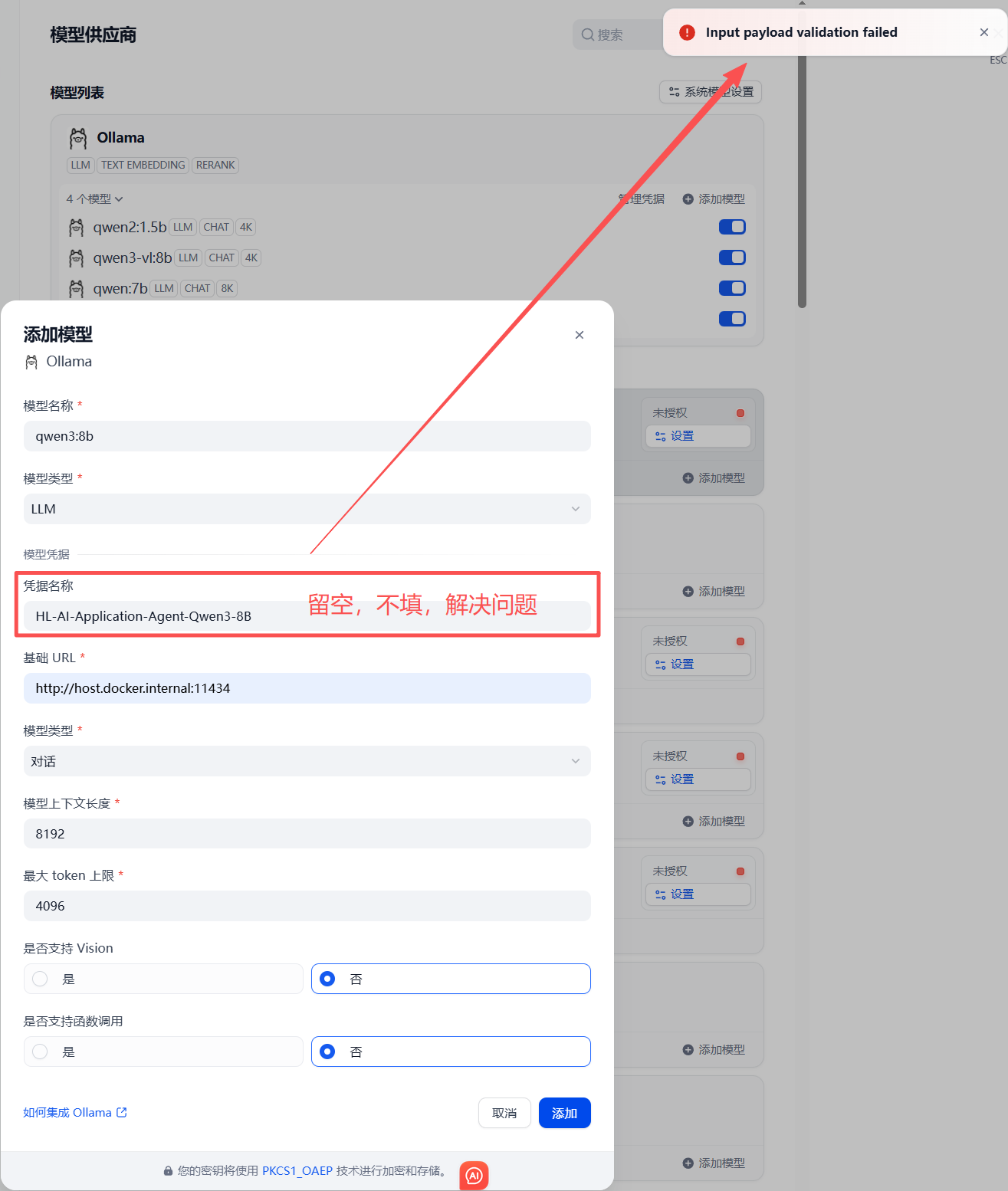

在Dify配置Ollama的qwen3:8b时出现「Input payload validation failed」,是因为当前表单中**「凭据名称」和「模型类型」的配置不符合Ollama的接入规则**。

症状截图如下:

以下是问题定位和修正步骤。

问题原因

- 「凭据名称」无需填写:Ollama本身不需要额外凭据(它是无密钥的本地服务),你填写的「HL-AI-Application-Agent-Qwen3-8b」属于无效配置,触发了参数校验;

- 「模型上下文长度」不匹配:qwen3:8b的默认上下文窗口是32768(不是4096),参数填错也会导致校验失败。

修正后的完整配置(直接按此填写)

| 配置项 | 正确填写内容 |

|---|---|

| 模型名称 | qwen3:8b(和Ollama中运行的模型名完全一致) |

| 模型类型 | LLM(保持不变) |

| 模型凭据 → 凭据名称 | 清空该输入框(留空)(Ollama不需要凭据) |

| 基础URL | http://host.docker.internal:11434(保持不变,确保Ollama服务在本地启动) |

| 模型类型(下方的下拉框) | 对话(保持不变) |

| 模型上下文长度 | 32768(qwen3:8b的默认上下文窗口) |

| 最大token上限 | 2048(建议值,可根据需求调整,不超过32768) |

| 是否支持Vision | 否(保持不变) |

| 是否支持函数调用 | 否(保持不变) |

操作步骤

- 清空「凭据名称」输入框(删除现有内容);

- 将「模型上下文长度」从

4096改为32768; - 点击「添加」按钮,即可通过参数校验。

额外检查

如果修改后仍报错,需确认:

- Ollama服务已正常启动(执行

ollama ps能看到qwen3:8b处于运行状态); - Docker中Dify容器能访问

host.docker.internal:11434(可进入Dify容器执行curl http://host.docker.internal:11434/v1/models,返回模型列表则网络正常)。

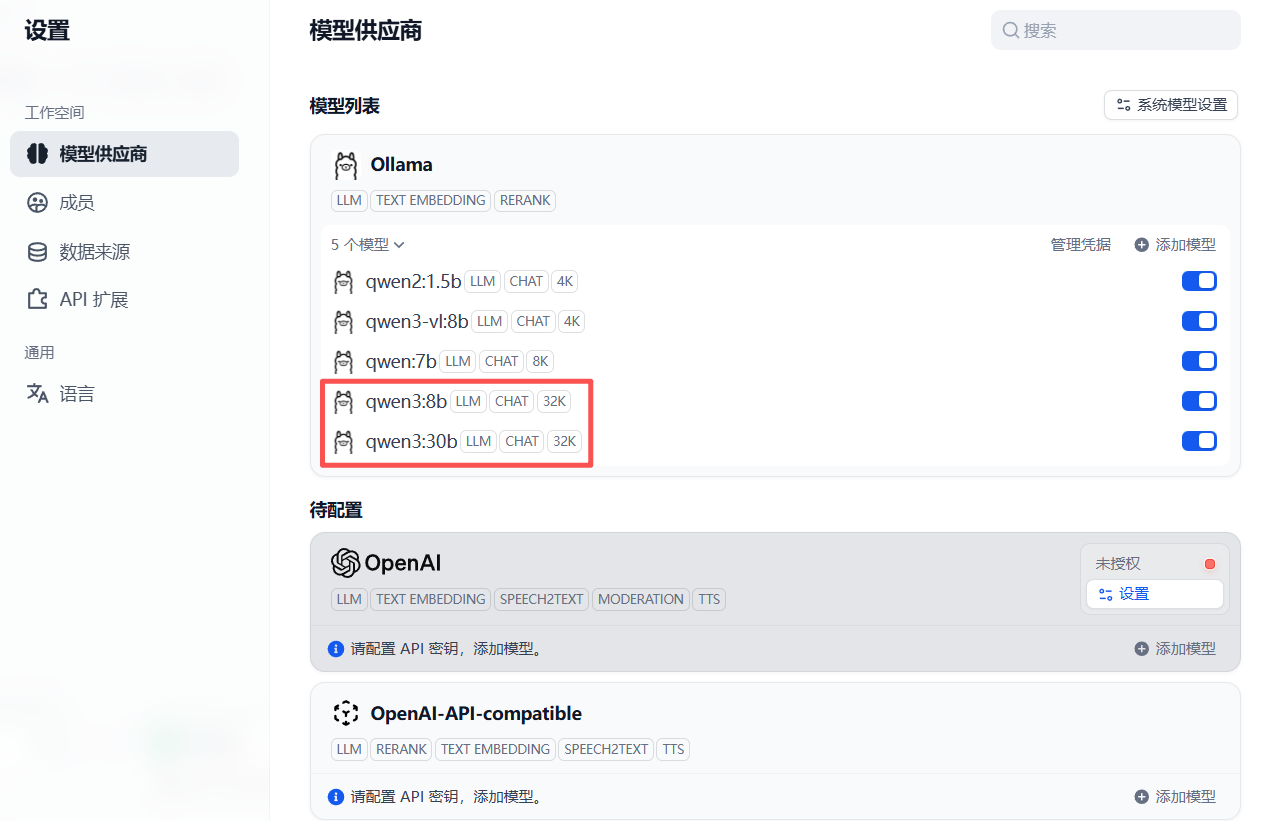

Dify中配置的模型如下