元旦假期刚过就看到了 Claude Code 作者发布的 13 条技巧,但是最近实在太忙,没来得及仔细学习。

昨天和朋友聊到这个,才再次想起。

由于最近一段时间 Claude Code 的使用没有像 TRAE 和 Cursor 那么多,今天就结合我的经验,和大家聊聊我对这 13 条技巧的的理解和实践。

终端多开并行

原文思路

在终端并行运行 5 个 Claude 实例,为每个标签页编号(1-5),利用系统通知功能提醒需要人工输入的任务,提高多任务处理效率。

理解/实践

现在各个 AI IDE 几乎都支持了多 Agent 并行的特性,这个特性对效率的提升并不是30%、40%这样增加的,而是随着 Agent 的启动成倍增加,这应该也是自动化的根本意义(我认为 AI 本身就是一种高级的自动化)。

在还没有该特性的时候,我和很多伙伴都是通过 IDE 多开 、多 IDE 切换实现并行开发的效果,不过,终究不如现在这样高效。

多端无缝联动

原文思路

结合网页端(5-10个会话)与移动端(如iOS应用)并行协作,使用--teleport命令在不同设备间同步会话进度,实现跨平台无缝衔接。

理解/实践

针对可以运行长任务的模型,多端切换确实非常有效。

你可以在外出、休息的时候掌控开发任务的进度,或者进行新的开发任务的启动。

由于 AI IDE 的界面特性,一直没有实践过,后续可以尝试通过 VS 插件 结合 APP 的模式试试。

优选思考模型

原文思路

使用带有"思考过程(thinking)"的 Opus 4.5 模型,尽管速度较慢,但更智能、更擅长调用工具,能减少人工引导,提高执行效率。

理解/实践

这个说实话,个人最近已经很少注意了,毕竟现在的几个主流 Coding 模型应该都是"思考"模型。

团队共用规范

原文思路

维护一个团队共享的 claude.md 文件,记录项目规范、编码习惯和 Claude 的错误案例,定期更新并提交到 Git 仓库,避免重复犯错。

理解/实践

这一点非常有用,不仅限于统一团队代码生成的规范。更是可以通过大家的写作,更快、更全面地整理出一套完善的 claude.md。

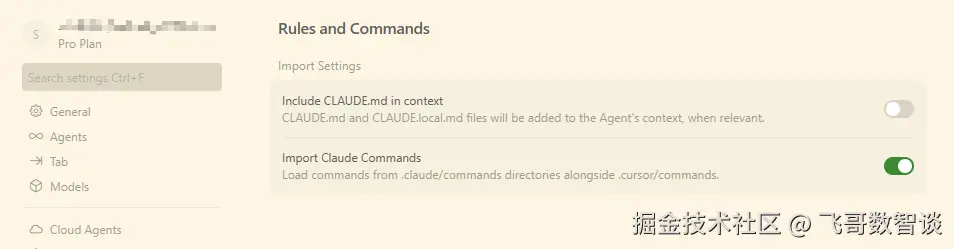

Cursor 是直接支持识别 claude.md,国内的其它 IDE 估计也很快会支持,毕竟 claude.md 几乎已经快要成为一个默认的标准了。

审查即刻更新

原文思路

在代码审查(PR)过程中,通过 @.claude 指令将新发现的规则或规范自动添加到 claude.md,利用 Claude Code 的 GitHub Action 实现自动化更新。

理解/实践

国外他们普遍接受 Github 方式开发,所以,Claude Code 有开发专门的 Github 应用,可以直接在 Issue 和 PR 阶段调用 Claude。

但据我了解,国内目前没有现成的方案。

Claude Code 和私有仓库,还可以借助 Git Hook 和 Claude Agent SDK 自行开发,AI IDE 的话,确实比较麻烦。

先谋而后动

原文思路

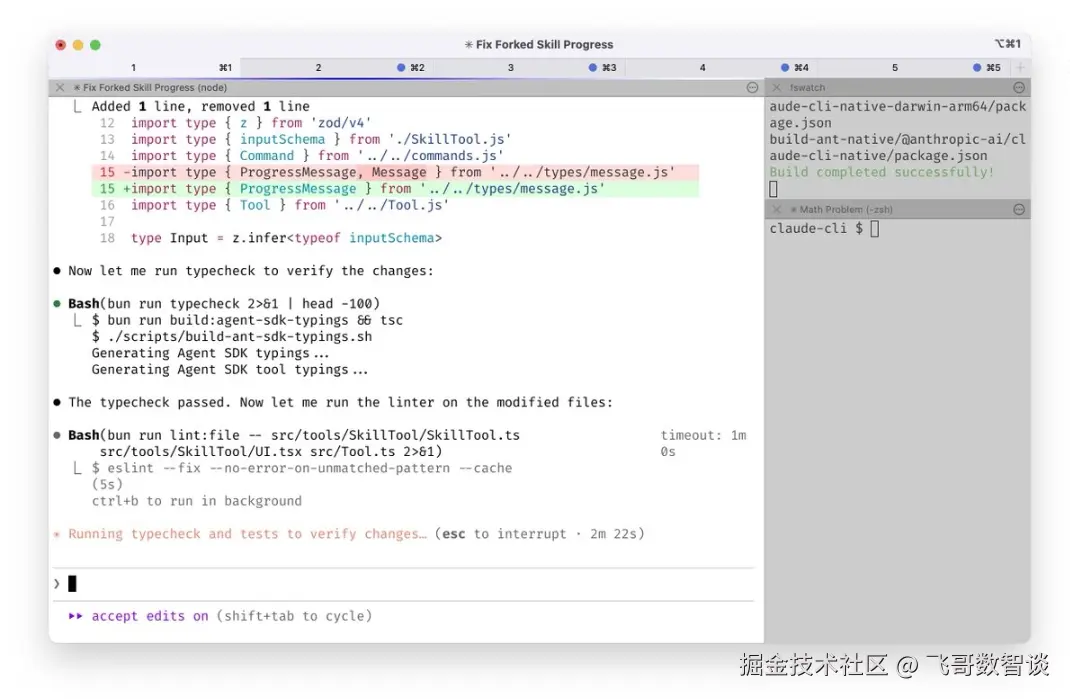

任务开始前先启用"计划模式(Plan Mode)"(双击 Shift+Tab),与 Claude 沟通确认方案,满意后再切换到"自动接受修改模式"执行,降低试错成本。

理解/实践

这个之前聊过很多次,甚至在没有 Plan 模式时,我就在分享参考"费曼学习法"让 AI 先复述一遍会大大提升回答质量。

其实本质都是让 AI 和你的思维对齐,因为同样的文字可能在你和 AI 的理解中是不一样的,只有 AI 再次返回一致,才证明你们理解同步了。

现在 Cursor/TRAE 等各类 AI IDE 都支持了 Plan 模式,大家直接使用即可。

下面 3 个技巧(高频操作指令化、部署专用子智能体、自动格式化 )在我的理解中,应该是同样的目的,都是自动化提高效率,不管是指令 方式、子智能体 方式,还是钩子方式。

高频操作指令化

原文思路

将每天重复的内循环工作流(如提交代码、合并分支等)封装为斜杠命令(Slash Commands),存放在.claude/commands/目录并提交到Git,减少重复输入。

理解/实践

Cursor 是直接支持 Claude 指令的,设置中勾选即可。

TRAE 暂时尚未支持该类特性,但是可以通过创建智能体模拟。

部署专用子智能体

原文思路

使用特定功能的子智能体(Subagents),如 code-simplifier 简化代码、verify-app 进行端到端测试,自动化常见流程。

理解/实践

现在 AI IDE 已经普遍支持自定义智能体了。

尤其是 TRAE 的智能体还支持 Claude Code 主智能体自动调用子智能体的特性,挺好用的。

自动格式化

原文思路

使用 PostToolUse 钩子自动修正 Claude 生成代码的格式细节,避免在持续集成(CI)中因格式问题报错。

理解/实践

格式不规整虽然不影响 AI 阅读,但现在的 AI 尚未达到生成质量100%接受的程度,因此良好的格式化还是非常有利于我们 CR 和接手的。

AI IDE 都是 VS Code 系的架构,可以借助各类语言的格式化插件进行替代实现。

权限精细化管理

原文思路

通过/permissions命令预先批准安全的Bash命令白名单,配置保存在.claude/settings.json中,团队共享,平衡安全与操作流畅度。

理解/实践

权限管理很重要,Cursor/TRAE 都提供了自定义 Auto Run 的功能。

根据自己的情况,把一些常用但不危险的命令加入白名单,将大大降低你被 AI 通知打断的频率。

下面 3 个技巧(全工具链集成 、长任务无人值守 、构建验证闭环)我感觉又是一组的,并且还是层层递进的。

全工具链集成

原文思路

通过MCP服务器集成 Slack、BigQuery、Sentry 等外部工具,让 Claude 能跨平台操作(如搜索 Slack 消息、运行 BigQuery 查询、抓取错误日志)。

理解/实践

工具链打通肯定是大家所期望的,谁都不喜欢在一个工具中干的好好时,需要 Alt+Tab 切换工具。

而这也是后面 2 个技巧的基础:工具集成的越多,AI 任务被中断的可能就会越少。

最近几年,国内越来越多的生态提供了 API 接口,再加上今年的 MCP,越来越多的工具已经可以被 AI 接入。

长任务无人值守

原文思路

对于长时间运行的任务,采用后台验证、stop钩子或 Ralph-Wiggum 插件进行自动化验证,配合沙箱模式或 --permission-mode=dontask 避免权限中断。

理解/实践

这一点也是我们团队目前一直在努力的方向:

通过各种工程化手段,逐步提升 AI Coding 任务的长度和复杂度,帮我们节省出更加大块的时间,可以做更多其他的事情。

此处 AI Coding 任务并不是一次 AI 对话,而是通过 Agent 架构自行实现目标分解、工具调用、多轮 AI 请求的一个完整目标完成过程。

构建验证闭环

原文思路

为Claude提供明确的验证方法(如运行测试脚本、打开浏览器测试UI),通过反馈闭环提升最终结果质量,这是提高产出质量的关键技巧。

理解/实践

如果说"长任务无人值守"是 AI Coding 的期望目标的话,"构件验证闭环"就是实现这个目标的保证。

毕竟,长任务执行后,结果不好,那一切都免谈。

因此,建立一个良好的验证方法,可以大大降低任务返工的几率。

这 13 条技巧整体上还是非常明晰且有效的,大家可以结合自己的情况进行尝试。

如果你对这 13 条技巧有什么不同的理解或疑问,欢迎留言讨论!