Rust + Wasm + AI (一):开启浏览器与边缘端的高性能推理时代

AI 只能跑在云端显卡阵列上?Python 是部署的唯一选择? 本系列连载将带你用 Rust + Wasm 彻底打破这些认知。第一篇,我们将从工程视角深度剖析 AI 部署的"范式转换",并亲手验证 Rust 在浏览器端的惊人算力。

1. 引言:从"中心化 AI"到 "泛在智能"

无需联网推理,无需云端显卡。那个爆火的 Web Stable Diffusion Demo 证明:借助 Wasm + WebGPU,浏览器完全可以脱离云端服务器,100% 在用户本地完成大模型的推理任务。这种算力民主化的尝试,开启了一个全新的泛在智能时代。

AI 不再是云端机房中昂贵显卡阵列的专利。当模型需要嵌入浏览器插件中、跑在智能门锁的 ARM 芯片上、驱动无人机进行实时避障,甚至是部署在工厂车间那台灰尘仆仆的工业网关中时,传统的 "Python + Docker + CUDA" 部署模式,正面临前所未有的挑战。

- 安全困境: 如何在不可信的第三方环境(如用户的浏览器或客户的私有服务器)中安全运行 AI ?一个恶意的

.pth模型文件或 Python 脚本,可能就是入侵系统的特洛伊木马。 - 碎片化地狱: 面对 x86、ARM 甚至 RISC-V 等高度碎片化的硬件架构,如果为每个平台都维护一套推理引擎,研发成本将是灾难性的。

- 效率悖论: 在传统模式下,Docker 镜像动辄数 GB,秒级的冷启动已是性能天花板。但在自动驾驶避障、工业机器人协作等 毫秒必争 的场景里,哪怕微小延迟都关乎成败。

结论呼之欲出: AI 部署需要一种全新的"载体"------它既要像 Docker 一样隔离安全,又要像原生代码一样毫秒级响应,更要能无视芯片架构 "一次构建,到处运行" 。

这个载体,就是 WebAssembly (Wasm)。

如今的 Wasm 早已不再局限于浏览器,它正在演进为 AI 能力的 通用标准容器 ,甚至催生出一种被称为 通用微服务架构 (UMA) 的全新形态,让 AI 能力像水和电一样,在云、边、端之间自由流动。

2. 横向评测:AI 部署的三大方案

在边缘计算的十字路口,为什么 Wasm 能脱颖而出?直接看数据:

| 维度 | Docker 容器 | 原生二进制 | WebAssembly (Wasm) |

|---|---|---|---|

| 冷启动 | 秒级 🐢 | 毫秒级 🐇 | 微秒级 ⚡️ (快100倍+) |

| 体积 | 数GB 😰 | MB级 😐 | KB/MB级 😎 (缩小10-100倍) |

| 安全性 | OS级隔离 | 依赖系统权限 | 指令级沙箱 (规避 70% 内存漏洞) |

| 跨平台 | 多架构镜像地狱 | 重复编译噩梦 | 一次编译,到处运行 (维护成本明显降低) |

| 分发难度 | 依赖Docker运行时 | 动态库依赖复杂 | URL即分发 (秒级部署) |

3. 核心支柱一:安全沙箱 (Security by Default)

传统 AI 部署的安全防线,就像用篱笆围住一头大象------看似有边界,实则漏洞百出。

"信任" 是最大的漏洞: 运行一个 Python 脚本或加载一个 .pth 模型,本质上是在拿系统权限做赌注。正如我们担心的,恶意模型可以通过 Pickle 反序列化漏洞,在被加载的一瞬间就接管你的系统。

而 Wasm 采用了 基于能力的安全性(Capability-based security) 模型,彻底终结了盲目信任:

- 线性内存模型:Wasm 模块被限制在特定的内存区域,无法窥探宿主机的任何隐私,任何越界访问都会被虚拟机直接"熔断"。

- 显式能力授予:文件读写、网络请求、摄像头调用......,所有权限必须由宿主显式授予,默认情况下啥也干不了。

- 指令级验证:在模块加载时,虚拟机会扫描所有代码指令,确保没有非法跳转或针对底层硬件的恶意注入。

4. 核心支柱二:极致跨平台 (Write Once, Infer Anywhere)

"这段代码在我电脑上能跑啊!" ------ 这可能是 AI 工程师最头疼的魔咒。

传统的 AI 部署方案通常需要你针对不同的 CPU 架构(x86、ARM、RISC-V)构建并维护多套臃肿的 Docker 镜像。而 Wasm 的方案优雅得像一首诗:

bash

# 1. 一次构建:编译为架构无关的二进制格式

cargo build --target wasm32-wasip1

# 2. 到处运行:在浏览器、边缘网关或云端即刻部署

wasmtime run model.wasm从代码移植到能力组件化

Wasm 充当了高级语言与机器硬件之间的通用中间层(IR)。它并不关心你是 Intel 的 AVX-512 指令集,还是 Apple Silicon 的 NEON 加速器,这些复杂的底层优化都由宿主环境的 JIT(即时编译器)按需处理。

更具颠覆性的是 Wasm Component Model (组件模型) 。它让我们可以将 AI 流程拆解为独立的乐高积木:

- 组件 A: Rust 编写的视频流预处理

- 组件 B: C++ 编译的模型推理核心

- 组件 C: Go 编写的结果后处理

借助这套标准,不同语言编写的 AI 逻辑可以无缝"粘合"在一个标准的 .wasm 文件中,彻底终结了 .so 或 .dll 动态库丢失带来的版本灾难。

分发优势

AI 模型不再是一堆碎片化的二进制文件,而是一个标准化的便携能力模块。无论是在 5G 基站还是浏览器插件中,它都能提供语义完全一致的执行结果。

5. 核心支柱三:边缘侧推理的必然性 (Edge AI)

当 ChatGPT 的回答延迟增加 2 秒时,用户可能只是皱眉;但当自动驾驶汽车的识别延迟增加 100 毫秒,可能就是生死之别。

在边缘计算的版图里,Wasm 正在重新定义"微服务"------它将笨重的容器精简为轻量级的 AI 能力 (AI Capabilities):

- 低延迟是硬指标:在机器人避障、工业质检、实时翻译等"毫秒必争"的场景,网络抖动是不可接受的灾难。Wasm 凭借微秒级启动和接近原生的执行性能,让端侧实时推理从理想照进现实。

- 隐私保护是信任底线:医疗影像、金融文档、人脸数据......这些敏感数据理应在端侧产生、端侧消费。Wasm 的沙箱确保数据被封锁在本地,连模型提供者都无法窥探。

- 计算离线化是生存需求:在地下车库、远洋船舶或野外矿区,Wasm 承载的 AI 模型能够像单机软件一样稳定。它不需要持续的云端连接,彻底终结了"没网就变砖"的尴尬。

统一硬件访问 :借助 WASI-NN 标准,Wasm 抹平了硬件加速的差异。无论底层是 NVIDIA GPU、Intel NPU 还是 Apple M 系列芯片,开发者只需一套代码,即可调用各异的算力源。

6. Rust:驱动 Wasm AI 的黄金引擎

在 AI 部署领域,为什么 Rust 能够击败 Python 或 Go,成为 Wasm 的首选?

- 零成本抽象,极致性能:Rust 生成的 Wasm 体积极小,没有 Python/Go 的垃圾回收(GC)包袱。一个向量计算模块编译后仅 15KB,执行效率达原生 C++ 的 95% 以上,完美契合边缘设备苛刻要求。

- 内存安全,稳定可靠:在智能门锁、工业网关等资源受限场景,内存泄漏 = 事故。Rust 编译期消除 70% 以上底层安全隐患,避免段错误导致的灾难。

- 多语言协作 + 生态对齐:用 Rust 编写高性能 AI 核心编译为 Wasm,可被 JavaScript 前端、Python 后端无缝调用,实现最佳技术栈组合。顶尖运行时(WasmEdge、Wasmer)和 AI 框架(Candle、Burn)均首选 Rust。

最新趋势: 据统计,超过 60% 的新兴 AI 工具正在转向 Wasm-native 架构,而其中 78% 的开发者选择了 Rust。

rust

// 只需几行,就能开启你的高性能 Wasm AI 之路

#[wasm_bindgen]

pub fn fast_cosine_similarity(a: &[f32], b: &[f32]) -> f32 {

// Rust 的迭代器会被 LLVM 自动优化为高效的向量化指令

a.iter().zip(b).map(|(x, y)| x * y).sum()

}Rust 让开发者无需成为底层系统专家,也能写出高效、安全、可移植的 Wasm 模块。 它不仅是生产力工具,更是 AI 部署时代的质量保证。

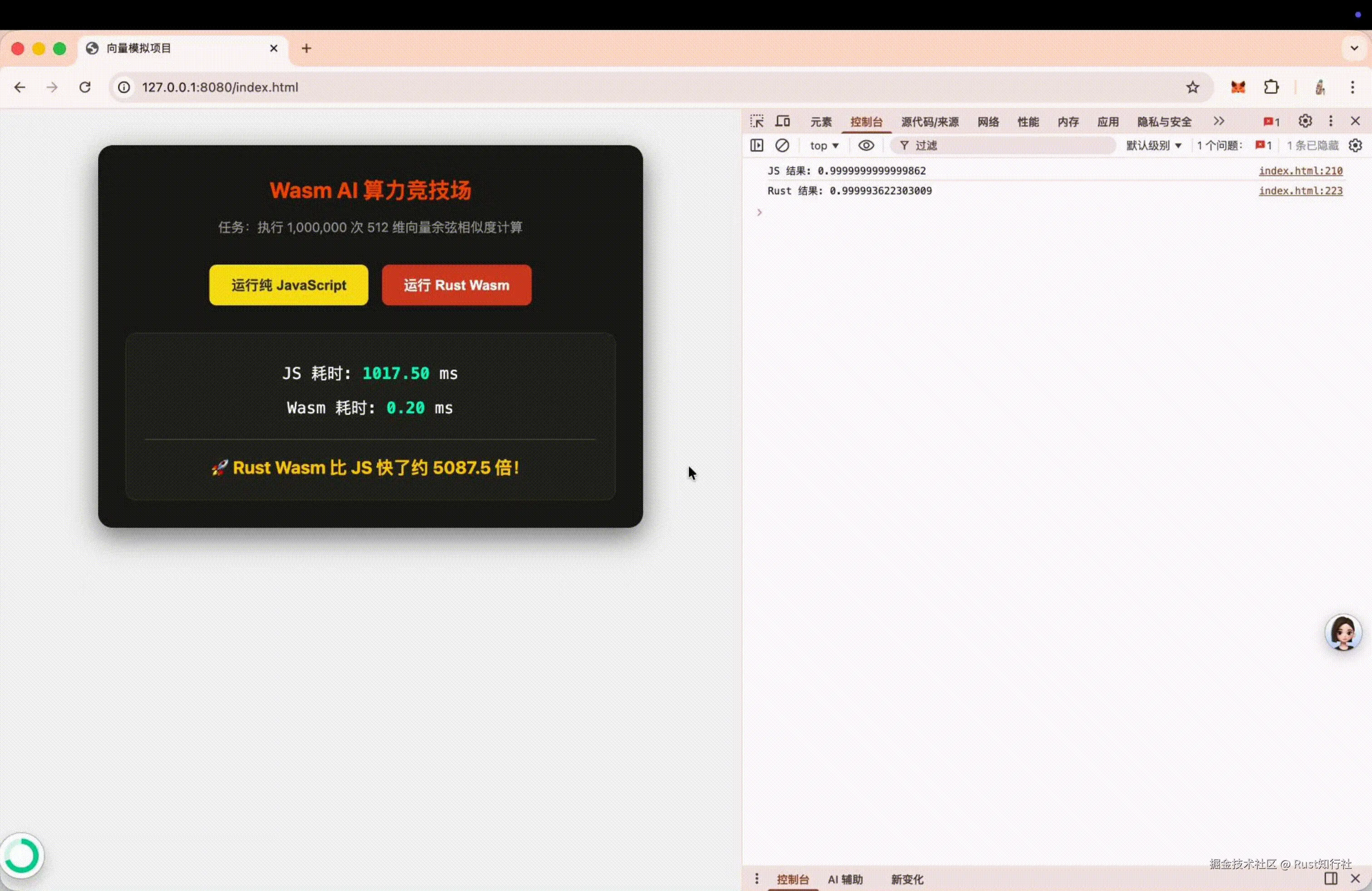

7. 快速上手:感受"触手可及"的算力

Talk is cheap. 我们来点实际的。

我们将对比 JavaScript 和 Rust (Wasm) 在执行 AI 核心算法------向量余弦相似度 (Cosine Similarity) 时的性能。这是 RAG(检索增强生成)和推荐系统中调用最频繁的计算。

Rust 侧:极致精简

ini

// lib.rs

use wasm_bindgen::prelude::*;

/// 计算两个 512 维向量的余弦相似度

/// 模拟 CLIP 等模型在 AI 检索时的核心计算任务

#[wasm_bindgen]

pub fn cosine_similarity_rust(vec_a: &[f32], vec_b: &[f32]) -> f32 {

if vec_a.len() != vec_b.len() || vec_a.is_empty() {

return 0.0;

}

let mut dot_product = 0.0;

let mut norm_a = 0.0;

let mut norm_b = 0.0;

for i in 0..vec_a.len() {

dot_product += vec_a[i] * vec_b[i];

norm_a += vec_a[i] * vec_a[i];

norm_b += vec_b[i] * vec_b[i];

}

let denominator = norm_a.sqrt() * norm_b.sqrt();

if denominator == 0.0 {

0.0

} else {

dot_product / denominator

}

}

#[wasm_bindgen]

pub fn cosine_similarity_rust_benchmark(vec_a: &[f32], vec_b: &[f32], iterations: i32) -> f32 {

let mut last_result = 0.0;

for _ in 0..iterations {

last_result = cosine_similarity_rust(vec_a, vec_b);

}

last_result

}浏览器侧:瞬间加载

ini

import init, { cosine_similarity_rust, cosine_similarity_rust_benchmark } from "./pkg/vector_sim.js";

// 纯 JS 实现的相同逻辑

function cosineSimilarityJS(vecA, vecB) {

let dotProduct = 0.0;

let normA = 0.0;

let normB = 0.0;

for (let i = 0; i < vecA.length; i++) {

dotProduct += vecA[i] * vecB[i];

normA += vecA[i] * vecA[i];

normB += vecB[i] * vecB[i];

}

return dotProduct / (Math.sqrt(normA) * Math.sqrt(normB));

}

function cosineSimilarityJSBenchmark(vecA, vecB, iterations) {

let lastResult = 0.0;

for (let i = 0; i < iterations; i++) {

lastResult = cosineSimilarityJS(vecA, vecB);

}

return lastResult;

}

async function setup() {

await init();

const ITERATIONS = 1000000;

const vecA = new Float32Array(512).fill(0.123);

const vecB = new Float32Array(512).fill(0.456);

let timeJS = 0;

let timeWasm = 0;

// --- JS 按钮逻辑 ---

document.getElementById('runJS').onclick = () => {

const start = performance.now();

// for (let i = 0; i < ITERATIONS; i++) {

// cosineSimilarityJS(vecA, vecB);

// }

const jsResult = cosineSimilarityJSBenchmark(vecA, vecB, ITERATIONS);

timeJS = performance.now() - start;

document.getElementById('jsTime').innerText = timeJS.toFixed(2);

updateConclusion();

console.log(`JS 结果: ${jsResult}`);

};

// --- Wasm 按钮逻辑 ---

document.getElementById('runWasm').onclick = () => {

const start = performance.now();

// for (let i = 0; i < ITERATIONS; i++) {

// cosine_similarity_rust(vecA, vecB);

// }

const rustResult = cosine_similarity_rust_benchmark(vecA, vecB, ITERATIONS);

timeWasm = performance.now() - start;

document.getElementById('wasmTime').innerText = timeWasm.toFixed(2);

updateConclusion();

console.log(`Rust 结果: ${rustResult}`);

};

function updateConclusion() {

if (timeJS > 0 && timeWasm > 0) {

const ratio = (timeJS / timeWasm).toFixed(1);

document.getElementById('conclusion').innerText = `🚀 Rust Wasm 比 JS 快了约 ${ratio} 倍!`;

}

}

}

setup();编译为 Wasm

shell

# 将上述代码放入 src/lib.rs,配置 Cargo.toml

wasm-pack build --target web --release

# 生成的 Wasm 文件路径为: ./pkg/vector_sim_bg.wasm运行并对比性能

yaml

# 启动本地服务器

# rust

cargo install miniserve

miniserve .

#python

python3 -m http.server 8080

结论: 即使是基础的数学运算,Wasm 也带来了极大的性能提升。而当涉及复杂的矩阵乘法时,配合 SIMD 指令集,差距将进一步拉大。

你的浏览器,其实比你想象中更聪明,也更强大。

8. 总结与下期预告

Rust + Wasm + AI (一):开启浏览器与边缘端的高性能推理时代

通过今天的探索,我们见证了 Wasm + Rust 正在如何重构 AI 的分发地图:

- 安全上: 指令级沙箱让"零信任 AI"成为现实

- 效率上: 微秒级启动和百倍性能让边缘推理触手可及

- 体验上: 一次编译,让 AI 模型如 JavaScript 般随用随取

但故事才刚刚开始。

拥有了强大的通用算力容器(Wasm)和高效的建造工具(Rust),下一步,我们该为它装载什么样的"大脑"?

👉 下期预告: 我们将深入 Rust 原生 AI 框架 Candle (HuggingFace 出品),挑战在浏览器中直接加载和运行真正的 LLM(大语言模型) ,实现一个离线版的"ChatGPT"。

敬请期待连载二:《Candle ------ 在浏览器中点燃 Rust 原生 AI 之火》。

📌 互动留言 觉得 Wasm 边缘 AI 有前景吗?欢迎在评论区留言

关注本公众号,和我一起探索 Rust 与 AI 的无限可能!

参考资料: [1] Dev.to: Revolutionizing AI/ML Deployment: The Power of WebAssembly

[2] Medium: The Rise of WASM-Native Runtimes for AI Tools

[3] Grid Dynamics: What is WebAssembly and Why is it Best for AI?