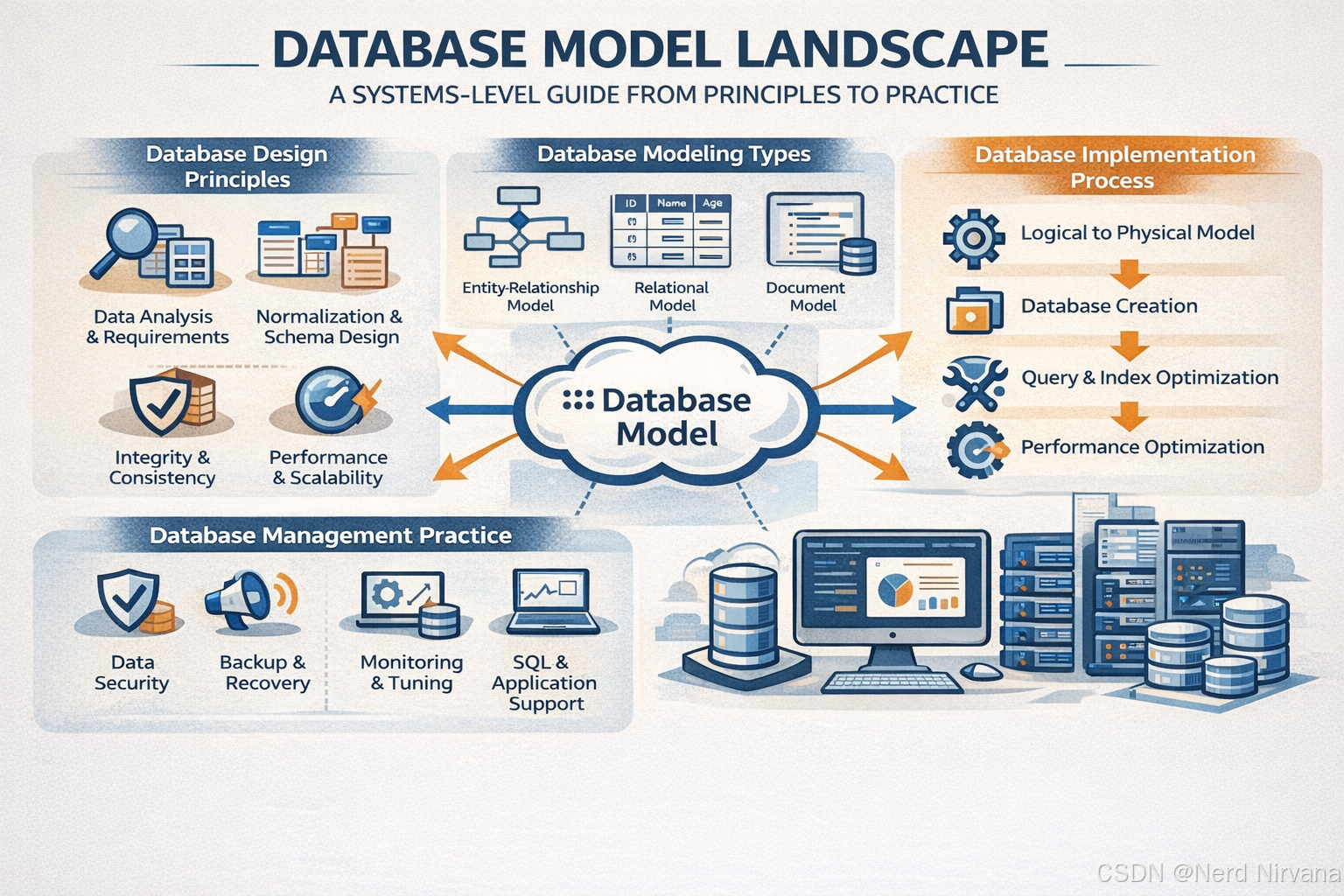

数据库模型全景:从原理到实践的系统性指南

一、引言:为什么要理解数据库模型而非产品特性

在现代软件系统中,我们常常面临这样的困惑:为什么有这么多种数据库?PostgreSQL、Redis、MongoDB、Cassandra、InfluxDB、Neo4j......它们之间的本质差异是什么?更重要的是,如何为特定问题选择合适的数据库?

问题的根源在于:我们常常被产品特性所迷惑,而忽略了底层的模型差异。

一个数据库产品可能有数百个特性,但其核心行为由少数几个基础模型决定。理解这些模型,就像理解编程范式(函数式、面向对象)一样重要------它们定义了根本的思维方式和问题解决路径。

本文的目标是:帮助建立一个清晰的数据库模型认知框架,从"知道有什么数据库"升级到"理解为什么需要不同的数据库模型"。

二、理解数据库的四个核心维度

在深入具体模型之前,我们需要建立一个统一的分析框架。任何数据库系统都可以从以下四个维度进行剖析:

2.1 数据模型(Data Model)

核心问题:数据以什么逻辑结构存在?

数据模型定义了:

- 数据的基本组织单元(表、键值对、文档、图节点等)

- 数据之间的关系表达方式

- 数据的约束与完整性规则

这是最根本的维度,决定了"用户如何思考数据"。

2.2 存储模型(Storage Model)

核心问题:数据在磁盘上如何物理存储?

存储模型涉及:

- 底层数据结构(B+树、LSM树、哈希表、时间分区等)

- 数据布局(行存储、列存储、混合存储)

- 索引机制

- 压缩策略

存储模型直接影响读写性能特征。

2.3 访问模型(Access Model)

核心问题:应用程序如何与数据库交互?

访问模型包括:

- 查询语言(SQL、命令式API、声明式查询)

- 操作语义(点查询、范围扫描、聚合、图遍历)

- 查询优化与执行

访问模型决定了"表达数据需求的难易程度"。

2.4 一致性与事务模型(Consistency and Transaction Model)

核心问题:并发操作和分布式环境下,数据保证什么样的正确性?

这个维度涉及:

- 事务隔离级别(Read Uncommitted、Read Committed、Repeatable Read、Serializable)

- 一致性语义(强一致性、最终一致性、因果一致性)

- 分布式协议(2PC、Paxos、Raft)

- CAP权衡

一致性模型定义了"系统在极端情况下的行为边界"。

这四个维度相互影响但又相对独立。 例如,文档型数据库(如MongoDB)和关系型数据库(如PostgreSQL)在数据模型上不同,但都可以使用B+树作为存储模型;Redis和Memcached都是Key-Value模型,但Redis提供持久化而Memcached纯内存。

接下来,我们将用这个框架系统性地剖析几种核心数据库模型。

三、关系型数据库模型:规范化与关系代数的力量

3.1 历史背景:从层次模型到关系革命

关系型数据库的诞生源于一篇划时代的论文:Edgar F. Codd 在1970年发表的《A Relational Model of Data for Large Shared Data Banks》。

在此之前,主流的数据库模型是层次模型(Hierarchical Model)和网状模型(Network Model),如IBM的IMS。这些模型的问题在于:

- 数据访问依赖物理存储结构:程序员需要知道数据如何存储才能查询

- 查询逻辑复杂:需要手动遍历指针,代码难以维护

- 缺乏数据独立性:改变存储结构会破坏应用程序

Codd提出的关系模型的核心创新是数据独立性:用户通过数学上的关系代数操作数据,而不关心物理存储。这实现了逻辑层和物理层的解耦。

3.2 数据模型:关系代数的优雅

关系型数据库的数据模型基于关系(Relation) ,在实践中表现为表(Table)。

核心概念:

- 关系(Relation):一个关系是元组(Tuple)的集合,每个元组是属性(Attribute)的有序组合

- 模式(Schema):定义关系的结构(列名、数据类型、约束)

- 键(Key):唯一标识元组的属性组合

- 外键(Foreign Key):表达关系间的引用完整性

数学基础:

关系模型基于集合论和一阶谓词逻辑,支持以下基本操作:

- 选择(Selection, σ):过滤行

- 投影(Projection, π):选择列

- 连接(Join, ⋈):组合多个关系

- 并、交、差(Union, Intersection, Difference):集合运算

规范化理论:

关系型数据库强调数据规范化,通过范式(1NF、2NF、3NF、BCNF等)减少冗余、避免异常:

- 第一范式(1NF):每个属性是原子值

- 第二范式(2NF):消除部分函数依赖

- 第三范式(3NF):消除传递函数依赖

规范化的核心思想是一个事实存储一次,通过连接操作重建完整数据。

3.3 存储模型:B+树与堆表

关系型数据库的主流存储结构是B+树(B+ Tree)。

为什么选择B+树?

- 磁盘友好:树的高度低(通常3-4层),每次查询只需少量磁盘I/O

- 范围查询高效:叶子节点有序链接,支持快速范围扫描

- 写入性能可接受:虽然需要维护树结构,但写入复杂度为O(log N)

存储布局:

- 堆表(Heap Table):数据行无序存储在堆文件中,通过索引访问

- 聚簇索引(Clustered Index):数据按主键顺序存储(如InnoDB)

- 二级索引(Secondary Index):额外的B+树,叶子节点存储主键或行指针

行存储特性:

关系型数据库通常采用行存储(Row-Store),一行的所有列连续存储。这适合OLTP场景的点查询和更新,但对分析型查询(扫描大量行的少数列)效率较低。

3.4 访问模型:SQL的声明式抽象

SQL(Structured Query Language)是关系型数据库的标准访问语言,其核心特征是声明式(Declarative)。

声明式的优势:

sql

-- 用户只需描述"要什么"

SELECT customer_name, SUM(order_amount)

FROM orders

WHERE order_date > '2024-01-01'

GROUP BY customer_name;

-- 而不是"怎么做"(命令式)

for each order in orders:

if order.date > '2024-01-01':

if order.customer in results:

results[order.customer] += order.amount

else:

results[order.customer] = order.amount查询优化器:

数据库系统负责将SQL转换为高效的执行计划,这涉及:

- 逻辑优化:应用关系代数等价变换(如谓词下推)

- 物理优化:选择索引、连接算法(Nested Loop、Hash Join、Sort-Merge Join)

- 统计信息:基于数据分布估算查询代价

SQL的声明式特性使得系统可以在不改变查询语义的前提下持续优化性能。

3.5 事务与一致性:ACID的严格保证

关系型数据库的标志性特征是ACID事务:

Atomicity(原子性):

- 事务是不可分割的工作单元

- 实现机制:Write-Ahead Logging (WAL) + Undo Log

Consistency(一致性):

- 事务执行前后,数据库从一个一致状态转移到另一个一致状态

- 通过约束(主键、外键、检查约束)和触发器保证

Isolation(隔离性):

- 并发事务间相互隔离

- 隔离级别(从弱到强):

- Read Uncommitted:可能读到未提交数据(脏读)

- Read Committed:只能读到已提交数据,但可能不可重复读

- Repeatable Read:同一事务内多次读取相同,但可能幻读

- Serializable:完全串行化,无异常

- 实现机制:多版本并发控制(MVCC)或锁机制

Durability(持久性):

- 已提交事务的修改永久保存

- 实现机制:WAL + 定期Checkpoint

ACID的代价:

- 性能开销:锁竞争、日志写入

- 扩展性瓶颈:分布式ACID(如2PC)显著增加延迟

3.6 扩展性特征:垂直扩展为主

关系型数据库传统上难以水平扩展(Scale-Out),原因包括:

- 跨节点JOIN:需要大量数据移动

- 分布式事务:2PC协议性能差、可用性低

- 强一致性约束:全局一致性需要全局协调

主流扩展策略:

- 垂直扩展(Scale-Up):升级硬件(更多CPU、内存、更快磁盘)

- 读写分离:主库写入,从库只读,但存在复制延迟

- 分片(Sharding):手动将数据分布到多个数据库,但JOIN、事务受限

近年来,NewSQL数据库(如Google Spanner、CockroachDB)尝试在保持ACID的同时实现水平扩展,但这需要复杂的分布式协议和工程实现。

3.7 适用场景:结构化数据与事务一致性

关系型数据库的最佳适用场景:

-

结构化、关系复杂的业务数据

- 财务系统(账户、交易、余额)

- ERP系统(订单、库存、供应链)

- CRM系统(客户、联系人、商机)

-

强一致性要求的场景

- 支付系统:必须保证转账的原子性

- 库存管理:不能超卖

- 订单系统:订单状态变更必须一致

-

复杂查询与临时分析

- 需要JOIN多张表

- 需要灵活的Ad-hoc查询

- 需要聚合、分组、排序等复杂操作

-

数据完整性约束严格

- 外键约束确保引用完整性

- 唯一约束、检查约束

- 触发器实现复杂业务规则

3.8 反模式:不适合关系型数据库的场景

-

极高吞吐量的简单操作

- 如果只需要简单的Key-Value查询(如缓存),关系型数据库的开销过大

- 例:用MySQL存储Session,不如用Redis

-

写入密集且无需事务的场景

- 日志收集、点击流数据、IoT传感器数据

- B+树写入需要维护索引结构,LSM树更适合

-

半结构化或无模式数据

- 如果数据结构频繁变化(如用户自定义字段),维护schema成本高

- 文档型数据库更灵活

-

图遍历查询

- 虽然可以用递归SQL,但性能远不如图数据库

- 例:社交网络的"朋友的朋友"查询

-

需要极致水平扩展

- 如果数据规模达到PB级别且需要写入扩展,传统关系型数据库难以应对

- 考虑NewSQL或NoSQL方案

四、Key-Value 数据库模型:极简与性能的极致追求

4.1 历史背景:从Amazon Dynamo到Redis

Key-Value数据库的理论基础可以追溯到分布式哈希表(DHT),但其真正兴起源于Amazon在2007年发表的Dynamo论文 (Dynamo: Amazon's Highly Available Key-value Store)。

Dynamo的设计动机:

- Amazon的购物车服务需要极高可用性:即使部分数据中心故障,用户仍能添加商品

- 不需要复杂查询:只需要根据用户ID获取购物车

- 愿意牺牲强一致性换取可用性(最终一致性)

Redis的不同定位:

Redis(Remote Dictionary Server,2009年)则聚焦于内存速度 + 数据结构:

- 不仅是Key-Value,还支持列表、集合、有序集合、哈希等丰富数据结构

- 主要用作缓存、会话存储、消息队列、排行榜等高性能场景

- 可选的持久化(RDB快照 + AOF日志)

4.2 数据模型:简单但强大的映射

Key-Value数据库的数据模型极其简单:一个巨大的哈希表(Hash Map)。

核心概念:

- Key:唯一标识符,通常是字符串或二进制数据

- Value:任意数据,数据库不关心其内部结构

基本操作:

GET(key) → value

PUT(key, value)

DELETE(key)Redis的扩展:

Redis引入了丰富的数据结构,但仍然遵循"一个Key对应一个数据结构"的原则:

redis

# 字符串

SET user:1001:name "Alice"

# 哈希(对象)

HSET user:1001 name "Alice" age 30 email "alice@example.com"

# 列表(消息队列)

LPUSH queue:tasks "task1" "task2"

# 集合(标签)

SADD user:1001:tags "developer" "golang" "database"

# 有序集合(排行榜)

ZADD leaderboard 1500 "player1" 1200 "player2"无Schema的灵活性:

- 不需要预定义表结构

- 可以动态添加新Key

- 不同Key的Value可以是不同类型

但也带来约束:

- 没有内置的关系表达(无外键)

- 没有跨Key的原子性保证(Redis支持事务,但功能有限)

- 查询能力极弱(只能通过Key精确查找或扫描)

4.3 存储模型:内存优先与持久化策略

Redis的存储架构:

Redis本质上是一个内存数据库,所有数据常驻内存,这带来了微秒级延迟。

内存管理:

- 数据结构优化:使用紧凑的内部编码(如小哈希用ziplist、大哈希用hashtable)

- 过期策略:惰性删除 + 定期采样删除

- 淘汰策略:当内存不足时,按照策略(LRU、LFU、TTL)淘汰数据

持久化机制:

-

RDB(快照):

- 定期将内存数据dump到磁盘(fork子进程 + Copy-on-Write)

- 优点:文件紧凑、恢复快

- 缺点:可能丢失最后一次快照后的数据

-

AOF(Append-Only File):

- 记录每个写命令到日志文件

- 优点:数据丢失少(可配置fsync策略)

- 缺点:文件较大、恢复慢

-

混合持久化:

- AOF重写时使用RDB格式,后续增量用AOF

- 兼顾恢复速度和数据安全

分布式存储(如Dynamo):

Dynamo使用一致性哈希 + 副本机制实现分布式存储:

- 一致性哈希:数据均匀分布到多个节点

- N/W/R参数:N个副本,写入W个成功,读取R个成功

- 向量时钟(Vector Clock):解决并发冲突

4.4 访问模型:命令式API与有限查询

Key-Value数据库通常提供命令式API,而非声明式查询语言。

Redis示例:

redis

# 原子递增

INCR page:views

# 条件更新

SET cache:key "value" EX 3600 NX # 只在不存在时设置,TTL 1小时

# 批量操作

MGET user:1001 user:1002 user:1003

# Pipeline(减少网络往返)

MULTI

SET key1 "value1"

SET key2 "value2"

EXEC查询能力的局限:

- 无法按Value查询:不能"查找所有年龄大于30的用户"

- 无法JOIN:不同Key间无关联

- 有限的范围查询:只有Sorted Set支持按分数范围查询

变通方法:

- 二级索引 :手动维护反向索引(如

age:30 -> [user:1001, user:1002]) - 应用层JOIN:在代码中组合多个查询结果

- 使用Redis Modules:如RediSearch提供全文搜索

4.5 一致性模型:从最终一致性到强一致性

Dynamo的最终一致性:

- 牺牲强一致性换取高可用性(AP in CAP Theorem)

- 场景示例:用户在节点A添加商品到购物车,在节点B可能暂时看不到,但最终会同步

- 冲突解决:使用向量时钟检测冲突,由应用层或Last-Write-Wins策略解决

Redis的单实例强一致性:

- 单线程命令执行:保证命令串行执行,无并发冲突

- 事务:MULTI/EXEC提供原子性,但无隔离性(其他客户端可见中间状态)

- Lua脚本:保证脚本内命令的原子性

Redis集群的弱一致性:

- 主从复制:异步复制,存在复制延迟

- 哨兵(Sentinel)模式:自动故障转移,但可能丢失未复制的数据

- Redis Cluster:分片 + 副本,可能丢失写入(主节点宕机且未复制到从节点)

4.6 扩展性特征:天然的水平扩展

Key-Value模型由于其简单性,非常适合水平扩展:

扩展优势:

- 无跨节点操作:每个操作只涉及单个Key,可以路由到单个节点

- 易于分片:使用一致性哈希或范围分片

- 无分布式事务:不需要2PC

Redis Cluster:

- 16384个哈希槽:每个Key根据CRC16(key) mod 16384分配到槽

- 自动故障转移:主节点故障时,从节点自动提升

- 重新分片:可以在线将槽从一个节点迁移到另一个节点

局限性:

- 无法跨Key事务:不同Key可能在不同节点

- 热点问题:某个Key访问量极大会导致单节点瓶颈

- 客户端路由:客户端需要知道Key在哪个节点(通过MOVED重定向)

4.7 适用场景:缓存与高速数据访问

Key-Value数据库的最佳适用场景:

-

缓存

- Web应用缓存(页面片段、API响应)

- 数据库查询结果缓存

- 计算结果缓存(如推荐系统中间结果)

- 为什么适合? 微秒级延迟、自动过期、LRU淘汰

-

会话存储(Session Store)

- Web应用的用户会话

- 为什么适合? 快速读写、支持TTL、跨服务器共享

-

实时数据

- 在线用户列表(Set)

- 实时排行榜(Sorted Set)

- 计数器(String的INCR)

- 为什么适合? 原子操作、低延迟

-

消息队列与发布订阅

- 简单的任务队列(List的LPUSH/RPOP)

- 发布订阅(Pub/Sub)

- 为什么适合? 阻塞弹出、持久化可选

-

分布式锁

- 使用SET NX EX实现分布式锁

- 为什么适合? 原子操作、自动过期

4.8 反模式:不适合Key-Value数据库的场景

-

复杂查询与关系数据

- 需要JOIN、聚合、复杂过滤

- 错误示例:用Redis存储订单和订单项,尝试查询"2024年所有金额大于1000的订单"

-

强一致性事务

- 需要跨多个Key的ACID事务

- 错误示例:用Redis实现银行转账(需要原子地减少A账户、增加B账户)

-

大数据分析

- 需要全表扫描、聚合分析

- 错误示例:用Redis存储原始日志,尝试做数据分析

-

数据持久性要求极高

- Redis主要是内存数据库,持久化有延迟

- 错误示例:用Redis作为唯一的数据存储(应结合关系型数据库)

-

Value过大

- 单个Value超过几MB会影响性能

- 错误示例:在Redis中存储大文件或长文本

五、时间序列数据库模型:为时序数据优化的专用系统

5.1 历史背景:IoT与监控爆发的产物

时间序列数据库(Time-Series Database, TSDB)是最近十年兴起的数据库类型,其出现源于监控、IoT、金融市场数据等场景的爆发式增长。

典型时间序列数据:

- 监控指标:CPU使用率、内存占用、网络流量

- IoT传感器:温度、湿度、振动、GPS位置

- 金融数据:股票价格、交易量

- 应用日志:请求响应时间、错误率

传统数据库的问题:

- 写入密集:每秒数百万个数据点

- 时间范围查询频繁:查询"最近1小时的平均值"

- 数据只追加、不修改:旧数据通常只读

- 存储开销大:关系型数据库存储时间序列数据冗余度高

代表性TSDB:

- InfluxDB(开源,单机为主)

- Prometheus(开源,监控领域标准)

- TimescaleDB(基于PostgreSQL扩展)

- OpenTSDB(基于HBase)

5.2 数据模型:时间戳 + 指标 + 标签

时间序列数据库的数据模型专门为时序数据设计:

核心概念:

时间序列 = 指标名称 + 标签集 + (时间戳, 值) 序列InfluxDB示例:

measurement: cpu_usage

tags: host=server01, region=us-west

fields: value=45.2

timestamp: 2024-01-08T10:30:00ZPrometheus示例:

http_requests_total{method="GET", endpoint="/api", status="200"} 1027 @1704709800模型特点:

-

时间戳是一等公民

- 每个数据点必须有时间戳

- 时间戳通常是主索引

-

标签(Tags)vs 字段(Fields)

- 标签:维度信息,用于过滤和分组(如host、region)

- 字段:实际的数值(如value、count)

- 标签会被索引,字段不会

-

不可变性

- 数据点一旦写入通常不修改(Append-Only)

- 简化并发控制

-

高基数问题

- 标签组合的唯一值数量称为"基数"

- 高基数(如用户ID作为标签)会导致索引膨胀

- 设计原则:标签应该是有限枚举值(如服务器列表、地区列表)

5.3 存储模型:为时序优化的结构

时间序列数据库的存储模型针对"高写入 + 时间范围查询"优化。

核心存储策略:

-

时间分区(Time Partitioning)

- 数据按时间窗口(如1小时、1天)分区存储

- 优势 :

- 时间范围查询只需扫描相关分区

- 旧数据删除只需删除整个分区(高效)

- 可以对旧分区应用高压缩率

-

列式存储(Columnar Storage)

- 同一字段的所有值连续存储

- 优势 :

- 高压缩率(同类型数据压缩效果好)

- 查询单个指标无需读取其他字段

- 示例:InfluxDB的TSM引擎、Prometheus的TSDB

-

压缩算法

- Delta-of-Delta编码:存储时间戳的差值的差值(Facebook Gorilla论文)

- XOR压缩:存储浮点数的异或值(Gorilla论文)

- Run-Length Encoding:重复值压缩

- 压缩比:可达10:1甚至更高

InfluxDB的TSM引擎:

TSM = Time-Structured Merge Tree (类似LSM树)

- WAL(Write-Ahead Log):写入先记录到WAL

- Cache:内存中的数据

- TSM文件:不可变的列式存储文件

- Compaction:定期合并小文件Prometheus的TSDB:

Block结构:

- Chunk:2小时数据块,使用Gorilla压缩

- Index:标签到Series的倒排索引

- Tombstones:删除标记

- WAL:未落盘数据5.4 访问模型:时间范围查询与聚合

时间序列数据库的查询语言围绕时间范围 + 聚合设计。

InfluxQL示例(类SQL):

sql

-- 查询最近1小时的平均CPU使用率

SELECT mean(value)

FROM cpu_usage

WHERE host='server01'

AND time > now() - 1h

GROUP BY time(5m)

-- 多维度聚合

SELECT mean(value)

FROM cpu_usage

WHERE time > now() - 24h

GROUP BY host, region, time(1h)Prometheus PromQL示例(函数式):

promql

# 计算5分钟的平均请求率

rate(http_requests_total[5m])

# 按endpoint聚合

sum by (endpoint) (rate(http_requests_total[5m]))

# 复杂查询:95分位延迟

histogram_quantile(0.95,

sum by (le) (rate(http_request_duration_seconds_bucket[5m]))

)查询特点:

- 时间范围是必需的:避免全表扫描

- 降采样(Downsampling):自动汇总数据(如1小时的数据聚合为1分钟粒度)

- 连续查询(Continuous Queries):自动定期聚合数据并存储

- 窗口函数:滑动窗口、移动平均

5.5 一致性模型:最终一致性为主

时间序列数据库通常优先考虑可用性和写入吞吐量,而非强一致性。

InfluxDB(单机):

- 写入WAL后立即返回成功

- 数据可能还未刷盘

- 支持配置fsync策略平衡性能和持久性

Prometheus:

- 本地存储,无分布式复制

- 通过联邦(Federation)或远程存储(Remote Write)实现高可用

分布式TSDB(如OpenTSDB):

- 基于HBase,继承其最终一致性

- 写入多个副本,读取可能读到旧数据

为什么可以接受最终一致性?

- 监控数据容忍短暂丢失:丢失几秒钟的数据点不影响整体趋势

- 时序数据不修改:无并发更新冲突

- 聚合查询容忍小误差:查询的是统计值(平均值、最大值),而非精确值

5.6 扩展性特征:写入扩展与存储优化

写入扩展:

-

Sharding(分片)

- 按指标名称或标签分片

- 示例:Prometheus通过远程写入到多个存储后端

-

批量写入

- 客户端缓存多个数据点,批量提交

- 示例:Telegraf(InfluxDB的数据采集器)支持批量写入

-

无索引写入

- 写入时不立即更新索引,后台异步构建

- LSM树天然支持高写入

存储优化:

-

数据保留策略(Retention Policy)

- 自动删除旧数据

- 示例:InfluxDB配置"保留7天的原始数据,1年的聚合数据"

-

降采样(Downsampling)

- 将高精度数据聚合为低精度

- 示例:1秒粒度 → 1分钟粒度 → 1小时粒度

-

冷热分离

- 热数据(最近)存储在SSD

- 冷数据(历史)存储在对象存储(S3)

5.7 适用场景:监控、IoT与实时分析

时间序列数据库的最佳适用场景:

-

系统监控与可观测性

- 服务器指标(CPU、内存、磁盘、网络)

- 应用指标(请求数、响应时间、错误率)

- 基础设施监控(Kubernetes、Docker)

- 为什么适合? 高写入吞吐量、时间范围查询、聚合分析

-

IoT数据收集

- 传感器数据(温度、湿度、压力)

- 设备状态数据

- GPS轨迹数据

- 为什么适合? 海量设备、高频采样、压缩存储

-

金融市场数据

- 股票价格、交易量

- 订单簿(Order Book)

- 实时行情

- 为什么适合? 时间有序、不可变、高压缩比

-

应用性能监控(APM)

- 请求链路追踪(Tracing)

- 业务指标(转化率、GMV)

- 为什么适合? 与监控场景类似

-

实时分析与报警

- 异常检测(CPU突增)

- 阈值报警(温度超过100°C)

- 趋势预测

- 为什么适合? 连续查询、窗口函数

5.8 反模式:不适合时间序列数据库的场景

-

需要修改或删除单个数据点

- TSDB是追加式存储,修改效率极低

- 错误示例:用InfluxDB存储用户订单,需要频繁更新订单状态

-

非时序数据

- 如果数据没有时间维度或时间不是主要查询条件

- 错误示例:用TSDB存储用户资料

-

高基数标签

- 用户ID、订单ID作为标签会导致索引爆炸

- 错误示例 :

page_views{user_id="12345"}(用户ID基数极高)

-

复杂事务与关系查询

- TSDB无事务支持、无JOIN

- 错误示例:用TSDB存储订单和订单项,需要JOIN查询

-

低频更新数据

- 如果数据每天只更新一次,TSDB的优势无法体现

- 错误示例:用TSDB存储每日汇总报表

六、其他数据库模型在体系中的位置

在理解了关系型、Key-Value、时间序列三种核心模型后,我们来看其他常见数据库模型如何定位。

6.1 文档型数据库(Document Store)

代表产品: MongoDB、CouchDB、Elasticsearch

数据模型:

- 存储半结构化的文档(通常是JSON或BSON)

- 文档内部可以有嵌套结构(对象、数组)

- 同一集合(Collection)的文档可以有不同字段

与其他模型的关系:

- vs 关系型:牺牲JOIN和规范化,换取灵活的模式和嵌套数据

- vs Key-Value:Value有结构,可以查询文档内部字段

- 定位 :介于关系型和Key-Value之间,适合半结构化、嵌套关系的数据

典型适用场景:

- 内容管理系统(CMS):文章、评论、标签

- 用户配置:不同用户有不同的自定义字段

- 产品目录:商品属性多样(手机有屏幕尺寸,书籍有作者)

- 日志存储与搜索:Elasticsearch专为此优化

存储模型:

- MongoDB:B+树(WiredTiger引擎)

- Elasticsearch:Lucene倒排索引

访问模型:

javascript

// MongoDB查询

db.products.find({

"category": "electronics",

"price": { $gt: 500 },

"tags": { $in: ["smartphone"] }

})6.2 列族数据库(Wide-Column Store)

代表产品: Apache Cassandra、HBase、Google Bigtable

数据模型:

- 数据组织为行键 + 列族 + 列 + 时间戳

- 每行可以有任意多列

- 按列族存储(同列族的列存储在一起)

与其他模型的关系:

- vs 关系型:无固定schema,支持海量列,水平扩展

- vs Key-Value:支持部分列查询(而非整个Value)

- 定位 :适合宽表、稀疏数据、大规模分布式场景

典型适用场景:

- 用户行为日志:每个用户有数千个行为列

- 社交网络:用户的好友列表、时间线

- 推荐系统:用户-物品交互矩阵

存储模型:

- LSM树(Log-Structured Merge-Tree)

- 优化大规模写入

Cassandra数据模型示例:

cql

CREATE TABLE user_actions (

user_id UUID,

action_time TIMESTAMP,

action_type TEXT,

action_data TEXT,

PRIMARY KEY (user_id, action_time)

) WITH CLUSTERING ORDER BY (action_time DESC);6.3 图数据库(Graph Database)

代表产品: Neo4j、Amazon Neptune、JanusGraph

数据模型:

- 数据组织为节点(Vertex)+ 边(Edge)+ 属性(Property)

- 边有方向和类型

- 天然表达实体间的关系

与其他模型的关系:

- vs 关系型:图遍历查询性能远超JOIN(尤其是多跳关系)

- vs 文档型:关注关系而非单个实体

- 定位 :适合复杂关系网络、图算法

典型适用场景:

- 社交网络:好友关系、共同好友、社区发现

- 推荐系统:基于图的协同过滤

- 知识图谱:实体关系、语义查询

- 欺诈检测:关联账户、异常模式

- 网络拓扑:路由、依赖分析

访问模型(Cypher语言):

cypher

// 查询Alice的好友的好友(2跳关系)

MATCH (alice:User {name: 'Alice'})-[:FRIEND]->()-[:FRIEND]->(fof)

WHERE NOT (alice)-[:FRIEND]->(fof) AND alice <> fof

RETURN fof.name, count(*) as mutual_friends

ORDER BY mutual_friends DESC存储模型:

- 原生图存储(如Neo4j):使用指针直接连接节点,遍历无需索引查找

- 非原生图存储(如JanusGraph):基于其他数据库(HBase、Cassandra)实现

七、数据库模型演进的本质:CAP定理与工程权衡

理解了不同数据库模型后,我们需要回答一个更深层的问题:为什么会有这么多不同的模型?它们本质上在权衡什么?

7.1 CAP定理:分布式系统的铁律

CAP定理(Eric Brewer,2000年提出)指出,分布式系统最多只能同时满足以下三个特性中的两个:

- Consistency(一致性):所有节点同时看到相同的数据

- Availability(可用性):每个请求都能得到响应(成功或失败)

- Partition Tolerance(分区容错性):系统在网络分区时仍能继续工作

核心洞察: 网络分区是客观存在的(机房断网、光纤故障),因此P是必须的。实际选择是CP vs AP。

模型对应:

- 关系型数据库(传统):选择CP,牺牲可用性(主库故障时不可写)

- Dynamo类系统:选择AP,牺牲一致性(最终一致性)

- Paxos/Raft共识算法:尝试在CP下提高可用性(但仍需多数节点存活)

7.2 读写模式与存储结构的对应

不同应用的读写模式决定了最优的存储结构:

| 读写模式 | 最优存储结构 | 代表数据库 |

|---|---|---|

| 读多写少 + 点查询 | B+树 | MySQL, PostgreSQL |

| 写多读少 | LSM树 | Cassandra, HBase, RocksDB |

| 范围扫描 + 分析 | 列式存储 | ClickHouse, Parquet |

| 时间范围查询 | 时间分区 + 列式 | InfluxDB, Prometheus |

| 图遍历 | 原生图存储 | Neo4j |

关键权衡:

- B+树:读优化,写入需要维护树结构(可能随机I/O)

- LSM树:写优化,写入顺序追加,但读取需要查询多层(读放大)

- 列式存储:分析查询优化,但点查询需要读取多个列文件

7.3 规范化 vs 反规范化的权衡

这是数据建模中最核心的权衡之一:

规范化(Normalization):

- 优势:无冗余、一致性易维护、存储节省

- 劣势:查询需要JOIN,性能开销大

- 适用:事务一致性要求高、数据频繁更新

反规范化(Denormalization):

- 优势:查询性能高(无需JOIN)、易于分片

- 劣势:数据冗余、一致性难维护、存储占用大

- 适用:读多写少、可接受最终一致性

不同模型的选择:

- 关系型数据库:默认规范化,通过JOIN组合数据

- 文档型数据库:倾向反规范化,将关联数据嵌套在文档中

- 列族数据库:反规范化,用宽表存储所有相关数据

- 时序数据库:天然反规范化,每个数据点包含所有标签

案例对比:

规范化设计(关系型):

sql

-- 三张表

users(id, name, email)

orders(id, user_id, total, created_at)

order_items(order_id, product_id, quantity, price)

-- 查询需要JOIN

SELECT u.name, o.total, oi.quantity

FROM users u

JOIN orders o ON u.id = o.user_id

JOIN order_items oi ON o.id = oi.order_id

WHERE u.id = 123;反规范化设计(文档型):

json

{

"user_id": 123,

"user_name": "Alice",

"user_email": "alice@example.com",

"order": {

"order_id": 456,

"total": 1500,

"created_at": "2024-01-08T10:00:00Z",

"items": [

{"product_id": 789, "quantity": 2, "price": 500},

{"product_id": 790, "quantity": 1, "price": 500}

]

}

}7.4 ACID vs BASE:一致性的两种哲学

ACID(关系型数据库):

- 目标:强一致性、数据正确性

- 代价:性能、可用性、扩展性

- 适用:金融、订单、库存等不容错误的场景

BASE(NoSQL数据库):

- Basically Available(基本可用):系统大部分时间可用

- Soft State(软状态):系统状态可能暂时不一致

- Eventually Consistent(最终一致性):系统最终会达到一致

- 适用:社交网络、推荐、缓存等容忍短暂不一致的场景

为什么BASE可行?

许多应用的业务语义本身就容忍最终一致性:

- 购物车:暂时看不到其他设备添加的商品,不影响最终购买

- 点赞数:显示1000还是1001个赞,用户无感知

- 推荐列表:略微过时的推荐仍然有价值

八、多数据库共存(Polyglot Persistence):现代架构的必然选择

现代应用很少只使用一种数据库。理解不同模型后,我们可以为不同的数据特征选择最合适的存储。

8.1 Polyglot Persistence的设计原则

核心思想: 每种数据用最适合它的数据库存储。

原则1:根据数据特征选择模型

- 结构化、关系复杂、需要事务 → 关系型数据库

- 简单键值、高速访问、缓存 → Key-Value数据库

- 时序数据、监控指标 → 时间序列数据库

- 半结构化、嵌套数据 → 文档型数据库

- 复杂关系网络、图算法 → 图数据库

原则2:明确数据的权威来源(Source of Truth)

- 每个数据实体应该有唯一的主存储

- 其他存储是派生数据(Derived Data)

原则3:通过异步同步实现数据一致性

- CDC(Change Data Capture):捕获主库变更

- 消息队列(Kafka):传递变更事件

- ETL/ELT:定期同步

8.2 典型架构模式

模式1:关系型数据库 + Redis缓存

应用层

↓ 读请求

Redis(缓存)

↓ Cache Miss

MySQL(权威数据)

↓ 写请求

MySQL

↓ 写后失效

Redis删除缓存适用场景: 读多写少、用户会话、热点数据

模式2:关系型数据库 + Elasticsearch全文搜索

MySQL(权威数据)

↓ CDC / Binlog

Kafka(消息队列)

↓ 消费

Elasticsearch(搜索索引)

← 查询

应用层适用场景: 电商商品搜索、文档检索、日志分析

模式3:事务数据库 + 时序数据库 + 缓存

用户请求

↓

Redis(会话、缓存)

↓

PostgreSQL(订单、用户、库存)

↓ 业务指标

应用层埋点

↓

InfluxDB(监控指标)适用场景: 电商系统、SaaS应用

8.3 数据一致性保证策略

策略1:最终一致性 + 幂等性

- 通过消息队列异步同步

- 消费者实现幂等(重复消费不影响结果)

- 监控同步延迟

策略2:双写(慎用)

python

# 反模式:容易出现不一致

db.save(data)

cache.set(key, data) # 如果失败,缓存和DB不一致

# 改进:使用TTL让缓存自动过期

db.save(data)

cache.set(key, data, ttl=300) # 5分钟后自动过期策略3:事件溯源(Event Sourcing)

- 所有变更记录为事件(Event)

- 不同数据库消费同一事件流构建视图

- 保证最终一致性

8.4 真实案例:电商系统的数据库选型

业务场景:

- 用户、商品、订单、库存

- 商品搜索与推荐

- 用户行为跟踪

- 实时大屏监控

数据库选型:

| 数据类型 | 数据库 | 理由 |

|---|---|---|

| 用户资料、订单 | PostgreSQL | 需要事务、外键约束、复杂查询 |

| 商品搜索 | Elasticsearch | 全文搜索、多维过滤、相关性排序 |

| 会话、购物车 | Redis | 高速读写、自动过期、跨服务器共享 |

| 实时库存 | Redis | 高并发扣减、原子操作(INCRBY) |

| 用户行为日志 | ClickHouse | 海量数据、分析查询、实时聚合 |

| 监控指标 | Prometheus | 应用性能、业务指标、报警 |

| 推荐关系 | Neo4j(可选) | 基于图的协同过滤、社交推荐 |

数据流:

1. 用户下单 → PostgreSQL(订单表)

2. 扣减库存 → Redis(INCRBY)+ PostgreSQL(最终持久化)

3. 订单变更 → Kafka → Elasticsearch(搜索"我的订单")

4. 用户行为 → Kafka → ClickHouse(数据分析)

5. 缓存热点商品 → Redis(定期刷新)

6. 监控订单量 → Prometheus(埋点上报)九、常见错误选型案例分析

9.1 错误1:用MySQL存储日志数据

问题描述:

将应用日志直接写入MySQL表,每条日志一行。

为什么错误?

- 写入性能差:日志量大(每秒数千条),MySQL的B+树写入开销高

- 查询效率低:全文搜索需要LIKE '%keyword%'(全表扫描)

- 存储成本高:日志数据冗余度高,但MySQL压缩率低

- 扩展困难:单表数据量达到亿级别后性能急剧下降

正确方案:

- Elasticsearch:专为日志搜索设计,倒排索引、全文搜索、聚合分析

- ClickHouse:如果主要做分析而非搜索

- 时序数据库:如果日志结构化为指标

9.2 错误2:用Redis存储大量用户资料

问题描述:

将所有用户的详细资料(姓名、地址、订单历史等)存储在Redis中。

为什么错误?

- 内存成本高:Redis是内存数据库,存储海量数据成本极高

- 持久化风险:RDB可能丢失数据,AOF恢复慢

- 无复杂查询:不能查询"所有北京的用户",只能通过Key精确查找

- 无事务支持:用户资料更新可能涉及多个Key,Redis事务功能弱

正确方案:

- 用户基本资料 → PostgreSQL/MySQL(权威数据)

- 热点用户资料 → Redis缓存(TTL自动过期)

- 用户会话 → Redis(天然适合)

9.3 错误3:用MongoDB替代关系型数据库存储订单

问题描述:

将订单、订单项、用户、商品等所有数据存储在MongoDB中。

为什么可能出错?

- JOIN困难:虽然可以用$lookup,但性能远不如关系型数据库

- 事务支持弱:MongoDB 4.0+支持多文档事务,但性能和成熟度不如PostgreSQL

- 无外键约束:引用完整性需要应用层保证

- 过度嵌套:为了避免JOIN而将订单项嵌套在订单中,导致查询复杂

何时MongoDB合适?

- 数据确实是半结构化(如不同商品的属性差异大)

- 不需要复杂JOIN(如内容管理系统、用户配置)

- 可以接受最终一致性

何时应该用关系型?

- 订单系统通常需要强一致性、事务、复杂查询

- 订单-订单项-商品-用户的关系清晰,适合规范化

9.4 错误4:用Cassandra存储需要强一致性的数据

问题描述:

将金融交易数据存储在Cassandra中。

为什么错误?

- 最终一致性:Cassandra默认最终一致性,可能读到旧数据

- 无跨分区事务:不同分区键的数据不能保证原子性

- 轻量事务性能差:虽然支持Lightweight Transactions(Paxos),但性能是普通写入的1/10

正确方案:

- 强一致性需求 → PostgreSQL、MySQL、NewSQL(CockroachDB、TiDB)

- 日志型数据、时间序列 → Cassandra适合

9.5 错误5:为了"技术时髦"引入过多数据库

问题描述:

一个小型应用同时使用PostgreSQL、MongoDB、Redis、Elasticsearch、Neo4j。

为什么错误?

- 运维复杂度:每种数据库需要监控、备份、调优

- 一致性难保证:多个数据库间同步容易出错

- 学习成本高:团队需要掌握多种数据库

- 过度设计:可能PostgreSQL + Redis就能满足需求

原则:

- 从简单开始:初期只用PostgreSQL可能就够了

- 按需扩展:当出现明确性能瓶颈时再引入新数据库

- 评估收益与成本:新数据库带来的收益是否超过运维成本

十、数据库选型决策树

为了帮助工程实践中的选型,我们提供一个简化的决策树:

[开始]

↓

数据是否有强一致性要求(如金融、订单)?

├─ 是 → 数据结构是否复杂(多表关联)?

│ ├─ 是 → PostgreSQL / MySQL

│ └─ 否 → NewSQL(TiDB、CockroachDB)或 PostgreSQL

└─ 否 → 数据访问模式是什么?

├─ 简单Key-Value,高速访问 → Redis / Memcached

├─ 时序数据,时间范围查询 → InfluxDB / Prometheus

├─ 半结构化,嵌套数据 → MongoDB / Couchbase

├─ 全文搜索,日志分析 → Elasticsearch

├─ 大规模写入,宽表 → Cassandra / HBase

├─ 图关系,复杂遍历 → Neo4j / Neptune

└─ 大数据分析,OLAP → ClickHouse / Snowflake关键考量因素:

- 一致性需求:ACID vs 最终一致性

- 数据结构:结构化 vs 半结构化 vs 无结构

- 访问模式:点查询 vs 范围扫描 vs 全文搜索 vs 图遍历

- 读写比例:读多写少 vs 写多读少 vs 平衡

- 扩展需求:单机足够 vs 需要水平扩展

- 查询复杂度:简单KV vs JOIN vs 聚合分析

- 延迟要求:微秒 vs 毫秒 vs 秒级

十一、权威参考资料与进一步学习

11.1 经典数据库论文

关系型数据库:

- Codd, E.F. (1970) : A Relational Model of Data for Large Shared Data Banks . CACM, 13(6).

- 关系模型的奠基之作

- Gray, J., et al. (1976) : Granularity of Locks and Degrees of Consistency in a Shared Data Base . IBM Research.

- 事务隔离级别的定义

分布式数据库:

- DeCandia, G., et al. (2007) : Dynamo: Amazon's Highly Available Key-value Store . SOSP.

- 最终一致性、一致性哈希、向量时钟

- Chang, F., et al. (2006) : Bigtable: A Distributed Storage System for Structured Data . OSDI.

- Google的列族数据库

- Lakshman, A., Malik, P. (2010) : Cassandra: A Decentralized Structured Storage System . SIGOPS.

- Cassandra的设计

存储引擎:

- O'Neil, P., et al. (1996) : The Log-Structured Merge-Tree (LSM-tree) . Acta Informatica.

- LSM树的原理

- Pelkonen, T., et al. (2015) : Gorilla: A Fast, Scalable, In-Memory Time Series Database . VLDB.

- Facebook的时序数据压缩算法

分布式共识:

- Lamport, L. (1998) : The Part-Time Parliament (Paxos). TOCS.

- Ongaro, D., Ousterhout, J. (2014) : In Search of an Understandable Consensus Algorithm (Raft). USENIX ATC.

11.2 专业书籍

数据库理论:

- Designing Data-Intensive Applications by Martin Kleppmann(强烈推荐)

- 系统性讲解数据库模型、分布式系统、数据处理

- Database System Concepts by Silberschatz, Korth, Sudarshan

- 经典教科书,理论全面

实践指南:

- High Performance MySQL by Baron Schwartz, et al.

- MySQL调优与架构

- Redis in Action by Josiah Carlson

- Redis实践模式

- MongoDB: The Definitive Guide by Kristina Chodorow

- MongoDB深入指南

分布式系统:

- Distributed Systems by Maarten van Steen, Andrew S. Tanenbaum

- 分布式系统理论

11.3 在线资源

官方文档:

- PostgreSQL: https://www.postgresql.org/docs/

- Redis: https://redis.io/documentation

- InfluxDB: https://docs.influxdata.com/

- MongoDB: https://docs.mongodb.com/

- Cassandra: https://cassandra.apache.org/doc/

学习平台:

- CMU Database Group (YouTube):Andy Pavlo教授的数据库课程

- Martin Kleppmann's Blog:数据系统深度文章

- Jepsen (jepsen.io):分布式系统一致性测试报告

十二、总结:构建数据库模型的思维框架

通过这篇文章,我们系统性地探讨了数据库模型的核心概念、演进历史和工程实践。让我们回顾几个关键要点:

12.1 核心认知

-

数据库模型比产品特性更重要

- 产品特性成百上千,但核心模型只有少数几种

- 理解模型才能理解本质差异

-

四个维度看透数据库

- 数据模型:数据如何组织

- 存储模型:数据如何存储

- 访问模型:如何查询数据

- 一致性模型:并发与分布式下的保证

-

没有银弹

- 每种模型都是特定权衡的结果

- CAP定理、读写权衡、一致性权衡无法回避

-

Polyglot Persistence是趋势

- 现代应用需要多种数据库协同工作

- 关键是为每种数据选择最合适的存储

12.2 实践原则

-

从业务需求出发

- 不要为了技术而技术

- 明确一致性要求、访问模式、扩展需求

-

从简单开始,按需扩展

- 初期单个数据库可能就够了

- 当出现明确瓶颈时再引入新数据库

-

关注运维成本

- 每引入一个数据库都增加复杂度

- 评估收益与成本

-

理解权衡,做明智的妥协

- 没有完美的方案

- 清楚地知道自己在牺牲什么、获得什么

12.3 持续学习

数据库技术在不断演进:

- NewSQL:尝试突破传统关系型数据库的扩展性瓶颈

- Cloud-Native数据库:针对云环境优化(如Aurora、Snowflake)

- 向量数据库:为AI应用优化(如Pinecone、Milvus)

- 流数据库:实时数据处理(如Apache Flink)

但无论技术如何变化,理解模型、理解权衡的思维方式是永恒的。

最后:

"数据库选型不是选择'最好'的数据库,而是为特定问题选择'最合适'的数据库。理解模型,理解权衡,你就掌握了选型的本质。"

希望这篇文章能帮助你建立完整的数据库模型认知框架,在工程实践中做出理性的决策。如果你是初学者,希望你建立了正确的整体认知;如果你是资深工程师,希望你深化了对模型本质的理解。

数据库不仅是存储数据的工具,更是一种思维方式,一种对数据的理解和抽象。 掌握这种思维,你就掌握了构建数据密集型应用的核心能力。