站在十字路口,你只需极短的一瞥,大脑就能瞬间给视野里的东西打上"标签":那辆红色的巴士正在进站,人行道上的小孩在奔跑,侧方还有外卖车在加速。这种近乎直觉的反应,计算机曾学得极为吃力。直到 YOLO 横空出世。You Only Look Once------在画面捕捉的瞬间,分类与定位同步完成。让目标检测告别了地毯式搜索,像人的直觉一样,真正赋予了机器实时思考的灵魂。

视觉的"直觉":YOLO 的回归哲学

在 YOLO 诞生之前,计算机视觉领域其实一直被两阶段(Two-stage)架构统治着。那时候检测一个物体,得先靠算法抠出几千个候选区域(Region Proposals),再逐个进行分类。YOLO 的天才之处,在于它彻底推翻了这种"先提案再审批"的繁琐,将目标检测从分类任务重构为端到端的回归问题。

当你把一张图像输入YOLO 网络时,它会快刀斩乱麻,直接将画面划分成S*S 个网格。每一个网格不仅是图像的一块切片,更是网络输出张量(Tensor)中的一个特征点。

- 张量一体化预测: 每一个网格都会直接预测出多个边界框(Bounding Boxes)的坐标信息 (x, y, w, h),以及一个代表"这里到底有没有物体"的置信度评分(Confidence Score)。

- 分类与定位的并行: 在预测坐标的同时,每个网格还要计算出一组类别概率。这意味着定位和分类这两件事,是在神经网络的同一层输出中、以完全并行的方式完成的。

- 全局特征耦合: 因为网络是端到端设计的,它在做决策时拥有整张图像的全局信息。相比于传统算法只盯着局部候选区域,YOLO 这种"大局观"让它能更准确地识别背景噪点,不容易把奇形怪状的云朵误认成飞鸟。

YOLO 的行业AI 视觉

很多人觉得 AI 很遥远,但说实话,在那些我们看不见的角落,YOLO 早就在"卷"了。

智慧工地: 在粉尘弥漫或光照极差的隧道施工现场,YOLOv9 展现了极强的特征提取能力。行为合规检测: 不仅能识别安全帽、反光衣的有无,还能通过细节特征判定佩戴是否规范(如是否系好帽带、拉好拉链)。高并发处理: 支持单帧 50 人以上的大规模实时检测,配合红外成像技术,实现了从"人眼盯防"到"全天候自动预警"的跨越。

城市治理: 城管与综治场景对算法的抗干扰能力要求极高。静态治理: 结合历史影像比对与语义分割,系统能精准识别新增违章建筑、垃圾堆积或占道经营,甚至能自动量化违规面积与体积。动态保障: 基于姿态识别(OpenPose/YOLO-Pose),系统能敏锐捕捉"人员倒地"等异常行为,并联动急救系统。在密集人流中,通过密度聚类算法(DBSCAN)实时监控拥挤度,预防踩踏风险。

电力巡检: 在地下电缆隧道或高压输电塔等高危区域多模态融合: 融合激光雷达点云与红外热成像,可在 30 米外非接触式检测变压器异常发热、避雷器泄漏电流或杆塔倾斜(精度达 0.1°)。缺陷自动判定: 针对电缆破损、支架腐蚀等细微隐患,识别准确率超过 92%,极大提升了运维效率并保障了人员安全。

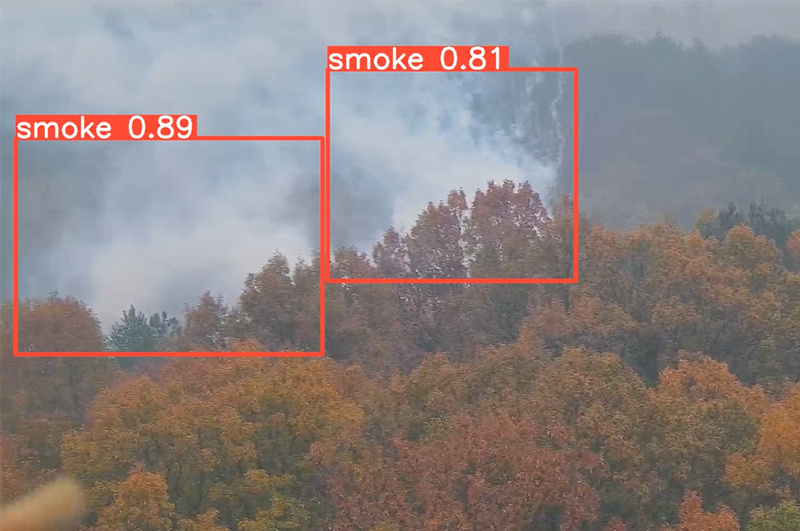

森林防火: 面对大面积、无固定形状的烟火检测,YOLO 展现了极速的响应能力。烟火精准判别: 结合图像特征与热辐射数据,能在 2 秒内区分野火、篝火或农田焚烧,抗云层和植被阴影干扰能力极强。态势感知: 整合 GIS 地理信息与随机森林模型,系统不仅能发现火情,还能结合风速、地形预测蔓延趋势,为现场调度提供可视化图谱。

RK3588/RK3576 的算力极致优化

说实话,在显卡上跑分只是热身,真正能让 YOLO 落地生根的,是把它塞进瑞芯微 RK3588 或 RK3576 这种指甲盖大小的芯片里。这不仅是一次简单的代码迁移,更是一场关于算力、带宽和内存的"极限压榨"。想要在这些 SoC 平台上实现毫秒级的目标检测,通常要:

"翻译"模型: 芯片的 NPU(神经网络处理器)有自己的脾气,它看不懂 PyTorch 原生的 .pt 训练文件。通过 RKNN-Toolkit2 ,把模型转成 ONNX 格式,再揉碎、重构成芯片能听懂的 .rknn 格式。看着那些复杂的算子被重新编排成 NPU 最爱的计算路径。

"瘦身"压缩: 原生的 FP32(32位浮点数)模型参数量极大,对于嵌入式芯片的带宽和存储是巨大的负担。通过量化算法将权重和激活值从 32 bit 压缩至 8 bit,内存占用直接缩减 75%。这不仅缓解了 DDR 带宽压力,更有效降低了计算功耗。

"搬运"调优: 即便模型够快,如果 CPU 忙着在内存里搬运视频流,NPU 照样得"坐冷板凳"。为了不浪费每一毫秒, 利用 DMA-BUF 零拷贝技术 ,实现视频流数据在 ISP、GPU 与 NPU 之间的显存共享,彻底消除 CPU 拷贝开销再加上异步推理的并行逻辑,前一张图还在卷积运算,下一张图已经排队进场。这种行云流水的协同,才让实时视频流在芯片上跑出了如丝般顺滑的质感。

哪一款 YOLO 才是你的"本命"?

在嵌入式端部署时,版本的选择并非单纯"追新",而是需要权衡算力开销、算子兼容性以及特定任务的精度需求。

工程化标杆:YOLOv5

作为生态最成熟的版本,YOLOv5 在工业界具有极高的稳定性和部署覆盖率。技术特点: 采用 Anchor-based 机制,架构设计灵活(从 Nano 到 Huge 多个尺度)。部署优势: 瑞芯微 RKNN 工具链对其支持最为完善,算子兼容性极佳,是追求项目快速落地与高稳定性的首选。

全能型架构:YOLOv8

YOLOv8 引入了 Anchor-free 机制,实现了检测、分割、姿态估计(Pose)的统一架构。技术特点: 采用 C2f 模块增强特征流动,通过解耦头(Decoupled Head)提升了回归精度。部署优势: 在处理多任务并行(如同时进行目标检测与人体关键点提取)时,具有极佳的精度与速度平衡,是目前 RK3588 等高性能 SoC 上的主流方案。

端到端性能飞跃:YOLOv10

针对实时检测中的后处理瓶颈,YOLOv10 实现了突破性的进展。技术特点: 引入 NMS-free(无非极大值抑制) 策略,通过一对多与一对一匹配的对齐设计,消除了推理延迟中的非确定性。部署优势: 在边缘端,NMS 往往占据显著的 CPU 耗时,YOLOv10 彻底解决了这一性能损耗,使推理流程在 SoC 硬件上表现出更优的线性稳定性。

高精度演进:YOLOv11 与 VajraV1

这是目前面向复杂场景的最新技术迭代,侧重于细分特征的捕获。技术特点: YOLOv11 优化了轻量化注意力机制(C3k2/C2PSA),而 VajraV1 则在此基础上针对边缘端做了深度定制,通过加宽核心卷积和低秩引导设计,显著提升了复杂环境下的鲁棒性。部署优势: 针对密集目标、遮挡场景以及高精度姿态感知(如安全帽佩戴细节、精细动作识别)具有显著优势,代表了目前 YOLO 家族在嵌入式端能达到的最高检测精度上限。

算法的进化降低了感知的门槛,而芯片的普惠则拓宽了智能的边界。