深度学习框架TensorFlow与PyTorch的演进对比,系统讲解了神经网络基础结构、训练流程、数据处理及PyTorch核心组件的使用方法。

1. 框架对比与演进

- TensorFlow与PyTorch发展:TensorFlow曾为工业界主流,因静态图机制在2018年前广泛用于大厂代码;PyTorch因动态图机制更适科研,随学生毕业进入工业界,现企业使用比例约五五开,学术界几乎全面采用PyTorch。

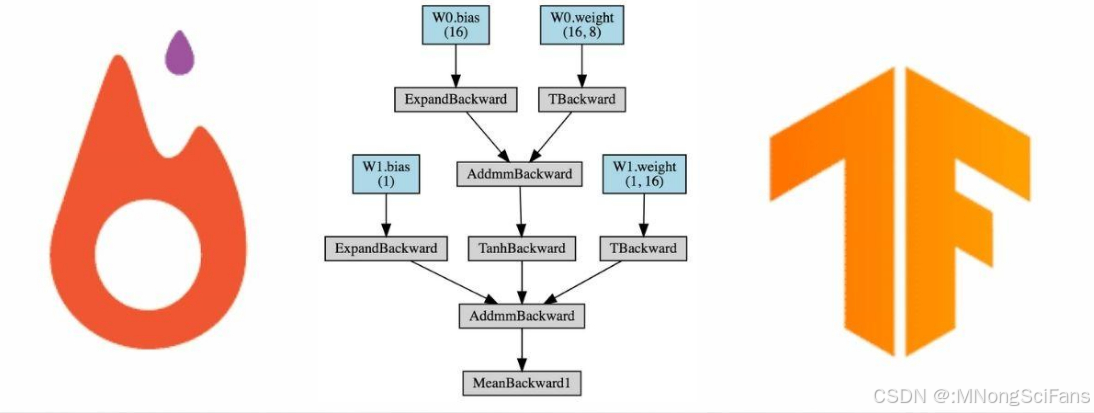

- 静态图与动态图区别:TensorFlow为静态图,模型结构固定,修改困难但推理优化空间大;PyTorch为动态图,支持运行时修改网络结构,更适合研发与科研。

- 推理框架差异:PyTorch主要用于训练,推理常用ONNX等专用框架;工业场景如自动驾驶对延时要求高(如0.01秒),需替换推理框架并保证参数等价迁移。

2. 神经网络基础与训练流程

- 感知机与激活函数:神经网络最小单元为感知机,权重为可更新参数;激活函数实现非线性变换并限制输出范围(如ReLU限制在[0,1])。

- 训练Pipeline:标准流程为:加载数据 → 选择损失函数 → 计算梯度 → 使用优化器进行梯度下降 → 训练 → 验证 → 测试 → 保存最优checkpoint。

- 数据集划分:训练集、验证集、测试集比例通常为7:2:1或8:2:0;验证集用于每轮训练后选择最优模型参数,测试集用于最终评估。

3. PyTorch核心组件与数据处理

- DataLoader与Dataset:DataLoader通过yield实现按需加载批次数据,避免内存溢出;Dataset封装原始数据,需先shuffle打乱顺序以保证训练集与验证集同分布。

- Tensor操作:Tensor为神经网络中向量/矩阵的统一表示,支持reshape、transpose、维度增减等操作,用于连接并行网络层或适配运算维度。

- 数据增强与读取:图像数据常用CSV、JSON格式,或通过Hadoop等数据中台拉取;数据增强包括裁剪、翻转等,提升模型泛化能力。

4. 模型构建与优化策略

- 网络搭建结构:通用结构为输入层 → 中间层(线性层、卷积层、激活函数、批量归一化) → 输出层;卷积层依赖局部感知域与卷积核,批量归一化用于加速训练、防止梯度爆炸。

- 损失函数与优化器:损失函数衡量预测与真实值差异(如MSE);优化器如Adam、SGD控制参数更新策略,Adam因综合性能常为首选。

- 梯度计算与反向传播:通过loss.backward()触发自动梯度计算,参数更新可并行进行,因各权重独立;梯度消失/爆炸常表现为loss为0或NaN。

5. 应用场景与工程实践

- 典型任务分类:NLP核心为意图识别与槽位填充;CV核心为图像分类、目标检测(如人脸识别);大模型替代传统NLP任务,但底层机制仍依赖意图与槽位。

- 阈值与动态调整:识别任务依赖阈值判断(如人脸相似度),阈值需随数据分布动态调整。

- 开发工具与版本管理:推荐使用conda安装PyTorch,Jupyter Notebook为常用开发环境;GitLab/GitHub为代码版本管理核心工具,源码阅读能力是进阶关键。