架构原理

架构总结图

plain

┌─────────────────────────────────────────────────────────┐

│ 用户层 │

│ Web UI (Next.js) → 可视化 Canvas → 生成 DSL JSON │

└───────────────────────┬─────────────────────────────────┘

│ HTTP/SSE

↓

┌─────────────────────────────────────────────────────────┐

│ Flask API 层 (Gunicorn) │

│ - DSL 校验 (Hash 冲突检测) │

│ - 鉴权 & 多租户隔离 │

│ - SSE 流式输出 (AppQueueManager) │

└───┬───────────────────┬─────────────────────────────────┘

│ │

│ 异步任务 │ 同步执行

↓ ↓

┌─────────────────┐ ┌────────────────────────────────────┐

│ Celery Worker │ │ GraphEngine (Workflow 执行) │

│ ━━━━━━━━━━━━━ │ │ - 解析 DSL (nodes + edges) │

│ 队列隔离: │ │ - 变量池 (VariablePool) │

│ • dataset │ │ - 事件驱动 DAG 遍历 │

│ • priority_ds │ │ - 节点并行执行 (WorkerPool) │

│ • trigger │ │ - SSRF Proxy 防护 │

│ │ └────────────────────────────────────┘

│ 任务类型: │ │

│ • 文档向量化 │ │ 事件流

│ • 长文清洗 │ ↓

│ • 定时任务 │ ┌────────────────────┐

└────┬────────────┘ │ Redis Pub/Sub │

│ │ - 任务队列 │

│ │ - 分布式锁 │

│ │ - SSE 消息缓存 │

│ └────────────────────┘

↓ │

┌─────────────────────────────┴───────────────────────────┐

│ PostgreSQL + pgvector │

│ - workflows.graph (DSL 存储) │

│ - workflow_runs (执行日志) │

│ - datasets + embeddings (向量数据) │

└─────────────────────────────────────────────────────────┘深度原理剖析

- 核心机制 :

- 异步调度引擎:Celery + Redis 实现任务队列分流,将同步 API 请求转换为异步处理,避免阻塞主线程

- 协程优化:Gevent 补丁将阻塞 IO 操作协程化,提升并发处理能力 (psycopg2 + gRPC 双重优化)

- 应用上下文管理:FlaskTask 包装器确保每个异步任务拥有独立的请求上下文,维持日志追踪和数据库会话隔离

- 定时任务编排:Beat Scheduler 管理周期性清理任务 (缓存清理、数据集清理、队列监控等),防止资源累积

- 设计模式 :

- 适配器模式:FlaskTask 适配 Celery Task 接口,注入 Flask 应用上下文

- 工厂模式 :

create_app()工厂函数通过扩展注册机制动态组装功能模块 - 策略模式:SSL 配置和 Sentinel 模式根据环境配置动态切换连接策略

为何选择 Low-Code DSL 驱动范式?

- 前后端完全解耦

- 前端(Next.js)负责可视化 Canvas 编排,生成 标准 JSON DSL

- 后端(Flask)只关心 DSL 解析 → 执行引擎 → 结果返回

- 任何符合 DSL Schema 的前端都可对接(Web/移动端/第三方工具)

- 执行引擎可版本化

- DSL 持久化到

workflows.graph字段(LongText) - 支持 Draft 版本 (

<font style="color:#DF2A3F;">version='draft'</font>)和 Published 版本(唯一版本号) - 可随时回滚到历史版本,实现 时间旅行调试

- DSL 持久化到

- 节点插件化扩展

- 每个节点类型(LLM、HTTP、Code、Agent)对应独立的

<font style="color:#DF2A3F;">Node</font>类 - 通过 工厂模式 (

node_factory.py) 动态加载节点实现 - 新增节点类型无需修改核心引擎代码

- 每个节点类型(LLM、HTTP、Code、Agent)对应独立的

json

{

"nodes": [

{"id": "start", "type": "start", "data": {...}},

{"id": "llm-1", "type": "llm", "data": {"model": "gpt-4", ...}},

{"id": "http-1", "type": "http_request", "data": {"url": "...", ...}}

],

"edges": [

{"source": "start", "target": "llm-1"},

{"source": "llm-1", "target": "http-1"}

],

"viewport": {...}

}Flask + Celery 高并发架构设计

职责分离原则

| 组件 | 职责 | 技术选型 |

|---|---|---|

| Flask (Gunicorn) | 轻量 API 层 | 处理 HTTP 请求、鉴权、DSL 验证、流式 SSE 输出 |

| Celery Worker | 重计算任务 | 文档清洗、向量化、长文本 Embedding、定时任务 |

| Redis | 消息总线 + 缓存 | Celery Broker、任务队列、分布式锁、SSE Pub/Sub |

| PostgreSQL | 持久化层 | DSL 存储、用户数据、执行日志、向量数据(pgvector) |

队列隔离策略

多队列设计:

dataset队列:普通知识库任务(FIFO)priority_dataset队列:VIP 租户优先任务- 租户隔离队列 (

TenantIsolatedTaskQueue):防止单租户任务占满队列

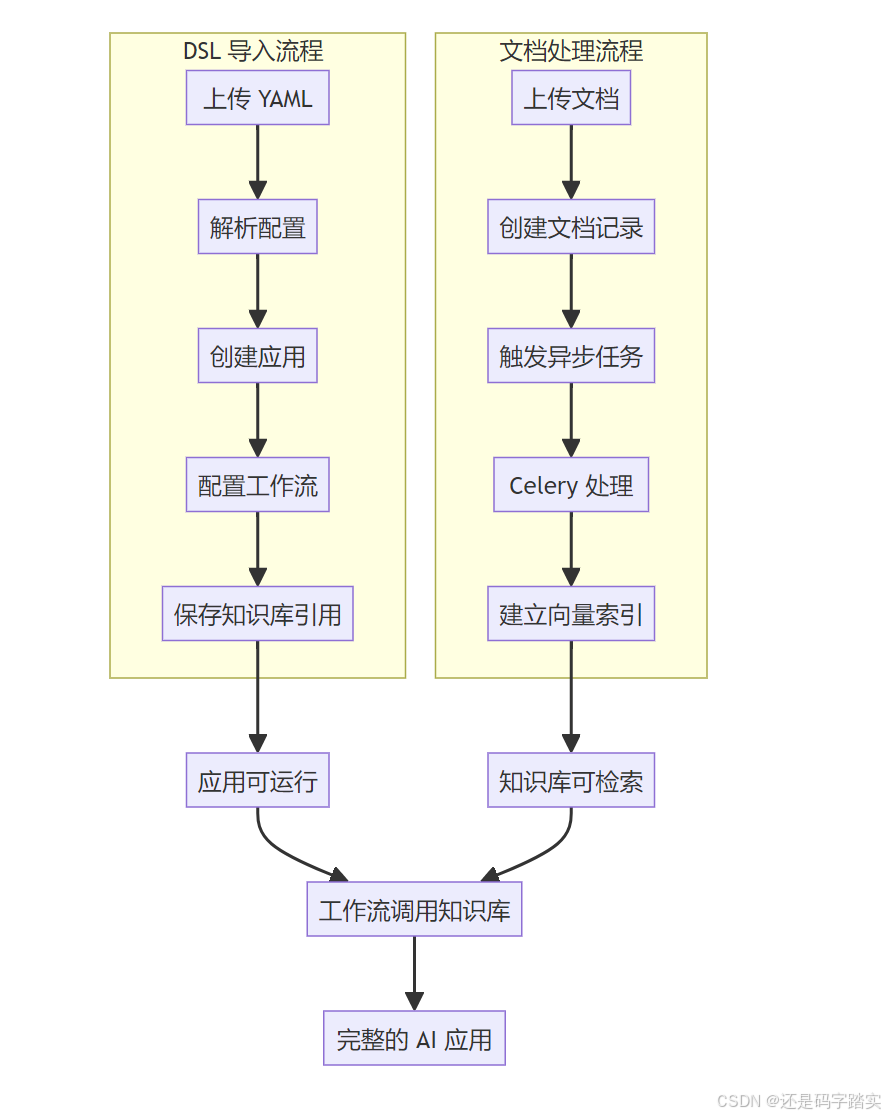

workflow/DSL 导入与文档处理的完整链路详解

从前端上传到workflow应用创建的完整链路

步骤 1: DSL 导入请求接收

核心入口函数 :AppImportApi.post()

文件位置 :api/controllers/console/app/app_import.py

python

@console_ns.route("/apps/imports") # API 路由定义

class AppImportApi(Resource):

def post(self):

# 步骤1: 用户身份验证

current_user, _ = current_account_with_tenant()

# 步骤2: 参数验证

args = AppImportPayload.model_validate(console_ns.payload)

# 步骤3: 调用业务服务处理 DSL

with Session(db.engine) as session:

import_service = AppDslService(session)

result = import_service.import_app(

account=current_user,

import_mode=args.mode, # "yaml-content" 或 "yaml-url"

yaml_content=args.yaml_content, # YAML 字符串内容

yaml_url=args.yaml_url, # 或者 YAML 文件 URL

name=args.name, # 应用名称

description=args.description, # 应用描述

# ... 其他参数

)

session.commit() # 提交数据库事务步骤 2: DSL 解析与版本兼容性检查

核心入口函数 :AppDslService.import_app()

文件位置 :api/services/app_dsl_service.py

python

def import_app(self, account: Account, import_mode: str, yaml_content: str | None = None, ...) -> Import:

# 步骤1: 模式验证

mode = ImportMode(import_mode)

# 步骤2: 获取 YAML 内容

content = ""

if mode == ImportMode.YAML_URL:

response = ssrf_proxy.get(yaml_url.strip(), follow_redirects=True, timeout=(10, 10))

content = response.content.decode()

# 步骤3: YAML 解析与验证

data = yaml.safe_load(content)

if not isinstance(data, dict):

raise ValueError("Invalid YAML format")

# 步骤4: 版本兼容性检查 ⭐⭐⭐ 核心逻辑

imported_version = data.get("version", "0.1.0")

status = _check_version_compatibility(imported_version)

# 如果版本不兼容,缓存到 Redis 等待用户确认

if status == ImportStatus.PENDING:

redis_client.setex(f"{IMPORT_INFO_REDIS_KEY_PREFIX}{import_id}", IMPORT_INFO_REDIS_EXPIRY, ...)

return Import(id=import_id, status=status)

# 步骤5: 依赖分析

dependencies = data.get("dependencies", [])

# 分析插件依赖,检查租户是否有权限使用

# 步骤6: 创建应用 ⭐⭐⭐ 核心逻辑

app = self._create_or_update_app(...)

return Import(id=import_id, status=ImportStatus.COMPLETED, app_id=app.id)步骤 3: 创建应用(数据持久化到 PostgreSQL)

核心入口函数 :_create_or_update_app()

文件位置 :api/services/app_dsl_service.py

python

def _create_or_update_app(self, app: App | None, data: dict, account: Account, ...) -> App:

# 步骤1: 提取应用基本信息

app_data = data.get("app", {})

app_mode = AppMode(app_data.get("mode")) # workflow/advanced-chat/chat 等

# 步骤2: 创建或更新应用记录

if app: # 更新现有应用

app.name = name or app_data.get("name", app.name)

app.updated_by = account.id

app.updated_at = naive_utc_now()

else: # 创建新应用

app = App()

app.id = str(uuid4())

app.tenant_id = account.current_tenant_id

app.mode = app_mode.value

app.created_by = account.id

app.updated_by = account.id

self._session.add(app)

self._session.commit() # 提交到数据库

# 步骤3: 根据应用模式初始化配置 ⭐⭐⭐ 核心分支逻辑

if app_mode in {AppMode.ADVANCED_CHAT, AppMode.WORKFLOW}:

# 处理工作流配置

workflow_data = data.get("workflow", {})

workflow_service = WorkflowService()

workflow_service.sync_draft_workflow(

app_model=app,

graph=workflow_data.get("graph", {}), # 节点图结构

features=workflow_data.get("features", {}), # 功能配置

# ... 其他参数

)

elif app_mode in {AppMode.CHAT, AppMode.AGENT_CHAT, AppMode.COMPLETION}:

# 处理模型配置

model_config = data.get("model_config", {})

app_model_config = AppModelConfig().from_model_config_dict(model_config)

self._session.add(app_model_config)

return app从文档上传到向量化的完整链路

步骤 1: 文档上传请求接收

核心入口函数 :DatasetService.save_document_with_dataset_id()

文件位置 :api/services/dataset_service.py

python

def save_document_with_dataset_id(

dataset: Dataset,

knowledge_config: KnowledgeConfig,

account: Account,

dataset_process_rule: DatasetProcessRule | None = None,

created_from: str = "web",

) -> tuple[list[Document], str]:

# 步骤1: 权限和配额检查

features = FeatureService.get_features(account.current_tenant_id)

# 检查文档数量限制、文件大小等

# 步骤2: 根据数据源类型处理文档

if knowledge_config.data_source.info_list.data_source_type == "upload_file":

# 文件上传处理

for file_detail in file_details:

document = DocumentService.build_document(...)

db.session.add(document)

document_ids.append(document.id)

# 步骤3: 提交数据库事务

db.session.commit()

# 步骤4: 触发异步文档处理 ⭐⭐⭐ 关键触发点

if document_ids:

DocumentIndexingTaskProxy(dataset.tenant_id, dataset.id, document_ids).delay()

return documents, batch步骤 2: 智能任务路由与分发

核心入口函数 :DocumentIndexingTaskProxy.delay()

文件位置 :api/services/document_indexing_proxy/document_indexing_task_proxy.py

python

class DocumentIndexingTaskProxy(BatchDocumentIndexingProxy):

def delay(self):

"""根据计费计划智能路由任务"""

self._dispatch() # 调用基类的分发逻辑

plain

DocumentIndexingTaskProxy

↓ 继承自

BatchDocumentIndexingProxy

↓ 继承自

DocumentTaskProxyBase ← delay() 方法定义在这里

def delay(self):

"""Public API: Queue the task asynchronously."""

self._dispatch()分发逻辑 (基类 DocumentTaskProxyBase):

python

def _dispatch(self):

"""根据计费计划路由任务

路由策略:

- Sandbox 计划 → 普通队列 + 租户隔离

- 付费计划 → 优先队列 + 租户隔离

- 自托管 → 优先队列,无隔离

"""

if self.features.billing.enabled:

if self.features.billing.subscription.plan == CloudPlan.SANDBOX:

self._send_to_default_tenant_queue() # 普通队列

else:

self._send_to_priority_tenant_queue() # 优先队列

else:

self._send_to_priority_direct_queue() # 自托管环境实际的调用链路:

python

# 1. 创建代理实例

proxy = DocumentIndexingTaskProxy(tenant_id, dataset_id, document_ids)

# 2. 调用继承的 delay() 方法

proxy.delay()

↓

# 3. 执行基类的 delay() 方法

self._dispatch()

↓

# 4. 根据计费计划路由任务

if billing.enabled:

if plan == SANDBOX:

_send_to_default_tenant_queue()

else:

_send_to_priority_tenant_queue()

else:

_send_to_priority_direct_queue()步骤 3: Celery 异步文档处理

核心入口函数 :normal_document_indexing_task() 或 priority_document_indexing_task()

文件位置 :api/tasks/document_indexing_task.py

python

@shared_task(queue="dataset") # 或 priority queue

def normal_document_indexing_task(tenant_id: str, dataset_id: str, document_ids: list):

"""普通优先级文档处理任务"""

_document_indexing_with_tenant_queue(tenant_id, dataset_id, document_ids, _document_indexing)不同任务优先级区别:

python

normal_document_indexing_task() 和 priority_document_indexing_task() 的处理流程和步骤是完全一致的!

唯一的区别:

队列不同:普通任务使用 dataset 队列,优先级任务使用 priority_dataset 队列

调度优先级:优先级队列的任务会被 Celery Worker 优先处理

相同点:

调用相同的核心处理函数 _document_indexing()

具有相同的租户隔离队列管理逻辑

执行相同的文档处理四大步骤(提取、转换、保存分段、建立索引)

这种设计的好处是:代码复用。只需要维护一份核心处理逻辑,通过不同的队列装饰器实现不同的优先级调度。实际处理函数 :_document_indexing()

python

def _document_indexing(dataset_id: str, document_ids: Sequence[str]):

# 步骤1: 权限和配额检查

dataset = db.session.query(Dataset).where(Dataset.id == dataset_id).first()

features = FeatureService.get_features(dataset.tenant_id)

# 检查文档数量限制

batch_upload_limit = int(dify_config.BATCH_UPLOAD_LIMIT)

if len(document_ids) > batch_upload_limit:

raise ValueError(f"超出批上传限制 {batch_upload_limit}")

# 步骤2: 更新文档状态为处理中

for document_id in document_ids:

document = db.session.query(Document).where(Document.id == document_id).first()

if document:

document.indexing_status = "parsing"

document.processing_started_at = naive_utc_now()

db.session.add(document)

db.session.commit()

# 步骤3: 执行文档处理 ⭐⭐⭐ 核心处理逻辑

try:

indexing_runner = IndexingRunner()

indexing_runner.run(documents) # 四大处理步骤

except Exception as e:

logger.exception("文档处理失败")

finally:

db.session.close()步骤 4: 文档处理四大步骤

核心入口函数 :IndexingRunner.run()

文件位置 :api/core/indexing_runner.py

python

def run(self, dataset_documents: list[DatasetDocument]):

for dataset_document in dataset_documents:

try:

# 获取数据集和处理规则

dataset = db.session.query(Dataset).filter_by(id=dataset_document.dataset_id).first()

processing_rule = db.session.query(DatasetProcessRule).filter_by(id=dataset_document.dataset_process_rule_id).first()

# 步骤1: 提取 (Extract) - 从原始文件提取文本

text_docs = self._extract(index_processor, dataset_document, processing_rule.to_dict())

# 步骤2: 转换 (Transform) - 文本清洗、分段、向量化

documents = self._transform(

index_processor, dataset, text_docs,

dataset_document.doc_language, processing_rule.to_dict()

)

# 步骤3: 保存分段 (Load Segments) - 保存到数据库

self._load_segments(dataset, dataset_document, documents)

# 步骤4: 建立索引 (Load) - 创建向量索引

self._load(index_processor, dataset, dataset_document, documents)

except Exception as e:

self._handle_indexing_error(dataset_document.id, e)文档处理四大步骤详细说明

Dify 的文档处理采用经典的 ETL (Extract-Transform-Load) 模式,扩展为四个步骤:提取 → 转换 → 保存分段 → 建立索引。

步骤 1: 提取 (Extract) - 从原始文件提取文本

核心方法 :_extract()

文件位置 :api/core/indexing_runner.py:366-446

详细逻辑

python

def _extract(self, index_processor: BaseIndexProcessor, dataset_document: DatasetDocument, process_rule: dict) -> list[Document]:

# 根据数据源类型进行不同处理

if dataset_document.data_source_type == "upload_file":

# 文件上传:PDF、Word、TXT 等

file_detail = db.session.query(UploadFile).get(data_source_info["upload_file_id"])

extract_setting = ExtractSetting(

datasource_type=DatasourceType.FILE,

upload_file=file_detail,

document_model=dataset_document.doc_form, # 文档形式:text_model, qa_model 等

)

text_docs = index_processor.extract(extract_setting, process_rule_mode=process_rule["mode"])

elif dataset_document.data_source_type == "notion_import":

# Notion 导入

extract_setting = ExtractSetting(

datasource_type=DatasourceType.NOTION,

notion_info=NotionInfo(...), # Notion 页面信息

document_model=dataset_document.doc_form,

)

text_docs = index_processor.extract(extract_setting, process_rule_mode=process_rule["mode"])

elif dataset_document.data_source_type == "website_crawl":

# 网站爬取

extract_setting = ExtractSetting(

datasource_type=DatasourceType.WEBSITE,

website_info=WebsiteInfo(...), # 网站信息

document_model=dataset_document.doc_form,

)

text_docs = index_processor.extract(extract_setting, process_rule_mode=process_rule["mode"])

# 更新文档状态为 "splitting"(分段中)

self._update_document_index_status(document_id, "splitting")

return text_docs提取器类型

根据 document_model 选择不同的索引处理器:

| 文档形式 | 处理器类 | 适用场景 |

|---|---|---|

text_model |

ParagraphIndexProcessor |

普通文本文档 |

qa_model |

QaIndexProcessor |

问答对文档 |

parent_child_index |

ParentChildIndexProcessor |

父子索引结构 |

提取结果

返回 list[Document],每个 Document 包含:

page_content: 提取的文本内容metadata: 元数据(文档ID、页码等)

步骤 2: 转换 (Transform) - 文本清洗、分段、向量化

核心方法 :_transform()

文件位置 :api/core/indexing_runner.py:742-776

详细逻辑

python

def _transform(self, index_processor: BaseIndexProcessor, dataset: Dataset,

text_docs: list[Document], doc_language: str, process_rule: dict,

current_user: Account | None = None) -> list[Document]:

# 获取向量化模型实例(仅高质量模式需要)

embedding_model_instance = None

if dataset.indexing_technique == "high_quality":

if dataset.embedding_model_provider:

# 使用指定的向量化模型

embedding_model_instance = self.model_manager.get_model_instance(

tenant_id=dataset.tenant_id,

provider=dataset.embedding_model_provider,

model_type=ModelType.TEXT_EMBEDDING,

model=dataset.embedding_model,

)

else:

# 使用默认向量化模型

embedding_model_instance = self.model_manager.get_default_model_instance(

tenant_id=dataset.tenant_id,

model_type=ModelType.TEXT_EMBEDDING,

)

# 执行转换处理

documents = index_processor.transform(

text_docs=text_docs,

current_user=current_user,

embedding_model_instance=embedding_model_instance,

process_rule=process_rule, # 处理规则

tenant_id=dataset.tenant_id,

doc_language=doc_language, # 文档语言

)

return documents转换处理内容

文本预处理:

- 移除多余空白字符

- 统一编码格式

- 语言检测和处理

分段策略:

- 固定长度分段:按字符数或token数分割

- 智能分段:基于语义分割,保持段落完整性

- 重叠分段:相邻分段有重叠以保持上下文连贯性

向量化处理(仅高质量模式):

- 将文本转换为向量嵌入

- 支持多种向量化模型(OpenAI、Cohere、本地模型等)

步骤 3: 保存分段 (Load Segments) - 持久化到数据库

核心方法 :_load_segments()

文件位置 :api/core/indexing_runner.py:778-800

详细逻辑

python

def _load_segments(self, dataset: Dataset, dataset_document: DatasetDocument, documents: list[Document]):

# 创建文档存储器

doc_store = DatasetDocumentStore(

dataset=dataset,

user_id=dataset_document.created_by,

document_id=dataset_document.id

)

# 保存文档分段到数据库

doc_store.add_documents(

docs=documents,

save_child=dataset_document.doc_form == IndexStructureType.PARENT_CHILD_INDEX

)

# 更新文档状态

cur_time = naive_utc_now()

self._update_document_index_status(

document_id=dataset_document.id,

after_indexing_status="indexing", # 索引中

extra_update_params={

DatasetDocument.cleaning_completed_at: cur_time,

DatasetDocument.splitting_completed_at: cur_time,

DatasetDocument.word_count: sum(len(doc.page_content) for doc in documents),

},

)

# 更新分段状态

self._update_segments_by_document(

dataset_document_id=dataset_document.id,

update_params={

DocumentSegment.status: "indexing",

DocumentSegment.indexing_at: naive_utc_now(),

},

)保存内容

DocumentSegment 表存储:

- 分段文本内容

- 位置信息(position)

- 元数据

- 状态信息

父子索引支持:

- 对于

<font style="color:#DF2A3F;">parent_child_index</font>类型的文档,还会创建父子关系 ChildChunk表存储子分段信息

步骤 4: 建立索引 (Load) - 创建向量和关键词索引

核心方法 :_load()

文件位置 :api/core/indexing_runner.py:550-633

详细逻辑

python

def _load(self, index_processor: BaseIndexProcessor, dataset: Dataset,

dataset_document: DatasetDocument, documents: list[Document]):

# 获取向量化模型(仅高质量模式)

embedding_model_instance = None

if dataset.indexing_technique == "high_quality":

embedding_model_instance = self.model_manager.get_model_instance(...)

# 并发处理设置

indexing_start_at = time.perf_counter()

max_workers = 10

# 经济模式:创建关键词索引

if dataset.indexing_technique == "economy":

create_keyword_thread = threading.Thread(

target=self._process_keyword_index,

args=(current_app._get_current_object(), dataset.id, dataset_document.id, documents),

)

create_keyword_thread.start()

# 高质量模式:并发建立向量索引

if dataset.indexing_technique == "high_quality":

with concurrent.futures.ThreadPoolExecutor(max_workers=max_workers) as executor:

# 将文档分组,避免数据库死锁

document_groups = [[] for _ in range(max_workers)]

for document in documents:

hash = helper.generate_text_hash(document.page_content)

group_index = int(hash, 16) % max_workers

document_groups[group_index].append(document)

# 并发处理每个分组

futures = []

for chunk_documents in document_groups:

if chunk_documents:

future = executor.submit(

self._process_chunk, # 核心处理函数

current_app._get_current_object(),

index_processor,

chunk_documents,

dataset,

dataset_document,

embedding_model_instance,

)

futures.append(future)

# 等待所有任务完成

tokens = 0

for future in futures:

tokens += future.result()

# 等待关键词索引完成

if create_keyword_thread:

create_keyword_thread.join()

# 更新文档状态为完成

indexing_end_at = time.perf_counter()

self._update_document_index_status(

document_id=dataset_document.id,

after_indexing_status="completed",

extra_update_params={

DatasetDocument.tokens: tokens,

DatasetDocument.completed_at: naive_utc_now(),

DatasetDocument.indexing_latency: indexing_end_at - indexing_start_at,

},

)索引类型

高质量模式 (high_quality):

- 向量索引:使用向量化模型将文本转换为向量,建立向量数据库索引

- 并发处理:10个线程并发处理,避免数据库死锁

- 负载均衡:基于内容哈希将文档分配到不同线程

经济模式 (economy):

- 关键词索引:基于TF-IDF等算法建立关键词索引

- 多线程处理:后台线程异步创建关键词索引

性能优化

- 分组处理:通过内容哈希将文档分配到不同线程,避免热点冲突

- 异步关键词索引:与向量索引并行处理,提升整体性能

- 连接池管理:合理使用数据库连接,避免资源耗尽

四大步骤对比总结

| 步骤 | 方法名 | 输入 | 输出 | 主要处理 | 性能特点 |

|---|---|---|---|---|---|

| 提取 | _extract |

原始文件 | list[Document] |

文件解析、文本提取 | IO密集型 |

| 转换 | _transform |

文本文档 | 分段文档 | 清洗、分段、向量化 | 计算密集型 |

| 保存分段 | _load_segments |

分段文档 | 数据库记录 | 数据持久化 | IO密集型 |

| 建立索引 | _load |

分段文档 | 向量索引 | 索引构建 | 计算+IO混合 |

关键设计理念

- 模块化设计:每个步骤职责单一,便于维护和扩展

- 策略模式 :通过

<font style="color:#DF2A3F;">index_processor</font>支持不同文档类型的处理 - 并发优化:高质量模式使用多线程提升性能

- 容错机制:每个步骤都有异常处理和状态更新

- 索引分层:支持向量索引和关键词索引两种模式,满足不同场景需求

这个设计使得 Dify 能够高效处理大规模文档,同时保证数据的一致性和系统的稳定性。

两个流程的区别与联系

流程对比表

| 方面 | DSL 导入流程 | 文档处理流程 |

|---|---|---|

| 触发时机 | 用户上传 YAML 文件 | 用户上传文档文件 |

| 处理对象 | 应用配置信息 | 文档内容数据 |

| 数据库操作 | 创建应用、工作流记录 | 创建文档记录,建立索引 |

| 异步处理 | 无(配置导入很快) | 有(文档处理很慢) |

| Celery 任务 | 不触发 | document_indexing_task.delay() |

| 最终结果 | 应用可运行 | 知识库可检索 |

两个流程的关联

完整链路关键函数总结

DSL 导入链路

| 步骤 | 关键函数 | 位置 | 功能 |

|---|---|---|---|

| 请求接收 | AppImportApi.post |

app_import.py |

API 路由接收 |

| DSL 解析 | AppDslService.import_app |

app_dsl_service.py |

YAML 解析和验证 |

| 版本检查 | _check_version_compatibility |

app_dsl_service.py |

版本兼容性检查 |

| 数据持久化 | _create_or_update_app |

app_dsl_service.py |

创建应用配置 |

文档处理链路

| 步骤 | 关键函数 | 位置 | 功能 |

|---|---|---|---|

| 文档上传 | save_document_with_dataset_id |

dataset_service.py |

文档上传处理 |

| 任务分发 | DocumentIndexingTaskProxy.delay |

document_indexing_proxy.py |

智能路由任务 |

| 异步处理 | normal_document_indexing_task |

document_indexing_task.py |

Celery 任务执行 |

| 文档处理 | IndexingRunner.run |

indexing_runner.py |

四大处理步骤 |

实际场景:run workflows(用户运行工作流,从点击"运行"到看到结果)

场景描述

小明在 Dify 前端可视化界面拖拽了一个简单的工作流:

- 开始节点 (用户输入:

{user_query: "什么是AI?"}) - LLM 节点(调用 GPT-4 回答问题)

- 结束节点(输出答案)

现在小明点击"运行"按钮,后台会发生什么?

完整链路流程图

plain

┌─────────────────────────────────────────────────────────────────┐

│ 第1步:前端发起请求 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 用户点击"运行" → 前端发送 HTTP POST 请求 │

│ POST /api/apps/{app_id}/workflows/run │

│ Body: { │

│ "inputs": {"user_query": "什么是AI?"}, │

│ "files": [] │

│ } │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第2步:Flask Controller 接收请求 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/controllers/console/app/workflow.py │

│ 🔧 函数:DraftWorkflowApi.post() │

│ │

│ 关键操作: │

│ 1. 验证用户权限(@login_required) │

│ 2. 解析请求参数(inputs, files) │

│ 3. 调用 Service 层 │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第3步:AppGenerateService 路由到工作流生成器 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/services/app_generate_service.py │

│ 🔧 函数:AppGenerateService.generate() │

│ │

│ 伪代码: │

│ if app_model.mode == AppMode.WORKFLOW: │

│ workflow = get_workflow(app_id) │

│ return WorkflowAppGenerator().generate( │

│ app_model=app, │

│ workflow=workflow, │

│ user=current_user, │

│ args=request_data, │

│ streaming=True # 开启流式输出 │

│ ) │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第4步:WorkflowAppGenerator 准备执行环境 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/core/app/apps/workflow/app_generator.py │

│ 🔧 函数:WorkflowAppGenerator.generate() │

│ │

│ 关键操作(按顺序): │

│ ┌────────────────────────────────────────────────────────────┐ │

│ │ 1️⃣ 创建 WorkflowAppGenerateEntity │ │

│ │ - task_id: "uuid-1234" │ │

│ │ - inputs: {"user_query": "什么是AI?"} │ │

│ │ - stream: True │ │

│ │ │ │

│ │ 2️⃣ 创建 AppQueueManager(消息队列管理器) │ │

│ │ - 内部维护 Python Queue 用于事件传递 │ │

│ │ - Redis 存储 task_id → user_id 映射 │ │

│ │ │ │

│ │ 3️⃣ 启动后台线程执行工作流 │ │

│ │ Thread(target=WorkflowAppRunner.run).start() │ │

│ │ │ │

│ │ 4️⃣ Flask 主线程进入 listen() 循环 │ │

│ │ while True: │ │

│ │ event = queue_manager.listen() # 阻塞等待事件 │ │

│ │ yield to_sse_format(event) # SSE 流式返回前端 │ │

│ └────────────────────────────────────────────────────────────┘ │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第5步:后台线程执行工作流(核心引擎) │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/core/workflow/workflow_entry.py │

│ 🔧 函数:WorkflowEntry.run() │

│ │

│ 调用链:WorkflowEntry.run() │

│ → GraphEngine.run() │

│ → Dispatcher.dispatch_nodes() (并行调度) │

│ │

│ 执行过程(事件驱动): │

│ ┌────────────────────────────────────────────────────────────┐ │

│ │ 阶段1:初始化 │ │

│ │ ├─ 解析 DSL (workflow.graph) │ │

│ │ ├─ 构建 DAG(节点 + 边) │ │

│ │ ├─ 创建 VariablePool(变量池) │ │

│ │ └─ 发送事件:GraphRunStartedEvent │ │

│ │ │ │

│ │ 阶段2:执行 Start 节点 │ │

│ │ ├─ 从用户输入初始化变量池 │ │

│ │ │ variable_pool.add("user_query", "什么是AI?") │ │

│ │ └─ 发送事件:NodeStartedEvent(node_id="start") │ │

│ │ │ │

│ │ 阶段3:执行 LLM 节点 │ │

│ │ ├─ 从变量池读取输入:query = variable_pool.get("user_query")│ │

│ │ ├─ 调用 OpenAI API (GPT-4) │ │

│ │ ├─ 流式返回 Chunk: │ │

│ │ │ └─ LLMChunkEvent("人工") → Queue → SSE → 前端 │ │

│ │ │ └─ LLMChunkEvent("智能") → Queue → SSE → 前端 │ │

│ │ └─ 输出存入变量池:variable_pool.add("llm_output", "...") │ │

│ │ │ │

│ │ 阶段4:执行 End 节点 │ │

│ │ ├─ 从变量池读取最终输出 │ │

│ │ └─ 发送事件:WorkflowFinishedEvent │ │

│ └────────────────────────────────────────────────────────────┘ │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第6步:事件流转回前端 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 后台线程 → Python Queue → Flask Listen() → SSE → 前端 │

│ │

│ 前端收到的 SSE 事件流: │

│ ┌────────────────────────────────────────────────────────────┐ │

│ │ data: {"event": "workflow_started", ...} │ │

│ │ data: {"event": "node_started", "node_id": "start"} │ │

│ │ data: {"event": "node_finished", "node_id": "start"} │ │

│ │ data: {"event": "node_started", "node_id": "llm-1"} │ │

│ │ data: {"event": "text_chunk", "text": "人工"} │ │

│ │ data: {"event": "text_chunk", "text": "智能"} │ │

│ │ data: {"event": "node_finished", "node_id": "llm-1"} │ │

│ │ data: {"event": "workflow_finished", "outputs": {...}} │ │

│ └────────────────────────────────────────────────────────────┘ │

└─────────────────────────────────────────────────────────────────┘关键函数详解(递归拆解)

应用生成服务的统一入口:AppGenerateService.generate()

python

# 文件:api/services/app_generate_service.py 第25-126行

@classmethod

def generate(cls, app_model: App, user: Union[Account, EndUser], args: Mapping[str, Any],

invoke_from: InvokeFrom, streaming: bool = True, root_node_id: str | None = None):

"""

应用生成服务的统一入口

参数:

- app_model: 应用模型(包含 mode、tenant_id 等)

- user: 当前用户

- args: 请求参数 {"inputs": {...}, "files": [...]}

- streaming: 是否流式输出(True 为 SSE,False 为一次性返回)

返回:

- Generator(流式)或 Dict(非流式)

"""

# 第1步:限流检查(每个应用同时最多N个请求)

max_active_request = cls._get_max_active_requests(app_model)

rate_limit = RateLimit(app_model.id, max_active_request)

request_id = RateLimit.gen_request_key()

try:

request_id = rate_limit.enter(request_id) # 进入限流队列

# 第2步:根据应用模式路由到不同生成器

if app_model.mode == AppMode.WORKFLOW: # ⭐ 工作流模式

workflow_id = args.get("workflow_id")

workflow = cls._get_workflow(app_model, invoke_from, workflow_id)

return rate_limit.generate(

WorkflowAppGenerator.convert_to_event_stream(

WorkflowAppGenerator().generate( # 👈 调用工作流生成器

app_model=app_model,

workflow=workflow,

user=user,

args=args,

invoke_from=invoke_from,

streaming=streaming,

root_node_id=root_node_id,

call_depth=0,

),

),

request_id,

)

# 其他模式(COMPLETION, CHAT, AGENT_CHAT)...

except Exception:

rate_limit.exit(request_id) # 出错时释放限流

raise作用 :这是所有应用执行的统一入口,相当于高铁站的总调度室,根据列车类型(工作流/聊天/补全)分配到不同站台。

工作流生成器的核心逻辑:WorkflowAppGenerator.generate()

python

# 文件:api/core/app/apps/workflow/app_generator.py 第100-300行

def generate(self, *, app_model: App, workflow: Workflow, user: Union[Account, EndUser],

args: Mapping[str, Any], invoke_from: InvokeFrom, streaming: bool = True,

call_depth: int = 0, triggered_from: WorkflowRunTriggeredFrom | None = None,

root_node_id: str | None = None, graph_engine_layers: Sequence[GraphEngineLayer] = ()):

"""

工作流生成器的核心逻辑

这个函数做了3件大事:

1. 准备执行环境(解析文件、验证输入)

2. 创建队列管理器(AppQueueManager)

3. 启动后台线程执行工作流

"""

# 第1步:解析文件上传

files: Sequence[Mapping[str, Any]] = args.get("files") or []

file_extra_config = FileUploadConfigManager.convert(workflow.features_dict, is_vision=False)

system_files = file_factory.build_from_mappings(

mappings=files,

tenant_id=app_model.tenant_id,

config=file_extra_config,

)

# 第2步:转换为应用配置

app_config = WorkflowAppConfigManager.get_app_config(

app_model=app_model,

workflow=workflow,

)

# 第3步:准备用户输入(类型验证 + 变量映射)

inputs: Mapping[str, Any] = args["inputs"]

if self._should_prepare_user_inputs(args):

inputs = self._prepare_user_inputs(

user_inputs=inputs,

variables=app_config.variables,

tenant_id=app_model.tenant_id,

)

# 第4步:创建执行实体(打包所有参数)

workflow_run_id = str(uuid.uuid4())

application_generate_entity = WorkflowAppGenerateEntity(

task_id=str(uuid.uuid4()), # 唯一任务ID

app_config=app_config,

inputs=inputs, # {"user_query": "什么是AI?"}

files=list(system_files),

user_id=user.id,

stream=streaming, # True

invoke_from=invoke_from,

call_depth=call_depth,

workflow_execution_id=workflow_run_id,

)

# 第5步:创建数据库 Repository(用于保存执行记录)

session_factory = sessionmaker(bind=db.engine, expire_on_commit=False)

workflow_execution_repository = DifyCoreRepositoryFactory.create_workflow_execution_repository(

session_factory=session_factory,

user=user,

app_id=application_generate_entity.app_config.app_id,

triggered_from=WorkflowRunTriggeredFrom.APP_RUN,

)

# 第6步:创建队列管理器 ⭐⭐⭐ 核心!

queue_manager = WorkflowAppQueueManager(

task_id=application_generate_entity.task_id,

user_id=application_generate_entity.user_id,

invoke_from=application_generate_entity.invoke_from,

conversation_id=None,

app_mode=app_model.mode,

)

# 第7步:创建执行管道(Pipeline)

generate_task_pipeline = WorkflowAppGenerateTaskPipeline(

application_generate_entity=application_generate_entity,

workflow=workflow,

queue_manager=queue_manager,

conversation_id=None,

message_id=None,

workflow_execution_repository=workflow_execution_repository,

workflow_node_execution_repository=workflow_node_execution_repository,

)

# 第8步:启动后台线程执行工作流 🚀

try:

generate_task_pipeline.process() # 👈 这里启动后台线程

except Exception as e:

queue_manager.publish_error(e, PublishFrom.APPLICATION_MANAGER)

finally:

queue_manager.stop_listen() # 清理资源

# 第9步:Flask 主线程在这里循环,监听队列中的事件

return self._handle_response( # 👈 这里会 yield 事件流

application_generate_entity=application_generate_entity,

workflow=workflow,

generator=generate_task_pipeline,

queue_manager=queue_manager,

)关键点 :这个函数把 Flask 主线程分成了两个角色:

- 主线程 :调用

queue_manager.listen()循环等待事件,通过 SSE 返回给前端 - 后台线程:执行工作流的实际计算(LLM 调用、HTTP 请求等)

监听队列中的事件:AppQueueManager.listen()

python

# 文件:api/core/app/apps/base_app_queue_manager.py 第55-85行

def listen(self):

"""

监听队列中的事件(Flask 主线程在这里循环)

这个函数是 Generator(生成器),每次 yield 一个事件

前端通过 SSE 实时接收这些事件

"""

# 最长监听时间(默认1200秒 = 20分钟)

listen_timeout = dify_config.APP_MAX_EXECUTION_TIME

start_time = time.time()

last_ping_time: int | float = 0

while True:

try:

# 从 Python Queue 中取出事件(阻塞1秒)

message = self._q.get(timeout=1)

if message is None: # 收到停止信号

break

yield message # 👈 返回给前端(SSE)

except queue.Empty: # 队列为空,继续循环

continue

finally:

elapsed_time = time.time() - start_time

# 超时或用户手动停止

if elapsed_time >= listen_timeout or self._is_stopped():

self.publish(

QueueStopEvent(stopped_by=QueueStopEvent.StopBy.USER_MANUAL),

PublishFrom.TASK_PIPELINE

)

# 每10秒发送一次 Ping(心跳检测)

if elapsed_time // 10 > last_ping_time:

self.publish(QueuePingEvent(), PublishFrom.TASK_PIPELINE)

last_ping_time = elapsed_time // 10作用 :这是一个无限循环的生成器,就像一个传送带工人,不停地从队列里拿事件,然后丢给前端。

后台线程执行图引擎:GraphEngine.run()

python

# 文件:api/core/workflow/graph_engine/graph_engine.py 第200-300行

def run(self) -> Generator[GraphEngineEvent, None, None]:

"""

图引擎的核心执行逻辑(在后台线程中运行)

执行步骤:

1. 发送 GraphRunStartedEvent

2. 初始化开始节点到 ready_queue

3. 启动 WorkerPool 并行执行节点

4. 收集执行事件并 yield

5. 发送 GraphRunFinishedEvent

"""

try:

# 第1步:发送开始事件

yield GraphRunStartedEvent(...)

# 第2步:初始化图状态(找到所有入口节点)

self._initialize_graph() # 将 start 节点放入 ready_queue

# 第3步:创建工作线程池(动态扩缩容)

self._worker_pool = WorkerPool(

min_workers=self._min_workers,

max_workers=self._max_workers,

scale_up_threshold=self._scale_up_threshold,

scale_down_idle_time=self._scale_down_idle_time,

)

# 第4步:启动调度器(Dispatcher)

dispatcher = Dispatcher(

ready_queue=self._ready_queue,

worker_pool=self._worker_pool,

stop_event=self._stop_event,

)

# 第5步:启动执行协调器(ExecutionCoordinator)

coordinator = ExecutionCoordinator(

dispatcher=dispatcher,

event_queue=self._event_queue,

edge_processor=self._edge_processor,

error_handler=self._error_handler,

)

# 第6步:开始执行并收集事件

for event in coordinator.run():

# 处理事件(更新图状态、触发下一个节点)

self._handle_event(event)

yield event # 👈 发送到队列

# 第7步:发送完成事件

yield GraphRunSucceededEvent(...)

except Exception as e:

yield GraphRunFailedEvent(error=str(e))核心概念:

- ready_queue:准备就绪的节点队列(类似待办清单)

- WorkerPool:线程池,从 ready_queue 取节点并行执行

- EdgeProcessor:节点执行完后,根据边(Edge)找下一个节点

示例:完整事件流(带时间戳)

假设小明运行的工作流:Start → LLM → End

| 时间 | 事件类型 | 事件内容 | 前端显示 |

|---|---|---|---|

| 0.0s | workflow_started |

{"workflow_id": "wf-123"} |

显示"执行中..." |

| 0.1s | node_started |

{"node_id": "start", "node_type": "start"} |

高亮 Start 节点 |

| 0.2s | node_finished |

{"node_id": "start", "outputs": {"user_query": "什么是AI?"}} |

Start 节点变绿 |

| 0.3s | node_started |

{"node_id": "llm-1", "node_type": "llm"} |

高亮 LLM 节点 |

| 1.5s | text_chunk |

{"text": "人工"} |

实时显示"人工" |

| 1.6s | text_chunk |

{"text": "智能"} |

追加显示"智能" |

| 2.0s | node_finished |

{"node_id": "llm-1", "outputs": {"text": "人工智能..."}} |

LLM 节点变绿 |

| 2.1s | node_started |

{"node_id": "end"} |

高亮 End 节点 |

| 2.2s | workflow_finished |

{"outputs": {"answer": "人工智能..."}} |

显示"执行成功" |

实际场景:用户上传文档(异步任务)

场景描述

小红上传了一个 PDF 文档到知识库,后台需要:

- 分段(Chunking)

- 调用 Embedding 模型生成向量

- 存入 PostgreSQL (pgvector)

这个过程可能需要几分钟,所以要用 Celery 异步任务。

完整链路流程图

plain

┌─────────────────────────────────────────────────────────────────┐

│ 第1步:前端上传文档 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ POST /api/datasets/{dataset_id}/documents │

│ Body (multipart/form-data): │

│ file: document.pdf (二进制) │

│ indexing_technique: "high_quality" # 使用高质量索引 │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第2步:Flask Controller 处理上传 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/controllers/console/datasets/documents.py │

│ 🔧 函数:DocumentAddByFileApi.post() │

│ │

│ 关键操作: │

│ ┌────────────────────────────────────────────────────────────┐ │

│ │ 1️⃣ 保存文件到 Storage (S3/本地) │ │

│ │ storage.save(f"datasets/{dataset_id}/document.pdf") │ │

│ │ │ │

│ │ 2️⃣ 创建 Document 记录(状态=queued) │ │

│ │ document = Document( │ │

│ │ id="doc-456", │ │

│ │ dataset_id="ds-789", │ │

│ │ name="document.pdf", │ │

│ │ indexing_status="queued", # 等待索引 │ │

│ │ created_by=user.id │ │

│ │ ) │ │

│ │ db.session.add(document) │ │

│ │ db.session.commit() │ │

│ │ │ │

│ │ 3️⃣ 发送 Celery 异步任务 ⭐⭐⭐ │ │

│ │ normal_document_indexing_task.delay( │ │

│ │ tenant_id=current_tenant.id, │ │

│ │ dataset_id="ds-789", │ │

│ │ document_ids=["doc-456"] │ │

│ │ ) │ │

│ │ │ │

│ │ 4️⃣ 立即返回响应给前端 │ │

│ │ return {"document_id": "doc-456", "status": "queued"} │ │

│ └────────────────────────────────────────────────────────────┘ │

└───────────────────────────┬─────────────────────────────────────┘

↓ (任务进入 Redis 队列)

┌─────────────────────────────────────────────────────────────────┐

│ 第3步:Celery Worker 接收任务 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/tasks/document_indexing_task.py │

│ 🔧 函数:normal_document_indexing_task() │

│ │

│ Celery Worker 进程(独立进程,不是 Flask): │

│ ┌────────────────────────────────────────────────────────────┐ │

│ │ 队列:dataset (普通优先级) │ │

│ │ 任务:normal_document_indexing_task │ │

│ │ 参数:(tenant_id, dataset_id, document_ids) │ │

│ └────────────────────────────────────────────────────────────┘ │

│ │

│ @shared_task(queue="dataset") │

│ def normal_document_indexing_task(tenant_id, dataset_id, doc_ids):│

│ # 更新文档状态为 "parsing" │

│ document.indexing_status = "parsing" │

│ db.session.commit() │

│ │

│ # 调用核心索引逻辑 │

│ _document_indexing(dataset_id, doc_ids) │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第4步:IndexingRunner 执行索引流程 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/core/indexing_runner.py │

│ 🔧 函数:IndexingRunner.run() │

│ │

│ 核心流程(按顺序): │

│ ┌────────────────────────────────────────────────────────────┐ │

│ │ 阶段1:文档解析 (Extraction) │ │

│ │ ├─ PDF → 文本提取 │ │

│ │ └─ 结果:"人工智能是... (5000字)" │ │

│ │ │ │

│ │ 阶段2:文本分段 (Chunking) │ │

│ │ ├─ 使用分段器:RecursiveCharacterTextSplitter │ │

│ │ ├─ 参数:chunk_size=500, overlap=50 │ │

│ │ └─ 结果: │ │

│ │ Segment 1: "人工智能是计算机科学..." │ │

│ │ Segment 2: "机器学习是人工智能的子领域..." │ │

│ │ Segment 3: "深度学习使用神经网络..." │ │

│ │ │ │

│ │ 阶段3:向量化 (Embedding) │ │

│ │ ├─ 调用 Embedding 模型(如 text-embedding-ada-002) │ │

│ │ ├─ 并发处理(批量调用,每批10个 Segment) │ │

│ │ └─ 结果: │ │

│ │ Segment 1 → [0.12, -0.34, 0.56, ...] (1536维) │ │

│ │ Segment 2 → [0.23, 0.11, -0.45, ...] (1536维) │ │

│ │ Segment 3 → [0.89, 0.02, 0.33, ...] (1536维) │ │

│ │ │ │

│ │ 阶段4:存入数据库 │ │

│ │ ├─ 批量插入 PostgreSQL (document_segments 表) │ │

│ │ └─ pgvector 扩展自动索引向量 │ │

│ │ │ │

│ │ 阶段5:更新文档状态 │ │

│ │ └─ document.indexing_status = "completed" ✅ │ │

│ └────────────────────────────────────────────────────────────┘ │

└───────────────────────────┬─────────────────────────────────────┘

↓

┌─────────────────────────────────────────────────────────────────┐

│ 第5步:租户隔离队列处理下一个任务 │

│ ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━ │

│ 📄 文件:api/tasks/document_indexing_task.py │

│ 🔧 函数:_document_indexing_with_tenant_queue() │

│ │

│ finally 块(任务完成后执行): │

│ ┌────────────────────────────────────────────────────────────┐ │

│ │ # 从租户专属队列取出下一个任务 │ │

│ │ tenant_queue = TenantIsolatedTaskQueue(tenant_id, "doc_idx")││

│ │ next_tasks = tenant_queue.pull_tasks(count=2) # 取2个任务 │ │

│ │ │ │

│ │ if next_tasks: │ │

│ │ for task in next_tasks: │ │

│ │ # 继续触发 Celery 任务 │ │

│ │ normal_document_indexing_task.delay(...) │ │

│ │ else: │ │

│ │ # 队列为空,清理标志位 │ │

│ │ tenant_queue.delete_task_key() │ │

│ └────────────────────────────────────────────────────────────┘ │

│ │

│ ⚙️ 设计目的:防止单租户提交1000个文档占满整个队列 │

└─────────────────────────────────────────────────────────────────┘关键函数详解

Celery Worker 执行索引任务:normal_document_indexing_task()

python

# 文件:api/tasks/document_indexing_task.py 第149-161行

@shared_task(queue="dataset") # ⭐ 声明这是 Celery 任务,路由到 dataset 队列

def normal_document_indexing_task(tenant_id: str, dataset_id: str, document_ids: Sequence[str]):

"""

普通文档索引任务(Celery Worker 执行)

参数:

- tenant_id: 租户ID(用于隔离)

- dataset_id: 数据集ID

- document_ids: 要处理的文档ID列表(可批量)

执行流程:

1. 调用 _document_indexing() 执行实际索引

2. 完成后检查租户队列是否还有待处理任务

3. 如果有,继续触发下一个任务

"""

logger.info("收到普通文档索引任务: %s - %s - %s", tenant_id, dataset_id, document_ids)

# 委托给带租户队列的处理函数

_document_indexing_with_tenant_queue(

tenant_id,

dataset_id,

document_ids,

normal_document_indexing_task # 传入自己(用于递归调用)

)关键点:

@shared_task(queue="dataset"):告诉 Celery 这个任务放到dataset队列<font style="color:#DF2A3F;">.delay()</font>:异步调用方式(Flask 调用后立即返回)

文档索引的核心流程:IndexingRunner.run()

python

# 文件:api/core/indexing_runner.py(简化版)

class IndexingRunner:

def run(self, documents: list[Document]):

"""

文档索引的核心流程

参数:

- documents: 要处理的文档列表

执行步骤:

1. 提取文本

2. 分段

3. Embedding

4. 存储

"""

for document in documents:

try:

# 第1步:提取文本(支持 PDF、Word、TXT 等)

extractor = self._get_extractor(document.file_type)

text = extractor.extract(document.file_path)

# 第2步:文本清洗

cleaned_text = self._clean_text(text)

# 第3步:分段

segments = self._split_to_segments(

cleaned_text,

chunk_size=500,

overlap=50

)

# 结果示例:

# segments = [

# {"content": "人工智能是...", "position": 1},

# {"content": "机器学习是...", "position": 2},

# ]

# 第4步:批量生成向量

embeddings = self._generate_embeddings(

[seg["content"] for seg in segments]

)

# embeddings = [

# [0.12, -0.34, ...], # 1536维向量

# [0.23, 0.11, ...],

# ]

# 第5步:存入数据库

self._save_segments_to_db(

document_id=document.id,

segments=segments,

embeddings=embeddings

)

# 第6步:更新文档状态

document.indexing_status = "completed"

document.indexed_at = naive_utc_now()

db.session.commit()

except Exception as e:

# 出错时标记为 error

document.indexing_status = "error"

document.error = str(e)

db.session.commit()

def _split_to_segments(self, text: str, chunk_size: int, overlap: int) -> list[dict]:

"""

递归字符分段器(RecursiveCharacterTextSplitter)

原理:

1. 优先按段落(\\n\\n)分割

2. 如果段落太长,按句子(。!?)分割

3. 如果句子太长,按字符强制分割

"""

splitter = RecursiveCharacterTextSplitter(

chunk_size=chunk_size,

chunk_overlap=overlap,

separators=["\\n\\n", "\\n", "。", "!", "?", " ", ""]

)

chunks = splitter.split_text(text)

return [

{"content": chunk, "position": i+1}

for i, chunk in enumerate(chunks)

]

def _generate_embeddings(self, texts: list[str]) -> list[list[float]]:

"""

批量生成向量(并发调用 Embedding API)

示例:

texts = ["人工智能是...", "机器学习是..."]

返回:

[

[0.12, -0.34, 0.56, ...], # 第1段的向量

[0.23, 0.11, -0.45, ...] # 第2段的向量

]

"""

embeddings = []

batch_size = 10 # 每批处理10个

for i in range(0, len(texts), batch_size):

batch = texts[i:i+batch_size]

# 调用 Embedding 模型 API

response = self.embedding_model.embed_documents(batch)

embeddings.extend(response.embeddings)

return embeddings

def _save_segments_to_db(self, document_id: str, segments: list[dict],

embeddings: list[list[float]]):

"""

批量插入数据库(使用 pgvector 扩展)

SQL 示例:

INSERT INTO document_segments (id, document_id, content, embedding, position)

VALUES

('seg-1', 'doc-456', '人工智能是...', '[0.12,-0.34,...]', 1),

('seg-2', 'doc-456', '机器学习是...', '[0.23,0.11,...]', 2);

"""

for segment, embedding in zip(segments, embeddings):

segment_model = DocumentSegment(

id=str(uuid.uuid4()),

document_id=document_id,

content=segment["content"],

embedding=embedding, # pgvector 自动处理

position=segment["position"],

)

db.session.add(segment_model)

db.session.commit()时间线示例(带租户隔离)

假设租户A 上传了 3 个文档(doc-1, doc-2, doc-3)

| 时间 | 事件 | Redis 队列状态 | Celery Worker 状态 |

|---|---|---|---|

| 0.0s | 前端上传 doc-1 | tenant:A:doc_idx = [doc-1] |

Worker-1 开始处理 doc-1 |

| 0.5s | 前端上传 doc-2 | tenant:A:doc_idx = [doc-1, doc-2] |

Worker-1 仍在处理 doc-1 |

| 1.0s | 前端上传 doc-3 | tenant:A:doc_idx = [doc-1, doc-2, doc-3] |

Worker-1 仍在处理 doc-1 |

| 5.0s | doc-1 完成 | tenant:A:doc_idx = [doc-2, doc-3] |

Worker-1 从队列取 doc-2 |

| 10.0s | doc-2 完成 | tenant:A:doc_idx = [doc-3] |

Worker-1 从队列取 doc-3 |

| 15.0s | doc-3 完成 | tenant:A:doc_idx = [](清空) |

Worker-1 空闲 |

租户隔离的好处:

- 如果租户B 同时上传文档,会进入独立队列

tenant:B:doc_idx - 不会被租户A 的任务阻塞

可视化总结(Mermaid 流程图)

PostgreSQL IndexingRunner Celery Redis Flask 前端 PostgreSQL IndexingRunner Celery Redis Flask 前端 Flask 立即返回,不等待处理完成 alt [队列为空] [队列有任务] POST /datasets/{id}/documents (上传 PDF) INSERT Document (status=queued) LPUSH task_queue (doc_indexing_task) 200 OK {"status": "queued"} RPOP task_queue (获取任务) run(document) 提取文本 (PDF → Text) 分段 (Text → Segments) Embedding (Segments → Vectors) INSERT Segments (批量插入) UPDATE Document (status=completed) 检查租户队列 (是否还有任务?) DELETE task_key LPUSH next_task

核心要点总结

场景 A(工作流执行)

- Flask 不阻塞 :通过

AppQueueManager + Python Queue实现异步 - SSE 流式输出:前端实时看到每个节点的执行状态

- 后台线程执行 :

<font style="color:#DF2A3F;">GraphEngine</font>在独立线程中运行,支持并行节点 - 事件驱动:节点通过事件(NodeStartedEvent、LLMChunkEvent)通信

场景 B(文档索引)

- Celery 异步:Flask 立即返回,Celery Worker 后台处理

- 租户隔离:每个租户有独立队列,防止相互阻塞

- 批量优化:Embedding 批量调用,数据库批量插入

- 自动重试:Celery 支持任务失败重试(max_retries)

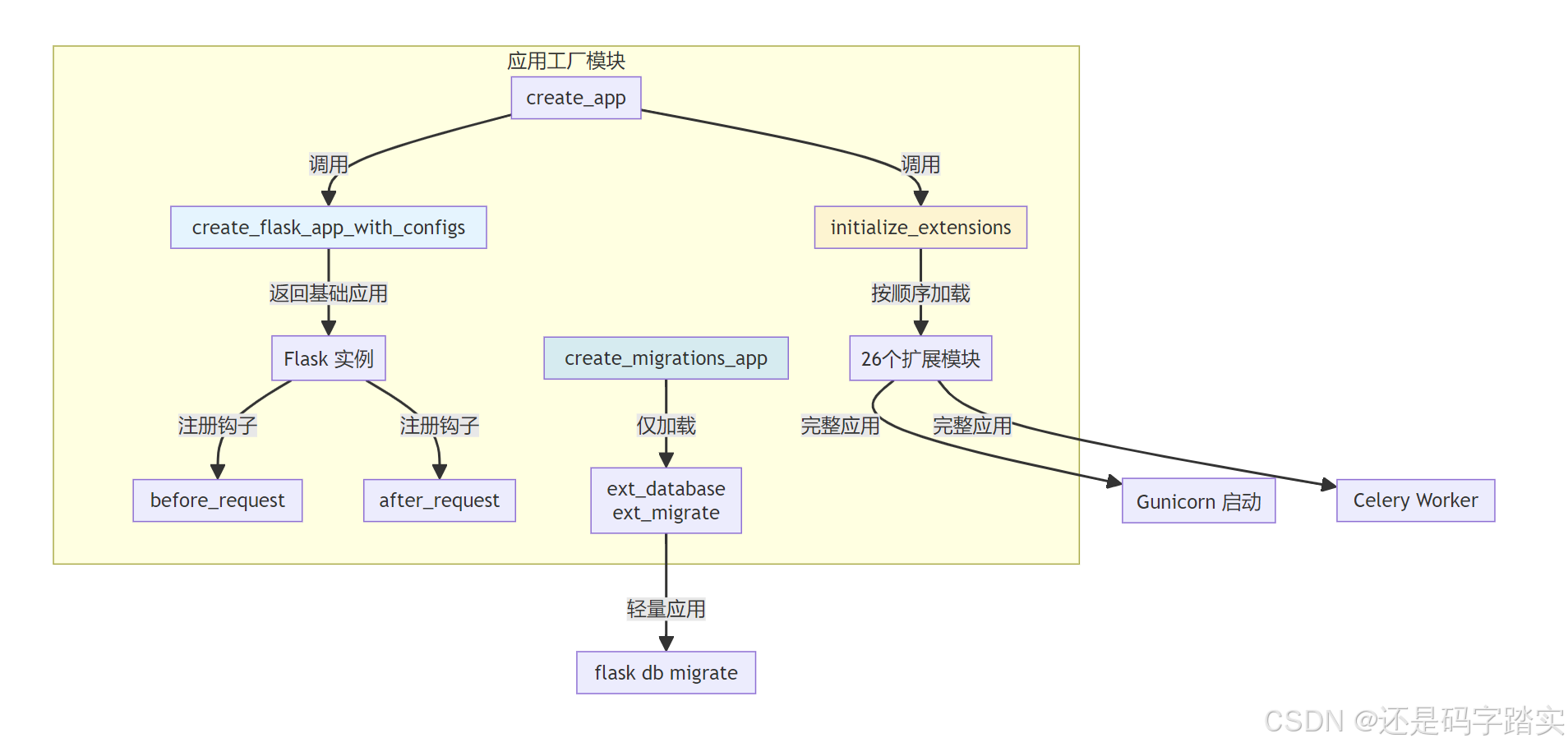

完美!让我为 app_factory.py 做同样的深度拆分解析。

Flask 应用工厂 app_factory.py

模块概览与职责

核心职责

python

"""

app_factory.py - Dify Flask 应用的工厂模块

【主要职责】

1. 创建 Flask 应用实例并加载配置

2. 注册请求生命周期钩子(before_request, after_request)

3. 按正确顺序初始化所有扩展(26 个扩展模块)

4. 注入分布式追踪的 Trace ID 到响应头

【设计模式】

- 工厂模式:通过函数创建应用实例,而非全局变量

- 依赖注入:扩展通过 init_app() 方法注入

- 生命周期管理:统一管理扩展的初始化顺序

【关键函数】

┌────────────────────────────────────────────────────────┐

│ create_flask_app_with_configs() # 创建基础应用 │

│ create_app() # 创建完整应用 │

│ initialize_extensions() # 初始化所有扩展 │

│ create_migrations_app() # 迁移专用应用 │

└────────────────────────────────────────────────────────┘

"""模块架构图

基础应用创建 - create_flask_app_with_configs()

函数详解

python

def create_flask_app_with_configs() -> DifyApp:

"""

创建原始 Flask 应用实例并加载配置

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【执行步骤】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

1️⃣ 实例化 DifyApp(继承自 Flask)

2️⃣ 从 .env 文件加载配置到 app.config

3️⃣ 注册请求生命周期钩子:

- before_request: 初始化日志上下文

- after_request: 注入追踪 ID 到响应头

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【返回】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

DifyApp 实例(已配置但未初始化扩展)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【注意】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

此时应用仅完成配置加载,尚未初始化:

- 数据库连接池(ext_database)

- Redis 客户端(ext_redis)

- Celery 任务队列(ext_celery)

需要调用 initialize_extensions() 完成完整初始化

"""

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# Step 1: 创建 Flask 应用实例

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

dify_app = DifyApp(__name__)

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# Step 2: 加载配置(Pydantic 模型 → Flask Config)

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# dify_config 是从 .env 加载的 Pydantic BaseSettings 对象

# model_dump() 将其转为 dict,然后注入到 Flask 的 config

dify_app.config.from_mapping(dify_config.model_dump())

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# Step 3: 启用 Flask-RESTX 的所有模型(Swagger 文档)

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

dify_app.config["RESTX_INCLUDE_ALL_MODELS"] = True

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# Step 4: 注册钩子(详见后续章节)

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

@dify_app.before_request

def before_request():

init_request_context()

RecyclableContextVar.increment_thread_recycles()

@dify_app.after_request

def add_trace_headers(response):

# ...

return response

# 避免 pyright 的 reportUnusedFunction 警告

_ = before_request

_ = add_trace_headers

return dify_app基础应用创建流程

环境变量

默认值

开始创建应用

创建 DifyApp 实例

加载 .env 配置

配置来源?

dify_config.model_dump

app.config.from_mapping

设置 RESTX 配置

RESTX_INCLUDE_ALL_MODELS = True

注册 before_request 钩子

注册 after_request 钩子

返回 DifyApp 实例

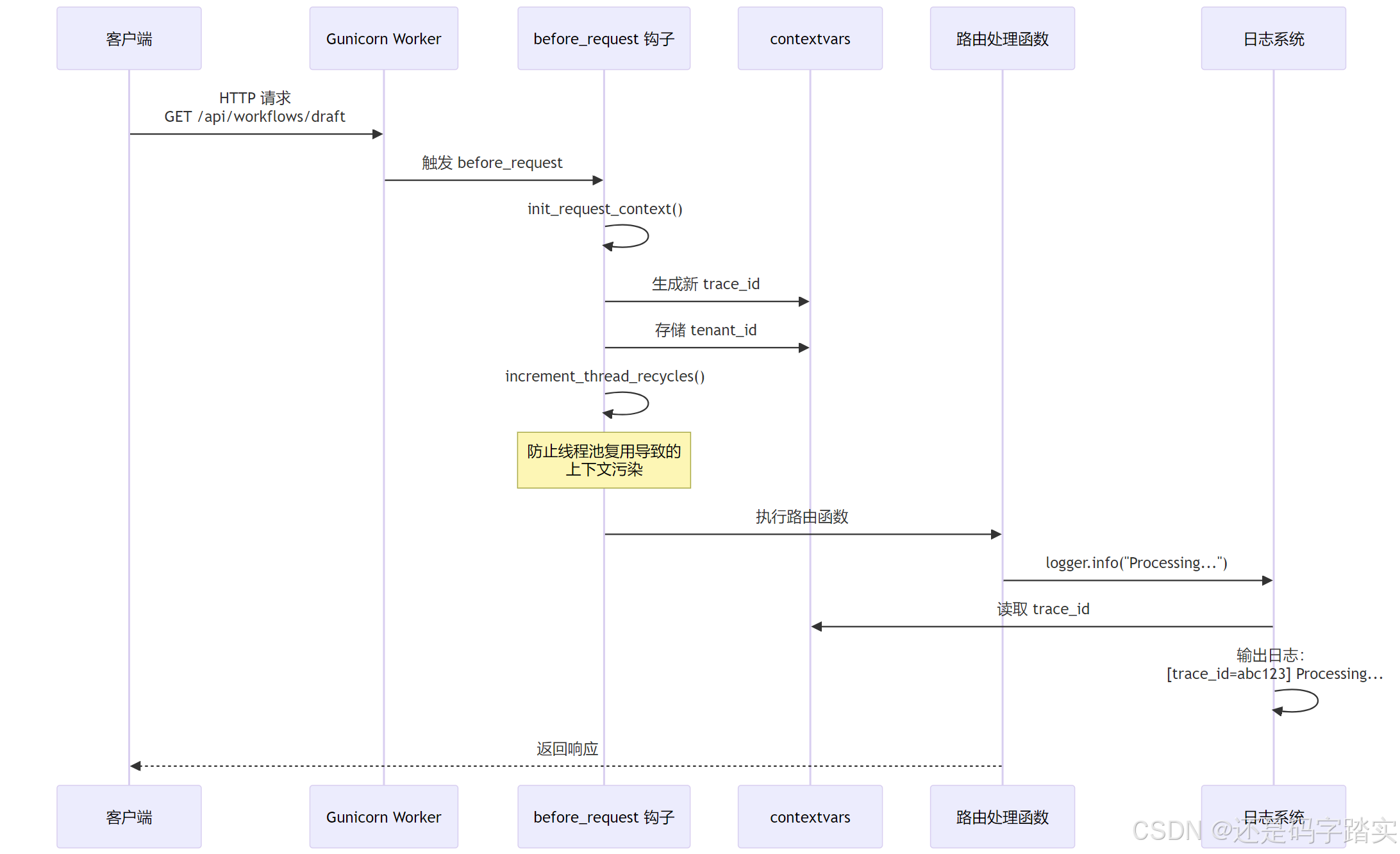

请求前钩子 - before_request

钩子详解

python

@dify_app.before_request

def before_request():

"""

请求前钩子 - 在每个 HTTP 请求处理前自动执行

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【执行时机】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

HTTP 请求到达 → before_request → 路由处理函数

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【核心功能】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

1️⃣ 初始化日志上下文(trace_id, span_id, tenant_id)

→ 确保日志能关联到具体请求和租户

2️⃣ 增加线程回收计数器

→ 防止线程池复用导致的上下文污染

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【为何需要】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

✅ Dify 是多租户系统,必须隔离不同租户的上下文

✅ 日志追踪需要 trace_id 来串联分布式调用链

✅ Gunicorn Worker 进程复用线程,需要清理旧上下文

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【底层原理】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

- init_request_context() 会生成新的 trace_id

- 存储在 Python 的 contextvars 中(线程安全)

- 所有日志输出会自动包含这些上下文信息

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【上下文示例】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

{

"trace_id": "00000000000000000000000000abc123",

"span_id": "0000000000000001",

"tenant_id": "tenant-456",

"user_id": "user-789",

"request_id": "req-001"

}

"""

# 1️⃣ 初始化当前请求的日志上下文

init_request_context()

# 2️⃣ 增加线程回收计数器

# 用于 ContextVar 的生命周期管理,避免上下文泄漏

RecyclableContextVar.increment_thread_recycles()before_request 执行流程

上下文隔离的实际案例

python

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 场景:多租户系统的上下文隔离

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# ─── 请求 A(租户 A)10:00:00 ───

# HTTP 请求到达

# before_request() 执行:

# → trace_id = "aaa-111"

# → tenant_id = "tenant-a"

# → user_id = "user-001"

# 路由处理:

logger.info("Creating workflow")

# 输出:[trace_id=aaa-111][tenant_id=tenant-a] Creating workflow

# ─── 请求 B(租户 B)10:00:01(同一 Worker 进程)───

# HTTP 请求到达

# before_request() 执行:

# → trace_id = "bbb-222" ✅ 独立的 trace_id

# → tenant_id = "tenant-b" ✅ 独立的租户 ID

# → user_id = "user-002"

# 路由处理:

logger.info("Creating workflow")

# 输出:[trace_id=bbb-222][tenant_id=tenant-b] Creating workflow

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 如果没有 before_request,会发生什么?

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# ❌ 请求 B 可能会读取到请求 A 的 tenant_id

# ❌ 日志会串到错误的租户

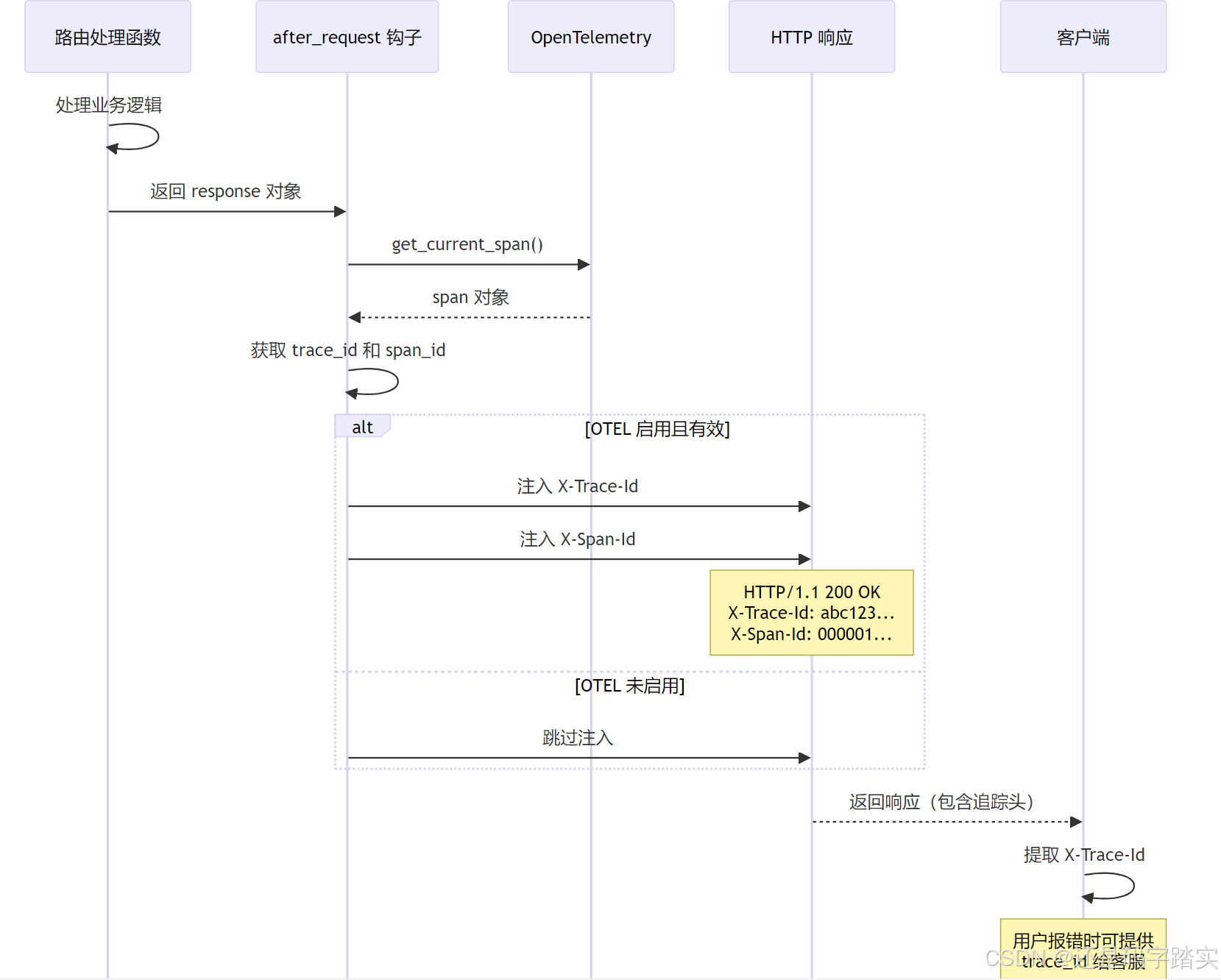

# ❌ 数据库查询可能访问到其他租户的数据(安全风险!)请求后钩子 - after_request

钩子详解

python

@dify_app.after_request

def add_trace_headers(response):

"""

请求后钩子 - 在响应返回前注入追踪头

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【执行时机】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

路由处理函数 → after_request → 返回 HTTP 响应

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【核心功能】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

1️⃣ 从 OpenTelemetry 获取当前 Span 的 trace_id 和 span_id

2️⃣ 将它们注入到 HTTP 响应头:

- X-Trace-Id: 用于全链路追踪

- X-Span-Id: 用于定位具体操作

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【应用场景】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

✅ 前端可以通过响应头获取 trace_id

✅ 用户报错时,提供 trace_id 给客服,快速定位问题

✅ 在日志系统(如 Langfuse)中搜索 trace_id,查看完整调用链

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【为何需要 try-except】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

❗ 即使追踪头注入失败,也不能影响正常响应

❗ 追踪是辅助功能,不应成为单点故障

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【技术细节】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

- trace_id 是 128 位整数,格式化为 32 位十六进制(032x)

- span_id 是 64 位整数,格式化为 16 位十六进制(016x)

"""

try:

# ─── Step 1: 获取当前 OpenTelemetry Span ───

span = get_current_span()

ctx = span.get_span_context() if span else None

# ─── Step 2: 检查 Span 上下文是否有效 ───

if not ctx or not ctx.is_valid:

return response

# ─── Step 3: 注入 Trace ID(32位十六进制)───

# 例如:00000000000000000000000000abc123

if ctx.trace_id != INVALID_TRACE_ID and "X-Trace-Id" not in response.headers:

response.headers["X-Trace-Id"] = format(ctx.trace_id, "032x")

# ─── Step 4: 注入 Span ID(16位十六进制)───

# 例如:0000000000000001

if ctx.span_id != INVALID_SPAN_ID and "X-Span-Id" not in response.headers:

response.headers["X-Span-Id"] = format(ctx.span_id, "016x")

except Exception:

# 永远不要因为追踪头注入失败而中断响应

logger.warning("Failed to add trace headers to response", exc_info=True)

return responseafter_request 执行流程

Trace ID 的实战应用

bash

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 场景:用户报错时的问题定位

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# ─── Step 1: 前端收到响应 ───

HTTP/1.1 500 Internal Server Error

Content-Type: application/json

X-Trace-Id: 00000000000000000000000000abc123

X-Span-Id: 0000000000000001

{

"error": "Workflow execution failed"

}

# ─── Step 2: 用户联系客服 ───

用户:"我的工作流执行失败了,请帮我查看"

客服:"请提供您的 Trace ID"

用户:"X-Trace-Id: abc123"

# ─── Step 3: 客服在 Langfuse 搜索 ───

# 搜索:trace_id = "abc123"

# 看到完整调用链:

┌─────────────────────────────────────────────┐

│ Workflow Execution Trace │

├─────────────────────────────────────────────┤

│ [10:00:00] Workflow Start │

│ ↓ │

│ [10:00:01] LLM Node (GPT-4) - 2.3s │

│ ↓ │

│ [10:00:03] HTTP Node - 500 Error ❌ │

│ URL: https://api.example.com/data │

│ Error: Connection timeout │

│ ↓ │

│ [10:00:03] Workflow Failed │

└─────────────────────────────────────────────┘

# 客服:"找到问题了!HTTP 节点访问超时,已通知技术团队修复"完整应用创建 - create_app()

主函数详解

python

def create_app() -> DifyApp:

"""

创建完整的 Dify 应用实例(生产环境入口)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【执行流程】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

1️⃣ 创建基础 Flask 应用(create_flask_app_with_configs)

2️⃣ 初始化所有扩展(initialize_extensions)

3️⃣ 记录启动耗时(DEBUG 模式)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【返回】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

DifyApp 实例(完全初始化,可直接运行)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【调用者】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

- api/app.py (Gunicorn 启动入口)

- api/celery_entrypoint.py (Celery Worker 启动)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【启动耗时参考】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

- 开发环境:~500ms

- 生产环境:~800ms(包含数据库连接池预热)

"""

# ─── 开始计时 ───

start_time = time.perf_counter()

# ─── Step 1: 创建基础应用 ───

app = create_flask_app_with_configs()

# ─── Step 2: 初始化所有扩展 ───

initialize_extensions(app)

# ─── Step 3: 记录启动耗时(仅 DEBUG 模式)───

end_time = time.perf_counter()

if dify_config.DEBUG:

logger.info(

"Finished create_app (%s ms)",

round((end_time - start_time) * 1000, 2)

)

return app6. 扩展初始化 - initialize_extensions()

核心函数详解

python

def initialize_extensions(app: DifyApp):

"""

按依赖顺序初始化 Flask 扩展

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【关键原则】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

1️⃣ 依赖顺序必须正确

例如:ext_database 必须在 ext_celery 之前

ext_storage 必须在 ext_logstore 之前

2️⃣ 支持条件加载

每个扩展可以通过 is_enabled() 方法控制是否加载

例如:SENTRY_DSN 未配置时,跳过 ext_sentry

3️⃣ 性能监控

DEBUG 模式下记录每个扩展的加载耗时

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【加载流程】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

for ext in extensions:

1. 检查 is_enabled()

2. 调用 ext.init_app(app)

3. 记录加载耗时

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【总共 26 个扩展】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

详见第 7 章:扩展加载顺序详解

"""

# ─── 导入所有扩展模块 ───

from extensions import (

ext_app_metrics, # Prometheus 指标

ext_blueprints, # API 路由

ext_celery, # Celery 任务队列

# ... 其他 23 个扩展

)

# ─── 定义加载顺序(顺序至关重要!)───

extensions = [

ext_timezone, # 1️⃣ 时区

ext_logging, # 2️⃣ 日志

ext_database, # 🔟 数据库

ext_redis, # 1️⃣3️⃣ Redis

ext_celery, # 1️⃣6️⃣ Celery

# ... 详见第 7 章

]

# ─── 遍历加载每个扩展 ───

for ext in extensions:

# 获取扩展名称

short_name = ext.__name__.split(".")[-1]

# 检查是否启用

is_enabled = ext.is_enabled() if hasattr(ext, "is_enabled") else True

if not is_enabled:

if dify_config.DEBUG:

logger.info("Skipped %s", short_name)

continue

# 记录加载开始时间

start_time = time.perf_counter()

# 🔥 核心:初始化扩展

ext.init_app(app)

# 记录加载耗时

end_time = time.perf_counter()

if dify_config.DEBUG:

logger.info("Loaded %s (%s ms)",

short_name,

round((end_time - start_time) * 1000, 2))扩展加载顺序详解

26 个扩展的分层架构

python

extensions = [

# ═══════════════════════════════════════════════

# 第一层:基础配置(无依赖)

# ═══════════════════════════════════════════════

ext_timezone, # 1️⃣ 时区设置

"""

【作用】设置全局时区为 UTC

【依赖】无

【耗时】~1ms

"""

ext_logging, # 2️⃣ 日志系统

"""

【作用】配置日志格式、级别、输出目标

【依赖】无

【耗时】~2ms

【配置】LOG_LEVEL, LOG_FILE, LOG_FORMAT

"""

ext_warnings, # 3️⃣ 警告过滤

"""

【作用】屏蔽第三方库的无用警告

【依赖】无

【耗时】~1ms

"""

ext_import_modules, # 4️⃣ 动态模块导入

"""

【作用】预加载 models、services 等模块

【依赖】无

【耗时】~50ms

"""

ext_orjson, # 5️⃣ 高性能 JSON 序列化

"""

【作用】替换 Flask 默认的 json 模块

【依赖】无

【耗时】~1ms

【性能】比标准 json 快 2-3 倍

"""

ext_forward_refs, # 6️⃣ Pydantic 前向引用

"""

【作用】解决循环导入问题

【依赖】无

【耗时】~1ms

"""

ext_set_secretkey, # 7️⃣ SECRET_KEY 设置

"""

【作用】设置 Flask Session 加密密钥

【依赖】无

【耗时】~1ms

【重要】生产环境必须配置随机密钥

"""

ext_compress, # 8️⃣ 响应压缩

"""

【作用】启用 Gzip 压缩

【依赖】无

【耗时】~2ms

【效果】减少 70% 的传输体积

"""

ext_code_based_extension, # 9️⃣ 代码扩展加载器

"""

【作用】加载自定义扩展

【依赖】无

【耗时】~1ms

"""

# ═══════════════════════════════════════════════

# 第二层:核心基础设施(有依赖关系)

# ═══════════════════════════════════════════════

ext_database, # 🔟 数据库连接池

"""

【作用】初始化 SQLAlchemy + PostgreSQL 连接池

【依赖】无(但其他扩展依赖它)

【耗时】~100ms(包含连接池预热)

【配置】

- DB_HOST, DB_PORT, DB_DATABASE

- SQLALCHEMY_POOL_SIZE = 30

- SQLALCHEMY_MAX_OVERFLOW = 10

【关键】后续所有数据库操作都依赖此连接池

"""

ext_app_metrics, # 1️⃣1️⃣ Prometheus 指标

"""

【作用】注册 Prometheus 指标端点

【依赖】ext_database(需要数据库指标)

【耗时】~5ms

【端点】GET /metrics

"""

ext_migrate, # 1️⃣2️⃣ Alembic 数据库迁移

"""

【作用】注册 flask db 命令

【依赖】ext_database

【耗时】~10ms

【命令】flask db upgrade, flask db migrate

"""

ext_redis, # 1️⃣3️⃣ Redis 客户端

"""

【作用】初始化 Redis 连接池

【依赖】无(但 ext_celery 依赖它)

【耗时】~20ms

【配置】

- REDIS_HOST, REDIS_PORT, REDIS_DB

- REDIS_USE_SENTINEL = false

- REDIS_USE_CLUSTERS = false

【用途】

- Celery Broker

- 缓存(用户会话、模型配置)

- 分布式锁

"""

ext_storage, # 1️⃣4️⃣ 对象存储

"""

【作用】初始化对象存储客户端(S3/本地/阿里云)

【依赖】无

【耗时】~30ms

【配置】

- STORAGE_TYPE = 'local' | 's3' | 'azure-blob'

- S3_BUCKET_NAME, S3_REGION

【用途】

- 文件上传存储

- 工作流执行日志

"""

# ═══════════════════════════════════════════════

# 第三层:业务服务层(依赖核心层)

# ═══════════════════════════════════════════════

ext_logstore, # 1️⃣5️⃣ 日志存储

"""

【作用】将日志写入对象存储

【依赖】ext_logstore ⚠️ 必须在 ext_storage 之后

【耗时】~5ms

"""

ext_celery, # 1️⃣6️⃣ Celery 任务队列

"""

【作用】初始化 Celery 配置

【依赖】ext_celery ⚠️ 必须在 ext_redis 之后

【耗时】~50ms

【配置】

- CELERY_BROKER_URL = redis://...

- 队列:dataset, priority_dataset, trigger

- Beat 定时任务:清理缓存、数据备份

【用途】

- 文档向量化

- 定时任务调度

- 异步工作流执行

"""

ext_login, # 1️⃣7️⃣ 登录管理

"""

【作用】Flask-Login 会话管理

【依赖】ext_database, ext_redis

【耗时】~5ms

"""

ext_mail, # 1️⃣8️⃣ 邮件发送

"""

【作用】SMTP 邮件发送

【依赖】无

【耗时】~5ms

【配置】SMTP_SERVER, SMTP_PORT, SMTP_USERNAME

"""

ext_hosting_provider, # 1️⃣9️⃣ 托管服务商配置

"""

【作用】云服务商特定配置(AWS/Azure/阿里云)

【依赖】无

【耗时】~2ms

"""

# ═══════════════════════════════════════════════

# 第四层:可观测性(依赖业务层)

# ═══════════════════════════════════════════════

ext_sentry, # 2️⃣0️⃣ Sentry 错误追踪

"""

【作用】捕获异常并上报到 Sentry

【依赖】ext_database

【耗时】~20ms

【配置】SENTRY_DSN

【条件】仅在 SENTRY_DSN 配置时启用

"""

ext_proxy_fix, # 2️⃣1️⃣ 代理修复

"""

【作用】处理 X-Forwarded-For 等反向代理头部

【依赖】无

【耗时】~1ms

【场景】Nginx/Traefik 反向代理后获取真实 IP

"""

ext_blueprints, # 2️⃣2️⃣ API 路由注册

"""

【作用】注册所有 API Blueprint

【依赖】ext_database, ext_redis, ext_celery

【耗时】~100ms

【路由】

- /api/console/* (控制台 API)

- /api/service/* (服务 API)

- /api/web/* (前端 API)

⚠️ 必须在其他扩展之后,因为路由依赖所有服务

"""

ext_commands, # 2️⃣3️⃣ CLI 命令

"""

【作用】注册 Flask CLI 命令

【依赖】ext_database

【耗时】~5ms

【命令】

- flask init (初始化数据库)

- flask reset-password

"""

ext_otel, # 2️⃣4️⃣ OpenTelemetry 追踪

"""

【作用】启用分布式追踪

【依赖】ext_blueprints ⚠️ 必须在路由注册后

【耗时】~30ms

【配置】

- OTEL_EXPORTER_OTLP_ENDPOINT

- OTEL_SERVICE_NAME = "dify-api"

"""

ext_request_logging, # 2️⃣5️⃣ 请求日志

"""

【作用】记录所有 HTTP 请求

【依赖】ext_blueprints

【耗时】~5ms

【输出】[GET /api/workflows/draft]

"""

ext_session_factory, # 2️⃣6️⃣ Session 工厂

"""

【作用】SQLAlchemy Session 管理

【依赖】ext_database

【耗时】~2ms

【用途】提供线程安全的数据库会话

"""

]常见的加载顺序错误

python

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 错误示例 1:ext_celery 在 ext_redis 之前

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

extensions = [

ext_celery, # ❌ 错误!Celery 需要 Redis 作为 Broker

ext_redis, # Redis 客户端尚未初始化

]

# 启动报错:

# RuntimeError: Redis client is not initialized. Call init_app first.

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 正确顺序:

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

extensions = [

ext_redis, # ✅ 先初始化 Redis

ext_celery, # ✅ 再初始化 Celery

]

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 错误示例 2:ext_logstore 在 ext_storage 之前

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

extensions = [

ext_logstore, # ❌ 错误!Logstore 需要将日志写入 S3

ext_storage, # 对象存储尚未初始化

]

# 启动报错:

# AttributeError: 'NoneType' object has no attribute 'put_object'

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 正确顺序:

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

extensions = [

ext_storage, # ✅ 先初始化对象存储

ext_logstore, # ✅ 再初始化日志存储

]

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 错误示例 3:ext_otel 在 ext_blueprints 之前

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

extensions = [

ext_otel, # ❌ OTEL 需要拦截所有路由

ext_blueprints, # 路由尚未注册

]

# 结果:OTEL 无法追踪 API 请求(功能失效)

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 正确顺序:

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

extensions = [

ext_blueprints, # ✅ 先注册所有路由

ext_otel, # ✅ 再启用追踪(拦截已注册的路由)

]数据库迁移专用应用

create_migrations_app() 详解

python

def create_migrations_app():

"""

创建仅用于数据库迁移的轻量级应用

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【使用场景】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

- flask db upgrade (执行数据库迁移)

- flask db migrate (生成迁移脚本)

- flask db downgrade (回滚迁移)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【为何需要】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

✅ 数据库迁移不需要加载重型扩展(Redis、Celery、Storage)

✅ 减少启动时间(从 ~800ms 降低到 ~150ms)

✅ 避免迁移脚本因外部服务不可用而失败

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【仅加载的扩展】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

- ext_database: PostgreSQL 连接(必需)

- ext_migrate: Alembic 迁移工具(必需)

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【调用者】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

- flask db 命令(通过 Flask CLI)

- api/app.py 中的条件判断

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【启动耗时】

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

~150ms(比完整应用快 5 倍)

"""

# ─── Step 1: 创建基础应用 ───

app = create_flask_app_with_configs()

# ─── Step 2: 仅加载数据库相关扩展 ───

from extensions import ext_database, ext_migrate

ext_database.init_app(app) # 初始化 SQLAlchemy

ext_migrate.init_app(app) # 初始化 Alembic

return app实际使用场景

bash

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 场景 1: 生成迁移脚本

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

$ flask db migrate -m "Add workflow unique_hash column"

# 执行流程:

# 1. Flask CLI 检测到 db 命令

# 2. 调用 create_migrations_app()(仅加载 2 个扩展)

# 3. Alembic 比对数据库与模型差异

# 4. 生成迁移脚本:migrations/versions/xxx_add_workflow_unique_hash.py

# ✅ 启动快速(~150ms)

# ✅ 不依赖 Redis、Celery 等外部服务

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 场景 2: 执行迁移

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

$ flask db upgrade

# 执行流程:

# 1. 调用 create_migrations_app()

# 2. Alembic 执行待执行的迁移脚本

# 3. 更新 alembic_version 表

# SQL 示例:

# ALTER TABLE workflows ADD COLUMN unique_hash VARCHAR(64);

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 场景 3: 回滚迁移

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

$ flask db downgrade -1

# 执行流程:

# 1. 调用 create_migrations_app()

# 2. Alembic 执行 downgrade() 函数

# 3. 回滚最近一次迁移

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 对比:如果使用完整应用

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# ❌ 启动耗时 ~800ms(慢 5 倍)

# ❌ 需要 Redis 可用(否则启动失败)

# ❌ 需要 Celery Broker 可用

# ❌ CI/CD 环境中可能因外部依赖失败api/app.py 中的条件判断

python

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# api/app.py - 应用启动入口

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

import sys

def is_db_command() -> bool:

"""

检测当前是否在执行数据库命令

【判断逻辑】

命令行参数:flask db ...

→ sys.argv[0] = "flask"

→ sys.argv[1] = "db"

"""

if len(sys.argv) > 1 and sys.argv[0].endswith("flask") and sys.argv[1] == "db":

return True

return False

# ─── 条件创建应用 ───

if is_db_command():

# 数据库命令 → 使用轻量级应用

from app_factory import create_migrations_app

app = create_migrations_app()

else:

# 正常启动 → 使用完整应用

from app_factory import create_app

app = create_app()

celery = app.extensions["celery"]核心知识点总结

三个核心函数的职责划分

python

┌────────────────────────────────────────────────────────┐

│ create_flask_app_with_configs() │

├────────────────────────────────────────────────────────┤

│ ✅ 创建 Flask 实例 │

│ ✅ 加载配置 │

│ ✅ 注册钩子(before_request, after_request) │

│ ❌ 不加载扩展 │

└────────────────────────────────────────────────────────┘

┌────────────────────────────────────────────────────────┐

│ create_app() # 生产环境入口 │

├────────────────────────────────────────────────────────┤

│ ✅ 调用 create_flask_app_with_configs() │

│ ✅ 调用 initialize_extensions() │

│ ✅ 记录启动耗时 │

│ ✅ 返回完整应用(可直接运行) │

└────────────────────────────────────────────────────────┘

┌────────────────────────────────────────────────────────┐

│ create_migrations_app() # 数据库迁移专用 │

├────────────────────────────────────────────────────────┤

│ ✅ 调用 create_flask_app_with_configs() │

│ ✅ 仅加载 ext_database + ext_migrate │

│ ✅ 启动快速(~150ms) │

│ ✅ 不依赖外部服务 │

└────────────────────────────────────────────────────────┘扩展加载的关键原则

plain

原则 1: 依赖顺序

ext_redis → ext_celery

ext_storage → ext_logstore

ext_blueprints → ext_otel

原则 2: 条件加载

ext_sentry: 仅在 SENTRY_DSN 配置时启用

ext_otel: 仅在 ENABLE_OTEL=true 时启用

原则 3: 性能监控

DEBUG 模式下记录每个扩展的加载耗时

原则 4: 失败隔离

单个扩展失败不应影响其他扩展

(目前未实现,建议改进)请求生命周期钩子的作用

plain

before_request:

✅ 初始化日志上下文(trace_id, tenant_id)

✅ 防止线程池复用导致的上下文污染

✅ 为多租户系统提供数据隔离

after_request:

✅ 注入分布式追踪 ID(X-Trace-Id, X-Span-Id)

✅ 前端可通过响应头获取 trace_id

✅ 用户报错时可快速定位问题最佳实践建议

正确的扩展开发流程

python

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 如何添加新扩展?

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 1️⃣ 创建扩展模块:api/extensions/ext_my_service.py

def init_app(app: DifyApp):

"""初始化自定义服务"""

# 检查依赖

if "database" not in app.extensions:

raise RuntimeError("ext_my_service requires ext_database")

# 初始化逻辑

my_service = MyService(app.config)

app.extensions["my_service"] = my_service

def is_enabled() -> bool:

"""条件加载"""

return dify_config.MY_SERVICE_ENABLED

# 2️⃣ 在 app_factory.py 中导入

from extensions import ext_my_service

# 3️⃣ 添加到 extensions 列表(注意顺序!)

extensions = [

ext_database, # 先加载依赖

ext_my_service, # 再加载自己

]常见陷阱

python

# ❌ 陷阱 1: 在扩展中直接导入 app

from app import app # 错误!会导致循环导入

# ✅ 正确做法:通过 init_app 注入

def init_app(app: DifyApp):

# 在这里使用 app

# ❌ 陷阱 2: 在 before_request 中执行耗时操作

@app.before_request

def before_request():

time.sleep(5) # 错误!会阻塞所有请求

# ✅ 正确做法:仅做轻量级初始化

@app.before_request

def before_request():

init_request_context() # 轻量级操作

# ❌ 陷阱 3: 扩展加载顺序错误

extensions = [

ext_celery, # 依赖 Redis

ext_redis, # 但 Redis 在后面!

]

# ✅ 正确顺序:先加载依赖

extensions = [

ext_redis,

ext_celery,

]Flask应用工厂create_app() 与 workflow创建_create_or_update_app()区别

整体流程:

python

启动服务器

↓

调用 create_app() ← 创建 Flask 应用容器

↓

初始化数据库/Redis/API路由

↓

服务器开始运行,等待用户请求

↓

用户上传 YAML 文件导入应用

↓

调用 AppDslService.import_app()

↓

调用 _create_or_update_app() ← 创建业务应用记录

↓

保存到数据库(使用 create_app() 初始化的数据库连接)具体对比:

| 对比维度 | create_app() |

_create_or_update_app() |

|---|---|---|

| 层次 | 系统基础设施层 | 业务逻辑层 |

| 返回类型 | DifyApp(Flask应用) |

App(数据库模型) |

| 调用次数 | 启动时调用1次 | 每次导入应用都会调用 |

| 作用范围 | 整个后端服务 | 单个业务应用 |

| 初始化内容 | 数据库连接、Redis、Celery、API路由 | 应用名称、工作流配置、模型设置 |

| 谁调用它 | app.py(启动脚本) |

AppDslService.import_app() |

| 依赖关系 | 不依赖业务逻辑 | 依赖于 create_app() 已经初始化好的数据库 |

| 类比 | 建造整栋大楼 | 在大楼里注册一家公司 |

Workflow 模型(DSL持久化)

模型概览与数据库设计

数据库表结构

sql

CREATE TABLE workflows (

-- 🔑 主键

id UUID PRIMARY KEY,

-- 🏢 多租户隔离

tenant_id UUID NOT NULL,

app_id UUID NOT NULL,

-- 📌 类型与版本

type VARCHAR(255) NOT NULL, -- 'workflow' | 'chat' | 'rag-pipeline'

version VARCHAR(255) NOT NULL, -- 'draft' | 'v1' | 'v2' ...

-- 📝 版本标记(仅发布版本有值)

marked_name VARCHAR(255) DEFAULT '',

marked_comment VARCHAR(255) DEFAULT '',

-- 🎯 核心数据(JSON 存储)

graph TEXT NOT NULL, -- DSL JSON

features TEXT, -- 功能配置

environment_variables TEXT DEFAULT '{}',

conversation_variables TEXT DEFAULT '{}',

rag_pipeline_variables TEXT DEFAULT '{}',

-- 👤 审计字段

created_by UUID NOT NULL,

created_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP,

updated_by UUID,

updated_at TIMESTAMP DEFAULT CURRENT_TIMESTAMP ON UPDATE CURRENT_TIMESTAMP,

-- 📇 索引

INDEX workflow_version_idx (tenant_id, app_id, version)

);关键字段说明

| 字段 | 类型 | 用途 | 示例值 |

|---|---|---|---|

graph |

TEXT | DSL JSON 核心存储 | {"nodes": [...], "edges": [...]} |

version |

VARCHAR | 版本标识 | "draft" / "v1" / "v2" |

features |

TEXT | 功能配置 | {"file_upload": {...}} |

unique_hash |

计算属性 | 冲突检测 | SHA256(graph + features + ...) |

DSL 持久化核心字段

graph 字段 - DSL JSON 存储

python

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

# 字段定义

# ━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

graph: Mapped[str] = mapped_column(LongText)

"""

【存储内容】前端 Canvas 生成的完整 JSON DSL

【JSON 结构】

{

"nodes": [ # 节点列表

{

"id": "start",

"type": "start",

"position": {"x": 100, "y": 100},

"data": {

"type": "start",

"title": "开始",

"variables": [...]

}

},

{

"id": "llm-1",

"type": "llm",

"data": {

"model": {"provider": "openai", "name": "gpt-4"},

"prompt_template": [...]

}

}

],

"edges": [ # 边列表(定义节点连接)

{"source": "start", "target": "llm-1"}

],

"viewport": {"x": 0, "y": 0, "zoom": 1}

}

【为何用 LongText 而非 JSONB】

✅ 跨数据库兼容(PostgreSQL/MySQL/TiDB)

✅ Dify 不需要查询 JSON 内部字段(总是全量读取)

✅ 简单直观,无需处理 JSONB 序列化

"""创建工作流 - Workflow.new()

工厂方法详解

python

@classmethod

def new(

cls,

*,

tenant_id: str, # 租户 ID(多租户隔离)

app_id: str, # 应用 ID

type: str, # 'workflow' | 'chat' | 'rag-pipeline'

version: str, # 'draft' | 'v1' | 'v2' ...

graph: str, # ⭐ JSON 字符串(前端传递)

features: str, # 功能配置 JSON

created_by: str, # 创建者 UUID

environment_variables: Sequence[Variable],

conversation_variables: Sequence[Variable],

rag_pipeline_variables: list[dict],

marked_name: str = "",

marked_comment: str = "",

) -> Workflow:

"""

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

创建新的 Workflow 实例

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【使用场景】

1️⃣ 用户首次创建工作流 → version="draft"

2️⃣ 发布工作流 → version="v1"(复制 draft 创建新记录)

3️⃣ 从模板创建 → graph 来自模板库

【返回】

未持久化的 Workflow 实例(需调用 db.session.add + commit)

【注意】

- graph 必须是 JSON 字符串,不是 dict

- 创建后需要手动 db.session.add(workflow)

"""

workflow = Workflow()

workflow.id = str(uuid4())

workflow.tenant_id = tenant_id

workflow.app_id = app_id

workflow.type = type

workflow.version = version

workflow.graph = graph # ⭐ 直接存储 JSON 字符串

workflow.features = features

workflow.created_by = created_by

# 变量赋值

workflow.environment_variables = environment_variables or []

workflow.conversation_variables = conversation_variables or []

workflow.rag_pipeline_variables = rag_pipeline_variables or []

# 版本标记

workflow.marked_name = marked_name

workflow.marked_comment = marked_comment

# 时间戳

workflow.created_at = naive_utc_now()

workflow.updated_at = workflow.created_at

return workflowGraph 数据访问 - graph_dict

动态 JSON 解析属性

python

@property

def graph_dict(self) -> Mapping[str, Any]:

"""

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

将 graph 字段(JSON 字符串)动态解析为字典

━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━

【返回结构】

{

"nodes": [{"id": "start", "data": {...}}, ...],

"edges": [{"source": "start", "target": "llm-1"}],

"viewport": {"x": 0, "y": 0, "zoom": 1}

}

【为何不用 @cached_property】

⚠️ 某些代码会修改返回的 dict(如 Iteration 单步调试)

⚠️ 使用缓存会导致意外副作用: