机器人能叠衣倒水,AI伴侣看懂你的眼神------这一切都因为,机器终于学会了真正地"看"世界。

2026 拉斯维加斯会展中心,当LG的机器人CLOiD"凝视"着地上散落的毛巾,经过短暂"思考"后决定召唤扫地机器人时,它完成的不仅是一系列动作,而是一个从像素到理解,再到决策的完整认知闭环。 CES 2026清晰地揭示了一个趋势:计算机视觉的革命,已经从研究"算法突破"进入"设备落地"的产品化爆发期。

十年前,这里的科技产品还在炫耀像素数量和屏幕分辨率;如今,展台上的焦点已经转向了机器如何理解所见的世界。

从实验室到客厅:AI视觉的演进

从2016年AlphaGo战胜李世石到2023年ChatGPT横空出世,AI的发展轨迹清晰可见。然而,这些突破大多发生在云端和服务器机房,普通用户难以直接感知。今年的CES揭示了一个转折点:AI视觉正从研究论文走向日常产品。

传统的计算机视觉技术如面部识别、物体检测已经相当成熟,但它们仅限于特定任务。2026年的新品展示了一种根本性转变:设备开始具备综合性的视觉理解能力。

这些系统不再仅仅是"识别"图像中的物体,而是开始"理解"场景、预测动作,甚至根据视觉输入做出复杂决策。

科技咨询机构ABI Research分析师斯蒂芬妮·汤姆林指出:"过去十年,我们教会了机器如何看见;现在,我们正在教会它们如何观察和理解。"这一转变正在催生新一代智能设备。

跨越边界:集成视觉的设备群像

CES 2026展会上,各种集成视觉感知的设备不再局限于单一品类,而是呈现出跨领域融合的特点。这种技术溢出效应正重新定义产品形态和用户体验。

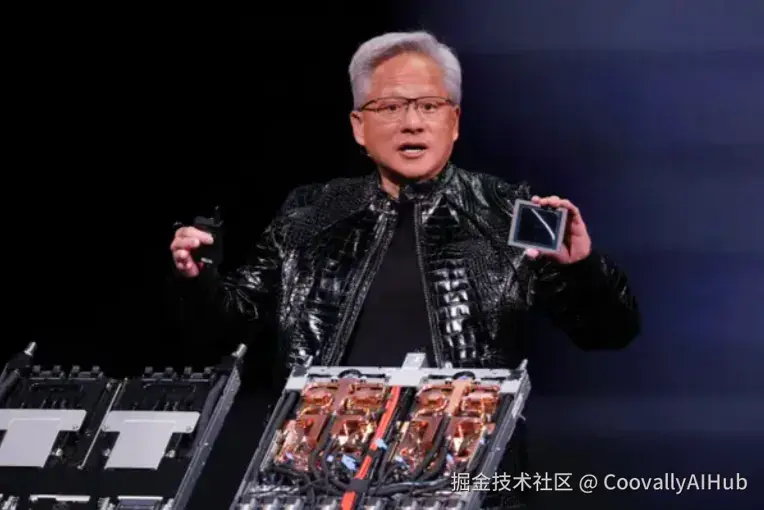

英伟达在自动驾驶领域的布局尤为突出。其最新发布的Alpamayo平台不是简单地升级传感器精度,而是通过视觉-语言-动作模型,赋予车辆罕见路况的推理能力。

黄仁勋在发布会上解释说:"当自动驾驶汽车遇到从未见过的场景时,它不能只是停下来等待人类干预。它需要像人类驾驶员一样,基于视觉信息做出合理推断。"

在家庭场景中,LG的CLOiD机器人展示了视觉理解的另一维度。它不仅看到了毛巾,还整齐地叠放好这一复杂概念,并选择最合适的工具完成任务。

波士顿动力与谷歌DeepMind的合作则将视觉与运动控制结合得更加紧密。新版Atlas机器人通过集成Gemini AI,能够理解"请把箱子搬到红色标记处"这样的自然语言指令,然后自主规划完成这一任务所需的视觉搜索、路径规划和动作执行。

多模态融合:当视觉遇见语言和行动

CES上最值得关注的发展之一是多模态AI系统的成熟。这些系统不再将视觉信息孤立处理,而是将其与语言理解、行动规划紧密结合。

雷蛇的Project AVA全息桌面伴侣就是一个典型例子。这个5.5英寸高的虚拟形象不仅通过摄像头"看见"用户,还通过麦克风"听见"指令,结合两者生成恰当的回应。

甚至连传统的乐高积木也加入了这一浪潮。新的智能积木通过内置传感器和连接能力,让玩家搭建的模型能够感知周围环境并作出反应。

芯片:视觉智能的"新大脑"

当然驱动这场视觉认知革命的核心,是一系列专门为复杂视觉任务设计的新型芯片。它们不再是简单的图像处理单元,而是集成了感知、推理甚至决策能力的"片上大脑"。

英伟达Vera Rubin架构的提前量产,是本次CES最受关注的芯片突破。黄仁勋将其描述为"六颗芯片组成的一个AI超级计算机"。与上一代Blackwell相比,Rubin不仅在处理速度上实现了三倍提升,更重要的是其架构专为复杂、动态的视觉环境设计。

该架构以发现暗物质的天文学家命名,象征着它要处理的是那些难以直接观测却至关重要的"关系"与"上下文"。它能够支持更复杂的多模态任务------同时处理来自摄像头、激光雷达、雷达的异构数据,并在芯片层面进行融合与推理。

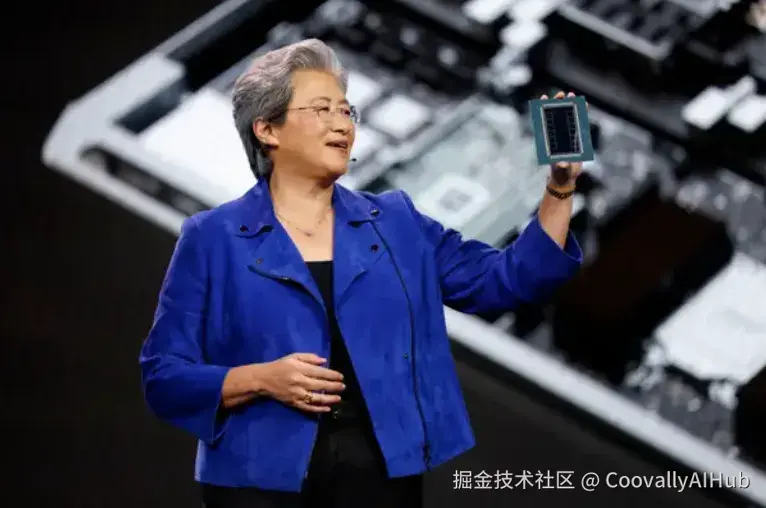

AMD的回应同样迅速。CEO苏姿丰展示了专为AI推理优化的MI400系列,并预告了性能跃升千倍的MI500处理器。她在演讲中提出的"尧塔尺度计算",直指未来视觉AI对算力的无穷渴求。"瓶颈不再是模型大小,"她指出,"而是我们能否在设备端提供足够的实时推理算力。"

技术核心:从2D到3D,从识别到推理

支撑这一波视觉感知设备爆发的,是几项关键技术突破。

神经辐射场(NeRF)技术的大规模应用使设备能够从2D图像重建3D场景,为机器提供了更接近人类的空间理解能力。英伟达的Vera Rubin架构就充分利用了这种能力,其设计目标之一就是处理更复杂的3D视觉任务。

同时,视觉Transformer模型的优化大大提升了设备处理长距离视觉依赖关系的能力。这使得机器人能够在杂乱环境中保持对特定目标的连续关注,不会被干扰物分散注意力。

多模态融合在芯片层面的优化。 新一代处理器能够高效协同处理视觉、语言、声音乃至传感器数据,形成统一的环境认知。Uber展示的自动驾驶出租车,其车顶"光环"内集成的正是这样一套复杂的多传感器融合计算单元。

最根本的进步可能在于推理能力的增强。传统视觉系统倾向于简单分类,新一代系统则能够进行因果推理、反事实思考甚至创造性问题解决。

总结

"2026年将是具身智能的转折点。"机器人正从执行预设脚本的工具,进化为能感知、理解并适应环境的自主智能体。其核心便是由强大芯片驱动的、实时运行的视觉认知模型。

与此同时,智能的定义正在被改写。未来,智能将不仅仅是云端庞大模型的产物,更是每一个终端设备基于本地视觉感知做出的即时、可靠的决策。从工厂机器人到家用电器,从汽车到可穿戴设备,一颗颗"视觉大脑"正在被点亮。