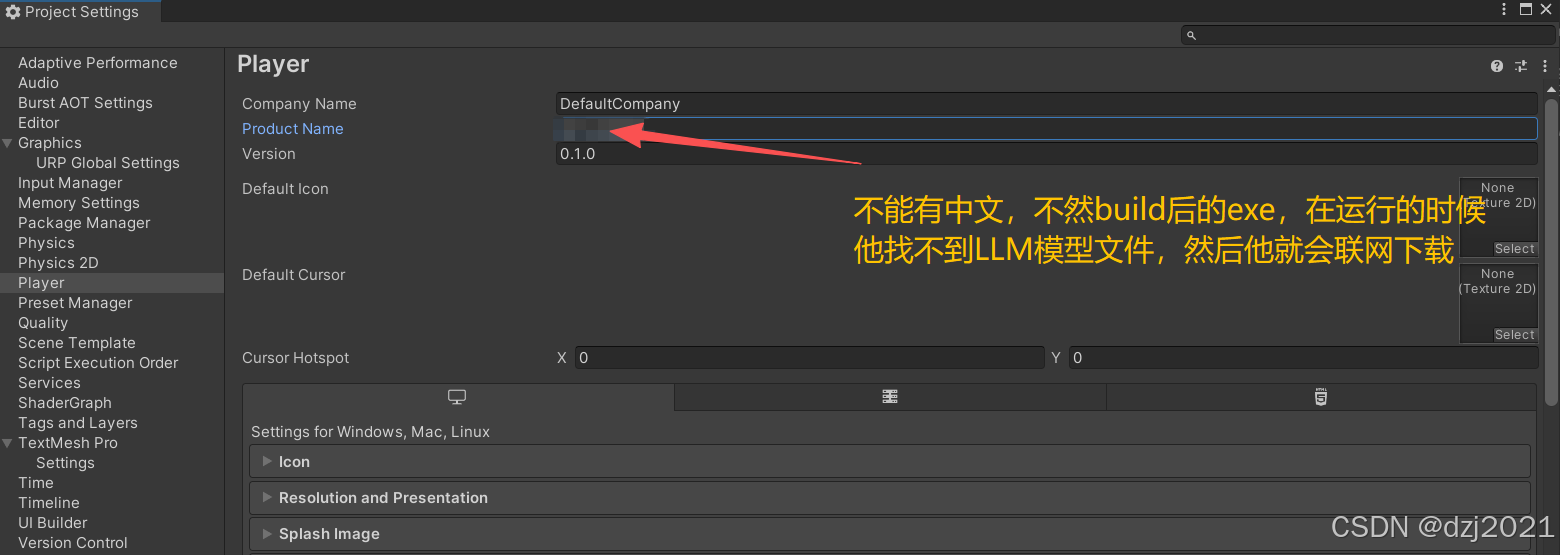

一、工程文件中已经指定了模型文件,发布运行后仍然联网下载大模型文件

1、原因:Product name包含中文名,改成全英文后正常了。

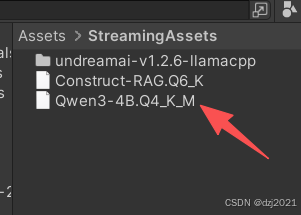

2、模型配置参考

- (1)模型文件的位置:如下所示,把模型文件拷贝到StreamingAssets根目录

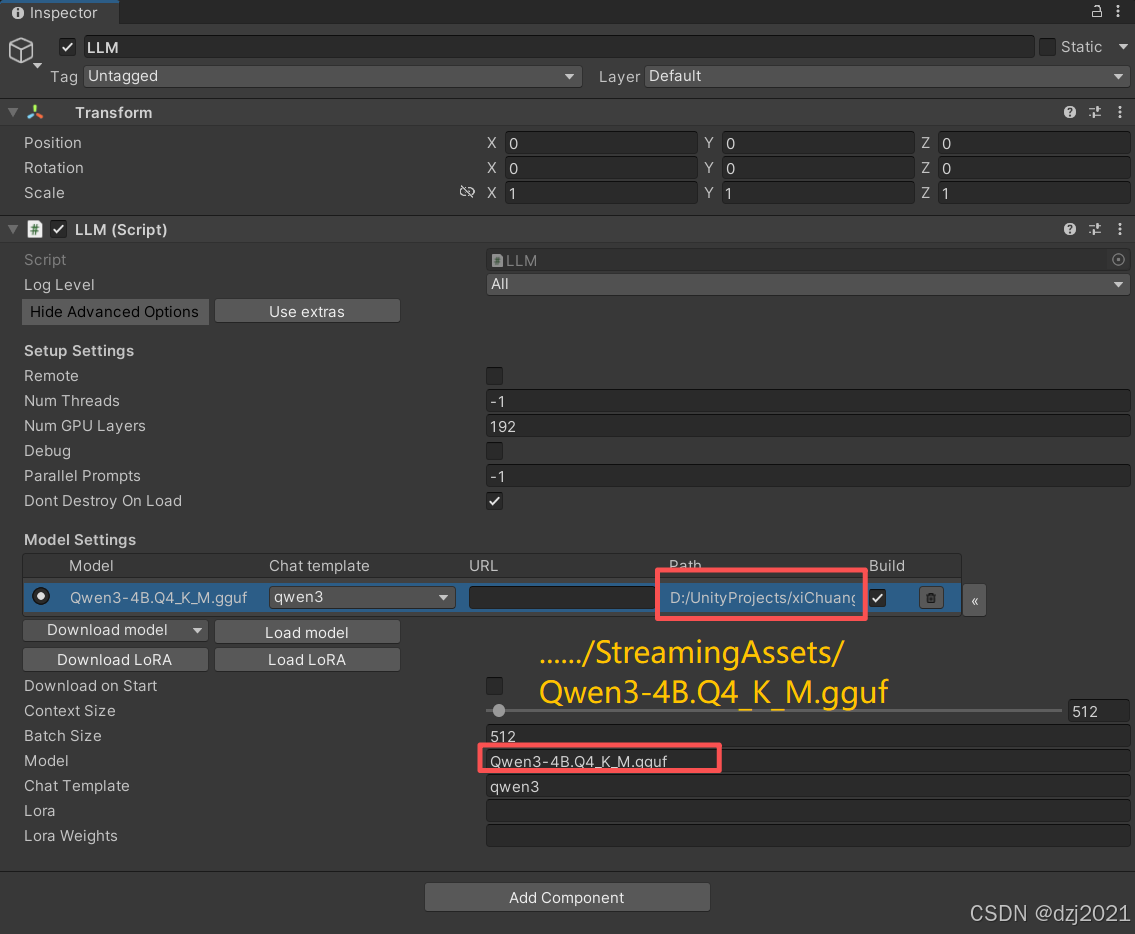

-(2)模型关联设置

通过[LoadModel]按钮,把模型指定到StreamingAssets下的gguf模型文件

二、如何让LLM使用GPU而不是全部依赖CPU

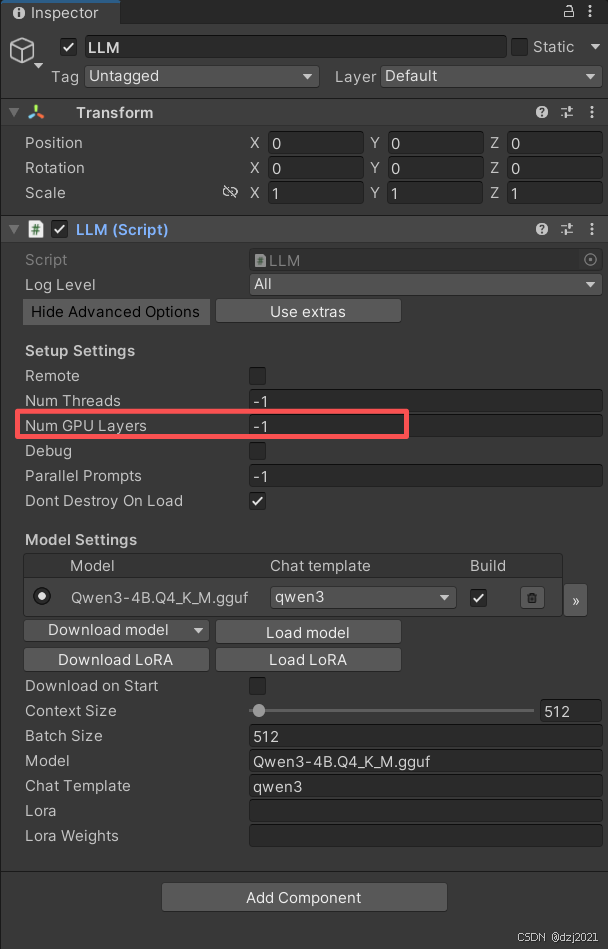

1、修改LLM脚本的配置参数

设置[Num GPU Layers]参数的值,官方说-1代表全用GPU,实测后发现设置成-1时,CPU满载,GPU貌似没有忙碌。

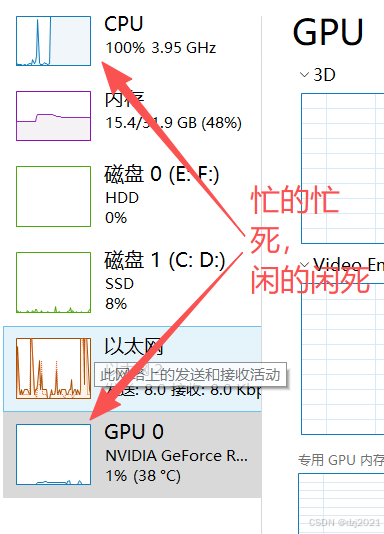

(1)Num GPU Layers = -1 时的实测

- 回答的时候,吐文本速度慢,像个七老八十的老倌吃饭的样子

- 查看CPU和GPU,发现CPU哼哧哼哧的满载,GPU则是清闲无比

(2)你可以设置【Num GPU Layers】 = 2-4-6-16-32-64-128然后测试

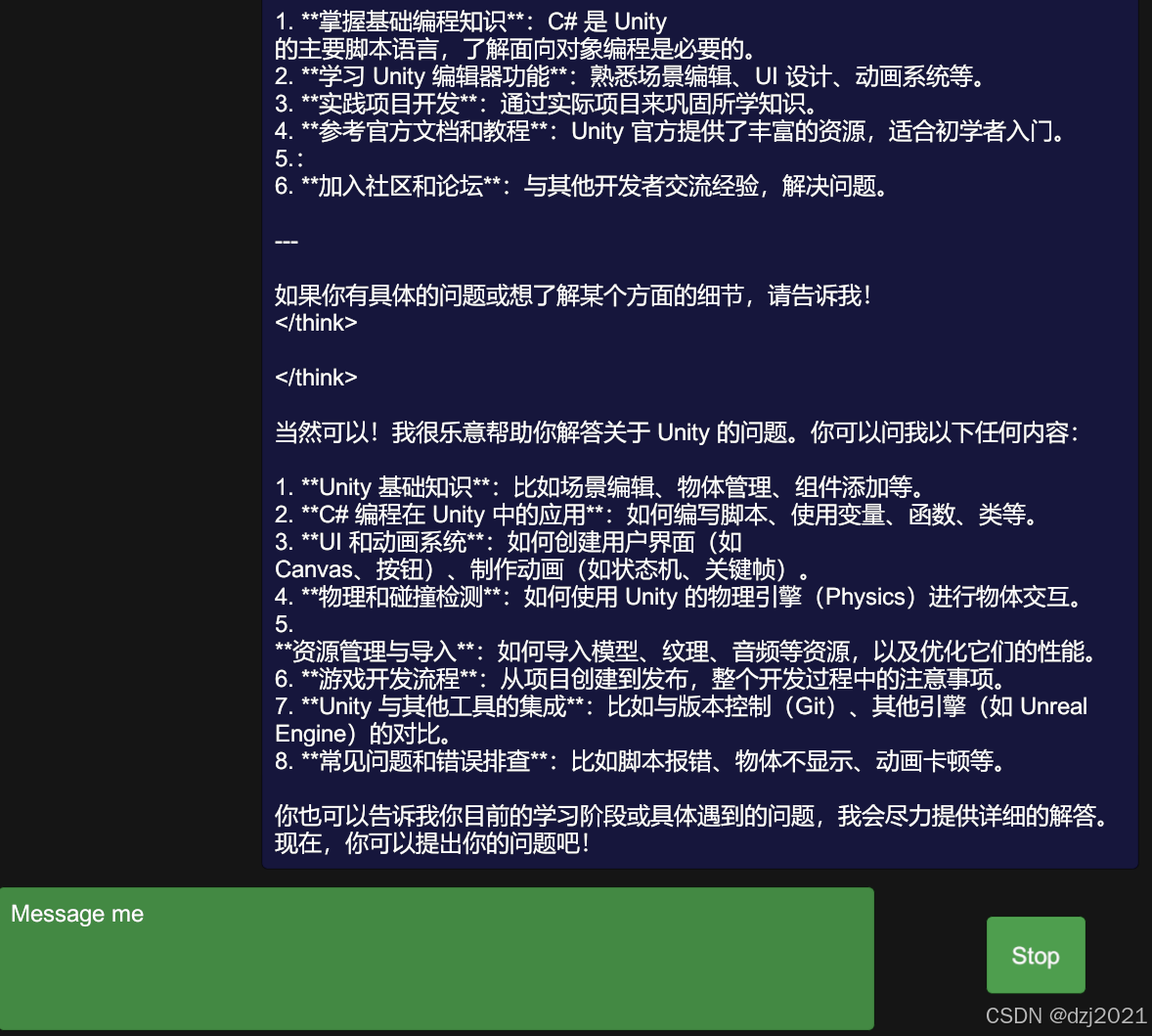

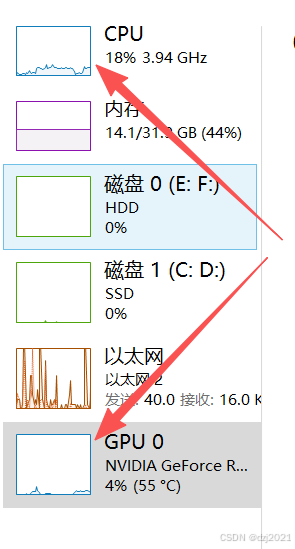

我这里直接设置 Num GPU Layers = 1024

- 我让它介绍一下Unity,吐文本的速度确实非常快

- CPU占用明显下降,GPU的话,只是抖动一下,峰值也就是4%

三、附录

1、LLMUnity在哪里?

https://github.com/undreamai/LLMUnity