📘 第6章 深度学习3 - CNN(卷积神经网络)复习提纲

一、基本概念与术语填空

-

CNN全称:卷积神经网络,是一类包含卷积运算的深度前馈神经网络。

-

CNN的核心特性:

-

局部感知(Local Perception)

-

参数共享(Parameter Sharing)

-

-

CNN的主要结构层:

-

卷积层(Convolution Layer):特征提取

-

池化层(Pooling Layer):降低维数,保留主要信息

-

全连接层(Fully Connected Layer):结果预测

-

-

感受野(Receptive Field):卷积结果输出点的取值仅依赖于其在输入图像中该点及其邻域区域点的取值。

-

填充(Padding):在输入周围添加0,以减少边缘信息丢失。

-

步幅(Stride):卷积核滑动的步长。

-

特征映射(Feature Map):卷积操作后得到的结果。

-

池化操作类型:

-

最大池化(Max Pooling)

-

平均池化(Average Pooling)

-

-

Dropout:训练时随机丢弃节点,防止过拟合。

-

Batch Normalization(BN):加快训练收敛,稳定训练过程,具有一定正则化作用。

-

L1与L2正则化:

-

L1:稀疏权重,可用于特征选择

-

L2:防止过拟合

-

-

过拟合与欠拟合:

-

过拟合:训练误差小,测试误差大,泛化能力差。

-

欠拟合:训练误差大,模型未充分学习。

-

二、重要历史与人物

-

CNN里程碑模型:

-

LeNet-5(1998,Yann LeCun)

-

AlexNet(2012,ImageNet冠军)

-

-

图灵奖得主(2018):

-

Yoshua Bengio

-

Geoffrey Hinton

-

Yann LeCun

-

三、计算与图像处理相关

-

卷积计算:给定图像和卷积核,能计算特征图。

-

池化计算:给定一组数字,计算最大池化或平均池化结果。

- 示例:

(1, 2, 3, 2)的平均池化结果为 2 ,最大池化结果为 3。

- 示例:

-

步幅与填充对输出尺寸的影响(需掌握基本公式)。

-

RGB图像的三维卷积:多通道卷积的操作方式。

四、模型结构与流程描述

-

CNN图像分类流程 :

输入 → 卷积 → 激活函数 → 池化 → 重复 → Flatten → 全连接 → Softmax → 输出

-

Flatten层的作用:将多维输入一维化,用于过渡到全连接层。

-

Dropout与BN的作用位置与原理。

五、正则化与防止过拟合

-

常用正则化方法:

-

Dropout

-

Batch Normalization

-

L1/L2 正则化

-

-

过拟合的表现与原因。

六、CNN的应用场景(可能作为简答题背景)

-

图像分类

-

目标检测(如Mask RCNN)

-

图像生成(如Deep Dream、画风迁移)

-

OCR(光学字符识别)

-

AlphaGo中的CNN应用

七、可能的出题形式

-

填空题:CNN特性、层名称、正则化方法、池化结果计算

-

选择题:CNN结构、卷积操作、正则化作用

-

简答题:CNN流程、防止过拟合的方法、CNN与全连接网络的比较

-

计算题:卷积操作、池化计算、步幅与填充对尺寸的影响

-

论述题:CNN在图像处理中的优势、与人类视觉系统的类比

✅ 复习建议:

-

熟记术语与定义,特别是填空常考内容。

-

理解卷积、池化、填充、步幅的计算与作用。

-

掌握CNN结构图,能画出或描述其流程。

-

理解正则化方法及其作用。

-

熟悉CNN的典型应用,能结合实例说明。

如果需要我可以为你整理成问答复习卡片 或模拟填空题集,帮助你进一步巩固记忆。是否需要我继续整理?

需要

以下是针对《第6章 深度学习3-CNN》整理的复习卡片式问答集,适合用于快速自测与记忆巩固:

🔁 CNN 复习问答卡片集

一、基本概念与术语

Q1:CNN的中文全称是什么?

A:卷积神经网络(Convolutional Neural Network)。

Q2:CNN相比传统全连接网络的两大核心特性是什么?

A:局部感知(Local Perception)与参数共享(Parameter Sharing)。

Q3:CNN的三个主要结构层分别是什么?

A:卷积层(Convolution Layer)、池化层(Pooling Layer)、全连接层(Fully Connected Layer)。

Q4:什么是"感受野"?

A:卷积结果输出点的取值仅依赖于其在输入图像中该点及其邻域区域点的取值,该邻域区域称为感受野。

Q5:Padding的作用是什么?

A:在输入周围添加0,以减少边缘信息丢失,保持输入输出尺寸一致。

Q6:Stride是什么?

A:卷积核在输入上滑动的步长。

二、计算与操作

Q7:给定卷积核和输入图像,如何计算特征图?

A:将卷积核与输入图像的对应区域逐元素相乘后求和,加上偏置,再通过激活函数得到输出值。

Q8:池化操作有哪两种常见类型?

A:最大池化(Max Pooling)和平均池化(Average Pooling)。

Q9:计算序列 (1, 2, 3, 2) 的平均池化和最大池化结果。

A:平均池化 = 2,最大池化 = 3。

Q10:如果输入图像尺寸为 5×5,卷积核尺寸为 3×3,步幅为1,无填充,输出尺寸是多少?

A:输出尺寸 = (5-3)/1 + 1 = 3×3。

三、正则化与优化

Q11:Dropout 是什么?它在训练中如何工作?

A:Dropout 是一种正则化技术,训练时以一定概率随机丢弃某些神经元,减少过拟合。

Q12:Batch Normalization 的作用是什么?

A:加快训练收敛,稳定训练过程,减少梯度爆炸或消失,具有一定正则化效果。

Q13:L1 和 L2 正则化的主要区别是什么?

A:L1 正则化倾向于产生稀疏权重,可用于特征选择;L2 正则化主要用于防止过拟合。

Q14:什么是过拟合?如何判断模型是否过拟合?

A:过拟合指模型在训练集上表现很好,但在测试集上表现差。判断依据:训练误差小,测试误差大。

四、历史与结构

Q15:CNN的里程碑模型有哪些?

A:LeNet-5(1998,Yann LeCun)、AlexNet(2012,ImageNet冠军)。

Q16:2018年因深度学习贡献获图灵奖的三位学者是谁?

A:Yoshua Bengio、Geoffrey Hinton、Yann LeCun。

Q17:Flatten层的作用是什么?

A:将多维输入(如卷积层输出)展平为一维向量,以便输入全连接层。

五、应用与扩展

Q18:CNN在图像处理中的三大典型应用是什么?

A:图像分类、目标检测、图像生成(如风格迁移)。

Q19:AlphaGo 中是否使用了CNN?

A:是,用于棋盘状态的特征提取。

Q20:什么是"特征映射"?

A:图像经过卷积操作后得到的结果,反映输入中某种特征的激活程度。

如果需要,我可以将这些内容整理成填空题集 或模拟题练习,进一步帮你备战考试。是否需要继续?

根据上面这些知识点,出几个典型的计算题

以下是基于《第6章 深度学习3-CNN》知识点设计的典型计算题,涵盖卷积、池化、输出尺寸计算等常考题型,附有详细解答步骤:

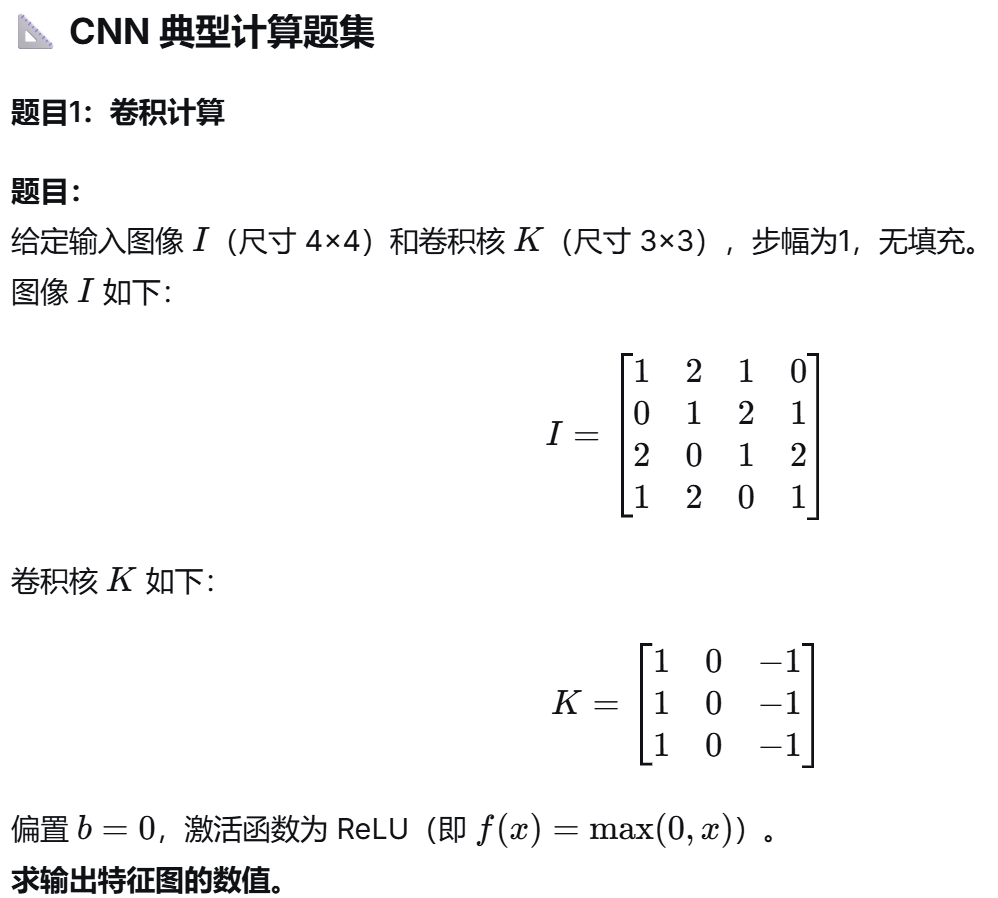

题目1:卷积计算

题目1:卷积计算

解答:

输出尺寸 = (4−3)/1+1=2×2(4−3)/1+1=2×2

逐区域计算:

- 左上区域:

(1×1+2×0+1×(−1)+0×1+1×0+2×(−1)+2×1+0×0+1×(−1))=1−1−2+2−1=−1(1×1+2×0+1×(−1)+0×1+1×0+2×(−1)+2×1+0×0+1×(−1))=1−1−2+2−1=−1

ReLU 后:max(0,−1)=0max(0,−1)=0

- 右上区域:

(2×1+1×0+0×(−1)+1×1+2×0+1×(−1)+0×1+1×0+2×(−1))=2+1−1−2=0(2×1+1×0+0×(−1)+1×1+2×0+1×(−1)+0×1+1×0+2×(−1))=2+1−1−2=0

ReLU 后:00

- 左下区域:

(0×1+1×0+2×(−1)+2×1+0×0+1×(−1)+1×1+2×0+0×(−1))=−2+2−1+1=0(0×1+1×0+2×(−1)+2×1+0×0+1×(−1)+1×1+2×0+0×(−1))=−2+2−1+1=0

ReLU 后:00

- 右下区域:

(1×1+2×0+1×(−1)+0×1+1×0+2×(−1)+2×1+0×0+1×(−1))=1−1−2+2−1=−1(1×1+2×0+1×(−1)+0×1+1×0+2×(−1)+2×1+0×0+1×(−1))=1−1−2+2−1=−1

ReLU 后:00

输出特征图:

0000\]\[0000

题目2:池化计算

题目:

给定一个 4×4 的特征图:

F=[2413517236251243]F=2531416217243253

使用 2×2 的池化窗口,步幅为2。

分别计算:

-

最大池化结果

-

平均池化结果

解答:

池化窗口不重叠(步幅=窗口大小),分为四个区域:

-

左上 2×2:[2,4;5,1][2,4;5,1]

-

最大池化:max(2,4,5,1)=5max(2,4,5,1)=5

-

平均池化:(2+4+5+1)/4=3(2+4+5+1)/4=3

-

-

右上 2×2:[1,3;7,2][1,3;7,2]

-

最大池化:max(1,3,7,2)=7max(1,3,7,2)=7

-

平均池化:(1+3+7+2)/4=3.25(1+3+7+2)/4=3.25

-

-

左下 2×2:[3,6;1,2][3,6;1,2]

-

最大池化:max(3,6,1,2)=6max(3,6,1,2)=6

-

平均池化:(3+6+1+2)/4=3(3+6+1+2)/4=3

-

-

右下 2×2:[2,5;4,3][2,5;4,3]

-

最大池化:max(2,5,4,3)=5max(2,5,4,3)=5

-

平均池化:(2+5+4+3)/4=3.5(2+5+4+3)/4=3.5

-

结果:

- 最大池化输出:

5765\]\[5675

- 平均池化输出:

33.2533.5\]\[333.253.5

题目3:输出尺寸计算

题目:

输入图像尺寸为 32×32×332×32×3(RGB三通道),使用:

-

卷积层:卷积核 5×5,步幅1,填充2

-

池化层:窗口 2×2,步幅2

-

卷积层:卷积核 3×3,步幅1,填充1

-

池化层:窗口 2×2,步幅2

求经过以上四层后,输出的特征图尺寸(高度、宽度、通道数)。

假设所有卷积操作不改变通道数(即每层卷积输出通道数等于输入通道数)。

解答:

公式:

-

卷积后尺寸:H′=H−K+2PS+1H′=SH−K+2P+1

-

池化后尺寸:H′=H−KS+1H′=SH−K+1

逐步计算:

- 第一层卷积(5×5,S=1,P=2):

H′=32−5+2×21+1=32H′=132−5+2×2+1=32

输出:32×32×332×32×3

- 第一层池化(2×2,S=2):

H′=32−22+1=16H′=232−2+1=16

输出:16×16×316×16×3

- 第二层卷积(3×3,S=1,P=1):

H′=16−3+2×11+1=16H′=116−3+2×1+1=16

输出:16×16×316×16×3

- 第二层池化(2×2,S=2):

H′=16−22+1=8H′=216−2+1=8

输出:8×8×38×8×3

最终输出尺寸:8×8×3

题目4:感受野计算

题目:

假设有一个三层的卷积网络:

-

第一层:卷积核 3×3,步幅1,无填充

-

第二层:卷积核 3×3,步幅1,无填充

-

第三层:卷积核 3×3,步幅1,无填充

每层输入输出高度宽度相同(通过填充实现)。

求第三层输出的一个像素点,对应第一层输入图像的感受野大小。

解答:

感受野计算公式:

RFl=RFl−1+(Kl−1)×∏i=1l−1SiRFl=RFl−1+(Kl−1)×i=1∏l−1Si

其中 RF1=K1RF1=K1,SiSi 为第 i 层的步幅。

逐步计算:

-

第一层:RF1=3RF1=3,S1=1S1=1

-

第二层:RF2=3+(3−1)×1=5RF2=3+(3−1)×1=5,S2=1S2=1

-

第三层:RF3=5+(3−1)×(1×1)=7RF3=5+(3−1)×(1×1)=7

感受野大小:7×7

题目5:参数量计算

题目:

一个卷积层:

-

输入:28×28×3228×28×32

-

卷积核:3×3×323×3×32(与输入通道一致)

-

输出通道数:64

-

偏置:每个输出通道一个偏置

求该卷积层的总参数量。

解答:

参数量 = (卷积核参数 + 偏置参数)× 输出通道数

卷积核参数 = 3×3×323×3×32

偏置参数 = 1

每输出通道参数 = 3×3×32+1=2893×3×32+1=289

总参数量 = 289×64=18496289×64=18496