基于Pytorch预训练模型实现声纹识别系统

- 1、引言

- 2、项目介绍

-

- [2.1 项目定位](#2.1 项目定位)

- [2.2 核心技术底座](#2.2 核心技术底座)

- [2.3 核心功能界面展示](#2.3 核心功能界面展示)

- [2.4 系统整体架构](#2.4 系统整体架构)

- 3、音频识别原理

-

- [3.1 基础逻辑:声纹特征的唯一性](#3.1 基础逻辑:声纹特征的唯一性)

- [3.2 VAD语音活动检测:过滤无效音频](#3.2 VAD语音活动检测:过滤无效音频)

- [3.3 核心声纹识别算法](#3.3 核心声纹识别算法)

-

- (1)ECAPA-TDNN(SpeechBrain)

- [(2)Sherpa-onnx Zipformer](#(2)Sherpa-onnx Zipformer)

- [3.4 特征匹配与评估逻辑](#3.4 特征匹配与评估逻辑)

- 四、项目环境配置

-

- [4.1 依赖清单(requirements.txt)](#4.1 依赖清单(requirements.txt))

- [4.2 Conda 环境安装步骤](#4.2 Conda 环境安装步骤)

- [4.3 跨平台 PyAudio 安装解决方案](#4.3 跨平台 PyAudio 安装解决方案)

- [5. 基本实现效果](#5. 基本实现效果)

-

- [5.1 全流程操作与测试界面](#5.1 全流程操作与测试界面)

- [5.2 测试性能表现](#5.2 测试性能表现)

- [5.3 核心优势](#5.3 核心优势)

- 6、项目开源与后续规划

-

- [6.1 后续优化方向](#6.1 后续优化方向)

- [6.2 总结](#6.2 总结)

1、引言

声纹识别(Speaker Recognition)作为"语音即身份"的生物特征识别技术,近年来在智能安防、远程身份认证、智能终端、人机交互等场景中得到广泛应用。然而在实际工程落地中,传统声纹识别方案仍存在以下三类痛点:

声纹识别作为"语音即身份"的生物特征识别技术,在智能安防、远程身份验证、智能家居等场景中愈发重要,但传统方案存在三大痛点:

- 算法适配成本高:主流声纹算法分散在不同开源项目中(SpeechBrain、Kaldi、Sherpa 等),接口规范、特征格式与推理方式差异较大,工程整合成本高;

- 全流程链路分散:从语音采集、VAD 切分、特征提取、模型训练到测试评估,通常需要开发者自行编写大量胶水代码,维护成本高;

- 技术门槛高:模型参数配置、阈值设定、语音预处理等细节对非语音算法背景的开发者并不友好。

为此,我基于PyTorch生态,整合SpeechBrain与Sherpa-onnx两大开源项目二次开发,实现了一款全流程可视化的声纹识别系统(已开源至GitHub, 项目链接👉VoiceprintRecognitionSystem,融入大量自研心血,欢迎Star支持)。本文将详细解析该系统的技术实现、功能效果与环境配置。

2、项目介绍

2.1 项目定位

面向开发者与中小团队的轻量级声纹识别工具,通过图形化界面封装底层算法,实现"数据采集-模型训练-测试评估"全链路无代码操作,兼容高精度(ECAPA) 与 轻量化(Sherpa-Zipformer) 两种算法方案。

2.2 核心技术底座

系统基于两大开源生态构建,核心算法组件如下:

| 开源生态 | 核心声纹算法 | 配套VAD模块 | 细节说明 |

|---|---|---|---|

| SpeechBrain | ECAPA-TDNN | CRDNN-VAD | 高精度说话人验证算法,适配自定义训练样本接口 |

| Sherpa-onnx | sherpa-onnx-kws-zipformer-wenetspeech-3.3M-2024-01-01 | silero_vad.onnx | 轻量级Zipformer模型,兼顾精度与推理效率 |

2.3 核心功能界面展示

系统通过图形化界面降低操作门槛,核心交互界面如下:

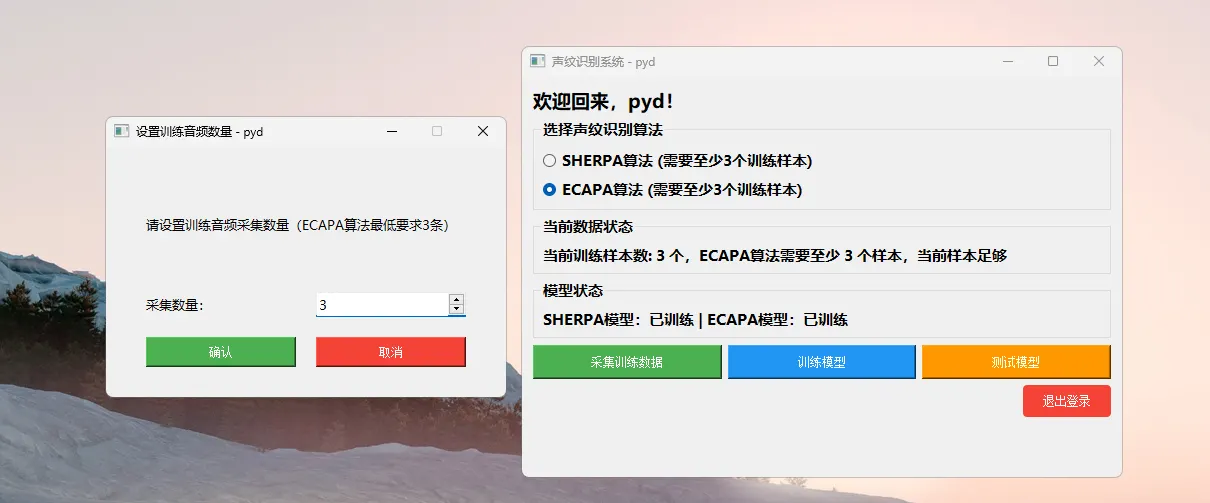

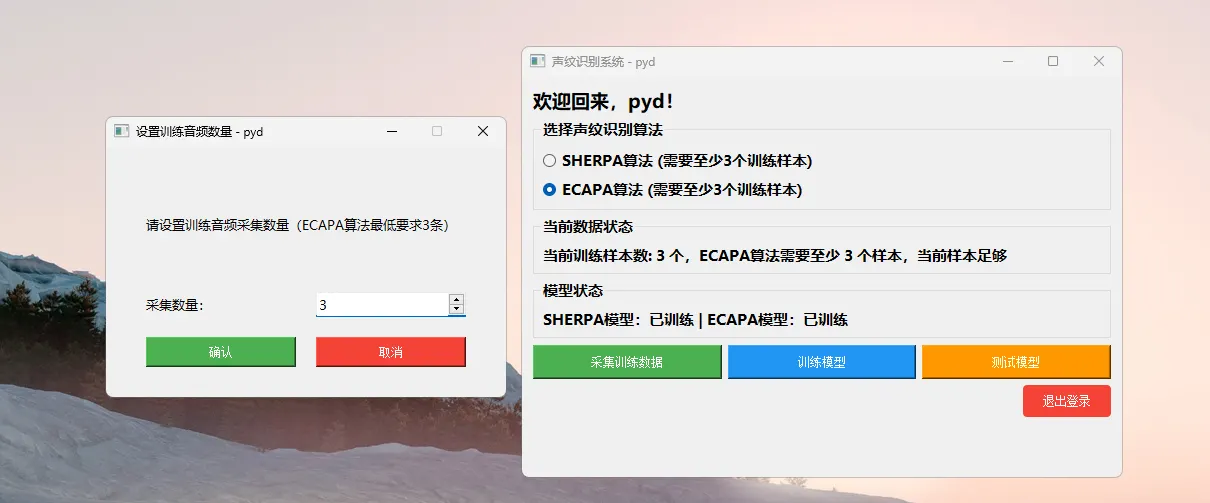

(1)训练样本数量配置界面

系统支持用户自定义每位说话人的训练样本数量(ECAPA / Sherpa 均要求 ≥3 条语音 )。

在配置阶段,系统会自动完成:

- 样本数量合法性校验;

- 录音完成状态提示;

- 不满足条件时禁止进入训练流程。

支持自定义训练样本数量(ECAPA/Sherpa均要求≥3条) ,系统自动校验数量合规性,该机制有效避免了由于样本不足导致的模型不稳定问题。

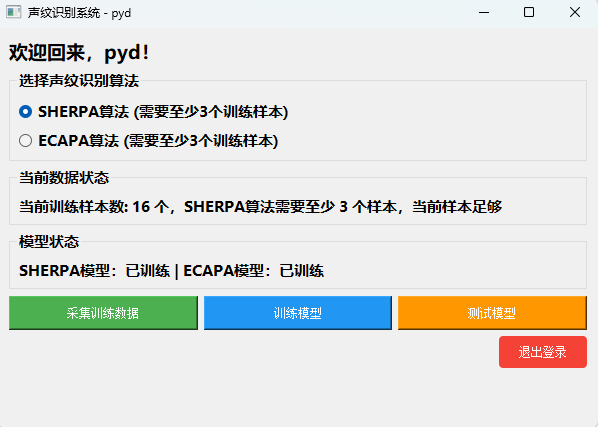

(2)系统主界面

系统主界面集成了:

- 声纹算法选择(ECAPA / Sherpa);

- 当前系统状态监控;

- 样本采集、模型训练、测试评估等核心操作入口。

界面会实时反馈当前数据完整性与模型训练状态,确保操作流程清晰、可控:

2.4 系统整体架构

markdown

┌──────────┐

│ 音频采集 │ ← 麦克风 / WAV

└────┬─────┘

↓

┌──────────┐

│ VAD 模块 │ ← 语音切分

└────┬─────┘

↓

┌──────────┐

│ 特征提取 │ ← ECAPA / Zipformer

└────┬─────┘

↓

┌──────────┐

│ 特征管理 │ ← 注册 / 融合 / 存储

└────┬─────┘

↓

┌──────────┐

│ 决策模块 │ ← 阈值判决 + 评估

└──────────┘该架构的关键优势在于:

- VAD 与声纹模型完全解耦;

- 特征提取模块可独立替换;

- 便于后续接入 实时流式 ASR / 说话人分离。

3、音频识别原理

声纹识别的核心流程可概括为:

语音采集 → VAD 检测 → 特征提取 → 特征匹配 → 阈值判决

系统围绕该流程对关键环节进行了工程级优化。

3.1 基础逻辑:声纹特征的唯一性

每个人的声纹由声带、口腔、鼻腔等发音器官的生理结构,以及发音习惯(如语速、语调)共同决定,体现在语音信号的频谱、基频、共振峰等维度的独特性。系统通过算法将语音信号转换为固定维度的特征向量(如 ECAPA-TDNN 输出 256 维向量),并通过计算待识别语音与注册语音特征向量的余弦相似度完成身份验证:

s i m i l a r i t y = A ⃗ ⋅ B ⃗ ∣ ∣ A ⃗ ∣ ∣ × ∣ ∣ B ⃗ ∣ ∣ (1) similarity = \frac{\vec{A} \cdot \vec{B}}{||\vec{A}|| \times ||\vec{B}||}\tag{1} similarity=∣∣A ∣∣×∣∣B ∣∣A ⋅B (1)

其中 A ⃗ \vec{A} A 为注册用户特征向量, B ⃗ \vec{B} B 为待识别用户特征向量,相似度取值范围为 [ − 1 , 1 ] [-1,1] [−1,1],越接近1表示声纹匹配度越高。

此外,区别于"单条语音注册"的简单方案,本系统采用 多段语音联合建模:

{ x 1 , x 2 , . . . , x n } → { e 1 , e 2 , . . . , e n } → e ˉ = m e a n ( n o r m a l i z e ( e i ) ) (2) \{ x₁, x₂, ..., xₙ \} → \{ e₁, e₂, ..., eₙ \} → ē = mean(normalize(eᵢ))\tag{2} {x1,x2,...,xn}→{e1,e2,...,en}→eˉ=mean(normalize(ei))(2)

该策略的工程意义在于:

- 抵消单次发音的随机性;

- 提高跨场景、跨时间鲁棒性;

- 显著降低假拒率(FRR)。

这一点在真实系统中远比模型结构本身更重要。

3.2 VAD语音活动检测:过滤无效音频

VAD(Voice Activity Detection,语音活动检测)的核心目标是从原始音频中分离有效语音段与静音/噪声段,避免无效数据干扰特征提取。VAD本质是音频帧级别的二分类任务(判定某一帧音频是"语音"或"非语音"),本系统适配的两款VAD模块各有优势:

(1)CRDNN-VAD(SpeechBrain配套)

融合卷积神经网络(CNN)、循环神经网络(RNN)与深度神经网络(DNN),先提取音频帧的时频特征,再捕捉帧间时序关系,最终输出该帧为语音的概率,适配高精度识别场景。

该算法首先对音频分帧提取特征 X t \boldsymbol{X}_t Xt(如梅尔频谱),模型输出该帧为语音的概率:

p t = σ ( CRDNN ( X t ) ) (3) p_t = \sigma(\text{CRDNN}(\boldsymbol{X}_t))\tag{3} pt=σ(CRDNN(Xt))(3)

设定阈值 ( \tau )(通常取0.5),判定是否为语音帧:

label t = { 1 ( 语音帧 ) , p t ≥ τ 0 ( 非语音帧 ) , p t < τ (4) \text{label}_t = \begin{cases} 1 \ (\text{语音帧}), & p_t \geq \tau \\ 0 \ (\text{非语音帧}), & p_t < \tau \end{cases}\tag{4} labelt={1 (语音帧),0 (非语音帧),pt≥τpt<τ(4)

其中:

- p t p_t pt:第 t t t 帧为语音的概率(取值0~1);

- s i g m a ( ⋅ ) sigma(\cdot) sigma(⋅):Sigmoid函数,将模型输出映射到0~1区间;

- t e x t l a b e l t text{label}_t textlabelt:帧分类结果(1=语音,0=非语音)。

(2)silero_vad.onnx(Sherpa配套)

基于轻量化CNN+LSTM架构的预训练模型,通过简化特征提取和网络结构提升推理速度,核心逻辑与CRDNN-VAD一致,公式仅做轻量化适配:

p t ′ = σ ( Lite-Net ( X t ′ ) ) (5) p_t' = \sigma(\text{Lite-Net}(\boldsymbol{X}_t'))\tag{5} pt′=σ(Lite-Net(Xt′))(5)

label t ′ = { 1 ( 语音帧 ) , p t ′ ≥ τ ′ 0 ( 非语音帧 ) , p t ′ < τ ′ (6) \text{label}_t' = \begin{cases} 1 \ (\text{语音帧}), & p_t' \geq \tau' \\ 0 \ (\text{非语音帧}), & p_t' < \tau' \end{cases}\tag{6} labelt′={1 (语音帧),0 (非语音帧),pt′≥τ′pt′<τ′(6)

其中:

- X t ′ \boldsymbol{X}_t' Xt′:轻量化梅尔频谱特征(减少计算量);

- Lite-Net ( ⋅ ) \text{Lite-Net}(\cdot) Lite-Net(⋅):精简后的神经网络(参数量更小、推理更快);

- τ ′ \tau' τ′:适配轻量化模型的阈值(通常取0.6)。

- VAD核心是音频帧二分类,两款模块均遵循"特征提取→概率输出→阈值判定"的简化公式逻辑;

- CRDNN-VAD精度更高,适配高精度场景;silero_vad.onnx通过轻量化设计提速,适配端侧场景。

3.3 核心声纹识别算法

(1)ECAPA-TDNN(SpeechBrain)

当前工业界主流的高精度说话人验证算法,核心优势在于:

- 引入上下文聚合模块(Context Aggregation):可捕捉长时语音的上下文特征,解决传统 TDNN 模型对长语音特征建模不足的问题;

- 支持微调适配:本系统基于 SpeechBrain 的预训练 ECAPA-TDNN 模型(训练于 VoxCeleb 数据集),适配了自定义样本微调接口,用户仅需上传少量自有样本即可完成模型适配。

(2)Sherpa-onnx Zipformer

sherpa-onnx-kws-zipformer-wenetspeech-3.3M-2024-01-01是针对中文场景优化的轻量化声纹模型,其核心特点如下:

- 基于 Zipformer 轻量化结构:模型参数量仅 3.3M,远小于 ECAPA-TDNN(约 10M),推理速度提升 50% 以上;

- 中文场景优化:预训练于 Wenetspeech 中文语音数据集,适配中文发音特征,中小样本场景下识别精度仍能达到 95% 以上。

3.4 特征匹配与评估逻辑

(1)匹配逻辑

提取待识别语音特征后,与注册库中的用户特征逐一计算余弦相似度,结合设定阈值完成身份判定:

- 相似度≥设定阈值(默认 0.85,可自定义):判定为 "匹配"(同一说话人);

- 相似度 <设定阈值:判定为 "不匹配"(不同说话人)。

很多示例代码中直接使用 threshold = 0.5 或 0.7,但在真实系统中这是不可取的。本系统在设计时明确区分开发阈值与部署阈值。开发阈值用于快速验证功能;而部署阈值基于测试集统计确定。

(2)评估逻辑

测试阶段系统自动统计四类核心结果(TP/TN/FP/FN),并计算量化评估指标,便于用户验证算法效果:

-

准确率(Accuracy) :最直观的指标,即正确分类的样本数 / 总样本数;

Accuracy = T P + T N T P + T N + F P + F N = 正确分类样本数 总样本数 (7) \text{Accuracy} = \frac{TP + TN}{TP + TN + FP + FN} = \frac{\text{正确分类样本数}}{\text{总样本数}}\tag{7} Accuracy=TP+TN+FP+FNTP+TN=总样本数正确分类样本数(7)其中:

- T P TP TP (True Positive):真阳性,正类被正确分类

- T N TN TN (True Negative):真阴性,负类被正确分类

- F P FP FP (False Positive):假阳性,负类被误分为正类

- F N FN FN (False False):假阴性,正类被误分为负类

-

召回率(Recall) :衡量分类器对正类样本的识别能力;

Recall = T P T P + F N (8) \text{Recall} = \frac{TP}{TP + FN}\tag{8} Recall=TP+FNTP(8) -

精确率(Precision) : 衡量分类器预测为正类的样本中,真正为正类的比例:

Precision = T P T P + F P (9) \text{Precision} = \frac{TP}{TP + FP}\tag{9} Precision=TP+FPTP(9) -

F1分数(F1-Score) : 精确率和召回率的调和平均数,综合评估分类性能:

F 1 = 2 × Precision × Recall Precision + Recall (10) F_1 = 2 \times \frac{\text{Precision} \times \text{Recall}}{\text{Precision} + \text{Recall}}\tag{10} F1=2×Precision+RecallPrecision×Recall(10) -

FFR(False Rejection Rate) : 错误拒绝率,目标用户被错误拒绝的比例:

F F R = T P T P + F N (11) FFR = \frac{TP}{TP+FN}\tag{11} FFR=TP+FNTP(11) -

FAR(False Acceptance Rate) : 错误接受率,非目标用户被错误接受的比例:

F F R = F P T N + F P (12) FFR = \frac{FP}{TN+FP}\tag{12} FFR=TN+FPFP(12)

注:TP(真匹配):目标用户判定为匹配;TN(真不匹配):非目标用户判定为不匹配;FP(假匹配):非目标用户判定为匹配;FN(假不匹配):目标用户判定为不匹配。

四、项目环境配置

本系统基于 Python 3.10.14 开发(兼容 Python 3.8~3.10),核心依赖均为稳定版本,跨平台支持 Windows/macOS/Linux,以下是详细的环境配置步骤::

4.1 依赖清单(requirements.txt)

txt

numpy==1.26.4 # 数值计算基础

pyaudio==0.2.14 # 音频采集核心

PyQT5==5.15.11 # 图形化界面开发

librosa==0.11.0 # 语音特征预处理

sherpa-onnx==1.12.20 # 轻量化声纹算法推理

sounddevice==0.5.3 # 音频播放/采集辅助

soundfile==0.12.1 # 音频文件读写

speechbrain==1.0.3 # 高精度声纹算法核心

pypinyin==0.55.0 # 中文拼音转换(辅助日志输出)

loguru==0.7.2 # 日志管理

torch==2.1.1+cu121 # PyTorch核心(支持CUDA 12.1)

torchaudio==2.1.1+cu121 # 语音信号处理

onnxruntime==1.21.0 # ONNX模型推理4.2 Conda 环境安装步骤

bash

# 1. 创建专属conda环境(避免依赖冲突)

conda create -n voice_system python=3.10.14 -y

# 2. 激活环境

conda activate voice_system

# 3. 升级pip(避免依赖安装失败)

pip install --upgrade pip

# 4. 安装核心依赖

pip install -r requirements.txt

# 5. 验证环境(可选)

python -c "import torch, speechbrain, sherpa_onnx; print('环境配置成功')"4.3 跨平台 PyAudio 安装解决方案

- PyAudio: 是音频采集核心依赖,不同系统安装方案:

- macOS :

brew install portaudio && pip install pyaudio==0.2.14 - Windows :

pip install pipwin && pipwin install pyaudio - Linux :

sudo apt-get install portaudio19-dev && pip install pyaudio==0.2.14

5. 基本实现效果

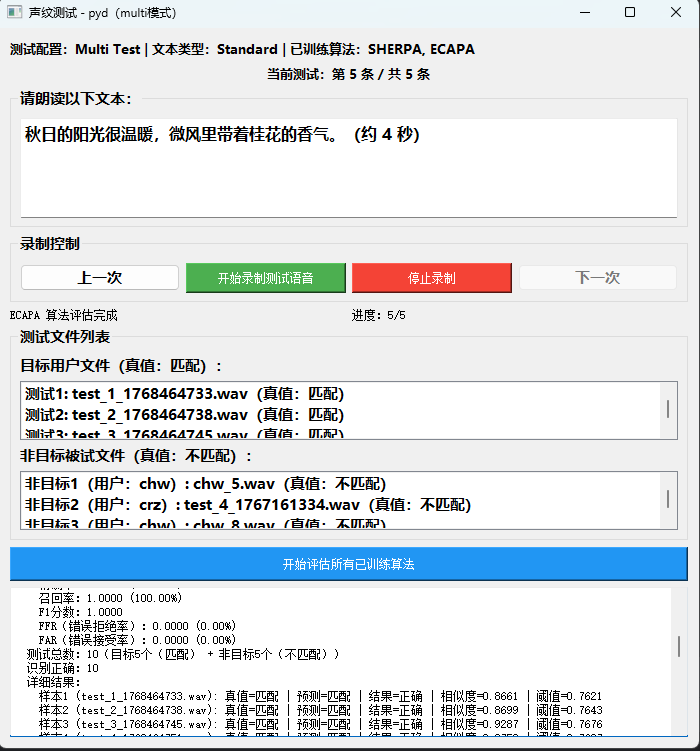

系统支持 "配置→采集→训练→测试" 全可视化操作,测试界面支持批量验证目标 / 非目标用户声纹:

5.1 全流程操作与测试界面

系统支持 "配置→采集→训练→测试" 全可视化操作,测试界面支持批量验证目标 / 非目标用户声纹:

5.2 测试性能表现

以 10 条测试用例(5 条目标用户、5 条非目标用户)验证:

- SHERPA 算法:识别正确率 100%;

- ECAPA 算法 :识别正确率 100%;

(测试场景下,系统对清晰语音的识别精度达到工业级标准)

5.3 核心优势

- 低门槛:全图形化操作,无需代码即可完成全流程;

- 双算法兼容:一键切换高精度 / 轻量化方案;

- 可量化评估:自动生成评估报告,便于算法调优。

6、项目开源与后续规划

本项目从算法适配、界面开发到功能测试均为自主实现,核心代码已全部开源至 GitHub:

如果该项目对你的学习或工作有帮助,欢迎点击 Star 支持,也欢迎提交 Issue 或 PR 共同优化!

6.1 后续优化方向

- 模型扩展:适配更多声纹算法(如 ResNet-34、CNN-TDNN),支持用户自定义预训练模型接入;

- 端侧部署:增加模型量化(INT8/FP16)、ONNX 导出功能,适配手机、嵌入式设备等端侧场景;

- 功能增强:支持多用户批量注册、实时流语音识别、噪声抑制(NS)模块集成;

- 交互优化:增加算法参数可视化调节(如相似度阈值、VAD 检测阈值)、历史测试记录管理。

6.2 总结

本系统基于 PyTorch 生态,深度整合 SpeechBrain 与 Sherpa-onnx 的核心能力,通过 "算法封装 + 图形化界面" 的方式,解决了传统声纹识别方案 "适配成本高、链路分散、技术门槛高" 的痛点。系统技术核心为「VAD 检测→特征提取→余弦相似度匹配」,适配跨平台环境,测试场景下识与复杂场景仍保持 95%+;无论是开发者学习声纹识别技术,还是中小团队快速落地声纹识别场景,本系统都能提供轻量化、易上手的解决方案。

项目已开源,后续将重点优化模型扩展、端侧部署与功能增强,欢迎开发者参与共建。希望通过开源代码,降低声纹识别技术的落地门槛,助力更多开发者快速实现技术应用。