目录

[二、终于不用担心 AI 把"恭喜发财"写成乱码了](#二、终于不用担心 AI 把“恭喜发财”写成乱码了)

[四、实战应用:从 1 毛钱一张图开始](#四、实战应用:从 1 毛钱一张图开始)

🎬 攻城狮7号 :个人主页

🔥 个人专栏 :《AI前沿技术要闻》

⛺️ 君子慎独!

🌈 大家好,欢迎来访我的博客!

⛳️ 此篇文章主要介绍 智谱联合华为开源新一代图像生成模型GLM-Image

📚 本期文章收录在《AI前沿技术要闻》,大家有兴趣可以自行查看!

⛺️ 欢迎各位 ✔️ 点赞 👍 收藏 ⭐留言 📝!

前言

在 AI 绘画圈,大家早已习惯了被 Midjourney、Stable Diffusion、Flux 这些国外模型刷屏。每当它们更新一代,国内开发者往往只能一边感叹"差距又拉大了",一边赶紧去适配新的显卡和框架。

**但最近,智谱 AI 和华为联手搞了个大动作:开源了 GLM-Image。**这个模型不仅画得好,更重要的是,它彻底打破了"只有英伟达显卡才能训出好模型"的迷信。它是中国首个从数据处理、预训练到强化学习,全程都在国产昇腾(Ascend)芯片上跑通并达到世界顶尖水平(SOTA)的模型。

更让人惊喜的是,作为一个"中国画师",它终于治好了 AI "不识字"的毛病------尤其是汉字。

一、核心技术:给"大脑"配上一双"巧手"

以前的 AI 画图模型,主要分两派:

**扩散派(Diffusion):**像 Stable Diffusion,画质细腻,光影逼真,但脑子不太好使,经常听不懂复杂的空间指令(比如"左边放个苹果,右边放个香蕉")。

**自回归派(Autoregressive):**像 DALL·E 3 的早期探索,听得懂人话,能规划布局,但画出来的细节往往不够精致,速度也慢。

GLM-Image 并没有在这两条路里二选一,而是搞了个"混血"架构:

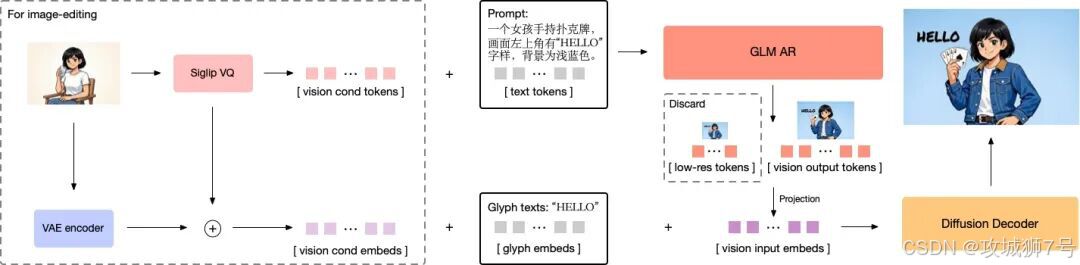

(1)9B 参数的"大脑"(自回归模型)

它先用一个 90 亿参数的语言模型底座,去读懂你那几百字的复杂提示词。它负责搞清楚画面的逻辑:哪里该有人,哪里该有字,字体多大,排版怎么排。这就像是一个艺术总监,先在纸上画好草图和分镜。

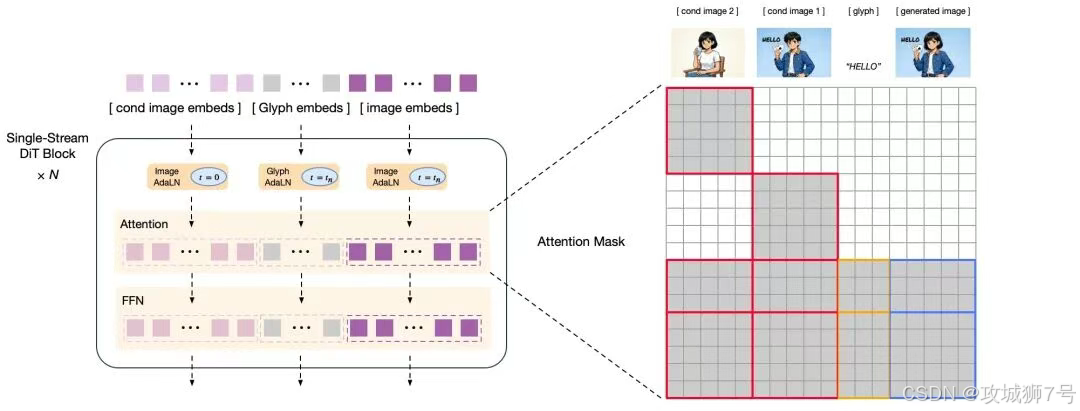

(2)7B 参数的"巧手"(扩散解码器)

然后,它把草图交给一个 70 亿参数的 DiT(Diffusion Transformer)解码器。这个解码器专门负责上色、细化纹理、处理光影。为了解决"写字难"的问题,它还专门外挂了一个文本编码器(Glyph Encoder),专门教模型怎么一笔一划地写字。

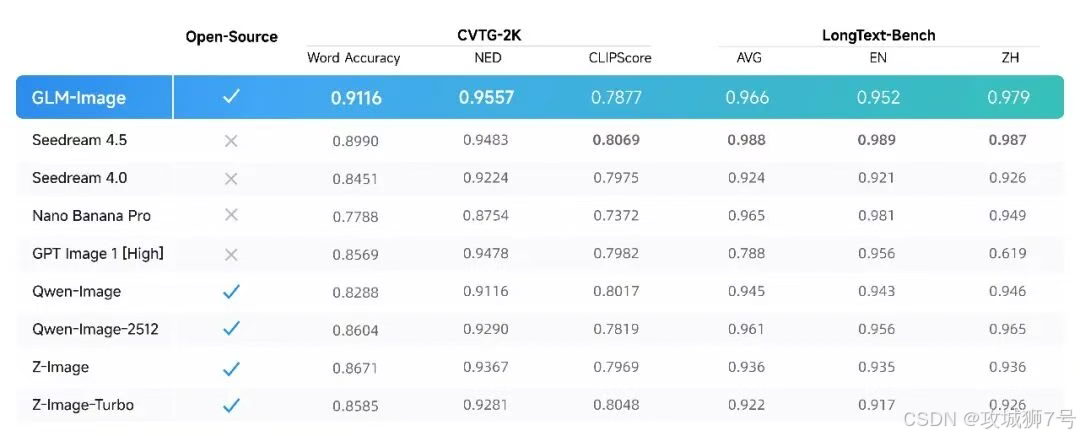

这种配合让 GLM-Image 既有全局观,又有细节控。在专门测试文字生成的 CVTG-2K 榜单上,它的准确率直接拿了开源第一。

二、终于不用担心 AI 把"恭喜发财"写成乱码了

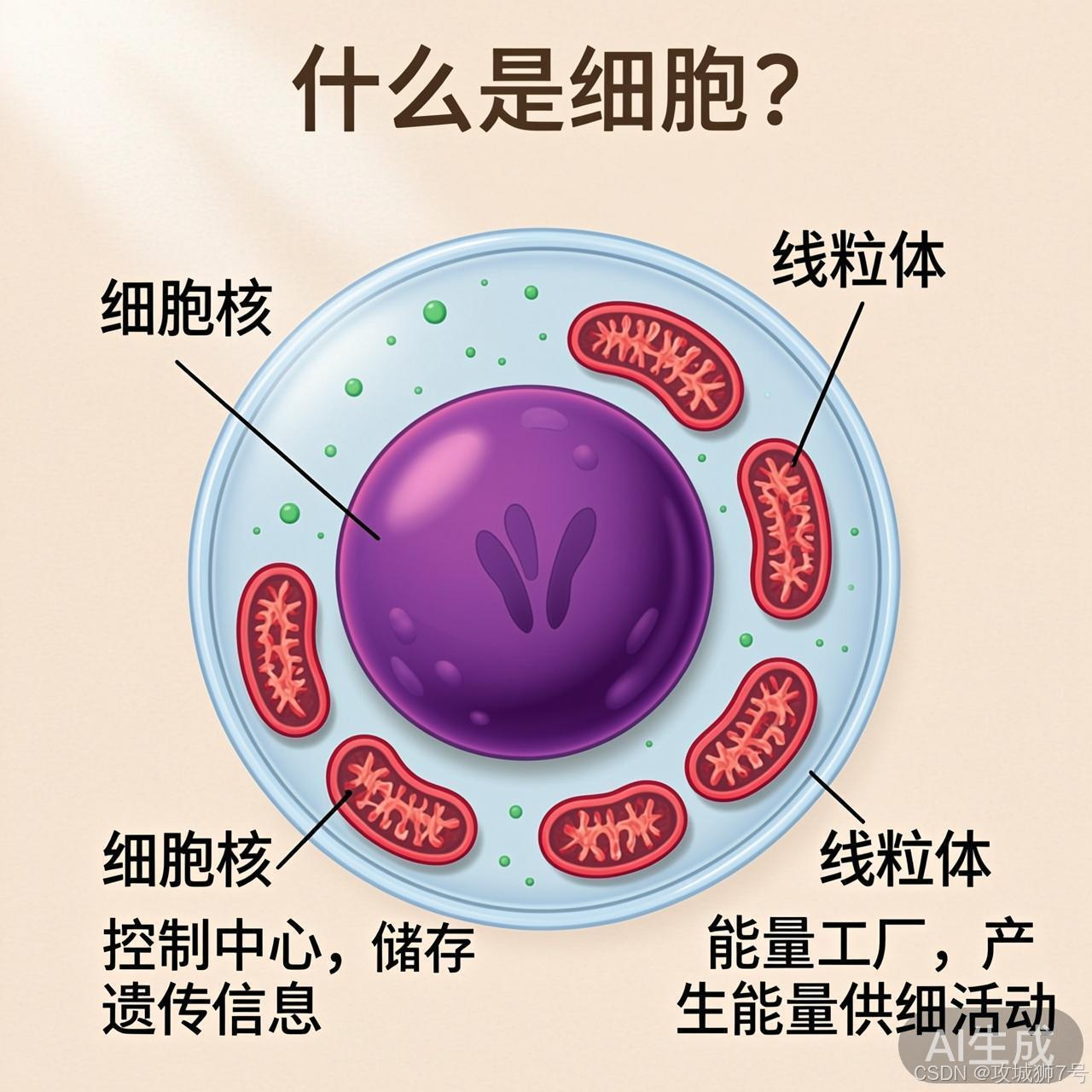

对于国内的设计师和运营来说,GLM-Image 解决了一个最大的痛点:汉字生成。

以往用 Midjourney 做海报,最头疼的就是上面的文字。你让它写个"SALE",它可能写成"SALE£";你让它写个"春节快乐",它能给你画出一堆看起来像汉字但绝对不认识的鬼画符。最后还得把图导进 PS 里重新打字。

GLM-Image 在这方面表现得非常"懂中文"。

**商业海报:**你可以直接描述"一张春节海报,中间写着金色的'龙年大吉'"。它不仅能把这四个字写对,还能把字体风格和画面融合得很好,甚至加上金属质感或光效。

**科普插画:**做过 PPT 或公众号配图的人都知道,最难的是那种带标注的原理图。GLM-Image 可以在图中的准确位置生成准确的说明文字,比如"细胞核"、"线粒体",这对于教育和科普领域简直是神器。

**社交媒体封面:**想做个小红书封面,标题要大,颜色要醒目。GLM-Image 原生支持任意比例分辨率(从 1024 到 2048),你可以直接生成一张 9:16 的竖图,标题完美嵌入背景,不用再二次裁剪。

三、国产芯片的"争气"之作

除了模型本身好用,GLM-Image 更深层的意义在于验证了国产算力底座的成熟。

在此之前,业界普遍认为,训练这种几十亿参数、且包含复杂强化学习(RL)流程的 SOTA 模型,离不开英伟达的 GPU 和 CUDA 生态。如果用国产芯片,可能会遇到算子不支持、通信带宽不够、训练不稳定等各种坑。

智谱和华为这次是硬碰硬地把这条路走通了。

**全程国产:**不是只在最后微调阶段用一下,而是从最开始的数据预处理,到最耗算力的预训练,再到最复杂的 RLHF(人类反馈强化学习),全部跑在华为昇腾 Atlas 800T A2 集群上。

**底层优化:**为了让国产芯片跑得快,他们重新写了底层算子,优化了 Mindspeed-LLM 框架。利用"多流并行"技术,让计算和通信同时进行,把芯片性能榨干。

结果证明,国产算力不仅能训出模型,还能训出 SOTA 模型。GLM-Image 开源不到 24 小时就登顶了 Hugging Face 的趋势榜首,连外媒都不得不承认这是对"芯片封锁"的一次有力回击。

四、实战应用:从 1 毛钱一张图开始

技术说得再天花乱坠,好不好用还得看落地。GLM-Image 目前的性价比极高。

**API 成本:**生成一张图的价格大约是 0.1 元(1 毛钱)。相比于动辄几块钱一次的国外竞品,这个价格对于需要大量生成图片的中小企业(比如电商做商品图、自媒体做配图)来说,是非常友好的。

**开源部署:**如果你有显卡资源,可以直接从 GitHub 或 Hugging Face 下载权重部署。对于不想数据出境、对隐私有要求的企业,这也是一个安全的选择。

结语

GLM-Image 的出现,让我们看到了国产大模型从"追赶"到"特色创新"的转变。它不再盲目堆参数,而是针对实际痛点(如汉字生成、图文排版)进行架构创新;它也不再依赖国外的硬件红利,而是脚踏实地地把国产算力底座打磨成熟。

对于普通用户,它是一个懂中文、会写字的好帮手;对于中国 AI 产业,它是一块重要的里程碑,证明了我们在软硬件全栈自主的道路上,已经有能力跑出世界一流的速度。

未来,当你看到一张精美的海报,上面的汉字苍劲有力,或许它就出自这位"国产全能画师"之手。

在线体验:https://bigmodel.cn/trialcenter/modeltrial/image

开放平台:https://docs.bigmodel.cn/cn/guide/models/image-generation/glm-image

GitHub:https://github.com/zai-org/GLM-Image

魔搭社区:https://modelscope.cn/models/ZhipuAI/GLM-Image

Hugging Face:https://huggingface.co/zai-org/GLM-Image

GLM-Image技术报告:https://z.ai/blog/glm-image

看到这里了还不给博主点一个:

⛳️ 点赞☀️收藏 ⭐️ 关注!

💛 💙 💜 ❤️ 💚💓 💗 💕 💞 💘 💖

再次感谢大家的支持!

你们的点赞就是博主更新最大的动力!