此前我们分享了基于 Langchain-Chatchat 的大模型本地化部署方案,依托 LangChain 的组件化生态,该方案能快速实现 RAG 知识库与基础函数调用能力的整合,满足个人及中小企业轻量化的私有问答需求。

今天,我们将介绍另一款更适配企业级生产场景的大模型部署架构 ------Dify。作为开源的低代码大模型应用开发平台,Dify 以可视化编排为核心特色,不仅具备更完善的函数调用能力,支持参数自动校验、智能追问与多函数并行,还提供 Docker 一键部署、权限管理、日志监控等生产级特性,助力开发者高效搭建稳定可靠的大模型应用。

1 Dify安装

1.1 安装要求

- CPU >= 2 Core

- RAM >= 4 GiB

该配置门槛极低,即便入门级开发板也能满足运行需求,极大降低了企业与个人的部署成本。

1.2 安装要求

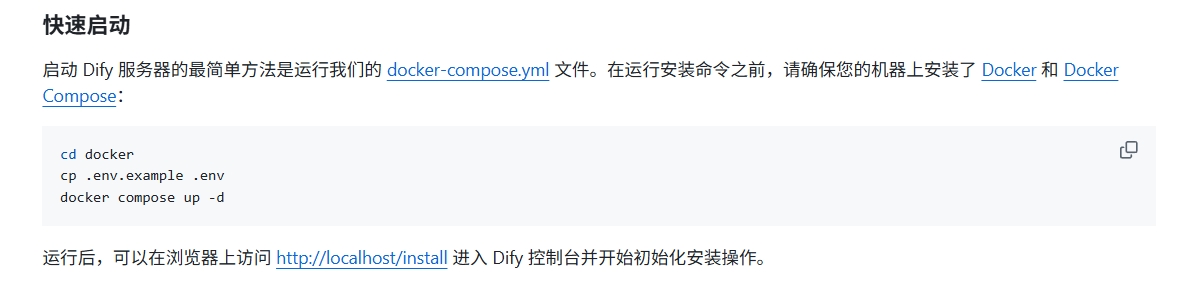

Dify依赖Docker环境运行,若尚未安装Docker,可参考我之前发布的相关教程。安装完成Docker后,按以下步骤部署Dify:

安装完成Docker之后使用以下命令安装dify:

shell

# 克隆Dify源码仓库

git clone https://github.com/langgenius/dify.git

# 进入项目目录

cd dify

# 切换至Docker部署目录

cd docker

# Windows系统需手动复制.env.example并重命名为.env,Linux/Mac可执行以下命令

cp .env.example .env

# 启动Docker容器,后台运行

docker compose up -d注:若克隆源码或拉取镜像失败,可尝试更换国内镜像源或通过科学上网解决网络问题。

部署完成后,在本地浏览器访问 http://localhost/install,进入Dify初始化配置界面:

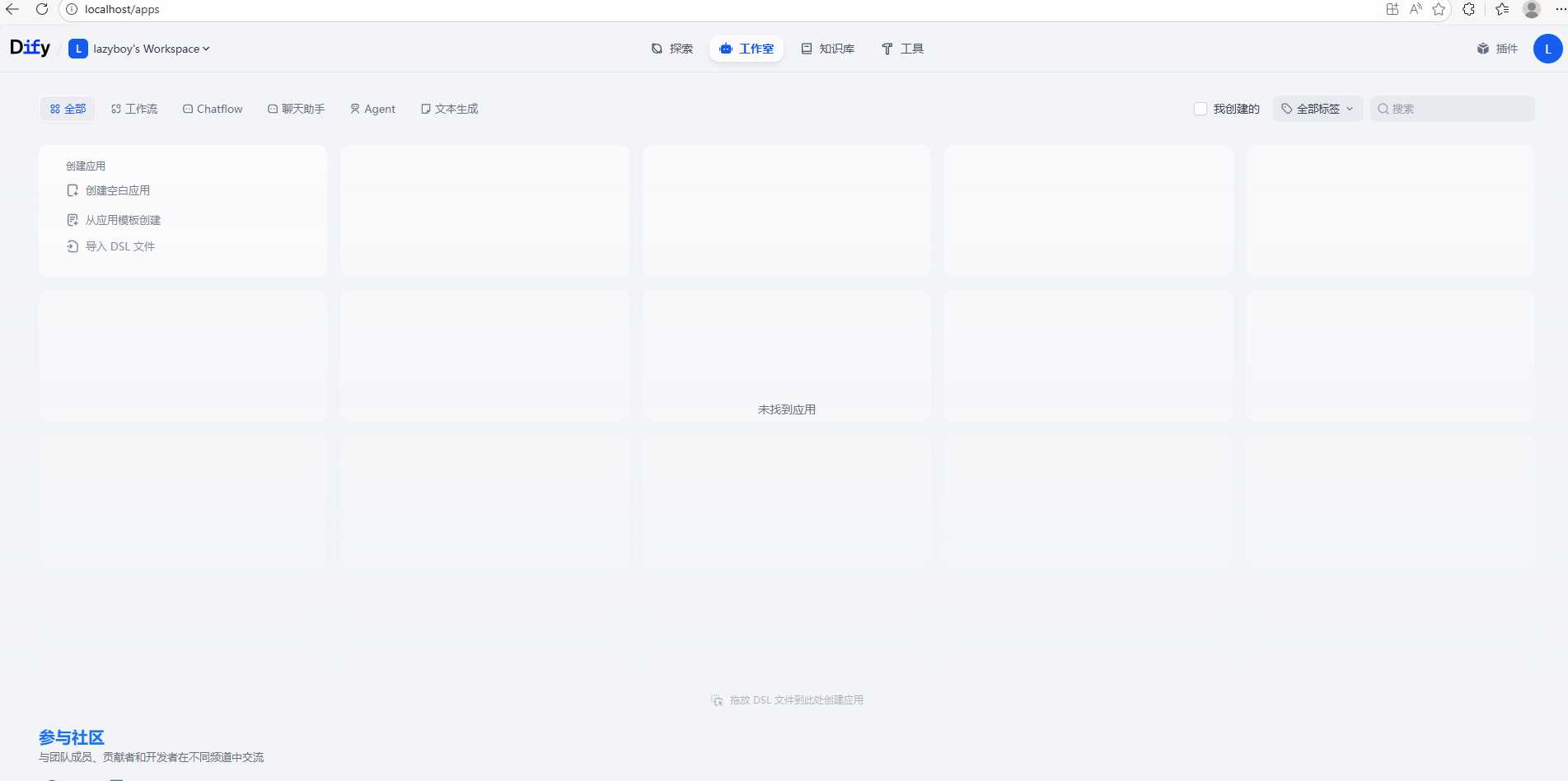

完成初始化配置并登录后,即可进入Dify主控制台,正式开启应用搭建:

2 Dify使用

2.1 聊天助手搭建与使用

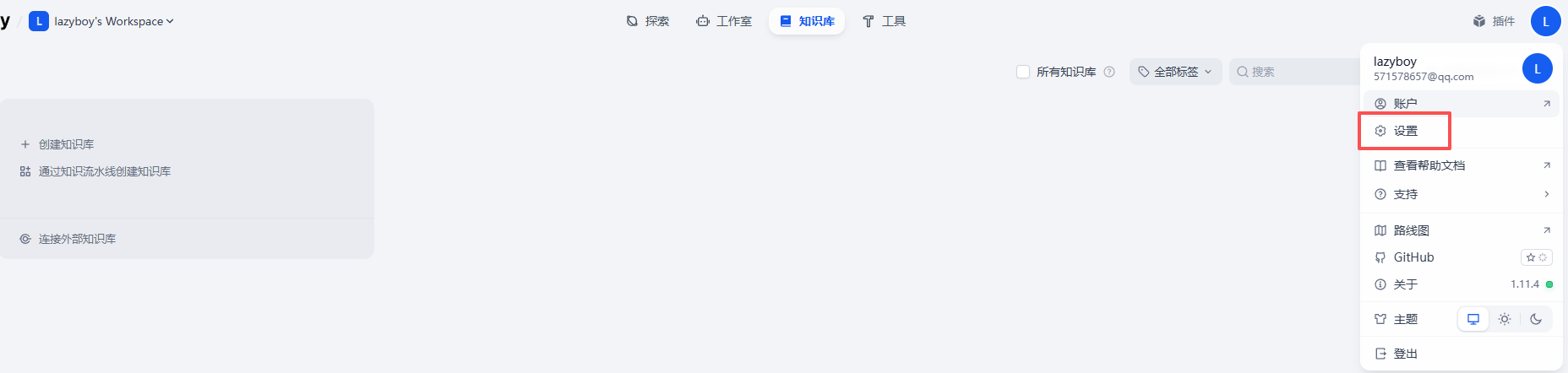

2.1.1 设置模型供应商

设置之前,首先确保你有大模型推理框架,比如说Ollama、xinference等,如果不知道怎么安装的可以看我之前写的文章:

Windows| DeepSeek最简单的本地部署方法

Windows 平台 Xinference 安装指北教程

推理框架部署完成后,按以下步骤配置Dify模型供应商:

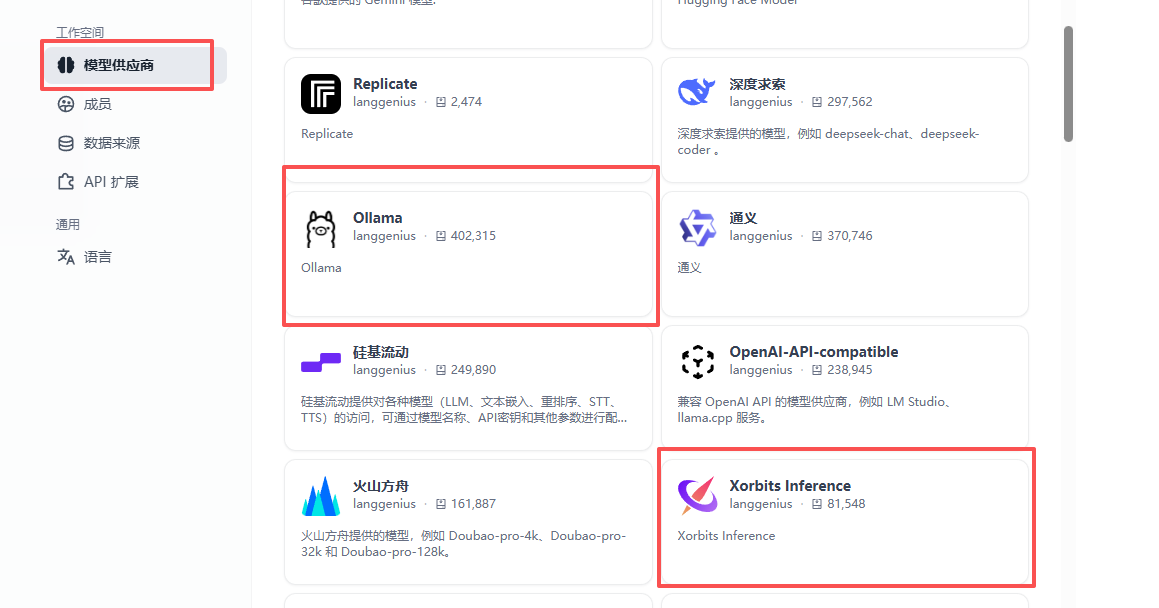

Dify原生支持Ollama、Xinference等主流推理框架,按需选择即可:

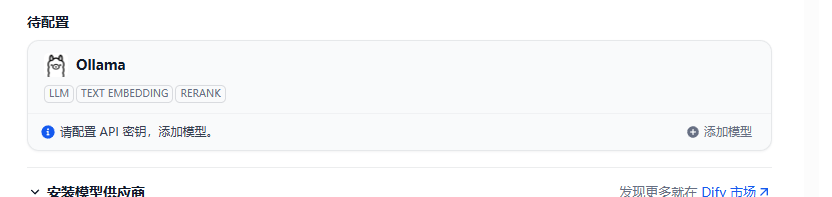

我们选择ollama,然后安装,安装完成后可以配置密钥:

点击添加模型->新添加模型,然后出现以下界面:

填写模型信息与宿主机IP后,点击「添加」即可完成配置。

关于IP配置的说明:

host.docker.internal 是Docker官方为Windows/Mac平台(Docker Desktop)内置的特殊DNS域名,核心作用是让Docker容器内部直接访问宿主机本机的所有服务(对应宿主机的127.0.0.1/localhost)。本质是Docker封装的宿主机IP映射快捷方式,无需手动写死宿主机真实IP,提升部署灵活性。

2.1.2 模型连通性测试

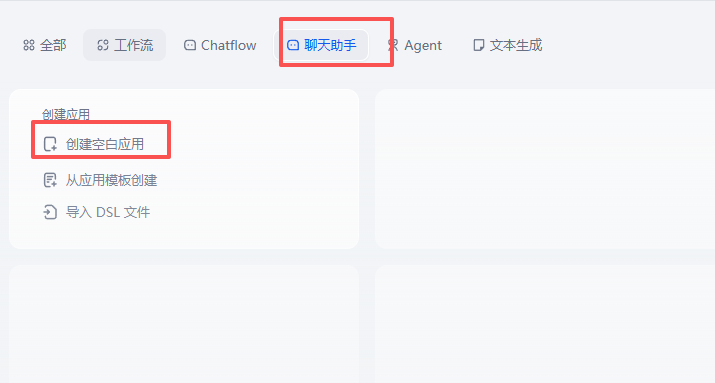

模型配置完成后,通过创建聊天助手应用测试连通性:

-

选择「聊天助手」,点击「创建空白应用」:

-

输入应用名称与描述,点击「创建」:

-

进入对话界面,输入测试内容即可验证模型响应能力:

2.2 Agent工具调用实战

2.2.1 Agent应用创建

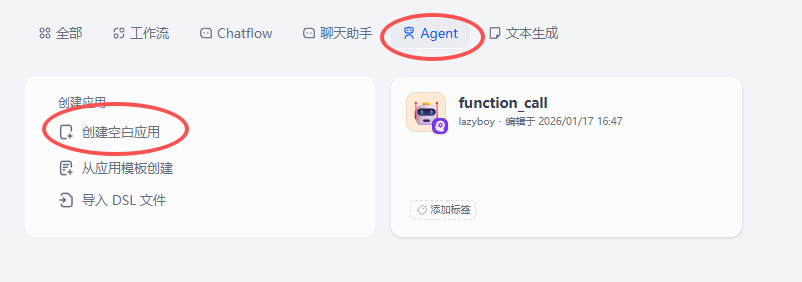

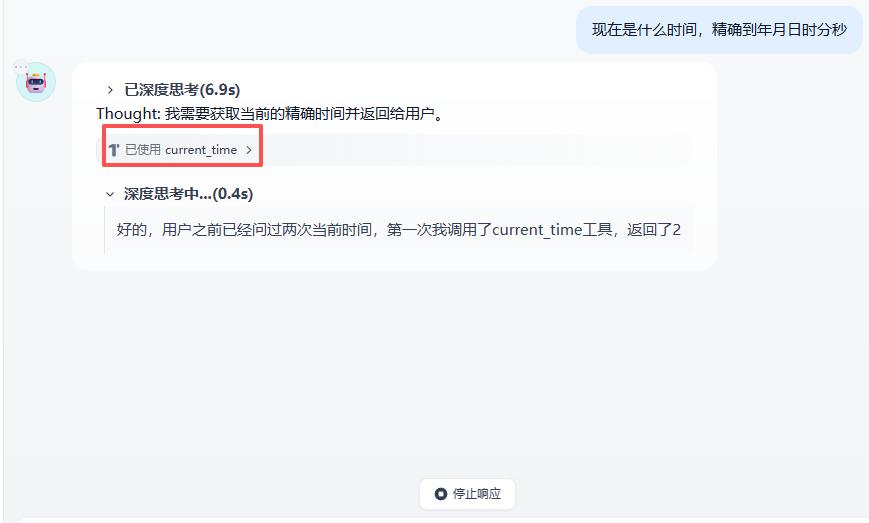

Dify的Agent具备知识库与第三方工具调用能力,可根据用户需求自动匹配工具分析问题(如查询实时时间需调用时间工具)。创建Agent应用步骤如下:

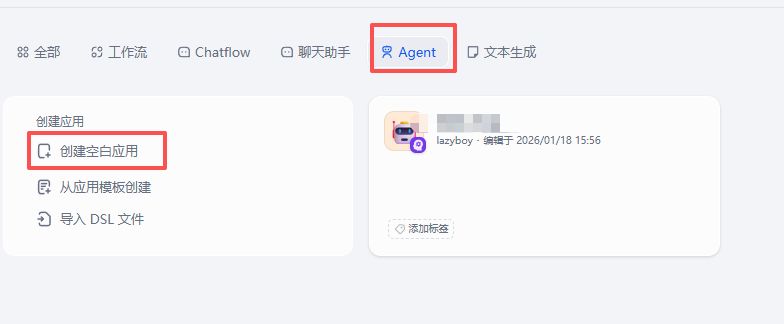

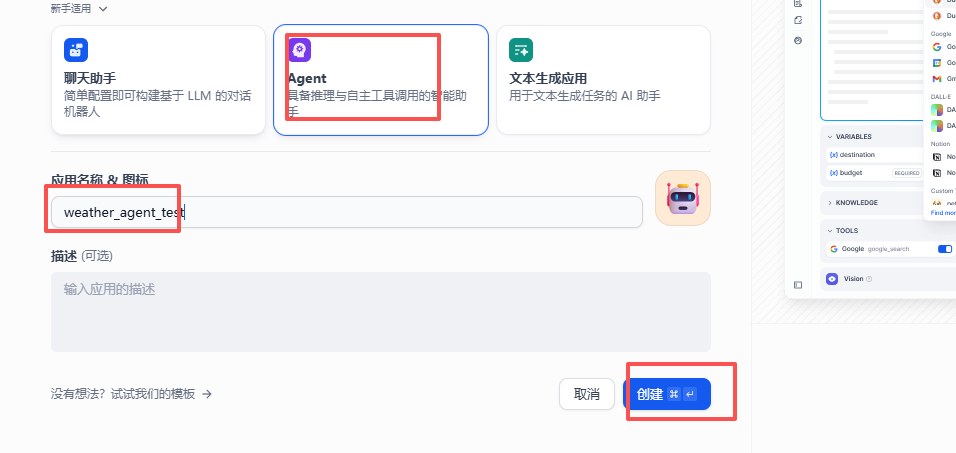

- 点击「Agent」,选择「创建空白应用」:

- 输入应用名称和描述,然后点击创建:

- 添加工具:

- 创建完成后,Agent可自动识别用户意图并调用对应工具,例如查询当前时间时,会触发工具调用逻辑获取结果:

2.2.2 MCP服务注册与集成

若需调用自定义工具,需先搭建MCP服务器并在Dify中注册,MCP服务器搭建教程可参考:基于 LLM 的 MCP 架构实战:服务端搭建、工具开发与 Dify 集成全流程,以下为Dify中MCP服务的注册步骤:

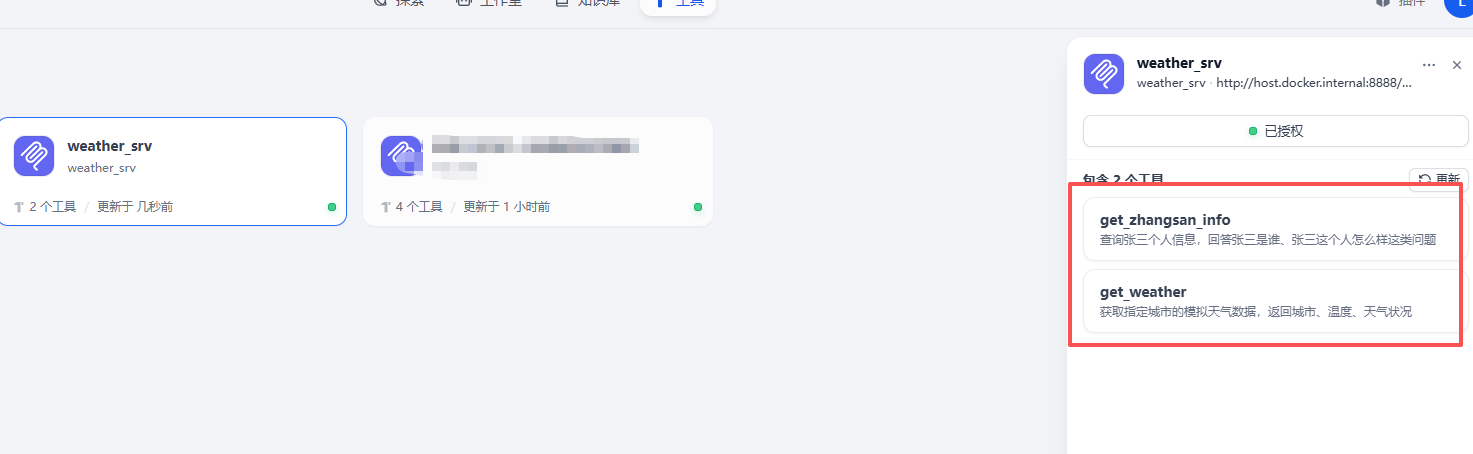

- 进入Dify后台,点击「工具」→「添加MCP服务」,进入配置页面:

- 按要求填写MCP服务参数,完成配置:

配置提交后,Dify会自动校验服务连通性,并加载MCP服务中注册的所有工具函数,完成服务与LLM平台的绑定:

2.2.3 MCP服务调用测试

- 创建专属Agent应用,完成基本配置:

按照下图所示完成 Agent 的基本配置:

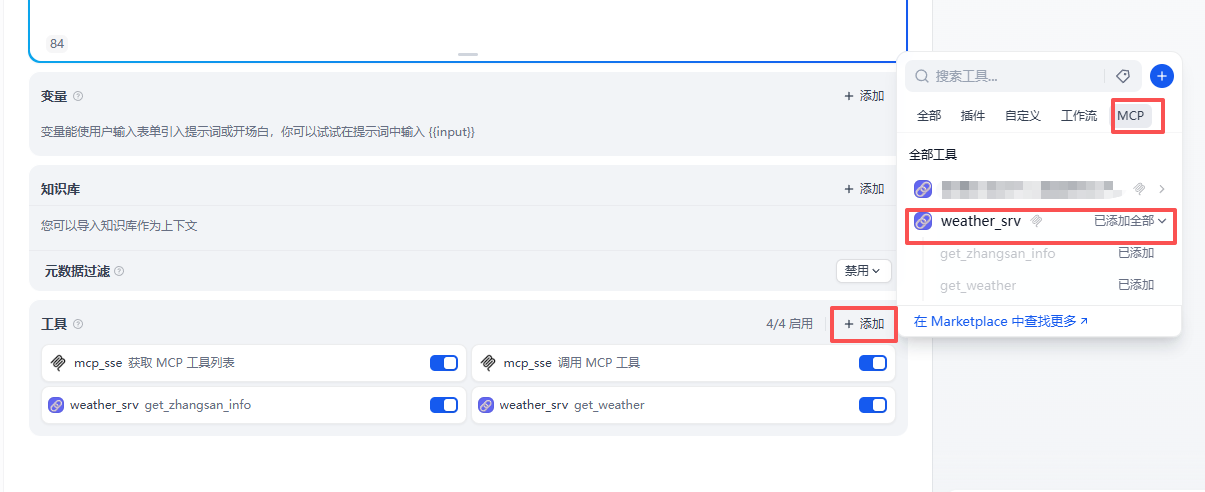

2.在Agent工具配置模块,点击「添加」,选中已注册的MCP工具函数,完成绑定:

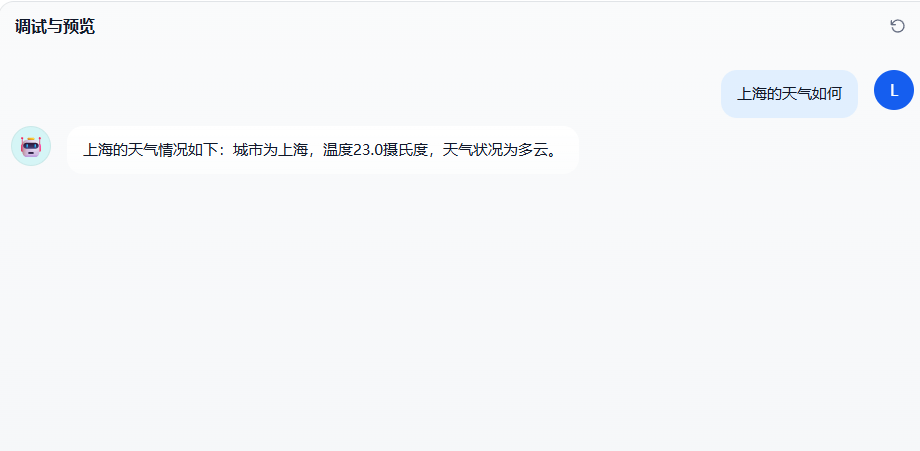

3.在对话界面发起业务请求,触发LLM自动调用MCP工具,获取返回结果:

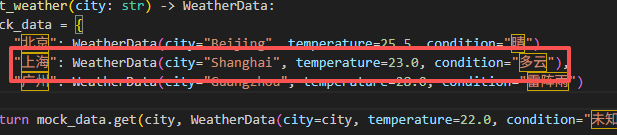

实际测试中可看到,Dify 中的 LLM 能精准识别用户意图,自动调用对应的get_zhangsan_info和get_weather函数,MCP 服务端正常响应并返回标准化数据,工具调用链路通畅,结果返回准确:

总结

本文此前分享了基于 Langchain-Chatchat 的轻量化私有问答部署方案,此次聚焦企业级生产场景,介绍开源低代码平台 Dify 的部署与使用。Dify 以可视化编排为核心,具备完善的函数调用、参数校验、权限管理等生产级特性,Docker 一键部署即可完成,最低仅需 2 核 CPU、4GiB 内存。安装后通过http://localhost/install完成初始化,后续需先配置模型供应商(支持 Ollama、Xinference 等,容器内通过 host.docker.internal 访问宿主机服务),再创建 Agent 空白应用即可启用。该方案适配企业级稳定需求,助力开发者高效搭建大模型应用,兼顾易用性与生产级可靠性。