目录

-

- 前言

- 2月:大模型战国时代的开启与本地化部署的尝试

- 3月:云端算力的可视化与角色扮演的深度定制

- [4月:边缘计算与 MCP 协议的初次邂逅](#4月:边缘计算与 MCP 协议的初次邂逅)

- [5月:AI 原生 IDE 的革新与 CodeBuddy 的崛起](#5月:AI 原生 IDE 的革新与 CodeBuddy 的崛起)

- [6月:MCP 生态的全面爆发](#6月:MCP 生态的全面爆发)

- 7月:设计到代码的闭环与浏览器自动化

- 8月:从安全防御到协议构建与全栈部署

- 9月:命令行交互的智能化重构

- 12月:智能体开发平台与逻辑推理游戏

- 1月:内容创作流的云端闭环

- [结语:与云共生的 AI 之年](#结语:与云共生的 AI 之年)

前言

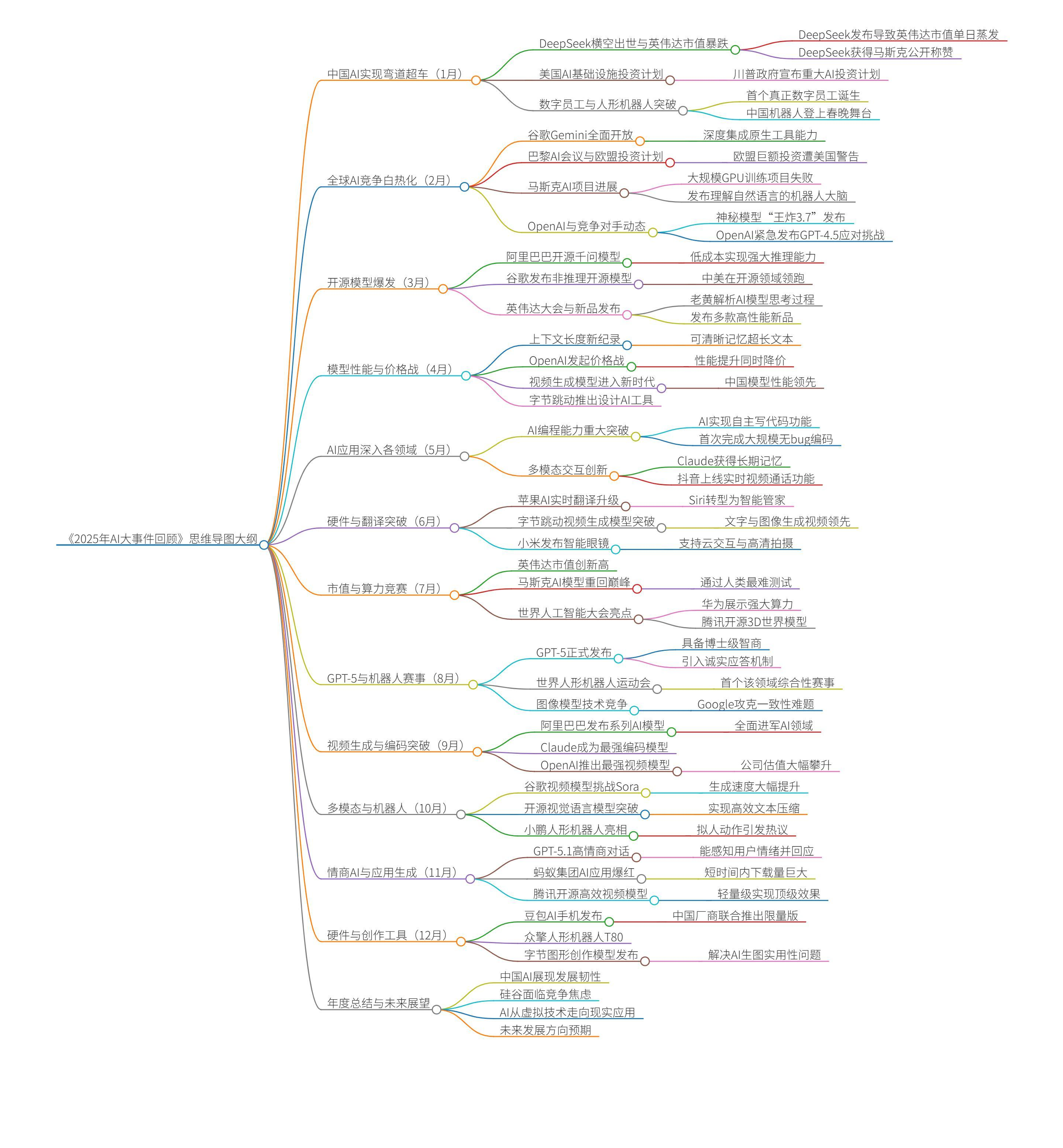

2025 年对于开发者而言,是技术范式发生剧烈重构的一年。如果说前两年的 AI 浪潮更多停留在"对话"与"生成"的层面,那么 2025 年则标志着 AI 正式接管了从基础设施部署、协议标准化到全栈代码交付的完整工作流。这一年,技术的边界被打破,基于 Model Context Protocol (MCP) 的生态连接、边缘计算的普及以及智能体(Agent)的深度应用,共同构建了一个全新的开发宇宙。

回顾这一年,从年初 DeepSeek 的算力博弈,到年末利用 Claude Code 与腾讯云全家桶实现的全自动化交付,这是一场关于效率与创造力的进化。

2月:大模型战国时代的开启与本地化部署的尝试

2025 年初,科技界的目光聚焦于 DeepSeek 的横空出世。这不仅仅是一个新模型的发布,更是一场关于算力、算法优化与开源精神的无硝烟战争。随着 DeepSeek 展现出惊人的推理能力,全球开发者陷入了对高性能模型的狂热追逐,服务器负载的红色警报成为了一种常态。

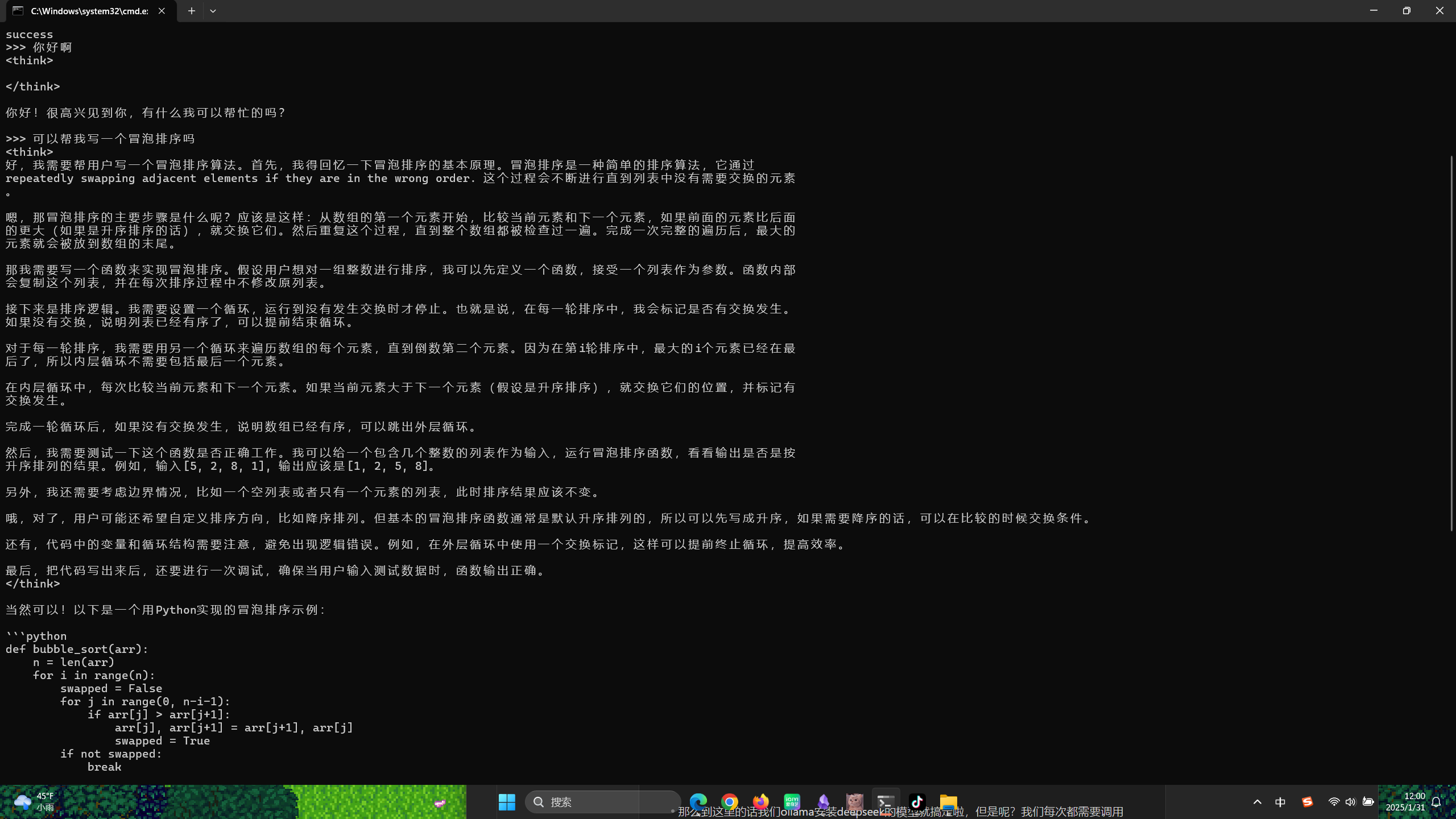

面对云端 API 的不确定性与延迟,本地化部署(Local Deployment)成为了当时最迫切的技术需求。本地部署不仅仅是为了避开网络的拥堵,更是为了数据的隐私安全与低延迟交互。通过 Ollama 等容器化工具,将量化后的 DeepSeek 模型加载至本地 GPU 或高内存 CPU 环境中,成为了当时技术社区的热门议题。

当时撰写的第一篇关于本地 AI 部署的技术文档,详细记录了如何从拉取镜像到暴露 API 端口的全过程。这一实践证明,算力民主化正在让每一台终端都具备成为智能中心的能力。

在本地终端的黑色背景与白色字符之间,第一次与 DeepSeek 的对话标志着个人开发模式的转变。此时的模型已经具备了极强的逻辑推理能力,能够理解复杂的上下文指令,而不再仅仅是简单的关键词匹配。

随后的几周内,云计算巨头迅速跟进。腾讯云将 DeepSeek 深度集成至其大模型知识引擎 LKE (LLM Knowledge Engine) 中。这是一个典型的 RAG (检索增强生成) 架构应用。通过 LKE,企业可以将私有知识库进行向量化处理(Embedding),存储于向量数据库中。当用户发起提问时,系统首先在向量库中检索相关片段,然后将检索结果作为上下文(Context)输入给 DeepSeek 模型。

DeepSeek 强大的总结与推理能力,结合 LKE 精准的检索能力,解决了大模型普遍存在的"幻觉"问题,使得生成的内容既具有逻辑性又具备事实依据。这种架构迅速成为了企业级 AI 应用的标准范式。

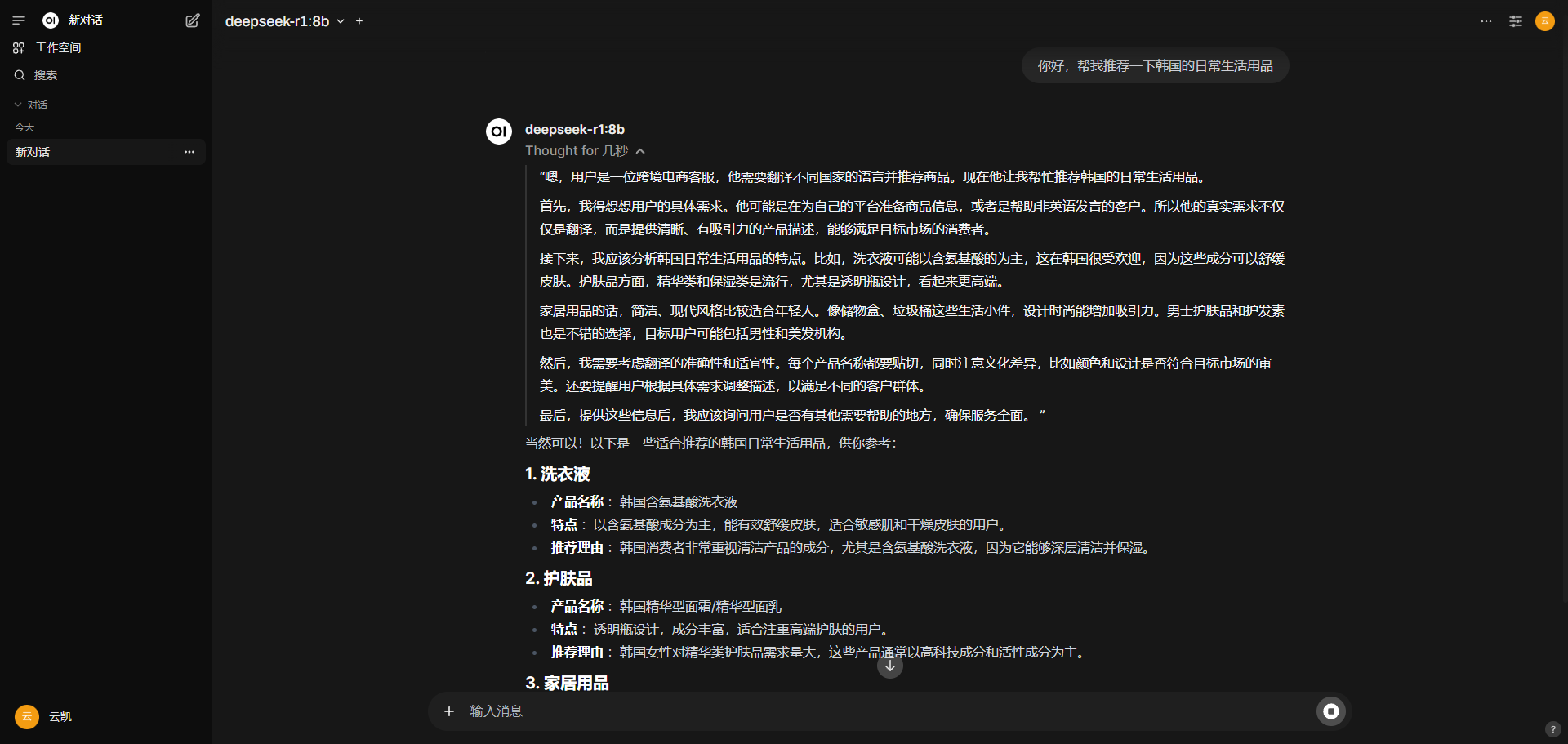

3月:云端算力的可视化与角色扮演的深度定制

随着模型参数量的提升,本地硬件的瓶颈逐渐显现。3月份,重心转向了基于云端高性能计算资源的部署。腾讯云高性能应用服务 HAI (High Performance Application Service) 提供了一种开箱即用的解决方案。特别是其 CPU 算力实例,经过特定的指令集优化,能够以较低的成本运行大参数量的推理任务,打破了"AI 必须依赖昂贵 GPU"的固有认知。

在服务器端部署 WebUI,实现了可视化的交互界面。这不仅仅是 UI 的改变,更重要的是它支持了参数的动态调整,如 Temperature(温度值)、Top-P 等,让开发者能够直观地感受到不同参数对模型输出创造性的影响。

在这一阶段,Prompt Engineering(提示词工程)的重要性被提升到了新的高度。在可视化的对话界面中,通过系统级指令(System Prompt)给 DeepSeek 赋予特定的"身份"。例如,设定其为一名资深的 Python 架构师或一名精通 SEO 的内容创作者。

这种基于身份的上下文设定,利用了模型在预训练阶段接触到的特定领域数据分布。当模型"认为"自己是某个角色时,其输出的术语准确度、逻辑结构以及解决问题的视角都会发生显著变化。通过这种方式,AI 不再是一个通用的聊天机器人,而是一个具备特定专业技能的虚拟员工。

4月:边缘计算与 MCP 协议的初次邂逅

4月份的技术探索进入了架构层面,重点在于如何打破数据孤岛与提升访问速度。腾讯云 EdgeOne 的引入,将应用部署推向了边缘计算节点。EdgeOne Pages 不仅提供了静态资源的托管,更重要的是利用其全球加速网络,将内容分发至离用户最近的节点。

与此同时,MCP (Model Context Protocol) 开始进入视野。这是一个旨在标准化 AI 模型与外部数据、工具交互的协议。利用 EdgeOne Pages Deploy MCP Server,可以将本地开发的静态网页项目快速封装并部署至公网。这背后涉及到 CI/CD 流水线的自动化构建,以及边缘函数(Edge Functions)对 HTTP 请求的路由处理。

通过 EdgeOne 直接连接 GitHub 或 Gitee 仓库,实现了代码提交即部署的 GitOps 流程。这种无缝的集成极大地缩短了从代码编写到产品上线的周期,让开发者能够专注于业务逻辑而非繁琐的运维配置。

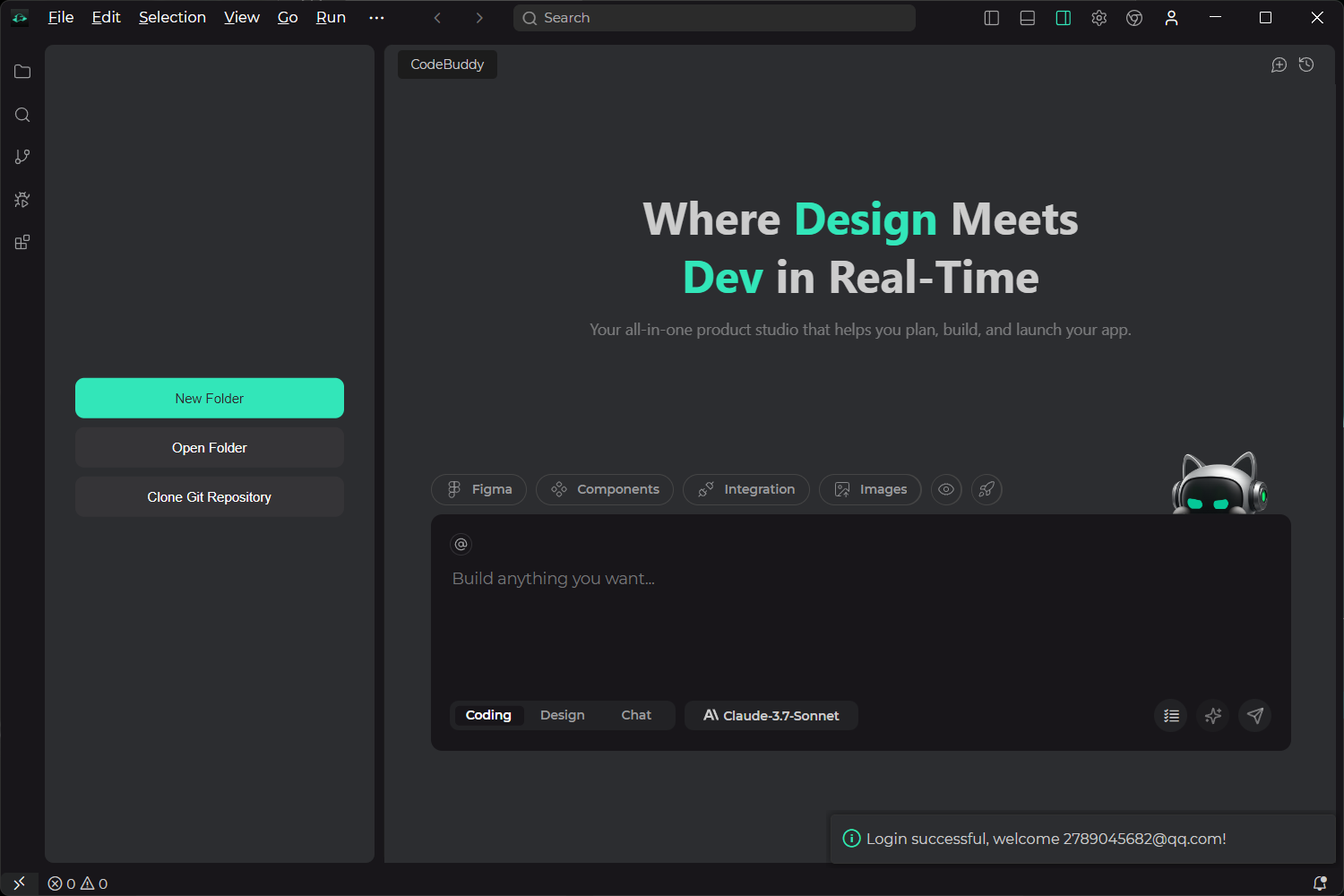

5月:AI 原生 IDE 的革新与 CodeBuddy 的崛起

5月标志着开发工具本身的智能化革命。腾讯发布了 AI 时代的 IDE ------ CodeBuddy。作为首批内测用户,深刻体验到了 AI 并非仅仅是代码补全工具,而是结对编程(Pair Programming)的实体化身。

CodeBuddy 深度理解项目的全量代码上下文(Context Awareness),能够基于整个项目结构提出重构建议。利用这一工具,开发了一款基于 Chrome 浏览器的网页翻译插件。这不仅仅是调用翻译 API,更涉及 DOM 树的解析、文本节点的替换以及异步请求的并发控制。CodeBuddy 在处理复杂的 JavaScript 异步逻辑和 CSS 样式隔离方面展现出了惊人的效率。

凭借对 CodeBuddy 的深度应用与技术解析,在年底的腾讯云大会上获得了最具价值原创作者的荣誉。这不仅是对个人技术探索的肯定,也是 AI 辅助开发模式逐渐成为主流的有力证明。

6月:MCP 生态的全面爆发

6月是 MCP 协议深度实践的一个月。MCP 的核心价值在于提供了一种通用的接口标准,使得 AI 模型可以"读写"外部系统。在这个月里,针对 Redis、MySQL、Obsidian 和 Figma 等不同类型的软件和服务,进行了 MCP 服务的配置与测试。

对于 MySQL MCP,AI 可以直接生成 SQL 查询语句并执行,从而实现自然语言查询数据库;对于 Figma MCP,AI 可以读取设计图的图层数据,理解设计规范。这种跨应用的数据互通,彻底打破了传统 SaaS 软件之间的壁垒,让 AI 成为了连接一切的万能胶水。

7月:设计到代码的闭环与浏览器自动化

CodeBuddy 的功能在 7 月迎来了重大升级,真正实现了"设计即代码"的愿景。新引入的功能模块包括 Select from Figma、Select Component、Config MCP、Upload Images、Preview 以及 Deploy。

通过 Select from Figma 功能,开发者可以直接在 IDE 中选中 Figma 的设计组件,CodeBuddy 能够解析其向量数据与样式属性,自动生成高质量的 React 或 Vue 组件代码。配合小红书卡片 MCP,这一工作流被应用于生成极具视觉冲击力的社交媒体封面。AI 能够自动分析当下的设计趋势,调整配色与排版,生成符合算法推荐逻辑的图片。

生成的封面不仅美观,而且严格遵循了图层分离与响应式设计的原则,展示了 AI 在创意设计领域的落地能力。

同月,Claude Code 与 BrowserCat MCP 的组合开启了网页自动化的新纪元。BrowserCat 提供了一个无头浏览器(Headless Browser)环境,通过 MCP 协议受控于 Claude。这意味着可以使用自然语言指挥 AI 去执行复杂的网页操作,如自动抓取数据、表单填写、甚至跨站点的交互测试。

在终端界面中,可以看到 AI 逐步解析网页结构、定位元素并执行操作的日志。这种自动化能力不再依赖脆弱的 CSS 选择器脚本,而是基于 AI 对网页语义的视觉理解,极大地提高了自动化任务的稳定性。

8月:从安全防御到协议构建与全栈部署

8月通过对腾讯 IOA (一体化终端安全管理系统) 的深度体验,补全了安全领域的拼图。在企业级开发中,安全是基石。IOA 提供了从病毒查杀、漏洞修复到资产管理的全面防护。其核心在于"零信任"架构的落地,确保只有合规的终端和身份才能访问企业资源。仪表盘上清晰展示了终端的安全评分与威胁拦截记录,为全栈开发提供了坚实的后盾。

在掌握了 MCP 的使用后,技术探索深入到了协议的创造层面。通过 Python 编写自定义的 MCP Server,并将其打包发布至 PyPI。这一过程涉及定义 MCP 的 JSON-RPC 接口、处理标准输入输出流(Stdio)以及 Python 包的构建(Poetry/Setuptools)。将原本分散的脚本工具封装成标准化的 MCP 服务,使得任何支持 MCP 的 AI 客户端都能直接调用这些能力。

基础设施方面,利用腾讯云轻量应用服务器(Lighthouse)配合宝塔面板搭建了个人 WordPress 站点。Lighthouse 提供了开箱即用的应用镜像,而宝塔面板则简化了 Nginx、PHP、MySQL 的配置管理。这是一个经典 LAMP/LEMP 栈的现代化实践。

随后,为了进一步提升站点的访问速度与安全性,EdgeOne 再次登场。这一次,它不仅仅是静态托管,而是作为动态站点的全站加速网关。配置了 CNAME 接入后,EdgeOne 提供了 DDoS 防护、Web 应用防火墙(WAF)以及智能路由优化。个人网站不仅实现了全球秒开,更具备了企业级的安全防护能力。

9月:命令行交互的智能化重构

随着 CodeBuddy CLI 的发布,服务器管理进入了"对话即运维"(ChatOps)的时代。CodeBuddy CLI 允许开发者在终端中直接与 AI 交互,通过自然语言生成复杂的 Shell 命令。

结合 Lighthouse MCP,这种交互变得更加强大。AI 可以直接读取服务器的状态(CPU 负载、内存使用、进程列表),并根据指令执行重启服务、查看日志或配置防火墙等操作。这避免了记忆繁琐的 Linux 命令参数,降低了运维门槛,同时也减少了误操作的风险。

12月:智能体开发平台与逻辑推理游戏

年末,腾讯元器(Yuanqi)平台的推出标志着智能体开发的普及化。在该平台上,开发了一款沉浸式的"海龟汤"推理智能体。

这不仅仅是一个聊天机器人,而是一个具备复杂状态管理的 Agent。它需要维护游戏的当前状态(谜面、已知的线索、玩家的提问历史),并根据预设的逻辑判断玩家的猜测是"是"、"否"还是"不相关"。腾讯元器提供了强大的提示词编排工具和知识库挂载能力,使得智能体能够严格遵守游戏规则,同时保持互动的趣味性与悬疑感。

1月:内容创作流的云端闭环

跨入新的一年,为了提升内容创作的效率,构建了一套基于腾讯云对象存储(COS)、PicGo 与 Obsidian 的无缝图床工作流。

COS 提供了高可靠、低成本的非结构化数据存储。通过配置 PicGo 工具,使其对接 COS 的 S3 兼容接口。在 Obsidian 中撰写 Markdown 文章时,粘贴的图片会自动触发 PicGo 的上传任务,将图片传输至云端,并返回标准的 Markdown 图片链接。这一流程极大地优化了写作体验,实现了本地写作、云端存储的内容生产模式。

结语:与云共生的 AI 之年

从年初 DeepSeek 的算力争夺,到年末构建复杂的 AI 智能体与全栈工作流,这一年的技术轨迹清晰地展示了 AI 如何从一个"玩具"进化为生产力核心。腾讯云提供的全方位基础设施------从 HAI 的算力、LKE 的知识引擎、EdgeOne 的边缘网络到 CodeBuddy 的开发工具------为这一进化提供了坚实的土壤。

代码不再仅仅是逻辑的堆砌,而是意图的表达;开发不再仅仅是敲击键盘,而是编排模型与服务的协奏曲。在这场技术变革中,与云的深度融合,让每一个开发者都拥有了改变世界的能力。

言尽于此,祝各位新年快乐,码到成功