想获取在 Windows 10 系统中纯 Docker 方式安装 Xinference 的极简、可直接执行的步骤,通过Docker来部署相对省心,没有太多的冗余步骤,确保一键式落地。

一、前置条件(Win10 必做)

- 已安装 Docker Desktop(官网下载:https://www.docker.com/products/docker-desktop/);

- 启动 Docker Desktop,确保右下角托盘图标显示「Running」(首次启动需开启 WSL 2 后端,按提示完成即可);

- 以管理员身份打开命令提示符(CMD)或 PowerShell(避免权限问题)。

二、Docker 安装 Xinference 核心步骤

步骤 1:拉取 Xinference 官方镜像

bash

# 拉取最新稳定版 Xinference 镜像

docker pull xprobe/xinference:latest

# 验证镜像是否拉取成功(显示 xprobe/xinference 即生效)

docker images | findstr xinference步骤 2:启动 Xinference 容器(关键)

执行以下命令启动容器,自动映射端口、挂载模型缓存目录(避免重复下载模型):

bash

# Windows CMD 命令(复制直接运行)

docker run -d ^

--name xinference-server ^

-p 9997:9997 ^

-v %USERPROFILE%\.xinference:/root/.xinference ^

xprobe/xinference:latest ^

xinference-local --host 0.0.0.0 --port 9997

# 若用 PowerShell,替换为:

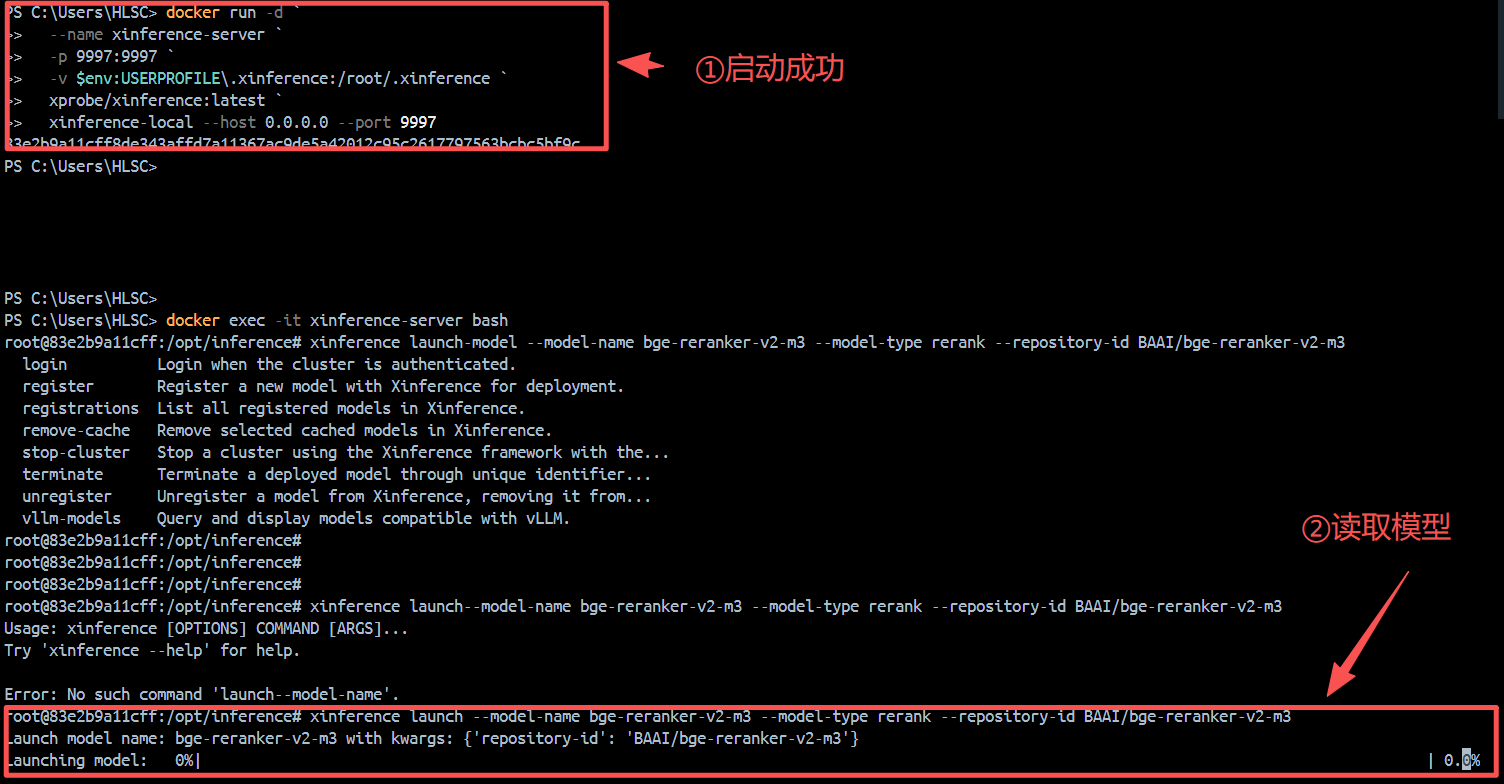

docker run -d `

--name xinference-server `

-p 9997:9997 `

-v $env:USERPROFILE\.xinference:/root/.xinference `

xprobe/xinference:latest `

xinference-local --host 0.0.0.0 --port 9997参数说明:

--name xinference-server:给容器命名,方便后续管理;-p 9997:9997:映射容器 9997 端口到主机,外部可访问;-v %USERPROFILE%\.xinference:/root/.xinference:挂载主机的模型缓存目录,重启容器后模型不丢失;--host 0.0.0.0:允许容器外部访问 Xinference 服务。

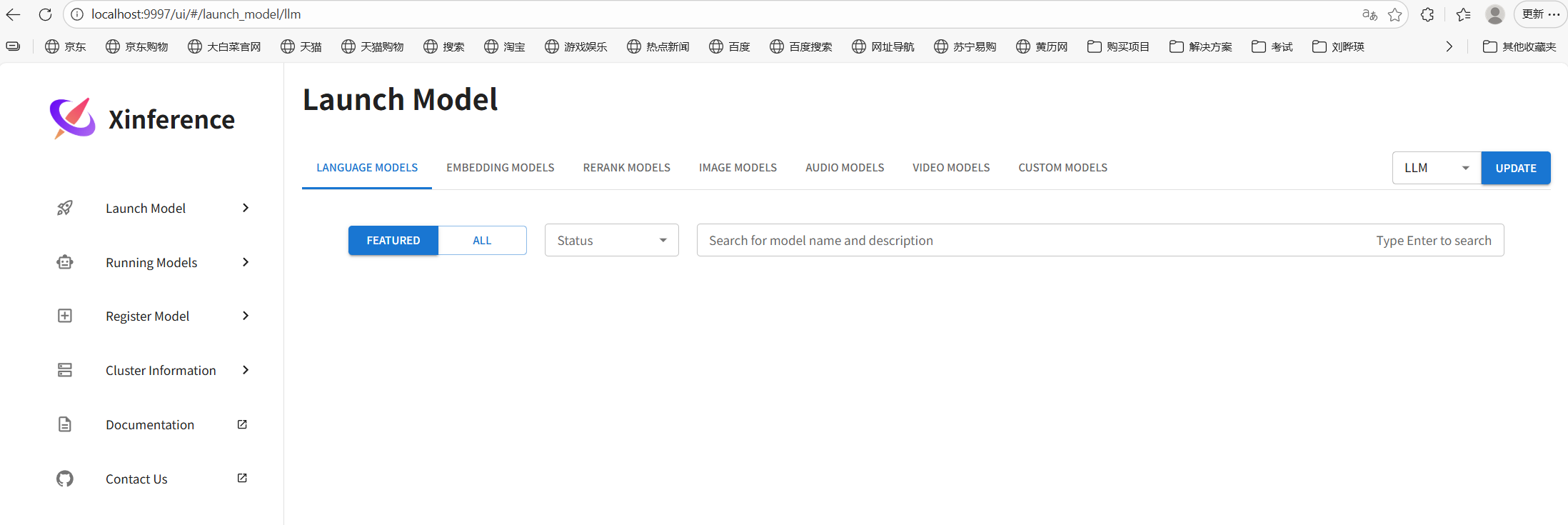

步骤 3:验证容器与服务是否启动成功

bash

# 1. 查看容器状态(STATUS 显示 Up 即运行中)

docker ps | findstr xinference-server

# 2. 访问 Xinference 验证页面

# 打开浏览器,输入 http://localhost:9997,能看到 Xinference 的 API 文档页面即成功

三、Docker 中操作 Xinference(常用命令)

1. 进入容器(加载/管理模型)

bash

# 进入 xinference-server 容器的命令行

docker exec -it xinference-server bash

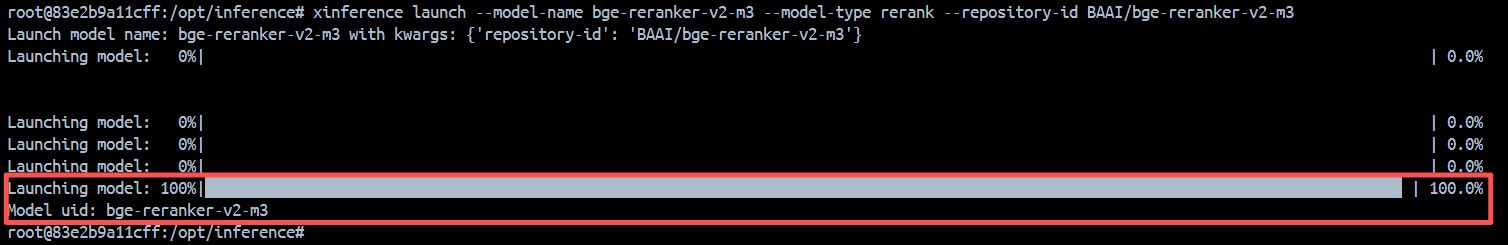

# 示例:在容器内加载 bge-reranker-v2-m3 重排序模型

xinference launch --model-name bge-reranker-v2-m3 --model-type rerank --repository-id BAAI/bge-reranker-v2-m3

加载模型完成

2. 容器常用管理命令

bash

# 停止容器

docker stop xinference-server

# 启动容器

docker start xinference-server

# 重启容器

docker restart xinference-server

# 查看容器日志(排查启动失败问题)

docker logs xinference-server

# 删除容器(需先停止)

docker rm xinference-server四、常见问题解决

-

端口 9997 被占用 :

更换端口启动,如将

-p 9997:9997改为-p 9998:9997,启动命令改为:bashdocker run -d ^ --name xinference-server ^ -p 9998:9997 ^ -v %USERPROFILE%\.xinference:/root/.xinference ^ xprobe/xinference:latest ^ xinference-local --host 0.0.0.0 --port 9997访问地址改为

http://localhost:9998。 -

模型下载慢 :

进入容器后配置 HuggingFace 镜像源,再加载模型:

bashdocker exec -it xinference-server bash export HF_ENDPOINT=https://hf-mirror.com xinference launch-model --model-name bge-reranker-v2-m3 --model-type rerank --repository-id BAAI/bge-reranker-v2-m3 -

挂载目录权限错误 :

以管理员身份运行 CMD/PowerShell,再执行启动命令;或关闭 Windows 防火墙临时测试。

总结

- 核心命令:拉取镜像 → 启动容器(映射端口+挂载目录)→ 验证服务,三步即可完成 Docker 部署 Xinference;

- 关键参数 :务必挂载模型缓存目录(

-v %USERPROFILE%\.xinference:/root/.xinference),避免重复下载模型; - 验证标准 :浏览器访问

http://localhost:9997能打开 API 文档页面,即为部署成功。