在企业数据体系建设过程中,ETL(Extract, Transform, Load)是一个基础而关键的概念。无论是构建数据仓库、搭建BI分析系统,还是实现跨系统数据同步,ETL都扮演着核心角色。然而,对于许多刚接触数据工程的开发者或业务人员而言,ETL的具体含义、技术流程及其实际价值仍存在理解偏差。

本文将从定义出发,系统解析ETL的三个核心阶段------提取(Extract)、转换(Transform)、加载(Load),并结合典型应用场景,说明其在企业数据架构中的作用。同时,探讨如何通过以KPaaS平台 为代表的集成平台化方案,提升ETL开发效率与可维护性。

ETL的基本定义

ETL 是 Extract(提取) 、Transform(转换) 和 Load(加载) 三个英文单词的首字母缩写,指的是一套用于从多个异构数据源中抽取数据,经过清洗、整合、计算等处理后,加载到目标系统(如数据仓库、分析数据库或应用平台)的数据处理流程。

传统上,ETL主要用于数据仓库建设,但随着实时分析、数据湖、数据中台等架构的兴起,ETL 的内涵已扩展为更广义的 数据集成与治理过程。

ETL三阶段详解

提取(Extract):从源头获取数据

提取阶段的目标是从一个或多个源系统中读取原始数据。这些源系统可能包括:

- 关系型数据库:如 MySQL、Oracle、SQL Server;

- SaaS 或 ERP 系统:如金蝶 K/3Cloud、用友、Salesforce;

- API 接口:RESTful、GraphQL 等提供的结构化数据;

- 文件系统:CSV、Excel、JSON 等格式的日志或导出文件。

提取方式可分为:

- 全量抽取:适用于首次同步或数据量较小的场景;

- 增量抽取:基于时间戳、自增ID或日志变更(CDC)机制,仅同步新增或修改的数据,提升效率。

关键挑战在于:不同源系统的协议、认证方式、数据结构差异大,需适配多种连接器。

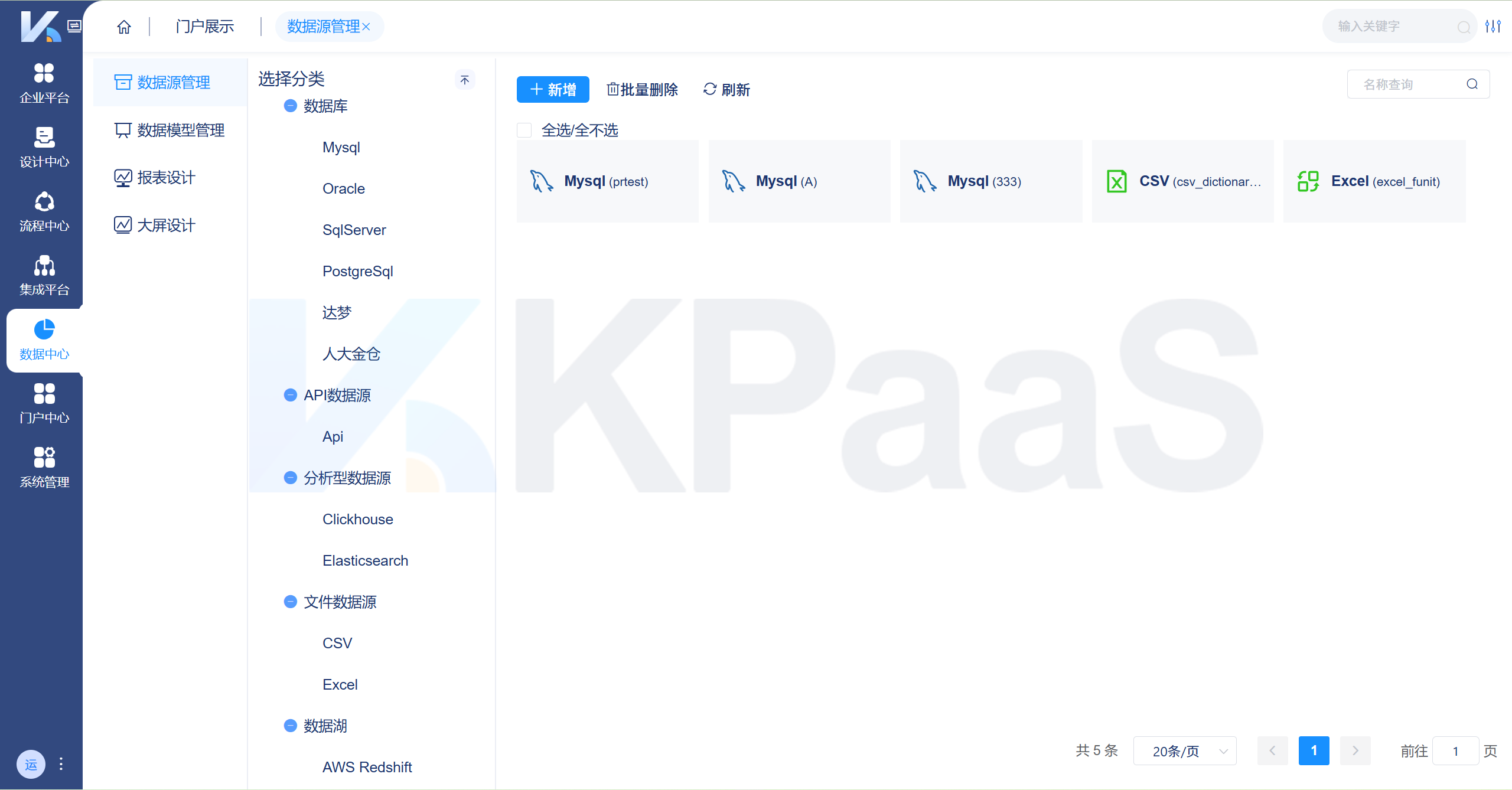

KPaaS平台数据源管理支持多种类型数据接入,助力企业统一管理异构数据。

KPaaS平台数据源管理支持多种类型数据接入,助力企业统一管理异构数据。

转换(Transform):清洗、映射与增强

转换是 ETL 中最复杂的环节,目的是将原始数据加工为符合目标系统要求的格式和语义。常见操作包括:

- 字段映射 :将源系统中的

cust_id映射为目标系统的customer_no; - 数据清洗:过滤空值、去重、修正格式错误(如日期格式不统一);

- 类型转换:将字符串转为数值、时间戳标准化;

- 逻辑计算:计算订单金额 = 单价 × 数量 - 优惠;

- 数据合并与关联:将订单主表与明细表按订单号关联,形成宽表;

- JSON 解析:若源数据为嵌套 JSON,需展开为扁平结构;

- 分组与聚合:按天汇总销售额,生成日报表底表。

转换过程不仅影响数据质量,也直接决定后续分析的准确性与一致性。

加载(Load):写入目标系统

加载阶段将处理后的数据写入目标存储,常见目标包括:

- 分析型数据库:如 MySQL(用于轻量分析)、ClickHouse、Doris;

- 数据仓库:如 Hive、Snowflake、Redshift;

- 应用系统:通过 API 将数据回写至业务系统;

- 可视化平台:直接供报表或大屏调用。

加载策略包括:

- 覆盖写入:每次全量替换目标表;

- 追加写入:仅插入新记录,适用于日志类数据;

- 更新写入:根据主键更新已有记录,适用于维度表。

加载过程需考虑性能、事务一致性及失败回滚机制。

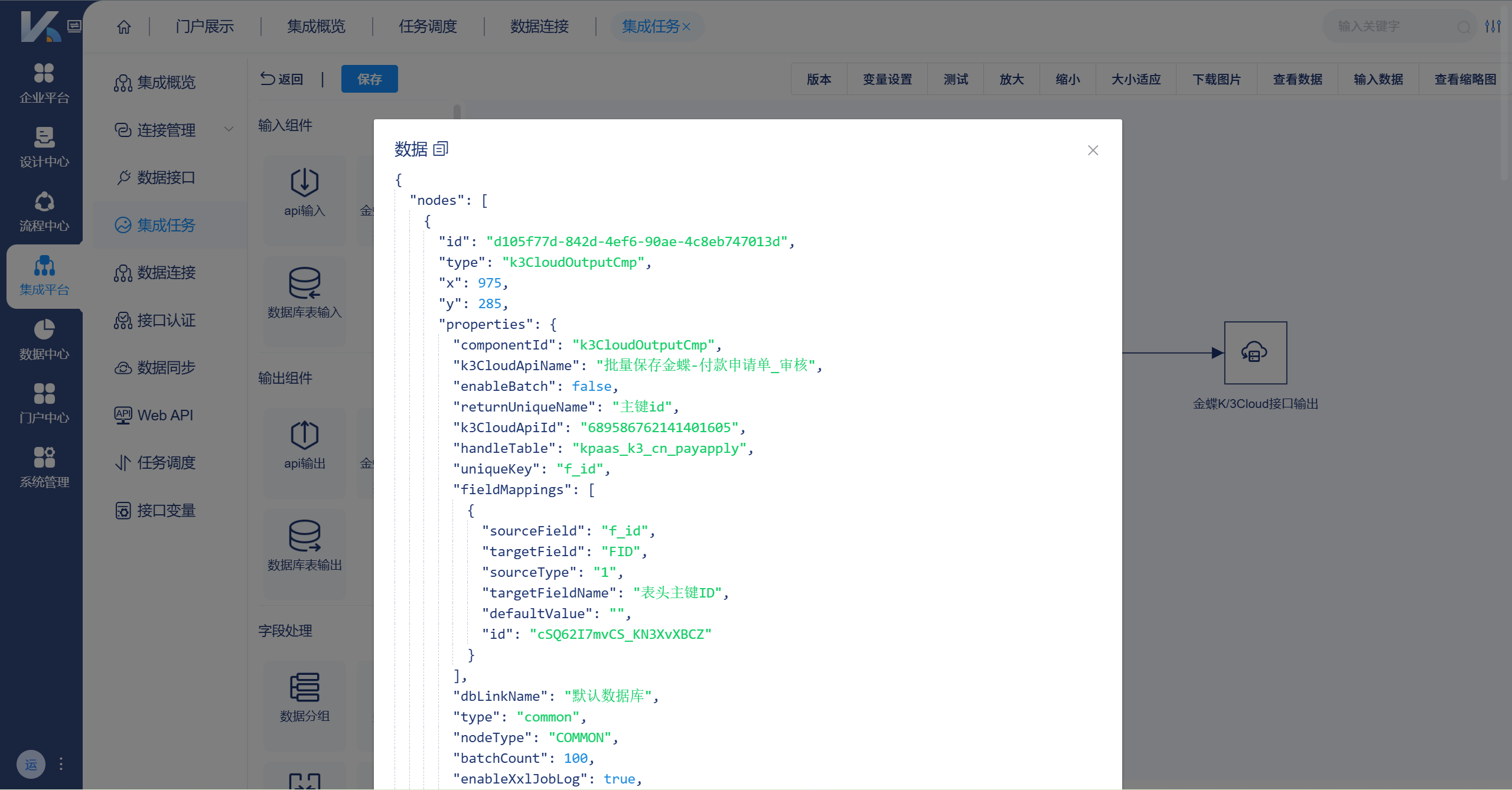

KPaaS 记录数据操作的日志信息,提供了完整的数据操作审计轨迹

KPaaS 记录数据操作的日志信息,提供了完整的数据操作审计轨迹

ETL的典型应用场景

场景1:构建销售分析数据集市

从电商ERP中提取订单、商品、客户数据,转换为统一宽表,加载至MySQL,支撑BI报表与大屏展示。

场景2:财务系统与金蝶K/3Cloud数据同步

每日将本地财务系统中的凭证数据通过ETL流程同步至金蝶云,确保账务一致。

场景3:多渠道用户行为整合

从APP埋点日志(JSON格式)、Web访问日志、第三方广告平台API中提取数据,清洗后加载至数据湖,用于用户画像建模。

场景4:实时运营监控

通过近实时ETL(通常称为ELT或流式ETL),将生产系统数据秒级同步至分析库,驱动大屏预警与决策。

传统ETL vs 高效可视化ETL

过去,ETL主要依赖脚本(如Python、Shell)或专业工具(如Informatica、Kettle),存在以下痛点:

- 开发周期长,需编写大量代码;

- 调试困难,错误定位耗时;

- 缺乏可视化,协作成本高;

- 难以支持国产数据库或新型API。

低代码、可视化ETL这类平台通过图形化界面,将ETL流程抽象为"节点+连线"的数据流图,用户只需拖放组件即可完成复杂任务。

如在 KPaaS 中:

- 输入组件:支持API输入、金蝶K/3Cloud接口输入、DB数据输入;

- 处理节点:提供数据合并、关联、分组、字段设置、JSON解析等;

- 输出组件:支持API输出、金蝶接口输出、数据表输出;

- 编排方式:通过拖放操作构建任务,节点间支持条件分支、循环等交互;

- 实时能力:支持定时或事件触发,确保报表数据与业务同步。

这种模式显著降低了ETL开发门槛,使业务分析师、实施顾问也能参与数据流程构建。

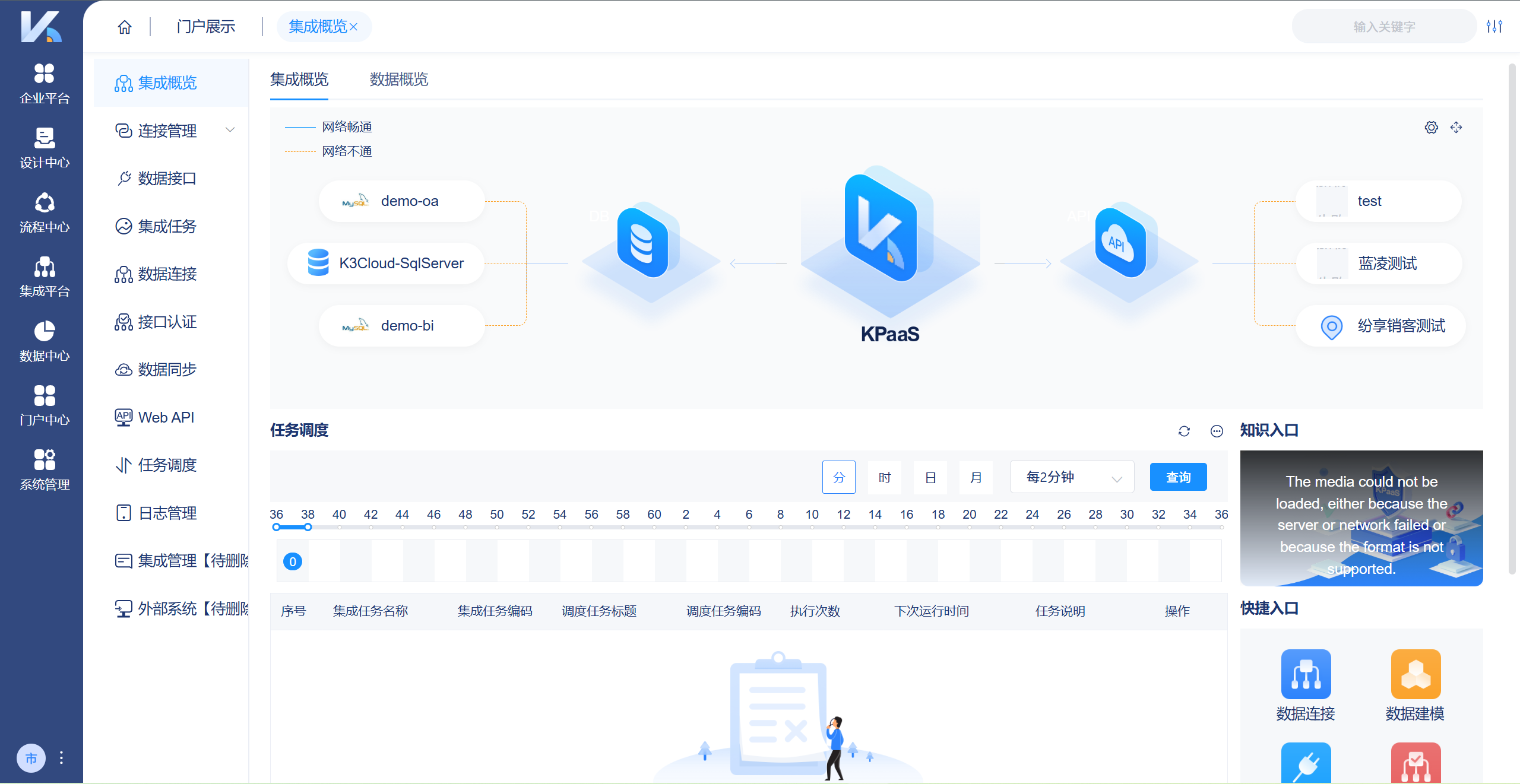

KPaaS平台提供强大的数据集成能力,支持数据接口、连接、认证及同步,通过集成任务、Web API和智能调度实现高效数据流转,并配备完善日志管理,助力企业降本增效。

KPaaS平台提供强大的数据集成能力,支持数据接口、连接、认证及同步,通过集成任务、Web API和智能调度实现高效数据流转,并配备完善日志管理,助力企业降本增效。

ETL与数据可视化的关系

ETL本身不直接产生业务价值,其最终目的是为分析与决策服务。因此,ETL流程的终点往往是报表或大屏。

一个完整的闭环通常为: 源系统 → ETL → 分析库 → 报表/大屏

在此链路中:

- ETL 保证数据的准确性与时效性;

- 报表提供结构化查询与导出;

- 大屏实现关键指标的实时可视化与预警。

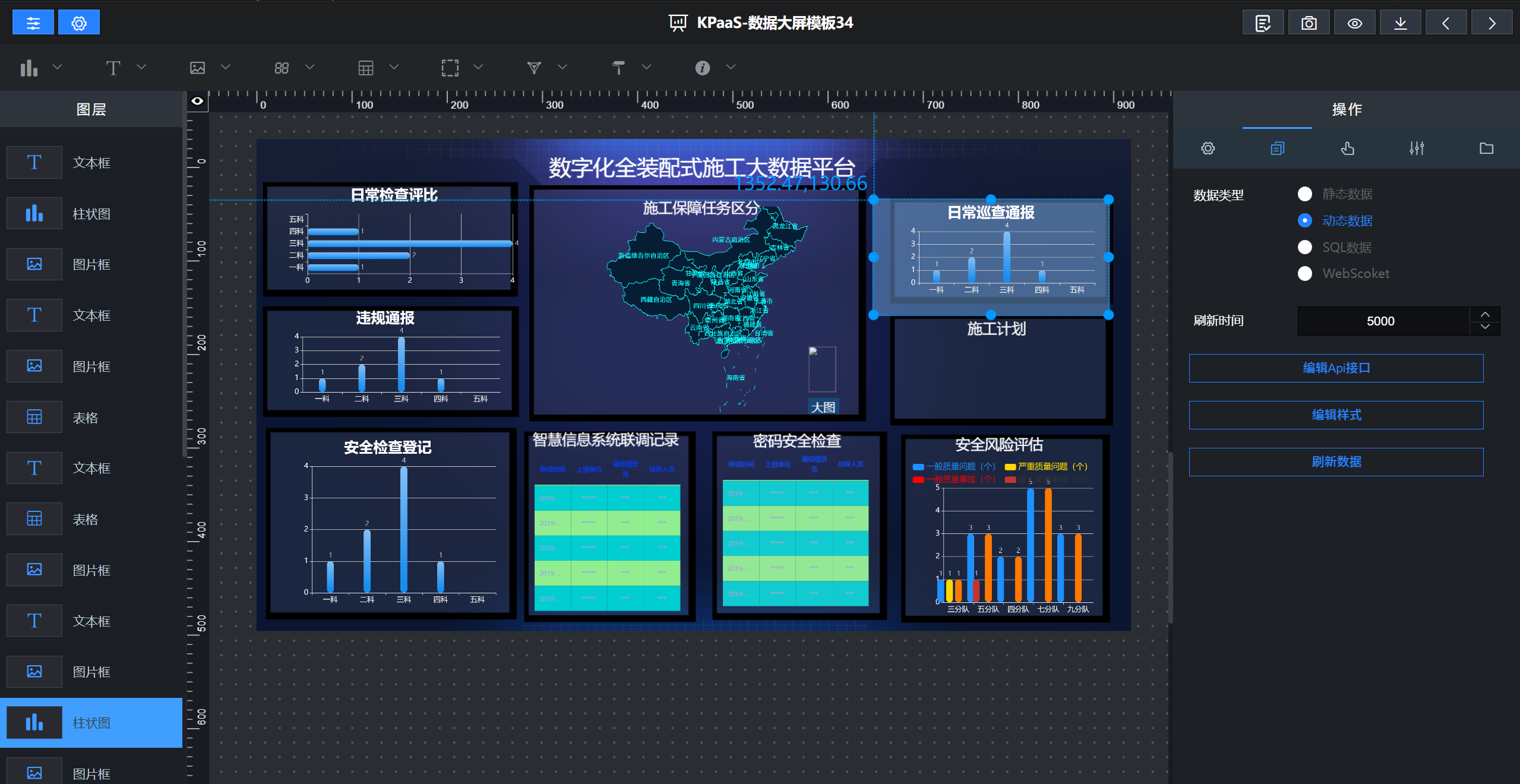

例如,KPaaS平台在完成ETL后,可直接基于目标表生成:

- 动态图表展示GMV、订单量、转化率等KPI;

- 设置阈值预警(如库存低于安全线时标红闪烁);

- 利用模板库快速定制行业专属看板。

这使得企业无需切换多个工具,即可实现"数据集成---分析---呈现"一体化。

KPaaS 平台提供丰富的图表组件与交互控件,支持任意维度、度量切换,帮助企业快速构建高质量数据可视化大屏。

KPaaS 平台提供丰富的图表组件与交互控件,支持任意维度、度量切换,帮助企业快速构建高质量数据可视化大屏。

总结

ETL作为数据工程的基石,其本质是将分散、杂乱的原始数据转化为可信、可用的分析资产。随着企业对数据时效性、灵活性和易用性要求的提升,ETL正从"后台技术"走向"前台赋能"。

对于希望快速落地数据项目的团队而言,选择一个支持多源接入、可视化编排、实时同步与可视化输出的集成平台化方案,将成为提升效率的关键。