在AI时代的程序员,越来越离不开AI开发代码工具,目前比较热门的有Claude code、codex、opencode以及智能AI的IDE比如,cursor、trae、antigravity等其他工具。

使用AI开发工具离不开大模型的接入,AI工具就比如是一辆车的外壳,只有加上大模型发动机才能发挥出巨大的能量。

本文介绍下比较的Claude Code【简称CC】的使用,并且可以接入国产大模型,免费使用大模型。

安装Claude

第一步是获取 Claude Code 的命令行客户端(CLI)

环境准备

在安装之前,请确保你的系统中已经安装了 Node.js 18.0 或更高版本。Claude Code 是基于 Node.js 生态构建的,npm 是其首选的安装工具。你可以在终端中运行以下命令来检查你的 Node.js 版本:

bash

node -v如果版本低于 18.0,请先前往Node.js 官网进行升级

或者使用nvm进行升级

bash

# Download and install nvm:

curl -o- https://raw.githubusercontent.com/nvm-sh/nvm/v0.40.3/install.sh | bash

# in lieu of restarting the shell

\. "$HOME/.nvm/nvm.sh"

# Download and install Node.js:

nvm install 22

# Verify the Node.js version:

node -v # Should print "v22.20.0".

# Verify npm version:

npm -v # Should print "10.9.3".全局安装 Claude Code

打卡终端,运行以下命令来全局安装 Claude Code

bash

npm install -g @anthropic-ai/claude-code等一会,安装完成后,可以通过运行以下命令来验证 Claude Code 安装和运行是否成功

bash

# 查看 claude 的安装位置

# which claude

/usr/local/bin/claude

# claude --version

2.1.12 (Claude Code)看到版本号说明已经安装成功。

首次运行 Claude Code

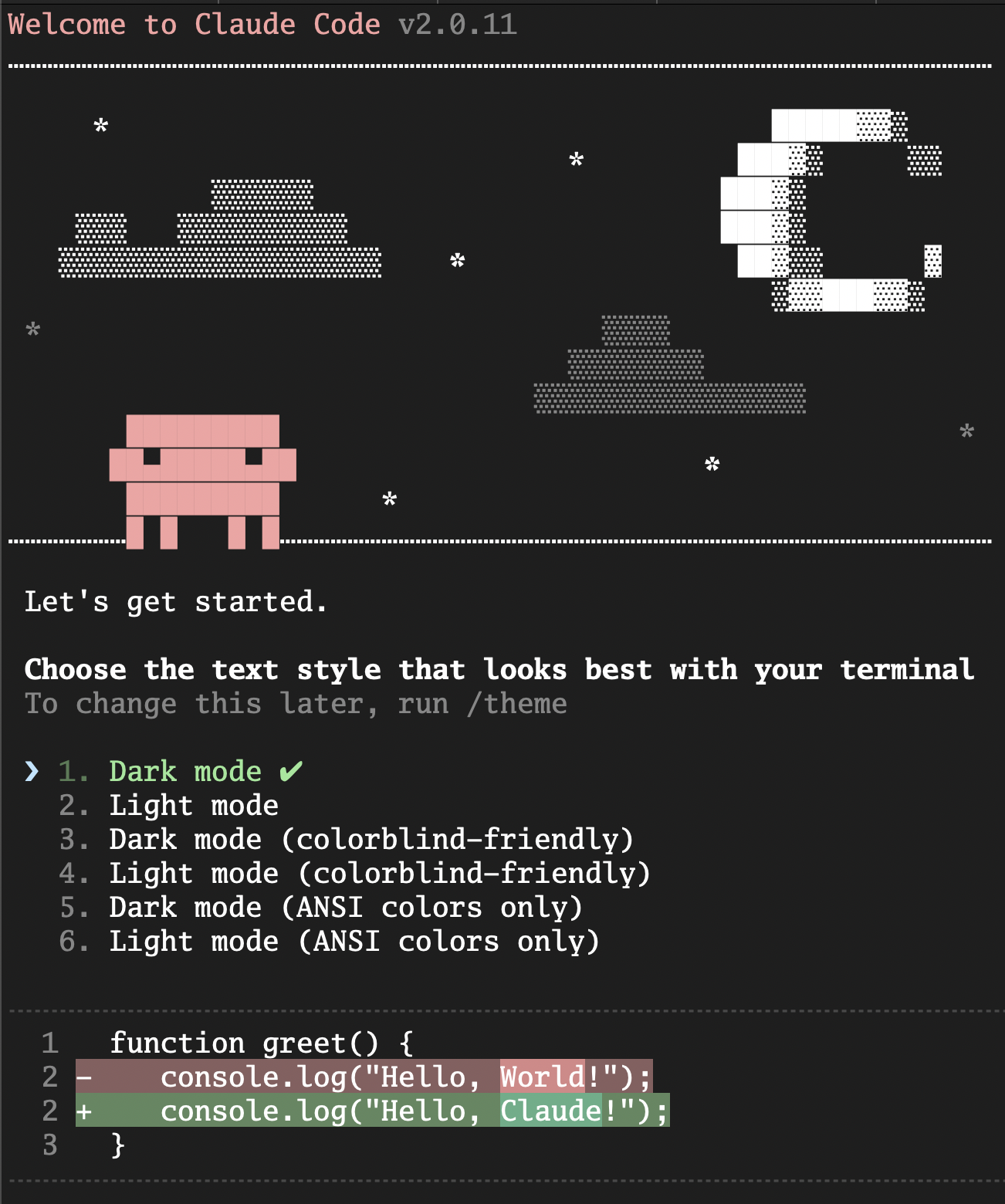

如果你直接运行 claude 命令,你将看到 Claude Code 的"欢迎"页面,如下图所示:

可以看到 Claude Code 让你选择终端主题(Terminal Theme),默认是第一个 Dark mode。这里我们可以直接敲击回车进入下一个页面(后续如果要重新配置主题时,可以通过 /config 斜杠命令进行):

第二个页面会引导你选择登录方式,

- Claude Code 支持通过浏览器登录官方 Anthropic 账户,

- 也可以通过 API 方式与 Claude 大模型进行交互 (通过方向键选择下面的选项"Anthropic Console account")。

不过,这里请先不要进行这一步,因为我们的目标是绕过官方 API,连接到我们自己的"引擎"。

接入国产大模型

连接国产 AI 大模型- 智谱大模型

首先需要注册智谱 AI 的账户 并创建 API Key

打开 智谱 官网,注册并登录你的账户。打卡API keys页面

然后就可以通过环境变量配置 Claude Code 访问智谱大模型 API 的连接地址和身份令牌了。你可以在你的 Shell 配置文件中添加下面两行

bash

export ANTHROPIC_BASE_URL="https://open.bigmodel.cn/api/anthropic"

export ANTHROPIC_AUTH_TOKEN="<your_zhipu_api_key>"以上是MAC系统配置;windows系统需要在环境变量中进行配置。

ANTHROPIC_BASE_URL:这是最关键的一行。它告诉 Claude Code 客户端,不要去访问默认的 Anthropic API 地址,而是将所有的网络请求都发送到智谱 AI 的 API 兼容端点。我们在这里实现了"请求重定向"。- ANTHROPIC_AUTH_TOKEN:尽管变量名看起来是"Anthropic"的,但由于我们已经重定向了 BASE_URL,这个 Token 实际上会被发送给智谱 AI 的服务器进行验证。我们在这里实现了"身份凭证替换"。

环境变量生效后,我们在本地新建一个项目test重新执行 claude:

可以看到下图

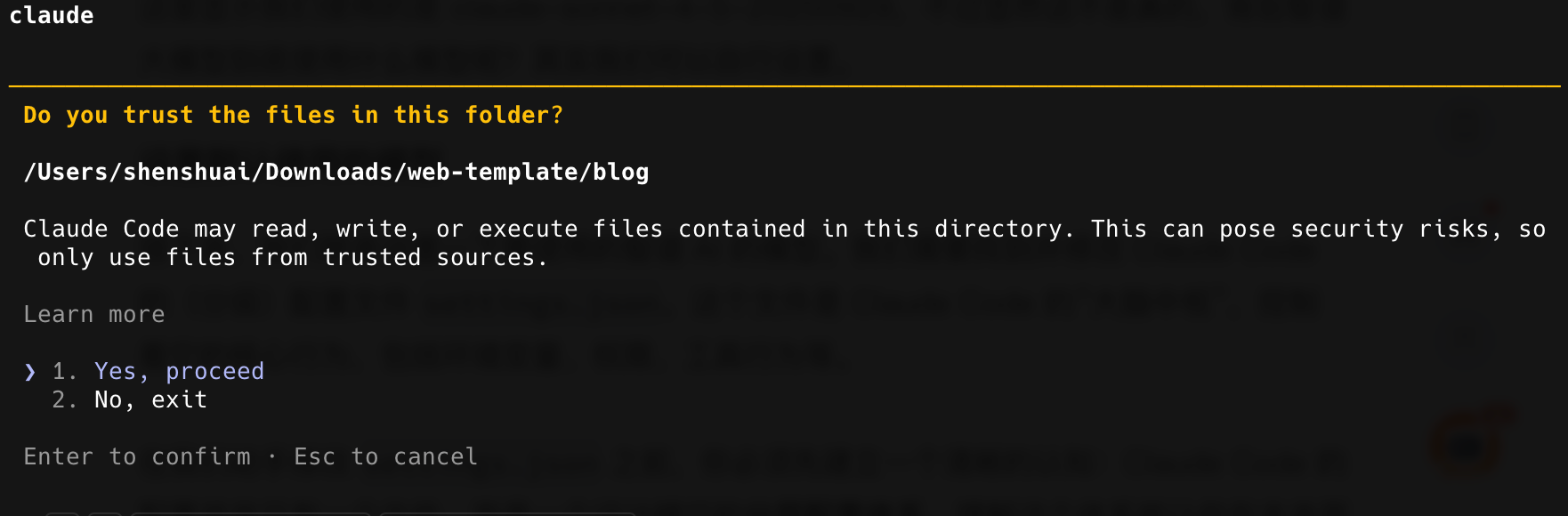

这次 Claude Code 没有让我们选择 login method,而是直接 login 成功了!敲击回车后,我们看到下一个页面:

询问我是否信任该本地文件夹,敲击回车选择信任后,我们便正式进入 Claude Code 的工作页面:

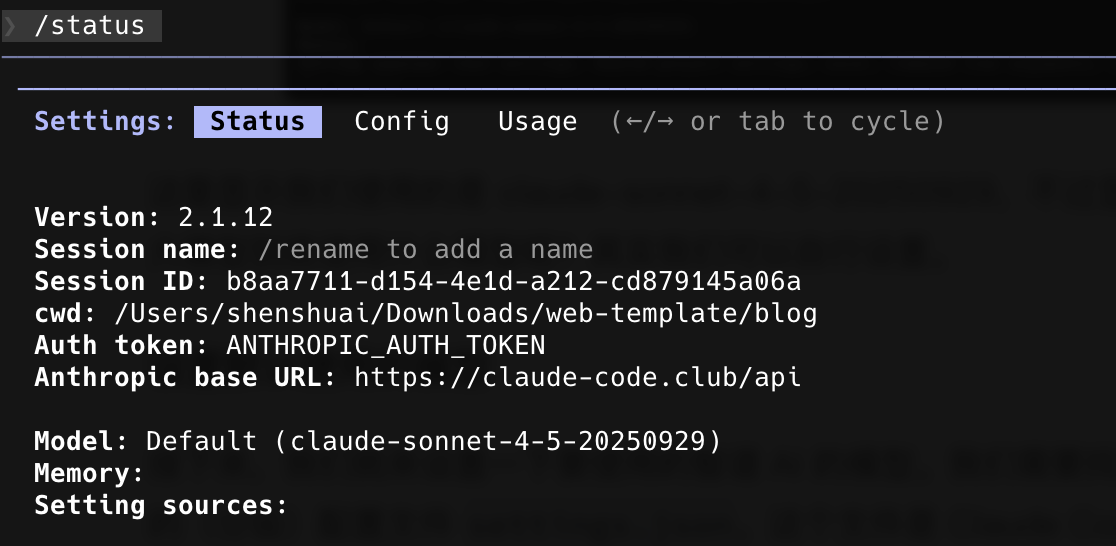

在输入提示符后面输入 /status 后回车,就可以看到当前 Claude Code 使用的模型的各种最新信息:

使用的是 claude-sonnet-4-5-20250929,不过显然这不是真的,背后智谱大模型到底使用什么模型呢?我们可以自行设置;

设置默认模型

接下来就设置一下要使用的智谱 AI 的模型。找到并修改 Claude Code 的(分级)配置文件 settings.json。这个文件是 Claude Code 的"大脑中枢",控制着它的核心行为,包括环境变量、权限、工具行为等;

在我们动手修改 settings.json 之前,你必须先建立一个清晰的认知:Claude Code 的配置并非只有一个文件,而是一个设计精巧的分层配置体系。有点类似npm包的层级,项目中的级别最高,也可全局中安装依赖包。

核心思想是,高层级的配置会覆盖低层级配置中的同名设置。

这五个层级各自的用途非常明确:

- 企业级策略(managed-settings.json):由 IT/DevOps 团队统一分发,用于强制执行公司级安全策略,拥有最高优先级,不可被覆盖。

- 命令行参数(例如--model ...):为单次会话提供的临时覆盖,非常适合快速测试。

- 项目级个人设置(.claude/settings.local.json):你个人在此项目的特定偏好(如测试用模型),默认被 Git 忽略,不会与团队共享。

- 项目级共享设置(.claude/settings.json):需要团队所有成员共享的项目级规范(如权限规则),应该提交到代码库。

- 用户级全局设置(~/.claude/settings.json):存放你个人的、希望在所有项目中都生效的全局配置。这正是我们本次"引擎移植"手术的核心操作区。

我们以用户级全局配置 ~/.claude/settings.json 为例,来看看如何设置默认使用的智谱大模型。

这个文件通常位于你用户主目录下的 .claude 文件夹中

bash

mkdir -p ~/.claude

# 使用你熟悉的编辑器打开,比如VS Code或Vim

# 如果文件不存在,这个命令会创建它

touch ~/.claude/settings.json

# 或者

# vim ~/.claude/settings.json打开这个(可能是空的)settings.json 文件,将以下内容完整地复制进去:

bash

{

"env": {

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "glm-4.5-air",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "glm-4.6",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "glm-4.6"

}

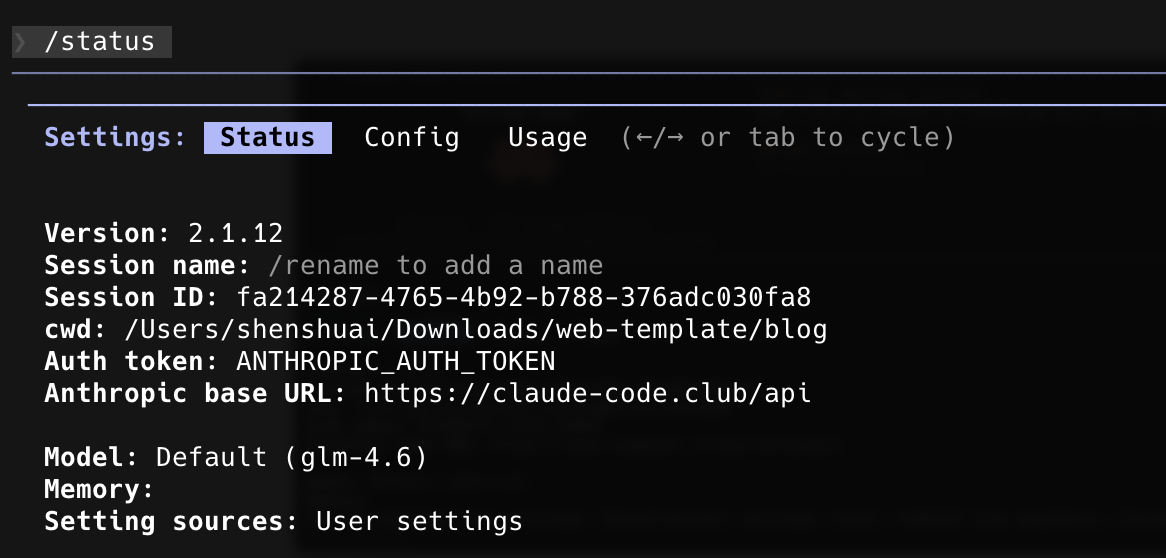

}保存并关闭 settings.json 文件。我们重新运行 Claude Code 并通过 /status 命令查看当前模型信息:

可以看到修改了模型的调用。

智谱提供了一些免费模型的使用

https://docs.bigmodel.cn/cn/guide/models/free/glm-4.7-flash

可以修改成这些模型进行使用。

免费模型开发能力有限,开发一些简单功能可以使用,如果使用热门流行的模型,还是需要付费使用。

通过代理转发链接

如果不想使用国产模型,也可以使用国内的一些代理商,通过他们提供的转发API可以使用原生的claude的大模型。

作为曾注册和测试了10来个系统账户,测试使用下来 CC club 使用最方便,售后服务也比较好,免费的额度给的比较多,而且每周都可以重置免费额度。这里的付费额度也是非常优惠和划算的。

当然你也可以注册其它代理使用:

主要介绍下CC club的使用

可以按照官方提供的使用文档进行配置;前提是已经安装好了CC;

然后就主要在 配置 这一步

配置完成后,就可以使用原汁原味的claude工具。

使用Claude-code-router调用魔搭社区的模型

使用claude-code-router,可以调用魔搭社区的模型,魔搭社区提供每天2000次的调用额度,当然每个模型还有日调用限制额度。可以测试使用不同的模型。

首先全局安装 claude-code-router 插件

https://github.com/musistudio/claude-code-router

bash

npm install -g @musistudio/claude-code-router然后按照说明问题创建并配置 ~/.claude-code-router/config.json

bash

{

"OPENAI_API_KEY": "$OPENAI_API_KEY",

"GEMINI_API_KEY": "${GEMINI_API_KEY}",

"Providers": [

{

"name": "openai",

"api_base_url": "https://api.openai.com/v1/chat/completions",

"api_key": "$OPENAI_API_KEY",

"models": ["gpt-5", "gpt-5-mini"]

}

]

}openai是chatGPT的模型,使用时会有一些网络问题。

我们可以使用魔搭社区的免费模型,每天有2000的免费调用额度。

魔搭社区的使用,要先完成阿里云的认证。

在首页-访问控制下,创建key,也可以使用默认的key。后边调用模型时,都需要填写key;

在模型页面选择支持推理的模型

选择一个点击进去

在模型的详情页面中,可以在查看代码示例中找到配置使用方法

比如:GLM-4.7模型

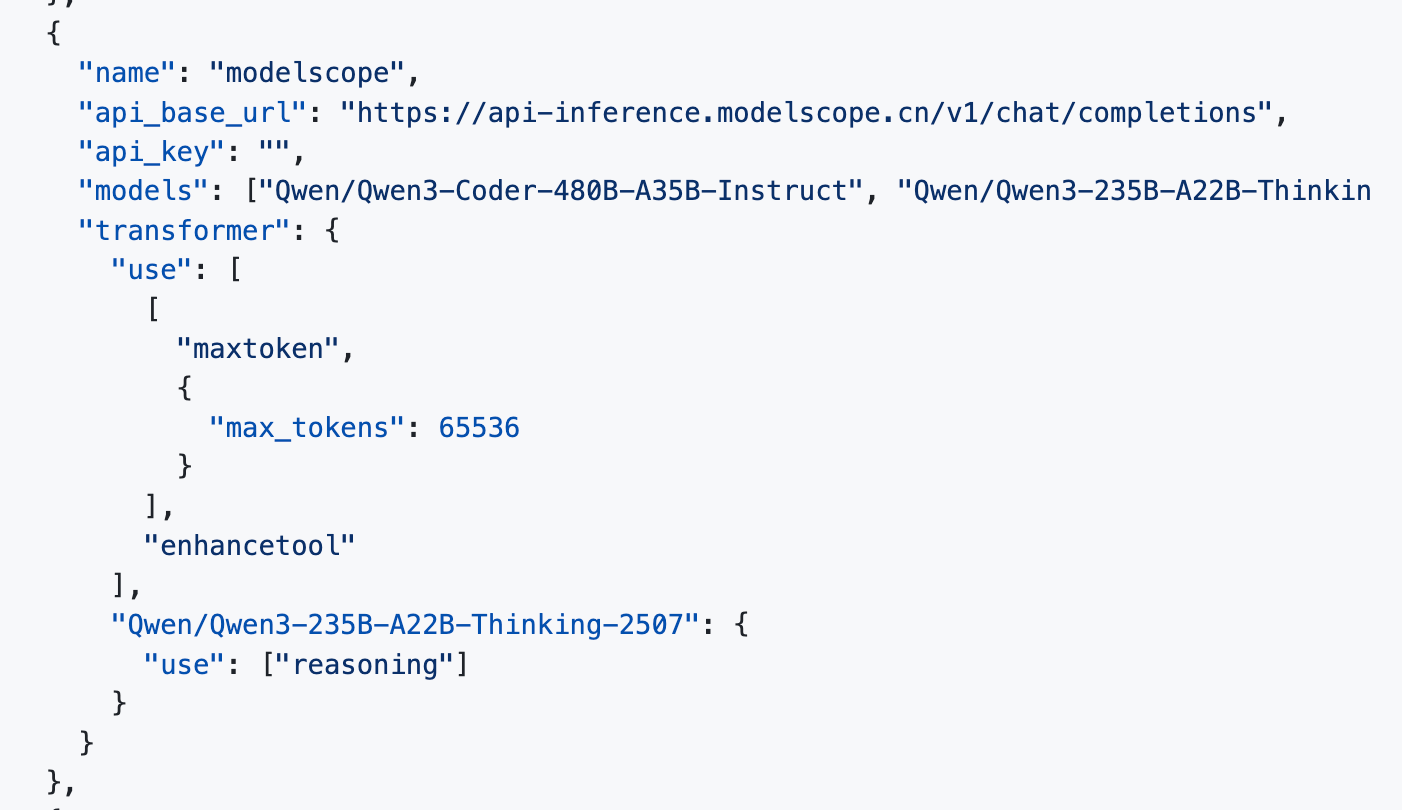

不同模型的json配置

下面是使用GLM-4.7模型的完整的config.json配置;

json

{

"Providers": [

{

"name": "modelscope",

"api_base_url": "https://api-inference.modelscope.cn/v1/chat/completions",

"api_key": "你自己的APIKEY",

"models": ["ZhipuAI/GLM-4.7"],

"transformer": {

"use": [

[

"maxtoken",

{

"max_tokens": 65536

}

],

"enhancetool"

],

"Qwen/Qwen3-235B-A22B-Thinking-2507": {

"use": ["reasoning"]

}

}

}

],

"Router": {

"default": "modelscope,ZhipuAI/GLM-4.7",

"think": "modelscope,ZhipuAI/GLM-4.7",

"background": "modelscope,ZhipuAI/GLM-4.7",

"longContext": "modelscope,ZhipuAI/GLM-4.7"

}

}添加deepseek的模型配置

json

{

"Providers": [

{

"name": "modelscope",

"api_base_url": "https://api-inference.modelscope.cn/v1/chat/completions",

"api_key": "ms-fd370b1c-3aed-4c0c-9980-2c545dbc4782",

"models": ["deepseek-ai/DeepSeek-V3.2"],

"transformer": {

"use": [

[

"maxtoken",

{

"max_tokens": 65536

}

],

"enhancetool"

],

"Qwen/Qwen3-235B-A22B-Thinking-2507": {

"use": ["reasoning"]

}

}

}

],

"Router": {

"default": "modelscope,deepseek-ai/DeepSeek-V3.2",

"think": "modelscope,deepseek-ai/DeepSeek-V3.2",

"background": "modelscope,deepseek-ai/DeepSeek-V3.2",

"longContext": "modelscope,deepseek-ai/DeepSeek-V3.2"

}

}其他的模型都是类似的配置方法。使用下来,越是热门模型每日的调用限制额度越低,可以进行多测试。