Kimi K2.5 是一个巨大的承诺,发布仅仅几个小时后,我就构建了一个完整的工作项目,如果使用 Claude Opus 4.5,成本将是 8-10 倍。

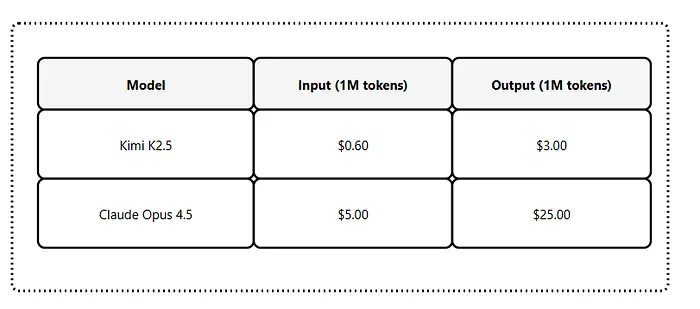

但在你怀疑我之前,这里有一个简单的比较:

这大约比输入和输出便宜 8 倍。

起初我不愿意测试。Hugging Face 上的低下载量让我感到怀疑

由于有这么多其他 AI 模型和工具需要评估,我想放过它。

但代理群集功能 和1 万亿参数架构太令人兴奋了,无法放过。

如果你关注了我最近的文章,你知道 我在连接 Claude Code 到替代模型时介绍了 Ollama Launch --- 一个消除配置烦恼的新命令。

该工作流程使得这个测试在几分钟内成为可能。

在本文中,我将引导你完成:

- 是什么让 Kimi K2.5 与众不同(代理群集、原生多模态、256K 上下文)

- 如何使用 Ollama Launch 将其与 Claude Code 一起设置

- 通过构建实际项目获得真实的测试结果

- 成本分解以及节省是否证明了切换的合理性

让我们看看 1 万亿参数的模型是否能兑现其承诺。

1、Kimi K2.5

Kimi K2.5 是 Moonshot AI 最智能的发布版本,通过在约 15 万亿混合视觉和文本令牌上持续预训练构建。

1.1 1 万亿参数

规模对于复杂推理很重要。

更多参数意味着对细致代码模式、架构决策和多步骤问题解决的理解更好。

1.2 原生多模态架构

K2.5 从基础向上进行了视觉语言令牌的预训练。

它以统一的方式处理图像、视频和文本。

你可以:

- 从 UI 设计生成代码 * 处理视频工作流程 * 在视觉输入中进行工具使用*

1.3 代理群集功能

K2.5 从单代理扩展到自主导向、协调的群集式执行。

它将复杂任务分解为由动态实例化的特定领域代理执行的并行子任务。

简单来说,给它一个复杂的项目,它会将其分解到多个在一起工作的专门代理。

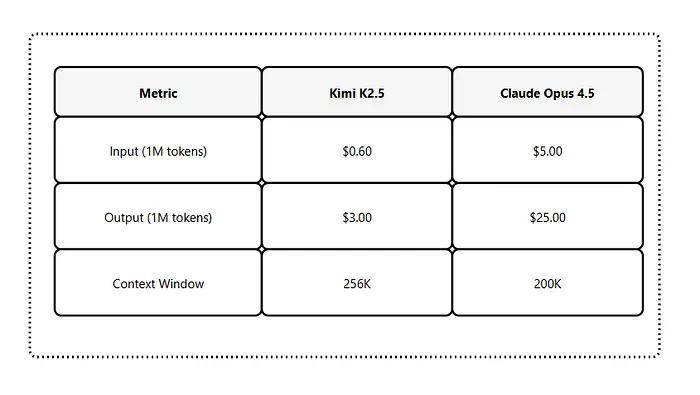

1.4 256K 上下文窗口

所有 K2.5 变体都支持 256K 上下文窗口。

这足以在会话期间将整个代码库保留在内存中。

1.5 思考模式

K2.5 支持即时和思考模式:

- 即时模式:用于直接任务的快速响应

- 思考模式:用于复杂问题的多步推理

你可以根据需要切换此功能。

1.6 成本

以下是定价分解:

现在让我们使用 Claude Code 设置它。

2、使用 Ollama Launch 设置 Kimi K2.5

如果你关注了 我之前的 Ollama Launch 文章, 这会感觉很熟悉。

设置是相同的;只是一个不同的模型。

确保你有:

-

已安装 Ollama v0.15+ * 已安装 Claude Code * Ollama Cloud 帐户(用于云模型)

检查你的 Ollama 版本:ollama --version

你需要版本 0.15.2 或更高。如果你落后,请从 ollama.com/download 更新。

2.1 拉取 Kimi K2.5 云模型

Kimi K2.5 作为云模型在 Ollama 上可用。运行:

ollama pull kimi-k2.5:cloud

云模型是轻量级的,因为推断在远程发生,下载很快。

2.2 使用 Claude Code 启动

这就是 Ollama Launch 大放异彩的地方。一个命令:

ollama launch claude --model kimi-k2.5:cloud

Ollama Launch 处理一切:

- 设置

ANTHROPIC_AUTH_TOKEN - 配置

ANTHROPIC_BASE_URL到 localhost:11434 - 使用选定的模型启动 Claude Code

2.3 验证设置

Claude Code 启动后,运行 /status 以确认:

Model: kimi-k2.5:cloud

Auth token: ANTHROPIC_AUTH_TOKEN

Anthropic base URL: http://localhost:11434

如果你看到

kimi-k2.5:cloud作为模型,你就准备好了。

2.4 上下文长度说明

云模型以完整上下文长度运行(Kimi K2.5 为 256K)。

如果你使用的是本地模型,你需要在 Ollama 设置中调整上下文长度。

使用云模型时,跳过此步骤。

3、测试 Kimi K2.5 + Claude Code

设置完成后,我想测试一些能发挥模型功能的项目。

一个简单的斐波那契函数**就像我们在 Ollama Launch 文章中测试的那样**并不理想。

我需要一个能展示以下内容的项目:

- 多文件生成

- 代码架构决策

- 真实世界的复杂性

3.1 测试项目:全栈任务仪表板

我给了 Kimi K2.5 这个提示:

构建一个任务管理仪表板,包含:

- 带有 Tailwind CSS 的 React 前端

- 带有 REST API 的 Express 后端

- 用于持久化的 SQLite 数据库

- 任务的 CRUD 操作

- 任务类别和优先级级别

- 过滤和搜索功能

- 干净、现代的 UI

3.2 第一印象

模型立即开始生成。

它创建了逻辑文件结构,然后系统地构建了每个组件。

外链图片转存中...(img-GCWa7F8K-1769699962657)

响应包括:

/server目录,包含 Express 路由和数据库设置/client目录,包含 React 组件- 适当的关注点分离

- 环境配置文件

3.3 速度

整个项目结构 --- 前端、后端、数据库架构、配置文件 --- 在不到 4 分钟内生成 --- 准确地说是 3 分钟,18 秒。

相比之下,与其他模型(除 Claude Opus 4.5 之外)的类似测试,对于 comparable 输出花费了超过 4 分钟。

3.4 代理群集

我没有在任何地方看到"Agent Swarm"。但行为表明了并行处理。

当我要求进行修改时 --- 添加用户身份验证、更改颜色方案、添加暗色模式 --- 模型同时处理了多个更改。

它感觉比单线程响应更快。

4、最终想法

带有 Ollama Launch 的 Kimi K2.5 是我测试过的最简单的替代模型设置。

1 万亿参数模型以成本的一小部分提供了扎实的代码生成。代理群集功能显示了复杂、多部分任务的承诺。

当你用完 Claude Code 令牌时,这非常有用,就像我在其中一个账户中遇到的情况一样。

这就是我为测试项目正在做的事情:

- Kimi K2.5用于脚手架、样板和标准模式

- Claude Sonnet用于日常开发和调试

- Claude Opus用于复杂的架构决策和棘手问题