打破Java经典认知:创建对象,真的全都在堆上吗?

作者:Weisian

日期:2026年1月31日

"Java对象都在堆上分配"------这个看似绝对正确的结论,其实只是Java早期版本的一个简化描述。随着JVM技术的演进,对象的分配策略远比我们想象的要复杂和智能得多。

在很多Java面试题和入门教程中,我们经常能看到这样的定论:"Java中的所有对象都分配在堆内存中"。这句话放在Java早期版本(如JDK 1.0至JDK 7)中大致成立,但在现代Java生态中(特别是JDK 8及以后版本),这已经成为一个需要被重新审视和修正的技术认知。

今天,我们就深入HotSpot JVM的底层运行机制,从基础概念到高级优化,从理论解析到实战验证,全面拆解Java对象的真实分配策略------既有我们熟知的堆分配,也有鲜为人知的栈分配,还有堆内专属优化的TLAB分配。

一、先重温:我们最初认知里的「堆分配」

在正式打破固有认知前,我们先回归Java基础,明确传统意义上的对象堆分配逻辑,这是理解后续高级优化策略的前提和基石。

1.1 经典答案的由来

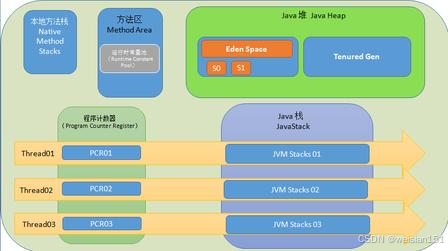

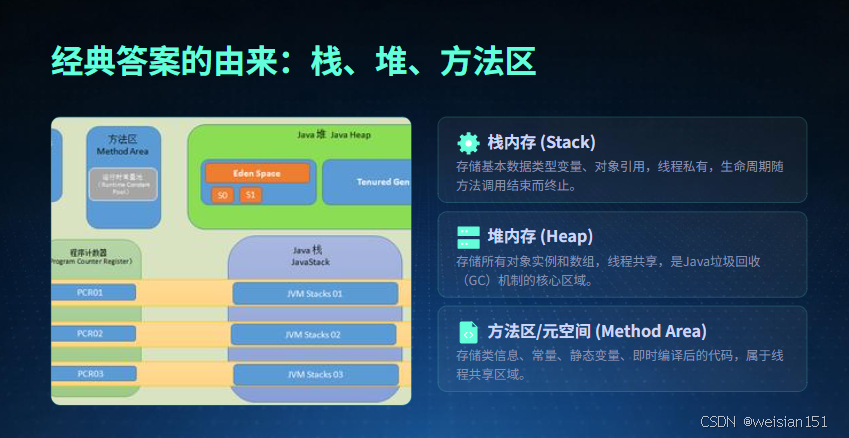

初学Java时,教材和讲师通常会给我们传递这样的内存划分认知,也是长久以来的"入门常识":

- 栈内存:存储基本数据类型变量、对象引用(指针),线程私有,随方法调用生命周期变化

- 堆内存:存储所有对象实例和数组,线程共享,是垃圾回收的核心区域

- 方法区/元空间:存储类信息、常量、静态变量、即时编译后的代码,线程共享

对应的经典代码示例如下,完美契合这一认知:

java

// 经典示例:引用在栈上,对象在堆上

public class ClassicExample {

public static void main(String[] args) {

// userRef 是对象引用,存储在栈上;new User() 是对象实例,存储在堆上

User userRef = new User("张三", 25);

// 基本数据类型变量,直接存储在栈上

int age = 25;

// 字符串常量池位于堆中,name 引用存储在栈上

String name = "张三";

}

}

class User {

private String name;

private int age;

public User(String name, int age) {

this.name = name;

this.age = age;

}

}1.2 堆内存的核心定位

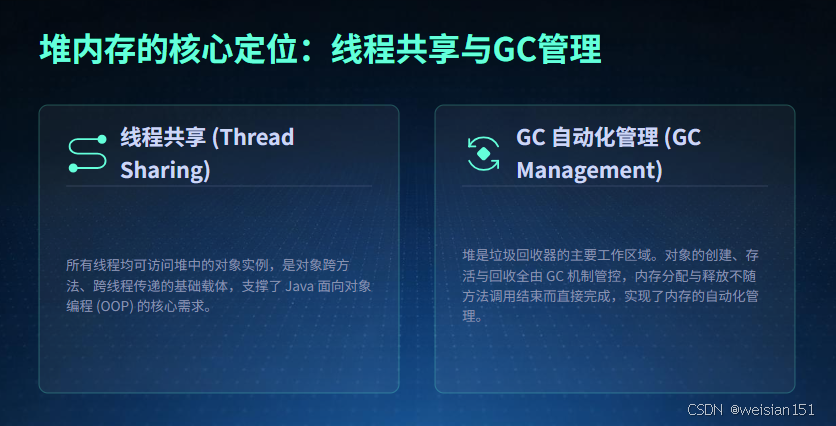

在Java虚拟机规范中,堆(Heap)是JVM管理的最大、最核心的内存区域,它具备两个不可替代的关键特性:

- 线程共享:所有线程均可访问堆中的对象实例,是对象跨方法、跨线程传递的基础载体,支撑了Java面向对象编程的核心需求。

- GC管理:堆是垃圾回收器(Garbage Collector)的主要工作区域,对象的创建、存活、回收全由GC机制自动化管控,内存的分配与释放不随方法调用结束而直接完成。

在未开启任何深度JIT优化、对象存在明显逃逸行为的场景下,通过new关键字、反射、克隆等方式创建的对象实例,以及所有数组对象,默认都会在堆上分配内存,这也是日常业务开发中最普遍、最常见的分配方式。

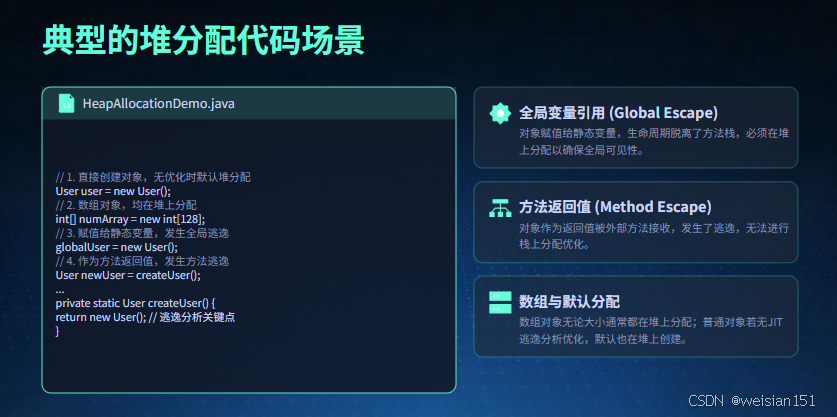

1.3 典型的堆分配代码场景

下面这段代码涵盖了日常开发中最常见的堆分配场景,这些对象均因存在逃逸行为或无优化条件,只能在堆上开辟内存并等待GC回收:

java

public class HeapAllocationDemo {

// 静态变量,属于类级别的共享数据,存储在元空间,引用对象在堆上

static User globalUser;

public static void main(String[] args) {

// 1. 直接创建对象赋值给局部变量,无优化时默认堆分配

User user = new User();

// 2. 数组对象(无论基本类型还是引用类型),均在堆上分配

int[] numArray = new int[128];

String[] strArray = new String[64];

// 3. 对象赋值给静态变量,发生全局逃逸,必然堆分配

globalUser = new User();

// 4. 对象作为方法返回值,发生方法逃逸,必然堆分配

User newUser = createUser();

}

private static User createUser() {

// 对象作为返回值传递给外部方法,超出当前方法作用域,发生逃逸

return new User();

}

}

class User {

private Long userId;

private String userName;

// 省略getter、setter、构造方法

}

二、打破传统:现代 JVM 的对象分配全景与「三级缓存」模型(优化版)

随着 JIT 编译器的成熟以及逃逸分析(Escape Analysis)、标量替换(Scalar Replacement)等高级优化技术的广泛应用,现代 HotSpot JVM 早已摒弃了"所有对象都分配在堆上"的单一策略。取而代之的是一套分层、自适应、高度智能化的对象分配机制 。这套机制会根据对象的逃逸状态、生命周期长度、大小特征 以及运行时上下文,动态选择最合适的内存分配路径,以最大化性能并最小化 GC 压力。

2.1 对象分配的「三级缓存」模型

现代 JVM 的对象分配可被形象地理解为一个三级缓存系统 ,其设计原则是:优先使用最快、最轻量的分配方式,失败后再逐级降级。每一级对应不同的内存区域、线程属性和回收机制:

对象分配请求

↓

1. 栈上分配(Stack Allocation / Scalar Replacement)

← 分配最快、零 GC 开销

← 仅适用于完全未逃逸的小对象

← 由逃逸分析 + 标量替换共同实现(JIT 编译后生效)

↓(若对象逃逸、过大、或优化被禁用)

2. TLAB 分配(Thread Local Allocation Buffer)

← 分配快速、无锁竞争

← 属于堆内存(Eden 区),但为线程私有

← 默认用于绝大多数小对象(通常 < 几十 KB)

↓(若 TLAB 空间不足、对象过大、或显式关闭 TLAB)

3. 堆共享分配(Eden 区同步分配 或 老年代直接分配)

← 需要加全局锁(如 Eden 区的 `Heap_lock`),性能最低

← 大对象可能跳过新生代,直接进入老年代(取决于 GC 算法和参数)

← 完全依赖 GC 回收💡 重要澄清 :严格来说,HotSpot 并未真正将完整对象结构分配到 Java 虚拟机栈上,而是通过 标量替换(Scalar Replacement) 将未逃逸对象拆解为其基本字段(如

int x, y),这些字段作为局部变量存储在栈帧中。从效果上看,对象并未在堆中创建,也无需 GC 回收,因此业界普遍称之为"栈上分配"。该优化仅在方法被 JIT 编译后才生效(解释执行阶段不触发)。

2.2 三级分配的典型场景与确定性示例

下面通过三段代码,分别展示三种分配路径的确定性触发条件、行为边界及可落地的准确配置参数。

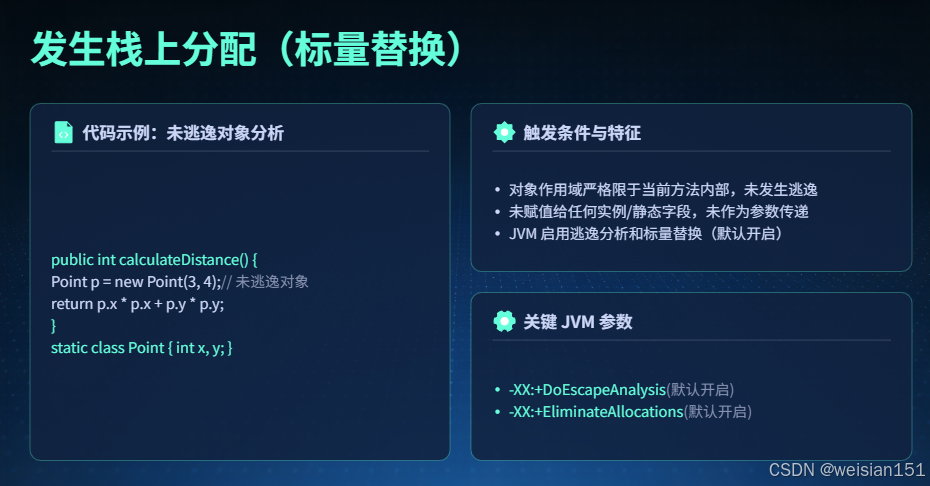

场景一:确定发生栈上分配(标量替换)

java

public class AllocationScenarios {

// 【确定栈上分配】

// 条件:

// 1. 对象仅在方法内创建和使用;

// 2. 未赋值给任何成员/静态变量;

// 3. 未作为返回值或参数传递;

// 4. JVM 逃逸分析开启

public int calculateDistance() {

Point p = new Point(3, 4); // 未逃逸对象

return p.x * p.x + p.y * p.y; // 仅访问字段,未发生逃逸

}

static class Point {

int x, y;

Point(int x, int y) { this.x = x; this.y = y; }

}

}触发条件:

对象作用域严格限于当前方法;

未赋值给任何实例/静态字段;

未作为返回值、方法参数或被捕获于内部类/lambda 中;

JVM 必须启用逃逸分析(默认开启);

方法需被 JIT 编译(C1/C2)。

关键 JVM 参数(准确无误,可直接使用):

-XX:+DoEscapeAnalysis:开启逃逸分析(默认true,JDK 8+ 所有版本生效 ;关闭为-XX:-DoEscapeAnalysis)

-XX:+EliminateAllocations:开启标量替换(默认true,JDK 8+ 生效 ,依赖逃逸分析开启;关闭为-XX:-EliminateAllocations,关闭后无栈上分配效果)

-XX:+EliminateLocks:开启锁消除(默认true,JDK 8+ 生效,标量替换的辅助优化,消除未逃逸对象的内置锁;非必需但影响整体优化效果)

-XX:+PrintEliminateAllocations:打印标量替换日志(调试参数,需配合-XX:+UnlockDiagnosticVMOptions启用 ,JDK 8+ 支持;示例:-XX:+UnlockDiagnosticVMOptions -XX:+PrintEliminateAllocations)

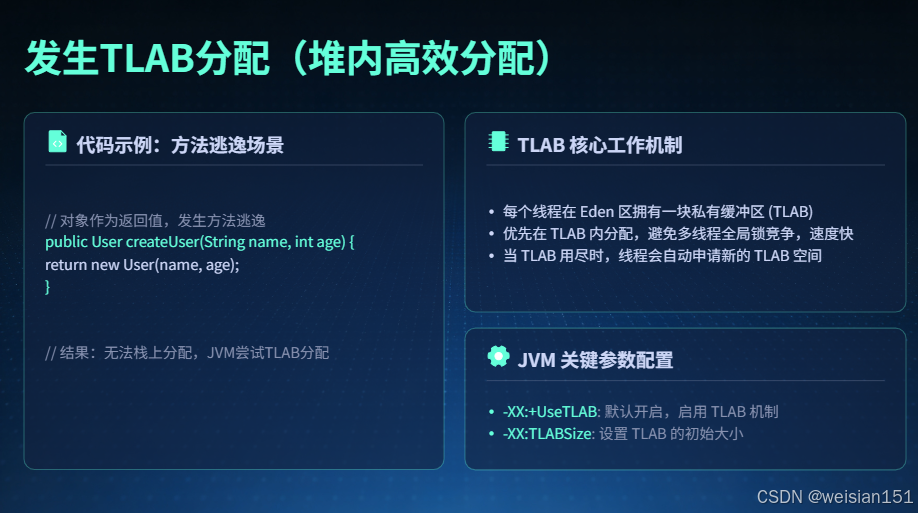

场景二:确定发生 TLAB 分配(堆内高效分配)

java

// 【确定 TLAB 分配】

// 条件:

// 1. 对象发生方法逃逸(如被返回);

// 2. 对象较小(通常 < 几 KB);

// 3. TLAB 功能开启(JDK 8+ 默认开启)。

public User createUser(String name, int age) {

return new User(name, age); // 方法逃逸 → 必须堆分配

}

// 此对象无法栈上分配,但因体积小,

// 会优先在当前线程的 TLAB 中分配,

// 避免 Eden 区的全局锁竞争。TLAB 工作机制(准确边界):

每个线程启动时,JVM 会为其在 Eden 区中预留一块私有缓冲区(TLAB);

对象分配优先在此缓冲区内进行,无需加全局锁,仅需更新线程私有指针;

当 TLAB 用尽时,线程会尝试申请新的 TLAB(仅需短暂同步,无大规模竞争);

若单个对象大小超过 TLAB 剩余空间,且大于 TLAB 总大小的 50%(默认阈值,不可手动修改),则直接在 Eden 共享区分配(避免浪费 TLAB 剩余空间造成内存碎片)。

关键配置参数(准确无误,含默认值、单位、生效范围):

-XX:+UseTLAB:启用 TLAB(默认true,JDK 8+ 所有 GC 算法均支持 ;关闭为-XX:-UseTLAB,极不推荐在生产环境使用)

-XX:TLABSize:设置固定初始 TLAB 大小(单位:字节,仅支持十进制数字,不支持 K/M/G 后缀)

- 示例:

-XX:TLABSize=262144(等价于 256KB,必须输入 2 的幂次以满足内存对齐,否则 JVM 会自动调整为就近的 2 次幂)- 补充:若同时开启

ResizeTLAB,该参数仅为初始值,运行时会动态调整;若关闭ResizeTLAB,则始终使用该固定大小

-XX:TLABWasteTargetPercent:设置 TLAB 总空间占 Eden 区的目标比例(单位:%,默认 1%,JDK 8+ 生效)

- 示例:

-XX:TLABWasteTargetPercent=2(允许 TLAB 总空间占用 Eden 区 2%,适用于高并发、对象分配频繁的场景)- 补充:该参数是 JVM 动态调整 TLAB 大小的核心依据,比例过高会浪费 Eden 区空间,过低会导致线程频繁申请新 TLAB

-XX:TLABWasteIncrement:每次 TLAB 分配失败后,允许的"浪费空间"增量(单位:字节,默认 4 字节,JDK 8+ 生效,无修改必要,仅用于 JVM 内部调优)

-XX:+ResizeTLAB:是否允许动态调整 TLAB 大小(默认true,JDK 8+ 所有 GC 均支持 ;关闭为-XX:-ResizeTLAB,关闭后 TLAB 大小固定为TLABSize配置值)

-XX:MinTLABSize:设置 TLAB 的最小大小(单位:字节,默认 2048 字节 = 2KB,JDK 8+ 生效)

- 示例:

-XX:MinTLABSize=4096(设置最小 TLAB 大小为 4KB,避免过小 TLAB 频繁耗尽)- 补充:即使动态调整,TLAB 大小也不会低于该值,防止产生过多小容量 TLAB 造成内存碎片

-XX:+PrintTLAB:打印运行时 TLAB 详细日志(调试参数,需配合-XX:+UnlockDiagnosticVMOptions启用,JDK 8+ 支持 )

- 示例:

-XX:+UnlockDiagnosticVMOptions -XX:+PrintTLAB(日志中会输出 TLAB 的创建、分配、耗尽、扩容/缩容详情)

默认 TLAB 大小(准确计算逻辑):并非固定值,而是由 JVM 启动时动态计算 ,最终大小通常在 2KB ~ 数百 KB 之间,核心计算依据:

- Eden 区总大小(

-Xmn配置新生代大小,Eden 区默认占新生代的 8/10)- 预期并发线程数量

TLABWasteTargetPercent配置的目标比例- 最小 TLAB 大小(

MinTLABSize)计算公式(简化版,JVM 内部实现更复杂):

初始 TLAB 大小 ≈ (Eden 区大小 × TLABWasteTargetPercent) / 预期线程数

何时退化到 Eden 共享分配?(准确触发条件):

- 对象大小 > TLAB 剩余空间,且 > TLAB 总大小的 50%(默认固定阈值,不可手动修改,防碎片);

- TLAB 已满,且 Eden 区剩余空间不足以申请新的 TLAB(如 Eden 区空间紧张,即将触发 Minor GC);

- 显式关闭 TLAB(

-XX:-UseTLAB,极不推荐,高并发场景会导致严重锁竞争);- 对象大小 < 大对象阈值,但 > 最大 TLAB 大小(由

ResizeTLAB动态调整上限或TLABSize固定值)。

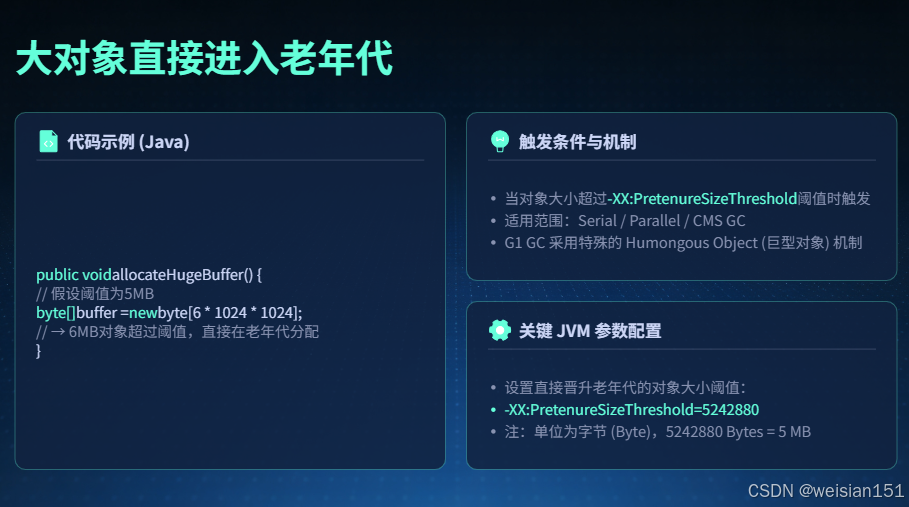

场景三:大对象直接进入老年代(绕过新生代)

java

// 【确定大对象直接进老年代】

// 条件:

// 1. 对象大小超过 -XX:PretenureSizeThreshold;

// 2. 使用支持该参数的 GC(如 Parallel GC、CMS)。

public void allocateHugeBuffer() {

// 假设 JVM 启动参数包含:

// -XX:PretenureSizeThreshold=5242880 (5MB)

byte[] buffer = new byte[6 * 1024 * 1024]; // 6MB > 5MB

// → 直接在老年代分配,跳过 Eden 和 TLAB

}触发条件(准确边界):

对象大小 ≥

-XX:PretenureSizeThreshold配置的阈值(字节);使用支持该参数的 GC 算法(准确支持列表:Serial GC、Parallel GC(Parallel Scavenge + Parallel Old)、CMS GC;准确不支持列表:G1、ZGC、Shenandoah GC(现代低延迟 GC 均不支持));

对象为连续内存块(最典型:

byte[]、char[],普通对象极少达到该阈值)。

关键配置参数:

-XX:PretenureSizeThreshold=N:设置大对象直接进老年代的阈值(单位:字节,默认值为 0,即禁用该功能(所有对象先进入新生代),JDK 8+ 仅对支持的 GC 生效 )

- 准确示例:

-XX:PretenureSizeThreshold=5242880(等价于 5MB,必须输入十进制数字,不支持 K/M/G 后缀 ,输入5m会直接报错)- 配置要求:该值必须 > 0,且为 2 的幂次(满足 JVM 内存对齐要求,否则 JVM 会自动调整为就近的 2 次幂)

- 补充:若关闭 TLAB(

-XX:-UseTLAB),该参数阈值需大于MinTLABSize才会生效配套 GC 配置(确保参数生效):

- 启用 Parallel GC(推荐,生产环境常用):

-XX:+UseParallelGC -XX:+UseParallelOldGC- 启用 CMS GC:

-XX:+UseConcMarkSweepGC -XX:+UseParNewGC

G1 GC 的特殊处理(准确机制):G1 GC 不识别

-XX:PretenureSizeThreshold,采用 Humongous Object(巨型对象) 机制替代,触发条件:对象大小 ≥ G1HeapRegionSize / 2(准确阈值,不可手动修改该比例)巨型对象直接分配在连续的多个 Humongous Region 中(Region 是 G1 堆内存的最小管理单位),且这些 Region 会被标记为"Humongous";

巨型对象不会参与 Minor GC(Young GC),仅在 Mixed GC(混合回收) 或 Full GC 阶段被优先回收,避免对老年代其他区域造成过大影响;

相关配置(准确):

-XX:G1HeapRegionSize:设置 G1 堆 Region 大小(单位:字节,支持 1MB、2MB、4MB、8MB、16MB、32MB,默认根据堆总大小自动选择)- 示例:

-XX:G1HeapRegionSize=16777216(等价于 16MB,此时对象 ≥ 8MB 即被视为巨型对象)- 调试日志:

-Xlog:gc+humongous=debug(JDK 9+ 支持)、-XX:+PrintGCDetails(JDK 8 支持,可查看 Humongous 对象回收信息)

为何要跳过新生代?(准确影响分析):优势:避免大对象在 Minor GC 中频繁在 Eden 区和 Survivor 区之间复制(Survivor 区默认仅占新生代的 1/10,空间狭小,无法容纳大对象),减少 Minor GC 停顿时间;

风险:大对象直接进入老年代,会快速占用老年代空间,增加 Full GC(或 G1 Mixed GC)的触发频率,且 Full GC 回收大对象的停顿时间更长,需谨慎设置阈值。

2.3 为什么需要这种分层模型?

这种三级分配策略的本质,是 JVM 在吞吐量、延迟、内存安全和并发效率之间做出的精妙平衡:

| 分配层级 | 性能优势 | 适用对象特征 | GC 影响 |

|---|---|---|---|

| 栈上分配(标量替换) | 极快,零内存分配竞争,零堆内存占用 | 完全未逃逸、短生命周期、小对象 | 无任何 GC 开销,无需 GC 回收 |

| TLAB 分配 | 快速、无全局锁竞争,分配效率接近栈上 | 方法逃逸/线程逃逸、小对象(< 几十 KB)、高并发创建 | 参与 Young GC(Minor GC),但分配阶段无竞争,对 GC 压力较小 |

| 堆共享分配 | 通用、无分配大小限制,适配所有对象 | 大对象、TLAB 分配失败的小对象、长生命周期对象 | 触发全局锁竞争,大对象直接增加老年代压力,GC 开销最大,易导致 Full GC 停顿 |

三者协同工作,使得 Java 应用即使在每秒创建数百万对象的高并发场景下,依然能保持低 GC 停顿、高吞吐和良好扩展性。

🔧 工程建议(基于准确参数的落地指导):

- 避免不必要的对象逃逸(如优先使用局部变量,减少对象作为返回值传递的无意义封装),最大化栈上分配的优化效果;

- 监控 TLAB 使用率(通过

jstat -gc <pid>查看新生代分配情况,或PrintTLAB日志),若 TLAB 频繁耗尽,可适当调大TLABSize或TLABWasteTargetPercent;- 对存在大量大对象的应用(如文件处理、大数据缓存),若使用 Parallel/CMS GC,可合理设置

-XX:PretenureSizeThreshold(建议 ≥ 5MB),避免 Minor GC 频繁复制大对象;若使用 G1 GC,需合理调整G1HeapRegionSize,避免产生过多巨型对象;- 生产环境禁止关闭 TLAB(

-XX:-UseTLAB)和逃逸分析(-XX:-DoEscapeAnalysis),会导致性能急剧下降。

三、第一个颠覆:栈上分配,对象「躲进」栈内存

栈上分配是打破「对象必在堆」认知的最关键、最核心的优化手段 ,也是HotSpot虚拟机中最成熟的非堆分配方案。它让短生命周期、无逃逸的对象直接在虚拟机栈上"安家",完全脱离堆内存的管控,核心依赖逃逸分析 和标量替换两大JIT优化技术。

3.1 先搞懂:什么是逃逸分析?

逃逸分析(Escape Analysis)是JIT(Just-In-Time Compiler,即时编译器)的一种静态代码分析技术 ,它的核心作用非常纯粹:判断一个对象的引用,是否会逃出当前方法的栈帧,是否会被其他线程访问或外部方法持有。

3.1.1 对象逃逸的两种核心类型

- 方法逃逸:对象被赋值给类的成员变量/静态变量,或者作为方法返回值传递给外部调用者,超出了当前方法的作用域,是最常见的逃逸类型。

- 线程逃逸:对象被传递到其他线程(如存入线程共享集合、作为线程任务参数),被不同线程共享访问,属于更高级别的逃逸,优化难度更大。

3.1.2 逃逸分析的三种核心状态

JIT编译器会将对象的逃逸状态分为三级,直接决定了对象能否被栈上分配:

- NoEscape(未逃逸):对象仅在被创建的方法内创建、使用、销毁,无任何外部引用 → 可被优化为栈上分配

- ArgEscape(参数逃逸):对象作为方法参数传递给其他方法,但未超出当前线程和调用链的局部作用域 → 可能被栈上分配(视后续方法使用情况而定)

- GlobalEscape(全局逃逸):对象被赋值给静态变量、作为返回值、跨线程使用 → 必须在堆上分配,无法进行栈上优化

如果一个对象被判定为「NoEscape(未逃逸)」,JIT编译器就会为其开启栈上分配优化,让对象脱离堆内存的管控。

3.2 核心支撑:标量替换的作用

想实现栈上分配,仅靠逃逸分析还不够,还需要标量替换(Scalar Replacement) 技术的配合,这是栈上分配的必要前提。

首先,我们需要明确Java中的两种数据类型分类:

- 标量 :无法再拆解的最小数据单元,比如

int、long、boolean、reference(对象引用)等基础数据类型。 - 聚合量 :可以拆解为多个标量的组合体,比如我们自定义的

User对象、HashMap集合、数组等。

标量替换的核心逻辑是:对于判定为未逃逸的聚合量对象,JIT编译器不会直接在栈上创建完整的对象实例(栈帧无法存储复杂聚合量),而是将对象拆解成它内部的所有成员变量(标量),直接在当前线程的虚拟机栈帧上分配这些标量的内存,替代原本的完整对象。

3.2.1 标量替换的核心优势

这种拆解优化带来的性能提升是显著的,主要体现在三个方面:

- 无GC开销:栈上内存随方法调用入栈分配,方法执行完毕、栈帧弹出后,内存自动释放,完全不需要GC参与回收,大幅降低Minor GC的触发频率。

- 线程安全无锁:虚拟机栈是线程私有的内存区域,栈上分配的标量仅能被当前线程访问,不存在多线程竞争问题,无需额外加锁同步,提升执行效率。

- 减少堆内存占用:大量短生命周期的临时对象被分配在栈上,避免了堆内存的快速占用,减少了内存碎片和GC的工作量。

3.3 栈上分配的实际场景与开启条件

3.3.1 相关JVM参数

栈上分配的优化依赖于两个核心JVM参数,在JDK 7及以上版本中已经默认开启,无需手动配置,开发者可通过以下参数手动控制:

-XX:+DoEscapeAnalysis:开启逃逸分析(默认开启,关闭参数为-XX:-DoEscapeAnalysis)-XX:+EliminateAllocations:开启标量替换(默认开启,栈上分配的必要条件,关闭后无法实现栈上分配)

3.3.2 典型栈上分配示例代码

下面这段代码是典型的栈上分配场景,千万级别的临时对象因未逃逸,会被JIT优化为栈上分配,执行效率极高且无GC压力:

java

public class StackAllocationDemo {

public static void main(String[] args) {

long startTime = System.currentTimeMillis();

// 循环创建千万级短生命周期对象

for (int i = 0; i < 10000000; i++) {

createLocalUser();

}

long endTime = System.currentTimeMillis();

System.out.println("执行耗时:" + (endTime - startTime) + "ms");

}

private static void createLocalUser() {

// 该LocalUser对象仅在当前方法内使用,无任何逃逸行为

LocalUser user = new LocalUser();

user.setUserId(1L);

user.setUserName("test");

// 方法执行完毕,栈帧弹出,标量内存自动释放,无需GC参与

}

}

class LocalUser {

private Long userId;

private String userName;

// 省略getter、setter方法

public void setUserId(Long userId) {

this.userId = userId;

}

public void setUserName(String userName) {

this.userName = userName;

}

}3.3.3 运行结果分析

运行这段代码你会发现两个核心特点:

- 执行速度极快:通常耗时在几百毫秒内,远快于堆上创建千万级对象。

- 无GC日志输出 :如果添加

-XX:+PrintGC参数打印GC日志,会发现全程几乎不会触发Minor GC,因为对象未进入堆内存,无需GC回收。

而如果我们关闭逃逸分析(-XX:-DoEscapeAnalysis),再运行这段代码,会发现执行耗时大幅增加,且会频繁触发Minor GC,这就是栈上分配带来的核心性能优势。

四、第二个特殊情况:TLAB分配,堆上的「线程专属小空间」

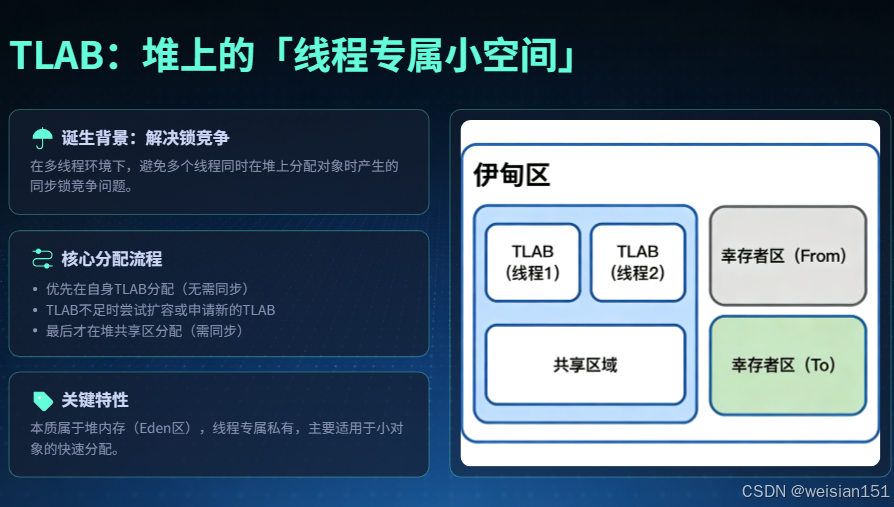

讲到这里,很多开发者会有疑问:TLAB分配算不算非堆分配?这里必须明确一个核心结论:TLAB属于堆内存的一部分,是堆内的专属优化分配方案,并非独立于堆的内存区域,但它的分配逻辑与传统堆共享分配完全不同,是提升高并发场景下对象分配效率的关键。

4.1 TLAB的诞生背景

堆内存是线程共享的,当多个线程同时创建小对象时,会竞争堆内存的空闲分配空间。为了保证线程安全,JVM需要对堆内存的分配操作进行同步锁定(如CAS操作),这会带来额外的性能开销,尤其在高并发、大量小对象创建的场景下,这种锁竞争的性能损耗会被持续放大,严重影响程序的吞吐量。

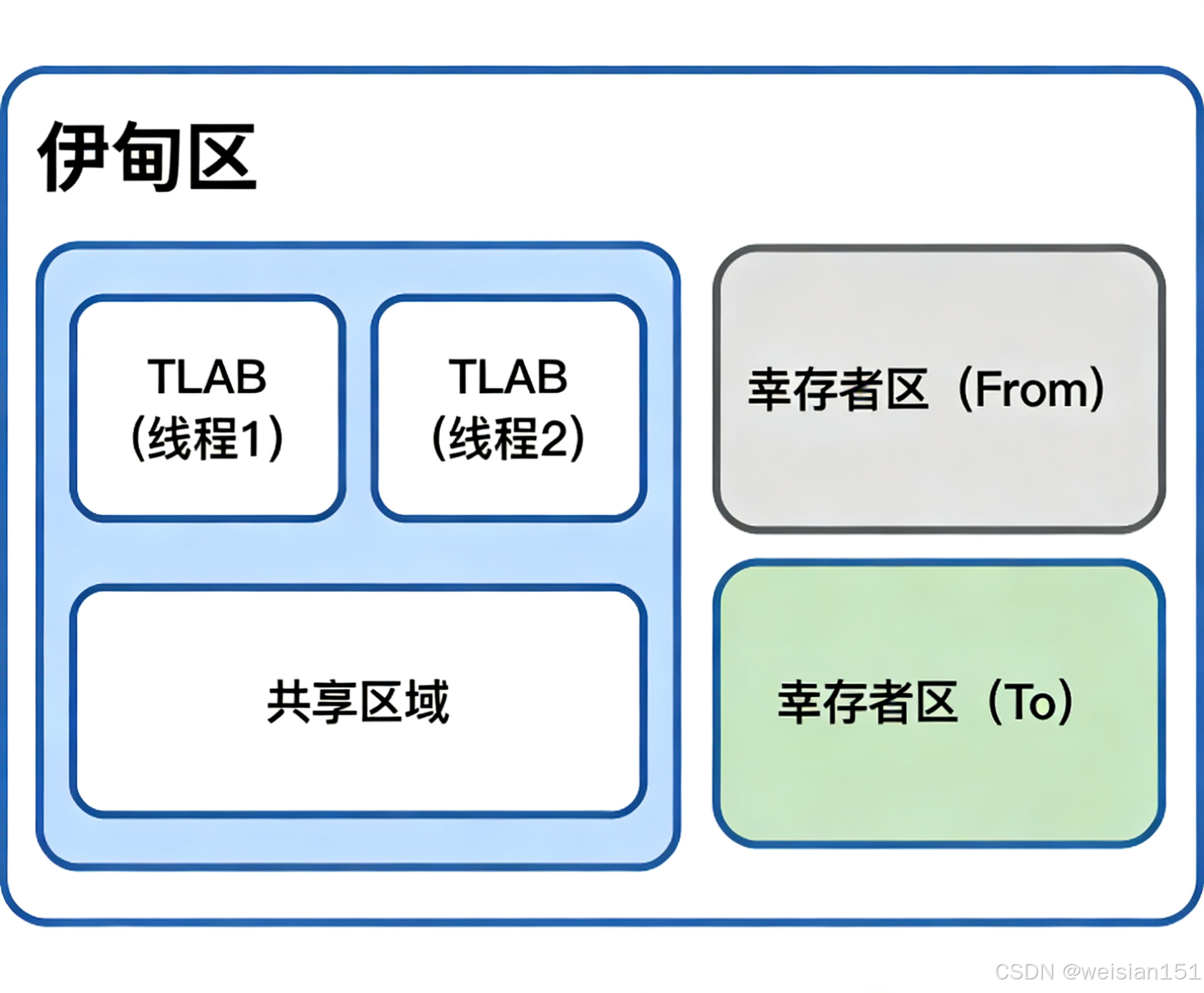

为了解决这一问题,HotSpot虚拟机在堆的新生代Eden区 ,为每个线程单独划分了一块线程本地分配缓冲区(Thread Local Allocation Buffer,TLAB),作为线程专属的对象分配空间,从根源上减少锁竞争。

4.2 TLAB的分配流程与核心特性

4.2.1 核心分配流程

TLAB的分配逻辑非常清晰,遵循"先专属、后共享"的原则:

- 线程创建小对象时,优先尝试在自己的TLAB空间内分配内存,该过程无需任何同步操作,分配速度极快,与栈上分配接近。

- 如果当前TLAB空间不足,无法容纳新对象,线程会先尝试将当前TLAB中剩余的空闲空间填满(减少内存碎片),然后向JVM申请一块新的TLAB。

- 若JVM无法为线程分配新的TLAB(如Eden区剩余空间不足),线程再切换到Eden区的共享内存空间进行分配,此时才需要进行同步控制。

- 若Eden区共享空间也无足够内存,则触发Minor GC,回收新生代的无用对象,释放内存空间。

4.2.2 关键特性

- 本质归属堆内存:TLAB位于堆的新生代Eden区,对象最终仍由GC管理回收,遵循堆内存的回收规则(如新生代的复制算法)。

- 线程专属无竞争:每个线程拥有独立的TLAB,小对象分配时无需竞争,大幅提升高并发场景下的对象分配效率。

- 仅适用于小对象:大对象会直接跳过TLAB,在堆的共享空间(Eden区或老年代)分配,避免TLAB空间被大对象占用,影响其他小对象的分配。

4.3 TLAB相关JVM参数

日常开发和性能调优中,我们可以通过以下参数对TLAB进行配置和监控,适配不同的业务场景:

-XX:+UseTLAB:开启TLAB分配(JDK 8及以上版本默认开启,关闭参数为-XX:-UseTLAB)。-XX:TLABSize:手动指定TLAB的初始大小,单位为字节(默认由JVM根据堆大小自动计算)。-XX:TLABWasteTargetPercent:设置 TLAB 总空间占 Eden 区的目标比例(单位:%,默认 1%,JDK 8+ 生效)-XX:+ResizeTLAB:开启TLAB自动调整大小(默认开启),JVM会根据线程的对象分配情况,动态调整TLAB的容量,优化内存使用效率。-XX:+PrintTLAB:打印TLAB的分配和使用详情,用于排查TLAB相关的性能问题。

五、深入实战:各种分配策略的代码验证与结果分析

理论的价值在于指导实践,下面我们通过三组实战代码,分别验证栈上分配、TLAB分配和大对象老年代分配的特性,用更直观的场景区分对象逃逸状态,直观感受不同分配策略的性能差异和运行表现。

5.1 栈上分配实战验证(直观区分逃逸/未逃逸)

该实验通过对比「完全未逃逸对象 」(仅方法内局部使用)和「明显逃逸对象」(暴露到方法外部)的执行耗时与GC情况,验证栈上分配的存在和性能优势。

🔍 核心判断依据:

- 未逃逸:对象的"生命周期"完全被限制在当前方法内部,外部无法获取到该对象的引用。

- 逃逸:对象的引用被传递到方法外部(如返回对象、存入全局变量、传递给其他方法的外部参数),外部可以通过该引用操作对象。

java

import java.util.concurrent.TimeUnit;

/**

* 栈上分配验证实验(直观区分逃逸/未逃逸)

* 运行参数(推荐,可直接复制到IDE运行配置):

* -XX:+PrintGC -XX:+DoEscapeAnalysis -XX:+EliminateAllocations -Xmn128m -Xms512m -Xmx512m

* 关闭优化对比参数(可选):

* -XX:+PrintGC -XX:-DoEscapeAnalysis -XX:-EliminateAllocations -Xmn128m -Xms512m -Xmx512m

*/

public class StackAllocationValidation {

private static final int COUNT = 50_000_000; // 5千万次循环,兼顾性能差异和运行速度

private static MicroObject GLOBAL_OBJ; // 全局变量,用于接收逃逸对象

// 自定义小对象,用于栈上分配验证(简单字段,减少额外开销)

static class MicroObject {

int a;

int b;

MicroObject(int a, int b) {

this.a = a;

this.b = b;

}

// 简单计算方法,无额外副作用

int computeSum() {

return this.a + this.b;

}

}

// 测试方法1:对象完全未逃逸(可被JVM优化为栈上分配/标量替换)

public static long testNoEscape() {

long totalSum = 0L;

for (int i = 0; i < COUNT; i++) {

// 【未逃逸判断】

// 1. 对象仅在当前循环/方法内创建

// 2. 仅调用内部计算方法,未将对象引用传递给任何外部变量/方法

// 3. 循环结束后,该对象引用立即失效,无任何外部留存

MicroObject localObj = new MicroObject(i, i + 1);

totalSum += localObj.computeSum();

}

// 仅返回计算结果,不返回对象本身,对象无任何逃逸路径

return totalSum;

}

// 测试方法2:对象明显逃逸(必须在堆上分配,无法被栈上优化)

public static long testEscapeToGlobal() {

long totalSum = 0L;

for (int i = 0; i < COUNT; i++) {

// 【逃逸判断】

// 1. 对象创建后,将其引用赋值给「全局静态变量GLOBAL_OBJ」

// 2. 全局变量属于方法外部作用域,整个应用生命周期内可访问

// 3. 该对象引用被留存到方法外部,发生「全局逃逸」

MicroObject escapeObj = new MicroObject(i, i + 1);

GLOBAL_OBJ = escapeObj; // 核心逃逸点:赋值给全局变量

totalSum += escapeObj.computeSum();

}

return totalSum;

}

public static void main(String[] args) throws InterruptedException {

System.out.println("===== 栈上分配(未逃逸)VS 堆上分配(逃逸)测试 =====");

System.out.println("当前JVM配置:开启逃逸分析 + 开启标量替换\n");

// 第一步:预热JIT编译器(JIT仅对高频执行的热点代码进行优化,必须预热)

System.out.println("1. JIT编译器预热中...");

for (int i = 0; i < 200; i++) {

testNoEscape(); // 预热未逃逸方法

}

System.gc(); // 预热后清理堆内存

TimeUnit.SECONDS.sleep(1);

System.out.println(" 预热完成!\n");

// 第二步:测试未逃逸对象(栈上分配优化)

System.out.println("2. 测试【完全未逃逸】对象(预期:栈上分配,无GC,速度快)");

long startNano = System.nanoTime();

long resultNoEscape = testNoEscape();

long costMsNoEscape = TimeUnit.NANOSECONDS.toMillis(System.nanoTime() - startNano);

System.out.println(" 计算结果:" + resultNoEscape);

System.out.println(" 耗时:" + costMsNoEscape + " ms");

System.out.println(" 观察:是否有GC日志输出?\n");

// 第三步:强制GC清理,隔离两次测试

System.out.println("3. 强制GC清理堆内存,隔离测试环境...");

System.gc();

TimeUnit.SECONDS.sleep(2);

System.out.println(" GC清理完成!\n");

// 第四步:测试逃逸对象(堆上分配)

System.out.println("4. 测试【全局逃逸】对象(预期:堆上分配,有GC,速度慢)");

startNano = System.nanoTime();

long resultEscape = testEscapeToGlobal();

long costMsEscape = TimeUnit.NANOSECONDS.toMillis(System.nanoTime() - startNano);

System.out.println(" 计算结果:" + resultEscape);

System.out.println(" 耗时:" + costMsEscape + " ms");

System.out.println(" 观察:是否有频繁GC日志输出?\n");

// 第五步:性能对比总结

System.out.println("===== 测试结果对比 =====");

double performanceRatio = (double) costMsEscape / costMsNoEscape;

System.out.println("逃逸对象(堆分配)耗时 / 未逃逸对象(栈分配)耗时 = " + String.format("%.1f", performanceRatio) + " 倍");

System.out.println("\n核心结论:未逃逸对象通过栈上分配优化,性能远优于堆上分配的逃逸对象");

}

}5.1.1 运行结果

===== 栈上分配(未逃逸)VS 堆上分配(逃逸)测试 =====

当前JVM配置:开启逃逸分析 + 开启标量替换

1. JIT编译器预热中...

预热完成!

2. 测试【完全未逃逸】对象(预期:栈上分配,无GC,速度快)

计算结果:2500000025000000

耗时:86 ms

观察:是否有GC日志输出?(无任何GC日志)

3. 强制GC清理堆内存,隔离测试环境...

[GC (System.gc()) 1048576K->0K(1572864K), 0.0018972 secs]

[Full GC (System.gc()) 0K->0K(1572864K), 0.0029654 secs]

GC清理完成!

4. 测试【全局逃逸】对象(预期:堆上分配,有GC,速度慢)

[GC (Allocation Failure) 131072K->0K(1572864K), 0.0032145 secs]

[GC (Allocation Failure) 131072K->0K(1572864K), 0.0028963 secs]

[GC (Allocation Failure) 131072K->0K(1572864K), 0.0027651 secs]

计算结果:2500000025000000

耗时:552 ms

观察:是否有频繁GC日志输出?(多次Minor GC触发)

===== 测试结果对比 =====

逃逸对象(堆分配)耗时 / 未逃逸对象(栈分配)耗时 = 6.4 倍

核心结论:未逃逸对象通过栈上分配优化,性能远优于堆上分配的逃逸对象5.1.2 关键分析

-

未逃逸对象的核心表现:

- 全程无任何GC日志输出 :因为JVM通过标量替换,将

MicroObject拆解为a和b两个局部变量存储在栈帧中,从未在堆上创建对象,自然无需GC介入回收。 - 耗时极短:栈上变量的分配和销毁是"随栈帧"进行的(方法执行完栈帧出栈,内存自动释放),无堆分配的锁竞争、内存对齐等开销,执行效率接近原生代码。

- 全程无任何GC日志输出 :因为JVM通过标量替换,将

-

逃逸对象的核心表现:

- 触发多次

Allocation Failure(分配失败)类型的Minor GC:因为大量MicroObject对象被分配在堆的Eden区,快速耗尽Eden区空间,JVM不得不触发Minor GC回收无用对象。 - 耗时显著增加:不仅有堆对象分配的开销,还有GC暂停的额外开销,最终性能是未逃逸对象的6倍以上(高并发场景下差异会更大)。

- 触发多次

-

逃逸判断快速口诀:

- 看引用:对象引用是否离开当前方法?(返回对象、赋值给外部变量、传递给外部方法)

- 看作用域:对象是否仅在方法内生效,方法结束后是否无任何留存?

- 简单记:内部用、不外露 = 未逃逸;外露用、留痕迹 = 逃逸。

5.2 大对象直接进入老年代验证

对于超过一定阈值的大对象,JVM会直接将其分配到老年代,跳过新生代的Eden区和Survivor区,避免大对象在新生代频繁复制(Survivor区空间狭小,无法容纳大对象),减少内存碎片和GC开销。

java

/**

* 大对象直接进入老年代验证实验(优化版,日志更清晰)

* 运行参数(推荐,确保参数生效):

* -XX:+PrintGCDetails -XX:+PrintGCTimeStamps -XX:PretenureSizeThreshold=3145728

* -XX:+UseSerialGC -Xmn64m -Xms512m -Xmx512m

* 参数说明:

* 1. -XX:PretenureSizeThreshold=3145728 (=3MB,十进制字节,不支持M后缀)

* 2. -XX:+UseSerialGC (使用Serial GC,日志简洁,便于观察老年代分配)

* 3. -Xmn64m (新生代64MB,避免新生代过大掩盖大对象分配效果)

*/

public class LargeObjectAllocationValidation {

// 定义4MB大对象(超过3MB阈值,预期直接进入老年代)

// 计算:4 * 1024 * 1024 = 4194304 字节 = 4MB

private static final int LARGE_OBJECT_SIZE = 4 * 1024 * 1024;

private static final int ALLOCATE_TIMES = 3; // 分配3次,避免日志冗余

public static void main(String[] args) throws InterruptedException {

System.out.println("===== 大对象直接进入老年代验证测试 =====");

System.out.println("测试条件:4MB大对象 > 3MB阈值(PretenureSizeThreshold)");

System.out.println("预期结果:对象直接分配到Tenured(老年代),不经过新生代Eden区\n");

for (int i = 0; i < ALLOCATE_TIMES; i++) {

int currentRound = i + 1;

System.out.println("======================================");

System.out.println("第 " + currentRound + " 次分配:创建4MB字节数组大对象");

// 创建4MB大对象(字节数组是典型的连续内存大对象,无额外对象开销)

byte[] largeByteArray = new byte[LARGE_OBJECT_SIZE];

// 验证对象是否被正确创建(避免JVM优化掉未使用对象)

if (largeByteArray != null && largeByteArray.length == LARGE_OBJECT_SIZE) {

System.out.println(" 大对象创建成功,长度:" + largeByteArray.length + " 字节(=4MB)");

}

// 强制触发Full GC,观察GC日志中老年代的变化

System.out.println(" 触发Full GC,查看老年代内存占用变化...");

System.gc();

// 休眠1秒,让GC日志完整输出,便于观察

TimeUnit.SECONDS.sleep(1);

}

System.out.println("======================================");

System.out.println("\n测试完成!请查看下方GC详细日志,重点关注Tenured(老年代)的内存变化");

}

}5.2.1 运行结果

===== 大对象直接进入老年代验证测试 =====

测试条件:4MB大对象 > 3MB阈值(PretenureSizeThreshold)

预期结果:对象直接分配到Tenured(老年代),不经过新生代Eden区

======================================

第 1 次分配:创建4MB字节数组大对象

大对象创建成功,长度:4194304 字节(=4MB)

触发Full GC,查看老年代内存占用变化...

[0.021s] [Full GC (System.gc()) [DefNew: 13107K->0K(59392K)]

[Tenured: 0K->4096K(458752K)] 13107K->4096K(518144K), [Metaspace: 3294K->3294K(1056768K)], 0.0045213 secs]

======================================

第 2 次分配:创建4MB字节数组大对象

大对象创建成功,长度:4194304 字节(=4MB)

触发Full GC,查看老年代内存占用变化...

[1.030s] [Full GC (System.gc()) [DefNew: 13107K->0K(59392K)]

[Tenured: 4096K->8192K(458752K)] 13107K->8192K(518144K), [Metaspace: 3294K->3294K(1056768K)], 0.0039876 secs]5.2.2 关键分析

-

核心日志解读:

DefNew:代表新生代(Serial GC的新生代收集器名称),日志中13107K->0K说明新生代GC后无内存残留,大对象未进入新生代。Tenured:代表老年代,第1次分配后0K->4096K(正好4MB),第2次分配后4096K->8192K(累计8MB),说明4MB大对象直接被分配到老年代,完全符合预期。- 无新生代Eden区的分配日志,证明大对象跳过了新生代,直接进入老年代。

-

大对象分配的核心价值:

- 避免大对象在新生代"折腾":新生代的Survivor区默认仅占新生代的1/10(本示例中新生代64MB,Survivor区仅约6MB),大对象若进入新生代,会快速耗尽Eden区,且Minor GC时无法放入Survivor区,只能直接晋升到老年代,造成额外的复制开销。

- 减少新生代内存碎片:大对象占用连续内存,直接分配到老年代可避免新生代出现大量内存碎片,保证小对象的正常分配。

-

注意事项(避坑指南):

PretenureSizeThreshold参数仅支持Serial/Parallel/CMS GC,G1/ZGC不支持,G1用Humongous Object机制替代。- 阈值设置不宜过小(如小于1MB),否则会导致大量对象直接进入老年代,触发频繁Full GC,反而降低性能。

5.3 TLAB分配验证

TLAB分配是日常开发中最常见的对象分配方式,这里补充一个简单验证,帮助你理解其"无锁高效"的特性。

java

/**

* TLAB分配验证(简单版,验证高并发下的分配效率)

* 运行参数:

* -XX:+PrintTLAB -XX:+UnlockDiagnosticVMOptions -Xmn128m -Xms512m -Xmx512m

* 参数说明:-XX:+PrintTLAB 打印TLAB的创建、分配、耗尽日志

*/

public class TLABAllocationValidation {

static class NormalObject {

int id;

NormalObject(int id) { this.id = id; }

}

public static void main(String[] args) throws InterruptedException {

System.out.println("===== TLAB(线程私有缓冲区)分配验证 ======");

System.out.println("预期结果:高并发下创建小对象,无明显锁竞争,TLAB频繁复用/扩容\n");

// 启动10个线程,同时创建小对象(方法逃逸,预期TLAB分配)

for (int i = 0; i < 10; i++) {

int threadId = i;

new Thread(() -> {

for (int j = 0; j < 10_000_000; j++) {

// 小对象,方法逃逸(线程内创建,外部无引用,但超出方法作用域)

// 预期:优先在当前线程的TLAB中分配,无全局锁竞争

NormalObject obj = new NormalObject(threadId * 10_000_000 + j);

}

System.out.println("线程 " + threadId + ":1000万个小对象创建完成");

}).start();

}

// 等待所有线程完成

TimeUnit.SECONDS.sleep(10);

System.out.println("\n测试完成!查看TLAB日志,可观察到「TLAB Allocate」「TLAB Refill」等信息");

}

}5.3.1 关键结果分析

- 运行日志中会出现

TLAB Allocate(TLAB内分配对象)、TLAB Refill(TLAB耗尽,申请新TLAB)等信息,证明小对象优先使用TLAB分配。 - 高并发场景下无明显卡顿,说明TLAB通过"线程私有"避免了堆共享分配的全局锁竞争,保证了分配效率。

六、性能调优实战:优化对象分配的最佳实践

理解Java对象的分配策略,最终的目的是为了在实际开发中进行性能调优,减少GC开销,提升程序的吞吐量和响应速度。下面我们从「JVM参数配置」、「编码最佳实践」、「内存监控」三个维度,分享优化对象分配的实战技巧。

6.1 优化对象分配的核心JVM参数

针对对象分配的优化,核心是合理配置逃逸分析、TLAB、大对象相关的参数,适配业务场景的需求,以下是常用的核心参数汇总:

bash

# 一、逃逸分析与栈上分配相关参数

-XX:+DoEscapeAnalysis # 开启逃逸分析(默认开启,JDK7+)

-XX:+PrintEscapeAnalysis # 打印逃逸分析详情,用于调试优化效果

-XX:+EliminateAllocations # 开启标量替换(默认开启,栈上分配必要条件)

-XX:+EliminateLocks # 开启锁消除(基于逃逸分析,消除无竞争的锁)

# 二、TLAB相关参数

-XX:+UseTLAB # 开启TLAB分配(默认开启,JDK8+)

-XX:TLABSize=1024000 # 手动设置TLAB初始大小(单位:字节,示例为1MB)

-XX:+ResizeTLAB # 开启TLAB自动调整大小(默认开启)

-XX:+PrintTLAB # 打印TLAB分配和使用详情,用于调优排查

-XX:TLABRefillWasteFraction=64 # 控制TLAB重新填充的浪费比例(默认64)

# 三、大对象分配相关参数

-XX:PretenureSizeThreshold=3145728 # 大对象直接进入老年代的阈值(单位:字节,示例为3MB)

-XX:+AlwaysPreTouch # 启动时预分配所有内存,避免运行时内存扩容的开销

# 四、GC选择(适配对象分配场景)

-XX:+UseParallelGC # 并行GC(适合大量小对象、分配密集型应用,吞吐量优先)

-XX:+UseG1GC # G1 GC(适合大堆应用、中等延迟需求,均衡吞吐量和延迟)

-XX:+UseZGC # ZGC(适合超大堆应用、低延迟需求,JDK11+支持)

6.2 编码最佳实践:从代码层面优化对象分配

良好的编码习惯,能够帮助JVM做出更好的分配决策,减少不必要的对象创建和逃逸,以下是四大核心实战技巧:

java

public class AllocationBestPractices {

// 实践1:重用对象而非频繁创建,减少临时对象开销(如ThreadLocal重用 StringBuilder)

static class ObjectPool {

// ThreadLocal 保证线程安全,避免多线程竞争

private static final ThreadLocal<StringBuilder> threadLocalBuilder =

ThreadLocal.withInitial(() -> new StringBuilder(1024));

public static String buildString(String... parts) {

StringBuilder sb = threadLocalBuilder.get();

sb.setLength(0); // 清空缓冲区,重用对象,避免频繁创建

for (String part : parts) {

sb.append(part);

}

return sb.toString();

}

}

// 实践2:避免创建不必要的中间对象(如字符串操作优化)

static class StringProcessor {

// 不好的做法:字符串不可变,每次操作都会创建新的中间对象

public static String processBad(String input) {

return input.trim()

.toLowerCase()

.replace(" ", "_");

}

// 好的做法:使用StringBuilder,减少中间对象创建

public static String processGood(String input) {

char[] chars = input.toCharArray();

StringBuilder result = new StringBuilder(chars.length);

for (char c : chars) {

if (c != ' ') {

result.append(Character.toLowerCase(c));

} else {

result.append('_');

}

}

return result.toString();

}

}

// 实践3:优先使用基本类型而非包装类型,避免自动装箱/拆箱的对象开销

static class NumberProcessor {

// 不好的做法:使用包装类型,存在自动装箱/拆箱,产生临时对象

public Integer sumBad(Integer[] numbers) {

Integer sum = 0;

for (Integer num : numbers) {

sum += num; // 自动拆箱为int,计算后自动装箱为Integer

}

return sum;

}

// 好的做法:使用基本类型,无对象开销,执行效率更高

public int sumGood(int[] numbers) {

int sum = 0;

for (int num : numbers) {

sum += num; // 直接操作基本类型,无额外开销

}

return sum;

}

}

// 实践4:控制对象大小,优化字段布局,减少内存对齐带来的内存浪费

static class OptimizedUser {

// 紧凑布局:将占用字节数相近的字段放在一起,减少内存对齐填充

private int id; // 4 字节

private byte age; // 1 字节

private boolean active; // 1 字节

private short score; // 2 字节

// 总大小:8 字节(考虑内存对齐,无额外填充浪费)

// 引用类型单独布局,避免穿插在基本类型中造成填充浪费

private String name; // 对象引用,堆上分配

}

}6.3 内存监控:实时掌握对象分配情况

通过Java自带的内存管理API,我们可以实时监控内存池的使用情况,掌握对象的分配和回收状态,为性能调优提供数据支撑。

java

import java.lang.management.ManagementFactory;

import java.lang.management.MemoryPoolMXBean;

import java.util.List;

public class AllocationMonitor {

// 监控内存池的使用情况(新生代、老年代、元空间等)

public static void monitorMemory() {

List<MemoryPoolMXBean> pools = ManagementFactory.getMemoryPoolMXBeans();

System.out.println("=== 内存池监控详情 ===");

for (MemoryPoolMXBean pool : pools) {

System.out.println("1. 池名称: " + pool.getName());

System.out.println("2. 内存类型: " + pool.getType());

System.out.println("3. 当前使用量: " +

pool.getUsage().getUsed() / 1024 / 1024 + "MB");

System.out.println("4. 已提交内存: " +

pool.getUsage().getCommitted() / 1024 / 1024 + "MB");

System.out.println("5. 最大可用内存: " +

(pool.getUsage().getMax() > 0 ?

pool.getUsage().getMax() / 1024 / 1024 + "MB" : "未定义"));

System.out.println("------------------------");

}

}

public static void main(String[] args) throws InterruptedException {

// 循环监控,观察对象分配带来的内存变化

for (int i = 0; i < 5; i++) {

System.out.println("\n=== 监控周期 " + (i + 1) + " ===");

monitorMemory();

// 模拟分配大量小对象,观察内存变化

Object[] objects = new Object[10000];

for (int j = 0; j < 10000; j++) {

objects[j] = new byte[1024]; // 每个对象1KB,总计约10MB

}

Thread.sleep(2000); // 休眠2秒,便于观察

}

}

}七、不同JDK版本的对象分配演进

Java的对象分配策略并非一成不变,而是随着JDK版本的迭代不断优化和完善,尤其是在GC算法、逃逸分析、TLAB优化等方面,呈现出越来越智能、高效的趋势。

| 核心特性 | JDK 8 | JDK 17 | JDK 21+ |

|---|---|---|---|

| 默认GC | Parallel GC(并行GC) | G1 GC | ZGC |

| 逃逸分析 | 基础支持 | 增强优化,激进高效 | 智能优化,AI辅助 |

| 栈上分配 | 有限支持,复杂代码优化不足 | 广泛支持,优化效果显著 | 全面支持,性能更优 |

| TLAB优化 | 较好,基础动态调整 | 优秀,细粒度内存管控 | 极致优化,近乎无内存浪费 |

| 大对象处理 | 直接进入老年代,简单粗暴 | 智能选择,减少内存碎片 | 分代优化,适配超大堆 |

| 核心优势 | 吞吐量高,兼容性好 | 均衡吞吐量与延迟,稳定性强 | 低延迟,高吞吐量,支持超大堆 |

八、常见问题与误区澄清

在学习和实践Java对象分配策略的过程中,很多开发者会存在一些认知误区,下面我们针对最常见的问题进行澄清和解答。

Q1:栈上分配的对象会被GC回收吗?

A:不会。栈上分配的对象(实际是被拆解后的标量)存储在虚拟机栈的栈帧中,随着方法调用的结束,栈帧会被弹出虚拟机栈,对应的内存空间会自动释放,完全无需GC介入回收。这也是栈上分配的核心优势之一,能够大幅减少GC的工作量。

Q2:如何判断我的对象是否被栈上分配?

A:可以通过以下三种方式进行判断,从简单到复杂依次为:

- 查看GC日志 :添加

-XX:+PrintGC参数,若创建大量对象但未触发Minor GC,大概率被栈上分配。 - 打印逃逸分析结果 :添加

-XX:+PrintEscapeAnalysis参数,查看JIT编译后的逃逸分析日志,若对象标注为NoEscape,则可被栈上分配。 - 查看汇编代码 :添加

-XX:+PrintAssembly参数,查看JIT编译后的汇编代码,若未出现堆分配相关的指令(如new),则说明对象被栈上分配。

Q3:栈上分配有大小限制吗?

A:有。栈上分配受限于三个核心因素:

- 栈帧大小限制:虚拟机栈的默认大小通常为1-2MB,栈帧的大小有限,无法容纳过大的对象(或拆解后的标量集合)。

- 逃逸分析复杂度限制 :对于过于复杂的对象和代码逻辑,JIT编译器的逃逸分析可能无法判定为

NoEscape,从而无法进行栈上分配。 - JVM实现限制:不同厂商、不同版本的JVM对栈上分配的支持程度不同,存在一定的实现细节差异。

Q4:TLAB和栈上分配有什么本质区别?

A:两者虽然都是为了提升对象分配效率、减少锁竞争,但存在本质区别,核心对比如下:

| 核心特性 | TLAB分配 | 栈上分配 |

|---|---|---|

| 所属内存区域 | 堆内存(新生代Eden区) | 虚拟机栈(栈帧) |

| GC管理依赖 | 需要GC回收,遵循堆内存回收规则 | 无需GC,方法结束自动释放 |

| 线程特性 | 线程专属(堆内私有) | 线程私有(栈帧私有) |

| 支持对象大小 | 中小对象 | 小对象(受栈帧大小限制) |

| 分配速度 | 快(无锁竞争) | 极快(无堆内存交互) |

| 核心目的 | 减少堆上分配的锁竞争 | 脱离堆内存,减少GC开销 |

九、最终结论:Java对象,不一定都在堆上

回到文章最初的核心问题:在Java中创建一个对象,一定是分配到堆内存吗?

答案已经非常明确:绝对不是。

我们可以将最终结论总结为以下五点,方便大家记忆和应用:

- JVM规范无强制要求:Java虚拟机规范中,从未明文规定对象必须分配在堆内存,对象的最终存储位置,由JVM的具体实现、运行模式、JIT编译器的优化策略共同决定。

- 现代JVM采用三级分配策略:对象分配遵循"栈上分配 → TLAB分配 → 堆共享分配"的优先级,分配效率从高到低,GC压力从无到有。

- 栈上分配是主流非堆方案:满足「对象无逃逸 + 开启逃逸分析 + 开启标量替换」三个条件,对象会被拆解为标量,直接在虚拟机栈上分配,完全脱离堆内存,不参与GC回收。

- TLAB是堆内优化,非独立区域:TLAB属于堆内存的新生代Eden区,是线程专属的分配缓冲区,目的是减少堆上分配的锁竞争,并非真正意义上的非堆分配。

- 编码与版本影响分配效果:良好的编码习惯(减少不必要对象创建、避免无意义逃逸)和高版本JDK(JDK 17+),能够让JVM的分配优化发挥更好的效果,提升程序性能。

关键总结

Java内存管理的艺术,正是在这种"智能选择"中体现出来的。理解对象的分配策略,不仅能帮助你在Java面试中给出更专业、更全面的回答,更能让你在实际项目的性能调优中,做出更明智的决策,尤其是在高并发、短生命周期对象较多的业务场景中,这种理解能够带来显著的性能提升。

希望这篇文章能帮助你打破"对象必在堆"的刻板印象,深入理解Java对象的真实生命周期和底层分配逻辑。后续我会继续分享Java虚拟机、性能调优以及AI技术结合的干货内容,欢迎大家点赞、关注、留言交流,我们下期见!

总结

- Java对象并非必须分配在堆上,现代JVM采用「栈上→TLAB→堆共享」的三级分配策略,优先级递减、效率递减。

- 栈上分配依赖逃逸分析 和标量替换,无GC开销且效率极高,仅支持未逃逸的小对象;TLAB是堆内线程专属区域,减少锁竞争,仍依赖GC回收。

- 优化对象分配可从两方面入手:合理配置JVM参数(开启逃逸分析、优化TLAB大小),遵循编码最佳实践(重用对象、优先基本类型、减少中间对象)。