✍✍计算机毕设指导师**

⭐⭐个人介绍:自己非常喜欢研究技术问题!专业做Java、Python、小程序、安卓、大数据、爬虫、Golang、大屏等实战项目。

⛽⛽实战项目:有源码或者技术上的问题欢迎在评论区一起讨论交流!

⚡⚡有什么问题可以在主页上或文末下联系咨询博客~~

⚡⚡Java、Python、小程序、大数据实战项目集](https://blog.csdn.net/2301_80395604/category_12487856.html)

⚡⚡文末获取源码

温馨提示:文末有CSDN平台官方提供的博客联系方式!

温馨提示:文末有CSDN平台官方提供的博客联系方式!

温馨提示:文末有CSDN平台官方提供的博客联系方式!

车辆二氧化碳排放量可视化分析系统-简介

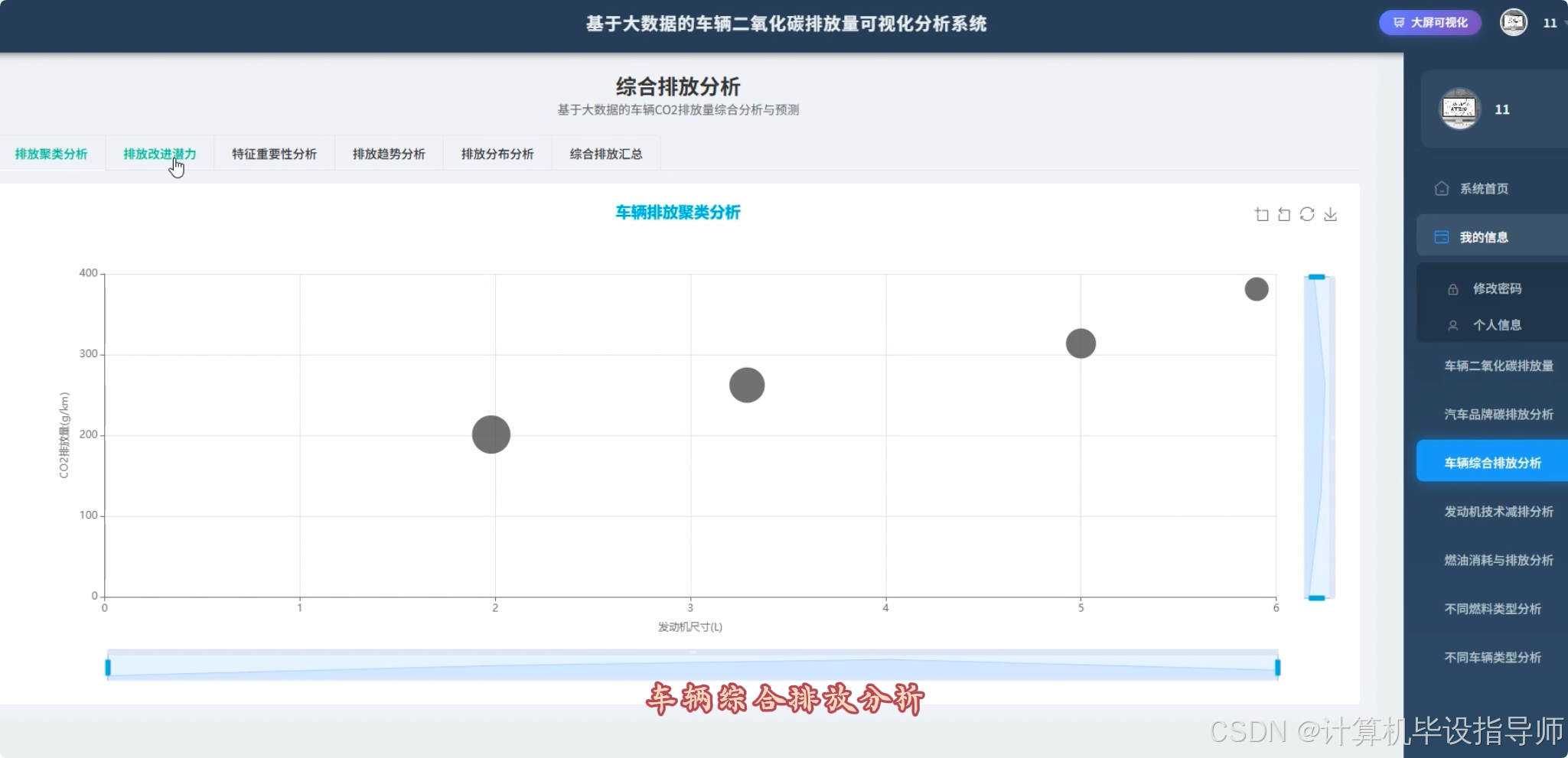

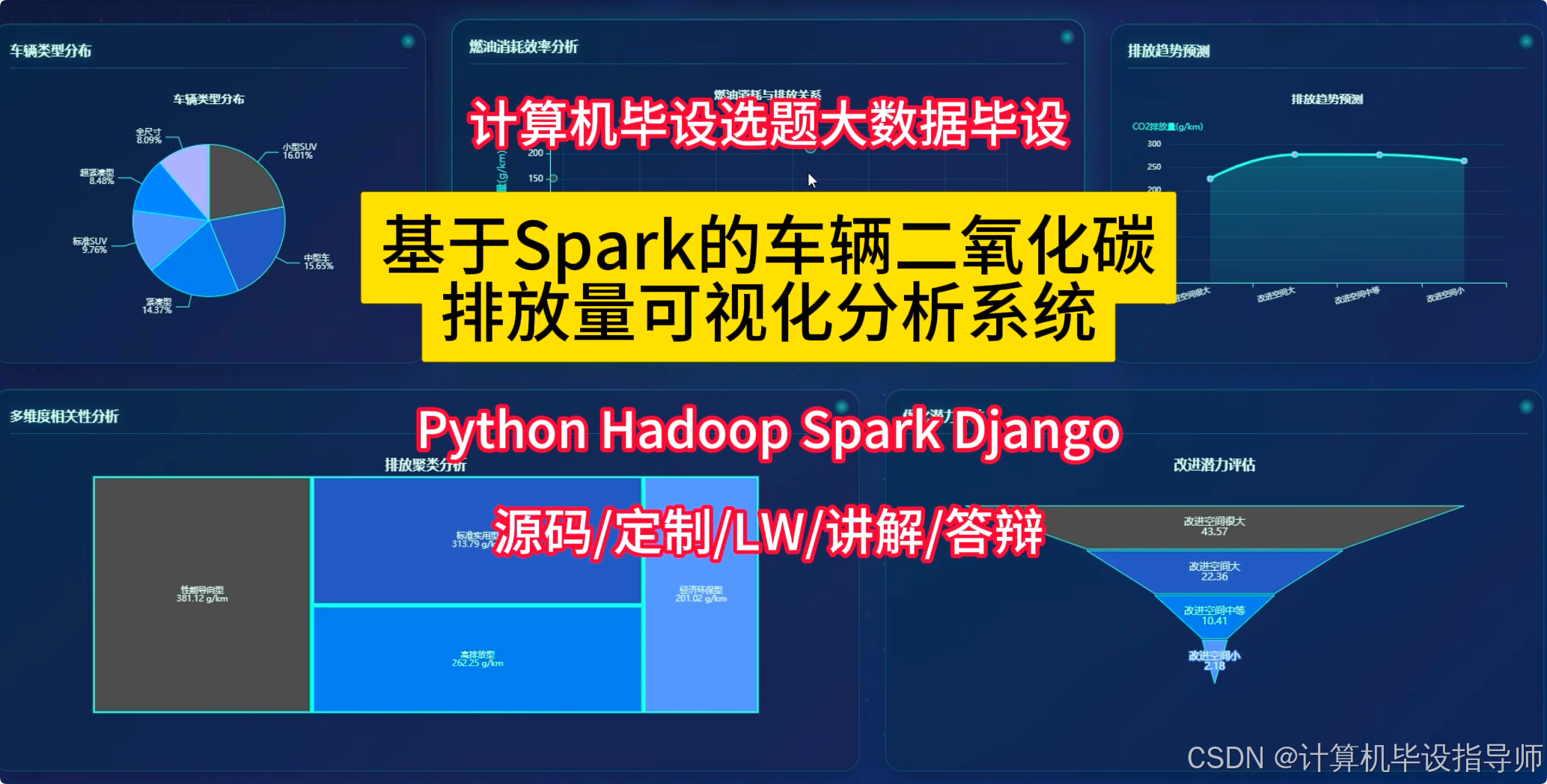

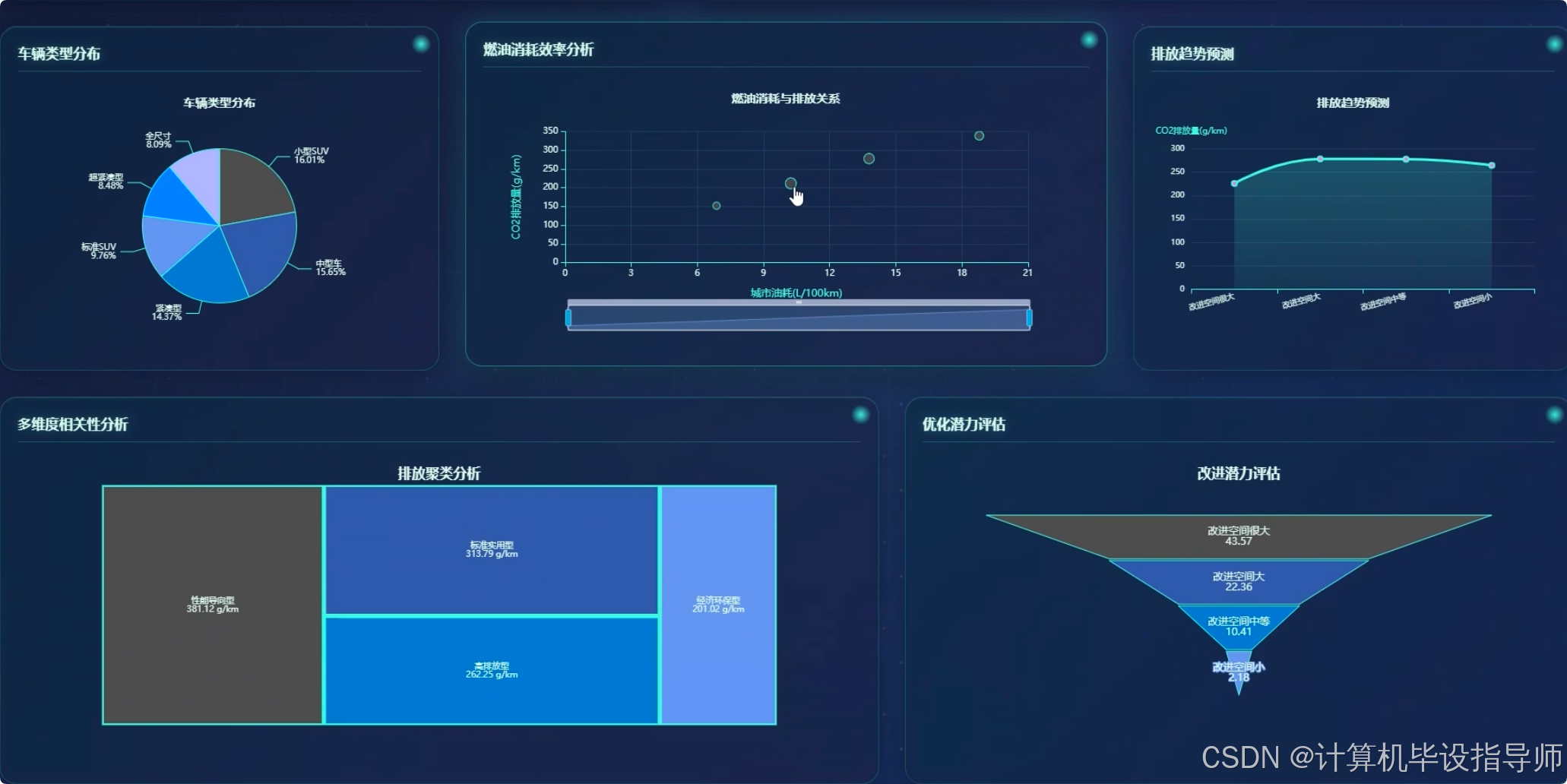

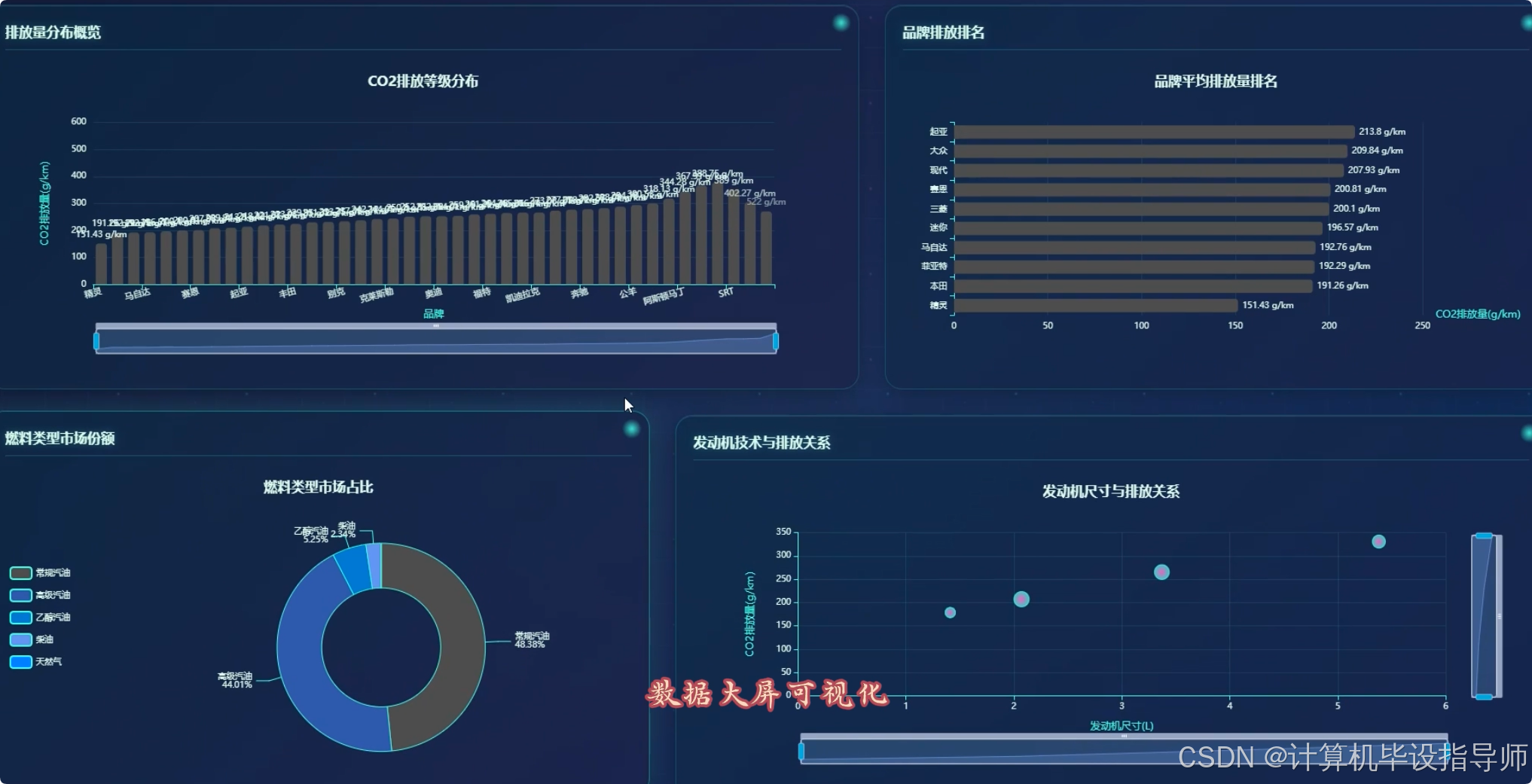

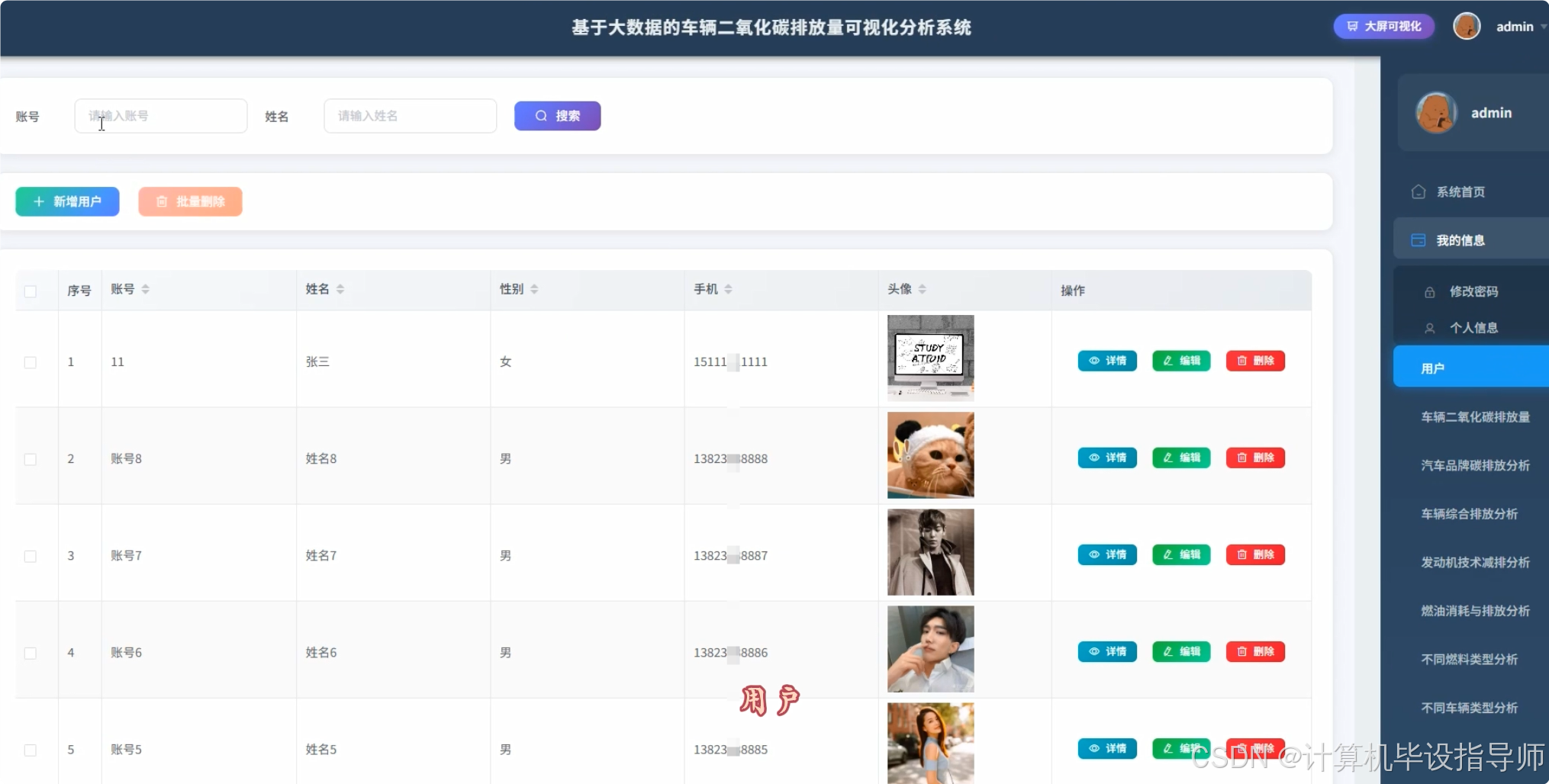

本系统是一个基于Spark的车辆二氧化碳排放量可视化分析系统,旨在运用大数据技术深度剖析车辆碳排放数据。系统整体架构采用Hadoop作为分布式存储基础,利用Spark进行大规模数据的并行计算与快速分析,有效解决了传统单机处理海量数据性能不足的问题。后端服务采用Python语言结合Django框架进行开发,负责处理前端的请求、调用Spark进行数据分析任务,并提供RESTful API接口。前端界面则基于Vue.js框架,集成ElementUI组件库与Echarts可视化图表库,为用户提供了美观且交互性强的数据展示界面。系统功能围绕品牌、车辆类型、发动机技术、燃料类型、油耗与排放关系及综合评估六大维度展开,具体包括各品牌平均排放量统计、发动机尺寸与排放关系分析、不同燃料类型环保性对比、油耗与排放相关性研究以及通过聚类算法识别高排放车辆特征等超过30个细分分析点,最终通过丰富的图表形式,直观地呈现车辆环保性能的全景视图。

车辆二氧化碳排放量可视化分析系统-技术

大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

开发语言:Python+Java(两个版本都支持)

后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

数据库:MySQL

车辆二氧化碳排放量可视化分析系统-背景

选题背景

随着全球对气候变化和环境保护的关注日益加深,交通运输领域作为主要的碳排放源之一,其减排压力越来越大。汽车作为城市交通的基石,其尾气排放对空气质量的影响直接关系到居民生活健康。在这样的背景下,如何科学评估和管理车辆的二氧化碳排放量,成为政府、汽车制造商乃至消费者共同关心的问题。市场上车辆型号繁多,技术参数各异,单纯依靠传统的小样本分析或经验判断,已难以满足精细化管理和绿色消费的需求。因此,利用大数据技术对海量车辆数据进行系统性、多维度的分析,挖掘数据背后的规律,显得尤为迫切和必要,这为相关政策的制定和技术的优化提供了坚实的数据基础。

选题意义

这个课题的意义在于,它提供了一个完整的大数据处理实践平台。通过这个项目,我们能把课堂上学到的Hadoop、Spark这些理论知识,真正运用到解决实际问题里去,锻炼自己处理和分析数据的能力,对整个大数据技术栈的理解会更加深刻。从实际应用角度看,系统的分析结果可以为普通消费者购车提供参考,帮他们更清晰地了解不同品牌、不同车型的环保表现,从而做出更绿色的选择。对于相关部门来说,这些分析数据也能为制定交通环保政策、鼓励低碳技术发展提供一些数据支持。虽然这只是一个毕业设计,功能上还有提升空间,但也希望能发挥一点小小的价值,让我们在学习技术的同时,也能为环保事业贡献一份微薄的力量。

车辆二氧化碳排放量可视化分析系统-视频展示

基于Spark的车辆二氧化碳排放量可视化分析系统 毕业设计

车辆二氧化碳排放量可视化分析系统-图片展示

车辆二氧化碳排放量可视化分析系统-代码展示

python

from pyspark.sql import SparkSession

from pyspark.sql.functions import avg, count, corr

from pyspark.ml.feature import VectorAssembler

from pyspark.ml.clustering import KMeans

spark = SparkSession.builder.appName("VehicleCO2Analysis").getOrCreate()

def analyze_brand_avg_emissions(df):

# 计算各品牌平均CO2排放量

brand_avg_emissions = df.groupBy("Make").agg(avg("CO2 Emissions").alias("Avg_CO2_Emissions"), count("*").alias("Model_Count"))

# 过滤掉车型数量过少的品牌,保证统计意义

brand_avg_emissions_filtered = brand_avg_emissions.filter(brand_avg_emissions.Model_Count >= 5)

# 按平均排放量降序排列

brand_avg_emissions_sorted = brand_avg_emissions_filtered.orderBy("Avg_CO2_Emissions", ascending=False)

brand_avg_emissions_sorted.show()

return brand_avg_emissions_sorted

def analyze_engine_size_correlation(df):

# 计算发动机尺寸与CO2排放量的全局相关系数

global_corr = df.select(corr("Engine Size", "CO2 Emissions").alias("Global_Correlation")).collect()[0][0]

print(f"发动机尺寸与CO2排放量的全局相关系数为: {global_corr}")

# 按车辆类别分组,计算每种类别下的相关系数

class_corr = df.groupBy("Vehicle Class").agg(corr("Engine Size", "CO2 Emissions").alias("Class_Correlation"))

class_corr.show()

return class_corr

def perform_emission_clustering(df):

# 选择用于聚类的特征列

feature_cols = ["Engine Size", "Cylinders", "Fuel Consumption Comb", "CO2 Emissions"]

# 使用VectorAssembler将特征列合并为一个特征向量

assembler = VectorAssembler(inputCols=feature_cols, outputCol="features")

assembled_df = assembler.transform(df)

# 初始化K-Means模型,设置聚类数量为3(高、中、低排放)

kmeans = KMeans(featuresCol="features", predictionCol="emission_cluster", k=3, seed=42)

# 训练模型

model = kmeans.fit(assembled_df)

# 使用模型进行预测

clustered_df = model.transform(assembled_df)

# 展示部分聚类结果

clustered_df.select("Make", "Model", "CO2 Emissions", "emission_cluster").show(20, truncate=False)

# 打印聚类中心,用于解释每个簇的特征

centers = model.clusterCenters()

print("聚类中心点(Engine Size, Cylinders, Fuel Consumption Comb, CO2 Emissions):")

for i, center in enumerate(centers):

print(f"Cluster {i}: {center}")

return clustered_df车辆二氧化碳排放量可视化分析系统-结语

本系统成功实现了对车辆CO2排放数据的多维度分析与可视化,验证了Spark大数据处理技术在环保领域的应用潜力。当然,系统还存在数据源单一、分析模型可优化等局限,未来可引入更多实时数据流和更复杂的预测模型,进一步提升分析的深度与广度。

对这个毕设项目感兴趣的同学,欢迎来我主页看看更多资料!如果觉得内容对你有帮助,别忘了给UP主一个一键三连哦~有什么问题或者想法,也欢迎在评论区留言交流,我们一起讨论,共同进步!

⛽⛽实战项目:有源码或者技术上的问题欢迎在评论区一起讨论交流!

⚡⚡如果遇到具体的技术问题或其他需求,你也可以问我,我会尽力帮你分析和解决问题所在,支持我记得一键三连,再点个关注,学习不迷路!~~