Windows 11 配置 CUDA 版 llama.cpp 并实现系统全局调用(GGUF 模型本地快速聊天)

前言

在本地快速部署大模型进行离线聊天,llama.cpp 是轻量化、高性能的首选工具,尤其是 CUDA 版本能充分利用 NVIDIA 显卡的算力,大幅提升模型推理速度。本文将详细记录在 Windows 11 系统中,从环境准备、CUDA 版 llama.cpp 配置,到实现系统全局调用、快速运行 GGUF 格式模型的完整步骤,全程基于实际操作验证,适配 RTX 3090 等 NVIDIA 显卡,新手也能轻松上手。

一、前置准备

1. 硬件要求

- 核心:NVIDIA 独立显卡(需支持 CUDA 12 或 13,算力 7.5 及以上,如 RTX 30/40/50 系列、TITAN 等,本文测试显卡为 RTX 3090 24G)

- 显存:根据模型大小选择,20B 4/3 量化模型建议 16G 及以上显存,7B 模型 8G 显存即可流畅运行

- 硬盘:预留足够空间存放 GGUF 格式模型(单模型文件通常 3-20G 不等)

2. 软件要求

- 操作系统:Windows 11 64 位(专业版 / 家庭版均可,本文版本 10.0.28020.1495)

- 显卡驱动:最新 NVIDIA 官方驱动(建议通过 GeForce Experience 或 NVIDIA 官网更新,保证 CUDA 兼容性)

- CUDA 工具包:需与 llama.cpp 版本匹配(本文使用 CUDA 13.1,llama.cpp 为 b7907 版本)

- 注:若未安装 CUDA,可从 NVIDIA 官网 下载对应版本,默认安装即可(无需手动配置环境变量,安装程序会自动添加)

3. 下载必备文件

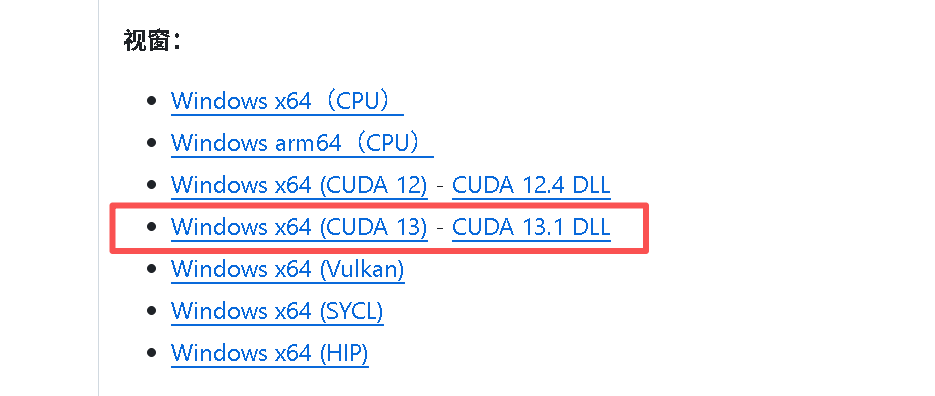

CUDA 版 llama.cpp 预编译包 :无需手动编译,直接下载官方预编译的 Windows 版本,推荐从 llama.cpp 官方发布页 下载,本文使用版本为 llama-b7907-bin-win-cuda-13.1-x64.zip(对应 CUDA 13.1,x64 架构)

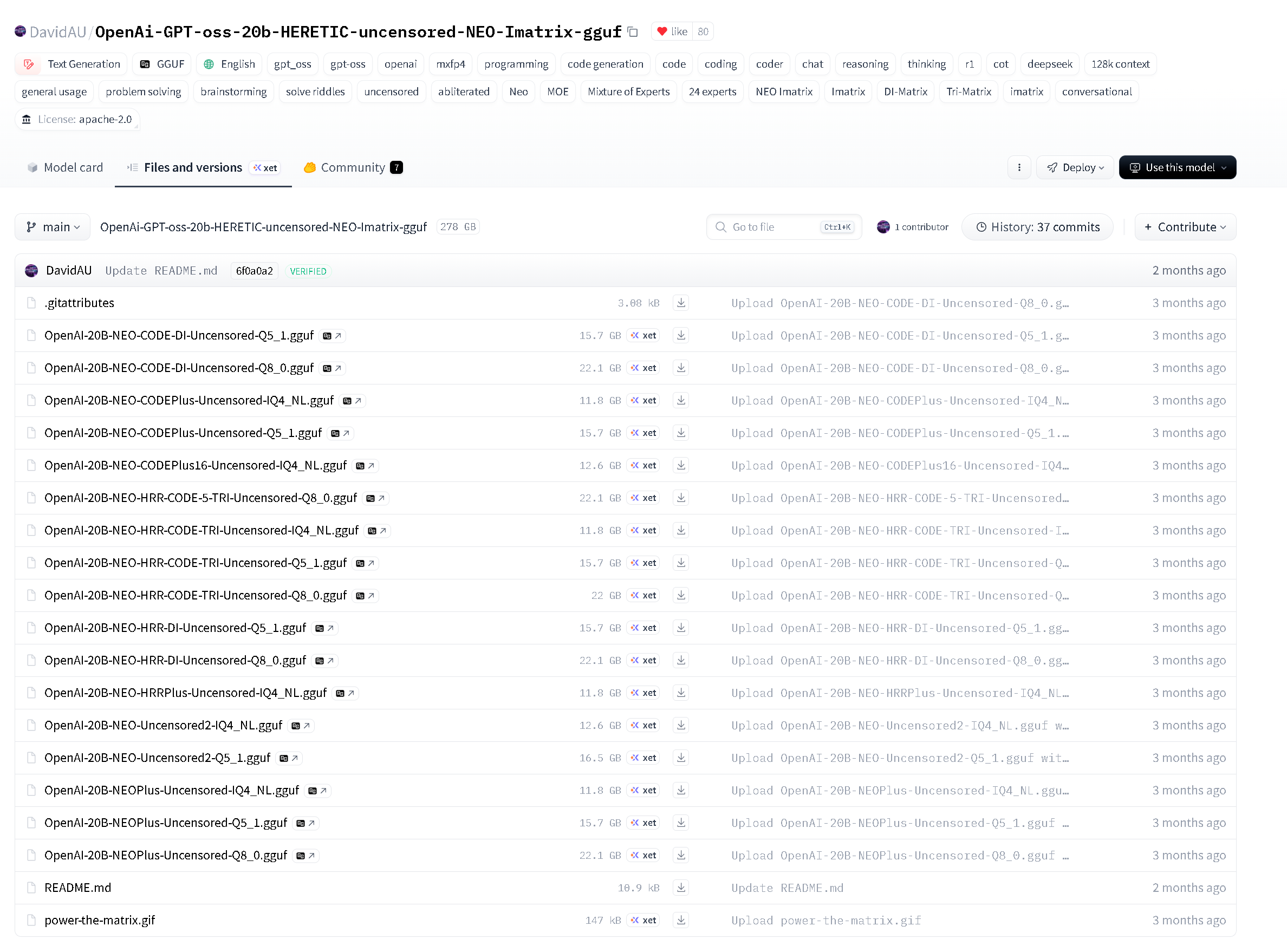

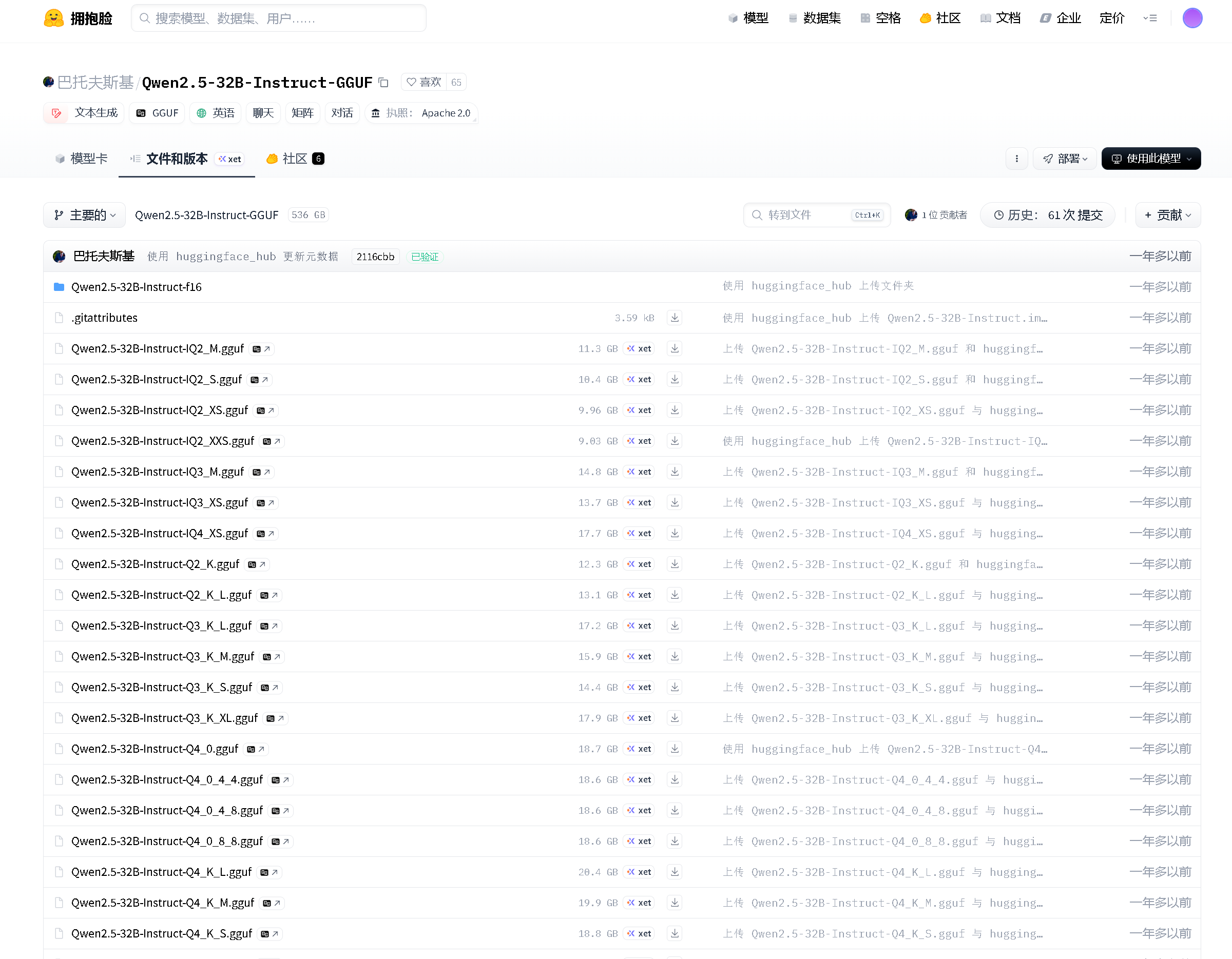

- GGUF 格式模型 :llama.cpp 仅支持 GGUF 格式模型,推荐从 Hugging Face、TheBloke 等仓库下载,本文测试模型为

gpt-oss-20b-base.Q3_K_L.gguf(3 量化,兼顾性能和显存)

- 注:选择模型时,优先匹配自身显存大小,量化等级(Q2_K-Q6_K)越高,效果越好但显存占用越大

部分 GGUF 格式 GPT 高性能开源模型示例

/

部分 GGUF 格式 Qwen 高性能开源模型示例

/

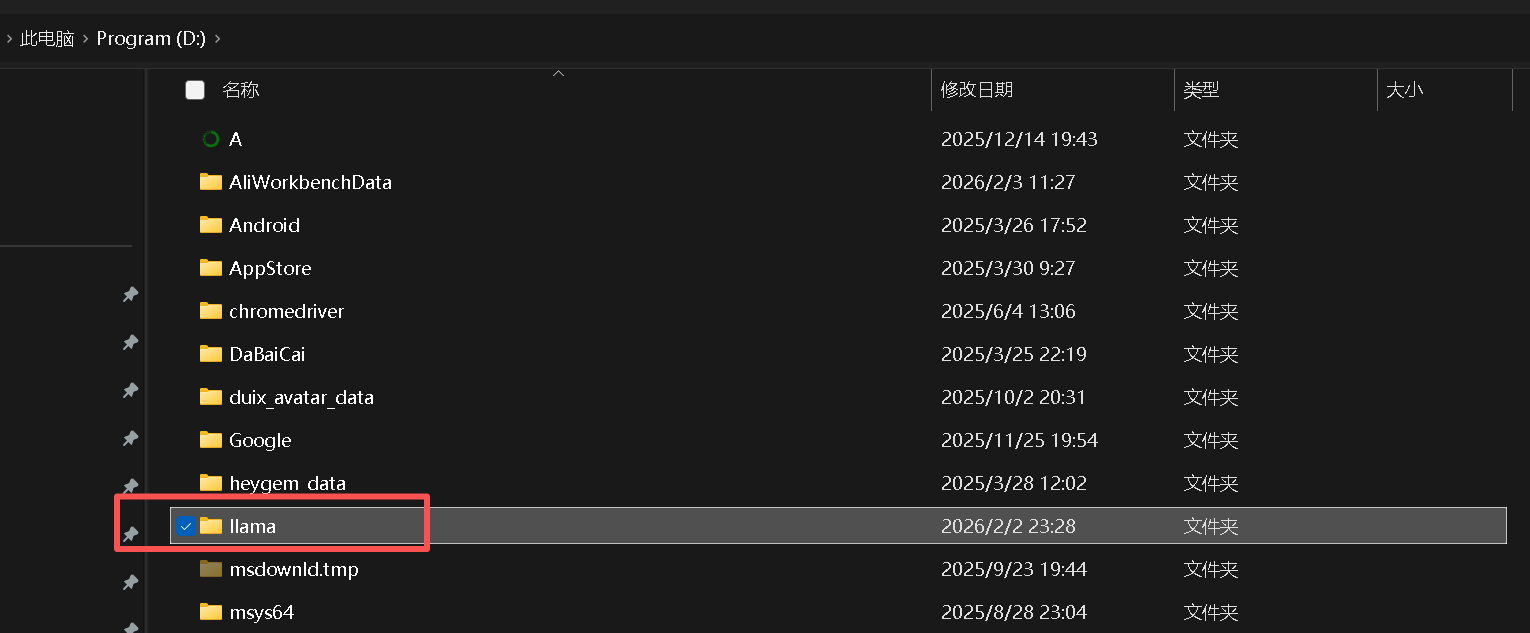

二、解压 llama.cpp 并整理目录

为了方便管理和后续全局调用,建议将 llama.cpp 解压到固定目录,避免路径含中文、空格(Windows 环境易出问题)。

- 解压下载的

llama-b7907-bin-win-cuda-13.1-x64.zip到自定义目录,本文选择D:\llama(核心目录,后续所有操作基于此) - 解压后目录包含核心文件:

llama-cli.exe(命令行聊天主程序)、ggml-cuda.dll(CUDA 加速核心库)、llama-server.exe(API 服务程序)等,无需额外修改文件结构

- 下载后解压成文件夹

- 解压后把文件夹移动到目标磁盘内

- 然后重命名文件夹为极简的名称(避免过多占用系统环境变量的字符数量)

三、配置系统环境变量,实现全局调用

这是实现「任意目录随时调用 llama-cli.exe」的关键步骤,配置后无需切换到 D:\llama 目录,在 CMD/PowerShell 任意路径下都能直接运行命令。

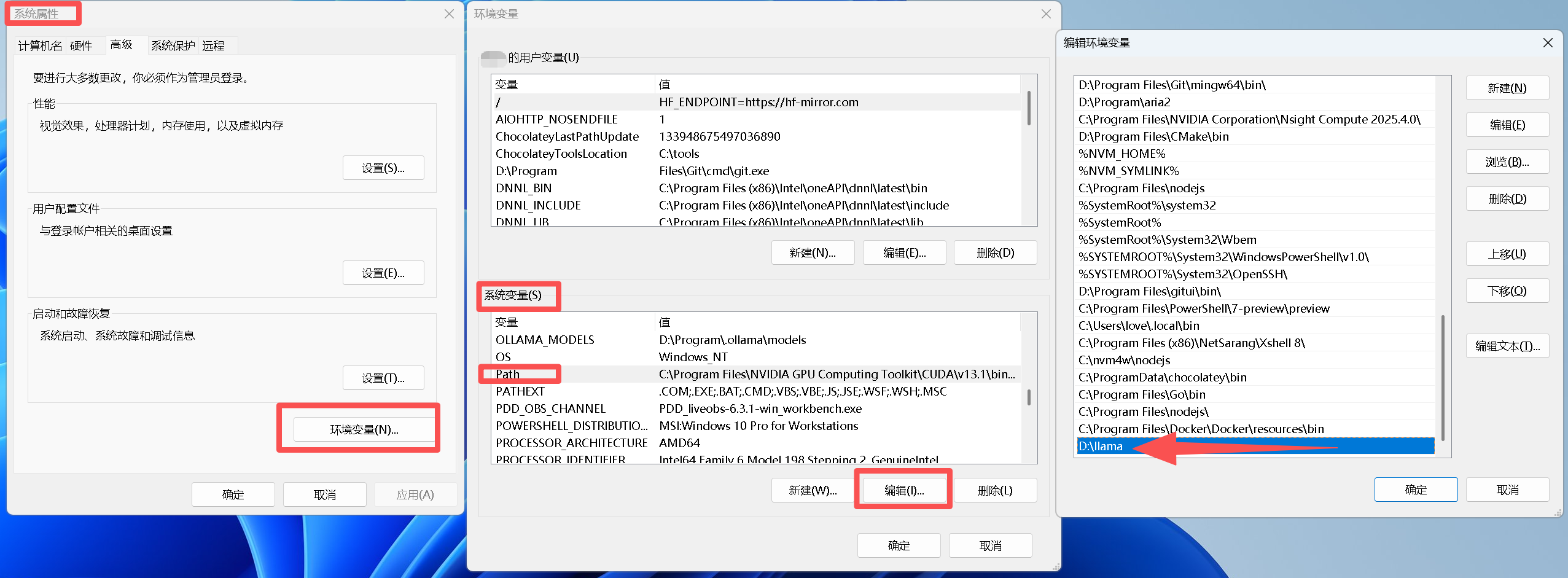

步骤 1:打开环境变量配置界面

- 按下

Win + R,输入sysdm.cpl,回车打开「系统属性」窗口 - 切换到「高级」选项卡,点击右下角「环境变量」按钮

步骤 2:添加 llama.cpp 目录到系统 Path

- 在「系统变量」列表中,找到并双击

Path变量(系统变量,不是用户变量,保证所有用户均可调用) - 点击「新建」,输入 llama.cpp 解压目录路径:

D:\llama(本文路径,根据自己的实际解压路径修改) - 点击「上移」,将该路径移到靠前位置(可选,上移位置的主要意图是避免路径冲突),依次点击「确定」保存所有设置

步骤 3:验证环境变量是否生效

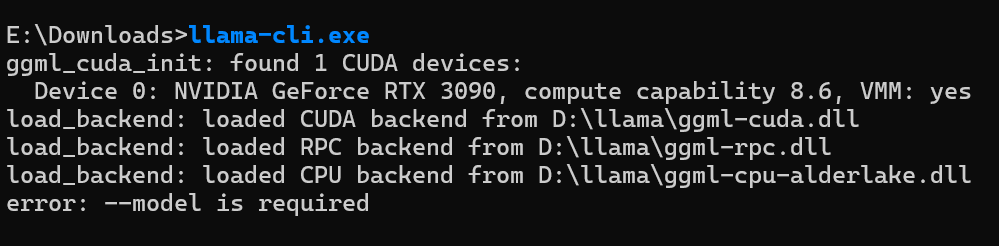

关键注意 :环境变量修改后,必须重启所有已打开的 CMD/PowerShell 窗口 ,或直接重启电脑(彻底生效,实测推荐)。验证步骤:

- 重启电脑后,打开任意 CMD/PowerShell 窗口(无需切换到 D:\llama 目录)

- 输入命令

where.exe llama-cli,若输出D:\llama\llama-cli.exe,说明环境变量配置成功; - 输入

llama-cli.exe,若提示error: --model is required,同时显示 CUDA 设备信息(如下),说明 CUDA 版 llama.cpp 全局调用已生效:

ggml_cuda_init: found 1 CUDA devices:

Device 0: NVIDIA GeForce RTX 3090, compute capability 8.6, VMM: yes

load_backend: loaded CUDA backend from D:\llama\ggml-cuda.dll四、快速运行 GGUF 模型,实现本地聊天

1. 模型存放建议

将下载的 GGUF 格式模型文件放到易查找的目录,建议单独建文件夹管理,如 E:\Downloads\LLM_Models,避免路径含中文、空格(本文测试模型路径:E:\Downloads\gpt-oss-20b-base.Q3_K_L.gguf)。

路径示例:

E:\Downloads\gpt-oss-20b-base.Q3_K_L.gguf

2. 核心运行命令

环境变量生效后,在任意目录的 CMD/PowerShell 中,输入以下命令即可启动模型聊天,核心参数说明 + 完整命令如下:

核心参数说明

-m:指定 GGUF 模型文件的完整路径(必填)-n:设置单次生成的最大令牌数(建议 2048/4096,根据模型上下文调整)--gpu-layers:设置加载到 GPU 显存的层数(核心!充分利用 CUDA 加速,RTX 3090 建议设 35+,显存较小的显卡可适当降低,如 16G 显存设 20-30)- 其他可选参数:

--temp 0.7(生成温度,越低越严谨,越高越灵活)、--ctx-size 4096(模型上下文窗口)

完整运行命令(直接复制使用,修改模型路径即可)

llama-cli.exe -m "模型文件路径" -n 2048 --gpu-layers 35

llama-cli.exe -m "E:\Downloads\gpt-oss-20b-base.Q3_K_L.gguf" -n 2048 --gpu-layers 35

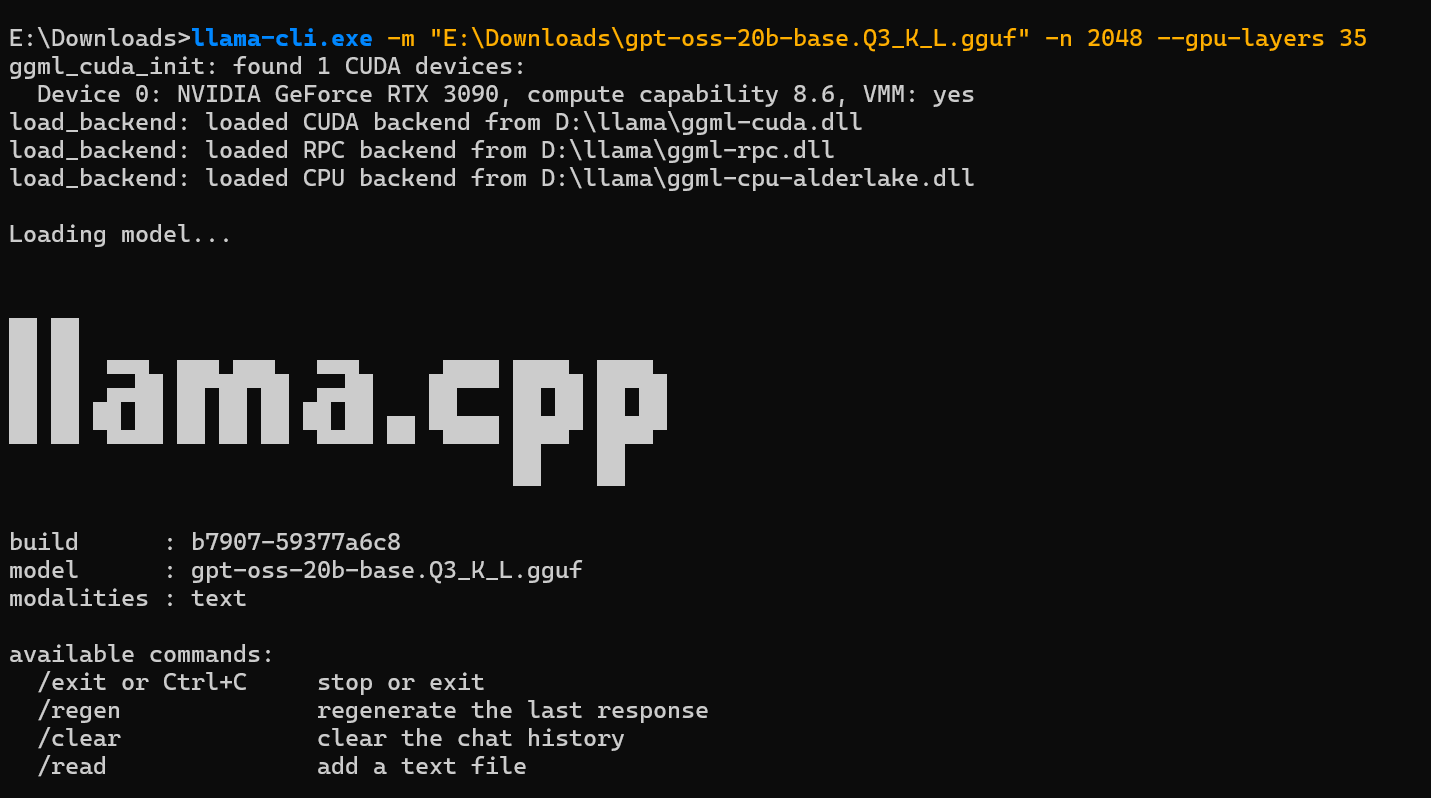

3. 运行成功验证

输入命令后,终端会依次显示:CUDA 设备加载 → 模型加载 → 出现 llama.cpp 标识和模型信息 → 进入聊天交互界面(> 提示符),如下即为成功:

Loading model...

build : b7907-59377a6c8

model : gpt-oss-20b-base.Q3_K_L.gguf

modalities : text

available commands:

/exit or Ctrl+C stop or exit

/regen regenerate the last response

/clear clear the chat history

> 你是哪个模型此时直接输入问题,回车即可得到模型的离线回复,推理速度会显示在回复下方(如 Prompt: 194.0 t/s | Generation: 203.3 t/s),CUDA 加速下速度会比纯 CPU 快 5-10 倍。

4. 常用交互命令

- 退出聊天:输入

/exit或按下Ctrl+C - 重新生成回复:输入

/regen(对当前问题的回复不满意时使用) - 清空聊天记录:输入

/clear - 导入文本文件:输入

/read 文本文件路径(让模型读取本地文本并基于此对话)

五、避坑指南(实际操作中遇到的问题及解决)

本文全程基于实际操作,整理了几个关键坑点,帮你少走弯路:

1. 「llama-cli.exe 不是内部或外部命令」

- 原因:环境变量未配置、配置后未重启终端 / 电脑、路径输入错误(含中文 / 空格)

- 解决:① 检查 Path 中是否为 llama.cpp 核心目录(如 D:\llama);② 重启所有终端或直接重启电脑;③ 目录路径全程无中文、无空格。

2. 输入 .\llama-cli.exe 报错,直接输入 llama-cli.exe 正常

- 原因:

./是 Linux/PowerShell 中「当前目录」的标识,CMD 中环境变量生效后,直接输入可执行文件名即可,无需加./ - 解决:全局调用时,直接输入

llama-cli.exe即可,无需加路径前缀。

3. CUDA 设备未找到,加载纯 CPU 运行

- 原因:显卡驱动过旧、CUDA 版本与 llama.cpp 不匹配、未安装 CUDA 工具包

- 解决:① 更新 NVIDIA 官方最新驱动;② 下载与 llama.cpp 预编译包匹配的 CUDA 版本(如本文 CUDA 13.1 对应 llama.cpp cuda-13.1 版本);③ 确认 CUDA 安装成功(CMD 输入

nvcc -V可查看版本)。

4. 模型加载失败,提示「文件格式错误」

- 原因:下载的模型不是 GGUF 格式(llama.cpp 已放弃支持旧的 GGML 格式)

- 解决:重新下载 GGUF 格式模型,优先选择 TheBloke 仓库(量化模型最全、最稳定)。

5. 运行时显存不足,提示「out of memory」

- 原因:模型量化等级过高、

--gpu-layers设置过大、同时运行其他占用显存的程序 - 解决:① 更换更低量化等级的模型(如 Q3_K_L 替换为 Q2_K);② 降低

--gpu-layers参数值;③ 关闭显卡占用高的程序(如原神、Pr、AE 等)。

六、进阶优化(提升使用体验)

1. 制作批处理文件,双击启动模型

每次输入长命令太麻烦?创建 .bat 批处理文件,双击即可启动聊天,步骤如下:

- 右键桌面 → 新建 → 文本文档,重命名为

run_llama.bat(后缀改为.bat,需显示文件后缀) - 用记事本打开,输入以下内容(修改模型路径为自己的):

bat

@echo off

echo 正在启动 CUDA 版 llama.cpp,加载模型中...

llama-cli.exe -m "E:\Downloads\gpt-oss-20b-base.Q3_K_L.gguf" -n 2048 --gpu-layers 35

pause- 保存后,双击该批处理文件,即可自动启动模型,无需手动打开终端输入命令。

2. 统一管理模型和批处理文件

- 在

D:\llama下新建Models文件夹,将所有 GGUF 模型放到此处,方便管理; - 将批处理文件放到桌面,同时在批处理中修改模型路径为

D:\llama\Models\xxx.gguf,避免模型路径混乱。

3. 尝试 llama-server 开启 API 服务

llama.cpp 还支持开启 API 服务,让其他程序(如 Web 界面、机器人)调用本地模型,命令如下:

llama-server.exe -m "E:\Downloads\gpt-oss-20b-base.Q3_K_L.gguf" --gpu-layers 35 --port 8080启动后,通过 http://localhost:8080 即可访问 API,实现更灵活的二次开发。

4. 利用 AI 开发 Gradio WebUI 界面,快速搭建模型交互界面服务。

七、总结

本文完成了 Windows 11 系统中 CUDA 版 llama.cpp 的全流程配置:从前置环境准备、CUDA 版预编译包解压,到系统环境变量配置实现全局调用,再到快速运行 GGUF 模型、避坑优化,全程基于实际操作,所有命令和步骤均经过验证,RTX 3090 显卡下可流畅运行 20B 量化模型,本地离线聊天无网络依赖、速度快。

llama.cpp 的优势在于轻量化、跨平台、CUDA 加速适配友好,无需复杂的 Python 环境配置,预编译包解压即可用,配合 GGUF 格式的量化模型,普通 NVIDIA 显卡也能实现本地大模型部署。后续可尝试不同大小、不同量化等级的模型,调整 --gpu-layers、--temp 等参数,找到最适合自己硬件的配置。

至此,你已经拥有了一个可全局调用、CUDA 加速的本地大模型聊天工具,尽情探索离线大模型的乐趣吧!