文章目录

- 第01章:LangChain使用概述

-

- [1、介绍 LangChain](#1、介绍 LangChain)

-

- [1.1 什么是 LangChain](#1.1 什么是 LangChain)

- [1.2 有哪些大模型应用开发框架呢?](#1.2 有哪些大模型应用开发框架呢?)

- [1.3 为什么需要 LangChain?](#1.3 为什么需要 LangChain?)

- [1.4 LangChain的使用场景](#1.4 LangChain的使用场景)

- [1.5 LangChain资料介绍](#1.5 LangChain资料介绍)

- [1.6 架构设计](#1.6 架构设计)

- 2、开发前的准备工作

-

- [2.1 前置知识](#2.1 前置知识)

- [2.2 相关环境安装](#2.2 相关环境安装)

- 3、大模型应用开发

-

- [3.1 基于RAG架构的开发](#3.1 基于RAG架构的开发)

- [3.2 基于Agent架构的开发](#3.2 基于Agent架构的开发)

- [3.3 大模型应用开发的4个场景](#3.3 大模型应用开发的4个场景)

- 4、LangChain的核心组件

-

- [4.1 一个问题引发的思考](#4.1 一个问题引发的思考)

- [4.2 核心组件的概述](#4.2 核心组件的概述)

- [4.3 核心组件的说明](#4.3 核心组件的说明)

-

- [**核心组件1:Model I/O**](#核心组件1:Model I/O)

- **核心组件2:Chains**

- **核心组件3:Memory**

- **核心组件4:Agents**

- **核心组件5:Retrieval**

- **核心组件6:Callbacks**

- [4.4 小结](#4.4 小结)

- 5、LangChain的helloworld

-

- [5.1 获取大模型](#5.1 获取大模型)

- [5.2 使用提示词模板](#5.2 使用提示词模板)

- [5.3 使用输出解析器](#5.3 使用输出解析器)

- [5.4 使用向量存储](#5.4 使用向量存储)

- [5.5 RAG(检索增强生成)](#5.5 RAG(检索增强生成))

- [5.6 使用Agent](#5.6 使用Agent)

- [第02章:LangChain使用之Model I/O](#第02章:LangChain使用之Model I/O)

-

- [1、Model I/O介绍](#1、Model I/O介绍)

- [2、Model I/O之调用模型1](#2、Model I/O之调用模型1)

-

- [2.1 模型的不同分类方式](#2.1 模型的不同分类方式)

- [2.2 角度1出发:按照功能不同举例](#2.2 角度1出发:按照功能不同举例)

-

- 类型1:LLMs (非对话模型)

- [类型2:Chat Models (对话模型)](#类型2:Chat Models (对话模型))

- [类型3:Embedding Model (嵌入模型)](#类型3:Embedding Model (嵌入模型))

- [2.3 角度2出发:参数位置不同举例](#2.3 角度2出发:参数位置不同举例)

-

- [2.3.1 模型调用的主要方法及参数](#2.3.1 模型调用的主要方法及参数)

- [2.3.2 模型调用推荐平台:closeai](#2.3.2 模型调用推荐平台:closeai)

- [2.3.3 方式1:硬编码](#2.3.3 方式1:硬编码)

- [2.3.4 方式2:配置环境变量](#2.3.4 方式2:配置环境变量)

- [2.3.5 方式3:使用.env配置文件 (推荐)](#2.3.5 方式3:使用.env配置文件 (推荐))

- [2.4 角度3出发:各平台API的调用举例(了解)](#2.4 角度3出发:各平台API的调用举例(了解))

-

- [2.4.1 OpenAI 官方API](#2.4.1 OpenAI 官方API)

- [2.4.2 百度千帆平台](#2.4.2 百度千帆平台)

- [2.4.3 阿里云百炼平台](#2.4.3 阿里云百炼平台)

- [2.4.4 智谱的GLM](#2.4.4 智谱的GLM)

- [2.4.5 硅基流动平台](#2.4.5 硅基流动平台)

- [2.5 如何选择合适的大模型](#2.5 如何选择合适的大模型)

-

- [2.5.1 有没有最好的大模型](#2.5.1 有没有最好的大模型)

- [2.5.2 小结:获取大模型的标准方式](#2.5.2 小结:获取大模型的标准方式)

- [3、Model I/O之调用模型2](#3、Model I/O之调用模型2)

-

- [3.1 关于对话模型的Message(消息)](#3.1 关于对话模型的Message(消息))

- [3.2 关于多轮对话与上下文记忆](#3.2 关于多轮对话与上下文记忆)

- [3.3 关于模型调用的方法](#3.3 关于模型调用的方法)

-

- [3.3.1 流式输出与非流式输出](#3.3.1 流式输出与非流式输出)

- [3.3.2 批量调用](#3.3.2 批量调用)

- [3.3.3 同步调用与异步调用 (了解)](#3.3.3 同步调用与异步调用 (了解))

- [4、Model I/O之Prompt Template](#4、Model I/O之Prompt Template)

-

- [4.1 介绍与分类](#4.1 介绍与分类)

- [4.2 复习:str.format()](#4.2 复习:str.format())

- [4.3 具体使用:PromptTemplate](#4.3 具体使用:PromptTemplate)

-

- [4.3.1 使用说明](#4.3.1 使用说明)

- [4.3.2 两种实例化方式](#4.3.2 两种实例化方式)

- [4.3.3 两种新的结构形式](#4.3.3 两种新的结构形式)

- [4.3.4 format()与invoke()](#4.3.4 format()与invoke())

- [4.3.5 结合LLM调用](#4.3.5 结合LLM调用)

- [4.4 具体使用:ChatPromptTemplate](#4.4 具体使用:ChatPromptTemplate)

-

- [4.4.1 使用说明](#4.4.1 使用说明)

- [4.4.2 两种实例化方式](#4.4.2 两种实例化方式)

- [4.4.3 模板调用的几种方式对比](#4.4.3 模板调用的几种方式对比)

- [4.4.4 更丰富的实例化参数类型](#4.4.4 更丰富的实例化参数类型)

- [4.4.5 结合LLM](#4.4.5 结合LLM)

- [4.4.6 插入消息列表:MessagesPlaceholder](#4.4.6 插入消息列表:MessagesPlaceholder)

- [4.5 具体使用:少量样本示例的提示词模板 (Few-Shot)](#4.5 具体使用:少量样本示例的提示词模板 (Few-Shot))

-

- [4.5.1 使用说明](#4.5.1 使用说明)

- [4.5.2 FewShotPromptTemplate的使用](#4.5.2 FewShotPromptTemplate的使用)

- [4.5.3 FewShotChatMessagePromptTemplate的使用](#4.5.3 FewShotChatMessagePromptTemplate的使用)

- [4.5.4 Example selectors (示例选择器)](#4.5.4 Example selectors (示例选择器))

- [4.6 具体使用:PipelinePromptTemplate(了解)](#4.6 具体使用:PipelinePromptTemplate(了解))

- [4.7 具体使用:自定义提示词模版(了解)](#4.7 具体使用:自定义提示词模版(了解))

- [4.8 从文档中加载Prompt(了解)](#4.8 从文档中加载Prompt(了解))

-

- [4.8.1 yaml格式提示词](#4.8.1 yaml格式提示词)

- [4.8.2 json格式提示词](#4.8.2 json格式提示词)

- [5、Model I/O之Output Parsers](#5、Model I/O之Output Parsers)

-

- [5.1 输出解析器的分类](#5.1 输出解析器的分类)

- [5.2 具体解析器的使用](#5.2 具体解析器的使用)

-

- [① 字符串解析器 StrOutputParser](#① 字符串解析器 StrOutputParser)

- [② JSON解析器 JsonOutputParser](#② JSON解析器 JsonOutputParser)

- [③ XML解析器 XMLOutputParser](#③ XML解析器 XMLOutputParser)

- [④ 列表解析器 CommaSeparatedListOutputParser](#④ 列表解析器 CommaSeparatedListOutputParser)

- [⑤ 日期解析器 DatetimeOutputParser (了解)](#⑤ 日期解析器 DatetimeOutputParser (了解))

- 6、LangChain调用本地模型

-

- [6.1 Ollama的介绍](#6.1 Ollama的介绍)

- [6.2 Ollama的下载-安装](#6.2 Ollama的下载-安装)

- [6.3 模型的下载-安装](#6.3 模型的下载-安装)

- [6.4 调用本地私有模型](#6.4 调用本地私有模型)

- 第03章:LangChain使用之Chains

-

- 1、Chains的基本使用

-

- [1.1 Chain的基本概念](#1.1 Chain的基本概念)

- [1.2 LCEL及其基本构成](#1.2 LCEL及其基本构成)

- [1.3 Runnable](#1.3 Runnable)

- [1.4 使用举例](#1.4 使用举例)

- 2、传统Chain的使用

-

- [2.1 基础链:LLMChain](#2.1 基础链:LLMChain)

-

- [2.1.1 使用说明](#2.1.1 使用说明)

- [2.1.2 主要步骤](#2.1.2 主要步骤)

- [2.1.3 参数说明](#2.1.3 参数说明)

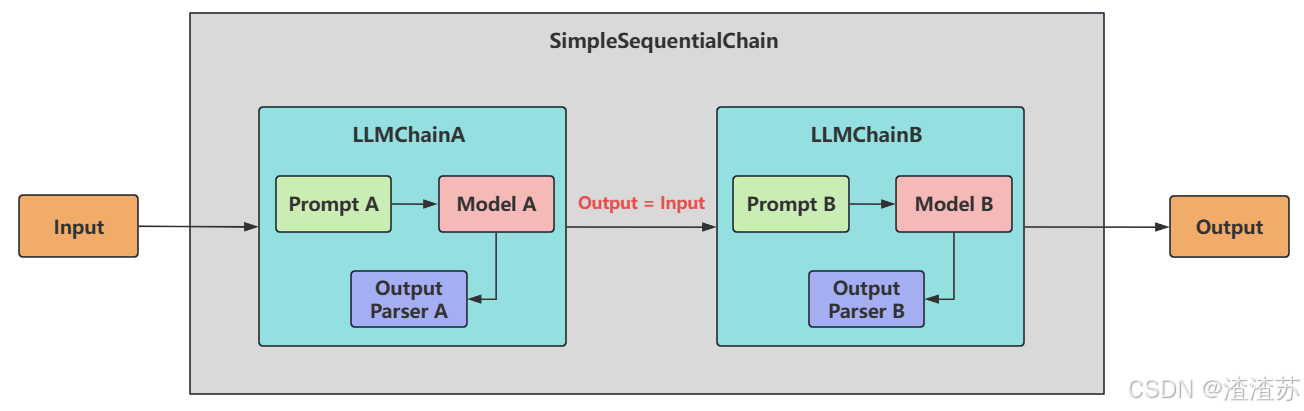

- [2.2 顺序链之 SimpleSequentialChain](#2.2 顺序链之 SimpleSequentialChain)

-

- [2.2.1 说明](#2.2.1 说明)

- [2.2.2 使用举例](#2.2.2 使用举例)

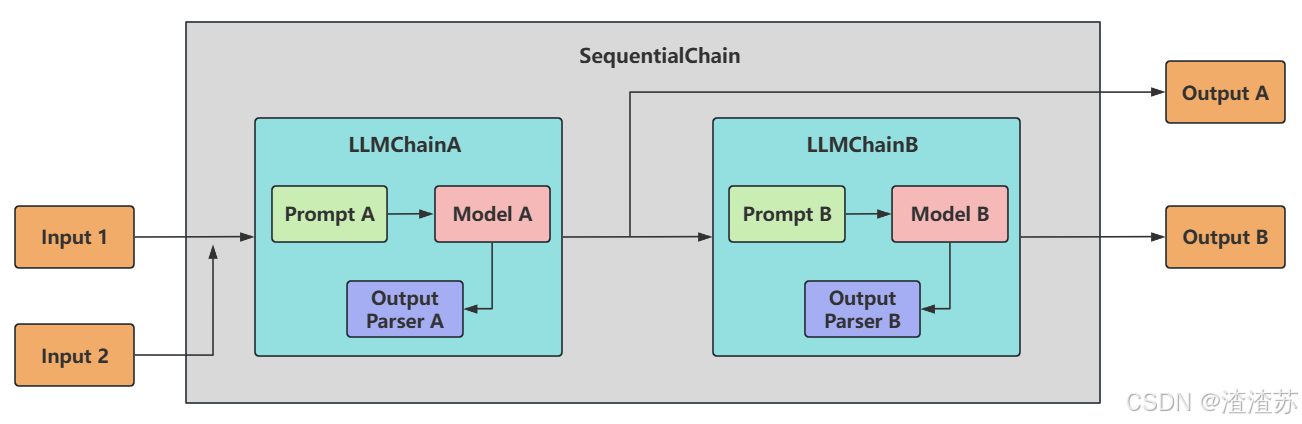

- [2.3 顺序链之 SequentialChain](#2.3 顺序链之 SequentialChain)

-

- [2.3.1 说明](#2.3.1 说明)

- [2.3.2 使用举例](#2.3.2 使用举例)

- 第04章:LangChain使用之Memory

-

- 1、Memory概述

-

- [1.1 为什么需要Memory](#1.1 为什么需要Memory)

- [1.2 什么是Memory](#1.2 什么是Memory)

- [1.3 Memory的设计理念](#1.3 Memory的设计理念)

- [1.4 不使用Memory模块,如何拥有记忆?](#1.4 不使用Memory模块,如何拥有记忆?)

- 2、基础Memory模块的使用

-

- [2.1 Memory模块的设计思路](#2.1 Memory模块的设计思路)

- [2.2 ChatMessageHistory(基础)](#2.2 ChatMessageHistory(基础))

- [2.3 ConversationBufferMemory](#2.3 ConversationBufferMemory)

- [2.4 ConversationChain](#2.4 ConversationChain)

- [2.5 ConversationBufferWindowMemory](#2.5 ConversationBufferWindowMemory)

- 3、其他Memory模块

-

- [3.1 ConversationTokenBufferMemory](#3.1 ConversationTokenBufferMemory)

- [3.2 ConversationSummaryMemory](#3.2 ConversationSummaryMemory)

- [3.3 ConversationSummaryBufferMemory](#3.3 ConversationSummaryBufferMemory)

- [3.4 ConversationEntityMemory(了解)](#3.4 ConversationEntityMemory(了解))

- [3.5 ConversationKGMemory(了解)](#3.5 ConversationKGMemory(了解))

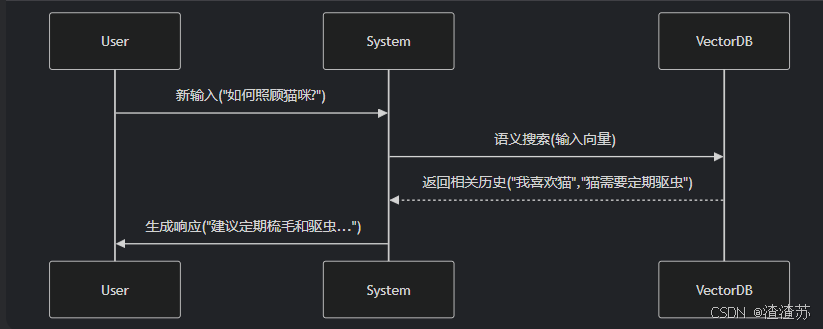

- [3.6 VectorStoreRetrieverMemory(了解)](#3.6 VectorStoreRetrieverMemory(了解))

- 第05章:LangChain使用之Tools

- 第06章:LangChain使用之Agents

-

- 1、理解Agents

-

- [1.1 Agent与Chain的区别](#1.1 Agent与Chain的区别)

- [1.2 什么是Agent](#1.2 什么是Agent)

- [1.3 Agent的核心能力/组件](#1.3 Agent的核心能力/组件)

- [1.4 举例](#1.4 举例)

- [1.5 明确几个组件](#1.5 明确几个组件)

- 2、Agent入门使用

-

- [2.1 Agent、AgentExecutor的创建](#2.1 Agent、AgentExecutor的创建)

- [2.2 Agent的类型](#2.2 Agent的类型)

-

- [2.2.1 FUNCATION_CALL模式](#2.2.1 FUNCATION_CALL模式)

- [2.2.2 ReAct模式](#2.2.2 ReAct模式)

- [Agent 两种典型类型对比表](#Agent 两种典型类型对比表)

- [2.3 AgentExecutor创建方式](#2.3 AgentExecutor创建方式)

- [2.4 小结](#2.4 小结)

- 3、Agent中工具的使用

-

- [3.1 传统方式](#3.1 传统方式)

- [3.2 通用方式](#3.2 通用方式)

- 4、Agent嵌入记忆组件

-

- [4.1 传统方式](#4.1 传统方式)

- [4.2 通用方式](#4.2 通用方式)

第01章:LangChain使用概述

1、介绍 LangChain

1.1 什么是 LangChain

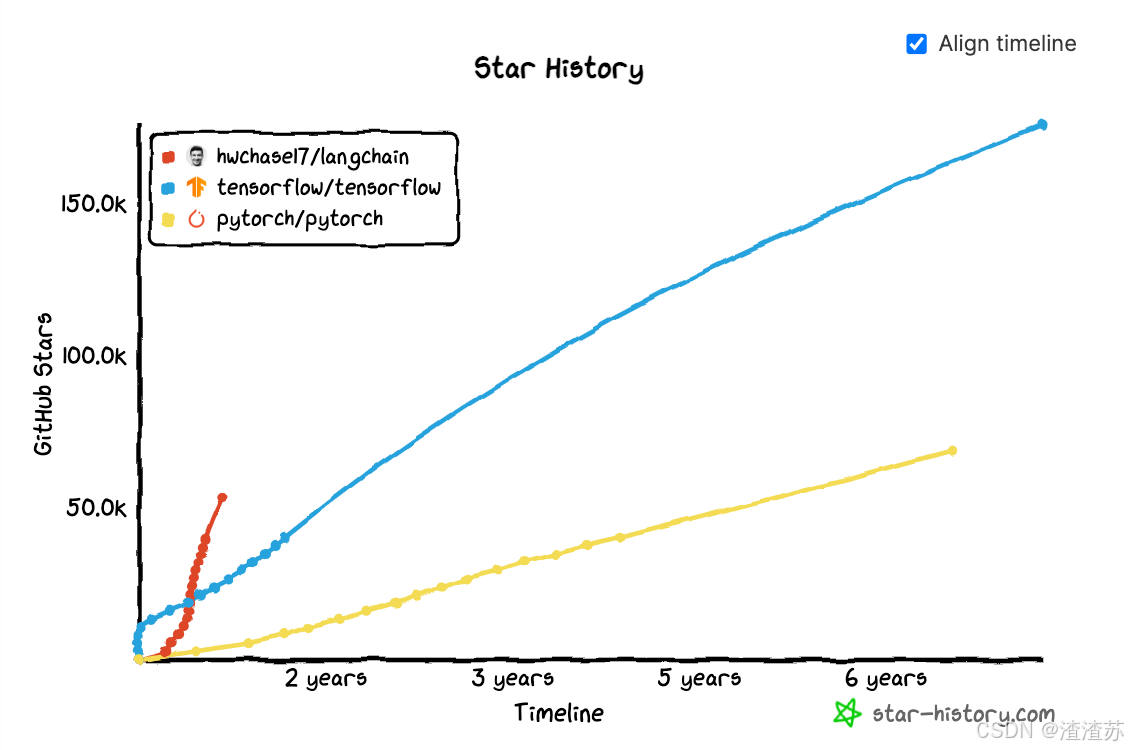

LangChain 是 2022年10月,由哈佛大学的 Harrison Chase (哈里森·蔡斯)发起研发的一个开源框架,用于开发由大语言模型(LLMs)驱动的应用程序。比如,搭建"智能体"(Agent)、问答系统(QA)、对话机器人、文档搜索系统、企业私有知识库等。

LangChain在Github上的热度变化

LangChain在Github上的star

https://github.com/langchain-ai/langchain

简单概括:

- LangChain ≠ LLMs

- LangChain之于 LLMs,类似 Spring之于 Java。

- LangChain之于 LLMs,类似 Django、Flask之于 Python。

顾名思义,LangChain中的"Lang"是指 language,即大语言模型,"Chain"即"链",也就是将大模型与外部数据&各种组件连接成链,以此构建AI应用程序。

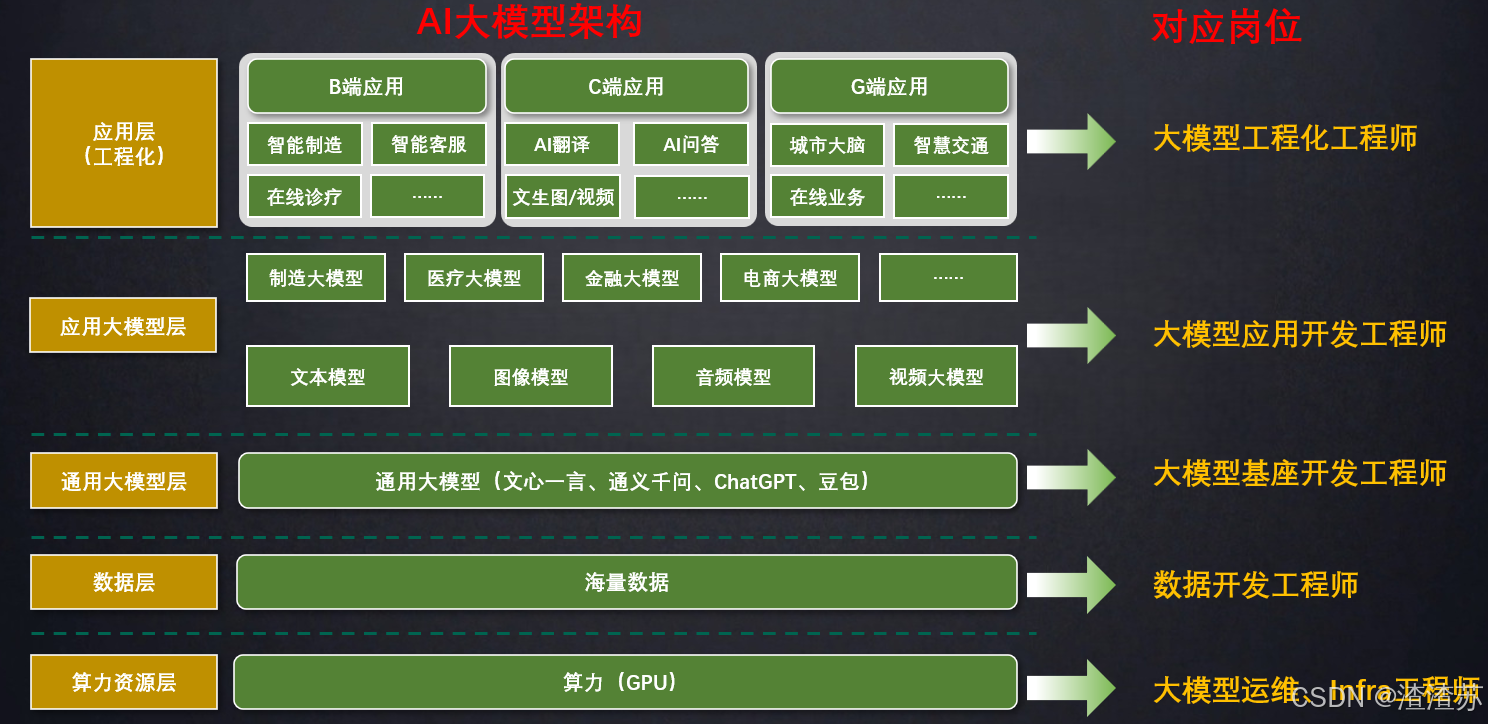

大模型相关的岗位

应用开发是大模型最值得关注的方向:应用为王! 学习LangChain框架,高效开发大模型应用。

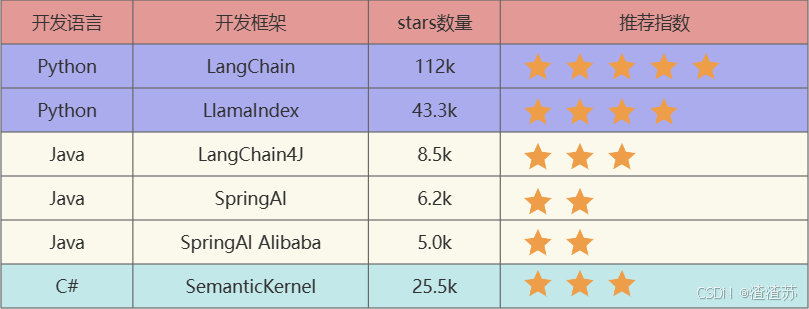

1.2 有哪些大模型应用开发框架呢?

截止到2025年7月26日,GitHub统计数据:

- LangChain:这些工具里出现最早、最成熟的,适合复杂任务分解和单智能体应用。

- LlamaIndex:专注于高效的索引和检索,适合 RAG场景。(注意不是Meta开发的)

- LangChain4J:LangChain还出了Java、JavaScript(LangChain.js)两个语言的版本,LangChain4j的功能略少于LangChain,但是主要的核心功能都是有的。

- SpringAI/SpringAI Alibaba:有待进一步成熟,此外只是简单的对于一些接口进行了封装。

- SemanticKernel:也称为sk,微软推出的,对于C#同学来说,那就是5颗星。

1.3 为什么需要 LangChain?

问题1:LLMs用的好好的,干嘛还需要LangChain?

在大语言模型(LLM)如 ChatGPT、Claude、DeepSeek等快速发展的今天,开发者不仅希望能"使用"这些模型,还希望能将它们灵活集成到自己的应用中,实现更强大的对话能力、检索增强生成(RAG)、工具调用(Tool Calling)、多轮推理等功能。

LangChain为更方便解决这些问题,而生的。比如:大模型默认不能联网,如果需要联网,用langchain。

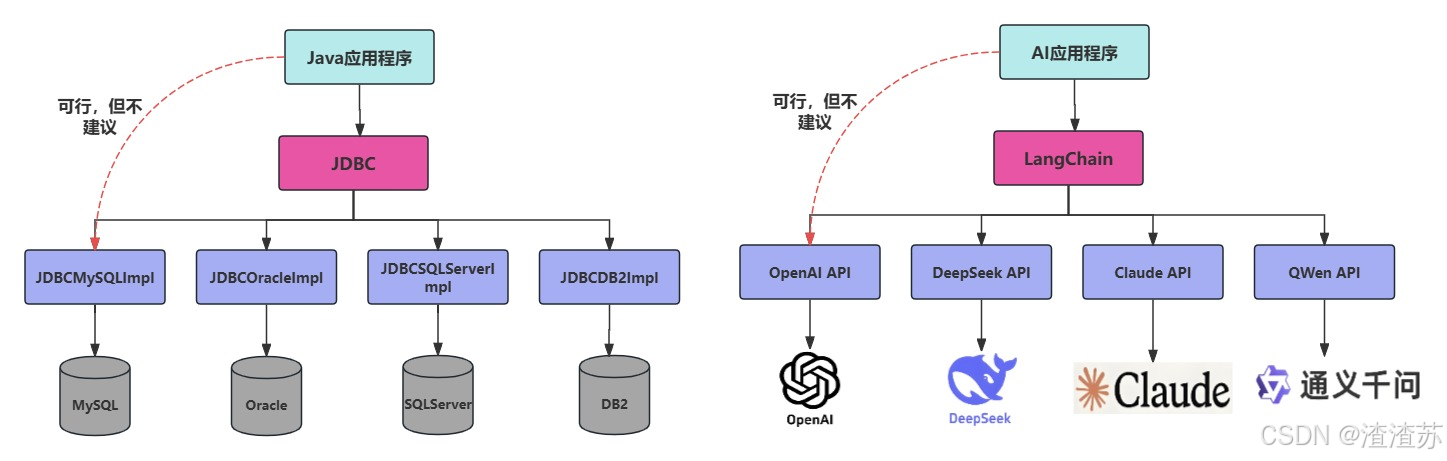

问题2:我们可以使用GPT或GLM4等模型的API进行开发,为何需要LangChain这样的框架?

不使用LangChain,确实可以使用GPT或GLM4等模型的API进行开发。比如,搭建"智能体"(Agent)、问答系统、对话机器人等复杂的 LLM应用。但使用LangChain的好处:

- 简化开发难度:更简单、更高效、效果更好。

- 学习成本更低:不同模型的API不同,调用方式也有区别,切换模型时学习成本高。使用LangChain,可以以统一、规范的方式进行调用,有更好的移植性。

- 现成的链式组装 :LangChain提供了一些现成的链式组装,用于完成特定的高级任务。让复杂的逻辑变得结构化、易组合、易扩展。

问题3:LangChain提供了哪些功能呢?

LangChain是一个帮助你构建 LLM应用的全套工具集。这里涉及到prompt构建、LLM接入、记忆管理、工具调用、RAG、智能体开发等模块。

学习 LangChain最好的方式就是做项目。

1.4 LangChain的使用场景

学完LangChain,如下类型的项目,大家都可以实现:

| 项目名称 | 技术点 | 难度 |

|---|---|---|

| 文档问答助手 | Prompt+ Embedding+ RetrievalQA | ⭐⭐ |

| 智能日程规划助手 | Agent+ Tool+ Memory | ⭐⭐⭐ |

| LLM+数据库问答 | SQLDatabaseToolkit+ Agent | ⭐⭐⭐⭐ |

| 多模型路由对话系统 | RouterChain+多 LLM | ⭐⭐⭐⭐ |

| 互联网智能客服 | ConversationChain+ RAG+Agent | ⭐⭐⭐⭐⭐ |

| 企业知识库助手(RAG+本地模型) | VectorDB+ LLM+ Streamlit | ⭐⭐⭐⭐⭐ |

-

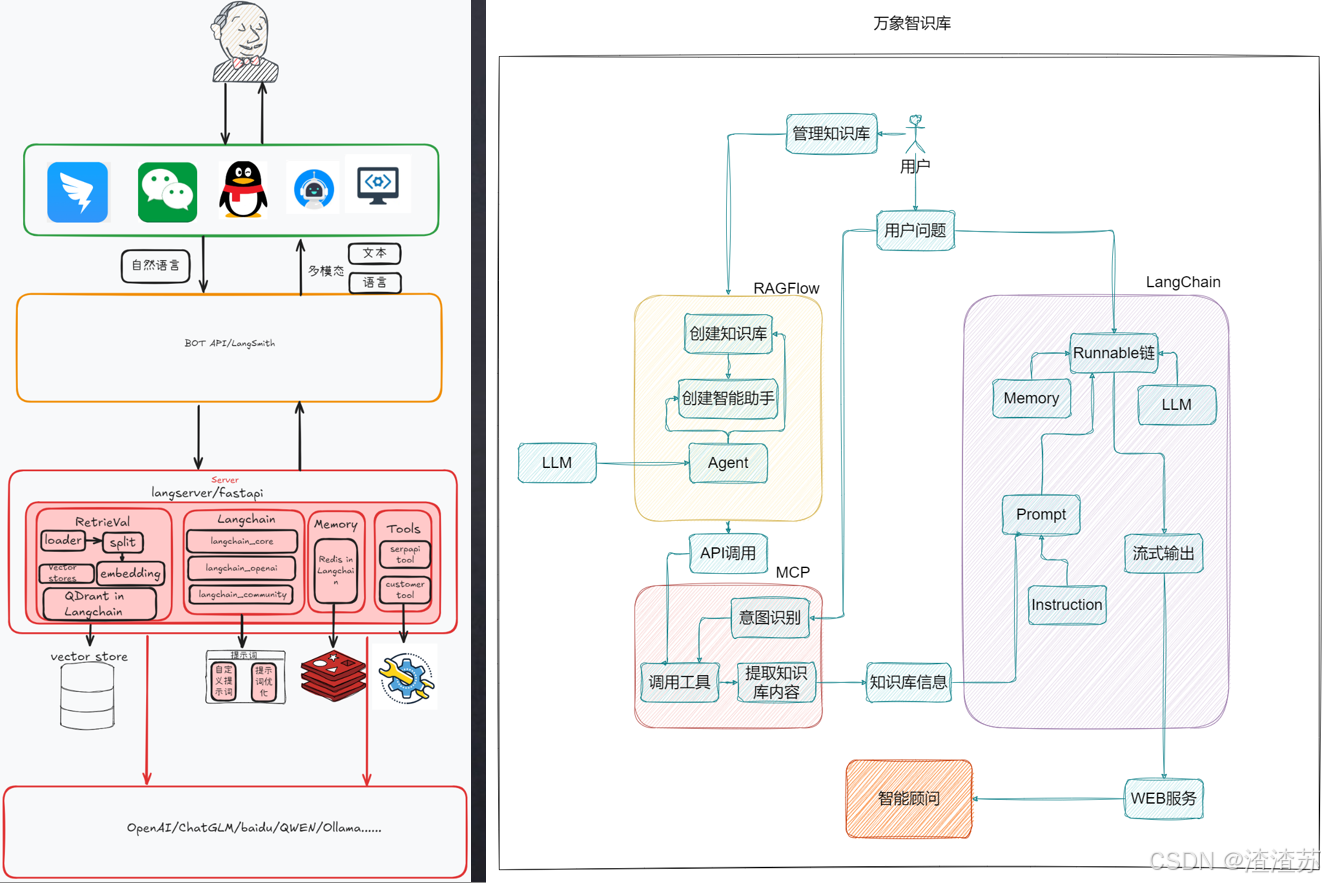

比如:医院智能助手

-

比如:万象知识库

-

比如:京东助手

LangChain的位置:

1.5 LangChain资料介绍

- 官网地址:https://www.langchain.com/langchain

- 官网文档:https://python.langchain.com/docs/introduction/

- API文档:https://python.langchain.com/api_reference/

- github地址:https://github.com/langchain-ai/langchain

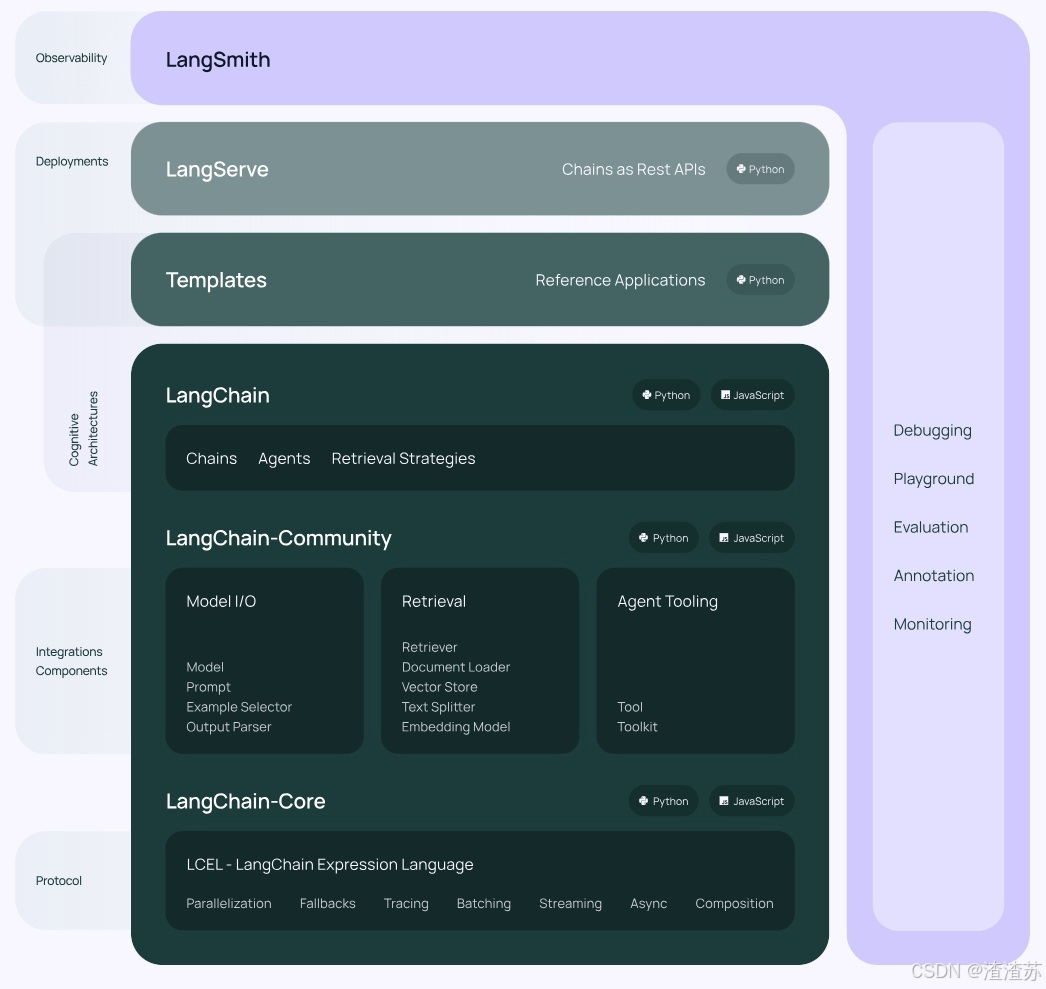

1.6 架构设计

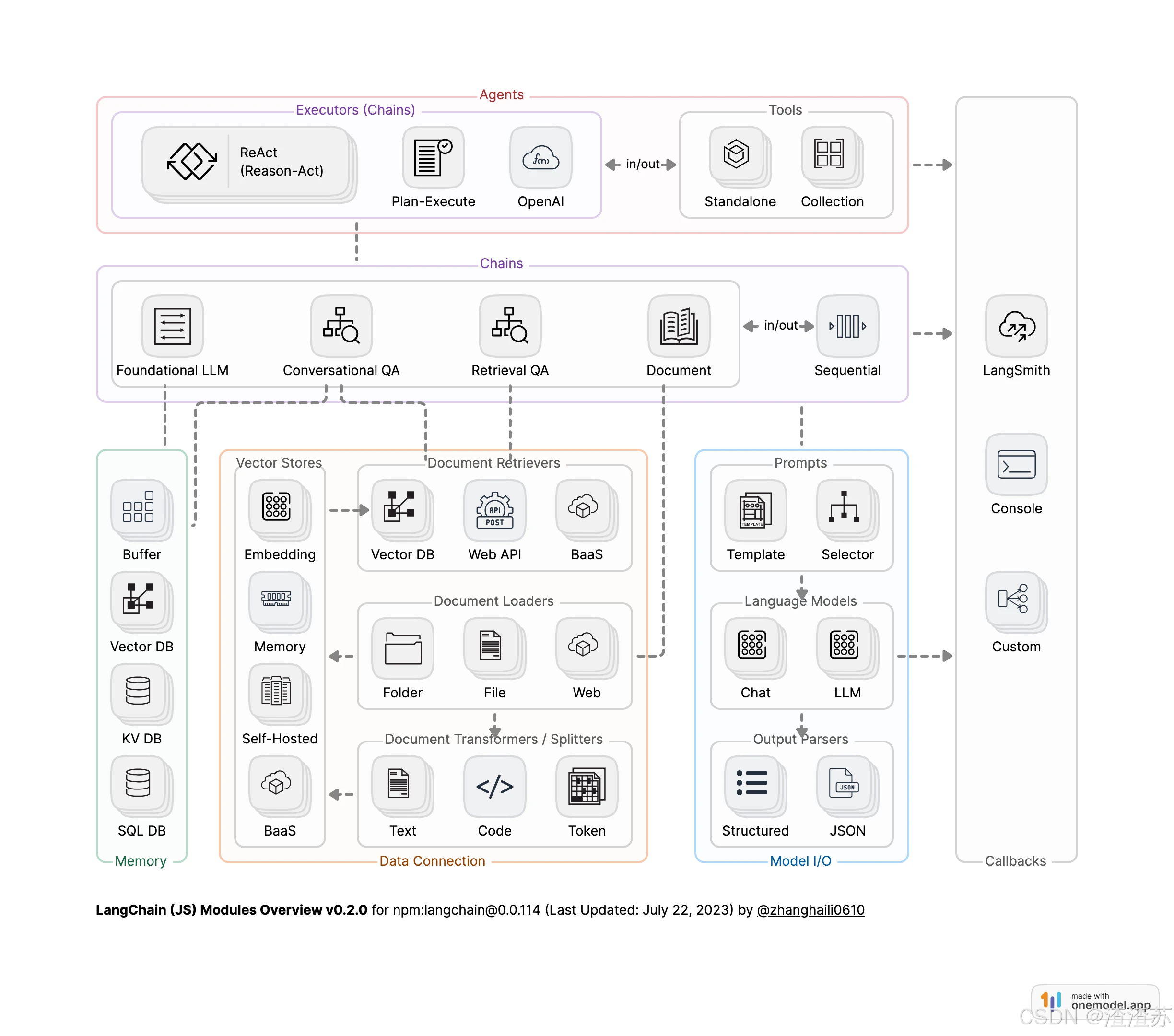

1.6.1 总体架构图

-

V0.1版本

-

V0.2/ V0.3版本

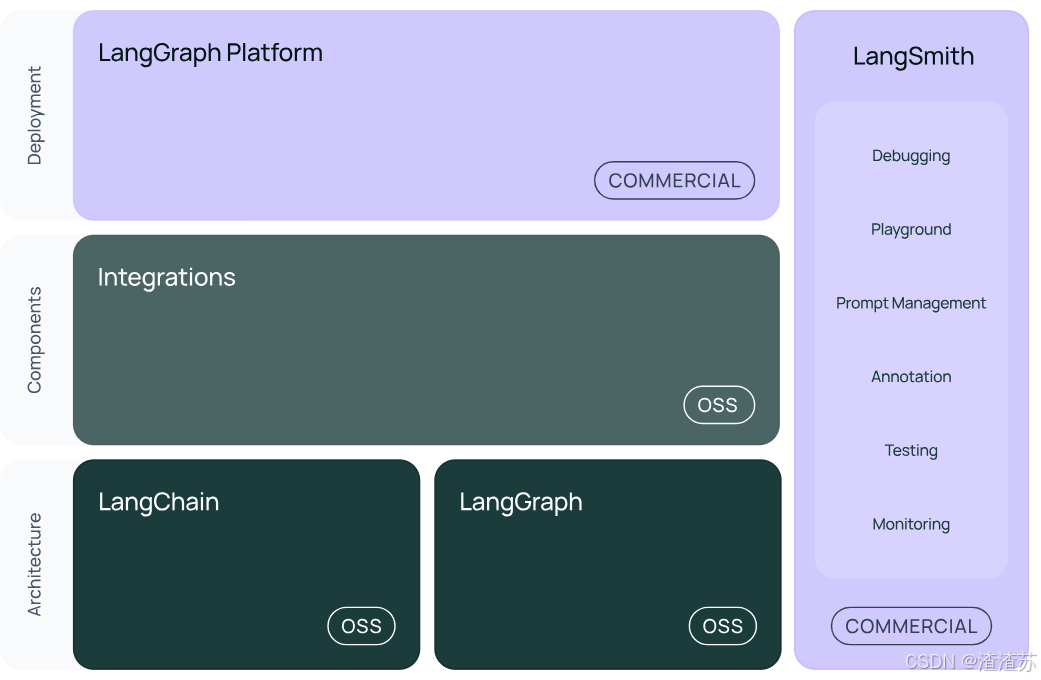

图中展示了LangChain生态系统的主要组件及其分类,分为三个层次:架构(Architecture)、组件(Components)和部署(Deployment)。

版本的升级,v0.2相较于v0.1,修改了大概10%-15%。功能性上差不多,主要是往稳定性(或兼容性)、安全性上使劲了,支持更多的大模型,更安全。

1.6.2 内部架构详情

结构1:LangChain

-

langchain:构成应用程序认知架构的Chains,Agents,Retrieval strategies等构成应用程序的链、智能体、RAG。

-

langchain-community:第三方集成,比如:Model I/O、Retrieval、Tool& Toolkit;合作伙伴包 langchain-openai,langchain-anthropic等。

-

langchain-Core:基础抽象和LangChain表达式语言(LCEL)

小结:LangChain,就是AI应用组装套件,封装了一堆的API。langchain框架不大,但是里面琐碎的知识点特别多。就像玩乐高,提供了很多标准化的乐高零件(比如,连接器、轮子等)

结构2:LangGraph

LangGraph可以看做基于LangChain的api的进一步封装,能够协调多个Chain、Agent、Tools完成更复杂的任务,实现更高级的功能。

结构3:LangSmith

官网:https://docs.smith.langchain.com/

链路追踪。提供了6大功能,涉及Debugging(调试)、Playground(沙盒)、Prompt Management(提示管理)、Annotation(注释)、Testing(测试)、Monitoring(监控)等。与LangChain无缝集成,帮助你从原型阶段过渡到生产阶段。

正是因为LangSmith这样的工具出现,才使得LangChain意义更大,要不仅靠⼀些API(当然也可以不⽤,⽤原⽣的API),⽀持不住LangChain的热度。

结构4:LangServe

将LangChain的可运行项和链部署为REST API,使得它们可以通过网络进行调用。

Java怎么调用langchain呢?就通过这个langserve。将langchain应用包装成一个rest api,对外暴露服务。同时,支持更高的并发,稳定性更好。

总结:

LangChain当中,最有前途的两个模块就是:LangGraph ,LangSmith。

- LangChain能做RAG,其它的一些框架也能做,而且做的也不错,比如LlamaIndex。所以这时候LangChain要在Agent这块发力,那就需要LangGraph。

- 而LangSmith,做运维、监控。故,二者是LangChain里最有前途的。

2、开发前的准备工作

2.1 前置知识

- Python基础语法

- 变量、函数、类、装饰器、上下文管理器

- 模块导入、包管理(推荐用 pip 或 conda )

- 大语言模型基础

- 了解什么是 LLM、Token、Prompt、Embedding

- OpenAI API或其他模型提供商,如 Anthropic、阿里云百炼、DeepSeek等

- 通过浏览器或app使用过大模型(比如:豆包、DeepSeek等)

2.2 相关环境安装

-

安装Python或Anaconda

LangChain基于Python开发,因此需确保系统中安装了Python。

- 方式1:直接下载Python安装包。推荐版本为Python 3.10及以上。

- 方式2:使用包管理工具(如Anaconda)进行安装。通过Anaconda可以轻松创建和管理虚拟环境。

-

创建虚拟环境

- 为了保持项目的独立性与环境的干净,建议使用虚拟环境。

-

如何下载安装包

-

方式1:使用pip指令

基础指令

bash# 安装包(默认最新版) pip install langchain # 指定版本 pip install langchain==0.3.7 # 批量安装(空格分隔) pip install langchain requests numpy # 升级包 pip install --upgrade langchain # 卸载包 pip uninstall langchain # 查看已安装包 pip list高级操作

bash# 国内镜像加速 (解决下载慢) -i:指定镜像源 pip install -i https://mirrors.aliyun.com/pypi/simple/ langchain # 从本地/URL安装: pip install ./local_package.whl pip install https://github.com/user/repo/archive/main.zip -

方式2:使用conda指令

bash# 安装包(默认仓库) conda install langchain # 指定频道(如 conda-forge) # -c:是--channel的缩写,conda用于指定包的安装来源渠道。 # conda-forge:该源比官方默认渠道更新更快、包更全 conda install -c conda-forge langchain==0.3.7 # 更新包 conda update langchain # 卸载包 conda uninstall langchain # 查看已安装包 conda list -c :是 --channel 的缩写,conda⽤于指定包的安装来源渠道。 conda-forge :该源⽐官⽅默认渠道更新更快、包更全 -

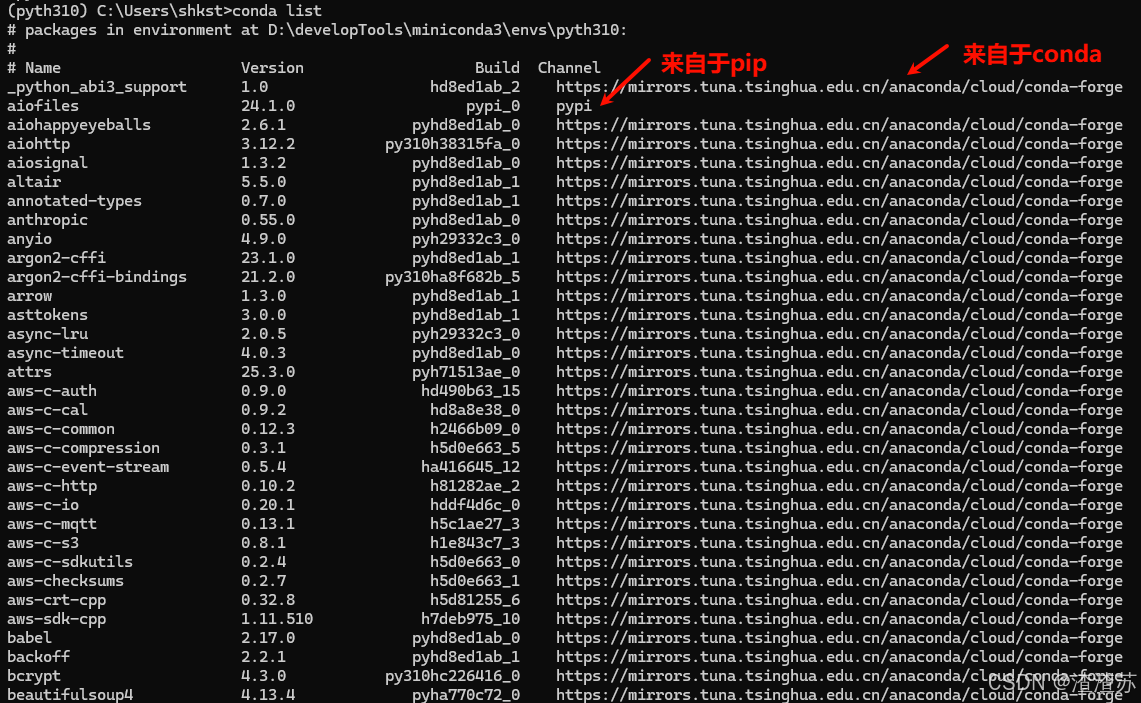

建议:二者最好不要混用,推荐先conda装基础包,后 pip补充的顺序。

bash# 检查包来源 conda list # conda安装的包显示频道,pip安装的显示 pypi

-

-

PyCharm开发环境

-

PyCharm作为专业的Python IDE,具有强大的代码编辑、调试和版本控制功能。

-

创建新的工程,并设置Python解释器(选择Anaconda环境)。

-

bash

import langchain

print(langchain.__version__) # 0.3.25

import openai

print(openai.__version__) # 1.81.0

import sys

#查看python的版本

print(sys.version) # 3.10.17 | packaged by conda-forge | (main, Apr 10 2025, 22:06:35) [MSC

v.1943 64 bit (AMD64)]3、大模型应用开发

大模型应用技术特点:门槛低,天花板高。

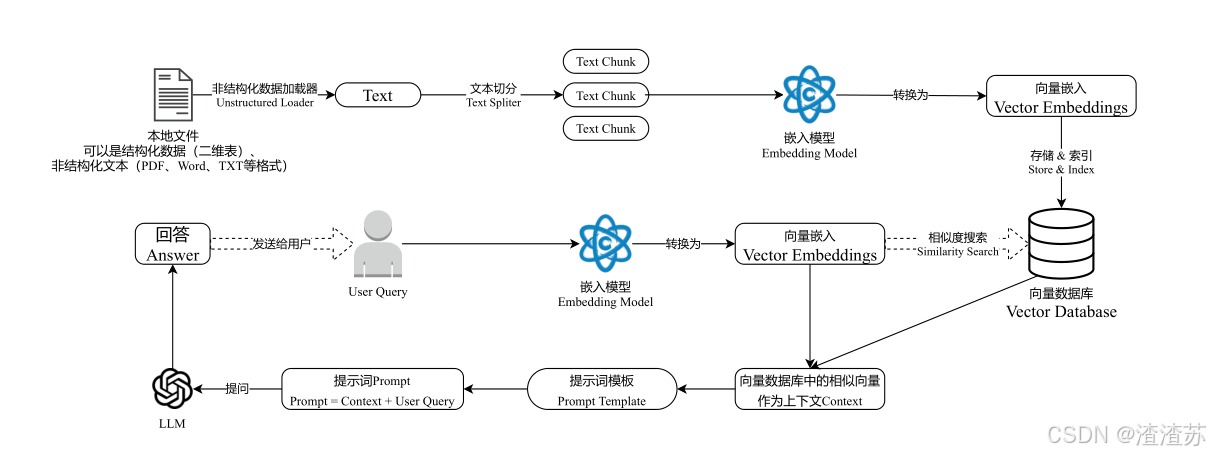

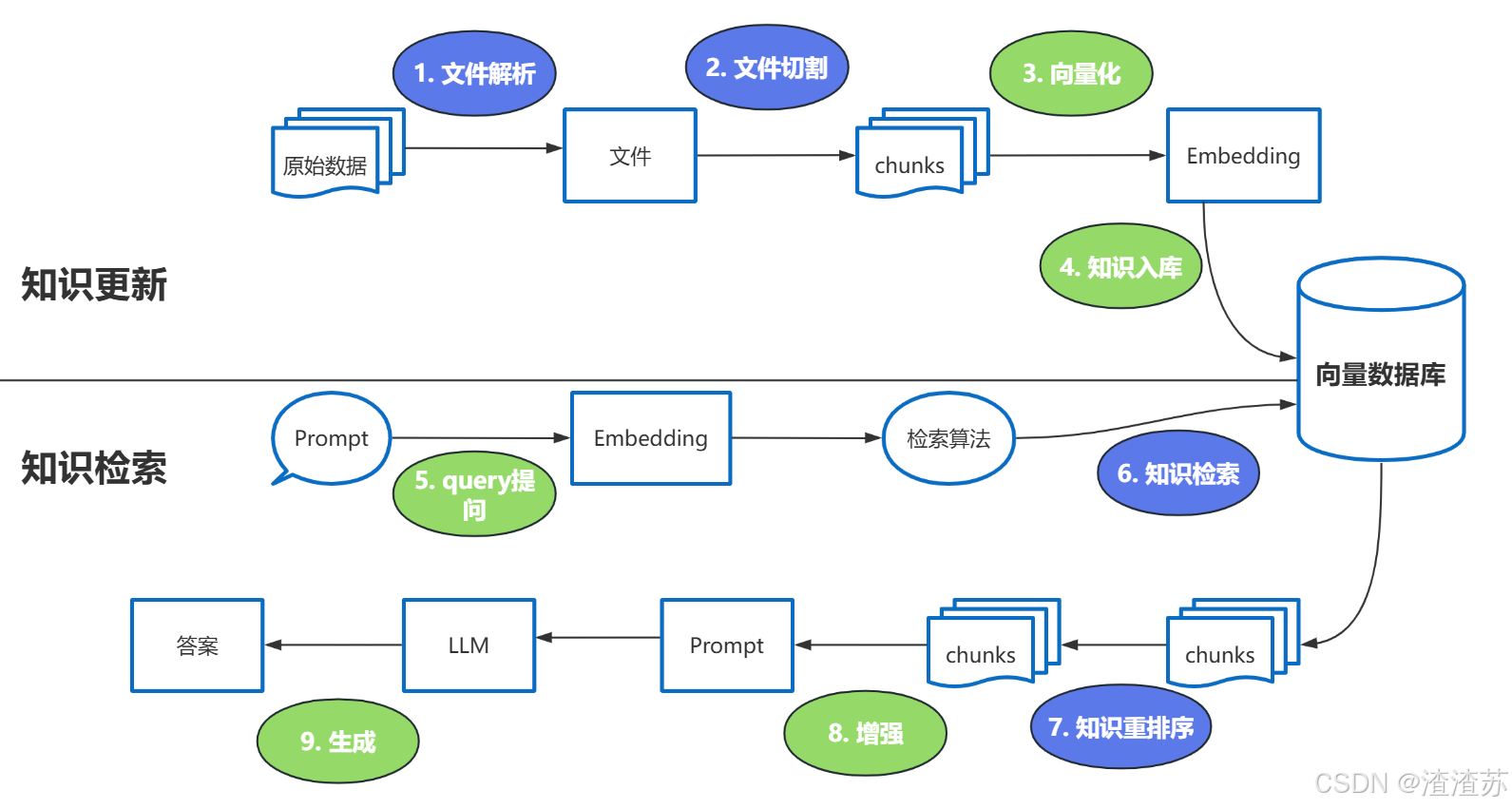

3.1 基于RAG架构的开发

背景:

- 大模型的知识冻结

- 大模型幻觉。

而RAG就可以非常精准地解决这两个问题。

举例:

LLM在考试的时候面对陌生的领域,答复能力有限,然后就准备放飞自我了。而此时RAG给了一些提示和思路,让LLM懂了开始往这个提示的方向做,最终考试的正确率从60%到了90%!

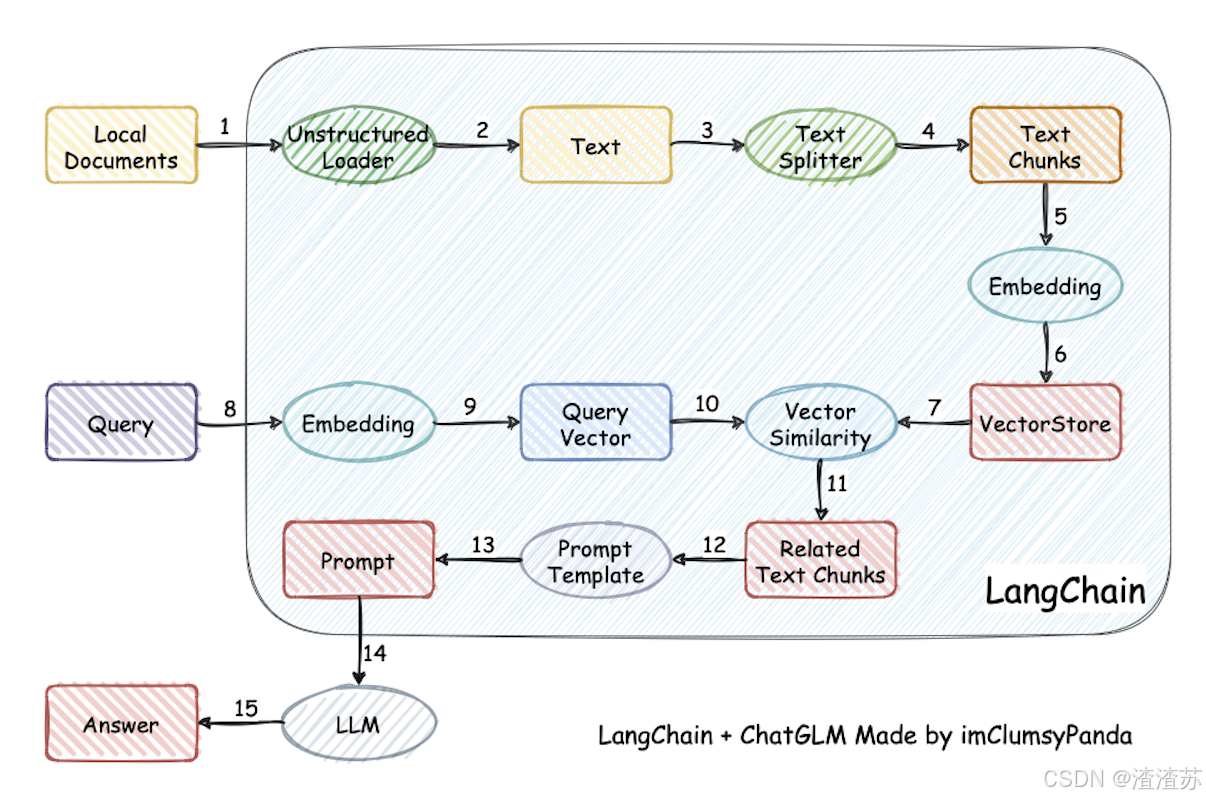

何为RAG?

Retrieval-Augmented Generation(检索增强生成)

检索-增强-⽣成过程:检索可以理解为第10步,增强理解为第12步(这⾥的提⽰词包含检索到的数据),⽣成理解为第15步。

类似的细节图:

强调一下难点的步骤:

Reranker的使用场景:

- 适合:追求回答高精度和高相关性的场景中特别适合使用 Reranker,例如专业知识库或者客服系统等应用。

- 不适合:引入reranker会增加召回时间,增加检索延迟。服务对响应时间要求高时,使用reranker可能不合适。

这里有三个位置涉及到大模型的使用:

- 第3步向量化时,需要使用EmbeddingModels。

- 第7步重排序时,需要使用RerankModels。

- 第9步生成答案时,需要使用LLM。

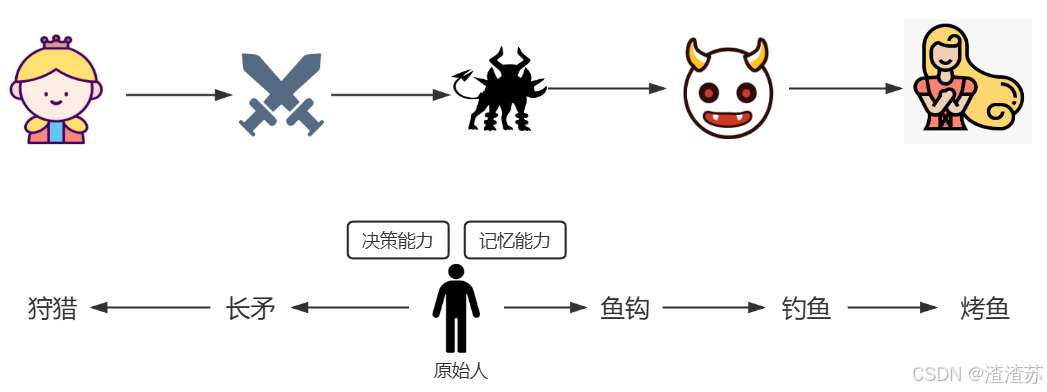

3.2 基于Agent架构的开发

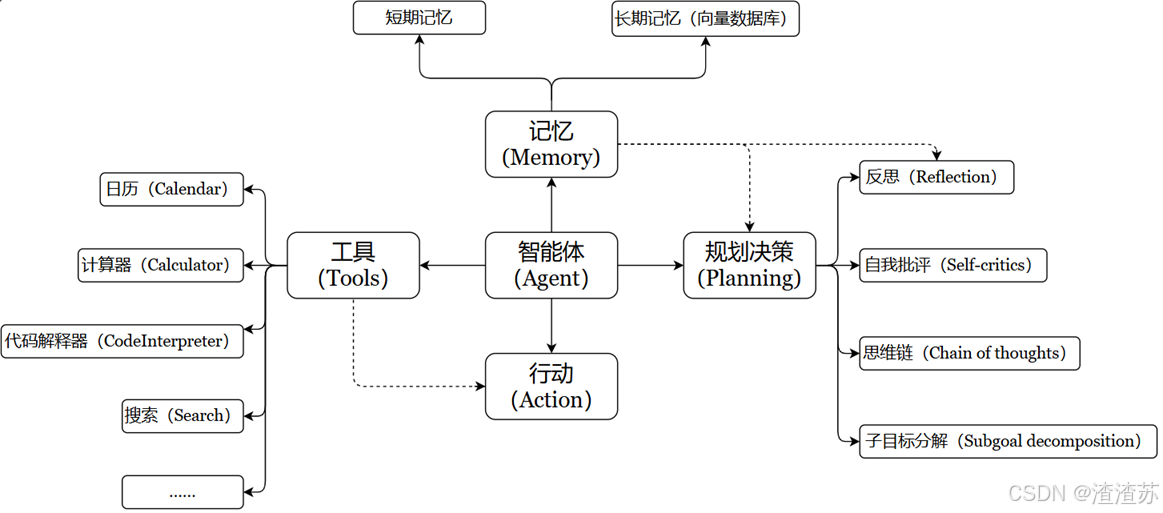

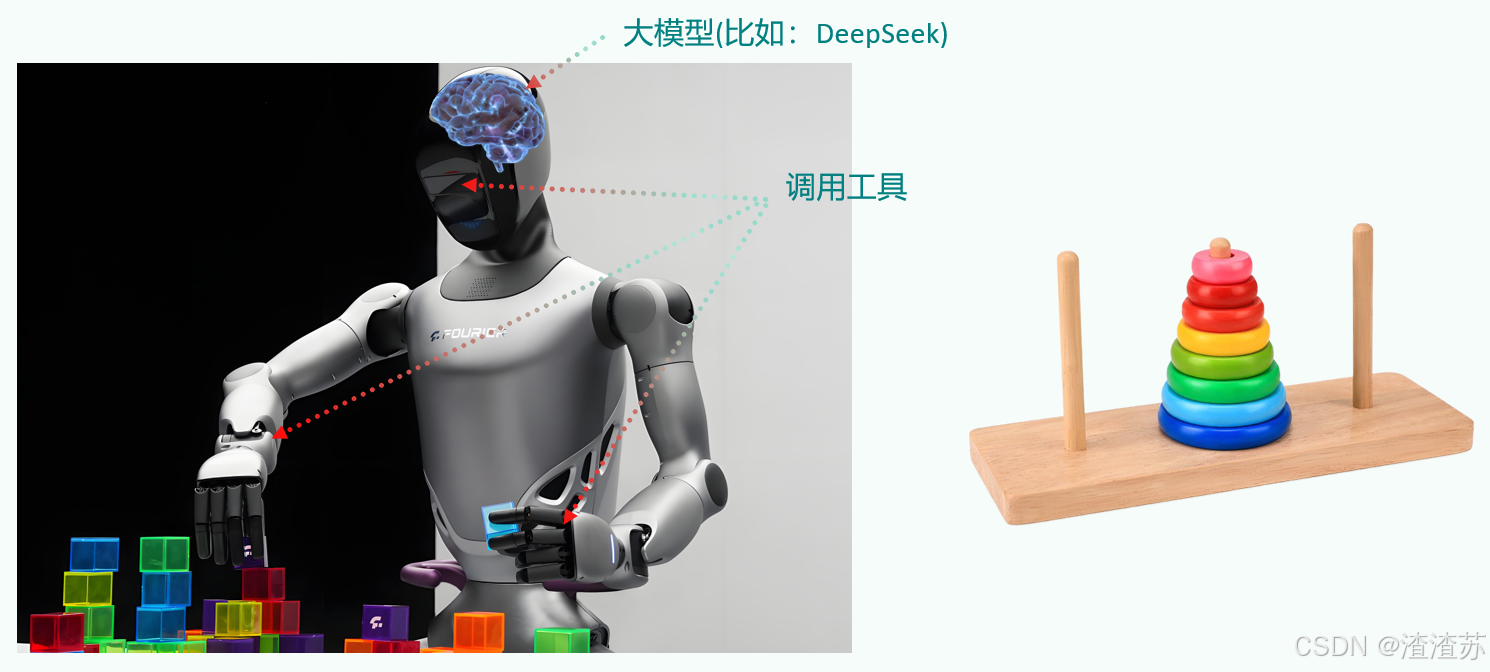

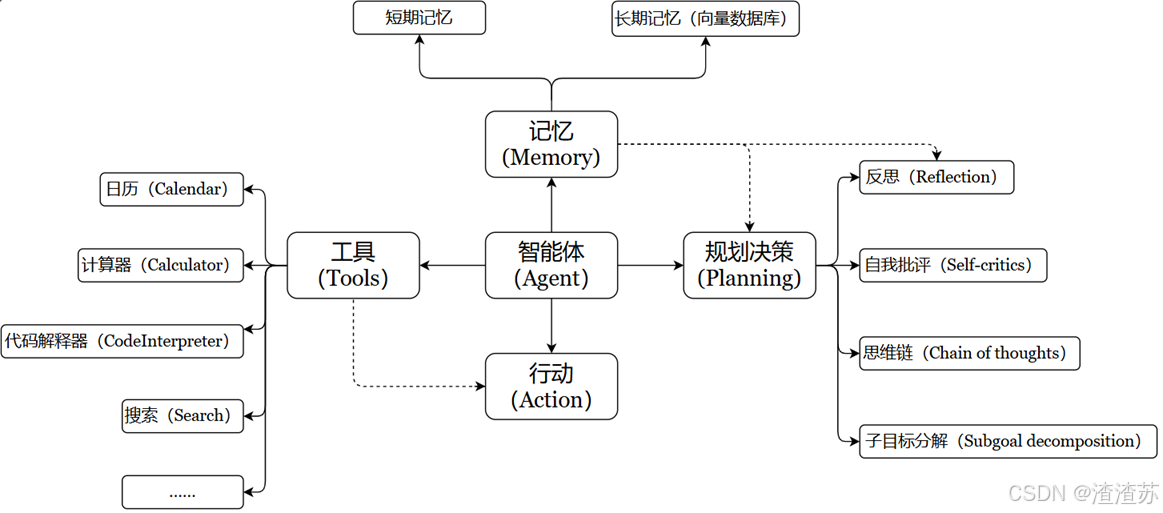

充分利用 LLM的推理决策能力,通过增加规划、记忆和工具调用的能力,构造一个能够独立思考、逐步完成给定目标的智能体。

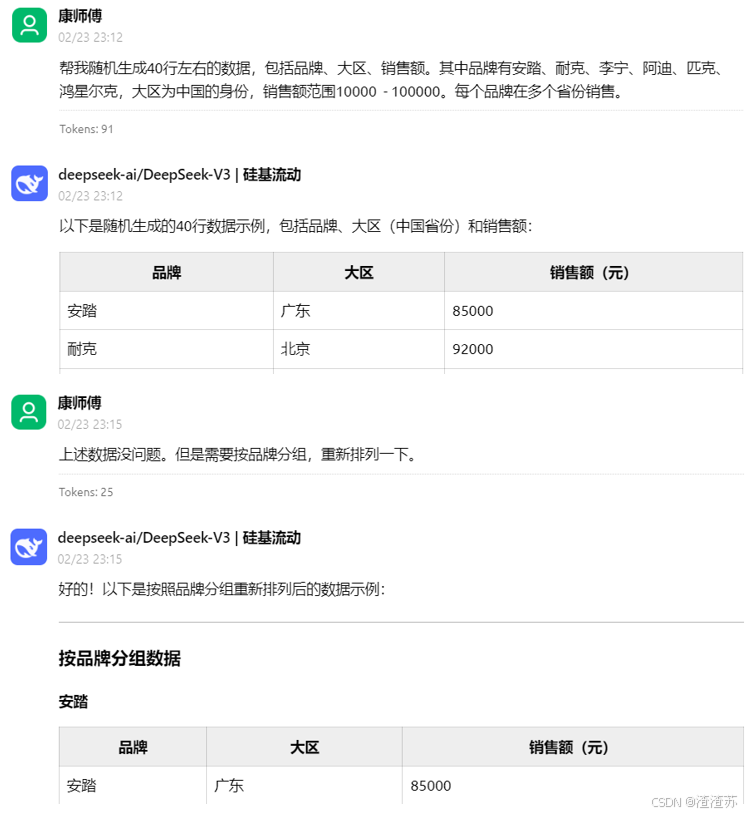

举例:传统的程序 vs Agent(智能体)

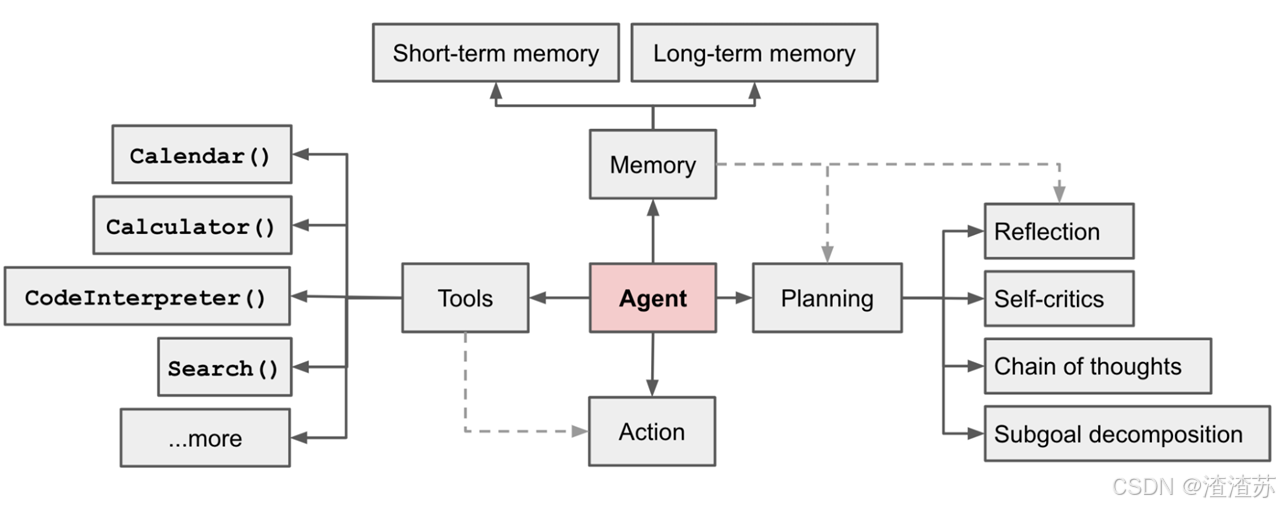

OpenAI的元老翁丽莲(Lilian Weng)于2023年6月在个人博客首次提出了现代AI Agent架构。

OpenAI的元老翁丽莲(Lilian Weng)于2023年6月在个人博客首次提出了现代AI Agent架构。

一个数学公式来表示 :

Agent = LLM + Memory + Tools + Planning + Action

⽐如,打⻋到西藏玩。

1. ⼤脑中枢:规划⾏程的你

2. 规划:步骤1:规划打⻋路线,步骤2:定饭店、酒店,。。。

3. 调⽤⼯具:调⽤MCP或FunctionCalling等API,滴滴打⻋、携程、美团订酒店饭店

4. 记忆能⼒:沟通时,要知道上下⽂。⽐如定酒店得知道是西藏路上的酒店,不能聊着聊着忘了最初的⽬的。

5. 能够执⾏上述操作。说走就走,不能纸上谈兵。智能体核心要素被细化为以下模块:

- 大模型(LLM)作为"大脑":提供推理、规划和知识理解能力,是AI Agent的决策中枢。

⼤脑主要由⼀个⼤型语⾔模型 LLM 组成,承担着信息处理和决策等功能, 并可以呈现推理和规划的过程,能很好地应对未知任务。

-

记忆(Memory):

记忆机制能让智能体在处理重复⼯作时调⽤以前的经验,从而避免⽤⼾进⾏⼤量重复交互。

-

短期记忆:存储单次对话周期的上下文信息,属于临时信息存储机制。受限于模型的上下文窗口长度。

ChatGPT:⽀持约8k token的上下⽂

GPT4:⽀持约32k token的上下⽂

最新的很多⼤模型:都⽀持100万、1000万 token的上下⽂ (相当于2000万字⽂本或20小时视频)

⼀般情况下模型中 token 和字数的换算⽐例⼤致如下:

- 1 个英⽂字符 ≈ 0.3 个 token。

- 1 个中⽂字符 ≈ 0.6 个 token。

-

长期记忆:可以横跨多个任务或时间周期,可存储并调用核心知识,非即时任务。

- 长期记忆,可以通过模型参数微调(固化知识)、知识图谱(结构化语义网络)或向量数据库(相似性检索)方式实现。

-

-

工具使用(Tool Use):调用外部工具(如API、数据库)扩展能力边界。

-

规划决策(Planning):通过任务分解、反思与自省框架实现复杂任务处理。例如,利用思维链(Chain of Thought)将目标拆解为子任务,并通过反馈优化策略。

-

行动(Action):实际执行决策的模块,涵盖软件接口操作(如自动订票)和物理交互(如机器人执行搬运)。比如:检索、推理、编程等。

智能体会形成完整的计划流程。例如先读取以前⼯作的经验和记忆,之后规划⼦⽬标并使⽤相应⼯具去处理问题,最后输出给⽤⼾并完成反思。

3.3 大模型应用开发的4个场景

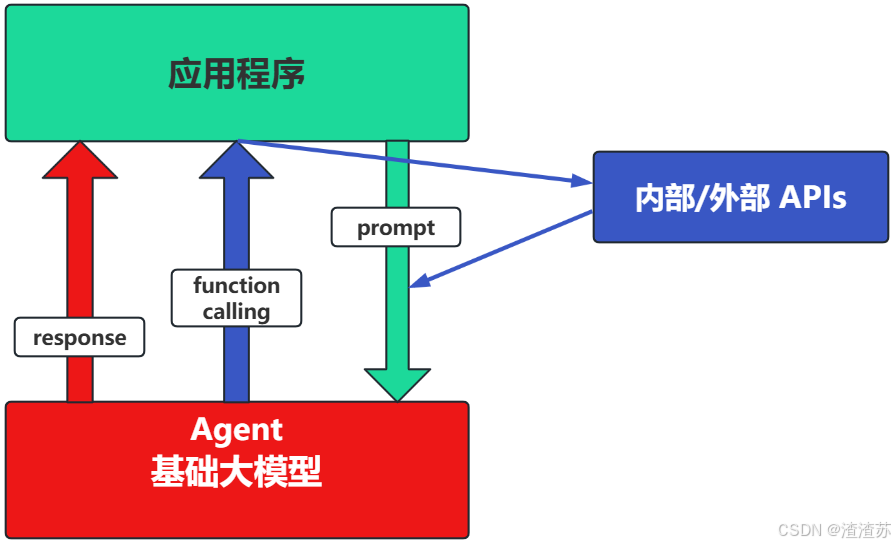

-

场景1:纯 Prompt

-

Prompt是操作大模型的唯一接口。

-

当人看:你说一句,ta回一句,你再说一句,ta再回一句...

-

-

场景2:Agent+ Function Calling

-

Agent:AI主动提要求。

-

Function Calling:需要对接外部系统时,AI要求执行某个函数。

-

当人看:你问 ta「我明天去杭州出差,要带伞吗?」,ta 让你先看天气预报,你看了告诉ta,ta再告诉你要不要带伞

-

-

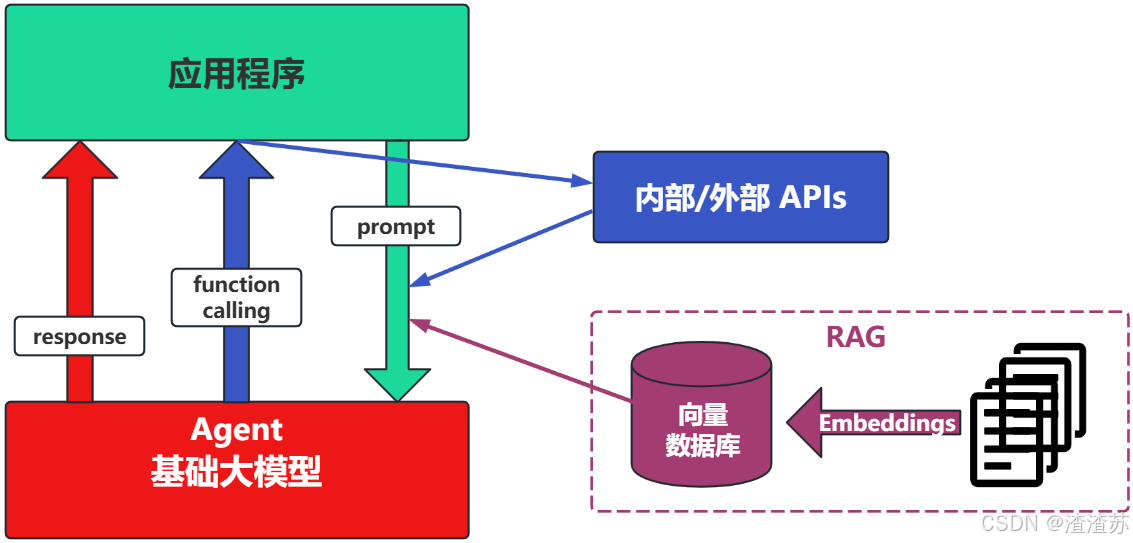

场景3:RAG(Retrieval-Augmented Generation)

RAG:需要补充领域知识时使用。

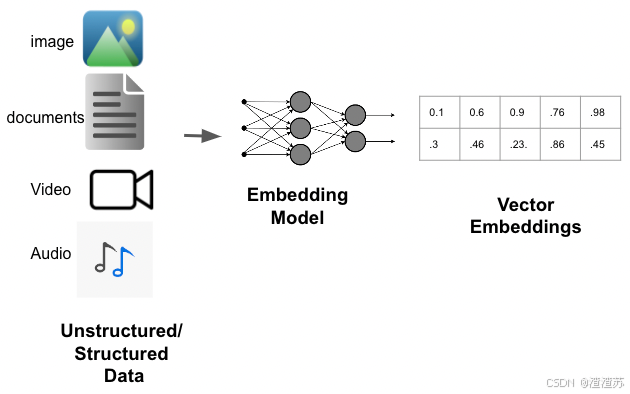

- Embeddings:把文字转换为更易于相似度计算的编码。这种编码叫向量。

- 向量数据库:把向量存起来,方便查找。

- 向量搜索:根据输入向量,找到最相似的向量。

举例:考试答题时,到书上找相关内容,再结合题目组成答案

-

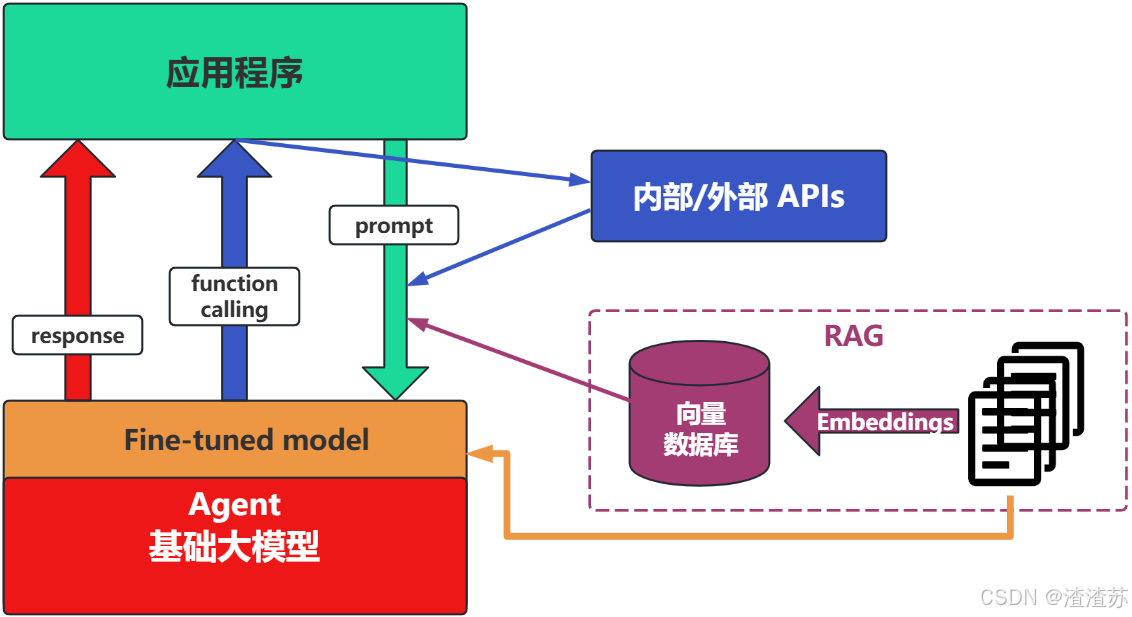

场景4:Fine-tuning(精调/微调)

-

举例:努力学习考试内容,长期记住,活学活用。

-

特点:成本最高;在前面的方式解决不了问题的情况下,再使用。

-

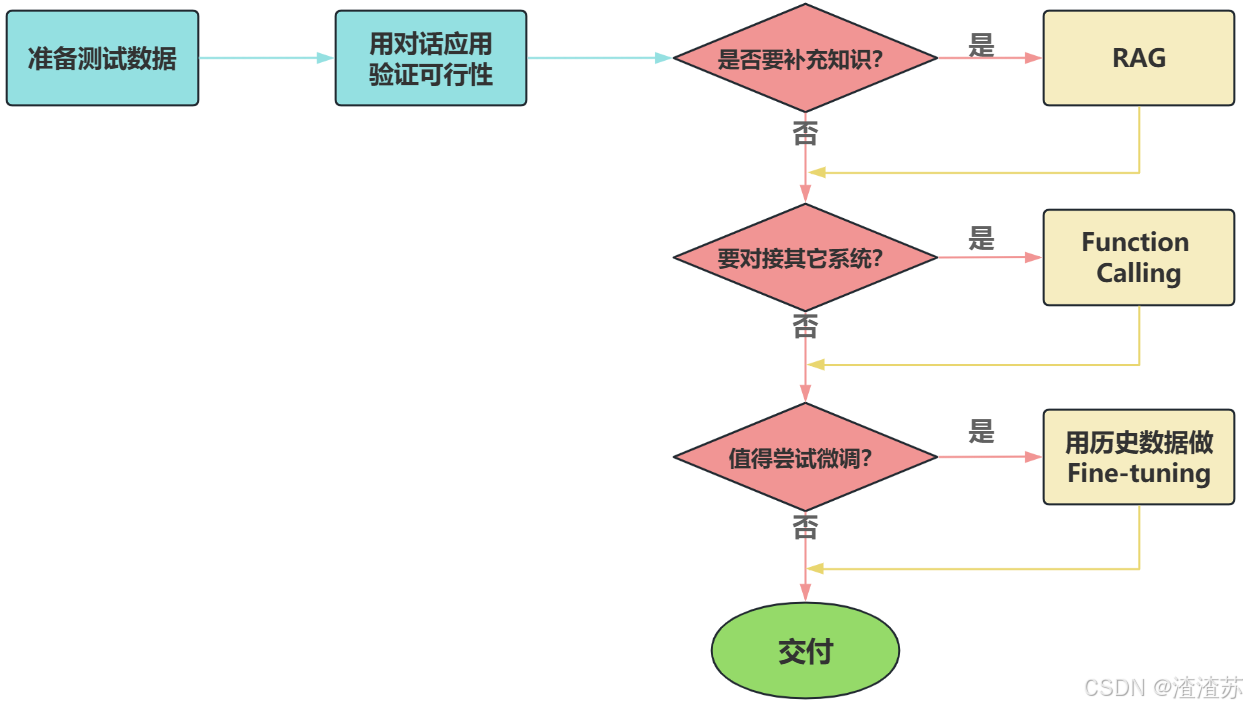

如何选择

面对一个需求,如何开始,如何选择技术方案?下面是个常用思路:

- 注意:其中最容易被忽略的,是准备测试数据。

下面,我们重点介绍下大模型应用的开发两类:基于RAG的架构,基于Agent的架构。

4、LangChain的核心组件

学习Langchain最简单直接的方法就是阅读官方文档。

https://python.langchain.com/v0.1/docs/modules/

通过文档目录我们可以看到,Langchain构成的核心组件。

两个红框内容是核心。中间的Integrations:集成各种工具或云平台。

4.1 一个问题引发的思考

如果要组织一个AI应用,开发者一般需要什么?

- 提示词模板的构建,不仅仅只包含用户输入。

- 模型调用与返回,参数设置,返回内容的格式化输出。

- 知识库查询,这里会包含文档加载,切割,以及转化为词嵌入(Embedding)向量。

- 其他第三方工具调用,一般包含天气查询、Google搜索、一些自定义的接口能力调用。

- 记忆获取,每一个对话都有上下文,在开启对话之前总得获取到之前的上下文吧?

4.2 核心组件的概述

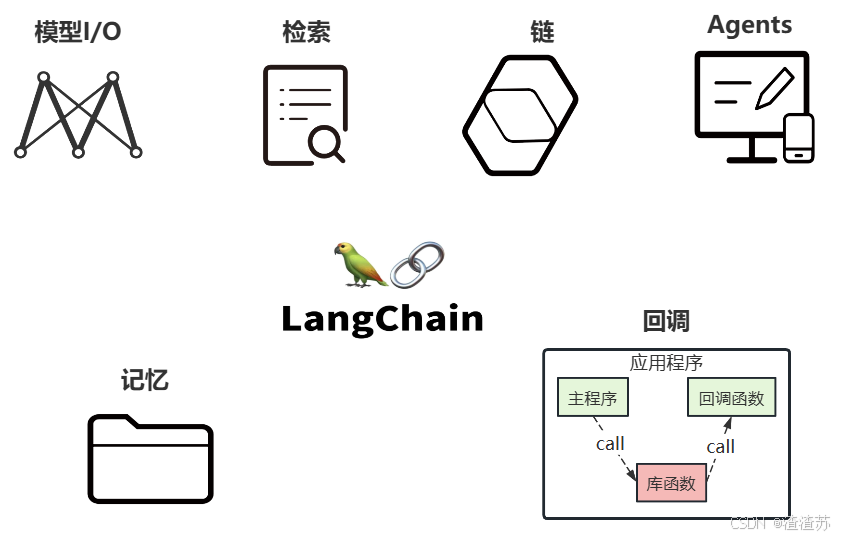

LangChain的核心组件涉及六大模块,这六大模块提供了一个全面且强大的框架,使开发者能够创建复杂、高效且用户友好的基于大模型的应用。

4.3 核心组件的说明

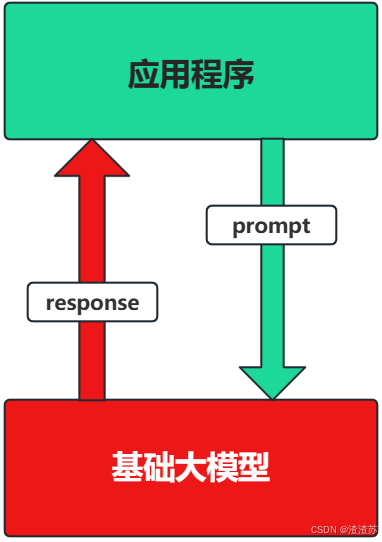

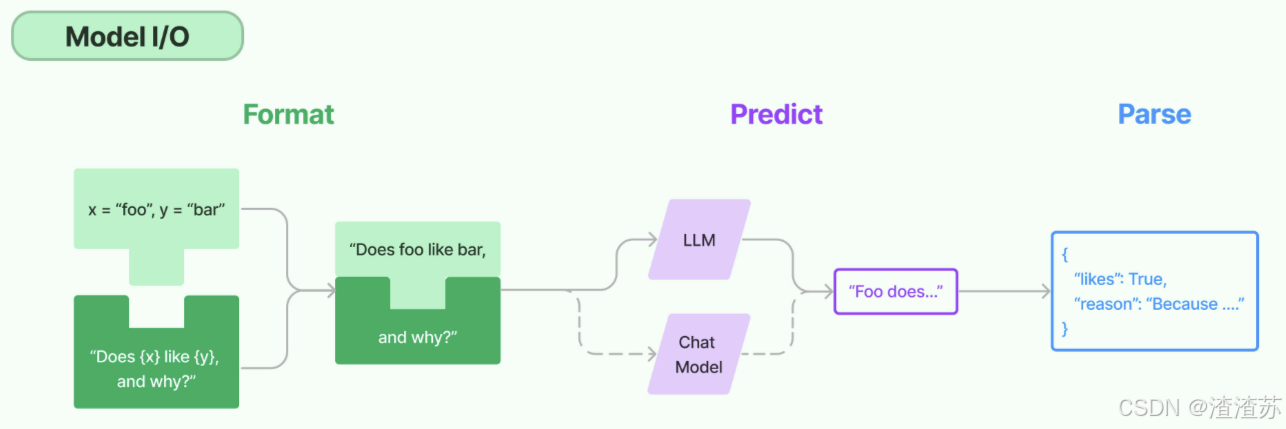

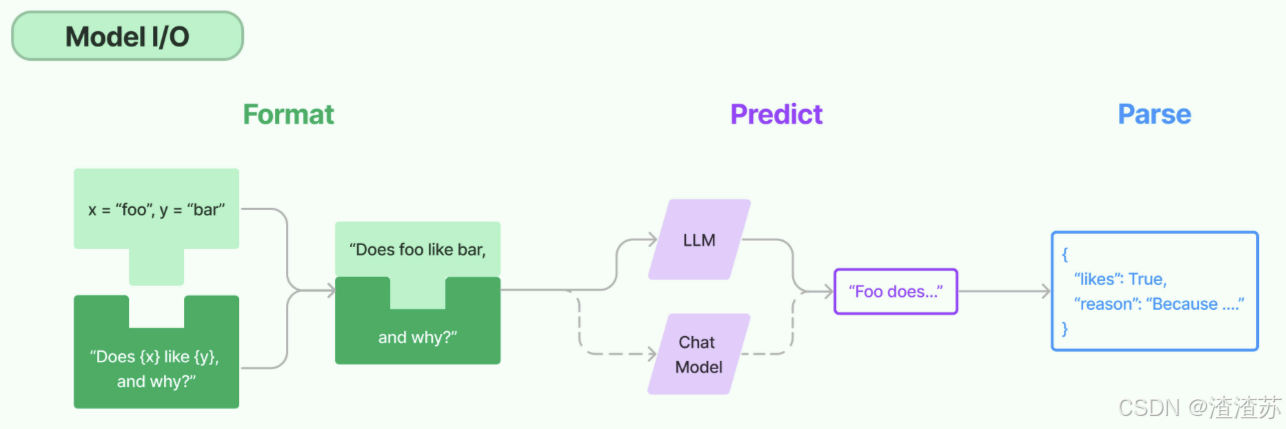

核心组件1:Model I/O

这个模块使用最多,也最简单。

Model I/O:标准化各个大模型的输入和输出,包含输入模版,模型本身和格式化输出。

以下是使用语言模型从输入到输出的基本流程。

以下是对每一块的总结:

- Format(格式化):即指代Prompts Template,通过模板管理大模型的输入。将原始数据格式化成模型可以处理的形式,插入到一个模板问题中,然后送入模型进行处理。

- Predict(预测):即指代Models,使用通用接口调用不同的大语言模型。接受被送进来的问题,然后基于这个问题进行预测或生成回答。

- Parse(生成):即指代Output Parser部分,用来从模型的推理中提取信息,并按照预先设定好的模版来规范化输出。比如,格式化成一个结构化的JSON对象。

核心组件2:Chains

Chain:"链条",用于将多个模块串联起来组成一个完整的流程,是 LangChain框架中最重要的模块。

例如,一个 Chain 可能包括一个 Prompt 模板、一个语言模型和一个输出解析器,它们一起工作以处理用户输入、生成响应并处理输出。

- 常见的Chain类型 :

LLMChain:最基础的模型调用链SequentialChain:多个链串联执行RouterChain:自动分析用户的需求,引导到最适合的链RetrievalQA:结合向量数据库进行问答的链

核心组件3:Memory

Memory:记忆模块,用于保存对话历史或上下文信息,以便在后续对话中使用。

- 常见的 Memory类型 :

ConversationBufferMemory:保存完整的对话历史ConversationSummaryMemory:保存对话内容的精简摘要(适合长对话)ConversationSummaryBufferMemory:混合型记忆机制VectorStoreRetrieverMemory:保存对话历史存储在向量数据库中

核心组件4:Agents

Agents,对应着智能体,是 LangChain的高阶能力,它可以自主选择工具并规划执行步骤。

- Agent的关键组成 :

AgentType:定义决策逻辑的工作流模式Tool:是一些内置的功能模块,如API调用、搜索引擎、文本处理、数据查询等工具。Agents通过这些工具来执行特定的功能。AgentExecutor:用来运行智能体并执行其决策的工具,负责协调智能体的决策和实际的工具执行。

⽬前最热⻔的智能体开发实践,未来能够真正实现通⽤⼈⼯智能的落地⽅案。

这⾥的Agent,就会涉及到前⾯讲的memory,以及tools。

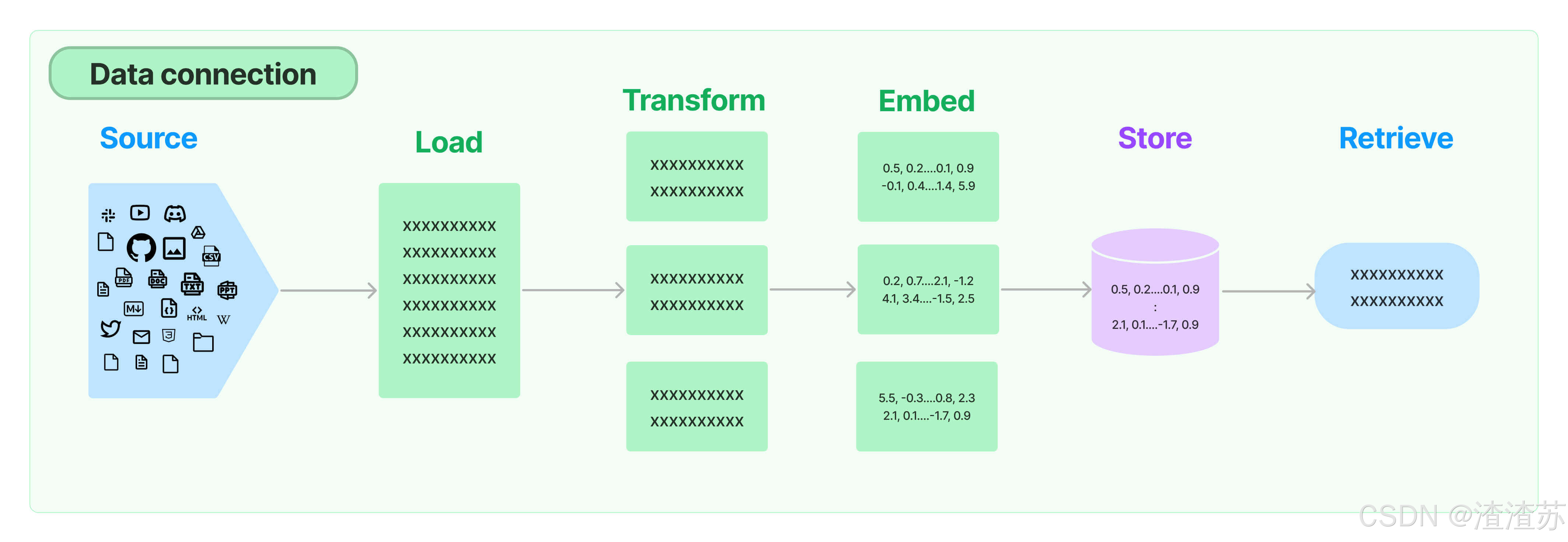

核心组件5:Retrieval

Retrieval:对应着RAG,检索外部数据,然后在执行生成步骤时将其传递到 LLM。步骤包括文档加载、切割、Embedding等

- Source:数据源,即大模型可以识别的多种类型的数据:视频、图片、文本、代码、文档等。

- Load:负责将来自不同数据源的非结构化数据,加载为文档(Document)对象

- Transform:负责对加载的文档进行转换和处理,比如将文本拆分为具有语义意义的小块。

- Embed:将文本编码为向量的能力。一种用于嵌入文档,另一种用于嵌入查询

- Store:将向量化后的数据进行存储

- Retrieve:从大规模文本库中检索和查询相关的文本段落

绿⾊的是⼊库存储前的操作。

核心组件6:Callbacks

Callbacks:回调机制,允许连接到 LLM应用程序的各个阶段,可以监控和分析LangChain的运行情况,比如日志记录、监控、流传输等,以优化性能。

回调函数,对于程序员们应该都不陌⽣。这个函数允许我们在LLM的各个阶段使⽤各种各样的"钩⼦",从而达实现⽇志的记录、监控以及流式传输等功能。

4.4 小结

- Model I/O模块:使用最多,也最简单

- Chains模块:最重要的模块

- Retrieval模块、Agents模块:大模型的主要落地场景

在这个基础上,其它组件要么是它们的辅助,要么只是完成常规应用程序的任务。

- 辅助:比如,向量数据库的分块和嵌入,用于追踪、观测的Callbacks

- 任务:比如,Tools,Memory

我们要做的就是一个一个module去攻破,最后将他们融会贯通,也就成为一名合格的LangChain学习者了。

5、LangChain的helloworld

注意:大家如果想演示如下代码的话,需要准备两个前提:

① 安装必要的库和插件

② 参考后续《02-LangChain使用之Model IO》的2.3.2小结,配置好.env配置文件

建议:如下的helloworld大家看看即可,从下一章开始展开讲解

5.1 获取大模型

python

# 导入 dotenv库的 load_dotenv函数,用于加载环境变量文件(.env)中的配置

import dotenv

from langchain_openai import ChatOpenAI

import os

dotenv.load_dotenv() # 加载当前目录下的.env文件

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

# 创建大模型实例

llm = ChatOpenAI(model="gpt-4o-mini") # 默认使用 gpt-3.5-turbo

# 直接提供问题,并调用llm

response = llm.invoke("什么是大模型?")

print(response)其中,需要在当前工程下提供 .env 文件,文件中提供如下信息:

OPENAI_API_KEY1="sk-cvUm8OddQbly.............AGgIHTm9kMH7Bf226G2" # 你自己的密钥

OPENAI_BASE_URL="https://api.openai-proxy.org/v1" # url是固定值,统一写成这样密钥来自于:https://www.closeai-asia.com/

5.2 使用提示词模板

python

from langchain_core.prompts import ChatPromptTemplate

# 需要注意的一点是,这里需要指明具体的role,在这里是system和用户

prompt = ChatPromptTemplate.from_messages([

("system", "你是世界级的技术文档编写者"),

("user", "{input}") # {input}为变量

])

# 我们可以把prompt和具体llm的调用和在一起。

chain = prompt | llm

message = chain.invoke({"input": "大模型中的LangChain是什么?"})

print(message)5.3 使用输出解析器

python

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser, JsonOutputParser

# 初始化模型

llm = ChatOpenAI(model="gpt-4o-mini")

# 创建提示模板

prompt = ChatPromptTemplate.from_messages([

("system", "你是世界级的技术文档编写者。"),

("user", "{input}")

])

# 使用输出解析器

# output_parser = StrOutputParser()

output_parser = JsonOutputParser()

# 将其添加到上一个链中

# chain = prompt | llm

chain = prompt | llm | output_parser

# 调用它并提出同样的问题。答案是一个字符串,而不是ChatMessage

# chain.invoke({"input":"LangChain是什么?"})

chain.invoke({"input": "LangChain是什么?用JSON格式回复,问题用question,回答用answer"})或者

python

from langchain_openai import ChatOpenAI

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.output_parsers import StrOutputParser, JsonOutputParser

# 初始化模型

llm = ChatOpenAI(model="gpt-4o-mini")

# 创建提示模板

prompt = ChatPromptTemplate.from_messages([

("system", "你是世界级的技术文档编写者。输出格式要求:{format_instructions}"),

("user", "{input}")

])

# 使用输出解析器

# output_parser = StrOutputParser()

output_parser = JsonOutputParser()

# 将其添加到上一个链中

# chain = prompt | llm

chain = prompt | llm | output_parser

# 调用它并提出同样的问题。答案是一个字符串,而不是ChatMessage

# chain.invoke({"input":"LangChain是什么?"})

chain.invoke({"input": "LangChain是什么?", "format_instructions": output_parser.get_format_instructions()})5.4 使用向量存储

使用一个简单的本地向量存储 FAISS,首先需要安装它

bash

pip install faiss-cpu

# 或者

conda install faiss-cpu

pip install langchain_community==0.3.7

# 或者

conda install langchain_community==0.3.7

python

# 导入和使用 WebBaseLoader

from langchain_community.document_loaders import WebBaseLoader

import bs4

loader = WebBaseLoader(

web_path="https://www.gov.cn/xinwen/2020-06/01/content_5516649.htm",

bs_kwargs=dict(parse_only=bs4.SoupStrainer(id="UCAP-CONTENT"))

)

docs = loader.load()

# print(docs)

# 对于嵌入模型,这里通过 API调用

from langchain_openai import OpenAIEmbeddings

embeddings = OpenAIEmbeddings(model="text-embedding-ada-002")

from langchain_community.vectorstores import FAISS

from langchain_text_splitters import RecursiveCharacterTextSplitter

# 使用分割器分割文档

text_splitter = RecursiveCharacterTextSplitter(chunk_size=500, chunk_overlap=50)

documents = text_splitter.split_documents(docs)

print(len(documents))

# 向量存储 embeddings会将 documents中的每个文本片段转换为向量,并将这些向量存储在 FAISS 向量数据库中

vector = FAISS.from_documents(documents, embeddings)5.5 RAG(检索增强生成)

基于外部知识,增强大模型回复

python

from langchain_core.prompts import PromptTemplate

retriever = vector.as_retriever()

retriever.search_kwargs = {"k": 3}

docs = retriever.invoke("建设用地使用权是什么?")

# for i,doc in enumerate(docs):

# print(f"⭐第{i+1}条规定:")

# print(doc)

# 6. 定义提示词模版

prompt_template = """

你是一个问答机器人。你的任务是根据下述给定的已知信息回答用户问题。确保你的回复完全依据下述已知信息。不要编造答案。如果下述已知信息不足以回答用户的问题,请直接回复"我无法回答您的问题"。

已知信息:

{info}

用户问:

{question}

请用中文回答用户问题。

"""

# 7. 得到提示词模版对象

template = PromptTemplate.from_template(prompt_template)

# 8. 得到提示词对象

prompt = template.format(info=docs, question='建设用地使用权是什么?')

# 9. 调用LLM

response = llm.invoke(prompt)

print(response.content)5.6 使用Agent

python

from langchain.tools.retriever import create_retriever_tool

# 检索器工具

retriever_tool = create_retriever_tool(

retriever,

"CivilCodeRetriever",

"搜索有关中华人民共和国民法典的信息。关于中华人民共和国民法典的任何问题,您必须使用此工具!",

)

tools = [retriever_tool]

from langchain import hub

from langchain.agents import create_openai_functions_agent

from langchain.agents import AgentExecutor

# https://smith.langchain.com/hub

prompt = hub.pull("hwchase17/openai-functions-agent")

agent = create_openai_functions_agent(llm, tools, prompt)

agent_executor = AgentExecutor(agent=agent, tools=tools, verbose=True)

# 运行代理

agent_executor.invoke({"input": "建设用地使用权是什么"})第02章:LangChain使用之Model I/O

1、Model I/O介绍

Model I/O 模块是与语言模型(LLMs)进行交互的 核心组件 ,在整个框架中有着很重要的地位。

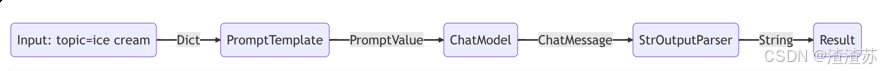

所谓的Model I/O,包括输入提示(Format)、调用模型(Predict)、输出解析(Parse)。分别对应着Prompt Template , Model 和 Output Parser 。

简单来说,就是输⼊、模型处理、输出这三个步骤

针对每个环节,LangChain都提供了模板和工具,可以快捷的调用各种语言模型的接口。

2、Model I/O之调用模型1

LangChain作为一个"工具",不提供任何 LLMs,而是依赖于第三方集成各种大模型。比如,将OpenAI、Anthropic、Hugging Face 、LlaMA、阿里Qwen、ChatGLM等平台的模型无缝接入到你的应用。

2.1 模型的不同分类方式

简单来说,就是⽤谁家的API以什么⽅式调⽤哪种类型的⼤模型:

角度1:按照模型功能的不同

- 非对话模型 (LLMs/Text Model)

- 对话模型 (Chat Models) (推荐)

- 嵌入模型 (Embedding Models)

角度2:模型调用时,几个重要参数的书写位置的不同

- 硬编码: 写在代码文件中(仅用于临时测试,有密钥泄露风险)。

- 使用环境变量: 密钥与代码分离,适合单机开发。

- 使用配置文件 (推荐): 安全性高,适合生产环境和团队协作。

角度3:具体调用的API

- OpenAI提供的API

- 其它大模型自家提供的API

- LangChain的统一方式调用API (推荐)

背景小知识: OpenAI的GPT系列模型影响了⼤模型技术发展的开发范式和标准。所以⽆论是Qwen、ChatGLM等模型,它们的使⽤⽅法和函数调⽤逻辑基本 遵循OpenAI定义的规范 ,没有太⼤差异。这就使得⼤部分的开源项⽬能够通过⼀个较为通⽤的接口来接⼊和使⽤不同的模型。

2.2 角度1出发:按照功能不同举例

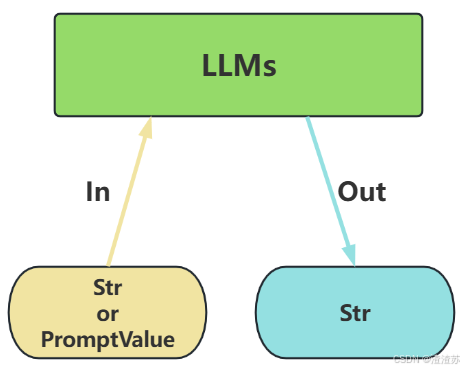

类型1:LLMs (非对话模型)

LLMs,也叫Text Model、非对话模型,是许多语言模型应用程序的支柱。主要特点如下:

- 输入:接受 文本字符串 或 PromptValue 对象

- 输出:总是返回 文本字符串

- 适用场景:仅需单次文本生成任务(如摘要生成、翻译、代码生成、单次问答)或对接不支持消息结构的旧模型(如部分本地部署模型)( 言外之意,优先推荐ChatModel )

- 不支持多轮对话上下文。每次调用独立处理输入,无法自动关联历史对话(需手动拼接历史文本)。

- 局限性:无法处理角色分工或复杂对话逻辑。

python

import os

import dotenv

from langchain_openai import OpenAI

dotenv.load_dotenv()

os.environ["OPENAI_API_KEY"] = os.getenv("OPENAI_API_KEY1")

os.environ["OPENAI_BASE_URL"] = os.getenv("OPENAI_BASE_URL")

###########核心代码############

llm = OpenAI()

str = llm.invoke("写一首关于春天的诗") # 直接输入字符串

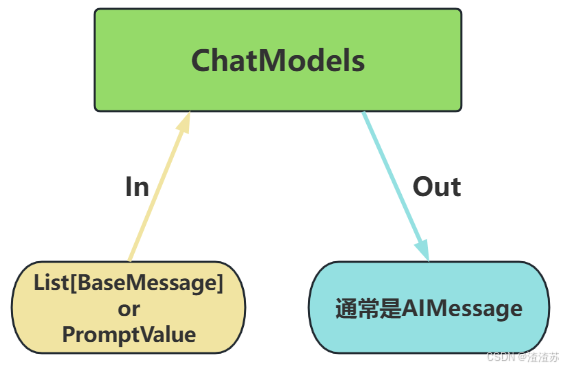

print(str)类型2:Chat Models (对话模型)

ChatModels,也叫聊天模型、对话模型,底层使用LLMs。

大语言模型调用,以 ChatModel 为主!

主要特点如下:

- 输入:接收消息列表 List[BaseMessage] 或 PromptValue ,每条消息需指定角色(如SystemMessage、HumanMessage、AIMessage)

- 输出:总是返回带角色的 消息对象 ( BaseMessage 子类),通常是 AIMessage

- 原生支持多轮对话。通过消息列表维护上下文(例如: [SystemMessage, HumanMessage,AIMessage, ...] ),模型可基于完整对话历史生成回复。

- 适用场景:对话系统(如客服机器人、长期交互的AI助手)

python

from langchain_openai import ChatOpenAI

from langchain_core.messages import SystemMessage, HumanMessage

import os

import dotenv

dotenv.load_dotenv()

os.environ["OPENAI_API_KEY"] = os.getenv("OPENAI_API_KEY1")

os.environ["OPENAI_BASE_URL"] = os.getenv("OPENAI_BASE_URL")

########核心代码############

chat_model = ChatOpenAI(model="gpt-4o-mini")

messages = [

SystemMessage(content="我是人工智能助手,我叫小智"),

HumanMessage(content="你好,我是小明,很高兴认识你")

]

response = chat_model.invoke(messages)

print(type(response)) # <class 'langchain_core.messages.ai.AIMessage'>

print(response.content)类型3:Embedding Model (嵌入模型)

Embedding Model:也叫文本嵌入模型,这些模型将 文本 作为输入并返回 浮点数列表 ,也就是Embedding。(后面章节《07-LangChain使用之Retrieval》重点讲)

python

from langchain_openai import OpenAIEmbeddings

import os

import dotenv

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

embeddings_model = OpenAIEmbeddings(model="text-embedding-ada-002")

res1 = embeddings_model.embed_query('我是文档中的数据')

print(res1)

# 打印结果:[-0.004306625574827194, 0.003083756659179926, -0.013916781172156334, ...., ]2.3 角度2出发:参数位置不同举例

这里以 LangChain 的API为准,使用对话模型,进行测试。

2.3.1 模型调用的主要方法及参数

- 相关方法及属性:

- OpenAI(...) / ChatOpenAI(...) :创建一个模型对象(非对话类/对话类)

- model.invoke(xxx) :执行调用,将用户输入发送给模型

- .content :提取模型返回的实际文本内容

模型调用函数使用时需初始化模型,并设置必要的参数。

-

必须设置的参数:

base_url: API服务的根地址。api_key: 用于身份验证的密钥,由大模型服务商(如 OpenAI、百度千帆)提供model/model_name: 指定要调用的具体大模型名称。

-

其它参数:

-

temperature :温度,控制生成文本的"随机性",取值范围为0~1。

- 值越低 → 输出越确定、保守(适合事实回答)

- 值越高 → 输出越多样、有创意(适合创意写作)

通常,根据需要设置如下:

- 精确模式(0.5或更低):生成的文本更加安全可靠,但可能缺乏创意和多样性。

- 平衡模式(通常是0.8):生成的文本通常既有一定的多样性,又能保持较好的连贯性和准确性。

- 创意模式(通常是1):生成的文本更有创意,但也更容易出现语法错误或不合逻辑的内容。

-

max_tokens: 限制生成文本的最大长度,防止输出过长。Token是什么?

基本单位 : 大模型处理文本的最小单位是token(相当于自然语言中的词或字),输出时逐个token依次生成。

收费依据 :大语言模型(LLM)通常也是以token的数量作为其计量(或收费)的依据。

- 1个Token≈1-1.8个汉字,1个Token≈3-4个英文字母

- Token与字符转化的可视化工具:

max_tokens设置建议:

- 客服短回复:128-256。比如:生成一句客服回复(如"订单已发货,预计明天送达")

- 常规对话、多轮对话:512-1024

- 长内容生成:1024-4096。比如:生成一篇产品说明书(包含功能、使用方法等结构)

-

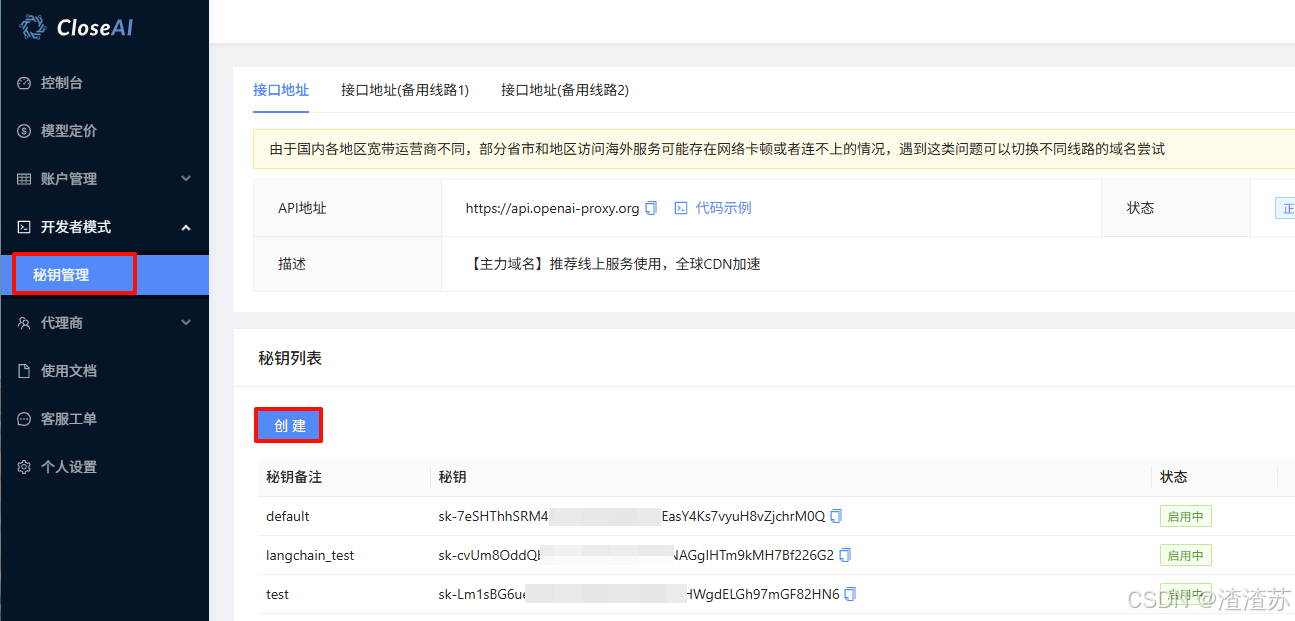

2.3.2 模型调用推荐平台:closeai

这里推荐使用的平台:

考虑到OpenAI等模型在国内访问及充值的不便,大家可以使用CloseAI网站注册和充值, 具体费用自

理 。

2.3.3 方式1:硬编码

直接将 API Key 和模型参数写入代码,仅适用于临时测试,存在密钥泄露风险,在 生产环境不推荐 。

python

from langchain_openai import ChatOpenAI

# 硬编码 API Key 和模型参数

llm = ChatOpenAI(

api_key="sk-xxxxxxxxx", # 明文暴露密钥

base_url="https://api.openai-proxy.org/v1",

model="gpt-3.5-turbo",

)

# 调用示例

response = llm.invoke("解释神经网络原理")

print(response.content)2.3.4 方式2:配置环境变量

通过系统环境变量存储密钥,避免代码明文暴露。

方式1:终端设置环境变量(临时生效):

bash

export OPENAI_API_KEY="sk-xxxxxxxxxxxxxxxxxxxx" # Linux/Mac

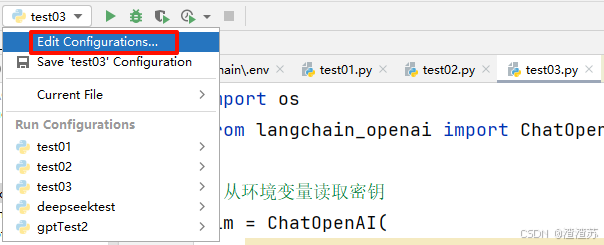

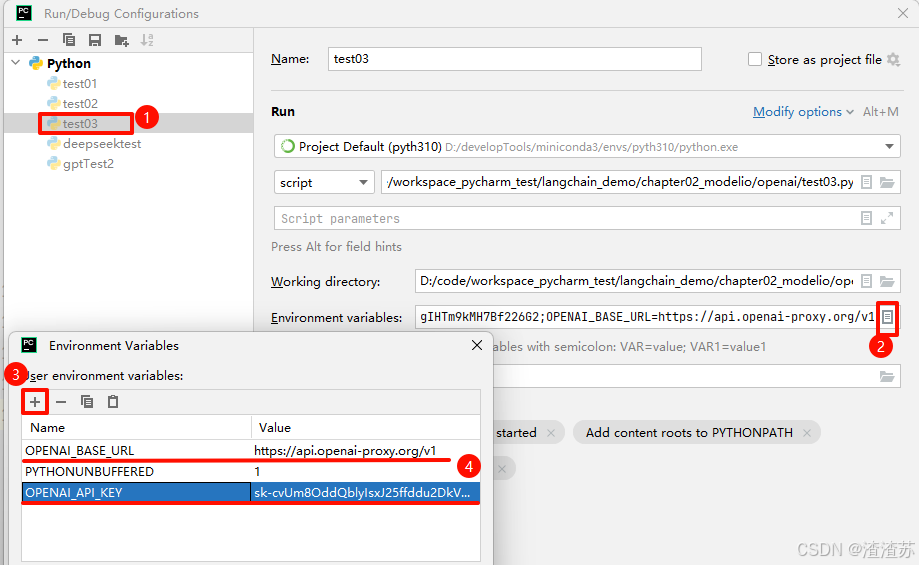

set OPENAI_API_KEY="sk-xxxxxxxxxxxxxxxxxxxx" # Windows方式2:从PyCharm设置

举例:

python

import os

from langchain_openai import ChatOpenAI

# 从环境变量读取密钥

llm = ChatOpenAI(

api_key=os.environ["OPENAI_API_KEY"], # 动态获取

base_url=os.environ["OPENAI_BASE_URL"],

model="gpt-4o-mini",

)

response = llm.invoke("LangChain 是什么?")

print(response.content)优点:密钥与代码分离,适合单机开发

缺点 :切换终端或文件后,变量失效,需重新设置。

2.3.5 方式3:使用.env配置文件 (推荐)

使用 python-dotenv 加载本地配置文件,支持多环境管理。

-

安装依赖:

bashpip install python-dotenv #或者 conda install python-dotenv -

创建

.env文件 (项目根目录):iniOPENAI_API_KEY="sk-xxxxxxxxx" OPENAI_BASE_URL="https://api.openai-proxy.org/v1" -

举例:

pythonfrom dotenv import load_dotenv from langchain_openai import ChatOpenAI import os load_dotenv() # 自动加载 .env 文件 # print(os.getenv("OPENAI_API_KEY")) # print(os.getenv("OPENAI_BASE_URL")) llm = ChatOpenAI( api_key=os.getenv("OPENAI_API_KEY"), # 安全读取 base_url=os.getenv("OPENAI_BASE_URL"), model="gpt-4o-mini", temperature=0.7, ) response = llm.invoke("RAG 技术的核心流程") print(response.content)方式2:给os内部的环境变量赋值

pythonfrom langchain_openai import ChatOpenAI import dotenv dotenv.load_dotenv() import os os.environ["OPENAI_API_KEY"] = os.getenv("OPENAI_API_KEY1") os.environ["OPENAI_API_BASE"] = os.getenv("OPENAI_BASE_URL") text = "猫王是猫吗?" chat_model = ChatOpenAI( model="gpt-4o-mini", temperature=0.7, max_tokens=300, ) response = chat_model.invoke(text) print(type(response)) print(response.content)核心优势:

- 配置文件可加入 .gitignore 避免泄露

- 结合 LangChain 可扩展其它模型(如 DeepSeek、阿里云)

- 生产环境推荐

小结:

| 方式 | 安全性 | 持久性 | 适用场景 |

|---|---|---|---|

| 硬编码 | ⚠低 | ❌临时 | 本地快速测试 |

| 环境变量 | ✅中 | ⚠会话级 | 短期开发调试 |

| .env 配置文件 | ✅✅高 | ✅永久 | 生产环境、团队协作 |

2.4 角度3出发:各平台API的调用举例(了解)

2.4.1 OpenAI 官方API

考虑到OpenAI在国内访问及充值的不便,我们仍然使用CloseAI网站(https://www.closeai-asia.com)注册和充值, 具体费用自理 。

调用非对话模型:

python

from openai import OpenAI

# 从环境变量读取API密钥(推荐安全存储)

client = OpenAI(api_key="sk-zD4CB2Qe7G2Dp6veCfPRSxeDx9fQPxCUIfOFAk20ETV5B2VA", #

填写自己的api-key

base_url="https://api.openai-proxy.org/v1") #通过代码示例获取

# 调用Completion接口

response = client.completions.create(

model="gpt-3.5-turbo-instruct", # 非对话模型

prompt="请将以下英文翻译成中文:\n'Artificial intelligence will reshape the future.'",

max_tokens=100, # 生成文本最大长度

temperature=0.7, # 控制随机性

)

# 提取结果

print(response.choices[0].text.strip())调用对话模型:

写法1:

python

from openai import OpenAI

client = OpenAI(api_key="sk-zD4CB2Qe7G2Dp6veCfPRSxeDx9fQPxCUIfOFAk20ETV5B2VA", #填

写自己的api-key

base_url="https://api.openai-proxy.org/v1")

completion = client.chat.completions.create(

model="gpt-3.5-turbo", # 对话模型

messages=[

{"role": "system", "content": "你是一个乐于助人的智能AI小助手"},

{"role": "user", "content": "你好,请你介绍一下你自己"}

],

max_tokens=150,

temperature=0.5

)

print(completion.choices[0].message)写法2:

python

from openai import OpenAI

import os

import dotenv

dotenv.load_dotenv()

os.environ["OPENAI_API_KEY"] = os.getenv("OPENAI_API_KEY1")

os.environ["OPENAI_BASE_URL"] = os.getenv("OPENAI_BASE_URL")

client = OpenAI()

response = client.chat.completions.create(

model="gpt-3.5-turbo",

messages=[

{"role": "system", "content": "我是一位乐于助人的AI智能小助手"},

{"role": "user", "content": "你好,请你介绍一下你自己。"}

]

)

print(response.choices[0])2.4.2 百度千帆平台

开发参考文档:

https://cloud.baidu.com/doc/qianfan-docs/s/Mm8r1mejk

获取API Key和App ID:

创建API Key:https://console.bce.baidu.com/qianfan/ais/console/apiKey

创建App ID:https://console.bce.baidu.com/qianfan/ais/console/applicationConsole/application/v2

代码举例:

python

from openai import OpenAI

client = OpenAI(

api_key="bce-v3/ALTAK-KZke********/f1d6ee*************", # 千帆bearer token

base_url="https://qianfan.baidubce.com/v2", # 千帆域名

default_headers={"appid": "app-MuYR79q6"} # 用户在千帆上的appid,非必传

)

completion = client.chat.completions.create(

model="ernie-4.0-turbo-8k", # 预置服务请查看模型列表,定制服务请填入API地址

messages=[{'role': 'system', 'content': 'You are a helpful assistant.'},

{'role': 'user', 'content': 'Hello!'}]

)

print(completion.choices[0].message)2.4.3 阿里云百炼平台

注册与key的获取:

提前开通百炼平台账号并申请API KEY:https://bailian.console.aliyun.com/#/home

对应的配置文件:

properties

DASHSCOPE_API_KEY="sk-f1a87324#####e6a819a482" #使用自己的api key

DASHSCOPE_BASE_URL="https://dashscope.aliyuncs.com/compatible-mode/v1"模型的调用:

参考具体模型的代码示例。这里以DeepSeek为例:

举例1:通过OpenAI SDK

pip install openai

python

import os

from openai import OpenAI

client = OpenAI(

# 若没有配置环境变量,请用阿里云百炼API Key将下行替换为:api_key="sk-xxx",

api_key=os.getenv("DASHSCOPE_API_KEY"), # 如何获取API Key:

https://help.aliyun.com/zh/model-studio/developer-reference/get-api-key

base_url=os.getenv("DASHSCOPE_BASE_URL")

)

completion = client.chat.completions.create(

model="deepseek-r1", # 此处以 deepseek-r1 为例,可按需更换模型名称。

messages=[

{'role': 'user', 'content': '9.9和9.11谁大'}

]

)

# 通过reasoning_content字段打印思考过程

print("思考过程:")

print(completion.choices[0].message.reasoning_content)

# 通过content字段打印最终答案

print("最终答案:")

print(completion.choices[0].message.content)举例2:通过DashScope SDK

pip install dashscope

python

import os

import dashscope

messages = [

{'role': 'user', 'content': '你是谁?'}

]

response = dashscope.Generation.call(

# 若没有配置环境变量,请用阿里云百炼API Key将下行替换为:api_key="sk-xxx",

api_key=os.getenv('DASHSCOPE_API_KEY'),

model="deepseek-r1", # 此处以 deepseek-r1 为例,可按需更换模型名称。

messages=messages,

# result_format参数不可以设置为"text"。

result_format='message'

)

print("=" * 20 + "思考过程" + "=" * 20)

print(response.output.choices[0].message.reasoning_content)

print("=" * 20 + "最终答案" + "=" * 20)

print(response.output.choices[0].message.content)2.4.4 智谱的GLM

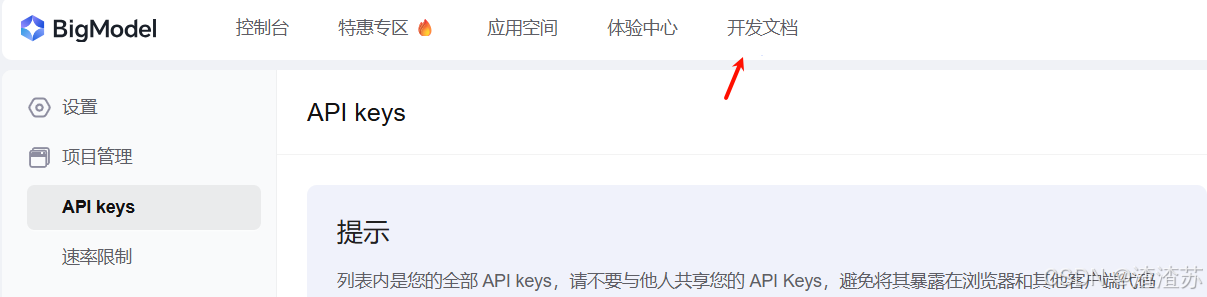

注册智谱模型并获取API Key:

https://www.bigmodel.cn/usercenter/proj-mgmt/apikeys

properties

#记录自己的api key,声明在.env文件中

ZHIPUAI_API_KEY="63a0f275b3a9###############rA4Y8daGaLydxQ"查看《开发文档》

或者选择如下《参考文档》皆可:

https://www.bigmodel.cn/dev/api/normal-model/glm-4

代码举例

举例1:使用OpenAI SDK

python

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("ZHIPUAI_API_KEY"),

base_url=os.getenv("ZHIPUAI_URL")

)

completion = client.chat.completions.create(

model="glm-4-air-250414",

messages=[

{"role": "system", "content": "你是一个聪明且富有创造力的小说作家"},

{"role": "user", "content": "请你作为童话故事大王,写一篇短篇童话故事,故事的主题是要永远

保持一颗善良的心,要能够激发儿童的学习兴趣和想象力,同时也能够帮助儿童更好地理解和接受故事

中所蕴含的道理和价值观。"}

],

top_p=0.7,

temperature=0.9

)

print(completion.choices[0].message)举例2:使用Langchain SDK

python

import os

from langchain_openai import ChatOpenAI

from langchain.prompts import (

ChatPromptTemplate,

MessagesPlaceholder,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

from langchain.chains import LLMChain

from langchain.memory import ConversationBufferMemory

llm = ChatOpenAI(

temperature=0.95,

model="glm-4-air-250414",

openai_api_key= os.getenv("ZHIPUAI_API_KEY"),

openai_api_base=os.getenv("ZHIPUAI_URL"),

)

prompt = ChatPromptTemplate(

messages=[

SystemMessagePromptTemplate.from_template(

"You are a nice chatbot having a conversation with a human."

),

MessagesPlaceholder(variable_name="chat_history"),

HumanMessagePromptTemplate.from_template("{question}")

]

)

memory = ConversationBufferMemory(memory_key="chat_history", return_messages=True)

conversation = LLMChain(

llm=llm,

prompt=prompt,

verbose=True,

memory=memory

)

conversation.invoke({"question": "给我讲个冷笑话"})举例3:参考langchain的文档

https://imooc-langchain.shortvar.com/docs/integrations/chat/zhipuai/

安装包:

pip install langchain-community

pip install pyjwt代码示例:

python

import dotenv

from langchain_community.chat_models import ChatZhipuAI

from langchain_core.messages import AIMessage, SystemMessage, HumanMessage

#智谱大模型:参考langchain的大模型

dotenv.load_dotenv()

import os

os.environ["ZHIPUAI_API_KEY"] = os.getenv("ZHIPUAI_API_KEY")

chat = ChatZhipuAI(

model="glm-4",

temperature=0.5,

)

messages = [

AIMessage(content="哈罗~"),

SystemMessage(content="你是一个诗人"),

HumanMessage(content="写一首关于AI的七言绝句"),

]

response = chat.invoke(messages)

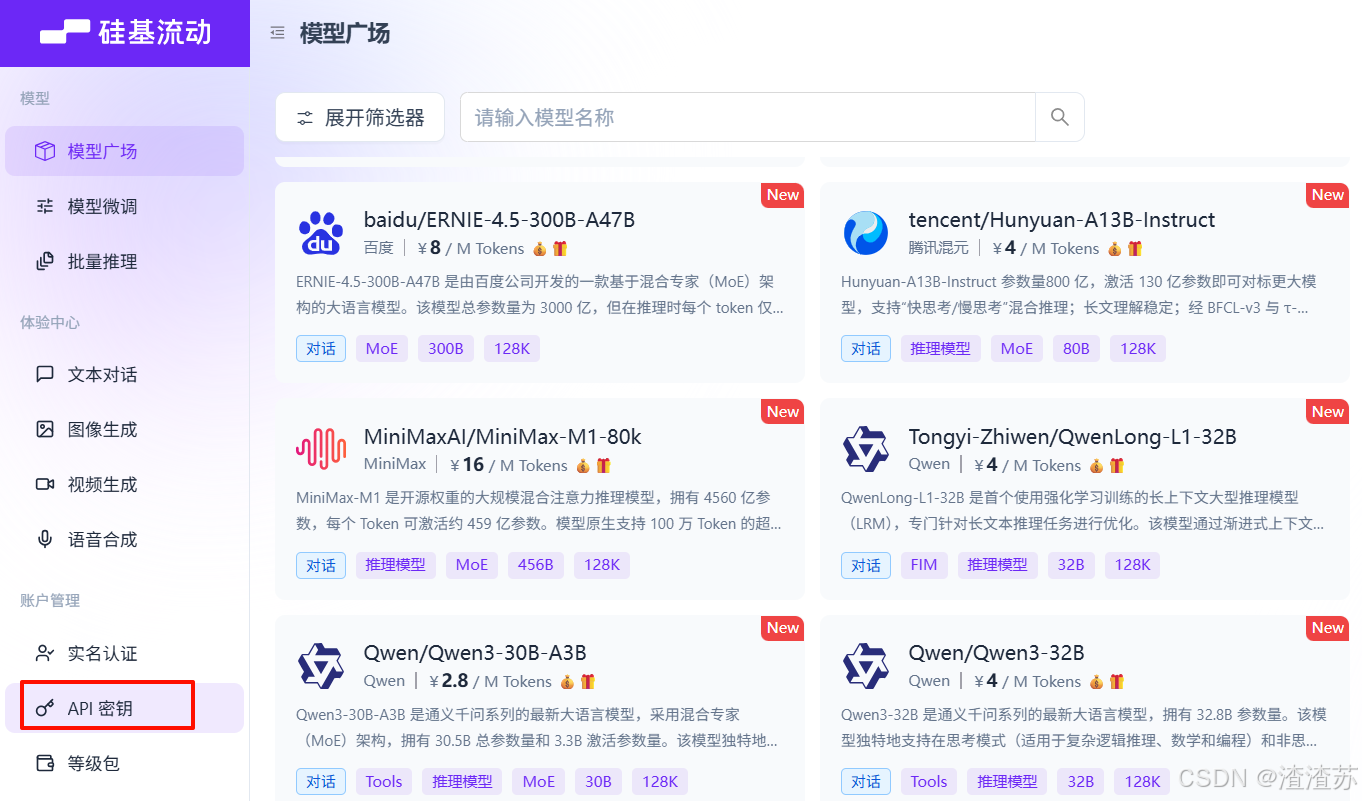

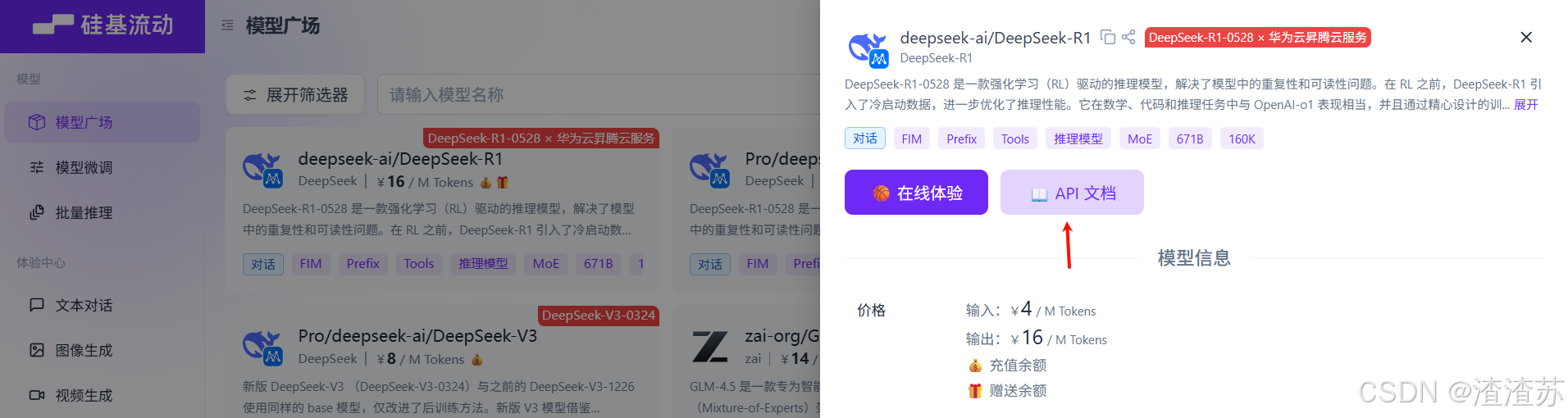

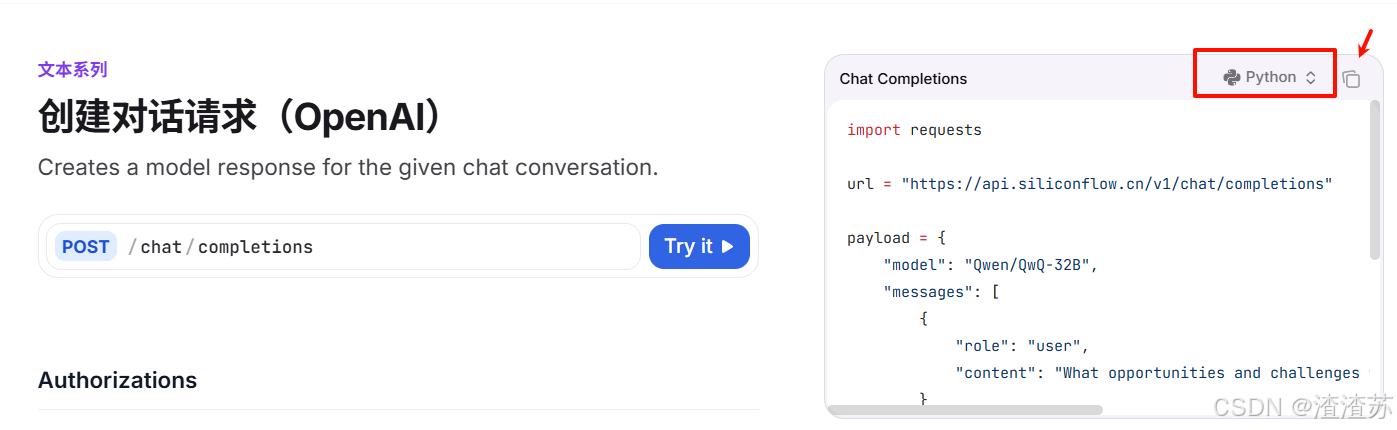

print(response.content) # 显示 AI 生成的诗2.4.5 硅基流动平台

官网:https://www.siliconflow.cn/

申请API Key:

python

from openai import OpenAI

client = OpenAI(api_key=os.getenv("SILICON_API_KEY"),

base_url="https://api.siliconflow.cn/v1")

response = client.chat.completions.create(

model='Pro/deepseek-ai/DeepSeek-R1',

# model="Qwen/Qwen2.5-72B-Instruct",

messages=[

{'role': 'user',

'content': "推理模型会给市场带来哪些新的机会"}

],

stream=True

)

for chunk in response:

if not chunk.choices:

continue

if chunk.choices[0].delta.content:

print(chunk.choices[0].delta.content, end="", flush=True)

if chunk.choices[0].delta.reasoning_content:

print(chunk.choices[0].delta.reasoning_content, end="", flush=True)或者:

python

import requests

url = "https://api.siliconflow.cn/v1/chat/completions"

payload = {

"model": "deepseek-ai/DeepSeek-R1", #填写你选择的大模型

"messages": [

{

"role": "user",

"content": "1 +2 * 3 = ?"

}

]

}

headers = {

"Authorization": "Bearer sk-auciaxqpz.....zepozralhwleyrdoyjani", #填写你的api-key

"Content-Type": "application/json"

}

response = requests.post(url, json=payload, headers=headers)

print(response.json())2.5 如何选择合适的大模型

2.5.1 有没有最好的大模型

凡是问「哪个大模型最好?」的,都是不懂的。

不妨反问:「无论做什么,有都表现最好的员工吗?」

划重点:没有最好的大模型,只有最适合的大模型

基础模型选型,合规和安全是首要考量因素!

为什么不要依赖榜单?

- 没有最好的大模型,只有最适合的大模型。合规和安全是首要考量因素。

- 不要过度依赖榜单,因为榜单体现的是整体能力,不一定适用于具体任务,且未体现成本差异。

- 本课程主要以OpenAI为例,因为其流行、先进,且其他模型大多在模仿其范式。

本课程主要以OpenAI为例展开后续的课程。因为:

1、OpenAl 最流行,即便国内也是如此

2、OpenAl 最先进。别的模型有的能力,OpenAI一定都有。OpenAI有的,别的模型不一定有。

3、其它模型都在追赶和模仿OpenAl gpt-4o-mini

学会OpenAl,其它模型触类旁通。反之,不⼀定

2.5.2 小结:获取大模型的标准方式

后续课程将基于以下标准方式初始化模型:

非对话模型:

python

import os

import dotenv

from langchain_openai import OpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

llm = OpenAI()对话模型:

python

import os

import dotenv

from langchain_openai import ChatOpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

chat_model = ChatOpenAI(model="gpt-4o-mini")对应的 .env 配置文件:

ini

OPENAI_API_KEY="sk-xxxxxx"

OPENAI_BASE_URL="https://api.openai-proxy.org/v1"3、Model I/O之调用模型2

3.1 关于对话模型的Message(消息)

聊天模型,出了将字符串作为输入外,还可以使用 聊天消息 作为输入,并返回 聊天消息 作为输出。

LangChain内置的消息类型:

SystemMessage: 设定AI行为规则或背景信息。HumanMessage: 表示来自用户的输入。AIMessage: 存储AI回复的内容。ChatMessage: 可以自定义角色的通用消息类型。FunctionMessage/ToolMessage: 用于函数/工具调用结果的消息类型。

注意:

FunctionMessage和ToolMessage分别是在函数调⽤和⼯具调⽤场景下才会使⽤的特殊消息类型,HumanMessage、AIMessage和SystemMessage才是最常⽤的消息类型。

举例1:

python

from langchain_core.messages import HumanMessage, SystemMessage

messages = [SystemMessage(content="你是一位乐于助人的智能小助手"),

HumanMessage(content="你好,请你介绍一下你自己"),]

print(messages)举例2:

python

from langchain_core.messages import HumanMessage, AIMessage, SystemMessage

messages = [

SystemMessage(content=["你是一个数学家,只会回答数学问题","每次你都能给出详细的方案"]),

HumanMessage(content="1 + 2 * 3 = ?"),

AIMessage(content="1 + 2 * 3 的结果是7"),

]

print(messages)举例3:

python

#1.导入相关包

from langchain_core.messages import SystemMessage, HumanMessage, AIMessage

# 2.直接创建不同类型消息

systemMessage = SystemMessage(

content="你是一个AI开发工程师",

additional_kwargs={"tool": "invoke_tool()"}

)

humanMessage = HumanMessage(

content="你能开发哪些AI应用?"

)

aiMessage = AIMessage(

content="我能开发很多AI应用, 比如聊天机器人, 图像识别, 自然语言处理等"

)

# 3.打印消息列表

messages = [systemMessage,humanMessage,aiMessage]

print(messages)举例4:

python

from langchain_core.messages import (

AIMessage,

HumanMessage,

SystemMessage,

ChatMessage

)

# 创建不同类型的消息

system_message = SystemMessage(content="你是一个专业的数据科学家")

human_message = HumanMessage(content="解释一下随机森林算法")

ai_message = AIMessage(content="随机森林是一种集成学习方法...")

custom_message = ChatMessage(role="analyst", content="补充一点关于超参数调优的信息")

print(system_message.content)

print(human_message.content)

print(ai_message.content)

print(custom_message.content)举例5:结合大模型使用

python

import os

from langchain_core.messages import SystemMessage,HumanMessage

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

chat_model = ChatOpenAI(

model="gpt-4o-mini",

)

# 组成消息列表

messages = [

SystemMessage(content="你是一个擅长人工智能相关学科的专家"),

HumanMessage(content="请解释一下什么是机器学习?")

]

response = chat_model.invoke(messages)

print(response.content)

print(type(response)) #<class 'langchain_core.messages.ai.AIMessage'>3.2 关于多轮对话与上下文记忆

前提:获取大模型

python

import os

import dotenv

from langchain_openai import ChatOpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

chat_model = ChatOpenAI(

model="gpt-4o-mini"

)测试1:

python

from langchain_core.messages import SystemMessage, HumanMessage

sys_message = SystemMessage(

content="我是一个人工智能的助手,我的名字叫小智",

)

human_message = HumanMessage(content="猫王是一只猫吗?")

messages = [sys_message, human_message]

#调用大模型,传入messages

response = chat_model.invoke(messages)

print(response.content)

response1 = chat_model.invoke("你叫什么名字?")

print(response1.content)测试2:

python

from langchain_core.messages import SystemMessage, HumanMessage

sys_message = SystemMessage(

content="我是一个人工智能的助手,我的名字叫小智",

)

human_message = HumanMessage(content="猫王是一只猫吗?")

human_message1 = HumanMessage(content="你叫什么名字?")

messages = [sys_message, human_message,human_message1]

#调用大模型,传入messages

response = chat_model.invoke(messages)

print(response.content)测试3:

python

from langchain_core.messages import SystemMessage, HumanMessage

sys_message = SystemMessage(

content="我是一个人工智能的助手,我的名字叫小智",

)

human_message = HumanMessage(content="猫王是一只猫吗?")

sys_message1 = SystemMessage(

content="我可以做很多事情,有需要就找我吧",

)

human_message1 = HumanMessage(content="你叫什么名字?")

messages = [sys_message, human_message,sys_message1,human_message1]

#调用大模型,传入messages

response = chat_model.invoke(messages)

print(response.content)测试4:

python

from langchain_core.messages import SystemMessage, HumanMessage

# 第1组

sys_message = SystemMessage(

content="我是一个人工智能的助手,我的名字叫小智",

)

human_message = HumanMessage(content="猫王是一只猫吗?")

messages = [sys_message, human_message]

# 第2组

sys_message1 = SystemMessage(

content="我可以做很多事情,有需要就找我吧",

)

human_message1 = HumanMessage(content="你叫什么名字?")

messages1 = [sys_message1,human_message1]

#调用大模型,传入messages

response = chat_model.invoke(messages)

print(response.content)

response = chat_model.invoke(messages1)

print(response.content)测试5:

python

from langchain_core.messages import SystemMessage, HumanMessage, AIMessage

messages = [

SystemMessage(content="我是一个人工智能助手,我的名字叫小智"),

HumanMessage(content="人工智能英文怎么说?"),

AIMessage(content="AI"),

HumanMessage(content="你叫什么名字"),

]

messages1 = [

SystemMessage(content="我是一个人工智能助手,我的名字叫小智"),

HumanMessage(content="很高兴认识你"),

AIMessage(content="我也很高兴认识你"),

HumanMessage(content="你叫什么名字"),

]

messages2 = [

SystemMessage(content="我是一个人工智能助手,我的名字叫小智"),

HumanMessage(content="人工智能英文怎么说?"),

AIMessage(content="AI"),

HumanMessage(content="你叫什么名字"),

]

chat_model.invoke(messages2)3.3 关于模型调用的方法

为了尽可能简化自定义链的创建,我们实现了一个"Runnable"协议。许多LangChain组件实现了Runnable 协议,包括聊天模型、提示词模板、输出解析器、检索器、代理(智能体)等。

Runnable 定义的公共的调用方法如下:

invoke: 处理单条输入,等待LLM完全推理完成后再返回调用结果。stream: 流式响应,逐字输出LLM的响应结果batch: 处理批量输入。

还有对应的异步方法,应该与 asyncio 的 await 语法一起使用以实现并发:

- astream : 异步流式响应

- ainvoke : 异步处理单条输入

- abatch : 异步处理批量输入

- astream_log : 异步流式返回中间步骤,以及最终响应

- astream_events : (测试版)异步流式返回链中发生的事件(在 langchain-core 0.1.14 中引入)

3.3.1 流式输出与非流式输出

在Langchain中,语言模型的输出分为了两种主要的模式:流式输出与非流式输出。

下面是两个场景:

-

非流式输出:这是Langchain与LLM交互时的 默认行为 ,是最简单、最稳定的语言模型调用方式。

当用户发出请求后,系统在后台等待模型 生成完整响应 ,然后 一次性将全部结果返回 。

- 举例:用户提问,请编写一首诗,系统在静默数秒后 突然弹出 了完整的诗歌。(体验较单调)

- 在大多数问答、摘要、信息抽取类任务中,非流式输出提供了结构清晰、逻辑完整的结果,适合快速集成和部署。

-

流式输出:一种 更具交互感 的模型输出方式,用户不再需要等待完整答案,而是能看到模型 逐个token 地实时返回内容。

- 举例:用户提问,请编写一首诗,当问题刚刚发送,系统就开始 一字一句 (逐个token)进行回复,感觉是一边思考一边输出。

- 更像是"实时对话",更为贴近人类交互的习惯,更有吸引力。

- 适合构建强调"实时反馈"的应用,如聊天机器人、写作助手等。

- Langchain 中通过设置 stream=True 并配合 回调机制 来启用流式输出。

-

非流式输出: 默认行为,等待模型生成完整响应后一次性返回。

pythonimport os import dotenv from langchain_core.messages import HumanMessage from langchain_openai import ChatOpenAI dotenv.load_dotenv() os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1") os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL") #初始化大模型 chat_model = ChatOpenAI(model="gpt-4o-mini") # 创建消息 messages = [HumanMessage(content="你好,请介绍一下自己")] # 非流式调用LLM获取响应 response = chat_model.invoke(messages) # 打印响应内容 print(response)输出结果如下,是直接全部输出的。

举例2:

pythonimport os import dotenv from langchain_core.messages import HumanMessage, SystemMessage from langchain_openai import ChatOpenAI dotenv.load_dotenv() os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1") os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL") # 初始化大模型 chat_model = ChatOpenAI(model="gpt-4o-mini") # 支持多个消息作为输入 messages = [ SystemMessage(content="你是一位乐于助人的助手。你叫于老师"), HumanMessage(content="你是谁?") ] response = chat_model.invoke(messages) print(response.content)举例3:

pythonimport os import dotenv from langchain_core.messages import HumanMessage, SystemMessage from langchain_openai import ChatOpenAI dotenv.load_dotenv() 1 os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1") os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL") # 初始化大模型 chat_model = ChatOpenAI(model="gpt-4o-mini") # 支持多个消息作为输入 messages = [ SystemMessage(content="你是一位乐于助人的助手。你叫于老师"), HumanMessage(content="你是谁?") ] response = chat_model(messages) #特别的写法 print(response.content)第19行,底层调用 BaseChatModel.call ,内部调用的还是invoke()。后续还会有这种写法出现,了解即可。

-

流式输出:

一种更具交互感的模型输出方式,用户不再需要等待完整答案,而是能看到模型逐个 token 地实时返回内容。适合构建强调"实时反馈"的应用,如聊天机器人、写作助手等。

Langchain 中通过设置 streaming=True 并配合 回调机制 来启用流式输出。

pythonimport os import dotenv from langchain_core.messages import HumanMessage from langchain_openai import ChatOpenAI dotenv.load_dotenv() os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY") os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL") # 初始化大模型 chat_model = ChatOpenAI(model="gpt-4o-mini", streaming=True # 启用流式输出 ) # 创建消息 messages = [HumanMessage(content="你好,请介绍一下自己")] # 流式调用LLM获取响应 print("开始流式输出:") for chunk in chat_model.stream(messages): # 逐个打印内容块 print(chunk.content, end="", flush=True) # 刷新缓冲区 (无换行符,缓冲区未刷新,内容可能不会 立即显示) print("\n流式输出结束")输出结果如下(一段段文字逐个输出)

3.3.2 批量调用

python

import os

import dotenv

from langchain_core.messages import HumanMessage, SystemMessage

from langchain_openai import ChatOpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

# 初始化大模型

chat_model = ChatOpenAI(model="gpt-4o-mini")

messages1 = [SystemMessage(content="你是一位乐于助人的智能小助手"),

HumanMessage(content="请帮我介绍一下什么是机器学习"), ]

messages2 = [SystemMessage(content="你是一位乐于助人的智能小助手"),

HumanMessage(content="请帮我介绍一下什么是AIGC"), ]

messages3 = [SystemMessage(content="你是一位乐于助人的智能小助手"),

HumanMessage(content="请帮我介绍一下什么是大模型技术"), ]

messages = [messages1, messages2, messages3]

# 调用batch

response = chat_model.batch(messages)

print(response)3.3.3 同步调用与异步调用 (了解)

invoke是同步调用。

python

import time

def call_model():

# 模拟同步API调用

print("开始调用模型...")

time.sleep(5) # 模拟调用等待,单位:秒

print("模型调用完成。")

def perform_other_tasks():

# 模拟执行其他任务

for i in range(5):

print(f"执行其他任务 {i + 1}")

time.sleep(1) # 单位:秒

def main():

start_time = time.time()

call_model()

perform_other_tasks()

end_time = time.time()

total_time = end_time - start_time

return f"总共耗时:{total_time}秒"

# 运行同步任务并打印完成时间

main_time = main()

print(main_time)之前的 llm.invoke(...) 本质上是一个同步调用。每个操作依次执行,直到当前操作完成后才开始下一个操作,从而导致总的执行时间是各个操作时间的总和。

-

ainvoke是异步调用,可以使用asyncio并发执行多个请求,提高效率。异步调用,允许程序在等待某些操作完成时继续执行其他任务,而不是阻塞等待。这在处理I/O操作(如网络请求、文件读写等)时特别有用,可以显著提高程序的效率和响应性。

举例:

写法1:此写法适合Jupyter Notebook

python

import asyncio

import time

async def async_call(llm):

await asyncio.sleep(5) # 模拟异步操作

print("异步调用完成")

async def perform_other_tasks():

await asyncio.sleep(5) # 模拟异步操作

print("其他任务完成")

async def run_async_tasks():

start_time = time.time()

await asyncio.gather(

async_call(None), # 示例调用,使用None模拟LLM对象

perform_other_tasks()

)

end_time = time.time()

return f"总共耗时:{end_time - start_time}秒"

# # 正确运行异步任务的方式

# if __name__ == "__main__":

# # 使用 asyncio.run() 来启动异步程序

# result = asyncio.run(run_async_tasks())

# print(result)

# 在 Jupyter 单元格中直接调用

result = await run_async_tasks()

print(result)写法2:(此写法不适合Jupyter Notebook)

python

import asyncio

import time

async def async_call(llm):

await asyncio.sleep(5) # 模拟异步操作

print("异步调用完成")

async def perform_other_tasks():

await asyncio.sleep(5) # 模拟异步操作

print("其他任务完成")

async def run_async_tasks():

start_time = time.time()

await asyncio.gather(

async_call(None), # 示例调用,替换None为模拟的LLM对象

perform_other_tasks()

)

end_time = time.time()

return f"总共耗时:{end_time - start_time}秒"

# 正确运行异步任务的方式

if __name__ == "__main__":

# 使用 asyncio.run() 来启动异步程序

result = asyncio.run(run_async_tasks())

print(result)使用 asyncio.gather() 并行执行时,理想情况下,因为两个任务几乎同时开始,它们的执行时间将重叠。如果两个任务的执行时间相同(这里都是5秒),那么总执行时间应该接近单个任务的执行时间,而不是两者时间之和。

异步调用之ainvoke

举例1:验证ainvoke是否是异步

python

# 方式1

import inspect

print("ainvoke 是协程函数:", inspect.iscoroutinefunction(chat_model.ainvoke))

print("invoke 是协程函数:", inspect.iscoroutinefunction(chat_model.invoke))举例2:(不能在Jupyter Notebook中测试)

python

import asyncio

import os

import time

import dotenv

from langchain_core.messages import HumanMessage, SystemMessage

from langchain_openai import ChatOpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

# 初始化大模型

chat_model = ChatOpenAI(model="gpt-4o-mini")

# 同步调用(对比组)

def sync_test():

messages1 = [SystemMessage(content="你是一位乐于助人的智能小助手"),

HumanMessage(content="请帮我介绍一下什么是机器学习"), ]

start_time = time.time()

response = chat_model.invoke(messages1) # 同步调用

duration = time.time() - start_time

print(f"同步调用耗时:{duration:.2f}秒")

return response, duration

# 异步调用(实验组)

async def async_test():

messages1 = [SystemMessage(content="你是一位乐于助人的智能小助手"),

HumanMessage(content="请帮我介绍一下什么是机器学习"), ]

start_time = time.time()

response = await chat_model.ainvoke(messages1) # 异步调用

duration = time.time() - start_time

print(f"异步调用耗时:{duration:.2f}秒")

return response, duration

# 运行测试

if __name__ == "__main__":

# 运行同步测试

sync_response, sync_duration = sync_test()

print(f"同步响应内容: {sync_response.content[:100]}...\n")

# 运行异步测试

async_response, async_duration = asyncio.run(async_test())

print(f"异步响应内容: {async_response.content[:100]}...\n")

# 并发测试 - 修复版本

print("\n=== 并发测试 ===")

start_time = time.time()

async def run_concurrent_tests():

# 创建3个异步任务

tasks = [async_test() for _ in range(3)]

# 并发执行所有任务

return await asyncio.gather(*tasks)

# 执行并发测试

results = asyncio.run(run_concurrent_tests())

total_time = time.time() - start_time

print(f"\n3个并发异步调用总耗时: {total_time:.2f}秒")

print(f"平均每个调用耗时: {total_time / 3:.2f}秒")4、Model I/O之Prompt Template

Prompt Template用于通过模板管理大模型的输入,使提示词更加灵活和结构化。

4.1 介绍与分类

Prompt Template 是LangChain中的一个概念,接收用户输入,返回一个传递给LLM的信息(即提示词prompt)。

在应用开发中,固定的提示词限制了模型的灵活性和适用范围。所以,prompt template 是一个 模板化的字符串 ,你可以将 变量插入到模板 中,从而创建出不同的提示。调用时:

- 以 字典 作为输入,其中每个键代表要填充的提示模板中的变量。

- 输出一个 PromptValue 。这个 PromptValue 可以传递给 LLM 或 ChatModel,并且还可以转换为字符串或消息列表。

有几种不同类型的提示模板:

- PromptTemplate :LLM提示模板,用于生成字符串提示。它使用 Python 的字符串来模板提示。

- ChatPromptTemplate :聊天提示模板,用于组合各种角色的消息模板,传入聊天模型。

- XxxMessagePromptTemplate :消息模板词模板,包括:SystemMessagePromptTemplate、HumanMessagePromptTemplate、AIMessagePromptTemplate、ChatMessagePromptTemplate等

- FewShotPromptTemplate :样本提示词模板,通过示例来教模型如何回答

- PipelinePrompt :管道提示词模板,用于把几个提示词组合在一起使用。

- 自定义模板 :允许基于其它模板类来定制自己的提示词模板。

模版导入

python

from langchain.prompts.prompt import PromptTemplate

from langchain.prompts import ChatPromptTemplate

from langchain.prompts import FewShotPromptTemplate

from langchain.prompts.pipeline import PipelinePromptTemplate

from langchain.prompts import (

ChatMessagePromptTemplate,

SystemMessagePromptTemplate,

AIMessagePromptTemplate,

HumanMessagePromptTemplate,

)4.2 复习:str.format()

Python的 str.format() 方法是一种字符串格式化的手段,允许在 字符串中插入变量 。使用这种方法,可以创建包含 占位符 的字符串模板,占位符由花括号 {} 标识。

- 调用format()方法时,可以传入一个或多个参数,这些参数将被顺序替换进占位符中。

- str.format()提供了灵活的方式来构造字符串,支持多种格式化选项。

在LangChain的默认设置下, PromptTemplate 使用 Python 的 str.format() 方法进行模板化。这样在模型接收输入前,可以根据需要对数据进行预处理和结构化。

带有位置参数的用法

python

# 使用位置参数

info = "Name: {0}, Age: {1}".format("Jerry", 25)

print(info)带有关键字参数的用法

python

# 使用关键字参数

info = "Name: {name}, Age: {age}".format(name="Tom", age=25)

print(info)使用字典解包的方式

python

# 使用字典解包

person = {"name": "David", "age": 40}

info = "Name: {name}, Age: {age}".format(**person)

print(info)4.3 具体使用:PromptTemplate

4.3.1 使用说明

PromptTemplate类,用于快速构建 包含变量 的提示词模板,并通过 传入不同的参数值 生成自定义的提示词。

主要参数介绍:

- template:定义提示词模板的字符串,其中包含 文本 和 变量占位符(如{name}) ;

- input_variables: 列表,指定了模板中使用的变量名称,在调用模板时被替换;

- partial_variables:字典,用于定义模板中一些固定的变量名。这些值不需要再每次调用时被替换。

函数介绍:

- format():给input_variables变量赋值,并返回提示词。利用format() 进行格式化时就一定要赋值,否则会报错。当在template中未设置input_variables,则会自动忽略。

4.3.2 两种实例化方式

方式1:构造方法

python

from langchain.prompts import PromptTemplate

# 定义模板:描述主题的应用

template = PromptTemplate(template="请简要描述{topic}的应用。",

input_variables=["topic"])

print(template)

# 使用模板生成提示词

prompt_1 = template.format(topic="机器学习")

prompt_2 = template.format(topic="自然语言处理")

print("提示词1:", prompt_1)

print("提示词2:", prompt_2)可以直观的看到PromptTemplate可以将template中声明的变量topic准确提取出来,使prompt更清晰。

举例2:定义多变量模板

python

from langchain.prompts import PromptTemplate

#定义多变量模板

template = PromptTemplate(

template="请评价{product}的优缺点,包括{aspect1}和{aspect2}。",

input_variables=["product", "aspect1", "aspect2"])

#使用模板生成提示词

prompt_1 = template.format(product="智能手机", aspect1="电池续航", aspect2="拍照质量")

prompt_2 = template.format(product="笔记本电脑", aspect1="处理速度", aspect2="便携性")

print("提示词1:",prompt_1)

print("提示词2:",prompt_2)方式2:调用from_template()

举例1:

python

from langchain.prompts import PromptTemplate

prompt_template = PromptTemplate.from_template(

"请给我一个关于{topic}的{type}解释。"

)

#传入模板中的变量名

prompt = prompt_template.format(type="详细", topic="量子力学")

print(prompt)举例2:模板支持任意数量的变量,包括不含变量:

python

#1.导入相关的包

from langchain_core.prompts import PromptTemplate

# 2.定义提示词模版对象

text = """

Tell me a joke

"""

prompt_template = PromptTemplate.from_template(text)

# 3.默认使用f-string进行格式化(返回格式好的字符串)

prompt = prompt_template.format()

print(prompt)4.3.3 两种新的结构形式

- 部分提示词模板 : 使用

partial_variables或.partial()方法预填充部分变量。 - 组合提示词 : 使用

+操作符连接多个模板。

形式1:部分提示词模版

在生成prompt前就已经提前初始化部分的提示词,实际进一步导入模版的时候只导入除已初始化的变量即可。

举例1:

方式1:实例化过程中使用partial_variables变量

python

from langchain.prompts import PromptTemplate

#方式2:

template2 = PromptTemplate(

template="{foo}{bar}",

input_variables=["foo","bar"],

partial_variables={"foo": "hello"}

)

prompt2 = template2.format(bar="world")

print(prompt2)方式2:使用 PromptTemplate.partial() 方法创建部分提示模板

python

from langchain.prompts import PromptTemplate

template1 = PromptTemplate(

template="{foo}{bar}",

input_variables=["foo", "bar"]

)

#方式1:

partial_template1 = template1.partial(foo="hello")

prompt1 = partial_template1.format(bar="world")

print(prompt1)举例2:

python

from langchain_core.prompts import PromptTemplate

# 完整模板

full_template = """你是一个{role},请用{style}风格回答:

问题:{question}

答案:"""

# 预填充角色和风格

partial_template = PromptTemplate.from_template(full_template).partial(

role="资深厨师",

style="专业但幽默"

)

# 只需提供剩余变量

print(partial_template.format(question="如何煎牛排?"))举例3:

python

prompt_template = PromptTemplate.from_template(

template = "请评价{product}的优缺点,包括{aspect1}和{aspect2}。",

partial_variables= {"aspect1":"电池","aspect2":"屏幕"}

)

prompt= prompt_template.format(product="笔记本电脑")

print(prompt)形式2:组合提示词(了解)

举例:

python

from langchain_core.prompts import PromptTemplate

template = (

PromptTemplate.from_template("Tell me a joke about {topic}")

+ ", make it funny"

+ "\n\nand in {language}"

)

prompt = template.format(topic="sports", language="spanish")

print(prompt)4.3.4 format()与invoke()

只要对象是RunnableSerializable接口类型,都可以使用invoke(),替换前面使用format()的调用方式

format(),返回值为字符串类型;invoke(),返回值为PromptValue类型,接着调用to_string()返回字符串。

举例1:

python

#1.导入相关的包

from langchain_core.prompts import PromptTemplate

# 2.定义提示词模版对象

prompt_template = PromptTemplate.from_template(

"Tell me a {adjective} joke about {content}."

)

# 3.默认使用f-string进行格式化(返回格式好的字符串)

prompt_template.invoke({"adjective":"funny", "content":"chickens"})举例2:

python

#1.导入相关的包

from langchain_core.prompts import PromptTemplate

# 2.使用初始化器进行实例化

prompt = PromptTemplate(

input_variables=["adjective", "content"],

template="Tell me a {adjective} joke about {content}")

# 3. PromptTemplate底层是RunnableSerializable接口 所以可以直接使用invoke()调用

prompt.invoke({"adjective": "funny", "content": "chickens"})举例3:

python

from langchain_core.prompts import PromptTemplate

prompt_template = (

PromptTemplate.from_template("Tell me a joke about {topic}")

+ ", make it funny"

+ " and in {language}"

)

prompt = prompt_template.invoke({"topic":"sports", "language":"spanish"})

print(prompt)4.3.5 结合LLM调用

Prompt 与大模型结合。

问题:这里的大模型,是哪类呢?非对话大模型?对话大模型?

提供大模型:(非对话大模型)

python

import os

import dotenv

from langchain_openai import OpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

llm = OpenAI()提供大模型:(对话大模型)

python

import os

import dotenv

from langchain_openai import ChatOpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

llm = ChatOpenAI(

model="gpt-4o-mini"

)调用过程:

python

prompt_template = PromptTemplate.from_template(

template = "请评价{product}的优缺点,包括{aspect1}和{aspect2}。"

)

prompt = prompt_template.format(product="电脑",aspect1="性能",aspect2="电池")

# prompt = prompt_template.invoke({"product":"电脑","aspect1":"性能","aspect2":"电池"})

print(type(prompt))

# llm.invoke(prompt) #使用非对话模型调用

llm1.invoke(prompt) #使用对话模型调用4.4 具体使用:ChatPromptTemplate

专为聊天模型设计,用于创建消息列表。

4.4.1 使用说明

ChatPromptTemplate是创建 聊天消息列表 的提示模板。它比普通 PromptTemplate 更适合处理多角色、多轮次的对话场景。

特点:

- 支持 System / Human / AI 等不同角色的消息模板

- 对话历史维护

参数类型:列表参数格式是tuple类型( role :str content :str 组合最常用)

元组的格式为:(role: str | type, content: str | list[dict] | list[object])

- 其中 role 是:字符串(如 "system" 、 "human" 、 "ai" )

4.4.2 两种实例化方式

方式1:使用构造方法

举例:

python

from langchain_core.prompts import ChatPromptTemplate

#参数类型这里使用的是tuple构成的list

prompt_template = ChatPromptTemplate([

# 字符串 role + 字符串 content

("system", "你是一个AI开发工程师. 你的名字是 {name}."),

("human", "你能开发哪些AI应用?"),

("ai", "我能开发很多AI应用, 比如聊天机器人, 图像识别, 自然语言处理等."),

("human", "{user_input}")

])

#调用format()方法,返回字符串

prompt = prompt_template.invoke(input={"name":"小谷AI","user_input":"你能帮我做什么?"})

print(type(prompt))

print(prompt)方式2:调用from_messages()

举例1:

python

# 导入相关依赖

from langchain_core.prompts import ChatPromptTemplate

# 定义聊天提示词模版

chat_template = ChatPromptTemplate.from_messages(

[

("system", "你是一个有帮助的AI机器人,你的名字是{name}。"),

("human", "你好,最近怎么样?"),

("ai", "我很好,谢谢!"),

("human", "{user_input}"),

]

)

# 格式化聊天提示词模版中的变量

messages = chat_template.invoke(input={"name":"小明", "user_input":"你叫什么名字?"})

# 打印格式化后的聊天提示词模版内容

print(messages)举例2:了解

python

# 示例 1: role 为字符串

from langchain_core.prompts import ChatPromptTemplate

prompt = ChatPromptTemplate.from_messages([

("system", "你是一个{role}."),

("human", "{user_input}"),

])

# 示例 2: role 为消息类 不支持

from langchain_core.messages import SystemMessage, HumanMessage

# prompt = ChatPromptTemplate.from_messages([

# (SystemMessage, "你是一个{role}."), # 类对象 role + 字符串 content

# (HumanMessage, ["你好!", {"type": "text"}]), # 类对象 role + list[dict] content

# ])

# 修改

prompt = ChatPromptTemplate.from_messages([

("system", ["你好!", {"type": "text"}]), # 字符串 role + list[dict] content

])4.4.3 模板调用的几种方式对比

invoke(): 返回ChatPromptValue对象。format(): 返回格式化后的字符串。format_messages(): 推荐 ,返回可以直接传给聊天模型的消息列表List[BaseMessage]。format_prompt(): 返回PromptValue对象。

方式1:使用 invoke(),前面已经讲过

python

from langchain_core.prompts import ChatPromptTemplate

#参数类型这里使用的是tuple构成的list

prompt_template = ChatPromptTemplate([

# 字符串 role + 字符串 content

("system", "你是一个AI开发工程师. 你的名字是 {name}."),

("human", "你能开发哪些AI应用?"),

("ai", "我能开发很多AI应用, 比如聊天机器人, 图像识别, 自然语言处理等."),

("human", "{user_input}")

])

prompt = prompt_template.invoke({"name":"小谷AI", "user_input":"你能帮我做什么?"})

print(type(prompt))

print(prompt)

print(len(prompt.messages))方式2:使用format()

python

from langchain_core.prompts import ChatPromptTemplate

#参数类型这里使用的是tuple构成的list

prompt_template = ChatPromptTemplate([

# 字符串 role + 字符串 content

("system", "你是一个AI开发工程师. 你的名字是 {name}."),

("human", "你能开发哪些AI应用?"),

("ai", "我能开发很多AI应用, 比如聊天机器人, 图像识别, 自然语言处理等."),

("human", "{user_input}")

])

#方式1:调用format()方法,返回字符串

prompt = prompt_template.format(name="小谷AI", user_input="你能帮我做什么?")

print(type(prompt))

print(prompt)方式3:使用format_messages()

python

from langchain_core.prompts import ChatPromptTemplate

prompt_template = ChatPromptTemplate([

("system", "你是一个AI开发工程师. 你的名字是 {name}."),

("human", "你能开发哪些AI应用?"),

("ai", "我能开发很多AI应用, 比如聊天机器人, 图像识别, 自然语言处理等."),

("human", "{user_input}")

])

#调用format_messages()方法,返回消息列表

prompt2 = prompt_template.format_messages(name="小谷AI", user_input="你能帮我做什么?")

print(type(prompt2))

print(prompt2)结论:给占位符赋值,针对于ChatPromptTemplate,推荐使用 format_messages() 方法,返回消息列表。

方式4:使用format_prompt()

python

from langchain_core.prompts import ChatPromptTemplate

#参数类型这里使用的是tuple构成的list

prompt_template = ChatPromptTemplate([

# 字符串 role + 字符串 content

("system", "你是一个AI开发工程师. 你的名字是 {name}."),

("human", "你能开发哪些AI应用?"),

("ai", "我能开发很多AI应用, 比如聊天机器人, 图像识别, 自然语言处理等."),

("human", "{user_input}")

])

prompt = prompt_template.format_prompt(name="小谷AI", user_input="你能帮我做什么?")

print(prompt.to_messages())

print(type(prompt.to_messages()))

#print(prompt.to_string())

#print(type(prompt.to_string()))4.4.4 更丰富的实例化参数类型

前面讲了ChatPromptTemplate的两种创建方式。我们看到不管使用构造方法,还是使用from_messages(),参数类型都是 列表类型 。列表中的元素可以是多种类型,前面我们主要测试了元组类型。

源码:

python

def __init__(self,

messages: Sequence[BaseMessagePromptTemplate | BaseMessage |

BaseChatPromptTemplate | tuple[str | type, str | list[dict] | list[object]] | str | dict[str, Any]],

*,

template_format: Literal["f-string", "mustache", "jinja2"] = "f-string",

**kwargs: Any) -> None源码:

python

@classmethod def from_messages(cls,

messages: Sequence[BaseMessagePromptTemplate | BaseMessage |

BaseChatPromptTemplate | tuple[str | type, str | list[dict] | list[object]] | str | dict[str, Any]],

template_format: Literal["f-string", "mustache", "jinja2"] = "f-string")

-> ChatPromptTemplate结论:参数是列表类型,列表的元素可以是字符串、字典、字符串构成的元组、消息类型、提示词模板类型、消息提示词模板类型等

类型1:str类型

列表参数格式是str类型(不推荐),因为默认角色都是human

python

#1.导入相关依赖

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.messages import SystemMessage,HumanMessage, AIMessage

# 2.定义聊天提示词模版

chat_template = ChatPromptTemplate.from_messages(

[

"Hello, {name}!" # 等价于 ("human", "Hello, {name}!")

]

)

#1.导入相关依赖

from langchain_core.prompts import ChatPromptTemplate

from langchain_core.messages import SystemMessage,HumanMessage, AIMessage

# 2.定义聊天提示词模版

chat_template = ChatPromptTemplate.from_messages(

[

"Hello, {name}!" # 等价于 ("human", "Hello, {name}!")

]

)类型2:dict类型

列表参数格式是dict类型

python

# 示例: 字典形式的消息

prompt = ChatPromptTemplate.from_messages([

{"role": "system", "content": "你是一个{role}."},

{"role": "human", "content": ["复杂内容", {"type": "text"}]},

])

print(prompt.format_messages(role="教师"))类型3:Message类型

python

from langchain_core.messages import SystemMessage,HumanMessage

chat_prompt_template = ChatPromptTemplate.from_messages([

SystemMessage(content="我是一个贴心的智能助手"),

HumanMessage(content="我的问题是:人工智能英文怎么说?")

])

messages = chat_prompt_template.format_messages()

print(messages)

print(type(messages))类型4:BaseChatPromptTemplate类型

使用 BaseChatPromptTemplate,可以理解为ChatPromptTemplate里嵌套了ChatPromptTemplate。

举例1:不带参数

python

from langchain_core.prompts import ChatPromptTemplate

# 使用 BaseChatPromptTemplate(嵌套的 ChatPromptTemplate)

nested_prompt_template1 = ChatPromptTemplate.from_messages([("system", "我是一个人工智

能助手")])

nested_prompt_template2 = ChatPromptTemplate.from_messages([("human", "很高兴认识你")])

prompt_template = ChatPromptTemplate.from_messages([

nested_prompt_template1,nested_prompt_template2

])

prompt_template.format_messages()举例2:带参数

python

from langchain_core.prompts import ChatPromptTemplate

# 使用 BaseChatPromptTemplate(嵌套的 ChatPromptTemplate)

nested_prompt_template1 = ChatPromptTemplate.from_messages([

("system", "我是一个人工智能助手,我的名字叫{name}")

])

nested_prompt_template2 = ChatPromptTemplate.from_messages([

("human", "很高兴认识你,我的问题是{question}")

])

prompt_template = ChatPromptTemplate.from_messages([

nested_prompt_template1,nested_prompt_template2

])

prompt_template.format_messages(name="小智",question="你为什么这么帅?")类型5:BaseMessagePromptTemplate类型

LangChain提供不同类型的MessagePromptTemplate。最常用的是SystemMessagePromptTemplate 、 HumanMessagePromptTemplate 和AIMessagePromptTemplate ,分别创建系统消息、人工消息和AI消息,它们是ChatMessagePromptTemplate的特定角色子类。

基本概念:

HumanMessagePromptTemplate,专用于生成 用户消息(HumanMessage) 的模板类,是ChatMessagePromptTemplate的特定角色子类。

- 本质 :预定义了 role="human" 的 MessagePromptTemplate,且无需无需手动指定角色

- 模板化 :支持使用变量占位符,可以在运行时填充具体值

- 格式化 :能够将模板与输入变量结合生成最终的聊天消息

- 输出类型 :生成 HumanMessage 对象( content + role="human" )

- 设计目的 :简化用户输入消息的模板化构造,避免重复定义角色

SystemMessagePromptTemplate、AIMessagePromptTemplate:类似于上面,不再赘述

ChatMessagePromptTemplate,用于构建聊天消息的模板。它允许你创建可重用的消息模板,这些模板可以动态地插入变量值来生成最终的聊天消息

- 角色指定 :可以为每条消息指定角色(如 "system"、"human"、"ai") 等,角色灵活。

- 模板化 :支持使用变量占位符,可以在运行时填充具体值

- 格式化 :能够将模板与输入变量结合生成最终的聊天消息

举例1:

python

# 导入聊天消息类模板

from langchain_core.prompts import ChatPromptTemplate, HumanMessagePromptTemplate,

SystemMessagePromptTemplate

# 创建消息模板

system_template = "你是一个专家{role}"

system_message_prompt = SystemMessagePromptTemplate.from_template(system_template)

human_template = "给我解释{concept},用浅显易懂的语言"

human_message_prompt = HumanMessagePromptTemplate.from_template(human_template)

# 组合成聊天提示模板

chat_prompt = ChatPromptTemplate.from_messages([system_message_prompt,

human_message_prompt])

# 格式化提示

formatted_messages = chat_prompt.format_messages(

role="物理学家",

concept="相对论"

)

print(formatted_messages)举例2:ChatMessagePromptTemplate的理解

python

# 1.导入先关包

from langchain_core.prompts import ChatMessagePromptTemplate

# 2.定义模版

prompt = "今天我们授课的内容是{subject}"

# 3.创建自定义角色聊天消息提示词模版

chat_message_prompt = ChatMessagePromptTemplate.from_template(

role="teacher", template=prompt

)

# 4.格式聊天消息提示词

resp = chat_message_prompt.format(subject="我爱北京天安门")

print(type(resp))

print(resp)举例3:综合使用

python

from langchain_core.prompts import (

ChatPromptTemplate,

SystemMessagePromptTemplate,

HumanMessagePromptTemplate,

)

from langchain_core.messages import SystemMessage, HumanMessage

# 示例 1: 使用 BaseMessagePromptTemplate

system_prompt = SystemMessagePromptTemplate.from_template("你是一个{role}.")

human_prompt = HumanMessagePromptTemplate.from_template("{user_input}")

# 示例 2: 使用 BaseMessage(已实例化的消息)

system_msg = SystemMessage(content="你是一个AI工程师。")

human_msg = HumanMessage(content="你好!")

# 示例 3: 使用 BaseChatPromptTemplate(嵌套的 ChatPromptTemplate)

nested_prompt = ChatPromptTemplate.from_messages([("system", "嵌套提示词")])

prompt = ChatPromptTemplate.from_messages([

system_prompt, # MessageLike (BaseMessagePromptTemplate)

human_prompt, # MessageLike (BaseMessagePromptTemplate)

system_msg, # MessageLike (BaseMessage)

human_msg, # MessageLike (BaseMessage)

nested_prompt, # MessageLike (BaseChatPromptTemplate)

])

prompt.format_messages(role="人工智能专家",user_input="介绍一下大模型的应用场景")类似的:

python

from langchain_core.messages import HumanMessage, AIMessage

from langchain_core.prompts import HumanMessagePromptTemplate,

SystemMessagePromptTemplate

from langchain_core.prompts import ChatPromptTemplate

chat_template = ChatPromptTemplate.from_messages(

[

SystemMessagePromptTemplate.from_template("你是一个AI开发工程师. 你的名字是

{name}."),

HumanMessage(content=("你能开发哪些AI应用?")),

AIMessage(content=("我能开发很多AI应用, 比如聊天机器人, 图像识别, 自然语言处理等.")),

HumanMessagePromptTemplate.from_template("{input}")

]

)

messages = chat_template.format_messages(input="你能帮我做什么?", name="小谷AI")

print(messages)4.4.5 结合LLM

举例1:

python

from langchain.prompts.chat import ChatPromptTemplate

######1、提供提示词#########

chat_prompt = ChatPromptTemplate.from_messages([

("system", "你是一个数学家,你可以计算任何算式"),

("human", "我的问题:{question}"),

])

# 输入提示

messages = chat_prompt.format_messages(question="我今年18岁,我的舅舅今年38岁,我的爷爷今年72岁,我和舅舅一共多少岁了?")

#print(messages)

######2、提供大模型#########

import os

import dotenv

from langchain_openai import ChatOpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

chat_model = ChatOpenAI(model="gpt-4o-mini")

######3、结合提示词,调用大模型#########

# 得到模型的输出

output = chat_model.invoke(messages)

# 打印输出内容

print(output.content)举例2:

python

from dotenv import load_dotenv

from langchain.prompts.chat import SystemMessagePromptTemplate,

HumanMessagePromptTemplate, AIMessagePromptTemplate

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

load_dotenv()

llm = ChatOpenAI()

template = ChatPromptTemplate.from_messages(

[

SystemMessagePromptTemplate.from_template("你是{product}的客服助手。你的名字叫{name}"),

HumanMessagePromptTemplate.from_template("hello 你好吗?"),

AIMessagePromptTemplate.from_template("我很好 谢谢!"),

HumanMessagePromptTemplate.from_template("{query}"),

]

)

prompt = template.format_messages(

product="AGI课堂",

name="Bob",

query="你是谁"

)

# 提供聊天模型

import os

import dotenv

from langchain_openai import ChatOpenAI

dotenv.load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv("OPENAI_API_KEY1")

os.environ['OPENAI_BASE_URL'] = os.getenv("OPENAI_BASE_URL")

chat_model = ChatOpenAI(model="gpt-4o-mini")

# 调用聊天模型

response = chat_model.invoke(prompt)

print(response.content)4.4.6 插入消息列表:MessagesPlaceholder

当你不确定消息提示模板使用什么角色,或者希望在格式化过程中 插入消息列表 时,该怎么办? 这就需要使用 MessagesPlaceholder,负责在特定位置添加消息列表。

使用场景:多轮对话系统存储历史消息以及Agent的中间步骤处理此功能非常有用。

举例1:

python

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholder

from langchain_core.messages import HumanMessage

prompt_template = ChatPromptTemplate.from_messages([

("system", "You are a helpful assistant"),

MessagesPlaceholder("msgs")

])

# prompt_template.invoke({"msgs": [HumanMessage(content="hi!")]})

prompt_template.format_messages(msgs=[HumanMessage(content="hi!")])这将生成两条消息,第一条是系统消息,第二条是我们传入的 HumanMessage。 如果我们传入了 5 条消息,那么总共会生成 6 条消息(系统消息加上传入的 5 条消息)。 这对于将一系列消息插入到特定位置非常有用。

举例2:存储对话历史内容

python

from langchain_core.prompts import ChatPromptTemplate, MessagesPlaceholder

from langchain_core.messages import AIMessage

prompt = ChatPromptTemplate.from_messages(

[

("system", "You are a helpful assistant."),

MessagesPlaceholder("history"),

("human", "{question}")

]

)

prompt.format_messages(

history=[HumanMessage(content="1+2*3 = ?"),AIMessage(content="1+2*3=7")],

question="我刚才问题是什么?")

# prompt.invoke(

# {

# "history": [("human", "what's 5 + 2"), ("ai", "5 + 2 is 7")],

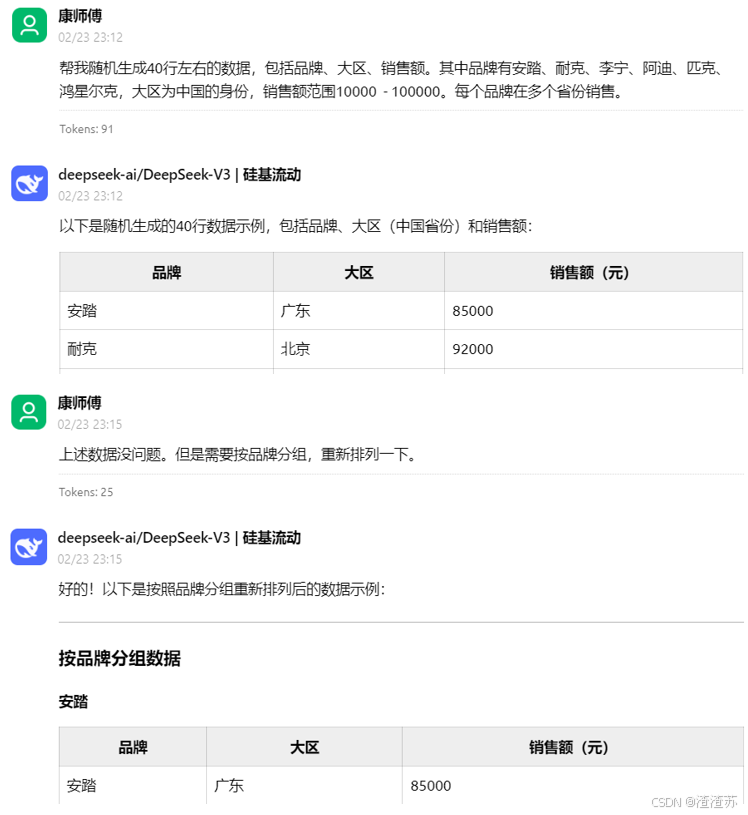

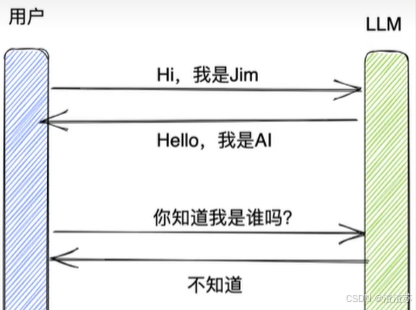

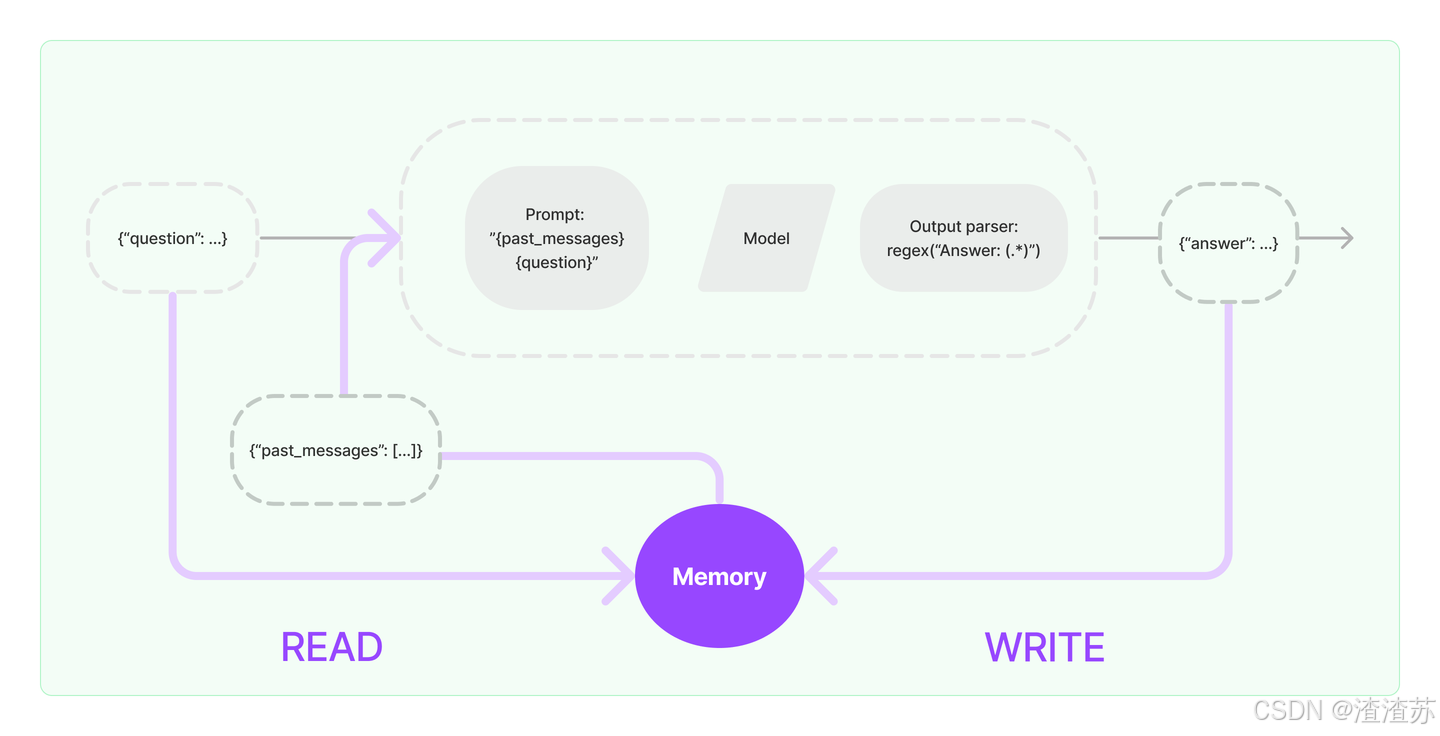

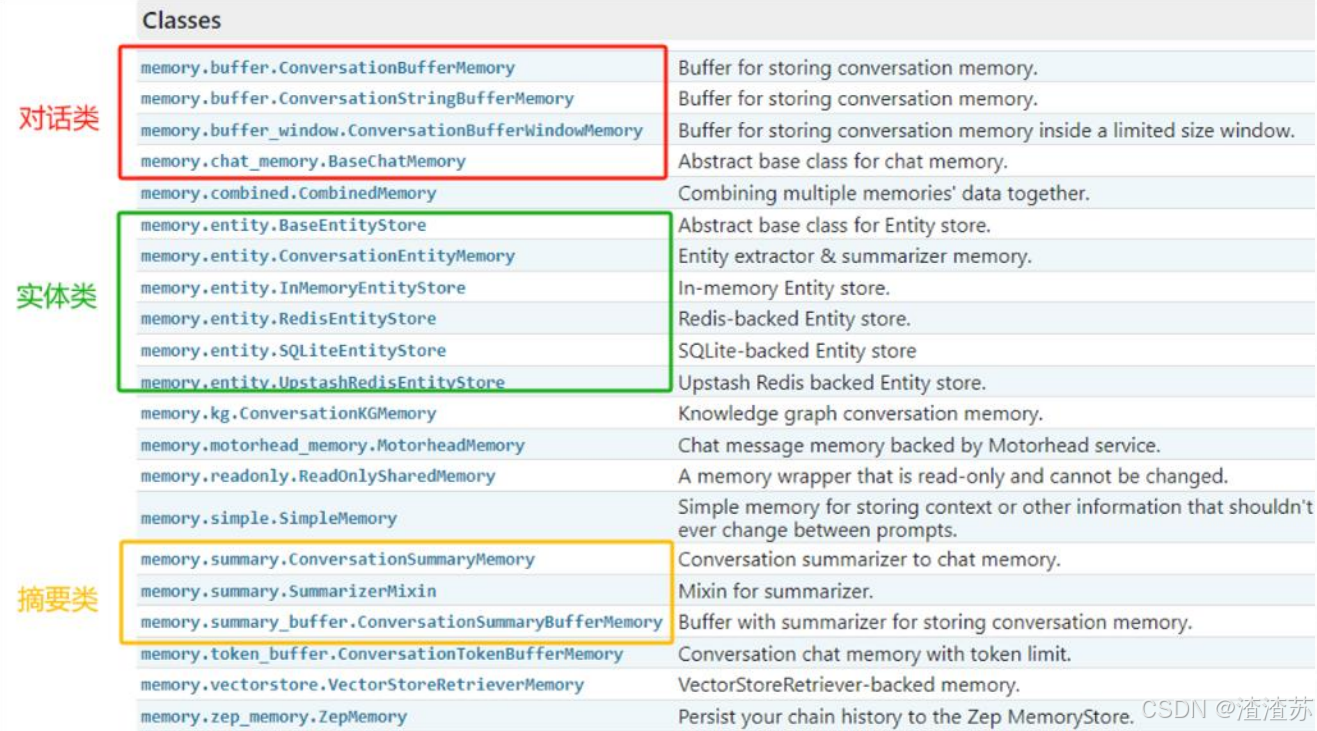

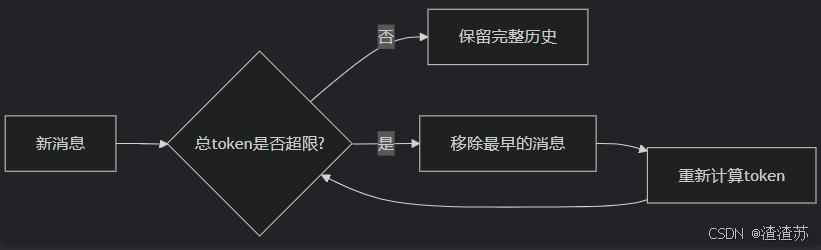

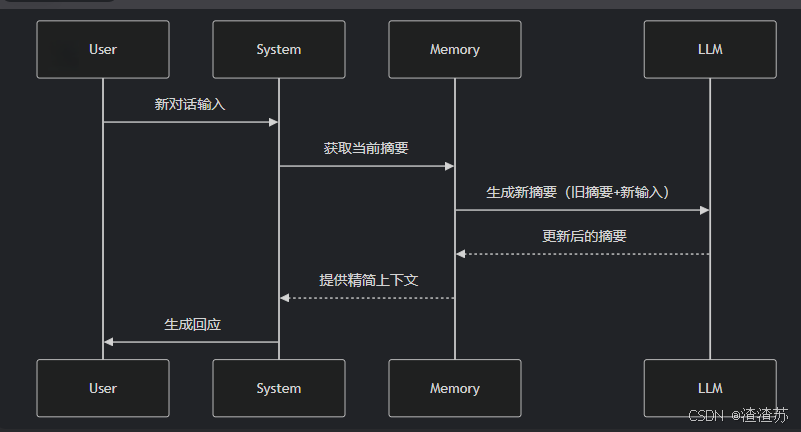

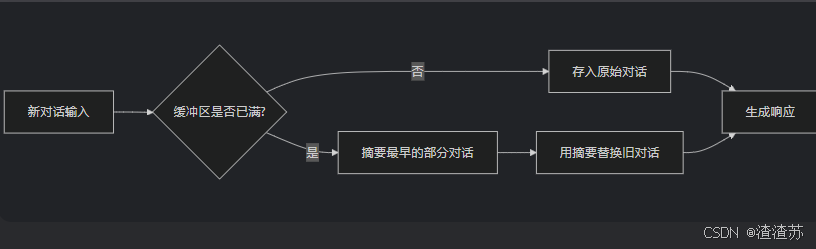

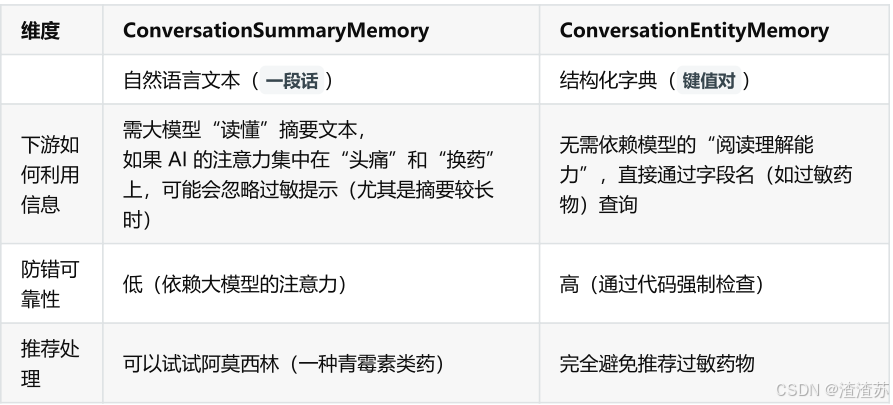

# "question": "now multiply that by 4"