引言:被割裂的 AI 体验

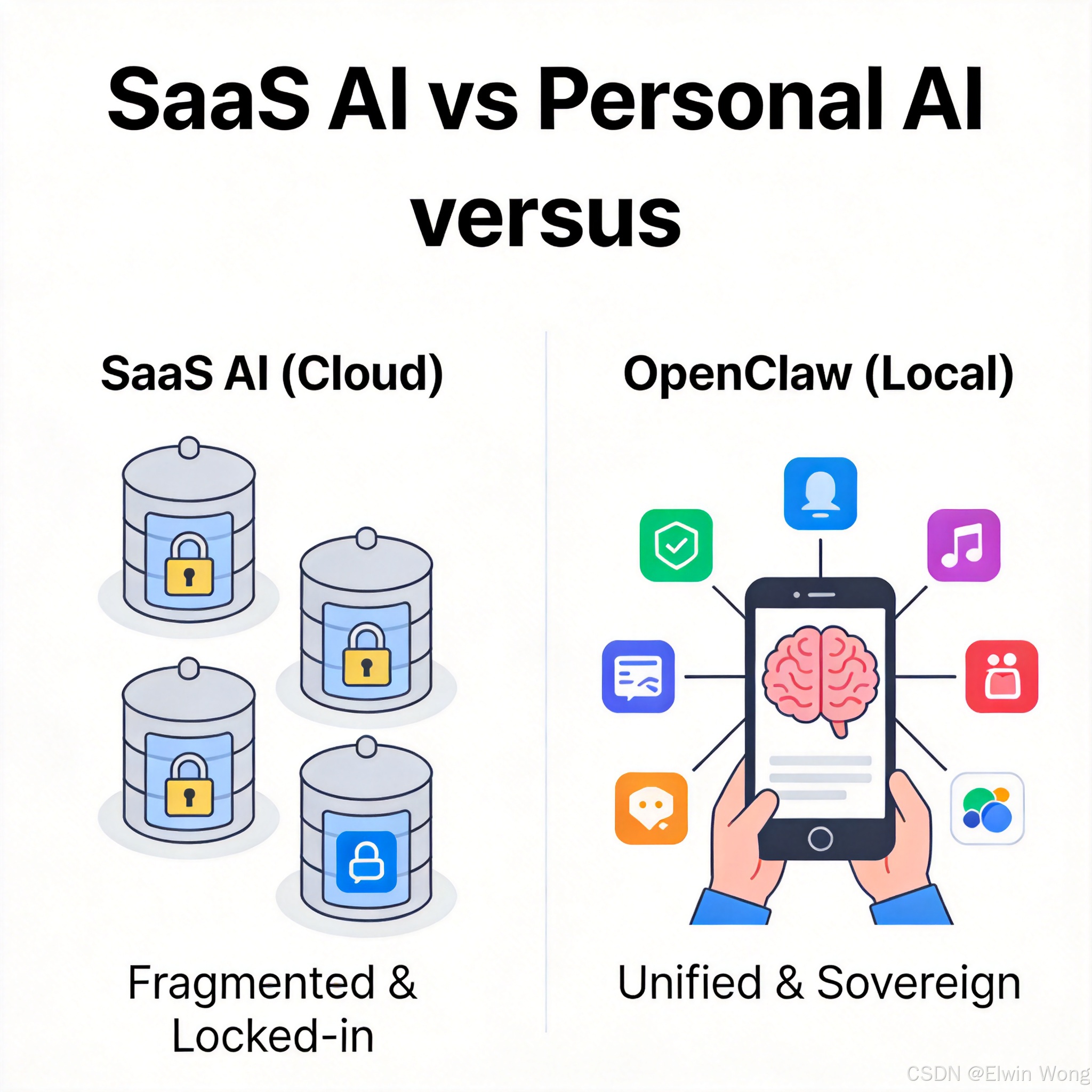

虽然大语言模型(LLM)已经展现出惊人的能力,但作为普通用户,我们的 AI 体验依然是支离破碎的。

工作时,我们求助于 IDE 里的 Copilot;写文档时,我们切换到 ChatGPT 的网页版;而在回家的路上想设置一个提醒,我们又得对着 Siri 喊话。这些 AI 助手虽然各自强大,但它们之间互不通气。ChatGPT 不知道你刚刚在 Copilot 里写的代码,Siri 也不了解你在 ChatGPT 里规划的旅行路线。

更重要的是,它们都不属于你。你的对话数据存储在云端,你的偏好设置被锁定在特定的 App 围墙内。

真正的个人 AI 助理,应该像钢铁侠的"贾维斯"(J.A.R.V.I.S.):

- 它跟着人走,而不是人去适应不同的 App。

- 它拥有连贯的记忆,无论你在哪里呼唤它,它都知道前因后果。

- 它绝对忠诚,运行在你的设备上,只为你服务。

这就是 OpenClaw 项目诞生的初衷。作为一个开源的 Personal AI Assistant,它不仅仅是又一个 Chatbot,而是试图构建一种全新的、Local-first(本地优先) 的 AI 操作系统。

核心哲学:为什么 AI 必须 Local-first?

OpenClaw 的核心理念被称为 "The Lobster Way" ------ 像龙虾一样拥有坚硬的外壳(隐私保护)和强大的钳子(执行能力)。这一理念主要体现在两个方面:

数据主权:从"租用算力"到"拥有算力"

目前的 AI 服务大多是 SaaS 模式,你是在租用别人的大脑。而 OpenClaw 强调 Bring Your Own Device (BYOD)。

- 配置在本地 :你的 Prompt、你的习惯、你的 API Key 都存储在本地文件系统(

~/.openclaw)。 - 记忆在本地:OpenClaw 的记忆库(Memory Bank)运行在本地数据库中,不上传云端。这意味着即使断网,你的 AI 依然记得你是谁。

- 逻辑在本地:除了必要的 LLM 推理(你可以选择调用 OpenAI/Claude,也可以跑本地模型如 Llama 3),所有的业务逻辑、工具调用都在本地执行。

全渠道(Omni-channel):AI 是一种能力,不是一个 App

OpenClaw 认为,AI 不应该是一个需要你专门去打开的 App,而应该是一种无处不在的"能力"。

想象这样一个场景:

- 你在 Slack 上让 OpenClaw 帮你查一个服务器的日志。

- 下班路上,你在 WhatsApp 上问它:"刚才查的日志里有没有报错?"

- 它能立刻回答,因为它记得你在 Slack 上的对话。

这种体验的实现,依赖于 OpenClaw 强大的 Gateway 架构,它将 WhatsApp、Telegram、Discord、Signal 等主流聊天平台全部打通,汇聚成统一的输入流。

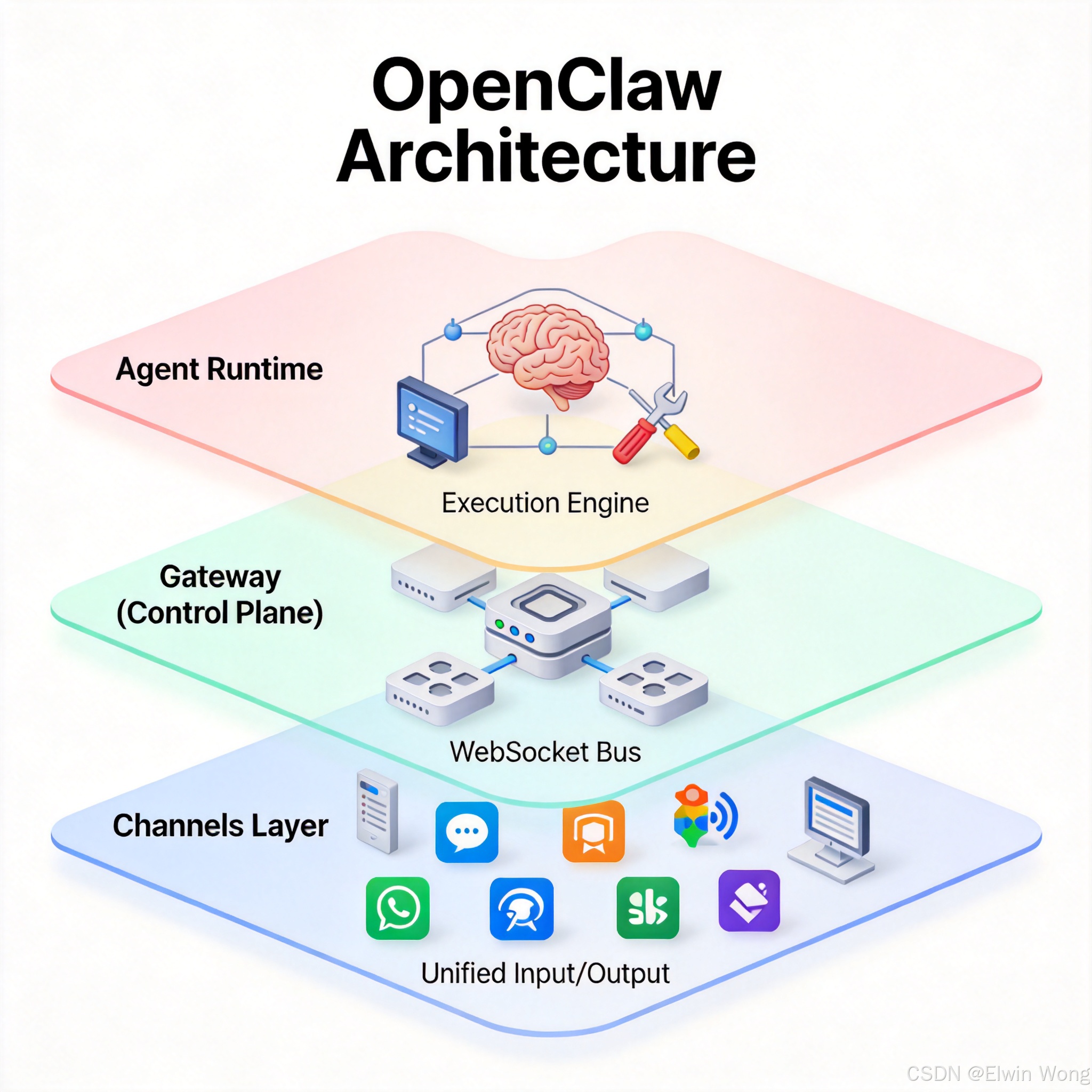

架构解密:构建 AI 的"神经中枢"

为了实现上述愿景,OpenClaw 设计了一套独特的架构。它不只是一个简单的消息转发器,更像是一个微型的操作系统。

Gateway:基于 WebSocket 的控制总线

OpenClaw 的心脏是 Gateway 。它并不直接处理业务逻辑,而是作为一个高效的控制平面 (Control Plane)。

- 协议标准化 :不同的 IM 平台协议千差万别(WhatsApp 是即时消息,Slack 是事件订阅)。Gateway 通过适配器层(Adapters)将这些异构数据标准化为统一的

Message对象。 - WebSocket 长连接:Gateway 与具体的执行单元(Agent)之间通过 WebSocket 保持全双工通信。这使得 Agent 可以部署在任何地方(本机、内网服务器、甚至另一台树莓派),只要能连上 Gateway 即可。

go

// 简化的 Gateway 消息处理逻辑

type Gateway struct {

sessMgr *SessionManager

}

func (g *Gateway) HandleMessage(msg IncomingMessage) {

// 1. 识别用户身份 (User Identity)

userId := g.resolveIdentity(msg)

// 2. 查找或创建会话 (Session)

session := g.sessMgr.GetSession(userId)

// 3. 路由给对应的 Agent Runtime

session.Dispatch(msg)

}Universal Session:跨平台的记忆连续性

如何让 AI 在 WhatsApp 和 Slack 之间"无缝衔接"?秘密在于 Session Manager。

OpenClaw 维护了一个全局的会话映射表。它将不同平台的 User ID(如 whatsapp:+12345 和 slack:U9876)映射到同一个 Persona(数字人格)。

当消息到达时,系统会:

- 归一化:识别出这是"主人"发来的消息。

- 上下文加载:从本地向量数据库中加载该用户的短期记忆和长期记忆。

- 状态同步:Agent 的思考状态(Thinking State)会实时推送到所有连接的客户端。你在电脑上看到 AI 正在"输入中",手机上也会同步显示。

Agent Runtime:安全的执行引擎

Agent Runtime 是真正"干活"的地方。它负责调用 LLM 进行推理,并执行工具(Tools)。

OpenClaw 特别强调安全性 。因为 AI 运行在本地,如果不加限制地执行 rm -rf / 将是灾难性的。因此,Runtime 引入了权限分级机制:

- 只读操作(如搜索、读取文件):默认允许。

- 敏感操作 (如修改文件、执行 Shell 命令):需要通过特殊的

system.run接口,并经过用户确认或白名单配置。

突破边界:从聊天到控制物理世界

OpenClaw 最令人兴奋的特性,是它打破了"聊天软件"的边界,延伸到了物理设备。

Nodes:分布式触手

通过 Nodes 机制,OpenClaw 可以控制多台设备。

- 场景:你出门在外,想查看家里电脑的运行状态。

- 实现:你在家里的 Mac 上运行一个 OpenClaw Node。你在手机 Telegram 上发指令:"截个图发给我"。Gateway 会将指令路由给 Mac Node,Node 调用 macOS 的原生 API 截图,并通过加密通道回传给你的手机。

这实际上构建了一个分布式的 AI 物联网,你的每一台设备都成为了 AI 的手和眼。

Skills:无限扩展的能力

OpenClaw 引入了类似 App Store 的 ClawHub 技能市场。开发者可以编写自定义的 Skill(通常是一个简单的 TypeScript 或 Python 脚本),一键安装到自己的 OpenClaw 中。

从查询加密货币价格,到管理 Notion 笔记,再到控制智能家居,Skills 让 OpenClaw 的能力边界无限扩展。

总结与展望

OpenClaw 让我们看到了 AI 的另一种未来。

在这个未来里,AI 不再是巨头垄断的中心化服务,而是分布式的、个人拥有的智能节点。它像 Linux 一样开放,像 Git 一样分布,像你的日记本一样私密。

如果你厌倦了在不同的 AI App 之间反复横跳,或者担心你的数据隐私,那么 OpenClaw 值得你一试。它不仅是一个工具,更是一场关于"数据主权"的技术实验。