说明:

我对各类AI助手在辅助学习、整理资料和启发思路上展现的潜力充满兴趣。然而,作为一名学生,直接订阅动辄每月上百元的官方服务是一笔不小的开销;之前尝试使用虚拟信用卡申请官方API,也遭遇了账户被封禁的窘境。

于是,我在网络上找到了一份由第三方服务商提供的、价格低廉的"Chatbox配置教程"。这份教程承诺能以较低成本,通过一个名为Chatbox的桌面客户端,访问包括GPT、Gemini、Claude在内的多种大模型。这引起了我强烈的好奇:它是如何实现的?背后隐藏着怎样的技术逻辑与潜在风险?本次探索的目的,并非推荐任何特定服务,而是以这次配置经历为案例,剖析"API中转服务"这一广泛存在的技术模式的工作原理,并重点揭示其伴随的数据安全风险,希望引导读者更关注技术本质与安全边界。

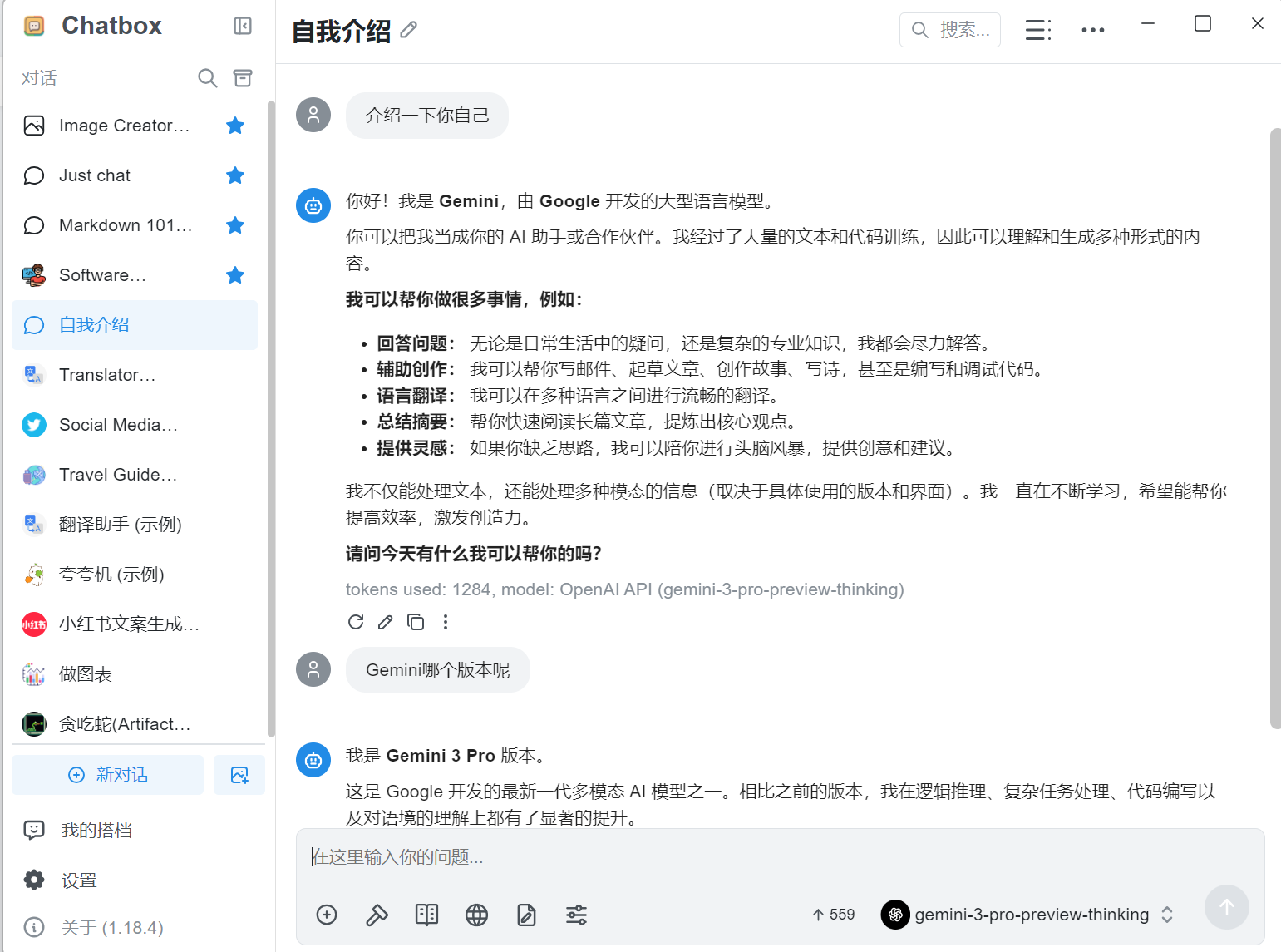

一.Chatbox AI

1.1 概述

Chatbox AI与大模型官网的核心区别在于它是一个整合多款AI模型的桌面客户端或云服务平台,让你在一个界面里方便地使用不同的大模型。

而"本地接入"实际上是另一种用法。

Chatbox AI的三种不同使用方式:

| 使用方式 | 核心原理 | 谁处理数据 | 是否需要付费 | 是否需要访问外网 | 典型配置 |

|---|---|---|---|---|---|

| 使用Chatbox AI云服务 | 付费订阅Chatbox AI整合好的GPT、Claude、DeepSeek等服务。 | 对应的大模型厂商服务器 | 是,支付给Chatbox AI | 是,需要直连或通过代理访问模型厂商 | 购买Chatbox AI套餐,在其应用内直接使用。 |

| 使用Chatbox客户端连接本地模型 | Chatbox作为纯聊天界面 ,连接Ollama等在本地电脑上运行的模型。 | 你自己的电脑 | 否(一次性硬件投入) | 否,完全离线 | 本地部署Ollama+模型,在Chatbox设置中连接localhost:11434。 |

| 使用Chatbox客户端连接镜像/中转API | Chatbox作为纯聊天界面,其API请求被重定向到国内中转服务器,再由它访问国外大模型。 | 对应的大模型厂商服务器 | 是,支付给中转服务商 | 是,但中转服务解决了直接访问的困难 | 在Chatbox设置中,将API地址改为中转服务商提供的地址。 |

下面,我们来详细拆解这几种方式,特别是你关心的本地部署和隐私问题。

1.2 方式拆解·

1.本地部署:电脑就是服务器

你问"本地电脑配置不行吧",这确实是关键。本地部署是把整个大模型(如一个70亿参数的DeepSeek模型)下载到你的电脑上运行。

-

工作原理 :你需要先安装 Ollama (一个负责在本地加载和运行模型的后端引擎),然后安装 Chatbox(一个提供聊天界面的前端)。Chatbox通过本地网络连接到Ollama,就像用音乐播放器打开本地的MP3文件。

-

对电脑的要求 :运行大模型确实需要不错的配置,主要是大内存(建议16GB以上) 和高性能显卡(如NVIDIA RTX系列)。如果配置不够,可以选择更小参数量的模型或使用量化技术(降低模型精度以节省资源)。

2.镜像/中转服务:访问外网的"桥梁"

这种方式和你使用Chatbox云服务在联网上类似,但更灵活。

-

工作原理:你付费给一个国内的"中转服务商"(比如搜索结果中提到的神马中转API)。他们在海外有服务器帮你调用OpenAI等官方API。你只需要在Chatbox等客户端里,把官方API地址换成他们提供的地址即可。

-

镜像与官方的区别 :镜像服务本质是一个代理和聚合层 。它帮你处理了网络访问、账户管理,有时还能聚合多个模型。但回答问题的最终能力依然取决于其背后连接的官方模型,响应速度和服务稳定性则取决于中转服务的质量。

3.为什么说本地化隐私好?

这是本地部署最核心的优势。你的所有对话、上传的文件数据,100%在你自己的电脑或内网中流转,不会发送给任何第三方服务器,从根本上杜绝了数据在传输和云端存储中被泄露、审查或滥用的风险。这对于处理法律、医疗、金融等敏感信息的个人或企业至关重要。

4.如何选择?

根据你的核心需求来选择:

-

追求极致隐私,且电脑配置足够 :选择 本地部署(Ollama + Chatbox) 。这是唯一真正实现数据完全自主可控的方案。

-

追求使用方便和最新模型能力,能承担费用 :选择 Chatbox AI官方云服务 或 其他可靠的中转API服务。这是在易用性、能力和成本间的平衡之选。

-

电脑配置较低,但仍想尝试本地AI:可以尝试用Ollama拉取更小参数(如3B、7B)或经过量化处理的模型,它们对硬件要求会低很多

1.3 通过Chatbox这个软件,连接和使用商家提供的"中转API服务"。

第三种方式:用Chatbox客户端连接镜像/中转API。

关键设置:Chatbox把请求发给商家,而不是官方。

1.快速总览这份文档的核心:

| 项目 | 说明 |

|---|---|

| 文档性质 | 一份由模型服务商提供的用户配置指南,核心是售卖其API服务。 |

| 核心原理 | "偷梁换柱" :把Chatbox客户端默认请求的官方服务器地址,替换成商家自己的服务器地址(如 https://max.openai365.top/v1)。 |

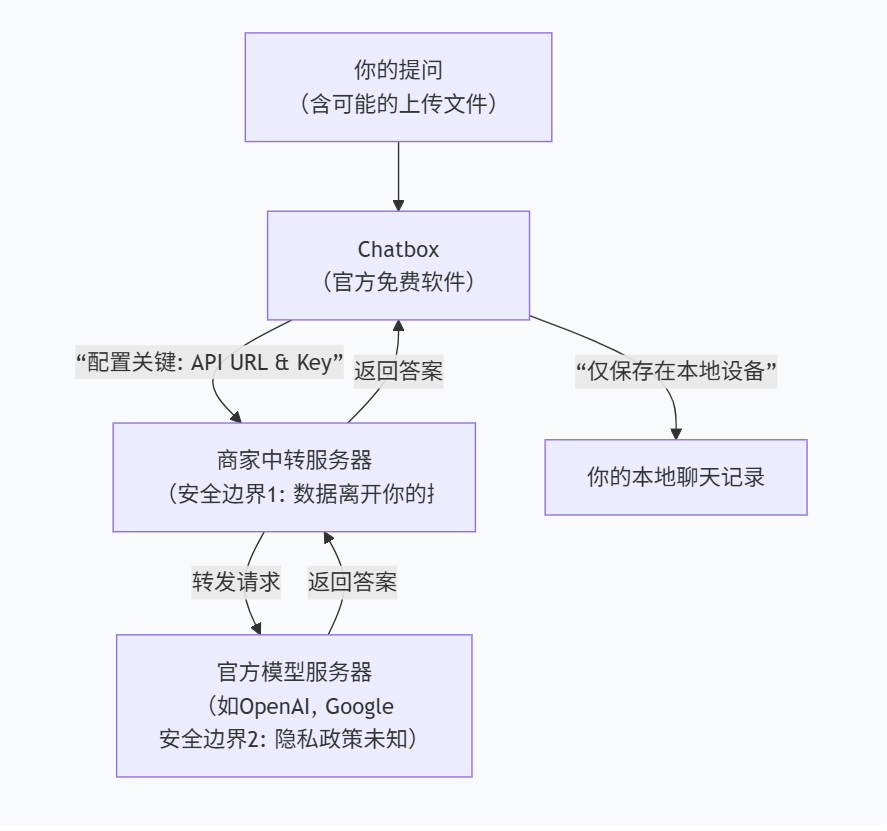

| 数据流向 | 你的提问 → Chatbox软件 → 商家服务器(中转/镜像) → 真正的模型服务商(如OpenAI、Google) → 原路返回答案。 |

| 费用模式 | 你付费给这个文档的商家(而不是OpenAI等官方),购买其API使用额度(Token)。文档里提到的"满血"、"额度表"等都是商家包装的计费方式。 |

| 模型来源 | 商家通过其海外服务器,以合规或不合规的方式接入了多个官方模型(如OpenAI的GPT、Google的Gemini、DeepSeek等),然后打包成"百种全模型"卖给你。 |

| 你的角色 | 是商家的最终用户,你调用的所有模型都在商家(或其上游供应商)的远程服务器上运行。 |

2.关键特点与风险提示

这种方式虽然解决了访问便利性的问题,但你需要清楚以下几点:

-

隐私并无保障 :你的所有对话数据都会流经商家的服务器。商家能否保障数据安全、是否会留存或滥用你的数据,完全取决于其信誉和道德,风险由你承担。

-

服务完全依赖商家:模型的稳定性、回答质量、响应速度、是否中途跑路(关停服务),都完全取决于这个商家的技术和运营。文档中反复提及"备用渠道"也侧面说明了其不稳定性。

-

成本与合规风险:你支付给商家的费用通常高于官方定价,且包含其运营成本与利润。更重要的是,商家为你"解决"访问限制的方式,可能存在合规风险。

3.物联网项目类比学习,

这其实就是把"物联网设备-云服务器"的模式,换成了"AI客户端-商家中转服务器"。

核心类比:把AI服务想象成你搭建的物联网服务

| 你的物联网项目 | 你现在要用的AI服务 | 解释 |

|---|---|---|

| 设备(比如ESP32) | 客户端(Chatbox这个.exe程序) | 都是一个发出请求的终端软件。你的设备固件是C写的,Chatbox客户端是别人用代码打包好的可执行文件(.exe)。 |

| 通信协议(MQTT/HTTP) | 通信协议(HTTP) | 都是通信的"语言"和"规则"。这里用的就是最普遍的HTTP。 |

服务器地址 (比如 mqtt.tencent.com:1883) |

API Host/URL (比如 https://max.openai365.top/v1) |

都是你要连接的远程服务器的网络地址 。IP地址是数字,不方便记,所以用域名。https:// 表示安全的HTTP,/v1 是服务器上某个特定服务的路径。 |

| 用户名/密码 | API Key | 都是身份验证凭证。告诉服务器:"我是谁,我有没有权限访问"。API Key就是一长串复杂的密码。 |

| 腾讯云服务器(你买的2核那台) | 商家中转服务器 | 都是接收请求、处理并返回数据的远程计算机。商家买了很多高性能服务器,在上面运行了特殊的转发程序。 |

| 你的物联网服务逻辑(处理传感器数据) | 商家的转发程序(把请求发给OpenAI等) | 服务器上运行的程序不同。商家的程序核心工作就是:验证你的API Key -> 把你的问题转发给真正的AI公司 -> 把AI的回答返回给你。 |

1.4 配置与使用指南

1.核心操作就两步:

(1)软件下载 :从官方地址 https://chatboxai.app/zh 下载并安装Chatbox客户端。

(2)配置设置:在软件设置中找到模型或API配置,填入商家提供给你的:

-

API接口地址(URL) :例如

https://max.openai365.top/v1 -

API密钥(Key):商家发给你的一串字符。

-

模型名称 :从商家提供的长列表(如

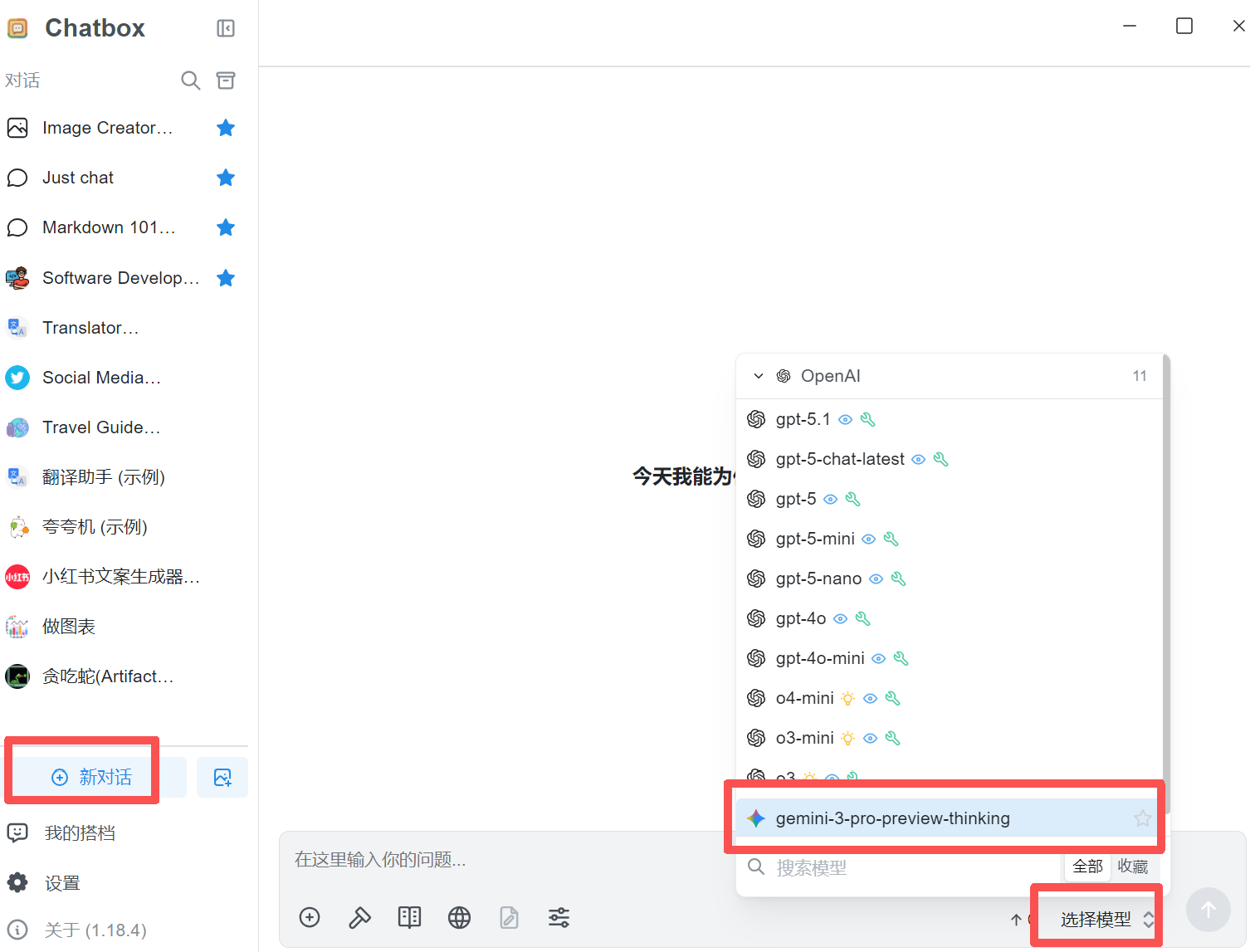

gemini-3-pro-preview)中选择。

2.API 是什么?

API 不是服务器,而是服务器提供的"标准化服务窗口"。

类比银行:

-

银行大楼 = 服务器(有公网IP的计算机)。

-

银行提供的服务(存款、取款、转账) = 服务器运行的程序。

-

这些服务的标准化操作流程(填什么单子、签哪里、交哪个窗口) = API。

所以,API(应用程序编程接口)就是一套预先定义好的规则,告诉外部程序(比如Chatbox)"如何请求服务"以及"服务会以什么格式返回结果"。当教程里说"OpenAI API兼容",意思是:"请使用符合OpenAI公司制定的那套请求规则的格式来和我对话"。

3. 核心概念

| 名词 | 它到底是什么? | 在你的场景中 |

|---|---|---|

| 服务器 | 一台提供服务的远程计算机。 | 商家购买的、有公网IP的腾讯云/阿里云服务器。 |

| API Host / Base URL | 这个服务器上"AI服务窗口"的具体网络地址。 它包含了协议、域名(或IP)、端口和路径。 | https://max.openai365.top/v1 (这就是商家把他服务器的AI服务窗口地址告诉你了)。 |

| API Key | 你的个人密码。服务器用它来验证:"哦,是用户2301来了,从他的余额里扣费"。 | 商家后台生成后单独发给你的那串sk-...字符。它就是密码,且一人一码。 |

| 客户端 (Chatbox.exe) | 一个操作界面。它按API规则把你的问题打包,带着API Key,发送到API Host。 | 一个图形化软件。你填好API Host和API Key,它就能帮你"对接"远端的服务。 |

总结流程 :Chatbox客户端 按照 OpenAI API 的格式,把你的问题和 API Key 打包,发送到 API Host (商家的服务器地址)。商家服务器验货扣费后,把请求转发给真正的AI模型,再把回答原路返回给Chatbox显示给你。

另外,如果直接用OpenAI官方服务,你在Chatbox里就需要填:

-

API Host :

https://api.openai.com/v1(这是OpenAI官方"服务窗口"的公开地址) -

API Key: 去OpenAI官网注册账号、绑卡充值后,在个人设置里生成的一个专属密钥。这个Key绝不公开,是你的私人密码,泄露就等于丢钱。

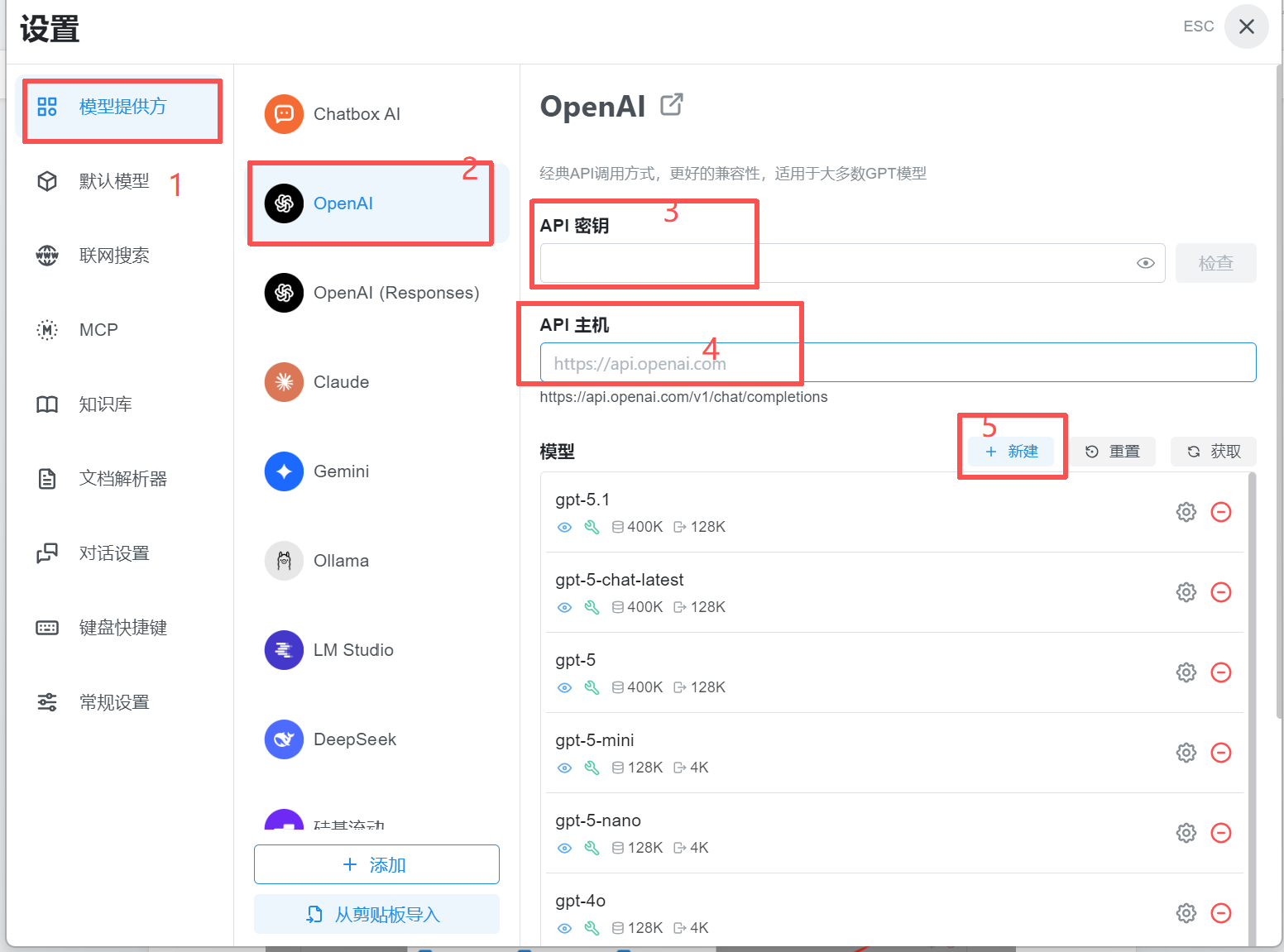

4.API Host、API Key、URL怎么配置?

这就是你配置客户端,让它找到正确服务器并登录的过程。

在Chatbox(或类似AI客户端)的设置里,通常有两个核心输入框:

-

API Host / Base URL / 对接URL端点

-

这是什么 :就是你要连接的商家中转服务器的完整地址 。你文档里给的是

https://max.openai365.top/v1。 -

为什么是URL而不是IP :和你的博客地址

https://blog.csdn.net/...一个道理。域名背后对应着IP,但域名更好记、更灵活(服务器换IP了,域名可以不变)。/v1代表这是该服务器提供的"第一版API"接口路径。 -

你的操作:将这个地址完整地填入Chatbox设置中对应的输入框。

-

-

API Key / 密钥

-

这是什么 :这是商家单独分配给你的一串密码 (例如

sk-xxxxx...)。服务器用它来识别你的身份,并扣减你账户里的额度。 -

你的操作:将商家发给你的这串字符填入Chatbox设置中"API Key"的输入框。

-

1.5 验证

设置=》模型提供方=》选OpenAI=》填入密钥及主机,新建自定义模型名字

退出回到聊天界面,选择模型,测试

说明:

- 为什么"模型只选OpenAI API兼容"?

这不是模型本身,而是通信格式。这是一个关键技巧!

-

Chatbox客户端在设计时,首先完美适配了OpenAI公司的官方API格式。你可以把这种格式理解为一种标准的"请求模板"或"信封格式"。

-

商家的服务器虽然背后连接了Gemini、Claude、DeepSeek等上百种模型,但他们把自己的服务器伪装成了"OpenAI官方服务器"。

-

所以,你在Chatbox里选择"OpenAI",Chatbox就会按照OpenAI的"信封格式"去打包你的问题,然后寄出去。

-

这个"信封"被寄到商家的服务器后,商家会拆开信封,读取内容,然后用自己的方式,去调用对应的Google Gemini等模型,拿到回答后,再按照OpenAI的"回信格式"打包好,送回给Chatbox。

-

这样做的好处是:Chatbox这个客户端无需做任何修改,就能对接无数种模型,兼容性极强。对你来说,操作也简单,永远只选一个选项。

2.关于新建自定义模型名字

模型名字 (Model Name),这是服务指令。告诉商家的服务器:"请帮我调用具体哪一个AI模型"。名字不对,服务器就不知道你要用什么。

为什么模型名字必须完全一致,包括标点?

因为商家的服务器里有一个模型名称的路由表。当你输入 gemini-2.5-pro-search,服务器就会把这个请求转发给谷歌的Gemini 2.5 Pro搜索增强版。如果你输成 gemini2.5pro,服务器在它的列表里找不到匹配项,就会返回错误。

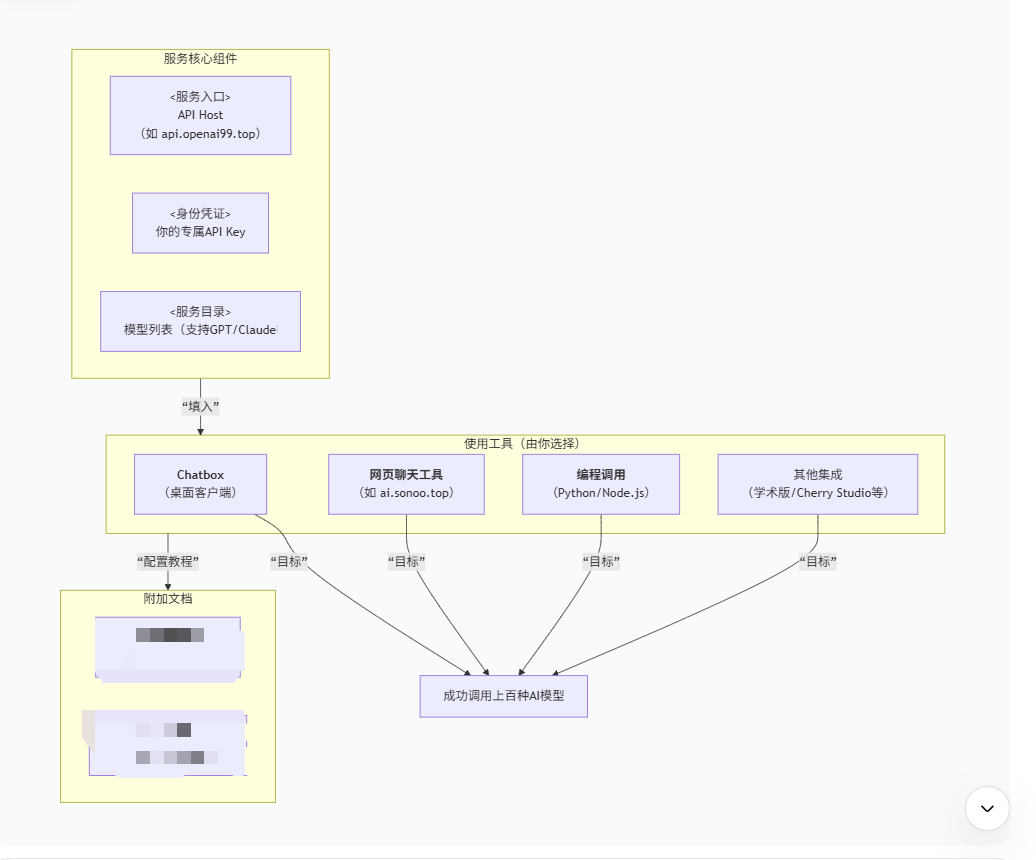

二. 推广-把API接入工具

所有文档都围绕同一个API服务 展开。你只需掌握 API Host + API Key + 模型名称 这三要素,就可以在各种工具上使用。

作为学生想快速用起来辅助学习,请专注于配置 Chatbox 桌面客户端。这是功能最全、体验最接近ChatGPT的本地软件。

你只需要在这些工具的设置里,把默认的OpenAI官方地址 (api.openai.com),替换成商家的地址 (api.openai99.top/v1) ,再配上你的密码 (API Key),工具就能无缝切换,开始从商家那里获取AI能力。

1.以Cursor为例,它如何工作?

你的理解基本正确。Cursor 是一款深度融合了AI的代码编辑器,它需要调用AI(如GPT-4)来帮你补全代码、解释代码、查找Bug等。

-

默认情况 :Cursor会要求你输入自己的OpenAI API Key,然后它直接与

api.openai.com通信。 -

接入商家API后 :你在Cursor的设置中,将API Base URL改为商家的地址,并填入商家给你的API Key。

-

发生了什么 :此后,当你在Cursor中按

Cmd+K让AI写代码时,Cursor会把你的代码片段和请求,发送到api.openai99.top/v1这个地址。商家服务器处理后,可能会转发给GPT-4或Claude等模型,再将结果返回给Cursor显示。 -

所以答案是 :是你把你本地的Cursor软件,接入了他们的远程服务器。AI协作调试的功能依然由Cursor这个软件提供,但"大脑"换成了由商家中转的模型。

2.Python代码示例:它是如何"对接"的?

我们看文档里的这段核心代码:

import os

# 关键步骤1:设置环境变量

os.environ["OPENAI_API_KEY"] = "sk-xxx" # 你的商家API Key

os.environ["OPENAI_BASE_URL"] = "https://api.openai99.top/v1" # 商家地址

# 关键步骤2:像调用OpenAI官方库一样正常写代码

from openai import OpenAI

client = OpenAI() # 此时,这个client会自动读取上面的BASE_URL和API_KEY

completion = client.chat.completions.create(

model="gpt-4", # 这里填你想用的模型名,来自商家列表

messages=[{"role": "user", "content": "Hello!"}]

)

print(completion.choices[0].message.content)代码解读:

-

OPENAI_BASE_URL = "https://api.openai99.top/v1":这行代码将程序的请求目标重定向到了商家的服务器。 -

model="gpt-4":这个模型名是发给商家服务器的指令。商家看到后会说:"用户要调用GPT-4,我帮他转发给真正的GPT-4 API。" -

之后的调用方式和官方完全一样。这意味着,任何基于OpenAI官方Python库开发的项目,理论上只需修改这两行配置,就能切换到这个商家的服务。

3.关于其他工具

这是一个专门为阅读论文、翻译文献、润色学术文本 而优化的开源工具(如著名的 GPT Academic)。它本身也是一个需要接入AI模型的后端。

-

接入方式 :在它的配置文件中,同样有

API_BASE_URL和API_KEY的设置项。 -

效果:填上商家的信息后,这个强大的学术工具就能利用商家背后的GPT等模型为你工作,帮你快速总结PDF论文、翻译大段外文等,非常有用。