赵志1^{1}1,王日君1,2,∗^{1,2,*}1,2,∗,陈文金1^{1}1,杜克1^{1}1,黄志刚1,2^{1,2}1,2,黄宇1,2,∗^{1,2,*}1,2,∗

1^{1}1 广西师范大学职业技术师范学院,桂林 541004,中国;yangzhi@stu.gxnu.edu.cn (Z.Y.);chenwenjin@stu.gxnu.edu.cn (W.C.);dukeer@stu.gxnu.edu.cn (K.D.);hbypolly@mailbox.gxnu.edu.cn (Z.H.)

2^{2}2 广西农业林业智能装备技术工程研究中心,桂林 546300,中国

通讯作者:rijunwang@mailbox.gxnu.edu.cn (R.W.);hyu7050@mailbox.gxnu.edu.cn (Y.H.)

摘要

低空无人机因其体积小、机动性强和低可观测性等特点,日益引发安全关切。在杂乱环境中检测此类目标仍面临严峻挑战,主要源于强烈的背景干扰和显著的尺度变化。为解决这些问题,我们提出了一种基于YOLO11的高效精准多尺度检测框架,专门针对杂乱场景中的小型无人机进行优化。该框架包含三个核心模块:C3K2-FB用于增强特征提取并抑制背景噪声;MS_FPN实现边缘感知的多尺度特征融合;RFCBAM联合利用空间与通道注意力机制,提升对判别性区域的关注度。在DeTFly数据集上的大量实验表明,我们的方法达到了94.4%的mAP@0.5和60.9%的mAP@0.5:0.95,无论在精度还是鲁棒性方面均优于包括YOLO11n、YOLOv10n和RT-DETR-L在内的最先进模型。这些结果验证了所提框架在涉及杂乱环境中小尺度目标的真实世界无人机检测任务中的有效性。

关键词:多尺度特征融合;小目标检测;无人机目标识别;背景抑制;注意力机制;目标检测框架

1. 引言

人工智能与传感器技术的最新进展显著推动了无人机(UAV)的发展,使其在空中监测、环境检查、交通管理和灾害救援等领域得到广泛应用[1]。然而,低空小型无人机的滥用,如未授权飞行和非法侦察,对空域管理和公共安全构成了严重挑战。特别是在高风险区域,无人机的远程可控性、高机动性和低可观测性在边境安全、关键基础设施保护和战术侦察等方面呈现出双重用途的隐忧[2]。因此,开发高效可靠的反无人机检测技术已成为全球优先事项。

当前反无人机检测方法主要包括雷达检测、射频(RF)信号分析、光电/红外(EO/IR)成像和声学识别[3,4]。雷达系统提供长距离探测和宽覆盖范围,不受光照条件影响,但易受电磁干扰,且对低空、慢速小型无人机的探测能力有限,缺乏精确的目标分类能力[5]。射频分析通过检测通信和视频传输信号进行定位,能有效定位活跃发射源,但对静默或跳频无人机失效,且易受环境噪声干扰[6]。光电/红外成像提供直观的视觉信息,适用于目标识别与跟踪,但高度依赖光照和天气条件,对远距离小型目标的探测能力较弱[7]。声学方法利用无人机特有噪声进行探测,具有良好的隐蔽性,但探测距离有限,且易受环境噪声干扰[8]。这些方法面临检测精度不足、误报率高、环境适应性差、多目标处理能力有限以及对低可观测性和微型无人机性能弱等挑战,限制了其在复杂场景中的适用性。

基于深度学习的目标检测算法已成为反无人机视觉检测领域的主流方法,其优势在于能够从复杂图像和视频中分层提取抽象特征,实现精准识别与定位[9]。这些方法主要分为两类:单阶段检测器(如YOLO系列[10,11]、SSD[12,13])和两阶段检测器(如Faster R-CNN)[14]。研究者在提升小目标检测和背景干扰抑制方面做出了大量努力。例如,Wang等人在YOLOv8的P2层添加高分辨率检测头以保留细节[15];为降低噪声,IRWT-YOLO集成了图像分割技术[16];Yang等人提出IASL-YOLO,对YOLOv8s进行优化,实现精度与轻量化的平衡[17];Huang等人开发了EDGS-YOLOv8,结合ghost卷积、高效多尺度注意力模块(EMA)和DCNv2,实现轻量级实时检测[18]。

如表1所示,我们明确指出了反无人机检测研究中仍存在的三个关键挑战:(1) 复杂背景中的目标混淆------低空场景中无人机与周围元素(如天空、植被或建筑物)常具有高度视觉相似性,导致注意力分散、误检和漏检;(2) 多尺度特征融合效率低下------剧烈的尺度变化和小目标场景阻碍了精确定位和边界建模[19,20];(3) 小目标检测精度与鲁棒性有限------小型无人机通常仅占据极少像素,在运动模糊或远距离条件下特征保留尤为困难[21,22]。

表1. 用于无人机检测的基于YOLO的目标检测模型

| 模型 | 数据集 | 关键技术 | 性能 | 优势 |

|---|---|---|---|---|

| IRWT-YOLO | 3rd Anti-UAV dataset | 用于背景抑制的图像分割 | mAP@0.5: 85.6% mAP@0.5:0.95: 85.7% | 抑制复杂背景 |

| IASL-YOLO | Anti-UAV dataset | YOLOv8s轻量化 | mAP@0.5: 92.4% mAP@0.5:0.95: 61.9% GFLOPs: 19.9 | 精度与尺寸的良好平衡 |

| EDGS-YOLOv8 | DUT Anti-UAV dataset | Ghost conv + EMA + DCNv2 | mAP@0.5: 93.4% mAP@0.5:0.95: 62.1% | 精准且实时 |

为应对这些挑战,我们提出了一种基于YOLO11的轻量高效检测框架,包含三个专用组件:C3K2-FB,旨在抑制背景干扰并增强关键区域特征;MS_FPN,改进跨尺度融合并实现边缘感知定位;RFCBAM,一种基于注意力机制的检测头,保留小目标的细粒度特征。这些模块协同设计以解决上述局限性,形成针对复杂环境中实时无人机检测优化的统一框架。

主要贡献总结如下:

- C3K2-FB(带融合块的C3K2)模块采用门控机制动态抑制复杂背景干扰并增强关键目标区域的特征,有效提升模型在挑战性环境条件下的鲁棒性和特征判别能力。

- 设计了多尺度边缘增强特征金字塔(MS_FPN),将边缘信息与改进的跨尺度双向融合策略相结合,实现深层语义特征与浅层细节特征的高效融合,增强多尺度目标检测的鲁棒性和定位精度。

- 构建了基于注意力机制的小目标检测头,通过添加高分辨率检测层并集成感受野与卷积块注意力模块,有效保留并突出小目标特征,显著提升小目标检测的精度与稳定性。

2. 基于YOLO的多尺度与小目标检测框架

2.1 YOLO11概述

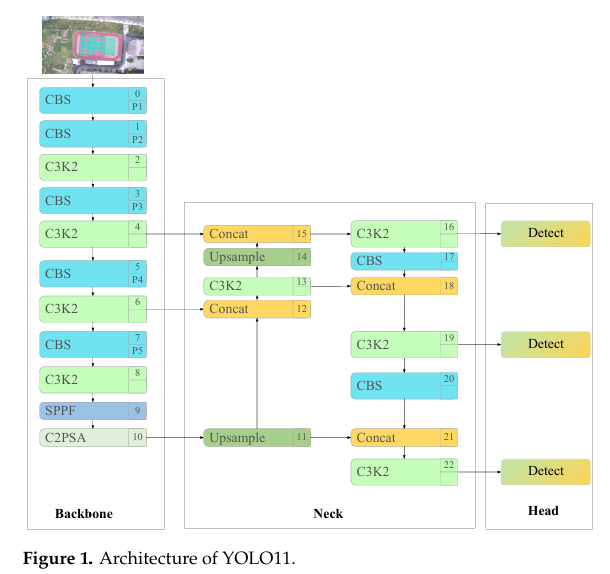

YOLO11[23]由Ultralytics团队开发,于2024年9月发布,代表了新一代目标检测框架。它在保留传统四组件YOLO架构的同时引入了多项架构创新,结构如图1所示。输入阶段采用基于网格的直接预测方法以增强多尺度适应性。骨干网络集成了优化的C3K2模块(相比YOLOv8的C2f模块,计算速度提升30%,参数减少40%),并融合了SPFF(空间金字塔快速融合)模块用于多尺度特征提取,以及C2PSA(交叉部分自注意力)双分支注意力机制,显著提升了小目标检测性能和关键区域感知能力。颈部架构利用上采样操作结合通道级联实现高效特征融合。最终检测采用端到端Detect模块,支持多目标并行预测。该优化架构在保持高检测精度的同时实现了计算效率的显著提升。

2.2 整体框架

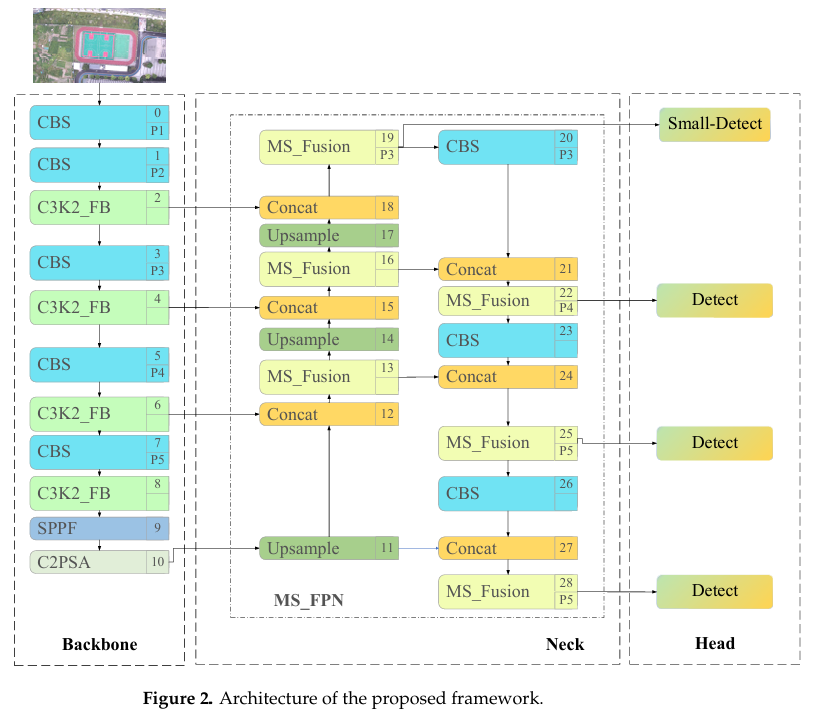

为解决杂乱环境中低空无人机的小目标检测挑战,本文提出了一种基于YOLO11架构的多尺度与小目标检测框架。该框架旨在系统性地解决三个关键问题:背景干扰、多尺度特征融合效率低以及特征提取过程中小目标信息的丢失。所提框架的整体架构如图2所示。

在骨干网络中,引入了新颖的特征提取模块C3K2-FB。该模块采用门控机制动态抑制背景噪声并增强关键目标区域的特征表示,提升模型在复杂环境中的鲁棒性和特征判别能力,并增强对小目标的早期响应。

在颈部网络中,提出了名为MS_FPN的网络。该网络融入边缘信息以支持特征表达,并采用改进的跨尺度双向融合机制,有效整合深层语义特征与浅层细节特征。该设计增强了不同尺度目标检测的鲁棒性和定位精度。

在检测头中,添加了专用于小目标的高分辨率检测层(图2中的Small-Detect)。此外,将标准卷积替换为新设计的感受野与卷积块注意力模块(RFCBAM),该模块集成了感受野注意力(RFA)和卷积块注意力模块(CBAM)。通过联合建模通道和空间维度的重要性,该模块引导网络更精确地聚焦于小无人机目标的关键区域和特征通道,显著提升小目标检测的精度与稳定性。

2.3 C3K2-FB模块设计

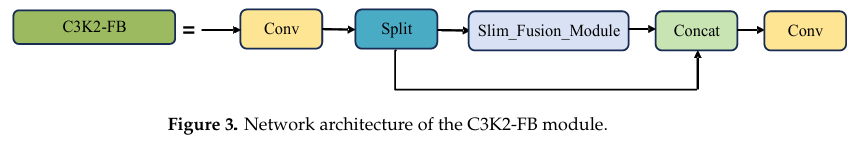

尽管YOLO11骨干网络中的C3K2模块通过高效的残差结构和多尺度卷积组合增强了特征提取效率,但其核心操作仍依赖于标准卷积。标准卷积在复杂场景中存在显著局限性,因其固定核参数无法适应空间结构变化。当目标与背景具有相似纹理或颜色时,常导致注意力分散、目标边界模糊,难以在聚焦关键判别区域的同时抑制无关干扰。为解决这些问题,提出了一种新颖的特征提取与融合模块------C3K2-FB,以替代原始C3K2结构。如图3所示,C3K2-FB模块集成了Slim Fusion Module(SFM)[24],引入门控机制和宽感受野卷积,动态增强目标特征并抑制复杂环境中的背景干扰。该模块促进多尺度语义信息的高效整合,同时保持较低计算开销,显著增强模型在杂乱场景中检测小型、遮挡和尺度变化目标的能力。

C3K2-FB借鉴了C2f的特征流优化理念,采用重构的融合策略提升深层特征的学习效率。具体而言,输入特征图首先通过深度卷积处理,提取多尺度目标的基本空间和语义表示。随后,这些特征沿通道维度进行重塑并均匀分组,确保边缘和纹理等语义信息的平衡分布与多样性。每组特征通过SFM模块处理(如图4所示),其中残差增强机制用于强调关键区域并抑制背景噪声。SFM的输出与输入特征融合(通过级联或加权求和),再经卷积整合步骤生成优化特征,从而形成特征流的闭环增强。

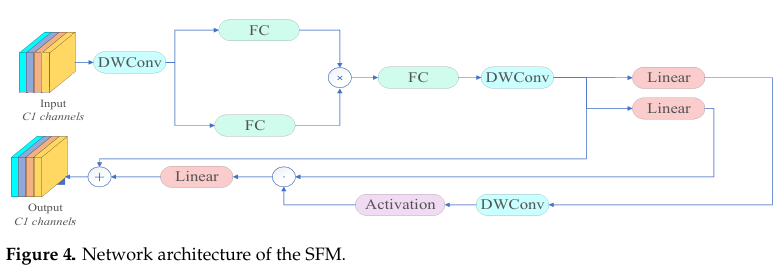

作为C3K2-FB模块的核心结构组件,SFM结合了高效的逐元素乘法机制(称为"star operation")与类门控线性单元(GLU)结构,以最小计算成本实现动态特征调制和空间增强。初始阶段,SFM使用深度可分离卷积将输入拆分为两个子特征组,分别由两个并行分支处理:主分支应用标准卷积提取基础特征,门控分支生成动态权重图并与主分支输出进行逐元素相乘。这种"星操作"替代传统求和,实现高维非线性特征建模和关键信息的自适应增强。两分支输出随后通过级联或逐元素操作融合,再经卷积处理以增强细粒度空间信息的表示。融合后的特征通过深度可分离卷积进行重构,并应用类GLU门控机制动态调整通道重要性。具体而言,重构特征被拆分为两个线性投影:其中一个经过3×33 \times 33×3深度卷积及SiLU激活[25]后,与另一个进行逐元素相乘,实现通道响应的动态控制。最后,通过残差连接将模块输出与原始输入合并,有效缓解梯度消失问题,同时保留信息完整性并增强特征表示。

2.4 多尺度边缘增强特征金字塔设计

尽管基于YOLO的目标检测模型中的传统金字塔结构具备一定的多尺度特征处理能力,但在特征提取与融合方面仍存在显著局限性。通常,这些结构依赖于图像的渐进式下采样,并在每个尺度独立提取特征。这种方法难以同时保留高分辨率特征图中的细粒度细节和低分辨率图中的全局语义上下文。这一局限对小目标检测尤为不利,因为高层语义特征往往丢失边缘和纹理细节,而低层特征缺乏足够的上下文信息,最终降低检测精度。此外,传统金字塔设计采用固定尺度处理,对复杂场景中多样化的物体尺度变化适应性不足,常导致跨尺度的特征不连续性和不一致性,从而制约模型对多尺度目标检测的鲁棒性和泛化能力。

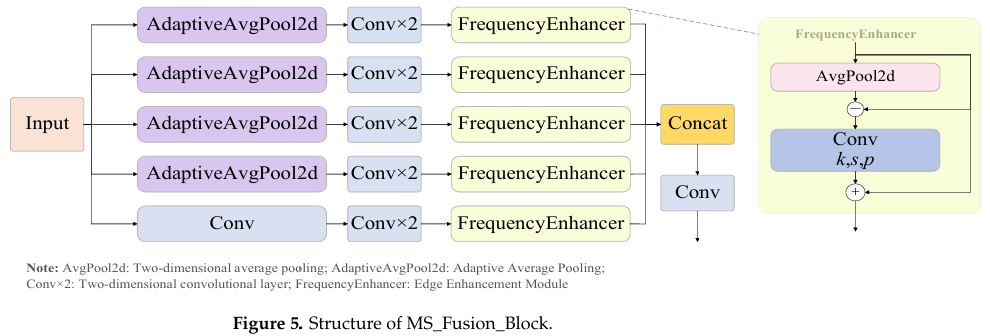

为克服这些局限,我们受SlimNeck设计理念启发,提出了一种新颖的多尺度边缘增强特征金字塔网络,称为MS_FPN。MS_FPN集成了新设计的MS_Fusion_Block(多尺度选择性融合块),该块融入了FrequencyEnhancer边缘增强模块。该设计实现了物体轮廓的精确建模和多尺度语义信息的有效融合。MS_FPN在保持计算效率的同时,显著提升了模型保留细粒度细节的能力以及对小型和远距离微型无人机目标检测的鲁棒性。

结构上,MS_Fusion_Block(如图5所示)作为MS_FPN的核心单元,包含四个主要处理阶段:(1) 多尺度上下文提取:自适应平均池化生成多分辨率特征图以捕获跨尺度上下文信息;(2) 高效特征建模:每个尺度的特征经过并行的1×11 \times 11×1卷积进行通道压缩和分组3×33 \times 33×3卷积进行空间细节提取,在特征丰富性与计算成本间取得平衡;(3) 边缘显著性增强:嵌入的FrequencyEnhancer模块首先通过平均池化提取低频背景,然后通过残差计算分离高频边缘信息。卷积后接Sigmoid激活增强边缘显著性,残差融合生成边缘增强特征图;(4) 跨尺度特征融合:增强的多尺度特征经上采样、通道维度对齐、级联后通过卷积融合生成最终优化特征图。该模块有效突出物体轮廓,在复杂背景条件下提升语义一致性与边界定位精度,为后续检测头提供稳定鲁棒的特征基础。

2.5 基于混合注意力卷积的小检测头

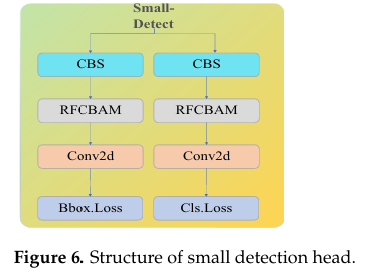

低空无人机检测通常属于小目标检测范畴。原始YOLO11架构采用三个检测头;然而,由于深度网络中的渐进式下采样操作,浅层中包含的小目标细节特征在传输过程中大量丢失,损害了模型准确检测小尺度无人机目标的能力。为解决此问题并更好地保留细粒度视觉信息,我们在框架中引入了专为小目标检测设计的额外高分辨率检测头。此外,传统检测头中常用的标准卷积模块对所有空间位置和通道特征平等对待,缺乏自适应聚焦于关键空间区域(如物体轮廓)和判别性通道(如纹理或形状相关特征)的能力,限制了小目标检测的特征提取与融合效果。

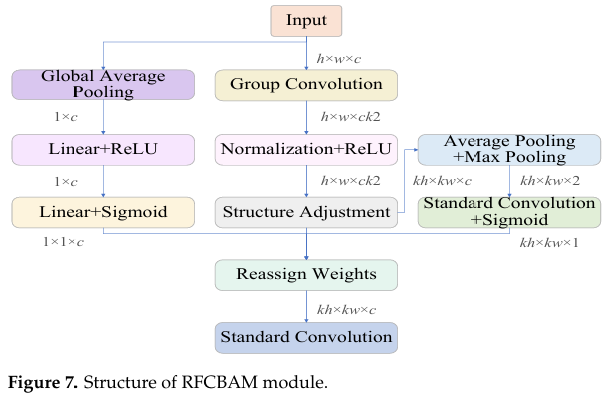

为克服这些局限,提出了一种混合注意力卷积模块RFCBAM,以替代新添加检测头中的标准卷积。RFCBAM将感受野注意力(RFA)机制[26]与卷积块注意力模块(CBAM)[27]相结合,在空间和通道维度上增强模型能力。RFA动态调整感受野以更好捕获具有多样化空间分布的小目标;然而,它缺乏抑制无关通道信息的能力,易受背景杂乱干扰。相比之下,CBAM擅长通道注意力并增强目标相关特征,但其空间注意力机制受固定感受野约束,对大尺度变化物体的有效性有限。

RFCBAM通过两种机制的协同组合克服了这些局限。具体而言,RFA提供自适应空间锚定,引导CBAM的注意力焦点,有效缓解背景干扰。同时,CBAM的通道注意力进一步细化RFA动态定位区域内特征。这种双重增强策略使模型在复杂场景中实现更精确的空间定位和更具判别性的特征表示。因此,RFCBAM显著提升了模型提取和利用相关特征的能力,同时保持对背景噪声的强鲁棒性。

基于混合注意力的小目标检测头结构如图6所示,其中输入特征直接取自骨干网络的第一浅层,以最大限度保留原始空间细节和位置线索。所提RFCBAM模块的架构如图7所示。

3. 实验与结果

3.1 数据集详情

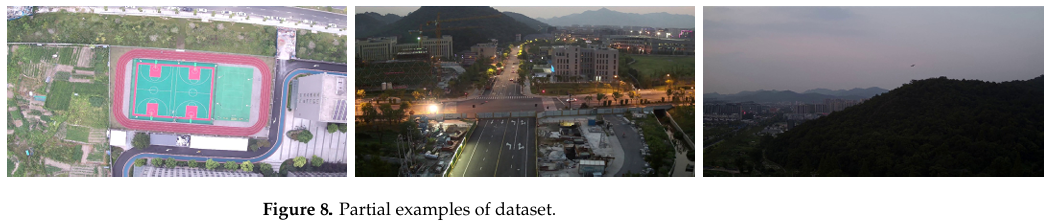

本研究采用DeTFly数据集作为训练和评估所提模型的主要基准。DeTFly[28]专为杂乱环境中的低空无人机检测设计,涵盖城市、天空和山地等多种挑战性场景。这些场景引入了显著的背景干扰和目标遮挡。代表性样本图像如图8所示。尽管数据集主要聚焦于无人机,但在目标尺度、背景复杂性和可见性方面呈现出显著的类内多样性。图像在光照(从早晨到傍晚)、背景类型(如天空、城市、山地、田野)、相对距离和无人机视角(顶部、正面、底部)方面各不相同。标注由训练有素的标注员手动创建,并通过双重检查验证以确保边界框的准确性和一致性。

该数据集包含超过10,000张高分辨率图像(3840×21603840 \times 21603840×2160像素)及相应的边界框标注。所有标注对象均为小型低空无人机,大多数目标占据图像面积不足5%,反映了小目标检测的典型挑战。数据集按8:1:1比例划分为训练集(8000张图像)、验证集(1000张图像)和测试集(1000张图像),以支持模型训练、超参数调优和最终评估。

3.2 实验配置

为确保训练稳定性和可重复性,所有实验均在表2所示的硬件和软件配置下进行。数据增强:旋转对称(概率0.2)、对称MixUp增强(概率0.1)、水平翻转(概率0.5)。

表2. 硬件和软件配置

| 硬件和软件 | 详细配置 |

|---|---|

| CPU | Intel® Core™ i7-12700KF |

| GPU | NVIDIA GeForce RTX 4090 |

| 内存 | 32GB DDR5 4800 MHz |

| 存储 | SSD 512 GB |

| 操作系统 | Windows 11 |

| PyTorch版本 | 1.10.1 |

| Python版本 | 3.8 |

| CUDA版本 | CUDA 12.0 |

训练超参数设置如表3所示。

表3. 超参数设置

| 超参数 | 设置值 |

|---|---|

| Batch Size | 16 |

| 图像尺寸 | 640×640640 \times 640640×640 |

| 权重衰减 | 0.0005 |

| 优化器 | SGD |

| 训练轮数 | 200 |

| 学习率 | 0.01 |

| 动量 | 0.937 |

3.3 评估指标

为全面评估所提框架在杂乱低空场景中的检测性能,采用以下广泛使用的目标检测指标:

精确率(P):预测为正样本中实际为真正例的比例,反映检测结果的准确性。

召回率(R):实际正例中被正确检测的比例,表示模型覆盖所有目标的能力。

AP(平均精度):不同召回率水平下精确率的平均值,用于衡量各类别的检测能力。本研究中,AP针对单类无人机目标计算。

mAP(平均平均精度):所有类别AP的均值。由于仅考虑单一类别,mAP等同于AP。mAP@0.5:0.95指标在0.5至0.95的交并比(IoU)阈值范围内平均性能,对定位精度和检测鲁棒性提供更严格的评估。这在小无人机检测中尤为关键,因为目标区域小,即使微小的定位误差也会显著影响IoU。

F1分数(F1):精确率和召回率的调和平均数,提供性能的平衡度量。定义为:

F1=2×P×RP+RF1=2\times\frac{P\times R}{P+R}F1=2×P+RP×R

3.4 消融实验

为评估各提出模块对整体模型性能的贡献,通过逐步集成特定结构组件进行了一系列消融实验,随后在DeTFly数据集上进行对比评估。主要评估指标包括精确率、召回率、F1分数、mAP@0.5、mAP@0.5:0.95和参数量。详细结果见表4。

Baseline:原始YOLO11n模型,作为对比参考。

Baseline + C3K2-FB:用所提C3K2-FB替换骨干网络中的标准C3K2模块,评估其对特征提取和背景抑制的影响。

Baseline + MS_FPN:在颈部引入带边缘增强的多尺度特征金字塔网络(MS_FPN),评估其在多尺度融合和小目标边界保留方面的有效性。

Baseline + 基于RFCBAM的小检测头:添加专用于小目标的额外高分辨率检测头,并用RFCBAM混合注意力模块替换标准卷积,评估其对小目标检测精度的影响。

Ours:将所有提出模块集成到统一的多尺度与小目标检测框架中,作为评估整体架构性能的最终模型。

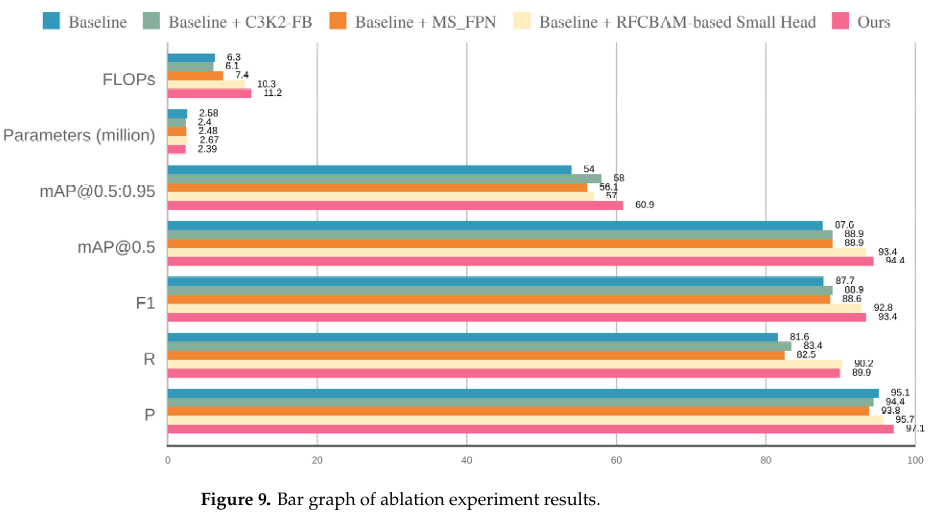

消融实验结果如表4所示。为便于不同模块组合间的视觉比较,消融实验结果的柱状图如图9所示。

表4. 消融实验结果

| 模型 | P | R | F1 | mAP@0.5 | mAP@0.5:0.95 | 参数量(百万) | FLOPs | FPS |

|---|---|---|---|---|---|---|---|---|

| Baseline | 95.1 | 81.6 | 87.7 | 87.6 | 54.0 | 2.58 | 6.3 | 327.4 |

| Baseline + C3K2-FB | 94.4 | 83.4 | 88.9 | 88.9 | 58.0 | 2.40 | 6.1 | 424.2 |

| Baseline + MS_FPN | 93.8 | 82.5 | 88.6 | 88.9 | 56.1 | 2.48 | 7.4 | 181 |

| Baseline + RFCBAM-based Small Head | 95.7 | 90.2 | 92.8 | 93.4 | 57.0 | 2.67 | 10.3 | 270 |

| Ours | 97.1 | 89.9 | 93.4 | 94.4 | 60.9 | 2.39 | 11.2 | 273.3 |

注:FLOPs:每秒浮点运算次数,FPS:每秒帧数。

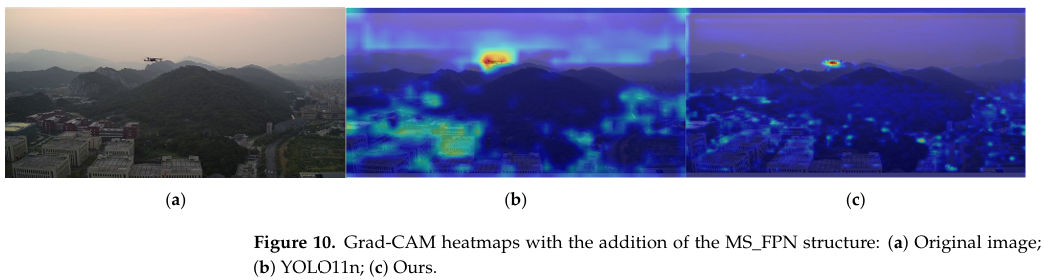

消融结果表明,与基线模型相比,引入C3K2-FB模块使mAP@0.5从87.6%提升至88.9%,mAP@0.5:0.95从54.0%提升至58.0%,F1分数提高至88.9%。这些结果表明C3K2-FB在复杂场景中有效增强了特征提取并抑制了背景干扰。添加MS_FPN结构后,mAP@0.5:0.95提升至56.1%,Grad-CAM热力图(如图10所示)证明了该模块在多尺度特征融合和细粒度边界保留方面的有效性,尤其在小目标检测中表现突出。引入基于RFCBAM的小目标检测头带来了最显著的性能提升,召回率提高至90.2%,F1分数达92.8%,mAP@0.5达93.4%。这些结果凸显了该模块在增强模型对小目标敏感性方面的强大能力。最终集成模型(Ours)实现了最佳整体性能,mAP@0.5和mAP@0.5:0.95分别达到94.4%和60.9%,F1分数升至93.4%。精确率和召回率也分别提升至97.1%和89.9%。值得注意的是,这些改进仅需239万参数,甚至少于基线模型,证明了所提框架的轻量高效设计。

总之,所有三个模块均对模型性能产生积极贡献。其中,RFCBAM检测头在小目标检测方面表现出最显著的改进,而C3K2-FB模块在轻量设计下增强了整体特征表示。最终集成框架在精度、鲁棒性和计算效率之间实现了良好平衡。

3.5 与主流模型的对比实验

为进一步验证所提模型的整体性能,与多种主流目标检测模型进行了对比实验,包括两阶段检测器Faster R-CNN、基于Transformer的检测器RT-DETR-L,以及多个轻量级YOLO系列模型版本(YOLOv8n、YOLOv9n、YOLOv10n和YOLO11n)。所有基线模型均采用其官方或广泛采用的开源版本实现,训练流程在增强策略、学习率、批量大小和轮数方面保持一致,以确保公平可重复的比较。

与主流模型的对比实验结果如表5所示。

实验结果表明,所提方法达到97.1%的精确率和89.9%的召回率,分别比YOLO11n提高了2.0和8.3个百分点,表明模型在复杂背景条件下检测鲁棒性的显著增强。mAP@0.5:0.95达到60.9%,超过YOLO11n的54.0%,接近RT-DETR-L的性能,同时仅需其约十二分之一的参数量,显著降低了计算复杂度。与早期模型如YOLOv10n、YOLOv9n和YOLOv8n相比,所提框架在保持相似或更低参数量的同时,mAP@0.5分别提升了8.0%、14.5%和13.2%;mAP@0.5:0.95分别提升了11.0%、20.3%和17.6%。与Faster R-CNN相比,模型mAP@0.5提升11.6%,mAP@0.5:0.95提升12.5%,参数量减少超过95%。总之,所提多尺度与小目标检测框架在低空无人机检测任务中展现出卓越的检测精度、增强的小目标敏感性和优异的模型效率,显著优于所选基线模型,凸显其在复杂真实场景中实际部署的广阔潜力。

表5. 与主流目标检测模型的对比结果

| 模型 | P | R | mAP@0.5 | mAP@0.5:0.95 | 参数量 | FLOPs |

|---|---|---|---|---|---|---|

| Faster R-CNN | 86.9 | 80.3 | 82.8 | 48.4 | 136.87 | 302.45 |

| RTDETR-L | 98.0 | 90.5 | 96.8 | 62.8 | 32.00 | 103.5 |

| YOLOv8n | 93.4 | 80.8 | 81.2 | 43.3 | 3.00 | 8.1 |

| YOLOv9n | 93.0 | 73.1 | 79.9 | 40.6 | 1.9 | 7.6 |

| YOLOv10n | 94.1 | 78.9 | 86.4 | 49.9 | 2.2 | 6.5 |

| YOLO11n | 95.1 | 81.6 | 87.6 | 54.0 | 2.58 | 6.3 |

| Ours | 97.1 | 89.9 | 94.4 | 60.9 | 2.70 | 11.2 |

3.6 可视化结果

为进一步验证所提模型在复杂背景条件下检测小无人机目标的有效性,本研究从多个角度呈现了一系列可视化分析。可视化包括三个方面:精确率-召回率(P-R)曲线、检测结果可视化和热力图。

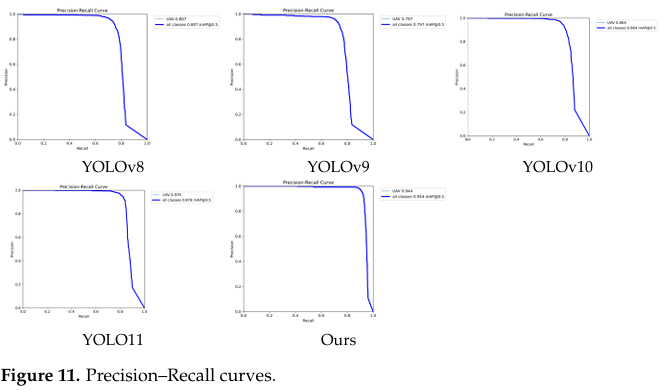

图11展示了不同模型在DeTFly测试集上的PR曲线。与YOLOv8n、YOLOv9n、YOLOv10n和YOLO11n相比,所提方法展现出明显更优的PR曲线,曲线更接近理想右上角。这表明所提模型在各种置信度阈值下均实现卓越的检测性能和鲁棒判别能力,特别适用于需在低置信度设置下保持高召回率的复杂应用场景。

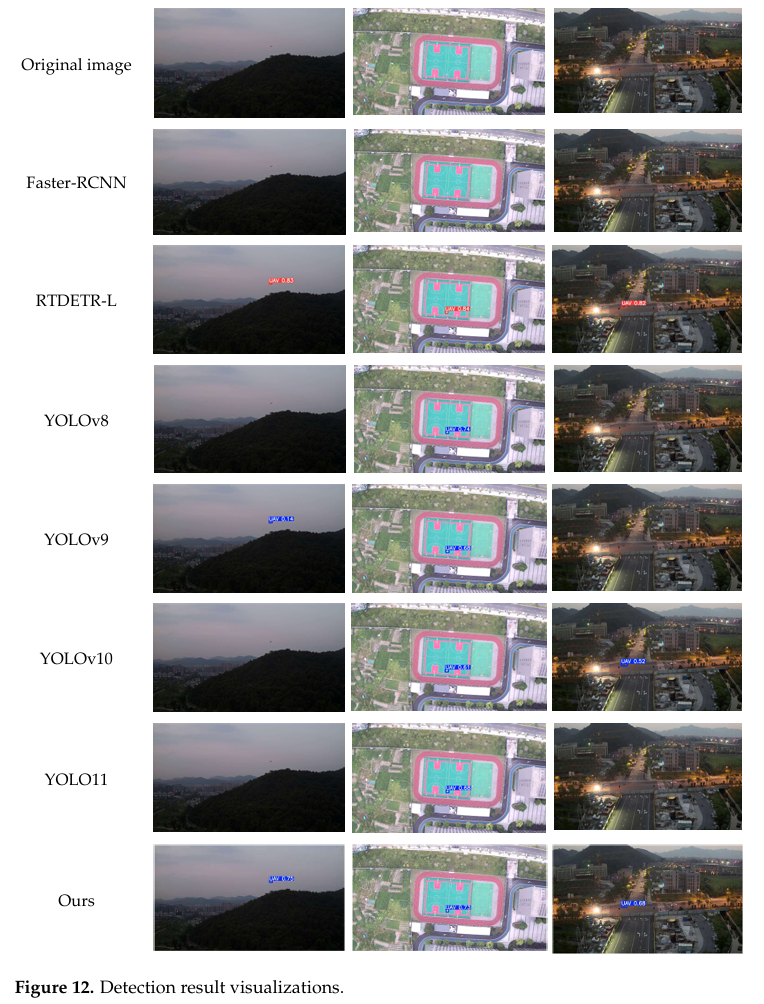

图12可视化了代表性测试图像上的检测结果,包括带对应置信度分数的边界框。可以观察到,所提模型即使在严重背景杂乱和遮挡条件下也能准确定位小无人机目标,并分配比其他模型更高的置信度分数。相比之下,竞争模型在类似场景中常表现出不稳定的置信度分布或漏检。如图12所示,在城市场景中,Faster-RCNN、YOLOv8、YOLOv9和基线模型均未能检测到无人机目标,而我们的方法成功识别了它。在其他复杂环境中也观察到类似的失败案例。这些结果证明,C3K2-FB和RFCBAM模块的集成有效增强了模型聚焦判别性区域并抑制背景噪声的能力,从而减少复杂场景中的误报和漏报。

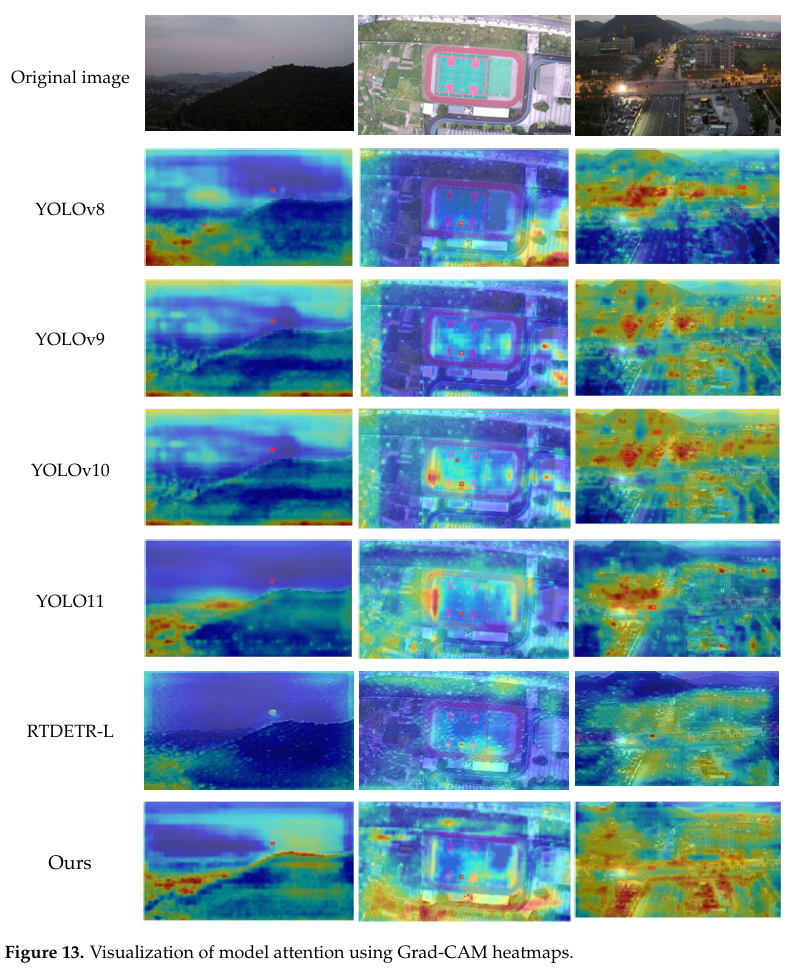

图13展示了使用Grad-CAM方法生成的热力图,以可视化模型在不同层级特征图上的注意力分布。所提模型在高层语义特征中对无人机轮廓和机身区域表现出清晰的注意力聚焦,而非被树木、建筑物或天空等无关背景纹理误导。这一结果进一步验证了MS_FPN模块在增强边缘敏感性和空间感知方面的作用,从而提升模型对小型或不明显目标的感知精度。

4. 结论

本文提出了一种专为杂乱环境中低空无人机检测定制的多尺度与小目标检测框架,其中小目标尺寸、背景复杂性和尺度变化构成了重大挑战。基于YOLO11架构,引入了三项关键增强:C3K2-FB模块用于改进特征提取并抑制无关背景噪声;MS_FPN模块实现有效的多尺度融合并增强小目标的边缘表示;RFCBAM检测头集成空间与通道注意力以提升对判别性特征的关注度。实验结果表明,我们的模型实现了卓越性能,mAP@0.5达94.4%,mAP@0.5:0.95达60.9%,比基线YOLO11n在mAP@0.5:0.95上提升+6.9%。与其他最先进模型如RT-DETR-L和YOLOv10n相比,我们的框架在检测精度与模型复杂度之间提供了更优的权衡,参数量仅2.7M,FLOPs为11.2。这些特性使该框架成为机场周界防护、敏感设施监控和公共活动安全等实时无人机监测与安全防御应用的有力候选方案。

尽管取得这些令人鼓舞的结果,当前局限性仍然存在。所提模型尚未在动态跟踪条件或极端天气环境下进行广泛验证,其中运动模糊、遮挡和光照变化可能降低性能。在未来工作中,我们计划使用UAVSwarm和UAVFly等基准进行全面的跨数据集评估,并将模型扩展到实时多目标跟踪、无人机群检测和多传感器融合场景,以进一步增强其在真实世界部署中的鲁棒性和应用潜力。

作者贡献:方法论、软件、论文初稿撰写、资金获取,Z.Y.;方法论、监督、论文审阅与编辑、概念化、资金获取,R.W.;数据管理、软件,W.C.;数据管理,K.D.;资源、验证、调查,Z.H.;论文审阅与编辑、概念化、监督,Y.H. 所有作者均已阅读并同意本稿件的发表版本。

资助:作者声明本研究、作者身份和/或出版获得了资金支持。本研究工作得到广西壮族自治区科技计划项目(编号:AD23026273);2024年大学生创新创业训练计划项目(大创)(编号:202410602080);2021年中国高校产学研创新基金项目(编号:2021ITA10018);人工智能与信息处理重点实验室基金项目(编号:2022GXZDSY101)的资助。

数据可用性声明:数据可根据要求提供。

利益冲突声明:作者声明不存在利益冲突。