「让无人机操作"归于直觉"」

目录

[01 用手势操控无人机](#01 用手势操控无人机)

[02 技术亮点](#02 技术亮点)

[03 实验与表现](#03 实验与表现)

[实验 1:轨迹飞行与避障(6-DoF UAV)](#实验 1:轨迹飞行与避障(6-DoF UAV))

[实验 2:物体交互抓取(7-DoF UAV + 夹爪)](#实验 2:物体交互抓取(7-DoF UAV + 夹爪))

[04 总结与延伸](#04 总结与延伸)

你操控无人机的时候,大概率都经历过这种别扭感:两根摇杆能飞,但要同时顾方向、速度、高度,还得盯着画面判断有没有危险,脑子像开了十几个标签页。更麻烦的是,越紧张越容易把动作做大,一不小心就"冲过头"。

现在也有不少无人机厂商尝试简化这种复杂的遥控器操作,比如将遥控器换成单手操控的惯性摇杆,结合VR眼镜一起控制无人机(如大疆的FPV穿越摇杆,影翎A1等),但是这种操作方式仍然需要时间适应,并且没有解决飞手操控无人机时同时需要处理的信息过多的问题。

Glove2UAV 这篇工作想做的,是把控制变得更像人的直觉:手往前倾,无人机就前进;手往左歪,它就侧移。同时再加一条"触觉通道":当飞得太快超过阈值时,手套直接震动提醒,给操作者一个不用看屏幕也能感知风险的信号。

01 用手势操控无人机

采用手势来操控无人机:

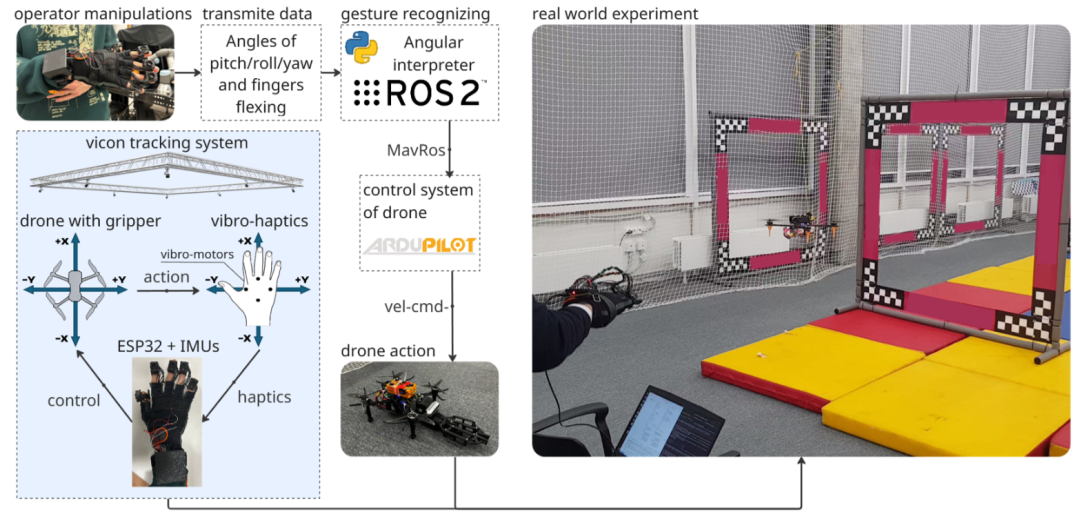

操作者戴手套 → 手套采 IMU → PC 端解算与映射 → 发指令给 UAV,UAV 再把遥测数据回传,用来触发手套震动。

这只手套的核心传感器是 IMU(惯性测量单元,能测加速度和角速度)。它分别装在手掌/手腕以及手指上,用来估计"手掌朝向"和"手指弯曲状态"。硬件上用 ESP32 做采集与通信,还配了振动马达用于触觉反馈。

在算法上,它走的是轻量路线:

-

ESP32 端先做滑窗中值滤波,压掉离群点,然后把数据发到电脑端。

-

电脑端再做姿态估计:计算出手掌手势所映射的无人机飞行方向 roll/pitch/yaw;手指则用简化 2D 的互补滤波融合加速度倾角与陀螺积分。

-

最后把这些姿态/手势映射为少量"控制指令":前后、左右、以及高度步进等;在带夹爪的无人机平台上,还能用手指闭合触发抓取。

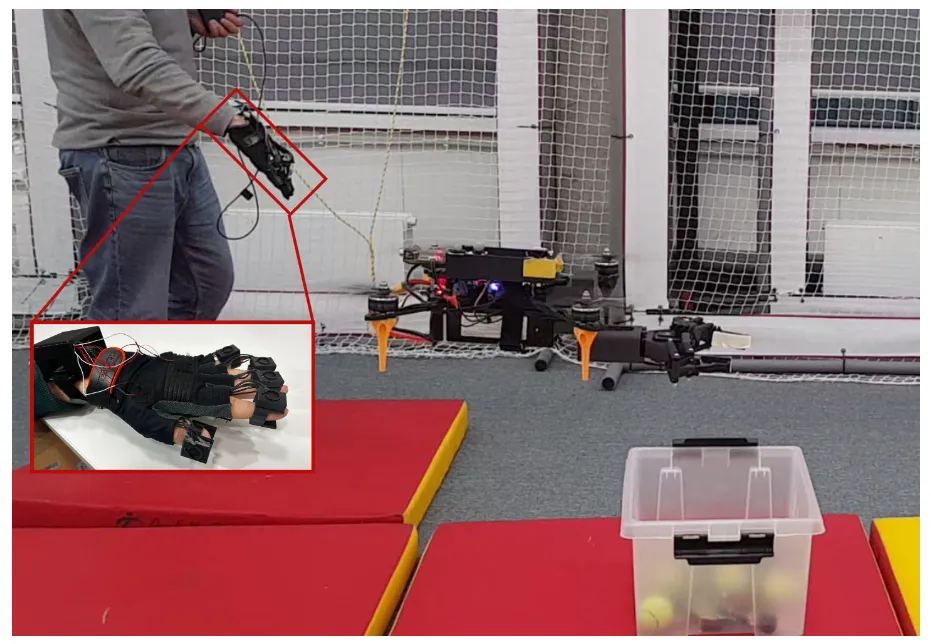

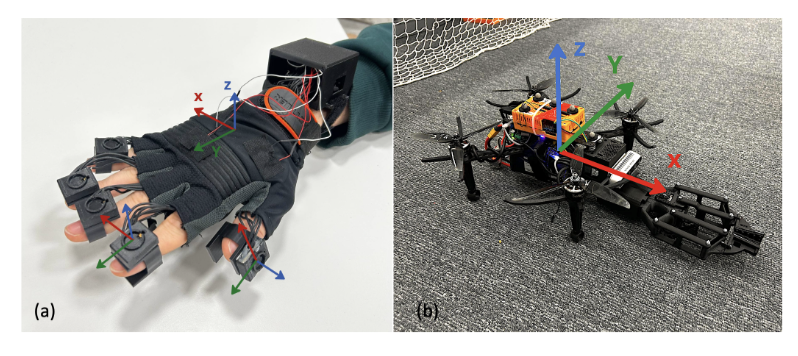

图1|硬件实物:手套负责"感知+震动",无人机负责"执行+回传"(a) 是可穿戴 IMU 手套,除了传感器外还集成了振动马达,用于速度超限等情况的触觉提醒。(b) 是用于验证这套交互方式的无人机平台,也就是整套系统最终要落地执行的对象

02 技术亮点

把"摇杆语法"换成"身体直觉"

用手的 roll/pitch 来控制无人机的横向与前后移动,让操作者不必在摇杆上"翻译意图",而是直接用身体姿态表达。

这套映射并不追求复杂指令集,而是用少量覆盖常见飞行行为,降低学习成本,适合把无人机控制变成一种"上手就能试"的交互方式。

它强调的是:控制不一定要更复杂,关键是让人的动作与无人机的动作通路更自然,减少"认知切换"。

图2|系统架构:三条信息流,一条链路跑通"输入-控制-反馈"。图中把关键模块拆开:手套采集 IMU 数据发到 PC 端处理,PC 端生成控制命令发给无人机;无人机再回传遥测数据,用于触发振动提示。换句话说,这是一个把"手势输入"和"安全反馈"都串起来的遥操作框架

复杂控制问题简单化

作者没有堆大模型,而是用中值滤波、互补滤波等等轻量方法,把 IMU 信号处理做成可实时跑的链路,这些算法足够轻量化,能够轻松Cover手势实时交互控制的场景,同时也经受过广泛的验证,具备足够的鲁棒性。

更实用的是,他们提供了几种"防翻车按钮":比如 Reset pose(重置姿态)、Zero-back alignment(纠正漂移对齐)、Finger lock(飞行控制时临时锁住手指识别,避免误触发)。

这部分看起来不起眼,但非常贴近真实使用场景:可穿戴交互最怕"越用越漂、越用越乱",他们给出了对策框架。

图3|从 IMU 到飞控:信号处理、姿态估计、指令映射一条龙。这张图把"手套数据如何变成无人机动作"讲得很清楚:先对 IMU 信号做基础滤波,再估计手掌姿态与手指状态,最后映射成少量控制指令(比如前后/左右/高度步进等),并实时发送给无人机执行

触觉反馈的"安全提示"

无人机飞行时,操作者往往同时盯画面、看环境、做控制,注意力很容易被耗尽。Glove2UAV 用一个简单的触觉机制补上:当 UAV 遥测速度超过阈值,手套振动提示"你飞快了"。

这种设计的价值在于它不跟视觉通道抢资源,你不用低头看数值,也能立刻意识到风险。

作者也观察到振动提示会促使操作者更谨慎(手势更小、转向更保守),虽然他们明确说定量评估留给未来工作,但这个"触觉安全通道"的思路已经很清晰。

03 实验与表现

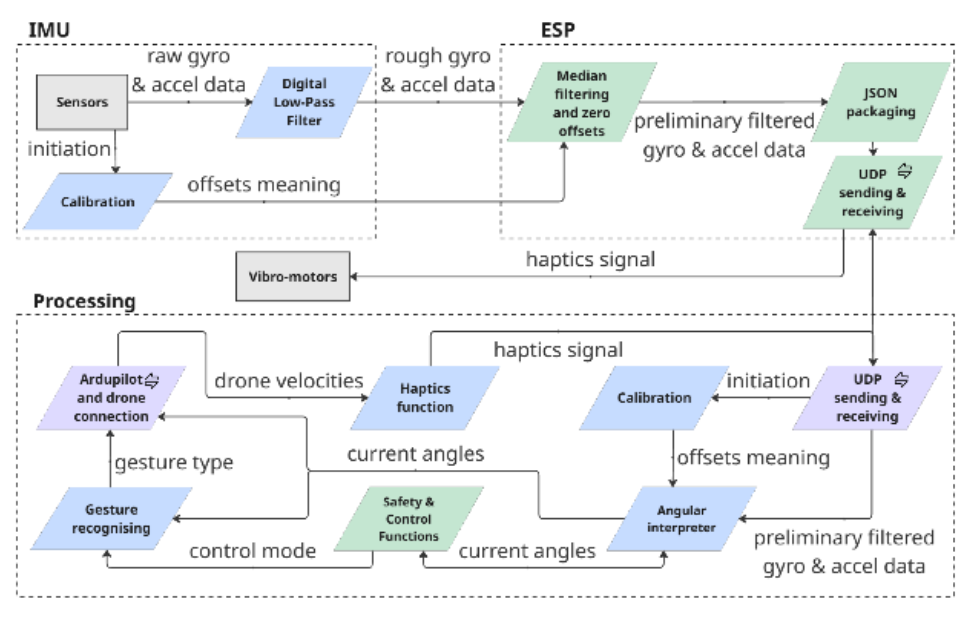

作者把实验定位为可行性验证,核心不是追求毫米级精度,而是证明"这套交互链路能跑通,并且手势变化能驱动无人机产生同步的运动响应"。

实验 1:轨迹飞行与避障(6-DoF UAV)

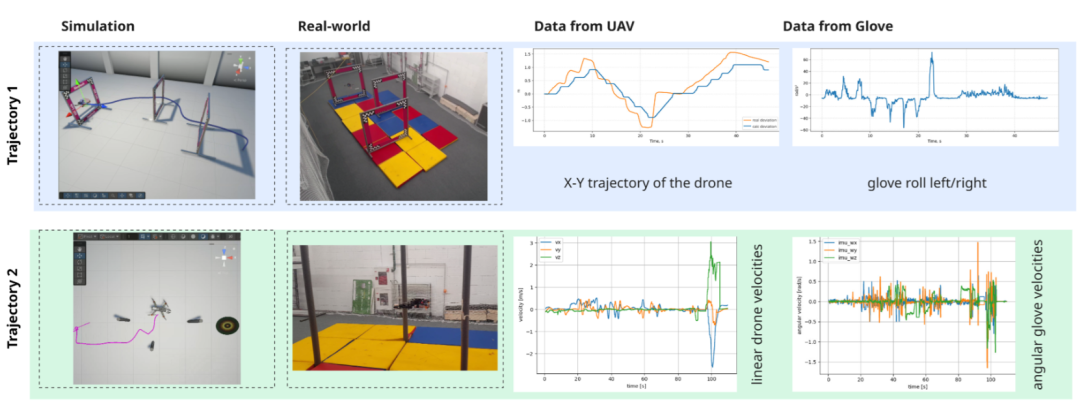

他们让操作者用手的 pitch 控制前进/后退、roll 控制左右平移,在预定义路线下飞行并避障。实验中同步记录 IMU 与无人机遥测,并展示了仿真回放与真实飞行对照,重点呈现"手势变化"和"飞行响应"能对齐。这部分直接回应了亮点 1:姿态映射确实能作为一种直觉控制方式跑通基本飞行动作。

图4|轨迹跟随与避障,仿真和真机对得上才算数。这里对比了两条代表性轨迹:同样的手势控制逻辑在仿真里能飞通,在真实环境里也能飞出相近的轨迹效果。作者用这种"仿真-真机对照"的方式证明:这套手势控制不是只在模拟器里好看

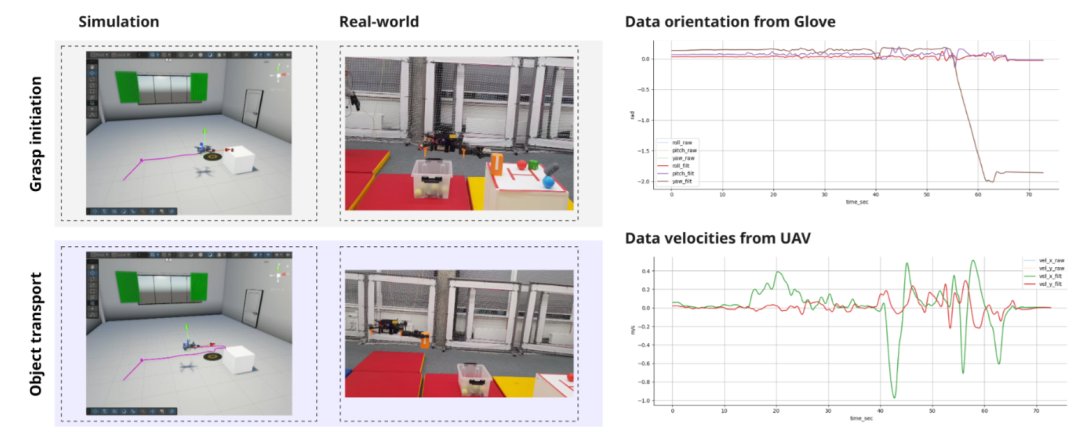

实验 2:物体交互抓取(7-DoF UAV + 夹爪)

在带夹爪的平台上,他们把"手指闭合"映射为夹爪抓取,流程是接近物体→触发抓取→带走,同样做了仿真与真实对照,并给出了同步时间序列。可见手指手势不仅能用来"飞",还能扩展到更具任务感的交互指令。

图5|抓取任务,验证手势不仅能"飞",还能"做事"。这部分对比了仿真与真实执行:操作者用手指动作触发夹爪抓取,完成接近目标、抓取并带走的流程。它展示了这套接口的扩展性,控制不止是"方向移动",也能支持更具任务感的交互动作

04 总结与延伸

Glove2UAV 的贡献并不在于提出多么复杂的新算法,而在于把"直觉交互"这件事做成了一条能跑通的闭环链路:可穿戴 IMU 采集 → 轻量姿态估计 → 控制原语映射 → 真机飞行与抓取验证 → 触觉速度预警。

这类工作提醒我们:让机器人更好用,往往不只靠更聪明的模型,也靠更贴合人的输入方式,以及更不打扰注意力的反馈通道。

如果未来无人机真的走向"人人可控",也许真正的门槛不是飞控算法,而是你能不能用最自然的方式,把意图稳稳递给机器。

REF

论文标题:Glove2UAV: A Wearable IMU-Based Glove for Intuitive Control of UAV

论文链接:https://arxiv.org/pdf/2601.15775

论文作者:Amir Habel, Ivan Snegirev, Elizaveta Semenyakina等