面对屏幕上加载到一半就因显存不足而中断的模型训练任务,计算机专业研究生李涛再次感受到硬件瓶颈带来的无奈。他环顾实验室里那几台沉重的塔式工作站,思考着一个问题:如果有一台笔记本能像工作站一样完成模型训练,又能在图书馆和教室之间自由移动,那该多好。

随着AI大模型从云端逐步走向本地部署,个人计算设备正面临着前所未有的性能挑战,大模型训练对GPU显存、内存带宽和处理器并发的需求呈指数级增长,直接关系到学习效率和研究进度。

在专业显卡不断升级的推动下,高性能笔记本电脑正在突破传统移动设备的性能限制,逐渐满足从模型推理到局部微调,甚至中等规模训练的计算需求。

大模型学习的硬件挑战

在大模型学习过程中,硬件配置直接影响学习效果和效率。不同于传统编程或视频剪辑,AI模型训练对计算资源有着特殊且苛刻的要求。

这背后的核心瓶颈在于模型参数的海量增长。当运行一个70亿参数的大语言模型时,仅加载模型本身就需要至少14GB的显存空间。如果涉及微调训练,所需显存可能翻倍甚至更多。

模型训练分为不同层次:推理级(已训练模型运行)、微调级(基础模型轻量训练)和训练级(从零训练)。对于大多数学习者而言,微调级是个人设备的主要应用场景。

这一层次既不需要从零开始构建模型的巨大成本,又能满足在特定领域或任务上优化模型的实际需求。

移动工作站的革新

随着专业图形处理器技术的突破,以ThinkPad P16 2026 AI元启版为代表的移动工作站正在重新定义便携式设备的性能边界。这款设备的核心亮点在于NVIDIA RTX PRO 5000 Blackwell专业显卡,提供高达1824 TOPS的GPU算力。

这一算力水平足以处理工程设计中的复杂模型渲染,甚至能在移动环境下承接大模型搭建中的高强度数据运算任务。

除了强大的硬核算力,这类移动工作站还集成了AI能力软件生态。ThinkPad P16搭载的"天禧个人超级智能体"包含了知识库、模型广场、AI Space和玲珑台四大核心模块。

这些软件模块能够与硬件能力协同工作,实现从数据处理到模型部署的全流程支持,将AI能力深度融入高负载工作场景。

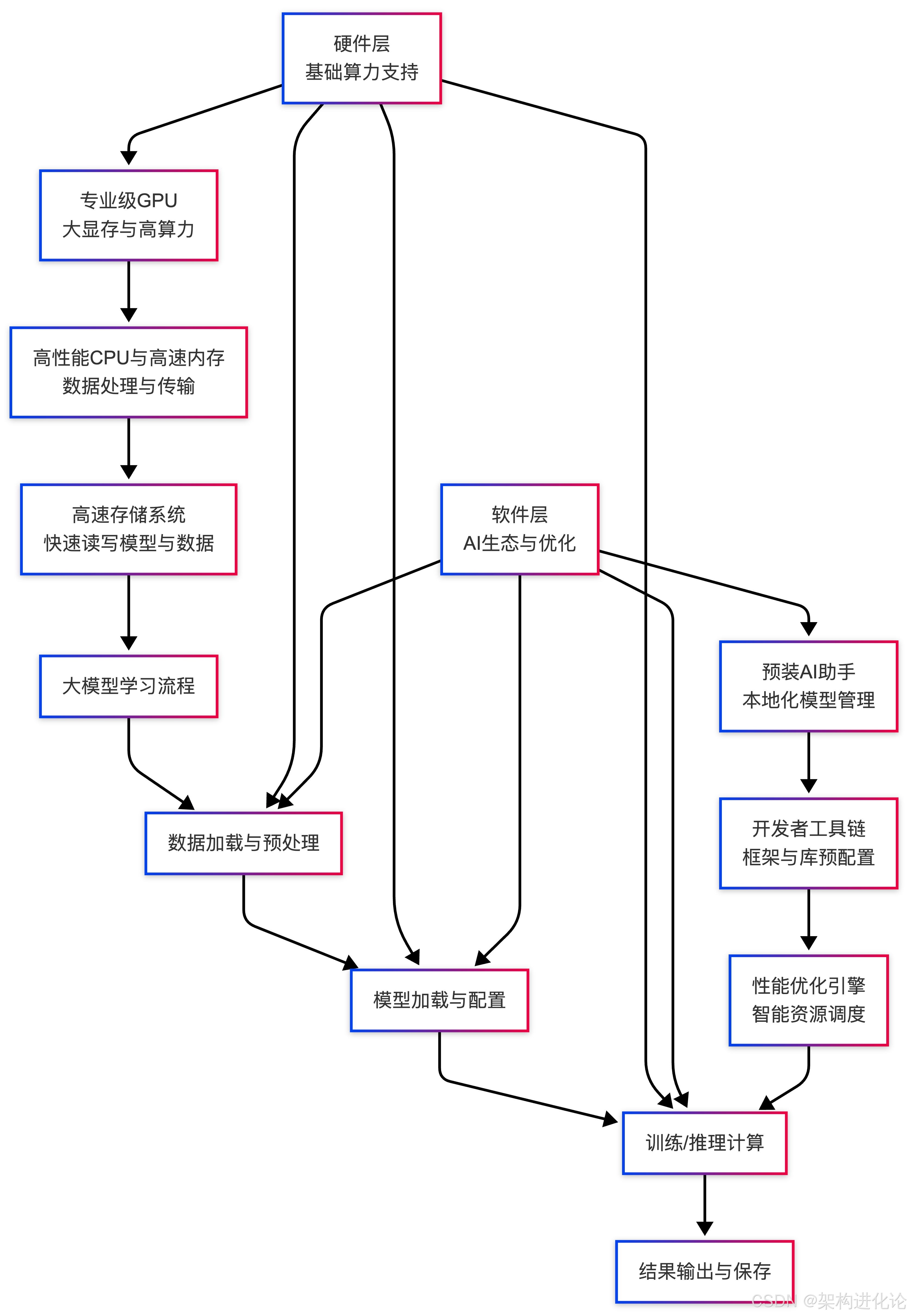

下面的架构图展示了专业AI移动工作站如何通过软硬件协同为大模型学习提供支持:

对于工程计算、建筑可视化、影视后期等领域的专业人士而言,这类设备既提供了桌面级工作站的计算性能,又保持了移动办公的灵活性。

关键硬件配置解读

选择适合大模型学习的笔记本电脑,关键在于理解各硬件组件在模型训练中的作用与相互关系。(扩展阅读:个人开发者选 GPU 的简单方案、MacBook Pro M4 Max vs. RTX 4090/5090笔记本:个人开发者如何选择大模型训练推理设备?、大模型训练与推理显卡全指南:从硬件选型到性能优化、大模型训练与推理显卡全指南:从个人开发者到企业级解决方案)

GPU显卡是模型训练的核心,它不仅决定了计算速度,更通过显存容量直接影响可训练的模型规模。NVIDIA RTX 50系列笔记本电脑GPU支持最新的AI软件堆栈,能显著加速深度学习训练。

以RTX 5060为例,在Transformer微调和LLM推理任务中,相比仅有集成显卡的笔记本,其性能提升可达数倍。

内存配置同样至关重要,32GB已成为运行中等规模模型的最低门槛。当加载Qwen3-235B-A22B-IQ2_S这类混合专家模型时,内存峰值占用可接近64GB。

处理器在多任务处理和模型训练前期数据准备阶段发挥关键作用。多核心设计有助于并行处理多个训练任务,同时高速缓存能够加快模型权重加载速度。

学生与初学者的实践选择

对于预算有限的学生群体,基于英特尔酷睿Ultra处理器的中端笔记本提供了性价比与性能的平衡点。联想YOGA Air14Aura AI元启版搭载的酷睿Ultra7-258V处理器,具有115TOPS平台算力,支持本地运行轻量级AI模型。

这类设备具备运行Stable Diffusion图像生成和轻量版大语言模型的能力,足以满足课程作业、小型项目研究等学习需求。

对于经常需要在实验室、教室和图书馆之间移动的学生,便携性和续航同样重要。荣耀MagicBook Pro14的92Wh超大容量电池可支持长达6小时的连续代码调试。

而联想小新Pro 14 GT 2025的84Wh电池配合140W快充技术,只需20分钟即可补电50%,能够有效应对学生全天候的学习需求。

下表对比了适合AI学习的几款主流笔记本配置:

| 笔记本型号 | 核心配置 | AI算力 | 显存/内存 | 适用场景 |

|---|---|---|---|---|

| ThinkPad P16 2026 AI元启版 | Ultra 9-285HX + RTX PRO 5000 | 1824 TOPS | 最高192GB内存 | 专业级模型开发与训练 |

| 联想YOGA Air14Aura AI元启版 | Ultra7-258V + ARC核显 | 115 TOPS | 32GB LPDDR5X | 学生全场景学习与轻量模型部署 |

| 荣耀MagicBook Pro14 | U9-285H | - | 16GB LPDDR5 | 长续航编程与轻度剪辑 |

| 未来人类X76 | i7-14650HX + RTX 5070Ti | 992 AI TOPS | 32GB/64GB可选 | 入门级模型学习与多任务处理 |

| 联想小新Pro 14 GT 2025 | Ultra 9 285H | 99 TOPS | 32GB LPDDR5X | 平衡性能与便携的学生全能本 |

AMD平台的创新方案

AMD锐龙AI Max+ 395处理器提供了解决AI应用瓶颈的创新思路。通过统一内存架构,该系统可以将系统内存的一部分动态分配给集成显卡作为显存使用。

这项技术使集成显卡能够获得最高96GB的显存分配,从而支持运行70B参数级别的大语言模型,这在传统笔记本架构中几乎不可能实现。

基于该平台的迷你主机如联宝AI MINI-PC、极摩客EVO-X2等,体积小巧却具备强大的AI计算能力。

与高性能移动工作站相比,这类设备在保持强大AI计算能力的同时,价格更为亲民,是学生和研究者的理想选择。

应用场景与性能匹配

了解不同硬件配置对应的实际应用场景,能够帮助学习者做出更加精准的选择。

以计算机专业学生为例,日常编程学习与AI项目开发所需设备存在显著差异。同时运行代码编辑器、虚拟机和数据库时,酷睿Ultra处理器的混合架构能够平衡性能与功耗。

当涉及4K视频剪辑与渲染时,独立显卡的CUDA加速能力将发挥关键作用。搭载RTX 5070Ti显卡的未来人类X76在3D渲染和高画质游戏中表现优异,同样适合图形密集型任务。

对于AI模型的实际部署,拥有RTX 4090 24GB显存的笔记本可以支持7B~13B参数模型的微调与推理,而配备RTX 4060 Ti 16GB的配置则能以约300 tokens/s的速度运行部分开源模型。

配套生态与长期价值

选择大模型学习设备时,配套软件生态同样值得关注。ThinkPad P16 2026 AI元启版内置的模型广场提供了DeepSeek、豆包、文心一言等多种大模型选择,方便用户根据需求灵活切换。

长期来看,设备的扩展性和使用寿命也是重要考量因素。ThinkPad P16的四插槽内存与三插槽硬盘设计,支持最高192GB内存和12TB存储扩展,为未来需求增长留出充足空间。

专业认证确保设备在运行CAD等专业软件时的稳定性,ISV认证能够避免项目交付过程中因软件兼容性问题导致的风险。