2026.2.12

本文提出了一种新颖的纹理保留扩散模型,用于锥形束CT到CT图像合成。该模型通过自适应高频优化、双模态特征融合模块和边缘感知边界约束,显著提高了合成图像的细节、泛化性和鲁棒性,有望提升临床诊断和治疗规划的准确性。

Title 题目

01

Texture-preserving diffusion model for CBCT-to-CT synthesis

用于CBCT到CT合成的纹理保留扩散模型

文献速递介绍

02

锥形束CT(CBCT)因其低辐射剂量和适用于局部解剖评估的特点,在图像引导手术、放射治疗和牙科干预等多种临床场景中扮演着基础性角色。然而,CBCT系统存在图像质量受损、噪声增加和伪影等固有局限性,限制了其在特定临床环境中的适应性。相比之下,计算机断层扫描(CT)技术提供更高的分辨率、更少的伪影和更好的软组织对比度,对于精确解剖描绘和全面的病理评估至关重要。因此,CBCT和CT之间不同的成像特性使得需要一个中间机制来弥合这种差异,从而产生了CBCT到CT合成的需求。深度学习技术已显著促进了CBCT到CT的合成,但生成对抗网络(GANs)在训练和应用中仍面临引入不真实结构和训练复杂性高等挑战。去噪扩散概率模型(DDPMs)作为图像合成的新工具已崭露头角,但现有扩散模型在生成高频细节方面仍有不足,且训练数据不足可能导致图像细节丢失。为解决这些挑战,本研究提出了一种专门为CBCT到CT合成设计的纹理保留扩散模型。该模型通过自适应小波基高频优化模块增强CBCT和CT分支的高频细节,通过基于注意力的双模态特征融合模块有效融合跨模态特征,并引入基于梯度信息的边缘感知边界约束以保留合成CT图像中的精细细节和尖锐过渡。

Aastract摘要

02

锥形束CT(CBCT)作为一种重要的医学成像模式,在多种临床应用中发挥关键作用,但其图像质量受限且噪声较高。相比之下,计算机断层扫描(CT)具有更优越的分辨率和组织对比度。因此,通过CBCT到CT合成来弥合这两种模态之间的差距变得至关重要。深度学习技术已显著推动了这一合成过程,但生成对抗网络仍面临挑战。去噪扩散概率模型(DDPMs)已成为图像合成领域一种有前景的替代方案。本研究提出了一种新颖的纹理保留扩散模型,专门用于CBCT到CT合成,该模型融合了自适应高频优化和双模态特征融合模块。我们的方法旨在增强高频细节,有效融合跨模态特征,并保留精细的图像结构。广泛的验证表明,本模型性能优于现有方法,展现出更强的泛化能力。所提出的模型提供了一条变革性的途径,以提高各种临床环境中的诊断准确性并完善治疗计划。这项工作代表了实现无创、更安全、高质量CBCT到CT合成的关键一步,推动了个性化诊断成像实践的发展。

Method 方法

03

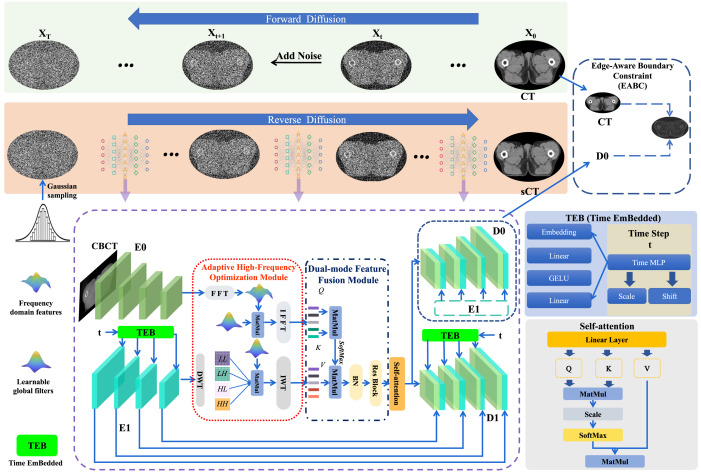

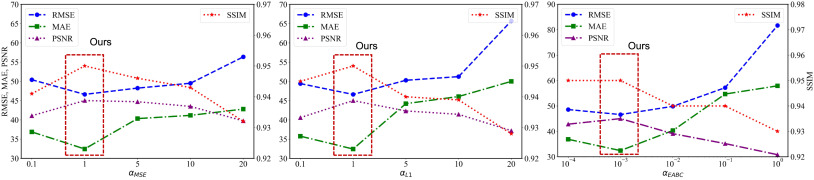

本方法(如图1所示)采用双分支注意力神经网络去噪噪声CT图像。该框架通过包含自适应高频优化(AHFO)模块、双模态特征融合(DMFF)模块、时间嵌入(TEB)模块和边缘感知边界约束(EABC)损失函数,增强了传统扩散范式,提升了模型的特征提取能力。在反向扩散步骤中,条件分支整合CBCT图像以引导主CT生成分支中当前噪声CT图像的恢复过程。自适应高频优化模块利用FFT在CBCT分支中捕捉全局信息,WT在CT生成分支中捕捉局部和精细结构信息,并通过可学习的加权矩阵优化子带特征。双模态特征融合模块采用注意力机制,有效地融合了CT分支的重建特征和CBCT分支的条件特征。时间嵌入模块在模型的编码器和解码器中引入时间信息,通过多层感知机动态调整模型输出特征。损失函数由MSE损失、L1损失和EABC损失组成,EABC损失通过拉普拉斯算子和二值化生成边缘图,确保合成CT图像的边界保真度。为提高推理速度,本研究采用了DDIM的策略,通过选择时间步子集进行加速。实验数据集包括内部和外部盆腔数据集以及头部数据集,所有数据均通过SyN非线性配准进行对齐。模型性能通过RMSE、MAE、SSIM和PSNR等指标进行评估,并与多种现有方法进行比较。所有实验均在PyTorch框架下,使用NVIDIA GeForce RTX 3090 GPU进行,并采用AdamW优化器和余弦退火学习率调度。

Discussion讨论

04

从CBCT数据合成CT图像是利用CT优势同时规避CBCT技术限制的有效途径,有助于提高图像质量、组织区分和解剖理解,从而提升诊断和治疗计划的准确性。扩散模型通过提供稳定且可解释的训练方法,避免了生成对抗网络(GANs)的模式崩溃和可解释性问题,从而能够生成高质量的CT图像。与U-Net和GANs的端到端方法不同,本研究方法引入了马尔可夫链来迭代生成由CBCT数据引导的CT图像,并采用辅助解码器D0,形成了双任务架构。我们对传统DDPM网络的修改包括四个主要组件:自适应高频优化(AHFO)、双模态特征融合(DMFF)、时间嵌入(TEB)和额外的边缘感知边界约束(EABC)。为了全面评估我们的方法,我们对三个独立数据集进行了多站点验证,包括内部和外部盆腔数据集以及不同的头部数据集。通过大量实验,我们的方法在各种数据集上的有效性得到了充分验证,显示出优于U-Net、GANs和DDPMs等现有最先进模型的卓越性能,强调了其泛化性、有效性和多功能性。在本框架中,我们整合了FFT和WT来增强不同分支的特征表示。在CBCT分支中利用FFT捕获全局信息,而在从噪声输入生成CT图像的分支中,我们采用了擅长处理局部特征和提取纹理细节的小波变换(WT)。FFT和WT的互补优势使得我们能够同时捕获全局和局部信息,从而改进了由CBCT引导的从噪声输入生成CT图像的能力。高频优化模块之后,特征融合模块被开发用于两种模态特征的交互,并在表5中展示了其优越性。我们提出了边缘感知边界约束损失函数,强调边界信息在生成任务中的重要性。该函数通过梯度反映信息变化的方向和大小,提高了生成的合成CT图像的质量。通过施加边缘感知边界约束,我们的方法确保了合成CT图像中的边界与真实CT图像中的边界紧密对齐,通过使用先进的边缘检测技术和边缘引导损失函数,保留了生成的合成CT图像中的精细细节和尖锐过渡,提高了视觉保真度和临床可解释性。目前,我们的模型以监督方式促进CBCT到CT的合成。尽管模型在图像转换任务中表现出色,我们也认识到其在无监督域适应方面的潜力和局限性。主要地,我们的模型在条件生成任务中具有显著适用性,但依赖配对数据集,当数据标注昂贵或难以获取时可能受限。此外,扩散模型固有的噪声添加和去除步骤导致计算需求大,训练和推理时间较长。生成的合成CT体积在横向切片之间可能不连贯,导致冠状面和矢状面视图的不一致。未来工作可探索通过迁移学习或自监督学习技术减轻对配对数据的依赖,并优化模型以降低计算成本,从而提高模型在实际临床环境中的可行性。同时,研究解决多视图一致性的方法是一个重要方向。

Conclusion结论

05

本研究引入了一种专门为CBCT到CT合成设计的纹理保留去噪扩散概率模型。我们研究的关键贡献在于集成了高频优化模块、双模态特征融合模块和用于梯度信息保留的边缘感知边界约束,确保了生成CT图像的保真度。此外,通过在编码器和解码器模块中嵌入时间信息,我们的模型增强了对目标感兴趣区域的关注。全面的定量和视觉评估结果表明,所提出的方法优于U-Net、GANs和其他DDPMs。同时,本方法在生成过程中提高了可解释性。为了解决推理速度较慢的局限性,未来的工作将探索提高CBCT到CT合成任务中采样速度的方法,最终目标是更快地生成高精度图像,以促进其在临床实验中的应用。

Results结果

06

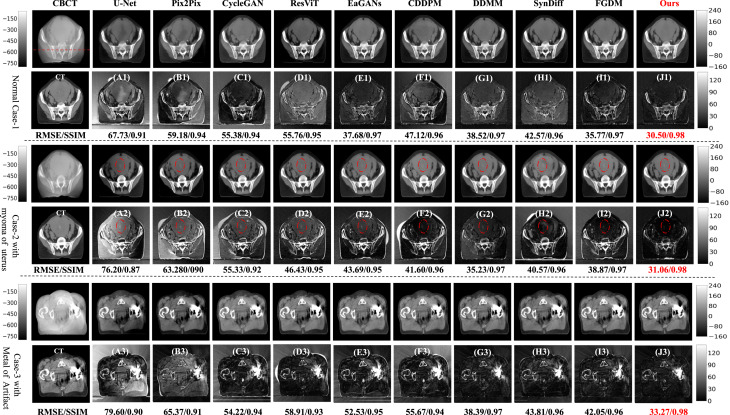

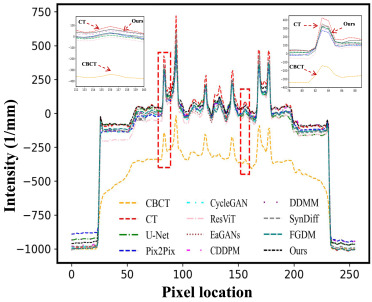

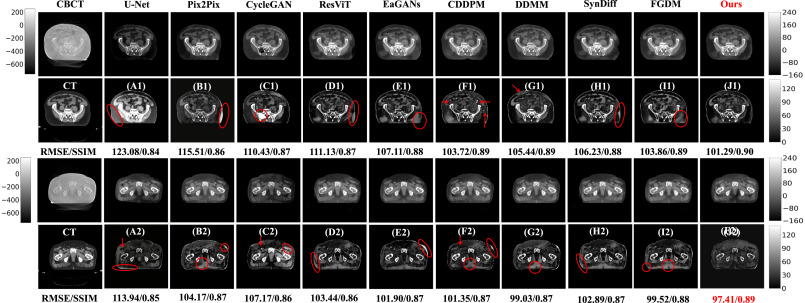

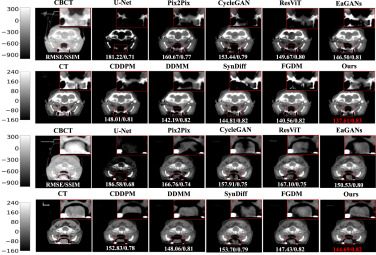

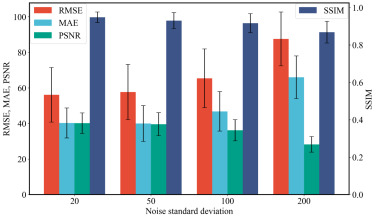

在内部盆腔测试数据集上,所提出的模型在所有评估指标上均表现出卓越性能,取得了最低的RMSE(46.62±11.77)和MAE(32.45±7.93),以及最高的SSIM(0.95±0.04)和PSNR(45.02±6.14)。与原始CBCT以及所有基线方法(包括U-Net、GANs和DDPMs)相比,模型显著提升了图像质量。定性分析(图2)显示,本模型生成的合成CT图像与原始CT扫描图像最为相似,尤其在子宫肌瘤病理变化和金属植入伪影处理上表现突出。图3的1D强度剖面图也进一步证实了模型在像素强度上与CT图像的接近性。在外部盆腔数据集上进行外部验证时,尽管所有方法的性能均有所下降,但本方法在所有评估指标上仍保持领先地位,展现出强大的泛化能力(表2和图4),能够有效减少其他方法引入的内部结构改变和灰度值误差。针对不同部位的头部数据集,本研究将仅在盆腔数据集上训练的模型进行测试,结果(表3和图5)表明本方法在所有指标上均优于其他方法,并能恢复更多的纹理细节,尤其在U-Net表现不佳的情况下,本模型仍能显著提升图像质量。消融研究证实了所提生成器、AHFO模块、DMFF模块和EABC模块的有效性,并验证了在CT分支中使用WT、CBCT分支中使用FFT的策略是最佳选择(表4、表5、表6)。此外,本研究通过引入不同噪声水平的实验,验证了模型对不完美CBCT图像(包括金属伪影和噪声)的鲁棒性(图7)。

Figure 图

07

图1.整体框架分别包括完整的正向和反向扩散过程。E1和D1分别是合成CT生成主分支中的编码器和解码器。E0是用于引入额外CBCT信息的编码器。D0是用于引入边缘感知边界约束额外损失函数的辅助解码器。

图2.盆腔内部测试数据集实验结果的视觉检查。此处选择了三个代表性病例:一个来自健康个体;一个来自子宫肌瘤患者,由红色虚线椭圆标记;一个来自髋关节金属植入患者。(A1-J1)、(A2-J2)和(A3-J3)是CT与相应预测合成CT之间的绝对差异图像。CBCT的显示窗为[-800, -50] HU。CT和合成CT的显示窗为[-160, 240] HU。

图3.1D强度剖面图,如图2所示,通过遍历红色虚线获得。图中插图清晰地展示了所提方法优于其他方法的卓越性能。

图4.盆腔外部测试数据集实验结果的视觉检查。(A1-J1)和(A2-J2)是CT与相应预测合成CT之间的绝对差异图像。外部测试数据集中CBCT的显示窗为[-750, 250] HU。CT和合成CT的显示窗为[-160, 240] HU。

图5.脑部数据集实验结果的视觉检查。第二行和第四行表示红色虚线矩形标记的放大区域。定量结果放置在预测图像的底部。CBCT的显示窗为[-1000, 340] HU。CT和sCT的显示窗为[-160, 240] HU。

图6.网络训练过程中在验证数据集上的评估结果。

图7.不同程度噪声对模型鲁棒性的影响。