https://robochallenge.cn/leaderboard

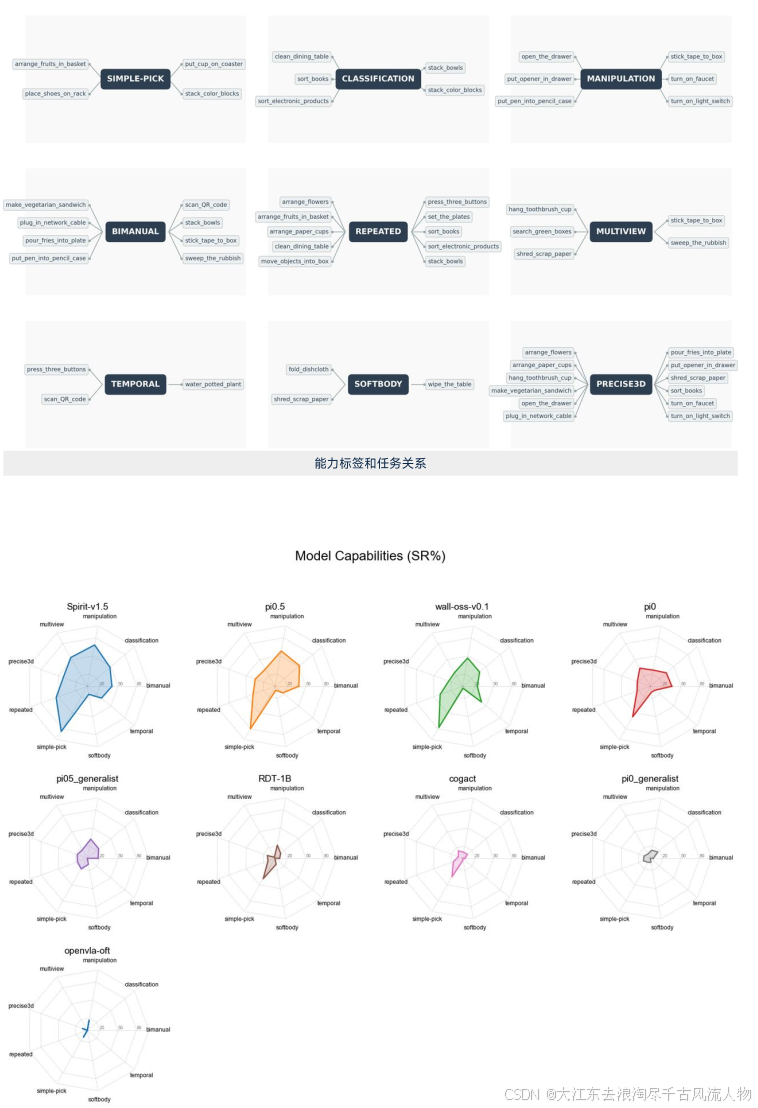

9 个能力维度本质上是对 VLA(Vision-Language-Action)模型的"能力解剖"。

RoboChallenge 能力维度拆解表

| # | 能力类别 | 代表任务示例 | 核心测什么 | 技术本质 | 对应 VLA 内部模块 |

|---|---|---|---|---|---|

| 1 | Classification | sort_books stack_color_blocks | 视觉识别 + 语义理解 | 物体类别区分、指令理解、语义对齐 | Vision Encoder + Language Alignment |

| 2 | Simple-pick | put_cup_on_coaster stack_color_blocks | 基础抓取与放置能力 | 抓取点预测、位姿估计、控制精度 | Grasp Head + Pose Prediction |

| 3 | Manipulation | open_drawer stick_tape_to_box | 连续状态控制能力 | 接触动力学、状态转移建模、连续动作生成 | Policy Head(连续控制) |

| 4 | Temporal | press_three_buttons water_potted_plant | 长时记忆 + 状态跟踪 | 任务阶段记忆、latent state 保持、避免动作幻觉 | Transformer Memory / Recurrent State |

| 5 | Softbody | fold_dishcloth | 软体物理建模能力 | 非刚体形变建模、受力预测、不可逆状态变化 | Implicit Physics Modeling |

| 6 | Precise3D | arrange_paper_cups | 三维空间精度 | 深度感知、IK 精度、误差积累控制 | Depth Modeling + Control Precision |

| 7 | Bimanual | 双臂协同任务 | 多体协调能力 | 两臂空间冲突规避、动作同步 | Multi-Agent / Multi-Arm Control |

| 8 | Repeated | 重复执行类任务 | 稳定性与鲁棒性 | 多次成功率、一致性、误差收敛 | Robustness / Policy Stability |

| 9 | Multiview | 多视角感知任务 | 多传感器融合能力 | 视角对齐、空间融合、场景一致性 | Perception Fusion Module |

零、从系统角度抽象一层

如果压缩成机器人完整 pipeline 对应关系:

| Pipeline 阶段 | 对应能力类别 |

|---|---|

| 感知 / 识别 | Classification |

| 抓取执行 | Simple-pick |

| 连续控制 | Manipulation |

| 任务记忆 | Temporal |

| 物理理解 | Softbody |

| 精度控制 | Precise3D |

| 协同控制 | Bimanual |

| 稳定性 | Repeated |

| 传感融合 | Multiview |

为什么任务设置为这几类?核心是关注哪些能力?(比如 分类是关注 识别的能力 ?),从"评测哲学"和"技术本质"两个层面拆解。

一、为什么要做能力分类?

RoboChallenge 的目标不是单纯排个总榜,而是:

回答:模型到底"会什么"?不会什么?

如果只看 SR(成功率),你只能知道:

- 模型 A:50%

- 模型 B:45%

但你不知道:

- A 是操作强?还是理解强?

- B 是抓取强?还是记忆强?

所以他们设计了能力标签体系(你图里那 9 类)。

这本质是:

把 VLA 模型拆解成「感知-理解-规划-控制」几个能力轴。

二、这几类能力到底在测什么?

按能力维度给你拆解核心关注点。

1️⃣ Classification(分类)

代表任务:sort_books、stack_color_blocks

核心测什么?

👉 视觉识别 + 语义理解能力

模型需要:

- 区分不同类别物体

- 识别目标物

- 根据语义做决策

技术上考察:

- VLM encoder 的视觉语义对齐能力

- embedding 的区分度

- 指令理解能力

⚠ 这里基本不考操作难度,主要是认知能力。

2️⃣ Simple-pick(简单抓取)

代表任务:put_cup_on_coaster、stack_color_blocks

核心测什么?

👉 基础 grasp & place 能力

技术核心:

- 物体检测

- 抓取点预测

- 位姿控制精度

这类任务类似机器人界的:

Hello World

3️⃣ Manipulation(复杂操作)

代表任务:open_drawer、stick_tape_to_box

核心测什么?

👉 连续动作生成能力

技术本质:

- 物体状态变化建模

- 关节空间连续控制

- 接触动力学理解

这是从"点对点抓取"升级到:

状态转移控制

4️⃣ Temporal(时序依赖)

代表任务:press_three_buttons、water_potted_plant

核心测什么?

👉 长时记忆 + 状态跟踪

技术考察:

- 是否有 memory token

- 是否能保持 latent state

- 是否出现"动作幻觉"

你报告里的 water_potted_plant 失败,本质是:

中间状态丢失,policy 失控

5️⃣ Softbody(软体操作)

代表任务:fold_dishcloth

核心测什么?

👉 物理建模能力

软体难在哪里?

- 非刚体

- 不可预测形变

- 受力不可逆

这对 VLA 是指数级难度提升。

6️⃣ Precise3D(三维精度)

代表任务:arrange_paper_cups

核心测什么?

👉 空间精度 + 位姿控制误差积累

技术考察:

- 深度感知质量

- IK 精度

- 控制 jitter 稳定性

7️⃣ Bimanual(双臂协同)

核心测什么?

👉 多体协调

难点:

- 两臂空间冲突避免

- 动作同步

- 双流 policy 协调

8️⃣ Repeated(重复执行)

核心测什么?

👉 稳定性

不是做一次成功,而是:

连续多次成功

这是鲁棒性测试。

9️⃣ Multiview(多视角)

核心测什么?

👉 多相机融合能力

是否真正用视觉推理,而不是"记忆场景"。

三、这套分类的真正核心

如果你从算法角度看,它本质在测:

| 能力类别 | 对应 VLA 内部模块 |

|---|---|

| Classification | Vision encoder + language alignment |

| Simple-pick | grasp head + pose prediction |

| Manipulation | policy head |

| Temporal | transformer memory |

| Softbody | physics implicit modeling |

| Precise3D | depth modeling + control precision |

| Bimanual | multi-agent control |

| Repeated | robustness |

| Multiview | perception fusion |

所以它其实是在拆解:

一个 VLA 模型的内部能力分布图

这也是你看到雷达图的意义。

四、为什么不按"任务分类",会出现什么问题?

假设我们按任务类别分:

厨房类任务

清洁类任务

收纳类任务

抓取类任务

装配类任务

听起来很直观,但问题是:

❌ 任务是"表象"

✅ 能力才是"本质"

举个例子:

做三明治(make_vegetarian_sandwich)

它属于"厨房任务",但它其实同时包含:

识别能力(分类)

抓取能力(simple pick)

双臂协同(bimanual)

精确3D定位(precise3d)

严格顺序(temporal)

如果按"厨房任务"分类,你根本不知道模型失败是因为:

不会识别番茄?

抓不稳?

双臂协调崩了?

记忆丢了?

所以:

任务分类不能诊断能力瓶颈。

五、从行业视角看,这种分类的战略意义

RoboChallenge 想解决一个核心问题:

当前 VLA 到底是"理解强"还是"操作强"?

从数据看:

- Classification 不差

- Simple-pick 很强

- Softbody 接近 0

- Temporal 很差

这说明:

当前模型更像"看得懂的抓取器",而不是"真正理解物理世界的智能体"。

六、你如果站在 SLAM / 机器人算法角度看

你会发现:

这个标签体系其实和机器人 pipeline 强相关:

感知 → 识别 → 位姿估计 → 规划 → 控制 → 反馈

而每个标签对应 pipeline 的某一环节。

七、总结

这些能力标签在回答一个关键问题:

具身模型到底在哪个环节出问题?

分类测认知

simple-pick 测抓取

manipulation 测状态控制

temporal 测记忆

softbody 测物理理解

它本质是一个"模型能力解剖系统"。