在当前人工智能Agent领域的发展浪潮中,各类框架层出不穷,大多数开发者都陷入了一种"加法思维"的误区,认为Agent的能力提升必然依赖更多的工具、更长的提示词、更复杂的规划链路以及更多的子Agent。然而,由Mario Zechner开发的Pi Agent Core(以下简称Pi)却走出了一条截然不同的道路,它以"极简主义"为核心哲学,用不到1500行代码、5个核心文件,在Terminal-Bench 2.0排行榜中与众多复杂架构的Agent同台竞技并跻身前列,重新定义了下一代Agent的设计逻辑。

Pi的核心哲学源自Mario Zechner的一句总结,An autonomous agent is just an LLM + tools + a loop. 这句话看似简单,却直击Agent的本质,也成为了Pi所有设计决策的出发点。作为一名在Agent开发领域有着深刻经验的开发者,Mario Zechner在长期实践中发现,当前很多Agent框架的复杂设计不仅没有提升效率,反而增加了系统的冗余度和维护成本,甚至影响了Agent的自主性和灵活性。于是,他摒弃了主流的加法思路,选择用减法重构Agent架构,打造出了这款极具颠覆性的Pi Agent Core。本文将从Pi的反直觉立场出发,逐层拆解其架构设计、核心模块机制,深入剖析其背后的设计哲学,帮助大家全面理解这款极简架构为何能成为下一代Agent的潜力标杆。

一、反直觉的极简主义 Pi打破Agent开发的固有误区

要理解Pi的设计逻辑,首先要跳出当前Agent开发的固有思维定式,读懂它的反直觉立场。在当前的Agent框架生态中,无论是Claude Code这样的巨头产品,还是各类开源项目,几乎都在沿着"做加法"的路径前进。大家普遍认为,Agent的能力越强,需要的工具就越多,系统提示词就越长,规划链路就越复杂,甚至需要引入多个子Agent协同工作,才能应对各类复杂场景。这种思路看似合理,却忽略了一个核心事实,那就是前沿的LLM模型经过RL训练后,已经具备了足够强的理解能力和执行能力,能够清晰地认知"编码Agent"的核心职责,根本不需要冗长的系统提示词和复杂的辅助模块来"教"它如何工作。

Mario Zechner对此有着明确的观点,他认为前沿模型已经被RL训练得足够理解"编码Agent"是什么,你不需要10000 token的系统提示词。这句话并非空谈,而是有着实打实的实践支撑。Pi在Terminal-Bench 2.0基准测试中,使用Claude Opus 4.5模型,成功跻身排行榜前列,与Codex、Cursor、Windsurf等拥有复杂工具链的Agent展开激烈竞争。而令人震惊的是,Pi的系统提示词加上工具定义的总长度还不到1000 token,不足Claude Code的十分之一,内置工具也只有4个,远远少于同类产品。

为了更清晰地展现Pi与主流Agent的差异,我们可以通过一组关键维度的对比来直观感受它的极简特性。

| 对比维度 | Claude Code | Codex | Pi |

|---|---|---|---|

| 系统提示词 | 约10000+ tokens | 适中 | < 1000 tokens |

| 内置工具数 | 数十个 | 适中 | 4个 (read/write/edit/bash) |

| Plan Mode | 有(黑盒子Agent) | 有 | 无(用文件代替) |

| MCP 支持 | 有 | 有 | 无(用CLI工具代替) |

| Sub-Agent | 有(不可观测) | --- | 无(通过bash自我调用) |

| 从这份对比中我们可以发现,Pi在所有主流Agent都在强化的模块上几乎都做了减法。没有冗长的系统提示词,没有数量众多的内置工具,没有复杂的Plan Mode和MCP支持,更没有不可观测的子Agent。但就是这样一款"极简"的架构,却能在核心性能上与主流产品比肩,这背后恰恰体现了Pi设计思路的先进性------放弃冗余的辅助模块,让LLM回归核心,用最简洁的结构实现最核心的功能。 |

很多人可能会疑惑,如此极简的设计,真的能应对复杂的编码场景吗?事实上,Pi的极简并不是"简陋",而是"精准"。它选择的4个内置工具read、write、edit、bash,几乎覆盖了编码Agent的所有核心需求,无论是读取文件、写入内容,还是编辑代码、执行命令,都能通过这4个工具高效完成。而bash工具的引入,更是巧妙地解决了子Agent的需求,通过bash自我调用,Pi可以实现复杂的任务拆分和执行,既保证了功能的完整性,又避免了引入子Agent带来的黑盒问题和观测困难。

与此同时,Pi放弃冗长的系统提示词,也并非降低了对LLM的引导要求,而是充分信任前沿LLM的能力。Mario Zechner认为,与其用大量的token去"教导"LLM如何成为一个Agent,不如用简洁的提示词明确其核心职责,让LLM充分发挥自身的理解和执行能力。这种思路不仅减少了上下文窗口的占用,提升了运行效率,还让Agent的行为更加灵活自主,能够更好地适应不同的场景需求。

二、架构分层解析 5个文件构建的高效运行时

Pi的极简主义不仅体现在设计理念上,更贯穿于整个架构实现之中。Pi Agent Core的全部源码只有5个文件,总代码量约1500行,却构建起了一个完整、高效、灵活的Agent运行时。这5个文件分别是types.ts、agent-loop.ts、agent.ts、proxy.ts和index.ts,每个文件对应一个核心模块,各司其职、相互配合,构成了Pi的完整架构。接下来,我们将逐层剖析每个核心模块的设计决策和实现细节,读懂这5个文件背后的精妙设计。

三、类型系统:少即是多 构建灵活可扩展的基础框架

types.ts作为Pi的类型定义文件,是整个架构的基础,它的设计核心是"少即是多",通过简洁而灵活的类型定义,为后续模块的实现提供了坚实的支撑。其中,最精妙的设计莫过于AgentMessage类型的抽象,它实现了应用状态与模型上下文的分离,这也是Pi能够实现"最晚转换"策略的关键。

在types.ts中,首先定义了一个空接口CustomAgentMessages,这个接口默认是空的,应用层可以通过Declaration Merging的方式对其进行扩展,添加自定义的消息类型。随后,AgentMessage类型被定义为Message类型与CustomAgentMessages所有子类型的联合类型,也就是说AgentMessage既可以是LLM能够直接理解的Message类型,也可以是应用层自定义的各类消息类型。

可能有很多开发者会疑惑,为什么不直接使用LLM的Message类型,反而要额外定义一个AgentMessage类型呢?这其实是Mario Zechner基于真实应用场景的精准考量。在实际的Agent应用中,存在大量"非LLM消息",这些消息并不需要交给LLM处理,如果直接使用Message类型,就无法对这些消息进行有效区分,要么会导致LLM处理无关消息,影响效率,要么会增加额外的过滤逻辑,增加系统复杂度。

我们可以通过一个具体的场景对比来理解这一设计的优势。在一个编码Agent应用中,用户提问属于UserMessage,Agent回复属于AssistantMessage,工具结果属于ToolResultMessage,这些都是需要交给LLM处理的消息。但与此同时,应用中还会存在UI通知、文件变更事件、会话分支标记等消息,这些消息属于应用层的状态通知,并不需要LLM进行处理,如果交给LLM,不仅会浪费上下文窗口,还可能导致LLM做出错误的判断。

AgentMessage类型的设计,恰好解决了这一问题。应用层通过扩展CustomAgentMessages,可以灵活添加各类自定义消息类型,内部所有逻辑,包括上下文压缩、会话分支管理、UI渲染等,都基于AgentMessage类型运转,只有在调用LLM的瞬间,才会通过convertToLlm方法将AgentMessage数组过滤转换为LLM能够理解的Message数组。这种"最晚转换"策略,不仅保证了应用层的灵活性,还最大限度地减少了LLM的无效处理,提升了系统的运行效率。

除了AgentMessage,types.ts中还定义了AgentLoopConfig接口,这个接口的设计同样体现了Pi的极简主义。AgentLoopConfig继承自SimpleStreamOptions,包含了模型实例、消息转换方法、上下文变换方法、引导消息获取方法、后续消息获取方法以及API Key获取方法等核心配置项。值得注意的是,这个接口中并没有包含maxSteps、maxTokens、temperature等常见的配置项,这些配置项虽然继承自SimpleStreamOptions,但循环本身并不关心这些细节,这种设计让循环逻辑更加纯粹,只专注于核心的任务流转,而将细节配置交给上层模块处理,实现了职责的清晰划分。

另外,types.ts中还定义了AgentEvent类型,通过三层嵌套的生命周期事件,实现了Agent运行过程的细粒度可观测。AgentEvent包含了agent_start、agent_end、turn_start、turn_end、message_start、message_update、message_end以及工具执行相关的各类事件,覆盖了Agent从启动到结束的整个生命周期。这种细粒度的事件设计,让开发者能够清晰地观测到Agent的每一步操作,包括LLM调用、工具执行、消息更新等,彻底解决了主流Agent中存在的黑盒问题,为调试和优化提供了极大的便利。

四、核心循环:双层While设计 实现高效灵活的任务流转

agent-loop.ts是Pi的核心模块,负责实现Agent的核心循环逻辑,也就是Mario Zechner所说的"LLM + tools + a loop"中的loop部分。这个模块的核心设计是双层While循环,外层由FollowUp消息驱动,内层由ToolCall和Steering消息驱动,通过这种精密的循环设计,实现了Agent任务的高效流转和灵活干预,同时保证了系统的简洁性和可维护性。

在深入解析双层循环之前,我们首先要明确Pi的核心循环理念:循环的目的是实现任务的自主执行和灵活调整,不需要复杂的规划模块,只需要通过消息驱动和工具执行,就能完成各类复杂任务。基于这一理念,Pi的核心循环没有设计复杂的规划链路,而是通过简单的循环逻辑,结合消息队列和工具执行,实现了任务的自主推进。

4.1 入口设计:区分场景 实现优雅的重试与恢复

agent-loop.ts中提供了两个核心入口函数,分别是agentLoop和agentLoopContinue,这两个函数的设计体现了Pi对不同场景的精准适配,尤其是实现了优雅的重试与恢复功能。其中,agentLoop函数主要用于用户发送新消息的场景,可以从空上下文开始,启动一轮新的对话和任务执行;而agentLoopContinue函数则主要用于重试或恢复场景,不需要重新构造prompt,直接从当前上下文继续执行任务。

这种入口的区分,看似简单,却解决了Agent开发中的一个常见痛点。在很多主流Agent框架中,当任务执行出错或需要重试时,开发者需要重新构造prompt和上下文,操作繁琐且容易出错。而Pi通过agentLoopContinue函数,让重试变得异常优雅,出错后不需要重新构造任何内容,直接调用该函数,就能从当前上下文继续执行,极大地提升了开发效率和用户体验。

4.2 双层循环:FollowUp与ToolCall双驱动 实现灵活流转

核心循环的核心是双层While结构,这也是Pi能够实现自主任务执行和灵活干预的关键。外层循环由FollowUp消息驱动,主要负责任务的后续推进;内层循环由ToolCall和Steering消息驱动,主要负责工具执行和中途干预,两层循环相互配合,构成了完整的任务流转逻辑。

外层循环的逻辑非常简洁,它是一个无限循环,当内层循环处理完当前的工具调用和消息后,Agent即将停止时,会检查是否有FollowUp消息。如果存在FollowUp消息,就将这些消息设为待处理消息,重启内层循环,继续执行后续任务;如果没有FollowUp消息,就跳出循环,任务正式结束。这种设计的优势在于,能够实现任务的连续推进,用户可以在Agent完成当前任务后,添加后续任务,Agent会自动继续执行,不需要重新启动循环。

内层循环则是任务执行的核心,它同样是一个无限循环,只要存在未处理的工具调用或待处理消息,就会持续执行。内层循环的主要流程包括注入待处理消息、流式调用LLM、执行工具、检查Steering消息等步骤。在这个循环中,Agent会不断地调用LLM生成工具调用指令,执行工具获取结果,再将结果反馈给LLM,生成下一步操作,直到所有工具调用完成,没有待处理消息为止。

值得注意的是,内层循环中加入了Steering中断的实现,这也是Pi实现用户中途干预的关键。当用户在工具执行期间发送Steering消息时,工具执行会立即停止,后续未执行的工具会被标记为"因排队的用户消息而跳过"并返回错误结果,然后跳出内层循环,将Steering消息注入上下文,下一轮LLM调用时,会看到已执行工具的正常结果、被跳过工具的错误结果以及用户的Steering消息,从而理解发生了什么,并做出适当的调整。

这种Steering中断机制,解决了主流Agent中用户无法中途干预的痛点。在很多复杂场景中,用户可能会发现Agent的执行方向出现偏差,此时需要能够及时中断并修正,但大多数主流Agent要么不支持中途干预,要么干预后无法正确处理后续逻辑。而Pi的Steering中断机制,不仅能够实现即时中断,还能通过错误结果标记,让LLM清晰地了解干预情况,做出正确的调整,保证任务能够按照用户的预期推进。

4.3 流式应答:最晚转换 保证上下文实时更新

agent-loop.ts中还实现了streamAssistantResponse函数,这个函数是AgentMessage与Message转换的唯一边界,负责实现流式应答处理,同时保证上下文的实时更新。流式应答是提升用户体验的关键,尤其是在处理复杂任务时,用户能够实时看到Agent的响应过程,而不需要等待整个任务完成。

streamAssistantResponse函数的执行流程可以分为五个步骤。第一步是可选的上下文变换,通过config.transformContext方法,可以对上下文消息进行剪枝、注入外部上下文等操作,从而优化上下文质量,减少无效信息的占用。第二步是消息转换,通过config.convertToLlm方法,将AgentMessage数组转换为LLM能够理解的Message数组,这也是"最晚转换"策略的核心实现点,只有在调用LLM的瞬间才进行转换,最大限度地保证了应用层的灵活性。

第三步是动态解析API Key,支持过期OAuth Token的动态更新,通过config.getApiKey方法,能够根据模型提供商的不同,动态获取对应的API Key,避免了API Key硬编码带来的安全隐患和维护问题。第四步是流式调用LLM,通过streamFunction方法,调用模型的流式接口,获取实时的响应事件。第五步是实时转发事件,将LLM返回的每个delta事件实时转发给UI,同时将部分消息就地更新到上下文消息数组中,确保上下文始终是当前最新状态。

这里有一个非常关键的细节,部分消息会被就地更新到context.messages数组中,也就是说,上下文消息数组会随着LLM的流式响应实时更新,而不是等到整个响应完成后再更新。这种设计的优势在于,无论任务执行到哪一步,上下文都能反映当前的最新状态,当出现重试、干预等场景时,LLM能够基于最新的上下文做出判断,避免了因上下文滞后导致的错误。

五、Agent类:状态容器+消息队列 实现灵活的任务管理

agent.ts模块实现了Agent类,这个类的核心作用是作为状态容器和消息队列,负责管理Agent的运行状态、处理消息队列、实现错误恢复等功能。Agent类的设计同样遵循极简主义理念,没有复杂的逻辑,却能实现灵活高效的任务管理,为上层应用提供了简洁易用的接口。

5.1 队列模式:两种模式适配不同场景需求

Agent类引入了两种队列模式,分别是Steering模式和FollowUp模式,每种模式都支持"all"和"one-at-a-time"两种类型。其中,Steering模式用于处理用户中途发送的干预消息,FollowUp模式用于处理用户添加的后续任务消息,两种模式相互独立,确保了消息处理的有序性和灵活性。

"all"模式表示一次性发送所有队列中的消息,适用于消息数量较少、不需要逐一条理的场景;"one-at-a-time"模式表示每次只发送一条消息,处理完成后再发送下一条,适用于消息数量较多、需要逐条处理的场景。为什么需要"one-at-a-time"模式呢?我们可以通过一个具体的场景来理解。假设用户在Agent工作时快速发送了3条修正消息,如果使用"all"模式,Agent会一次性收到这3条消息,很可能只会回应最后一条,导致前两条修正消息被忽略;而使用"one-at-a-time"模式,Agent会逐条处理这3条消息,每条消息都能得到充分的响应,确保用户的所有需求都能被满足。

这种队列模式的设计,充分考虑了真实应用中的场景需求,让Agent能够根据不同的消息类型和数量,灵活选择合适的处理方式,既保证了处理效率,又避免了消息遗漏或处理不充分的问题。

5.2 核心方法:清晰划分职责 实现灵活调用

Agent类提供了一系列核心方法,包括prompt、continue、steer、followUp、abort等,每个方法都有明确的调用时机和功能,职责划分清晰,方便上层应用灵活调用。

prompt方法用于Agent空闲时,用户发送新消息的场景,调用该方法会启动一轮新的对话和任务执行,将用户消息添加到待处理队列中,触发核心循环。continue方法用于Agent空闲时,需要重试或恢复任务的场景,调用该方法会从当前上下文继续执行任务,不需要重新构造prompt和上下文。steer方法用于Agent工作时,用户需要中途干预的场景,调用该方法会中断当前的工具链,将干预消息添加到Steering队列中,触发内层循环的重新执行。

followUp方法用于任何时候,用户需要添加后续任务的场景,调用该方法会将后续任务消息添加到FollowUp队列中,当当前任务完成后,Agent会自动执行后续任务。abort方法用于Agent工作时,需要取消当前任务的场景,调用该方法会取消当前的LLM调用,终止任务执行,并标记任务状态为"aborted"。

这些方法的设计,让上层应用能够根据不同的场景需求,灵活调用对应的方法,实现对Agent的精准控制。同时,方法的命名简洁易懂,降低了上层应用的开发难度,提升了开发效率。

5.3 错误恢复:优雅处理异常 保证系统稳定性

错误恢复是Agent开发中的一个重要环节,尤其是在复杂的任务场景中,很容易出现LLM调用失败、工具执行错误等问题,如果不能妥善处理这些错误,很可能导致系统崩溃或任务无法继续执行。Pi的Agent类在错误处理方面做了非常细致的设计,能够优雅地处理各类异常,保证系统的稳定性。

在Agent类的核心逻辑中,所有可能出现错误的地方都添加了try-catch捕获机制,当出现错误时,会在catch块中构造一个完整的AssistantMessage,该消息包含了错误状态、错误信息等内容,其中stopReason被标记为"error",如果是用户主动取消,则标记为"aborted"。然后,将这个错误消息添加到上下文消息数组中,确保错误状态能够成为上下文历史的一部分。

这种设计的优势在于,当任务执行出现错误时,用户可以通过调用continue方法,从错误处重试,LLM会看到之前的错误信息,并据此调整策略,避免再次出现相同的错误。同时,错误消息被添加到上下文后,也方便开发者调试和分析错误原因,提升系统的可维护性。

六、Proxy Stream:带宽优化 适配Web应用场景

proxy.ts模块是Pi为Web应用场景设计的核心模块,主要用于解决Web应用中LLM调用的带宽优化问题。在Web应用场景中,Agent的运行流程通常是浏览器发送请求到代理服务器,代理服务器调用LLM接口,再将响应结果返回给浏览器。如果直接传输完整的响应消息,尤其是流式响应中的部分消息,会占用大量的带宽,影响响应速度,尤其是在网络环境较差的情况下,这种影响会更加明显。

为了解决这一问题,Pi的Proxy Stream模块引入了一种带宽优化策略,服务器不传输完整的部分消息对象,仅传输轻量的delta事件。具体来说,ProxyAssistantMessageEvent比原始的AssistantMessageEvent轻得多,它去掉了完整的部分字段,仅包含contentIndex、delta等最小必要信息。客户端通过processProxyEvent方法,根据这些delta事件,逐步重建完整的响应消息,从而减少了带宽占用,提升了响应速度。

这种设计的核心思路是"按需传输",只传输客户端重建完整消息所必需的最小信息,避免传输冗余数据。通过这种方式,不仅能够节省带宽,还能提升响应速度,改善用户体验,让Pi能够更好地适配Web应用场景的需求。同时,Proxy Stream模块的设计也保持了极简主义,没有引入复杂的压缩算法,仅通过数据裁剪的方式实现带宽优化,兼顾了效率和简洁性。

七、设计哲学总结 极简背后的深层思考

深入剖析Pi的架构设计和核心模块后,我们不难发现,Pi的成功不仅仅是技术层面的创新,更核心的是其背后的设计哲学。Mario Zechner用"减法思维"重构了Agent架构,他认为"不做什么"比"做什么"更重要,这种理念贯穿于Pi的每一个设计决策之中,也正是这种理念,让Pi在众多复杂架构的Agent中脱颖而出。

7.1 "不做什么"比"做什么"更重要

Pi的设计哲学中,最核心的一点就是刻意放弃了很多主流Agent都在强化的功能,每一个"不做"的决策,背后都有深刻的思考和实践支撑,都是为了回归Agent的本质,提升系统的简洁性和效率。

Pi刻意不做Plan Mode,而是用文件PLAN.md替代。主流Agent的Plan Mode通常是一个黑盒子,开发者无法观测其内部的规划过程,且难以进行版本控制和跨会话共享。而Pi用PLAN.md文件来记录规划过程,不仅具有完整的可观测性,还能进行版本控制,方便跨会话共享和复用,同时也减少了复杂规划模块带来的冗余。

Pi刻意不做MCP支持,而是用CLI工具替代。MCP工具描述通常会占用7-9%的上下文窗口,大量占用宝贵的上下文资源,影响LLM的响应效率。而Pi通过CLI工具结合bash调用,能够按需加载工具描述,避免了上下文窗口的浪费,同时也简化了系统逻辑。

Pi刻意不做Sub-Agent,因为子Agent会形成"黑盒中的黑盒",让开发者失去对Agent运行过程的可观测性,难以调试和优化。而Pi通过bash自我调用,实现了子Agent的核心功能,同时保留了完整的输出可见性,让开发者能够清晰地观测到每一步操作。

Pi刻意不做maxSteps限制,Mario Zechner认为,循环应该自然结束,他在长期实践中从来没有找到需要maxSteps的用例,因此没有必要添加这一限制,让Agent能够根据任务的实际情况,自主决定执行步骤,提升了系统的灵活性。

Pi刻意不做权限检查,Mario Zechner认为,安全措施大多是安全剧场,一旦Agent能够写代码和运行代码,安全沙箱就失去了意义。因此,Pi选择了"YOLO by default"的策略,放弃了复杂的权限检查,专注于核心功能的实现,提升了系统的效率和灵活性。

7.2 核心设计原则 极简背后的底层逻辑

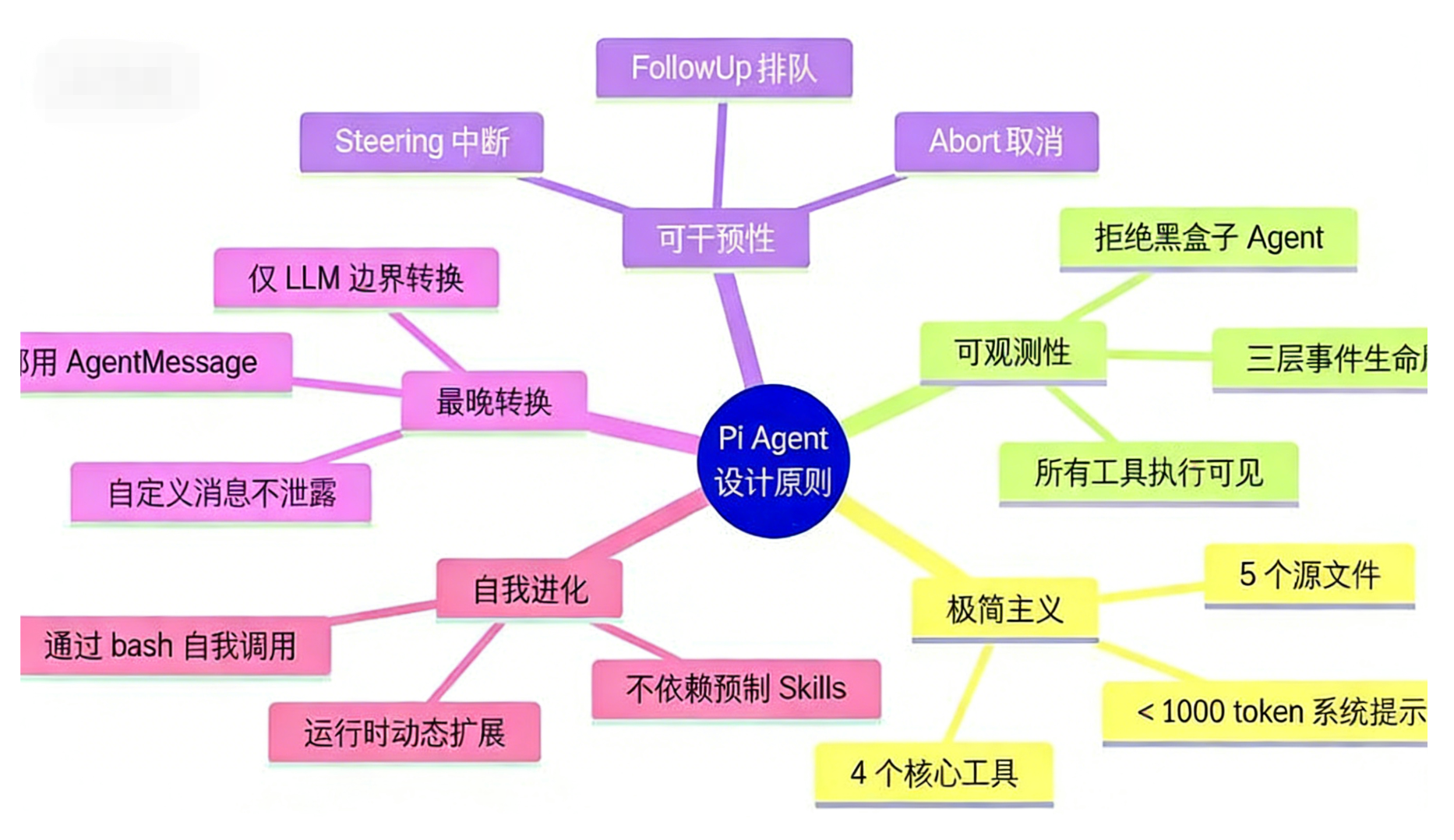

Pi的所有设计决策,都围绕着三个核心原则:极简主义、可观测性、可干预性,这三个原则相互支撑,构成了Pi设计哲学的底层逻辑,也正是这三个原则,让Pi能够实现高效、灵活、可维护的特性。

极简主义是Pi的核心原则,体现在系统的各个方面。不到1000token的系统提示词,4个核心工具,5个源文件,没有复杂的规划模块和子Agent,用最简洁的结构实现最核心的功能。这种极简主义不仅降低了系统的冗余度和维护成本,还提升了系统的运行效率和灵活性,让Agent能够更好地适应不同的场景需求。

可观测性是Pi的重要原则,Mario Zechner认为,Agent的运行过程必须是可观测的,否则就无法调试和优化,也无法保证系统的稳定性。因此,Pi设计了三层事件生命周期系统,覆盖了Agent从启动到结束的整个运行过程,每一步操作都能被清晰地观测到。同时,Pi用文件替代Plan Mode,用bash自我调用替代Sub-Agent,也都是为了保证可观测性,避免黑盒问题。

可干预性是Pi的另一重要原则,Mario Zechner认为,Agent应该能够接受用户的中途干预,根据用户的需求调整执行策略,这样才能更好地满足用户的实际需求。因此,Pi设计了Steering/FollowUp双队列机制,支持用户中途发送干预消息和后续任务消息,同时实现了Steering中断机制,让用户能够即时中断Agent的执行,做出修正。

除此之外,Pi还遵循"最晚转换"和"自我进化"的原则。"最晚转换"策略实现了应用状态与模型上下文的分离,提升了系统的灵活性和效率;"自我进化"则通过bash自我调用和动态扩展,让Pi能够适应不同的场景需求,不需要依赖预制的Skills,实现了自主进化。

7.3 写给开发者 何时借鉴Pi的设计思路

Pi的设计思路虽然先进,但并不是适用于所有场景,它的极简主义理念更适合特定的Agent开发需求。因此,对于开发者来说,需要根据自身的项目场景,理性借鉴Pi的设计思路,避免盲目跟风。

如果你的Agent需要高可观测性,想要避免黑盒问题,方便调试和优化,那么可以学习Pi的三层事件系统,通过细粒度的事件设计,实现Agent运行过程的全程观测。如果你的项目是构建编码/CLI Agent,那么可以学习Pi"4工具+bash"的极简策略,用最简洁的工具组合覆盖核心需求,提升系统效率。

如果你的Agent需要跨Provider会话迁移,想要实现不同LLM模型之间的灵活切换,那么可以学习Pi的convertToLlm最晚转换模式,通过AgentMessage与Message的分离,实现上下文的跨Provider迁移。如果你的Agent需要支持用户中途干预,想要提升用户体验,那么可以学习Pi的Steering/FollowUp双队列机制,实现用户的即时干预和后续任务添加。

相反,如果你的Agent需要复杂的多Agent编排,需要多个子Agent协同工作,处理极其复杂的任务,那么Pi的设计理念与此相悖,不建议借鉴。如果你的Agent需要严格的安全沙箱,对权限控制有极高的要求,那么Pi"YOLO by default"的策略也不适合你的项目,需要谨慎选择。

八、总结 极简主义引领Agent的下一代发展方向

Pi Agent Core的出现,为当前Agent领域的发展提供了一种全新的思路,它以"极简主义"为核心哲学,打破了主流Agent"做加法"的固有误区,用不到1500行代码、5个核心文件,实现了与复杂架构Agent比肩的性能,充分证明了"An autonomous agent is just an LLM + tools + a loop"这句话的正确性。

从Pi的反直觉立场,到其架构分层设计,再到各个核心模块的精密实现,我们看到的不仅仅是一款简洁高效的Agent架构,更是一种回归本质的设计思维。在当前技术快速迭代的时代,很多开发者都陷入了"为复杂而复杂"的误区,认为复杂的设计就是先进的体现,却忽略了技术的本质是解决问题。Pi的成功告诉我们,真正先进的设计,往往是简洁而高效的,它能够精准抓住问题的核心,用最简单的方式实现最核心的功能。

对于下一代Agent的发展方向,Pi给出了一个明确的答案:极简主义、可观测性、可干预性。未来,随着LLM模型能力的不断提升,Agent的架构将会越来越简洁,复杂的辅助模块将会被逐步淘汰,Agent将回归"LLM + tools + a loop"的本质,实现更高的自主性、灵活性和效率。而Pi Agent Core作为这一方向的先行者,其设计逻辑和哲学思想,将会为更多的Agent开发者提供借鉴,推动整个Agent领域的健康发展。

当然,Pi也并非完美无缺,它的"YOLO by default"策略在安全方面存在一定的隐患,不适合对安全有严格要求的场景;同时,它的极简设计也导致其在复杂多Agent编排场景中存在局限性。但这并不影响Pi成为下一代Agent架构的潜力标杆,它的设计思路和实践经验,将会为Agent领域的创新发展注入新的动力。