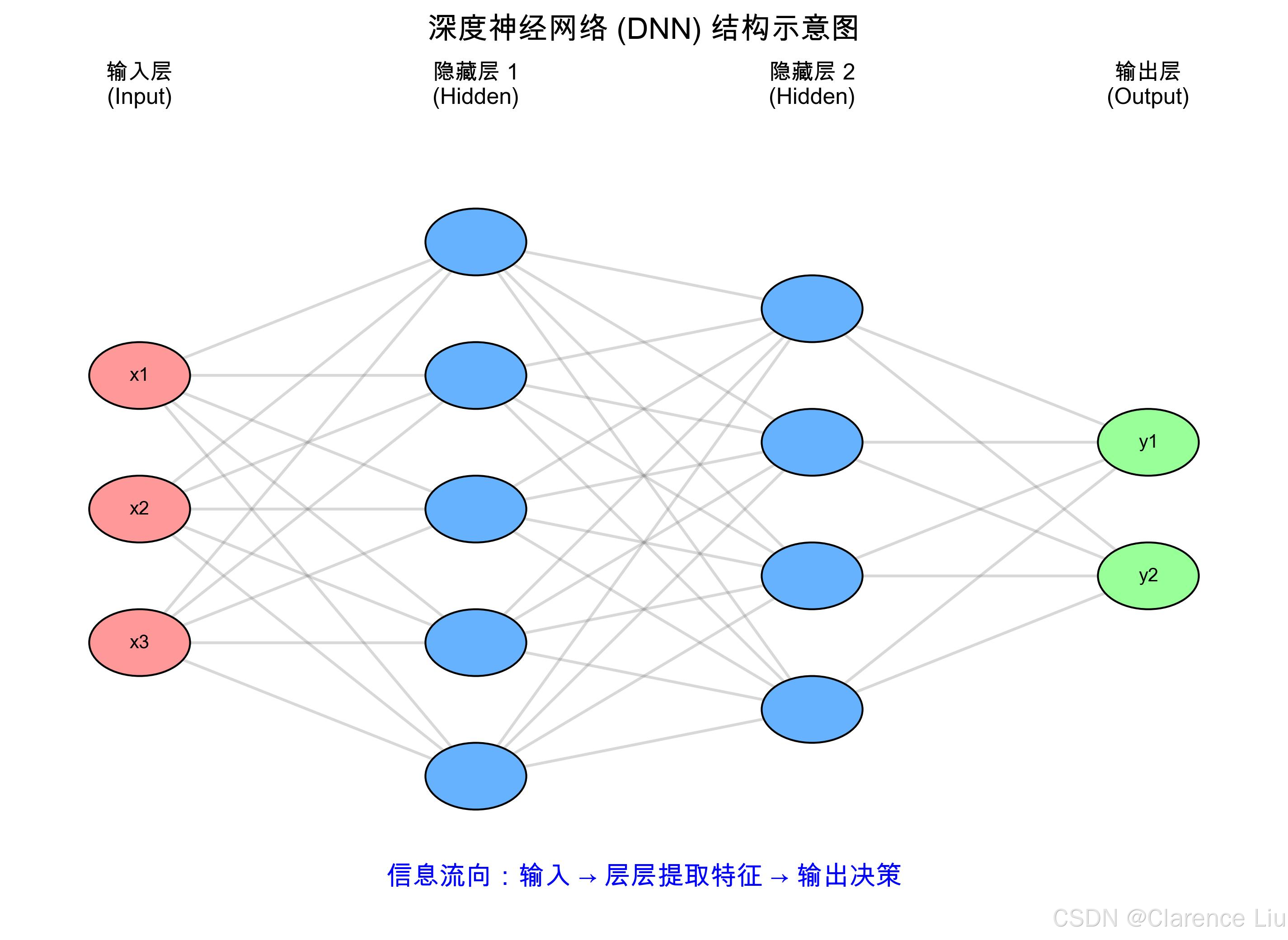

深度学习:堆"多层神经网络"会发生什么?

从"剥洋葱"看深度学习的本质

如果你见过洋葱,就知道它一层包着一层。深度学习(Deep Learning)就像这颗洋葱------把"神经网络"一层叠一层,从表面到核心,层层深入地提取信息。

- 浅层神经网络:像剥洋葱的第一层,只能看到最表面的特征(比如图片的边缘、颜色)。

- 深层神经网络:像剥到洋葱核心,能看到本质特征(比如图片里是猫还是狗,文字是"开心"还是"愤怒")。

这就是为什么深度学习能处理图像、语音、语言这些复杂数据------它不是"一眼看穿",而是通过多层网络逐步把复杂问题拆解成简单问题。

为什么"多层"比"单层"更厉害?

单层神经网络的局限

假设你要教AI识别一只猫:

- 单层神经网络(如Softmax回归)只能做"线性判断",就像用直尺画一条线把猫和非猫分开。

- 但猫的特征太复杂了:有的胖、有的瘦,有的黑猫、有的白猫,有的正面、有的侧面------用一条直线根本分不完!

多层网络:让AI学会"组合特征"

多层神经网络就像团队分工:

- 第一层:专门识别边缘和颜色(比如猫的胡须边缘、毛色)。

- 第二层:把第一层的特征组合起来,识别眼睛、耳朵等局部器官。

- 第三层:把眼睛、耳朵组合起来,识别"猫脸"这个整体。

就像工厂流水线:

- 工人A(第一层)分拣零件(边缘/颜色);

- 工人B(第二层)组装部件(眼睛/耳朵);

- 工人C(第三层)总装成产品(猫脸)。

层数越多,能识别的特征越复杂------这就是"深度"的意义。

深度神经网络的"三大家族"

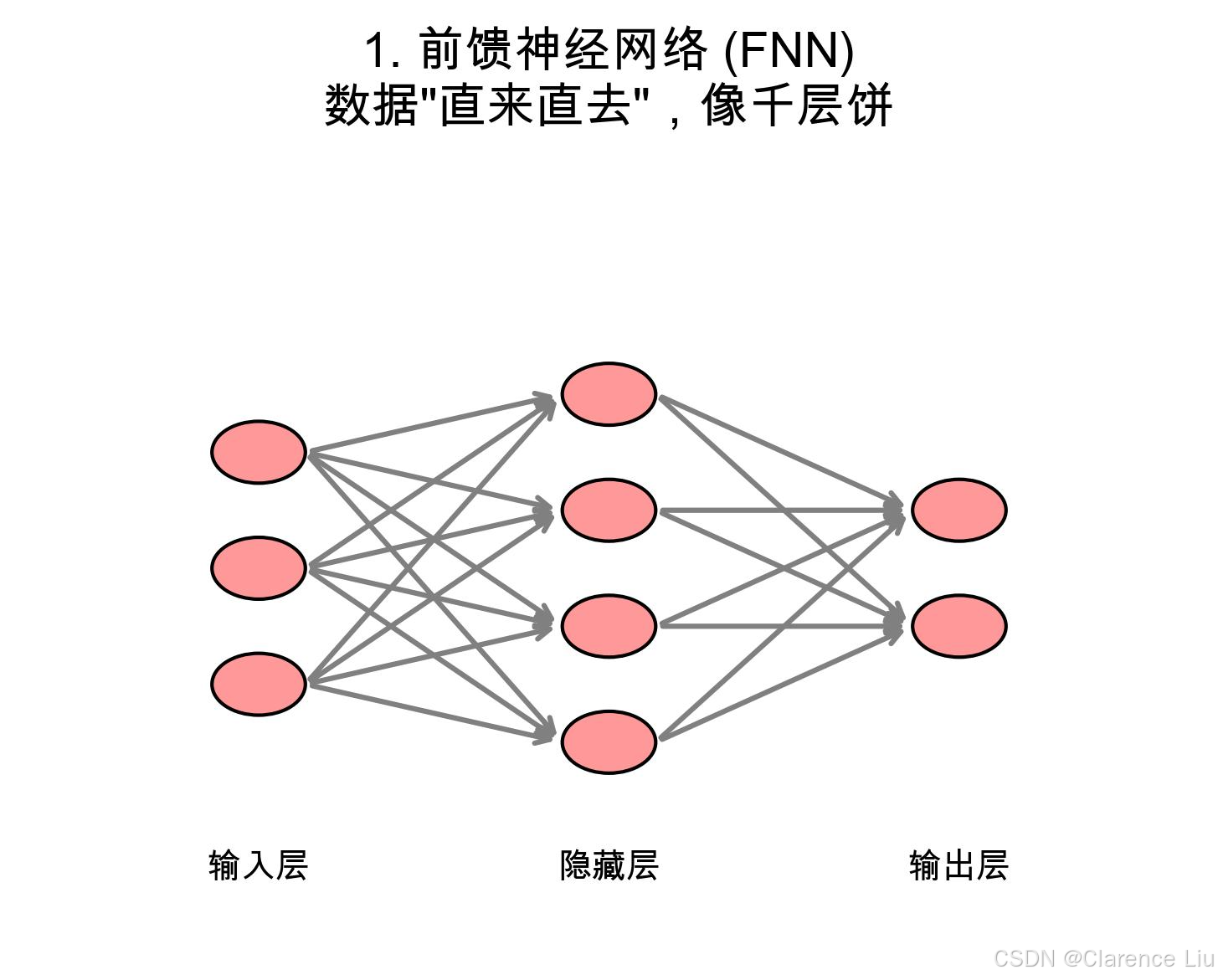

1. 前馈神经网络(Feedforward Neural Network):最基础的"千层饼"

结构像千层饼,数据从输入层"喂"进去,一层一层向前传,直到输出层。

- 应用:简单的分类问题(如判断邮件是否垃圾)、回归问题(如预测房价)。

- 特点:没有"回头路",数据只往前走。

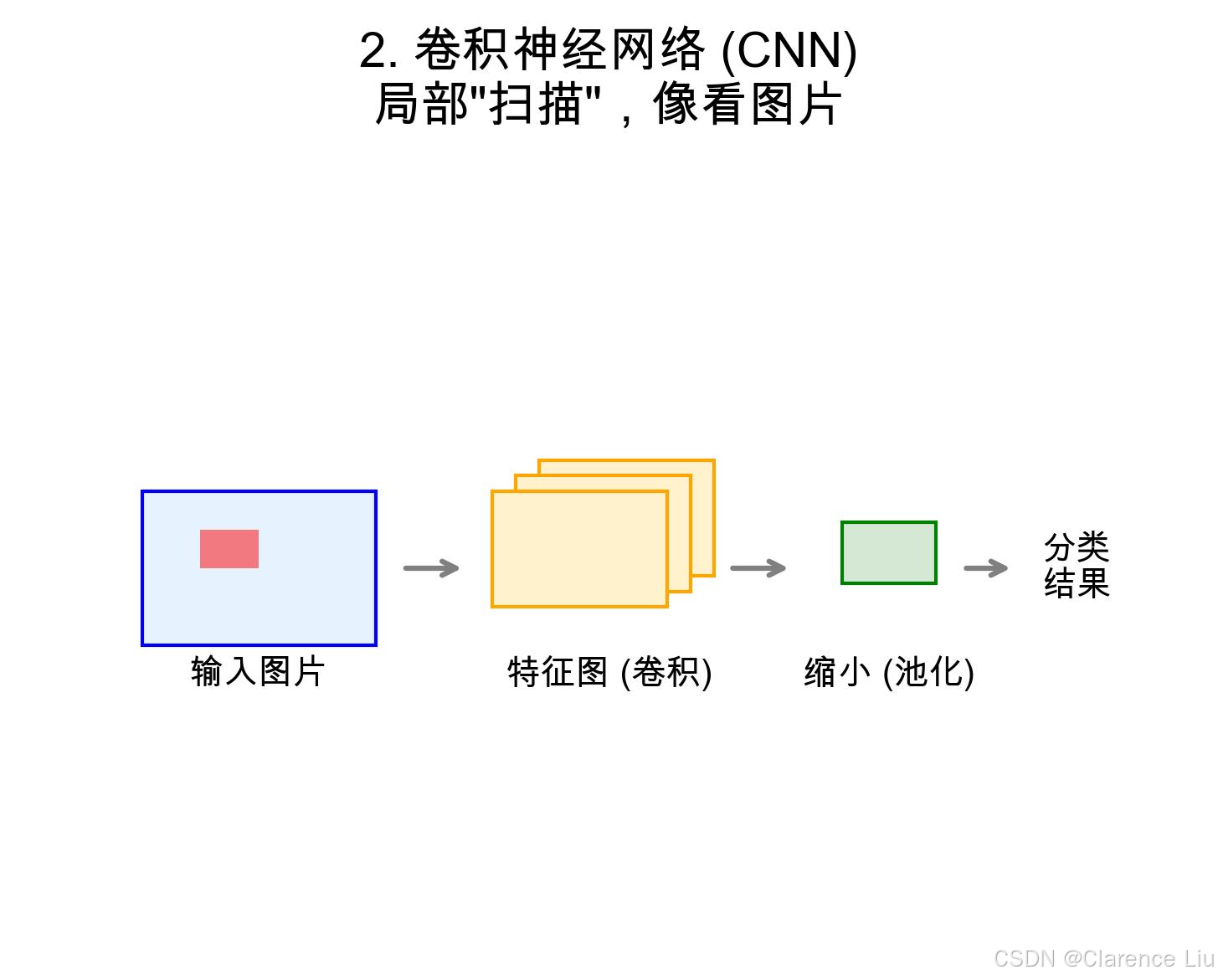

2. 卷积神经网络(CNN):专门"看图片"的专家

专为处理图像设计,有两个"独门武器":

- 卷积层:像戴眼镜看世界,每次只关注局部(比如先看猫的眼睛,再看鼻子)。

- 池化层:像把图片缩小,保留关键信息(比如猫的眼睛位置比具体像素更重要)。

- 应用 :人脸识别、自动驾驶(识别红绿灯)、医学影像(找肿瘤)。

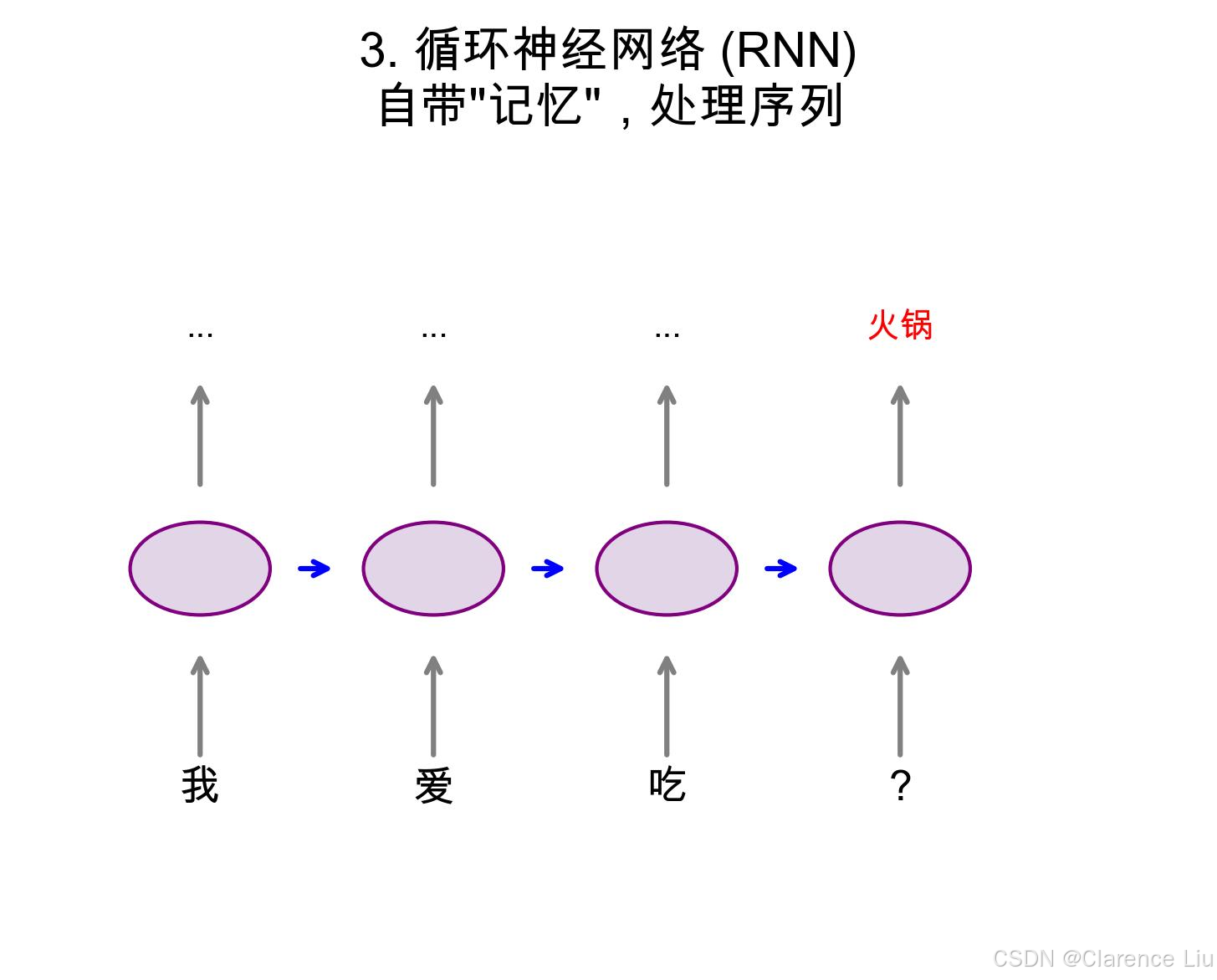

3. 循环神经网络(RNN):能"记东西"的网络

处理文字、语音等"序列数据"时,RNN会像记笔记一样记住前序内容:

- 当你说"我爱吃..."时,RNN会根据"爱"和"吃"预测下一个词可能是"火锅"或"米饭"。

- 变种:LSTM(长短期记忆网络)解决了RNN"健忘"的问题,能记住更长的上下文(比如理解一句话的意思)。

- 应用 :语音转文字、机器翻译、聊天机器人。

深度学习的"学习秘籍":反向传播(Backpropagation)

就像"从错题中学习"

假设你考试做错了一道题,正确做法是:

- 看哪里错了(计算误差);

- 分析错因(哪些知识点没掌握);

- 针对性复习(调整学习方法)。

反向传播就是AI的"错题本学习法":

- 前向传播:AI用当前参数做预测,算出误差(比如把猫认错成狗)。

- 反向传播:从输出层往回算,找出"哪些参数导致了错误"(比如某个神经元的权重设错了)。

- 梯度下降:调整参数,让下次预测更准(就像你调整学习方法)。

这个过程重复几万次,AI就从"啥都不懂"变成"专家"。

生活中的深度学习:不止"识别图片"

案例1:手机拍照的"魔法"

- 场景:你拍了一张逆光照片,手机自动把暗部调亮,人脸变清晰。

- 背后:CNN识别出"人脸"和"背景",对不同区域用不同参数调整------这比传统的"整体调亮"聪明多了。

案例2:语音助手听懂你的"弦外之音"

- 场景:你说"今天好热啊",小爱同学自动推荐"要不要开空调?"

- 背后:RNN结合上下文理解"热"不是简单的温度描述,而是需要降温------这就是"语义理解"。

案例3:AlphaGo打败围棋世界冠军

- 场景:AlphaGo下出人类从未想到的"神之一手"。

- 背后:深层神经网络能预测"每一步棋的胜率",比人类算得更深、更远------它不是记住棋谱,而是"理解"棋理。

深度学习的"三宗罪":不是万能药

罪1:"黑箱"难解释

深度学习像个"魔法盒"------你知道它输入什么、输出什么,但不知道中间是怎么算的。

- 医生不敢完全相信AI的诊断,因为它说不出"为什么这个斑点是肿瘤"。

罪2:需要"喂"大量数据

训练一个深度学习模型,可能需要百万甚至亿级别的数据。

- 对比:人类小孩看3张猫的图片就知道什么是猫,AI可能需要10万张。

罪3:计算成本高

训练一个大模型(如GPT-3)需要上千块GPU跑几周,电费就几十万。

- 普通公司玩不起,只有大科技公司才能玩。

深度学习 vs 传统机器学习:就像"自动挡"vs"手动挡"

| 传统机器学习 | 深度学习 |

|---|---|

| 需要人来设计特征(比如手动提取"猫的胡须特征") | 自动学习特征(从像素直接学到"猫脸") |

| 适合小数据、简单问题 | 适合大数据、复杂问题(图像、语音、语言) |

| 结果可解释(比如"因为这个像素是黑色,所以是猫") | 结果难解释("我也不知道为什么,反正像猫") |

简单说:传统机器学习是"手动挡"(需要人操作),深度学习是"自动挡"(自动化程度高)。

小问题:为什么深度学习在2012年后才火起来?

(提示:三个关键因素:1. 大数据时代到来(有足够数据喂模型);2. GPU算力提升(能跑得起深层网络);3. 算法优化(如ReLU激活函数解决了梯度消失问题)。)

下一篇预告:《卷积神经网络(CNN):AI怎么"看懂"图片?》------用"拼图游戏"的例子,讲透CNN如何一层一层"拆解"图像特征。