本篇技术博文摘要 🌟

- 文章开篇阐明为何需要

tf.dataAPI 来替代传统的feed_dict方式,以提升训练效率与资源利用率。- 核心部分首先详述了Dataset 对象的三种创建方式 :从内存数据、文件(支持

TFRecord、文本、CSV 等格式)及生成器创建,并辅以代码示例。继而,文章深入剖析了关键的链式数据转换操作 ,包括map(元素级处理)、batch(批次化)与shuffle(打乱)的原理、参数详解与最佳实践。- 为确保管道性能,文章重点分享了高级优化技巧 ,如

prefetch(预取)实现计算与I/O重叠、num_parallel_calls参数实现map操作的并行化,以及cache(缓存)机制。- 最后,通过汇总一个完整的图像分类数据管道代码 ,将前述知识串联为可复用的实践模板,并针对大数据集处理 与管道性能瓶颈排查 提供了具体解决方案与步骤,最终提炼出系列最佳实践,旨在帮助读者构建从数据加载、处理到加速的端到端能力

引言 📘

- 在这个变幻莫测、快速发展的技术时代,与时俱进是每个IT工程师的必修课。

- 我是盛透侧视攻城狮,一个"什么都会一丢丢"的网络安全工程师,目前正全力转向AI大模型安全开发新战场。作为活跃于各大技术社区的探索者与布道者,期待与大家交流碰撞,一起应对智能时代的安全挑战和机遇潮流。

上节回顾

目录

[本篇技术博文摘要 🌟](#本篇技术博文摘要 🌟)

[引言 📘](#引言 📘)

[1.TensorFlow tf.data API](#1.TensorFlow tf.data API)

[1.1为什么需要 tf.data API](#1.1为什么需要 tf.data API)

[2.TensorFlow tf.data API](#2.TensorFlow tf.data API)

[2.1Dataset 对象](#2.1Dataset 对象)

[3.1map 操作详解及示例](#3.1map 操作详解及示例)

[3.2 batch 操作及示例](#3.2 batch 操作及示例)

[3.3shuffle 操作及示例](#3.3shuffle 操作及示例)

[4.1预取 (Prefetch)及示例](#4.1预取 (Prefetch)及示例)

1.TensorFlow tf.data API

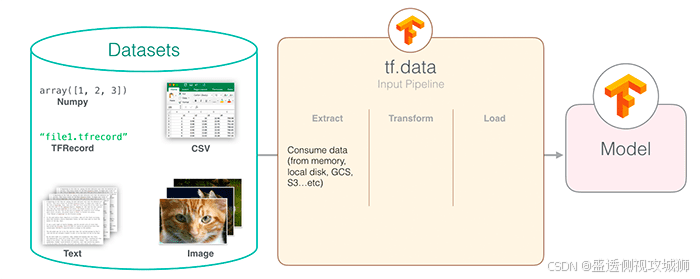

TensorFlow tf.data API 是 TensorFlow 提供的高效数据输入管道构建工具,专门用于处理大规模数据集。

tf.data API 解决了传统数据加载方式中的性能瓶颈问题,使数据预处理和模型训练能够并行进行。

1.1为什么需要 tf.data API

- 性能优势:比传统方法快 10-100 倍

- 内存效率:支持流式处理超大数据集

- 灵活性:可组合的数据转换操作

- 易用性:简洁的链式调用接口

2.TensorFlow tf.data API

2.1Dataset 对象

- Dataset 是 tf.data API 的核心抽象,表示一系列元素,其中每个元素包含一个或多个张量。

2.1.1从内存数据创建及示例

python

dataset = tf.data.Dataset.from_tensor_slices([1, 2, 3, 4, 5])2.1.2从文件创建及示例

python

dataset = tf.data.TextLineDataset(["file1.txt", "file2.txt"])2.1.3从生成器创建及示例

python

def gen():

for i in range(10):

yield i

dataset = tf.data.Dataset.from_generator(gen, output_types=tf.int32)

3.关键数据转换操作

| 操作类型 | 常用方法 | 说明 |

|---|---|---|

| 单元素转换 | map, filter |

对每个元素单独处理 |

| 多元素转换 | batch, window |

涉及多个元素的操作 |

| 全局转换 | shuffle, repeat |

影响整个数据集的行为 |

3.1map 操作详解及示例

map是最常用的转换操作,用于对每个元素应用自定义函数

python

# 对每个数字进行平方

dataset = dataset.map(lambda x: x**2)

# 处理图像数据的典型用法

def process_image(image_path):

img = tf.io.read_file(image_path)

img = tf.image.decode_jpeg(img, channels=3)

img = tf.image.resize(img, [256, 256])

return img

image_dataset = image_dataset.map(process_image)3.1.1如何最佳实践

- 使用

num_parallel_calls参数启用并行处理- 对于 CPU 密集型操作,设置

tf.data.experimental.AUTOTUNE

3.2 batch 操作及示例

- 将多个元素组合成一个批次..

python

# 创建32大小的批次

batched_dataset = dataset.batch(32)

# 不等长序列的填充批次

padded_batch = dataset.padded_batch(

32,

padded_shapes=([None], []),

padding_values=(0.0, 0)

)

3.3shuffle 操作及示例

- 起到打乱数据顺序作用,对训练至关重要

python

# 基本用法

shuffled = dataset.shuffle(buffer_size=10000)

# 最佳实践:buffer_size应 >= 数据集大小

full_shuffle = dataset.shuffle(buffer_size=len(dataset))

4.性能优化技巧

4.1预取 (Prefetch)及示例

- 让数据加载和模型执行重叠进行

python

dataset = dataset.prefetch(buffer_size=tf.data.experimental.AUTOTUNE)4.2并行化处理及示例

python

dataset = dataset.map(

process_func,

num_parallel_calls=tf.data.experimental.AUTOTUNE

)4.3缓存机制及示例

python

# 内存缓存

dataset = dataset.cache()

# 文件缓存

dataset = dataset.cache(filename='/tmp/cache')

5.图像分类数据管道代码汇总

python

def build_image_pipeline(file_pattern, batch_size=32, is_training=True):

dataset = tf.data.Dataset.list_files(file_pattern)

if is_training:

dataset = dataset.shuffle(10000)

dataset = dataset.map(

lambda x: load_and_preprocess_image(x),

num_parallel_calls=tf.data.experimental.AUTOTUNE

)

dataset = dataset.batch(batch_size)

if is_training:

dataset = dataset.repeat()

return dataset.prefetch(buffer_size=tf.data.experimental.AUTOTUNE)

def load_and_preprocess_image(path):

image = tf.io.read_file(path)

image = tf.image.decode_jpeg(image, channels=3)

image = tf.image.resize(image, [224, 224])

image = tf.cast(image, tf.float32) / 255.0 # 归一化

return image6.常见问题解答

6.1如何处理非常大的数据集?

6.1.1解决方案

- 使用

tf.data.Dataset.list_files创建文件数据集- 使用交错读取 (

interleave) 并行处理多个文件- 考虑使用 TFRecord 格式存储数据

6.2为什么我的数据管道速度很慢

6.2.1排查步骤

- 检查是否使用了预取 (

prefetch)- 确保 map 操作设置了

num_parallel_calls- 验证 shuffle 的 buffer_size 是否足够大

- 考虑使用

tf.data.experimental.snapshot缓存中间结果

7.最佳实践总结

- 尽早 shuffle:在数据管道的早期应用 shuffle

- 延迟批处理:在应用 map 后再进行批处理

- 利用并行:尽可能使用并行化操作

- 重叠执行:使用 prefetch 实现数据加载和模型执行的重叠

- 合理缓存:对不变的数据进行缓存

欢迎各位彦祖与热巴畅游本人专栏与技术博客

你的三连是我最大的动力

点击➡️指向的专栏名即可闪现

➡️计算机组成原理****

➡️操作系统

➡️****渗透终极之红队攻击行动********

➡️ 动画可视化数据结构与算法

➡️ 永恒之心蓝队联纵合横防御

➡️****华为高级网络工程师********

➡️****华为高级防火墙防御集成部署********

➡️ 未授权访问漏洞横向渗透利用

➡️****逆向软件破解工程********

➡️****MYSQL REDIS 进阶实操********

➡️****红帽高级工程师

➡️红帽系统管理员********

➡️****HVV 全国各地面试题汇总********