前言

在微服务架构中,网关是流量的统一入口,网关层限流 是流量治理的第一道核心防线,能在流量进入服务层前完成无效流量拦截,大幅减轻下游服务的资源消耗。此前笔者在《流量治理:熔断 vs 限流的协同防御体系构建》中,详细解析了限流 / 熔断的核心机制、算法原理及分层防护逻辑,而本次内容则是限流理论的工程化落地实践 ------ 聚焦 Spring Cloud 生态下Sentinel + Spring Cloud Gateway 的联动限流,从基础配置、进阶功能、生产化改造,实现可复现、可落地、企业级 的网关层限流方案。

一、核心认知:为什么选择 Sentinel + Spring Cloud Gateway 做网关限流?

1.1 网关层限流的核心价值

相较于服务层限流,网关层限流具备 「前置拦截、粗粒度管控、统一策略」 的优势,具体体现在:

- 减少无效资源消耗 :在流量进入服务层前拦截超限请求,避免下游服务的线程、连接池、数据库资源被无效请求占用;

- 策略统一管理 :基于网关实现全微服务集群的限流策略统一配置,无需在每个服务中单独配置,降低维护成本;

- 防护范围更广 :可针对路由、API 分组做粗粒度限流,适配多服务的通用防护场景;

- 与熔断协同防护 :网关层限流做流量入口控制 ,服务层 Sentinel 熔断做服务依赖防护 ,形成「限流 + 熔断」的双层流量治理体系。

1.2 单独限流方案的弊端:为什么一定要「Sentinel + Spring Cloud Gateway 联动」?

在微服务网关限流的演进中,很多团队最先尝试的是两种简单方案 :

- 方案 A:只使用 Spring Cloud Gateway 自带过滤器实现限流

- 方案 B:只在微服务内部接入 Sentinel,做服务层限流

但在真实高并发生产环境下,这两种方案都存在明显缺陷 ,无法支撑企业级流量治理需求。

1.2.1 只使用 Spring Cloud Gateway 自带限流的弊端

Spring Cloud Gateway 本身提供了 RequestRateLimiter 过滤器,可以基于 Redis + Lua 实现简单限流,但存在五大硬伤 :

|-----------------|---------------------------------------------------|

| 弊端 | 具体问题 |

| 限流维度极其单一 | 仅支持 IP、用户 ID 等简单维度,无法支持路由分组、API 分组、热点参数、业务字段等复杂限流 |

| 无统一管控控制台 | 规则散落在配置文件或 Redis 里,没有可视化监控、流控报表、实时 QPS 展示 |

| 规则无法动态热更新 | 修改阈值必须重启网关,无法应对大促、秒杀、突发流量场景 |

| 无熔断、降级、隔离能力 | 只能限流,不能熔断慢调用、不能降级、不能隔离故障依赖,流量防护能力残缺 |

| 无集群精准限流能力 | 基于 Redis 计数,在超高频场景下存在精度问题,且没有内置集群限流模式 |

结论 :Gateway 自带限流只能算 "能用",远远达不到 "生产级、高可用、可运营" 的标准。

1.2.2 只在服务层使用 Sentinel 限流的弊端

如果只在每个微服务内部接入 Sentinel,不在网关层做统一限流,同样存在架构缺陷 :

|--------------------|-------------------------------------------|

| 弊端 | 具体问题 |

| 流量已经穿透到服务层才被拦截 | 无效流量、恶意流量、超限流量依然会经过网关、网络、过滤器,浪费系统资源 |

| 每个服务都要重复配置 | 订单、商品、支付... 每个服务都要写限流规则,维护成本极高,策略不统一 |

| 无法做全局流量调度 | 不能在入口层对流量做优先级排序、流量染色、分层放行,只能被动防御 |

| 网关与服务流量治理割裂 | 网关不知道服务负载,服务不知道网关流量,极易出现 "网关放行、服务被打挂" 的矛盾 |

| 无法实现统一降级返回 | 各个服务限流返回格式不一致,前端体验混乱,难以标准化 |

结论 :只在服务层限流 = "亡羊补牢" ,不是 "前置防御",架构上不闭环。

1.2.3 为什么「Sentinel + Spring Cloud Gateway 联动」是必然趋势?

只有把 Gateway 的全局入口能力 与 Sentinel 的流量治理能力 结合,才能弥补各自缺陷,形成真正企业级的网关限流方案 。

|--------------------------|-----------------------------------|

| 优势 | 解决的问题 |

| 统一入口 + 统一治理 | 网关做流量入口,Sentinel 做规则引擎,全系统限流策略一盘棋 |

| 前置拦截,不浪费下游资源 | 超限流量在网关层直接拒绝,不进入服务集群 |

| 多维度、精细化限流 | 支持路由、API 分组、请求头、请求参数、用户、租户等任意维度 |

| 规则动态热更新 + 持久化 | 支持 Nacos/Apollo/ 控制台配置,不重启、不丢失 |

| 限流 + 熔断 + 降级 + 隔离全覆盖 | 真正完整的高可用防护体系 |

| 集群限流精准可靠 | 解决网关集群下计数不准、阈值被突破的问题 |

| 监控可观测、可告警 | QPS、通过数、阻塞数、响应时间全可视化 |

二、基础 限流 实战:网关层基础限流

本部分实现最基础的网关层限流能力 :基于 Sentinel 控制台实现路由级限流 和API 分组限流 ,自定义限流降级响应结果,并用 JMeter 完成压测验证。

2.1 环境准备:Sentinel 控制台部署

Sentinel 限流规则的配置、监控均依赖控制台,需先完成控制台部署,步骤如下:

-

下载控制台包 :从Sentinel 官方仓库下载1.8.6 版本 的 jar 包(sentinel-dashboard-1.8.6.jar);

-

启动控制台 :执行命令启动,默认端口 8080,可自定义端口(避免与业务服务冲突);

java# 直接启动(默认端口8080) java -jar sentinel-dashboard-1.8.6.jar # 自定义端口启动(推荐,如8858) java -jar sentinel-dashboard-1.8.6.jar --server.port=8858 -

访问控制台 :浏览器打开http://localhost:8858,默认账号 / 密码:sentinel/sentinel,进入控制台首页。

2.2 项目配置:Gateway + Sentinel 基础联动配置

2.2.1 核心 yml 配置

在 Spring Cloud Gateway 项目中添加以下配置,实现与 Sentinel 控制台的联动、路由配置、基础限流降级配置:

bash

server:

port: 9000 # 网关服务端口

spring:

application:

name: gateway-server # 网关服务名

cloud:

# Gateway 路由配置

gateway:

routes:

# 路由1:订单服务路由(ID:order-service)

- id: order-service

uri: lb://order-service # 服务负载均衡地址(需配合Nacos/Eureka)

predicates:

- Path=/api/order/** # 路由匹配路径

# 路由2:商品服务路由(ID:goods-service)

- id: goods-service

uri: lb://goods-service

predicates:

- Path=/api/goods/**

# 路由3:支付服务路由(ID:pay-service,核心业务)

- id: pay-service

uri: lb://pay-service

predicates:

- Path=/api/pay/**

# Sentinel 配置

sentinel:

transport:

dashboard: localhost:8858 # Sentinel控制台地址(与实际启动地址一致)

port: 8719 # Sentinel客户端与控制台通信的端口(默认8719,若占用可自定义)

# Sentinel Gateway 专属配置

scg:

fallback:

mode: response # 限流降级返回方式:直接返回响应

response-status: 429 # 限流返回状态码

response-body: '{"code": 429, "msg": "请求过于频繁,请稍后重试", "data": null}' # 自定义限流返回JSON

content-type: application/json;charset=UTF-8 # 响应体类型配置说明 :

- sentinel.transport.dashboard:指定 Sentinel 控制台地址,网关服务启动后会自动向控制台注册;

- sentinel.scg.fallback:网关层限流降级的基础配置,实现标准化 JSON 响应 ,替代 Sentinel 默认的 HTML 页面响应,适配前端统一处理;

- 路由 ID 是 Sentinel路由级限流 的核心标识,后续限流规则将基于此 ID 配置。

2.2.2 启动服务验证注册

启动网关服务(gateway-server)、下游微服务(order-service/goods-service/pay-service),访问 Sentinel 控制台(http://localhost:8858),在「网关路由」菜单中可看到已注册的网关路由,说明基础联动成功。

注意 :Sentinel 采用懒加载机制 ,需先访问一次网关的路由接口(如http://localhost:9000/api/order/list),控制台才会显示对应的路由资源。

2.3 控制台配置:实现路由级 / API 分组级限流

Sentinel 控制台为 Gateway 提供了专属的网关限流配置入口 ,无需编写代码,直接在控制台配置规则即可生效,支持路由级 和API 分组级 两种核心限流方式。

2.3.1 路由级限流(最常用)

适用场景 :针对单个网关路由做整体限流,如限制支付服务路由(pay-service)的 QPS,保护核心业务服务。配置步骤 :

- 进入 Sentinel 控制台 → 选择网关服务gateway-server → 左侧菜单「网关流控规则」→ 「新增网关流控规则」;

- 配置限流规则(以支付服务路由为例,限制 QPS=10):

|---------|-------------|-----------------------------------------|

| 配置项 | 配置值 | 说明 |

| 资源类型 | 网关路由 | 选择「网关路由」,基于路由 ID 限流 |

| 资源名 | pay-service | 网关路由 ID(与 yml 中配置的一致) |

| 限流类型 | QPS | 限流指标:QPS(每秒请求数),也可选择「并发数」 |

| 阈值 | 10 | 限流阈值:每秒最多允许 10 个请求 |

| 流控模式 | 直接 | 直接限流:针对当前路由直接限流(无需关联其他资源) |

| 流控效果 | 快速失败 | 超出阈值直接拒绝,返回降级结果(其他效果:WarmUp / 排队等待后续讲解) |

- 点击「新增」,规则立即生效(热更新 ,无需重启服务)。

2.3.2 API 分组级限流

适用场景 :针对多个路由的通用 API 路径 做统一限流,如对所有服务的/api/**/detail(详情接口)、/api/**/list(列表接口)做统一限流,实现粗粒度的通用防护。

配置步骤 :

- 先创建 API 分组:进入 Sentinel 控制台 → 「API 管理」→ 「新增 API 分组」;

- 分组名:如api-detail-group(详情接口分组);

- 匹配模式:前缀匹配 / 精确匹配 / 正则匹配 (推荐前缀匹配);

- 匹配值:/api/**/detail(匹配所有服务的详情接口);

- 配置 API 分组限流规则:进入「网关流控规则」→ 「新增网关流控规则」;

|---------|------------------|----------------------------|

| 配置项 | 配置值 | 说明 |

| 资源类型 | API 分组 | 选择「API 分组」,基于已创建的 API 分组限流 |

| 资源名 | api-detail-group | 已创建的 API 分组名 |

| 限流类型 | QPS | 限流指标:QPS |

| 阈值 | 20 | 该 API 分组的全局 QPS 阈值 |

- 点击「新增」,规则立即生效,所有匹配该 API 分组的接口将被统一限流。

2.4 压测验证:限流规则是否生效

使用JMeter 对配置了限流规则的路由做压测,验证限流效果,步骤如下:

- 新建 JMeter 测试计划 → 新建线程组:设置线程数 = 20,循环次数 = 无限(持续压测);

- 新建 HTTP 请求:请求地址 =http://localhost:9000/api/pay/create(支付服务核心接口),请求方式 = POST;

- 启动压测,同时查看两个维度的结果:

- 前端响应 :部分请求返回{"code":429,"msg":"请求过于频繁,请稍后重试"},说明限流降级生效;

- Sentinel 控制台监控 :进入「实时监控」,可看到 QPS 稳定在 10 左右,「阻塞数」持续增加,与配置的阈值一致。

三、进阶实战:网关层限流的高频实战需求实现

基础限流仅能满足简单场景,实际生产中需要细粒度、可定制、高可用 的限流能力。

3.1 自定义维度限流:基于 Header / 请求参数实现细粒度限流

基础的路由级 / API 分组级限流属于粗粒度限流 ,实际场景中常需要基于业务属性 做细粒度限流,如:

- 基于X-User-Id(用户 ID)Header:限制单用户的请求 QPS,防止单用户刷接口;

- 基于goodsId(商品 ID)请求参数:限制秒杀商品的单商品请求 QPS,防止热点商品被冲垮;

- 基于X-Tenant-Id(租户 ID)Header:多租户架构中,限制单租户的 QPS。

Sentinel Gateway 支持通过实现 GatewayRequestParser 接口自定义限流维度,核心思路是:从 Gateway 的请求上下文中提取自定义属性,作为 Sentinel 的限流维度标识 ,实现细粒度限流。

3.1.1 实现自定义 GatewayRequestParser

创建自定义类CustomGatewayRequestParser,实现GatewayRequestParser接口,从请求中提取 用户 ID(X-User-Id)和 商品 ID(goodsId) 作为自定义限流维度:

java

import com.alibaba.csp.sentinel.adapter.gateway.sc.request.GatewayRequestParser;

import org.springframework.http.server.reactive.ServerHttpRequest;

import org.springframework.stereotype.Component;

import org.springframework.util.StringUtils;

import org.springframework.web.server.ServerWebExchange;

import java.util.HashMap;

import java.util.Map;

/**

* 自定义Sentinel Gateway请求解析器,实现基于Header/参数的自定义维度限流

*/

@Component

public class CustomGatewayRequestParser implements GatewayRequestParser {

// 自定义维度标识:用户ID

private static final String DIMENSION_USER_ID = "X-User-Id";

// 自定义维度标识:商品ID

private static final String DIMENSION_GOODS_ID = "goodsId";

@Override

public Map<String, String> parse(ServerWebExchange exchange) {

Map<String, String> dimensionMap = new HashMap<>(2);

ServerHttpRequest request = exchange.getRequest();

// 1. 从Header中提取用户ID(X-User-Id)

String userId = request.getHeaders().getFirst(DIMENSION_USER_ID);

if (StringUtils.hasText(userId)) {

dimensionMap.put(DIMENSION_USER_ID, userId);

}

// 2. 从请求参数中提取商品ID(goodsId,支持GET/POST表单参数)

String goodsId = request.getQueryParams().getFirst(DIMENSION_GOODS_ID);

// 若GET参数中无,可从POST表单中提取(根据实际业务场景调整)

if (!StringUtils.hasText(goodsId)) {

// 处理POST表单参数逻辑(略,可基于ServerWebExchange获取请求体)

}

if (StringUtils.hasText(goodsId)) {

dimensionMap.put(DIMENSION_GOODS_ID, goodsId);

}

return dimensionMap;

}

}代码说明 :

- 实现GatewayRequestParser接口的parse方法,该方法的返回值为自定义维度的 K-V 映射 ,Sentinel 会将这些维度纳入限流规则的匹配范围;

- 可根据实际业务场景,从 Header、URL 参数、POST 请求体、Cookie 等任意位置提取自定义属性;

- 该类需添加@Component注解,让 Spring 自动扫描并注入,Sentinel 会自动识别并使用该自定义解析器。

3.1.2 配置自定义维度限流规则

自定义维度解析器实现后,在 Sentinel 控制台配置网关流控规则 时,通过 「参数流控」 实现自定义维度的细粒度限流,步骤如下:

- 进入「网关流控规则」→ 「新增网关流控规则」;

- 基础配置:资源类型 = 网关路由,资源名 = pay-service,限流类型 = QPS,阈值 = 5;

- 开启参数流控 配置:

- 勾选「是否开启参数流控」;

- 参数名:X-User-Id(与自定义解析器中的维度标识一致);

- 参数类型:字符串;

- 限流方式:单机限流(集群限流后续讲解);

- 点击「新增」,规则生效:支付服务路由中,单个用户 ID 的 QPS 被限制为 5 ,实现单用户的细粒度限流。

3.2 规则持久化:基于 Nacos 实现限流规则持久化(解决重启丢失问题)

Sentinel 控制台的默认规则配置是内存级 ,网关服务或 Sentinel 控制台重启后,限流规则会全部丢失,这是生产环境的致命问题。因此必须实现限流规则的持久化 ,本文选择Nacos 作为规则配置中心(贴合 Spring Cloud 生态,配置简单,支持热更新),实现「规则配置在 Nacos,Sentinel 自动监听并加载,重启不丢失」。

3.2.1 核心原理

Sentinel 提供了动态数据源扩展 ,通过实现DataSource接口,可将规则从 Nacos、Apollo、ZooKeeper 等配置中心加载,并监听配置中心的规则变更,实现规则的热更新与持久化。核心流程:

Nacos配置中心(持久化规则)→ Sentinel动态数据源 → 监听Nacos配置变更 → 自动更新Sentinel限流规则

3.2.2 添加 Nacos 数据源依赖

在网关项目中添加 Sentinel-Nacos 数据源依赖,实现与 Nacos 的联动:

XML

<!-- Sentinel 整合 Nacos 动态数据源 -->

<dependency>

<groupId>com.alibaba.csp</groupId>

<artifactId>sentinel-datasource-nacos</artifactId>

</dependency>

<!-- Nacos 服务发现依赖(若已引入可忽略) -->

<dependency>

<groupId>com.alibaba.cloud</groupId>

<artifactId>spring-cloud-starter-alibaba-nacos-discovery</artifactId>

</dependency>3.2.3 yml 配置 Nacos 数据源

在原有 yml 配置的基础上,添加 Sentinel 动态数据源配置,指定 Nacos 的地址、规则配置的 dataId、groupId:

bash

spring:

cloud:

nacos:

discovery:

server-addr: localhost:8848 # Nacos服务发现地址(与实际一致)

sentinel:

# 新增:动态数据源配置(基于Nacos实现规则持久化)

datasource:

# 数据源1:网关流控规则(gw-flow)

gw-flow:

nacos:

server-addr: localhost:8848 # Nacos配置中心地址

data-id: ${spring.application.name}-gw-flow-rules # 规则配置的dataId(网关服务名-网关流控规则)

group-id: SENTINEL_GROUP # 规则配置的groupId(自定义)

data-type: json # 配置格式:JSON

rule-type: gw-flow # 规则类型:网关流控规则(固定值)

# 可选:数据源2:网关降级规则(若需要熔断,可配置)

gw-degrade:

nacos:

server-addr: localhost:8848

data-id: ${spring.application.name}-gw-degrade-rules

group-id: SENTINEL_GROUP

data-type: json

rule-type: gw-degrade配置说明 :

- rule-type:规则类型,网关流控规则为gw-flow,网关降级规则为gw-degrade,不可写错 ,否则 Sentinel 无法识别;

- data-id:建议使用「服务名 + 规则类型」的命名方式,避免多服务规则冲突;

- 若需要实现服务层流控 / 降级规则的持久化,可新增数据源,规则类型分别为flow/degrade。

3.2.4 Nacos 中配置限流规则 JSON

进入 Nacos 控制台 → 「配置管理」→ 「配置列表」→ 「新增配置」,配置与 yml 中对应的dataId和groupId,配置内容为 Sentinel 网关流控规则的 JSON 数组 ,示例如下(配置 pay-service 路由的 QPS 限流 + 用户 ID 维度限流):

bash

[

{

"resource": "pay-service",

"resourceType": 0,

"grade": 1,

"count": 10,

"strategy": 0,

"controlBehavior": 0,

"clusterMode": false,

"paramItem": {

"parseStrategy": 3,

"fieldName": "X-User-Id",

"dataType": 0,

"paramFlowItemList": []

}

}

]JSON 字段说明(核心) :

|-----------------|---------------------------------------------------------------|

| 字段 | 取值 / 说明 |

| resource | 资源名:网关路由 ID(pay-service) |

| resourceType | 资源类型:0 = 网关路由,1=API 分组(固定) |

| grade | 限流类型:1=QPS,0 = 并发数(固定) |

| count | 限流阈值:10(QPS=10) |

| controlBehavior | 流控效果:0 = 快速失败,1=WarmUp,2 = 排队等待 |

| clusterMode | 是否集群限流:false(单机),true(集群) |

| paramItem | 自定义参数限流配置:parseStrategy=3(自定义解析),fieldName=X-User-Id(自定义维度标识) |

配置完成后 ,发布配置,网关服务会自动监听 Nacos 配置变更,加载限流规则,且服务重启后规则不会丢失 ;若需要修改规则,直接在 Nacos 中编辑配置并发布,规则会热更新 至 Sentinel,无需重启服务。

3.3 流控效果进阶:WarmUp 与排队等待(适配不同业务场景)

Sentinel 提供了三种流控效果 ,基础实战中使用的是「快速失败」,本部分讲解另外两种进阶效果,适配不同的业务场景:

|------------------------------|-------------------------|--------------------------------|

| 流控效果 | 核心原理 | 适用场景 |

| 快速失败(ControlBehavior=0) | 超出阈值直接拒绝,无缓冲 | 非核心业务、防刷场景,允许直接拒绝 |

| WarmUp(预热,ControlBehavior=1) | 限流阈值从低到高逐渐提升至目标值,有预热期 | 核心业务的流量高峰场景(如秒杀、大促),避免瞬间流量冲垮服务 |

| 排队等待(ControlBehavior=2) | 超出阈值的请求进入队列,按固定速率处理,无拒绝 | 核心支付、订单提交等场景,不允许拒绝请求,可接受短暂排队 |

3.3.1 WarmUp(预热)配置

适用于秒杀、大促等场景,避免瞬间高流量直接冲击服务,配置示例(Nacos JSON / 控制台均可):

java

{

"resource": "pay-service",

"resourceType": 0,

"grade": 1,

"count": 50, // 目标阈值:QPS=50

"controlBehavior": 1, // 流控效果:WarmUp

"warmUpPeriodSec": 300 // 预热时间:300秒(5分钟),阈值从50/3=16逐渐提升至50

}核心参数 :warmUpPeriodSec(预热时间,秒),Sentinel 会将目标阈值除以 3 作为初始阈值 ,在预热时间内逐渐提升至目标阈值。超过阈值,新的请求将被直接拒绝(抛出 FlowException),这与"快速失败"模式的行为一致。

3.3.2 排队等待配置

适用于支付、订单提交等核心业务,不允许直接拒绝请求,配置示例:

java

{

"resource": "pay-service",

"resourceType": 0,

"grade": 1,

"count": 20, // 处理速率:QPS=20

"controlBehavior": 2, // 流控效果:排队等待

"maxQueueingTimeMs": 1000 // 最大排队时间:1000毫秒(1秒),超过则拒绝

}核心参数 :maxQueueingTimeMs(最大排队时间,毫秒),请求的排队时间超过该值则直接拒绝,避免请求无限排队导致超时。

3.4 网关层限流与服务层熔断的协同联动

网关层限流与服务层熔断是流量治理的双层防护体系 ,二者需协同工作,避免「网关层限流放行,但服务层因依赖故障导致雪崩」的问题,核心协同策略:

- 网关层做流量入口控制 :拦截超限、恶意流量,保证进入服务层的流量在服务承载能力范围内;

- 服务层做依赖故障防护 :对服务间的 RPC 调用、第三方接口调用做熔断,避免单个服务故障拖垮整个集群;

- 状态联动 :网关层感知服务层的健康状态(如错误率、RT),当服务层异常时,自动降低网关层限流阈值,减少进入服务层的流量。

3.4.1 基础协同配置

- 服务层熔断配置 :在下游服务(如 pay-service)中配置 Sentinel 熔断规则,对核心依赖(如库存服务)做熔断:

java

// 服务层熔断规则示例(以代码方式为例,也可通过Nacos/控制台配置)

@PostConstruct

public void initDegradeRule() {

DegradeRule rule = new DegradeRule()

.setResource("rpc://stock-service/reduceStock") // 依赖资源名

.setGrade(RuleConstant.DEGRADE_GRADE_RT) // 按RT熔断

.setCount(500) // RT阈值:500ms

.setTimeWindow(10); // 熔断时间:10秒

DegradeRuleManager.loadRules(Collections.singletonList(rule));

}2. 网关层限流兜底 :网关层对服务层的熔断异常做统一降级,避免前端收到杂乱的异常信息(已在基础配置中实现标准化 JSON 降级)。

3.4.2 高级状态联动(基于 Sentinel 规则动态调整)

通过Sentinel 规则动态更新 实现网关层与服务层的状态联动:开发服务监控组件,实时采集服务层的错误率、RT 指标,当指标超过阈值时,通过 Nacos 动态修改网关层的限流阈值,实现流量的动态收缩 ;当服务层恢复正常后,自动恢复网关层限流阈值。

四、生产化改造:企业级网关限流的核心优化

基础与进阶配置实现了网关限流的核心功能,但要在高并发、高可用 的生产环境中稳定运行,还需从集群限流、性能优化、资源隔离、监控联动 四个维度做生产化改造,解决集群计数误差、性能瓶颈、故障隔离、监控缺失等问题。

4.1 集群限流:解决网关集群部署的限流计数误差问题

网关服务在生产环境中必然是集群部署 ,单机限流会导致「集群总 QPS 超出阈值但单个节点未超限」的问题(如每个节点限流 QPS=10,3 个节点集群总 QPS 可达 30,若服务层仅能承载 20QPS,会导致服务层过载)。因此必须实现Sentinel 集群限流 ,保证全集群的限流计数精准统一 。

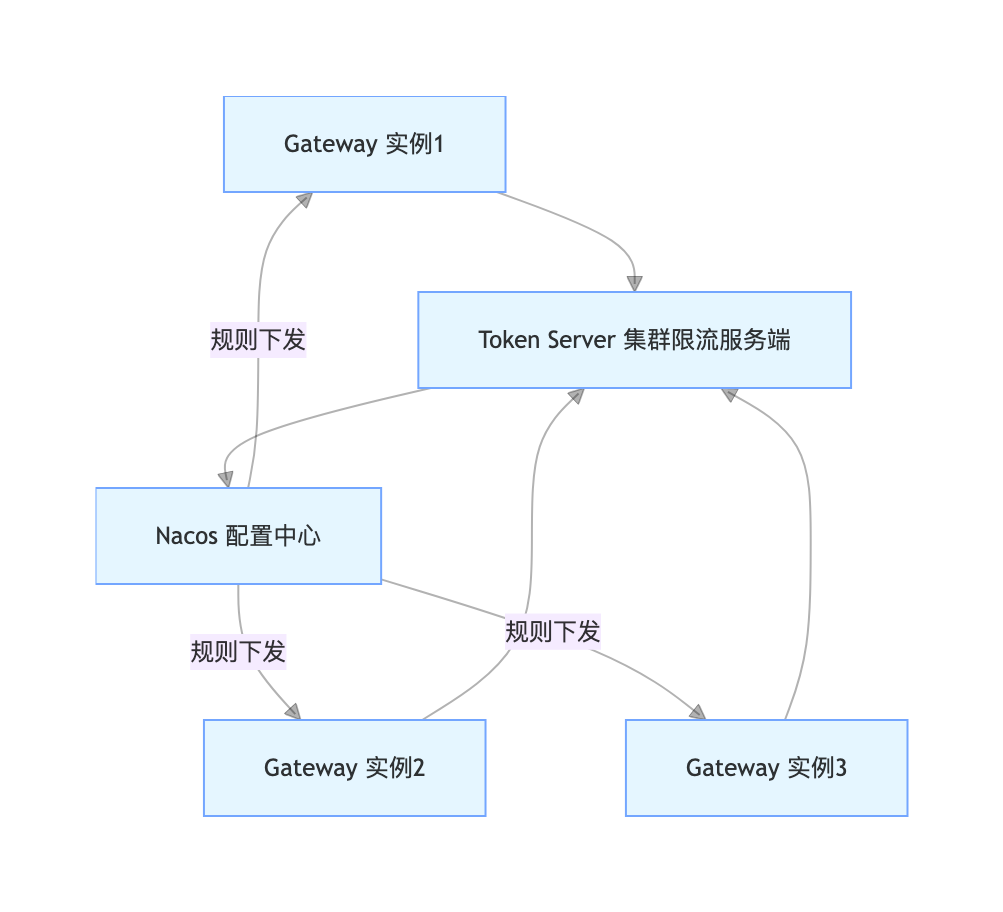

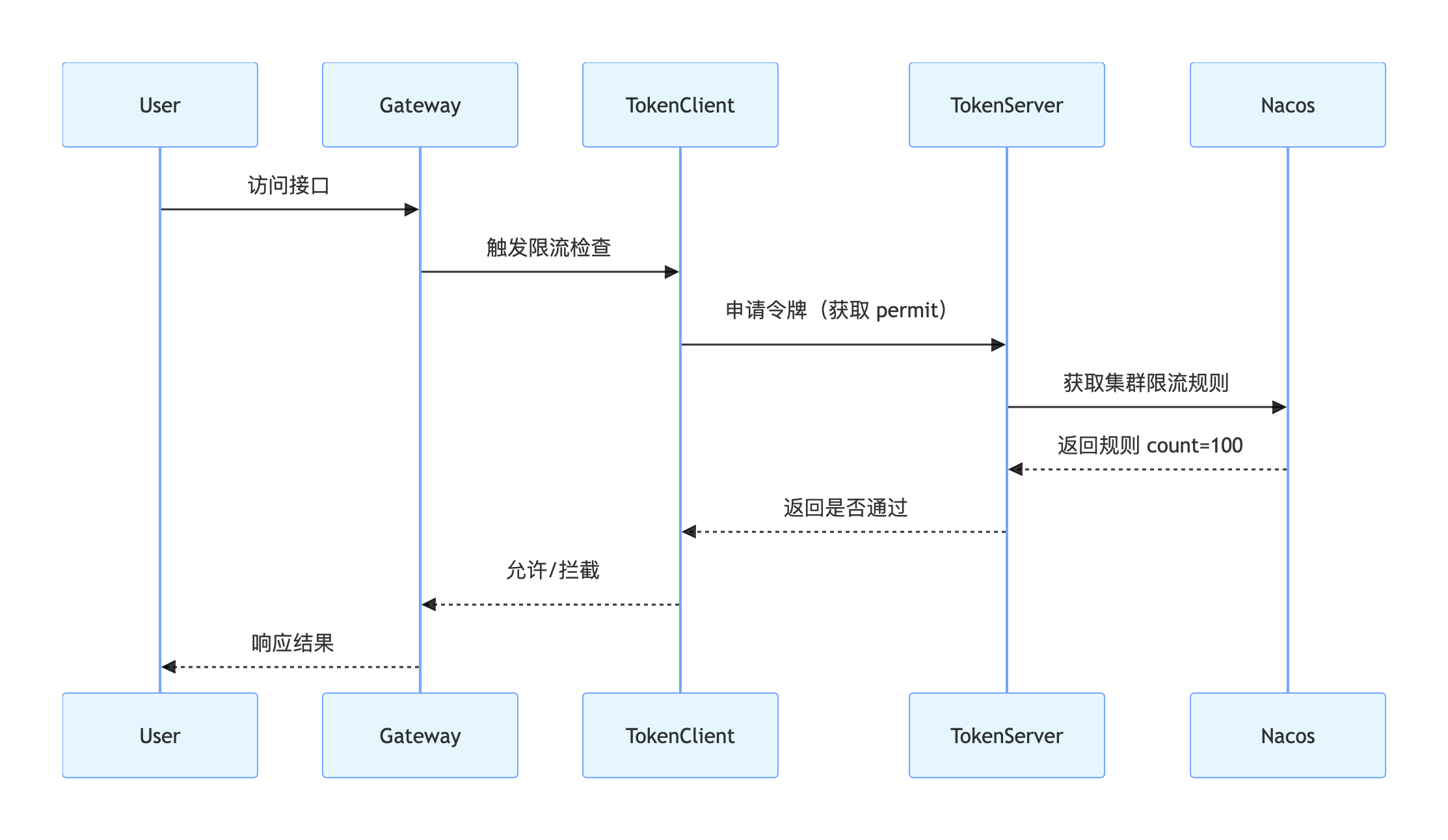

4.1.1 集群限流核心架构

Sentinel 集群限流采用 「服务端 - 客户端」架构,核心组件:

- 集群限流服务端( Token Server) :负责统一的限流计数、规则管理,独立部署,集群化运行,避免单点故障;

- 集群限流客户端( Token Client) :即网关服务(Sentinel 客户端),将限流计数请求发送至服务端,由服务端统一判断是否限流。

架构图

交互时序图

4.2 性能优化:避免 Sentinel 成为网关性能瓶颈

Sentinel 的限流统计、规则匹配等操作会带来一定的性能损耗,若不做优化,在高并发场景下可能成为网关的性能瓶颈,核心优化点如下:

- 关闭不必要的监控 :Sentinel 默认开启的控制台监控、日志监控会带来性能损耗,生产环境可关闭非核心监控:

java

sentinel:

metric:

export:

enabled: false # 关闭监控指标导出

log:

enabled: false # 关闭Sentinel日志(若需要可调整日志级别为WARN/ERROR)2. 规则瘦身 :仅保留必要的限流规则,避免规则过多导致的规则匹配性能下降(如网关层仅做路由级 / 核心自定义维度限流,细粒度的参数限流下放至服务层);

3. 开启异步统计 :Sentinel 的StatisticSlot默认采用同步统计,高并发下可开启异步统计,减少请求阻塞:

java

@PostConstruct

public void initSentinelConfig() {

// 开启Sentinel异步统计

StatisticSlotConfig.setAsyncCalc(true);

// 设置异步统计的线程池大小

StatisticSlotConfig.setAsyncExecutorPoolSize(10);

}4. 本地缓存热点规则 :将高频访问的热点限流规则(如秒杀商品 ID)缓存至网关本地内存,减少对 Nacos / 集群服务端的访问,提升规则匹配速度。

4.3 资源隔离:避免限流组件故障拖垮网关服务

Sentinel 的限流逻辑、集群限流客户端的网络请求等操作,若与网关的核心路由逻辑共享资源(线程池、网络连接),当 Sentinel 组件故障时(如集群服务端连接超时、Nacos 配置中心不可用),会导致网关的核心路由逻辑阻塞,最终拖垮整个网关服务。因此必须实现Sentinel 与网关的资源隔离 。

4.3.1 线程池隔离

将 Sentinel 的限流过滤逻辑与 Gateway 的核心路由逻辑放在不同的线程池 中执行,实现线程级隔离:

java

import org.springframework.cloud.gateway.filter.GlobalFilter;

import org.springframework.context.annotation.Bean;

import org.springframework.context.annotation.Configuration;

import org.springframework.scheduling.concurrent.ThreadPoolTaskExecutor;

/**

* Sentinel 资源隔离配置:线程池隔离

*/

@Configuration

public class SentinelResourceIsolationConfig {

// 定义Sentinel专属线程池

@Bean("sentinelExecutor")

public ThreadPoolTaskExecutor sentinelExecutor() {

ThreadPoolTaskExecutor executor = new ThreadPoolTaskExecutor();

executor.setCorePoolSize(10);

executor.setMaxPoolSize(20);

executor.setQueueCapacity(100);

executor.setThreadNamePrefix("sentinel-");

executor.setRejectedExecutionHandler(new ThreadPoolExecutor.CallerRunsPolicy());

executor.initialize();

return executor;

}

// 自定义Sentinel全局过滤器,使用专属线程池执行限流逻辑

@Bean

public GlobalFilter sentinelIsolationFilter(ThreadPoolTaskExecutor sentinelExecutor) {

return (exchange, chain) -> {

// 将Sentinel限流逻辑提交至专属线程池执行

return sentinelExecutor.submit(() -> chain.filter(exchange)).get();

};

}

}4.3.2 网络资源隔离

将 Sentinel 与集群服务端、Nacos 的网络请求,与网关的业务路由网络请求做网络隔离 (如使用不同的 NIO 线程池、连接池),避免网络请求阻塞相互影响。

4.4 监控联动:Prometheus + Grafana 实现可视化监控

Sentinel 自带的控制台监控仅能满足基础需求,生产环境中需要更全面、更灵活、可告警 的可视化监控体系。本文实现Sentinel + Prometheus + Grafana 的监控联动,实时采集网关限流的核心指标,实现可视化展示与分级告警。

4.4.1 暴露 Sentinel 监控指标

Sentinel 支持通过 Micrometer 暴露监控指标,对接 Prometheus,步骤如下:

- 添加 Micrometer 与 Prometheus 依赖:

XML

<!-- Micrometer 核心依赖 -->

<dependency>

<groupId>io.micrometer</groupId>

<artifactId>micrometer-core</artifactId>

</dependency>

<!-- Micrometer 对接 Prometheus -->

<dependency>

<groupId>io.micrometer</groupId>

<artifactId>micrometer-registry-prometheus</artifactId>

</dependency>

<!-- Spring Boot Actuator 暴露指标端点 -->

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-actuator</artifactId>

</dependency>- 配置 Actuator 暴露 Prometheus 指标端点:

java

management:

endpoints:

web:

exposure:

include: prometheus,health,info # 暴露prometheus端点

metrics:

tags:

application: ${spring.application.name} # 为指标添加服务名标签- 验证指标暴露:访问http://localhost:9000/actuator/prometheus,可看到 Sentinel 的核心监控指标(如sentinel_gateway_flow_pass、sentinel_gateway_flow_block)。

4.4.2 Prometheus 配置采集

修改 Prometheus 的prometheus.yml配置文件,添加网关服务的指标采集配置:

java

scrape_configs:

- job_name: 'gateway-server'

scrape_interval: 5s # 采集间隔:5秒

static_configs:

- targets: ['localhost:9000'] # 网关服务地址(集群部署则配置所有节点)启动 Prometheus,访问http://localhost:9090,可看到已成功采集网关服务的 Sentinel 指标。

4.4.3 Grafana 配置可视化面板

- 启动 Grafana,访问http://localhost:3000(默认账号 / 密码:admin/admin);

- 添加 Prometheus 数据源:配置数据源地址为http://localhost:9090;

- 导入 Sentinel 监控面板:可从 Grafana 官网(https://grafana.com/dashboards)搜索「Sentinel Gateway」导入现成的面板,或自定义面板,展示核心指标:

- 各路由的 QPS(通过 / 阻塞);

- 限流次数、降级次数趋势;

- 集群限流计数、规则匹配次数;

- 网关服务的 CPU、内存、线程池状态。

4.4.4 分级告警配置

在 Grafana 中配置分级告警规则 ,针对核心指标设置阈值,触发告警后通过邮件、企业微信、钉钉等方式通知相关人员:

- P0 告警 :支付服务路由阻塞次数 > 100 次 / 分钟、网关服务 CPU 使用率 > 90%;

- P1 告警 :商品 / 订单服务路由阻塞次数 > 200 次 / 分钟、Sentinel 集群服务端不可用;

- P2 告警 :普通接口限流次数 > 500 次 / 分钟、监控指标采集失败。

五、 核心 复习 要点

本文从 基础配置 → 进阶功能 → 生产化改造 → 架构对比 ,完整实现了 Sentinel + Spring Cloud Gateway 联动限流 的企业级方案,核心价值如下:

- 先破后立 :明确了「只靠 Gateway 自带限流」和「只靠服务层 Sentinel」各自的弊端,从架构上证明联动是必然趋势 。

- 多维度限流全覆盖 :路由级、API 分组、请求头 / 参数、热点参数、自定义字段。

- 规则持久化 + 热更新 :基于 Nacos 实现规则不丢失、不重启生效。

- 集群限流精准可控 :解决网关集群下单机限流不准、总阈值突破问题。

- 生产级强化 :性能优化、资源隔离、全链路监控、动态扩缩容能力。

- 可运营、可观测、可联动 :网关层限流 + 服务层熔断形成完整流量治理闭环。

一句话定位:Spring Cloud Gateway 负责流量入口,Sentinel 负责流量治理,二者联动才是现代微服务网关层的标准架构。

📚 我的技术博客导航:[点击进入一站式查看所有干货]