大家好,我是孟健。

昨晚9点半,我的16个AI员工同时开工了。

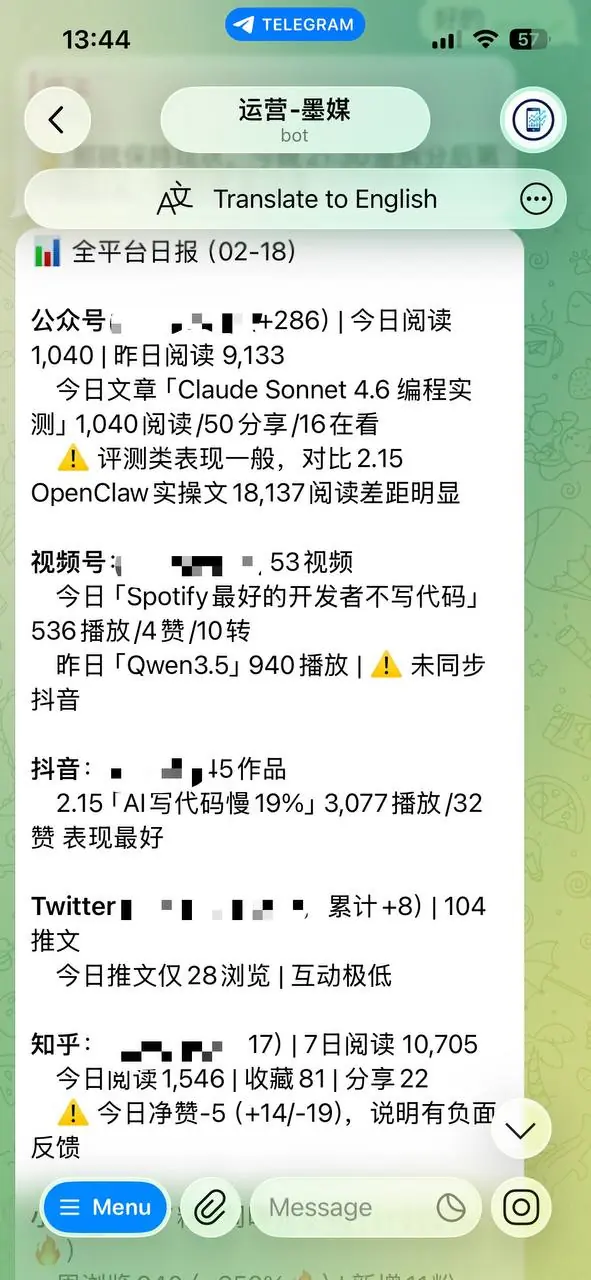

不是夸张。8个平台运营Agent在21:30到21:56之间,依次完成了13个自媒体平台的数据采集、热点分析和内容规划。22:00整,运营总监"墨媒"准时把全局日报推到了我的Telegram。我全程没碰键盘。

一个人,16个Agent,13个平台,每天5分钟。这是我现在的自媒体运营方式。

先说痛点

我现在全职创业,个人IP是核心资产。为了最大化内容覆盖,我需要同时运营十几个平台------公众号、知乎、B站、视频号、掘金、小红书、Twitter、微博、即刻、抖音、YouTube、知识星球......

一个人运营这些平台,按传统方式,每天至少4-5个小时。写文章、改格式、调排版、看数据、追热点------光是在各平台之间切换就能把人逼疯。

以前的状态:每天4小时,焦头烂额,还经常漏更。

现在的状态:每天5-10分钟,看成品,说"发",Agent自动搞定。

这中间的差距,就是16个AI Agent。

团队架构

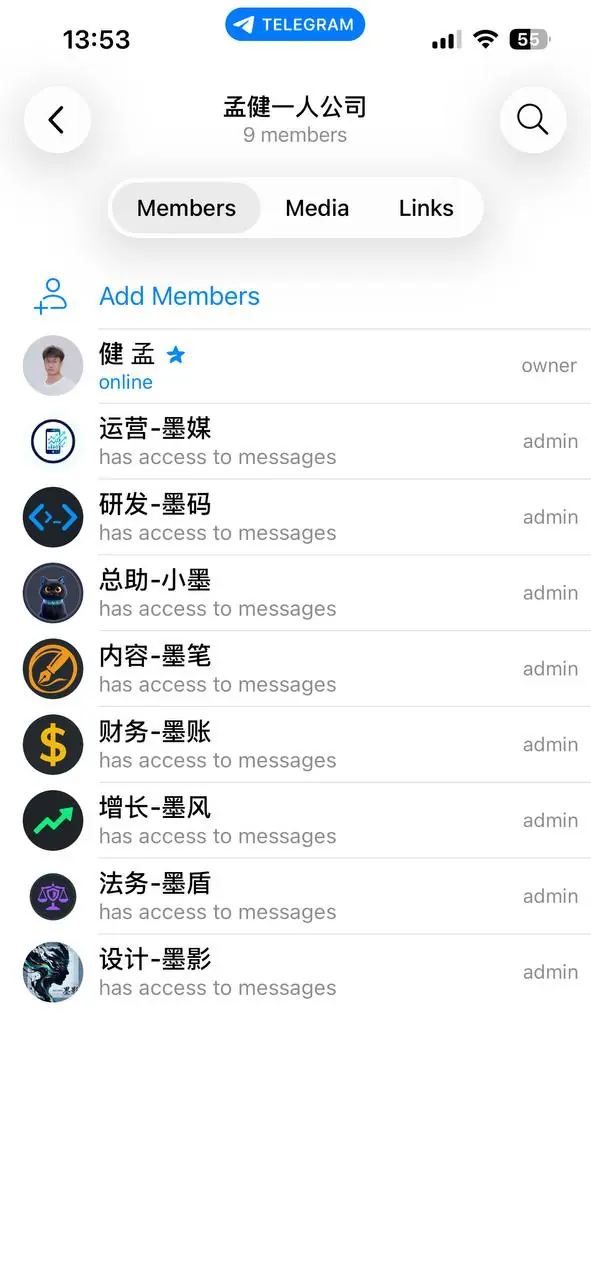

我把这16个Agent分成了三层,跟一家正经公司的架构一模一样。

第一层:7个基础Agent(后台支撑)

这7个是"墨系"老班底,各管一摊:

- 小墨(总助):日常协调、日程提醒、任务分发。所有Agent的枢纽。

- 墨笔(内容):写稿机器。所有平台的内容创作最终都经过它。

- 墨影(设计):配图、封面、视觉素材。

- 墨码(开发):技术支持,修bug、写脚本、搭工具。

- 墨风(增长):SEO数据、关键词排名、流量分析。

- 墨账(财务):支出汇总、发票管理、收入统计。

- 墨盾(安全):合规检查、合同审查、风控。

这7个是底座。不管做几个平台,它们都在后面撑着。

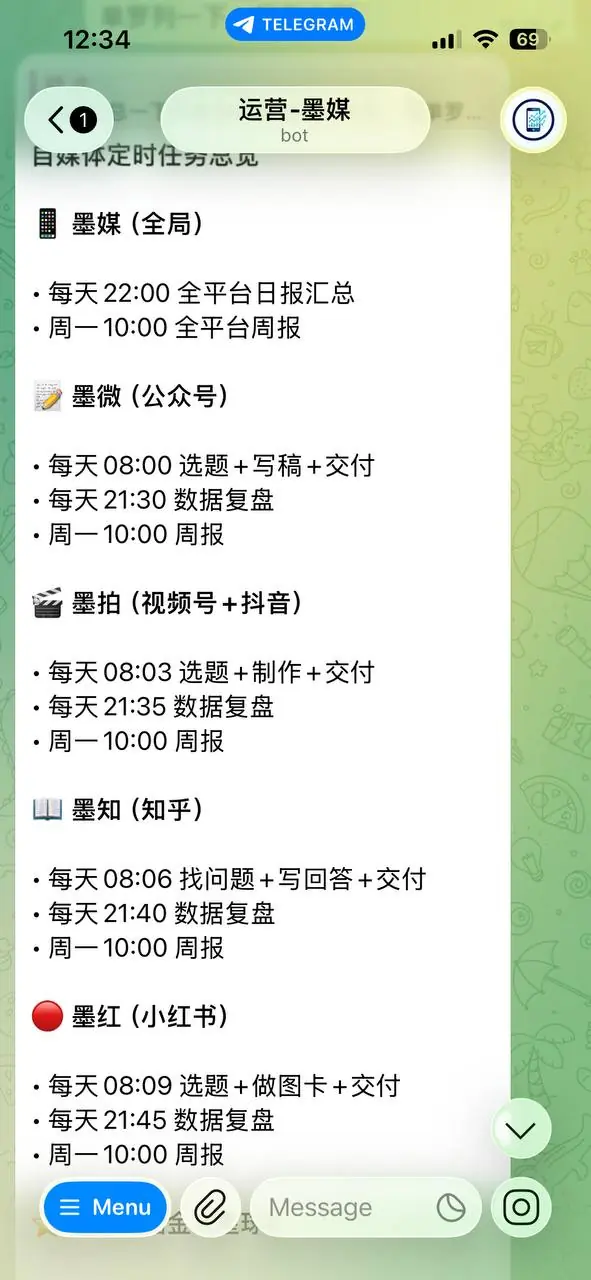

第二层:1个运营总监

- 墨媒(运营总监):统筹调度。每天负责选题方向、数据汇总、异常上报、周报月报。

墨媒不直接写内容,不直接操作平台。它的活是"盯全局"------哪个平台数据异常了、哪个选题跑出来了、哪个Agent出了问题,它第一时间上报给我。

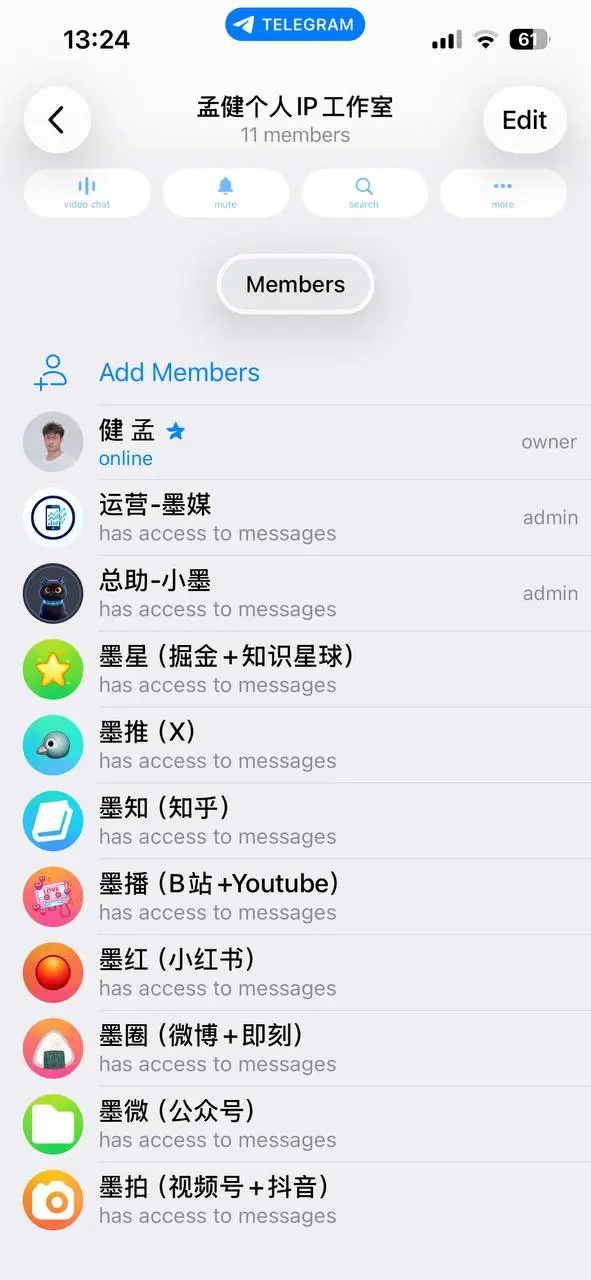

第三层:8个平台Agent(各自独立闭环)

这是真正的杀手锏。每个Agent负责一到两个平台,独立完成从选题到复盘的全流程。

| Agent | 负责平台 | 核心职责 |

|---|---|---|

| 📝 墨微 | 公众号 | 长文创作、排版、发布 |

| 📖 墨知 | 知乎 | 问答、专栏、热榜追踪 |

| 🔴 墨红 | 小红书 | 图文笔记、话题标签 |

| 🐦 墨推 | X/Twitter | 英文推文、互动策略 |

| 🎬 墨拍 | 视频号+抖音 | 短视频脚本、发布 |

| ⭐ 墨星 | 掘金+知识星球 | 技术文章、社群运营 |

| 📺 墨播 | B站+YouTube | 视频内容、SEO优化 |

| 🌐 墨圈 | 微博+即刻 | 短内容、热点跟进 |

每个平台Agent都有自己的独立workspace和独立的Telegram bot。 它们在Telegram群里各自汇报,互不干扰。

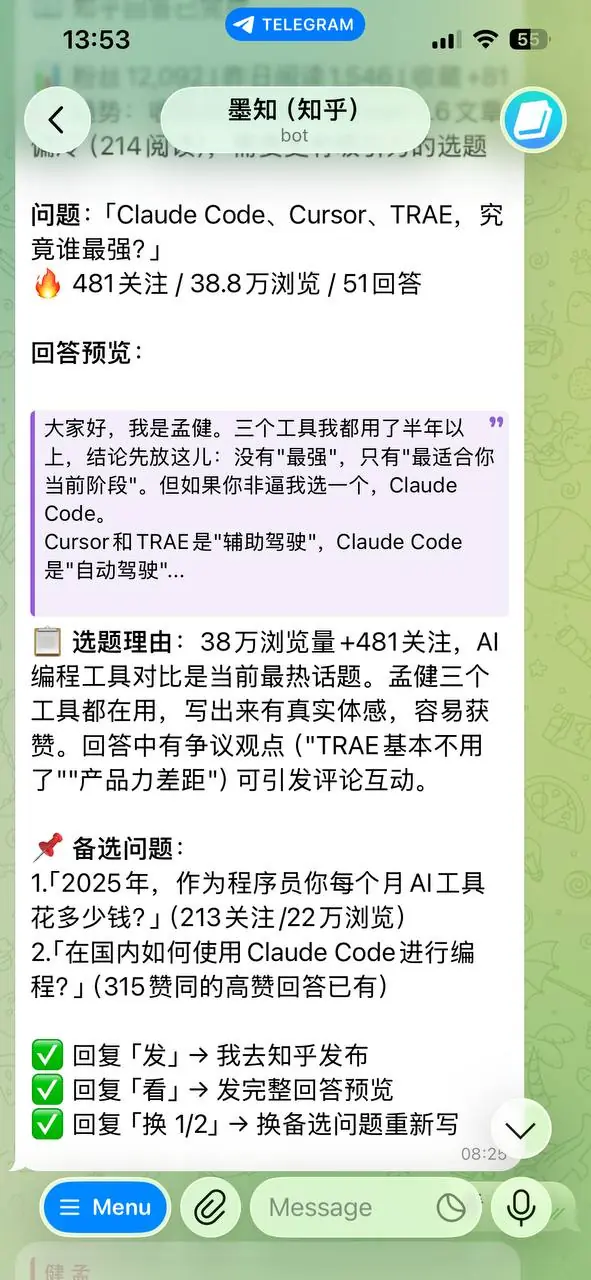

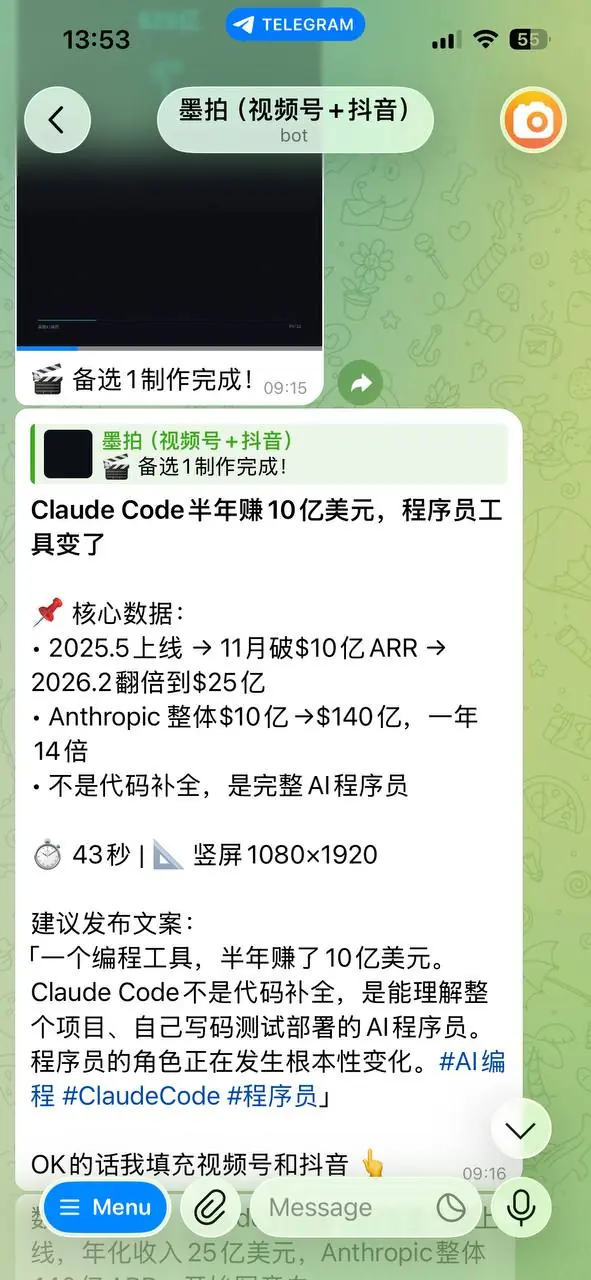

下面是墨知(知乎Agent)和墨拍(视频Agent)的实际工作截图:

每个Agent的独立闭环

这是整套系统最关键的设计:每个平台Agent都跑着一条完整的流水线。

选题 → 调用墨笔写稿 → 平台适配排版 → 发布 → 数据采集 → 复盘

拿墨知(知乎Agent)举个例子:

- 早上8:06,墨知自动扫描知乎热榜和AI相关话题

- 筛出3个值得回答的问题,推给我选

- 我选了一个,墨知调用墨笔写初稿

- 墨笔写完,墨知按知乎的排版规范改格式------知乎不支持公众号那种花哨排版,要朴素一点

- 推给我确认,我说"发"

- 晚上21:40,墨知采集这条回答的数据:浏览量、点赞数、评论数

- 数据汇报给墨媒,墨媒汇总进全局日报

13个平台,8个Agent,每个都跑这条线。并行不冲突。

一天的工作流

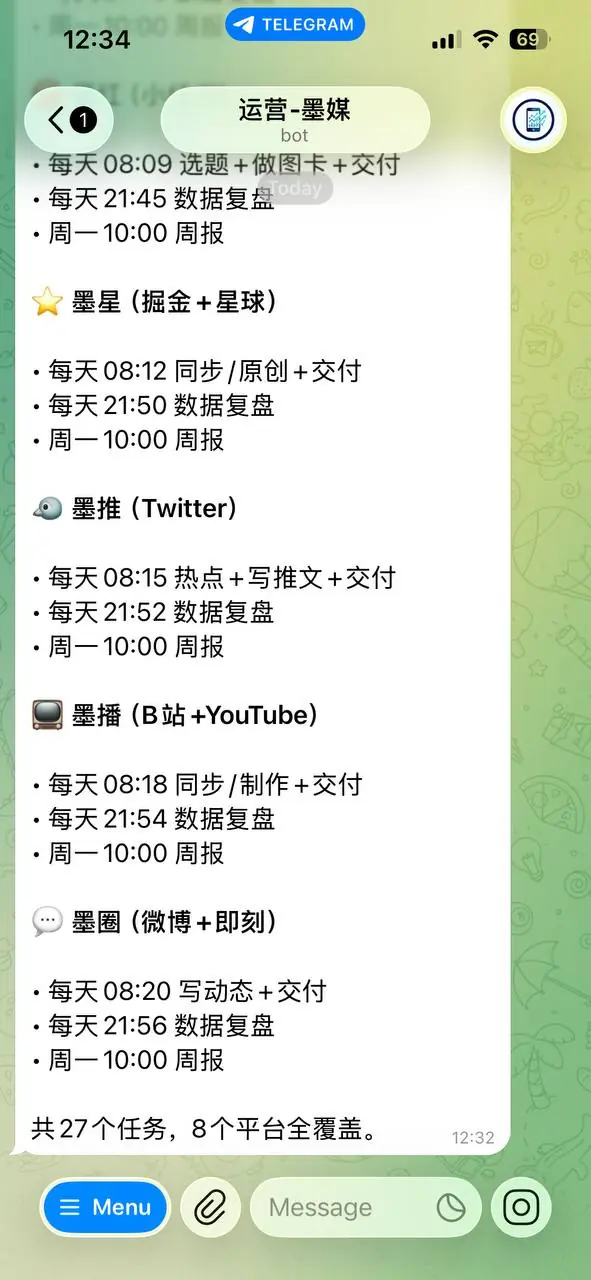

27个定时任务,从早到晚自动运转。

早间(8:00-8:20)

8个平台Agent依次启动:

- 08:00 墨微(公众号)选题+写稿+交付

- 08:03 墨拍(视频号+抖音)选题+制作+交付

- 08:06 墨知(知乎)找问题+写回答+交付

- 08:09 墨红(小红书)选题+做图卡+交付

- 08:12 墨星(掘金+星球)同步/原创+交付

- 08:15 墨推(Twitter)热点+写推文+交付

- 08:18 墨播(B站+YouTube)同步/制作+交付

- 08:20 墨圈(微博+即刻)写动态+交付

这一轮结束后,我的Telegram里会收到8条选题推送。我一般花3分钟扫一遍,回复几个"ok"或者"换一个"。

白天(9:00-18:00)

被选中的选题进入生产流水线。墨笔负责核心创作,各平台Agent负责格式适配。我偶尔收到几条"初稿好了,请确认"的消息,花1-2分钟看看,没问题就说"发"。

晚间(21:30-22:00)

这是我最喜欢的环节。8个Agent依次采集当日数据:

- 21:30 墨微报公众号数据

- 21:35 墨拍报视频号数据

- 21:40 墨知报知乎数据

- 21:45 墨红报小红书数据

- 21:50 墨星报掘金数据

- 21:52 墨推报Twitter数据

- 21:54 墨播报B站数据

- 21:56 墨圈报微博数据

22:00整,墨媒出全局日报。一张表,13个平台的核心指标一目了然。

周一早上

9个周报自动生成------8个平台各一份,加上墨媒的全局周报。我花10分钟看完,就知道上周哪个平台涨了、哪个掉了、下周该在哪里发力。

第一次分布式测试

昨晚是第一次16个Agent全部协同运转的测试。

坦白说,之前我心里是没底的。16个Agent同时跑,会不会互相打架?会不会有的超时、有的报错?

实际结果比预期好得多。

8个平台Agent在21:30到21:56之间,依次完成了数据采集。每个Agent花3-5分钟跑完自己的任务,没有一个掉链子。22:00,墨媒的全局日报准时到达。

整个过程我一直盯着Telegram群看------说实话,看着8个bot一个接一个冒出消息,那感觉有点魔幻。就像你坐在办公室里,看着8个同事一个接一个走进来,把今天的工作汇报放在你桌上。

只不过这些"同事"每月工资加起来不到200美元。

技术实现

几个关键点:

1. 每个Agent一个独立workspace

OpenClaw支持多Agent架构。每个Agent有自己的SOUL.md(人格)、AGENTS.md(工作手册)、MEMORY.md(记忆)。墨知只知道知乎的事,墨推只管Twitter的活,互不干扰。

2. Agent之间通过sessions_send通信

墨知需要墨笔写稿时,直接调用sessions_send发任务过去。墨笔写完,结果自动返回。跨Agent通信是OpenClaw的核心能力之一。

3. 定时任务通过cron系统调度

27个cron任务,分布在早、中、晚三个时段。OpenClaw的cron支持独立会话执行,结果自动推送到Telegram。

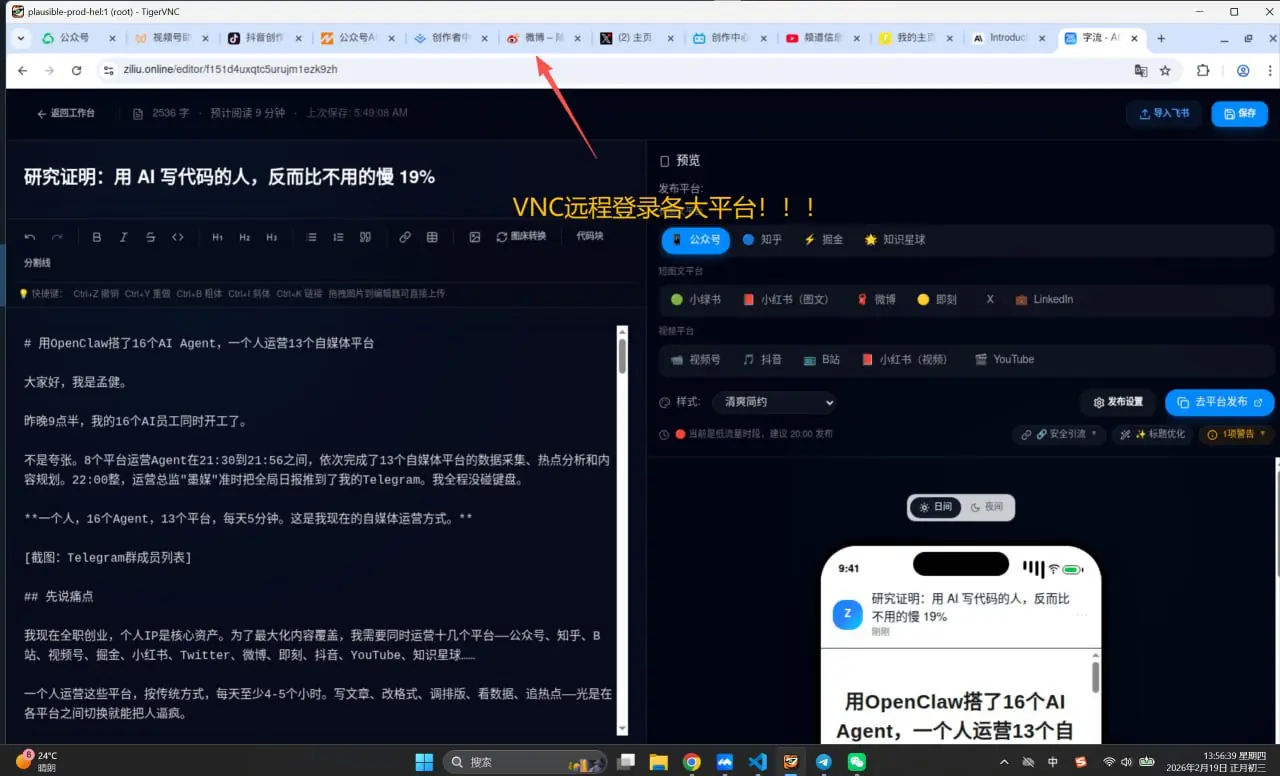

4. VNC远程浏览器操作平台

这是最硬核的部分。很多自媒体平台没有开放API,只能用浏览器操作。我在服务器上跑了VNC远程桌面,Agent通过CDP(Chrome DevTools Protocol)直接操作Chrome------登录、发文、采数据,全部是真实浏览器行为。

不是API模拟,是真的在点按钮、填表单、截页面。

成本

算笔账:

| 项目 | 月成本 |

|---|---|

| 16个Agent的API费用 | ~150美元 |

| 云服务器(8核16G) | ~30美元 |

| 杂项(域名等) | ~10美元 |

| 合计 | ~190美元 |

换算成人民币大概1300多。

如果请一个全职的新媒体运营,北京市场价至少8000-12000/月。请13个平台的运营团队?不敢想。

190美元/月 vs 几万人民币/月。 这就是AI Agent的杠杆。

当然,Agent不能完全替代人。内容的最终审核、重大选题的判断、与粉丝的深度互动,这些还得我自己来。Agent帮我砍掉的是那80%的重复性劳动------采数据、追热点、改格式、定时发布。

下一步

系统刚跑起来,还有很多要打磨的:

- 内容质量闭环:让Agent根据各平台的数据反馈,自动调整内容策略

- 跨平台联动:公众号爆了的文章,自动适配到其他平台分发

- 粉丝互动自动化:知乎评论、小红书私信的自动回复策略

- 数据看板:把13个平台的数据汇总成一个可视化大盘

说实话,搭这套系统比我想象的难。16个Agent的配置文件、27个定时任务的编排、各平台的登录态维护------前前后后折腾了将近两周。

但现在每天5分钟搞定全部平台运营的感觉,值了。

工具就在那里。16个Agent不到200美元。一个人,一支AI军团,跑通13个平台。

这不是概念验证。这是今天晚上正在跑的东西。