人机互助新时代超级个体(OPC)的学术述评

------基于人文学科与数理学科的双重视域

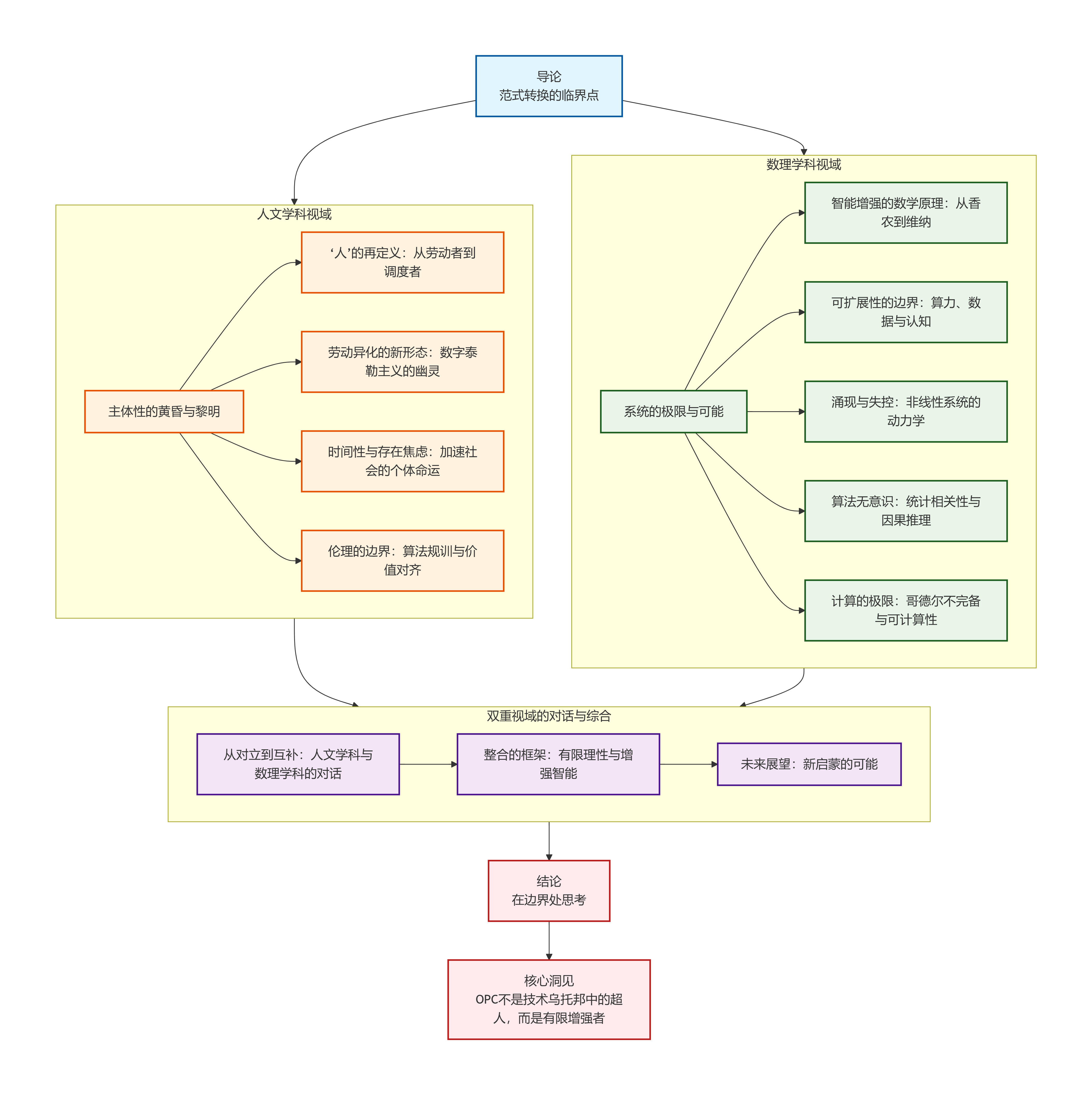

**摘要:**本文从人文学科与数理学科的双重视域探讨了"超级个体"(OPC)现象。人文学科视角揭示了AI赋能下主体性重构、数字泰勒主义异化、加速社会焦虑等深层问题;数理学科视角分析了信息处理原理、系统可扩展性边界、非线性风险等技术约束。研究指出,真正的"超级个体"应是既善用AI扩展能力,又清醒认识其边界,在人类有限理性与算法系统间保持平衡的"增强主体"。这种人机协同新范式既是技术机遇,也带来主体性危机,需要批判性思考与技术边界的清醒认知。研究为理解人机互助新时代提供了跨学科分析框架。

导论:范式转换的临界点

当大语言模型通过图灵测试的余波尚未平息,当生成式AI以月为单位迭代进化,一个根本性的追问浮出水面:人类与智能机器的关系将走向何方?"超级个体"(OPC, One-Person Company)------即借助AI赋能实现"单人成军"的新型创业范式------正是这一追问在实践领域的集中呈现。从北京中关村的AI北纬社区到上海临港的"超级个体288行动",从萨希尔·拉文吉亚的Gumroad神话到无数知识付费博主兜售的"AI副业课",OPC已不仅是技术现象,更成为折射时代精神的文化符号。

然而,热潮之下,鲜有人从学术高度对这一范式进行系统审视。本文试图填补这一空白,从人文学科与数理学科的双重视域出发,对OPC现象进行犀利的学术述评。这不是对技术进步的简单讴歌,也不是对人文忧患的肤浅重复,而是试图在两种知识范式的对话中,揭示OPC背后的深层逻辑与根本悖论。

人文学科视域关注的是意义、价值与存在------OPC如何重塑人的主体性?技术赋能的同时是否伴随着异化的新形态?数理学科视域关注的是系统、算法与效率------OPC背后的计算原理是什么?可扩展性的边界在哪里?两种视域的交汇处,或许正是理解人机互助新时代的关键入口。

一、人文学科视域:主体性的黄昏与黎明

1.1 "人"的再定义:从劳动者到调度者

在OPC的叙事中,最引人注目的转变是人的角色的根本性重构。传统的创业者是"劳动者"------亲力亲为地完成产品设计、代码编写、市场推广;而AI赋能的超级个体则日益成为"调度者"------其核心能力不再是对具体技能的掌握,而是对AI工具的组合运用与任务分解。

这一转变看似解放了人的创造力,实则暗含深刻的哲学追问:当知识工作被分解为可以由AI执行的"任务",当创意的实现依赖于对提示词(prompt)的精心设计,人的独特性究竟何在?法国哲学家斯蒂格勒(Bernard Stiegler)曾提出"技术药学"的概念------技术既是毒药,也是解药。AI工具赋予个体前所未有的生产力,却也可能侵蚀使人成其为人的那些能力:深度思考、批判性判断、创造性直觉。

BCG的研究显示,配备GPT-4的咨询顾问完成任务的数量增加12%、速度提高25%。但研究者同时警示,长期依赖AI可能导致"自动化偏见"------过度信任机器输出,放弃独立判断。在OPC视域下,这一警示具有存在论的意义:当人将自己的认知功能外包给机器,主体性的边界何在?我们是在使用工具,还是正在被工具重塑?

1.2 劳动异化的新形态:数字泰勒主义的幽灵

马克思在《1844年经济学哲学手稿》中提出的"异化劳动"概念在OPC时代获得新的表现形式。传统工业化时代的异化体现为工人与劳动产品的分离;数字时代的异化则体现为认知过程本身的碎片化与外包化。

AI工具将复杂的创造性工作分解为可标准化的"任务单元"------写一封邮件、生成一段代码、绘制一幅插图。OPC创业者的工作日益变成对这些任务单元的"调度",而非创造本身。这正是数字泰勒主义的本质:将知识工作纳入可测量、可优化、可替代的轨道。当创造本身被标准化,人的劳动价值何在?

更深刻的危机在于,AI系统本身成为"劳动产品"的主人。创业者使用Midjourney生成的图像、使用ChatGPT或DeepSeek等AI大模型撰写的文案,其版权归属、价值分配仍处于法律与伦理的灰色地带。当劳动产品脱离劳动者的控制,当价值的创造与分配日益不对称,异化的幽灵正在数字时代悄然复活。

1.3 时间性与存在焦虑:加速社会的个体命运

德国哲学家罗萨(Hartmut Rosa)提出"社会加速"理论,指出现代性的核心特征是时间结构的加速------技术加速、社会变迁加速、生活节奏加速。OPC现象既是加速的产物,也是加速的推手。

AI工具使个体能够以前所未有的速度完成工作------3万行市场数据的清洗从8小时压缩至11分钟,一个App的MVP从2个月缩短至1周。但速度的提升并未带来从容,反而催生了新的存在焦虑:当每个人都在以"AI速度"奔跑,停下来的代价是什么?当信息半衰期以小时计算,深度思考空间何在?

海德格尔在《存在与时间》中区分了"本真性"与"非本真性"的存在方式。非本真性的生存是"沉沦"于日常世界的操劳,是随波逐流地接受现成的意义。在OPC的语境中,"本真性"危机表现为:创业者究竟是听从内心的召唤从事创造,还是被AI副业神话裹挟着追逐风口?当"成为超级个体"本身成为一种社会期待,个体是否正在失去选择"不成为"的自由?

1.4 伦理的边界:算法规训与价值对齐

AI系统的"价值对齐"(value alignment)问题------如何确保AI的目标与人类价值观一致------在OPC层面呈现出新的复杂性。当个体将自己的决策权部分让渡给AI,当AI生成的内容直接面向市场,谁为输出的后果负责?

知识付费博主兜售的"AI变现课"中,伦理问题往往被简化为"合规问题"只要不违法即可。但更深层的伦理追问在于:AI生成的内容是否可能传播偏见?是否可能加剧信息茧房?是否可能侵蚀公共讨论的质量?当每个"超级个体"都在追求效率最大化,公共善(public good)的维度如何保障?

哈贝马斯的交往理性在此具有警示意义:真正的理性不是工具性的计算,而是主体间的对话与共识。在OPC的孤立化趋势中,对话的空间正在萎缩------个体与AI的对话取代了人与人的交往,效率逻辑取代了交往理性。这不仅是伦理问题,更是文明问题。

二、数理学科视域:系统的极限与可能

2.1 智能增强的数学原理:从香农到维纳

从信息论的角度看,AI赋能个体的本质是信息处理能力跃迁。香农(Claude Shannon)信息论奠定了数字通信的数学基础,而维纳(Norbert Wiener)控制论则将信息、反馈与目的性行为纳入统一框架。OPC现象的数学基础,正可以追溯至这一传统。

当个体使用AI工具处理信息时,实际上是在利用神经网络的高维映射能力------将输入(用户需求、市场数据)映射到输出(产品设计、营销文案)。从函数逼近论的角度看,大语言模型是在高维空间中学习复杂的概率分布;而从控制论的角度看,OPC创业者与AI系统构成一个"人-机闭环系统"------人的意图输入机器,机器的输出反馈给人,人再进行调整。

这一闭环效率取决于两个因素:AI模型表达能力(模型的容量与复杂度)与人机交互带宽(提示词的质量与迭代速度)。香农第二定理指出,信道容量决定信息传输的上限;类比而言,人机交互"认知带宽"------即人能够有效传达意图并理解机器反馈的能力------构成了OPC效率的根本约束。

2.2 可扩展性的边界:算力、数据与认知

OPC的核心承诺是"单人成军"------个体借助AI完成原本需要团队才能实现的任务。但从计算复杂性的角度看,这一承诺面临根本性的约束。

首先是算力约束。大语言模型的训练与推理消耗巨大的计算资源,虽然API服务使个体无需自建算力,但成本仍然是可扩展性的约束。当OPC的业务规模扩大,API调用次数呈线性增长,成本结构能否支撑可持续运营?这是经济学问题,也是算法优化问题。

其次是数据约束。AI模型的能力源于海量数据的训练,但个体的业务往往涉及垂直领域的特定知识。如何在通用模型基础上实现"领域适应"(domain adaptation)?需要多少垂直数据才能达到可接受的性能?这涉及迁移学习、小样本学习等前沿问题。

第三是认知约束。这是最根本的约束。人类的工作记忆容量有限------米勒(George Miller)经典研究指出,工作记忆的容量约为7±2个组块。AI可以无限扩展信息的处理能力,但人类对信息的吸收与整合存在生物学上限。当AI输出的信息,超出人的处理能力,当"AI速度",超越"人脑速度",人便从"调度者"沦为"瓶颈"。

2.3 涌现与失控:非线性系统的动力学

将AI系统与人类个体视为耦合系统,其行为可以用非线性动力学描述。从复杂系统理论的角度看,OPC现象涉及两个层面的涌现:

第一层是AI大模型本身的涌现能力------大语言模型在足够规模下展现出预训练中未明确出现的推理能力。第二层是人-机耦合系统的涌现------个体与AI的互动可能产生超出双方独立能力的新颖输出。

但涌现伴随着失控的风险。非线性系统的典型特征是初始条件的微小变化,可能被放大为结果的巨大差异------这正是"蝴蝶效应"。在OPC语境中,这意味着:一个不准确的提示词、一个有偏差的训练数据,可能被AI放大为严重的业务失误。而当多个OPC同时使用相似的AI工具,系统层面的"群体行为"可能出现意想不到的协同或冲突------这是复杂适应性系统的典型特征。

控制论创始人维纳在《人有人的用处》中早已警示:信息与控制的本质是"在熵增的世界中,局部地逆熵"。OPC的成功依赖于能否在复杂系统中维持局部秩序,而避免被系统的不确定性所吞噬。

2.4 算法无意识:统计相关性与因果推理

大型语言模型的核心机制是基于海量数据学习统计相关性------给定上文,预测下文。但相关性不等于因果性,这是统计学的基本洞见,也是AI系统的根本局限。

当OPC创业者依赖AI生成市场分析、产品策略时,AI的输出在本质上是基于训练数据中观察到的相关性模式。但是商业决策需要的是因果推理------这个营销策略会带来销售增长吗?那个产品特性会提升用户留存吗?相关性无法回答因果问题。

珀尔(Judea Pearl)的因果革命揭示了这一局限的深刻性。他区分了三个层级的认知能力:观察(seeing)、干预(doing)、想象(imagining)。当前的大型语言模型主要停留在"观察"层级------学习数据中关联模式;而真正的决策需要"干预"层级的能力------预测某种操作的结果;创新则需要"想象"层级的能力------构想未曾在数据中出现的新可能性。

OPC的核心悖论在于:创业者越是依赖AI的统计相关性输出,就越可能陷入"相关性陷阱"即将相关误认为因果,将历史模式误认为未来趋势。当所有人都在使用相似的AI工具学习相似的统计模式,市场的同质化与内卷便不可避免。

2.5 计算的极限:哥德尔不完备与可计算性

在最根本的层面,OPC现象触及计算的哲学边界。哥德尔不完备定理指出在任何足够强大的形式系统中,都存在既不能证明也不能证伪的命题。图灵停机问题则表明,不存在通用算法能够判定任意程序是否停机。

这些计算的极限对OPC具有深远的启示意义。AI系统本质上是形式系统的实现,它基于确定的算法处理符号。因此AI的能力受限于形式系统的边界:存在它无法解决的问题,存在它无法推理的真理。

当创业者将决策权让渡给AI,实际上是在将自己的命运交给一个本质上有限的形式系统。这不是对AI的否定,而是对其边界的清醒认知。真正的"超级个体"不是那些最善于使用AI工具的人而是那些理解AI边界、在边界之外保持人类判断的人。

三、双重视域的对话与综合

3.1 从对立到互补:人文学科与数理学科的对话

人文学科与数理学科对OPC的审视呈现出鲜明的对比:人文学科关注意义、价值、主体性的危机;数理学科关注系统、算法、可扩展性的边界。这两种视域看似对立,实则构成理解OPC现象的互补维度。

人文学科的批判揭示出:OPC的兴起,不仅是技术变革,更是人的存在方式的深刻转型。数理学科的约束则表明:这种转型并非无限可能,而是受到根本性的计算边界约束。两者的对话告诉我们:真正的"超级个体"不是技术乌托邦中无所不能的神话人物,而是在人类有限性与技术可能性之间寻求平衡的实践者。

3.2 整合的框架:有限理性与增强智能

西蒙(Herbert Simon)"有限理性"(bounded rationality)概念为整合双重视域提供了理论框架。西蒙指出,人类的决策不是完全理性的最优化过程,而是在认知资源约束下的"满意化"过程。AI的本质是扩展人类的信息处理能力------它不能消除有限理性,但可以改变有限理性的边界。

从这一视角看,OPC的核心挑战是:如何在增强智能(augmented intelligence)的框架下,实现人与机器的有效协同?这不是"谁取代谁"的问题而是"如何分工"的问题。人擅长什么?AI擅长什么?如何在各自的优势领域实现互补?

认知偏差的研究揭示了人的局限------自动化偏见、确认偏误、乐观偏见等。AI的研究揭示了算法的局限------统计相关性不能替代因果推理、形式系统的不可判定性。真正的智慧在于同时认识两种局限,并在局限之内做出最优的协同决策。

3.3 未来展望:新启蒙的可能

德国哲学家康德在《什么是启蒙》中提出,启蒙就是人类摆脱自我招致的未成熟状态,敢于运用自己的理性。在AI时代,启蒙获得了新的内涵:启蒙就是人类在技术赋能的同时保持对技术边界的清醒认知;就是既利用AI扩展自己的能力,又不将决策权完全让渡给算法。

从这个意义上说,OPC浪潮既是一场危机,也是一次机遇。危机在于它可能加剧人的异化、侵蚀公共生活、制造新的不平等;机遇在于,它可能催生一种新型的主体性------既非工业时代被动的劳动者,也非后现代碎片化的消费者,而是能够与技术协同、在技术边界之内保持自主性的"增强主体"。

这种新主体性的培育,需要人文学科的批判精神与数理学科的严谨思维。人文学科提供价值的罗盘,数理学科提供边界的测绘。两者结合或许能够指引我们穿越技术迷雾,抵达一个真正意义上的"人机互助新时代"。

结论:在边界处思考

本文从人文学科与数理学科的双重视域出发,对OPC现象进行了系统的学术述评。人文学科的视角揭示了主体性危机、劳动异化新形态、存在焦虑与伦理边界;数理学科的视角揭示了信息处理的基本原理、可扩展性的约束、非线性系统的风险与计算的哲学极限。

两种视域的交汇处,浮现出一个根本性的洞见:OPC不是技术乌托邦中无所不能的"超人"而是在人类认知局限与算法系统边界之间寻求平衡的"有限增强者"。真正的"超级个体",不是那些最善于使用AI工具的人,而是那些既懂得利用AI扩展能力,又清醒认识到AI边界、在边界之外保持人类判断的人。

在边界处思考,或许是AI时代最稀缺的品质。当技术以前所未有的速度重塑世界,当"AI副业月入十万"的神话裹挟着无数个体涌入OPC赛道,保持批判性反思的能力、保持对根本性的问题的追问、保持对技术边界的清醒认知,恰恰是人之为人的最后堡垒,也是人机互助新时代的真正起点。

参考文献

Stiegler, B. (1998). Technics and Time, 1: The Fault of Epimetheus. Stanford University Press.

Rosa, H. (2013). Social Acceleration: A New Theory of Modernity. Columbia University Press.

Heidegger, M. (1962). Being and Time. Harper & Row.

Habermas, J. (1984). The Theory of Communicative Action. Beacon Press.

Shannon, C. E. (1948). A mathematical theory of communication. Bell System Technical Journal, 27(3), 379--423.

Wiener, N. (1948). Cybernetics: Or Control and Communication in the Animal and the Machine. MIT Press.

Wiener, N. (1950). The Human Use of Human Beings. Houghton Mifflin.

Pearl, J., & Mackenzie, D. (2018). The Book of Why: The New Science of Cause and Effect. Basic Books.

Simon, H. A. (1957). Models of Man: Social and Rational. Wiley.

Kahneman, D. (2011). Thinking, Fast and Slow. Farrar, Straus and Giroux.

Tversky, A., & Kahneman, D. (1974). Judgment under uncertainty: Heuristics and biases. Science, 185(4157), 1124--1131.

Gödel, K. (1931). Über formal unentscheidbare Sätze der Principia Mathematica und verwandter Systeme I. Monatshefte für Mathematik und Physik, 38(1), 173--198.

Turing, A. M. (1936). On computable numbers, with an application to the Entscheidungsproblem. Proceedings of the London Mathematical Society, 42(1), 230--265.

Marx, K. (1844/1959). Economic and Philosophic Manuscripts of 1844. Progress Publishers.

Kant, I. (1784/1996). An answer to the question: What is enlightenment? In Practical Philosophy (pp. 11--22). Cambridge University Press.

Bostrom, N. (2014). Superintelligence: Paths, Dangers, Strategies. Oxford University Press.

Floridi, L. (2014). The Fourth Revolution: How the Infosphere is Reshaping Human Reality. Oxford University Press.

Harari, Y. N. (2016). Homo Deus: A Brief History of Tomorrow. Harvill Secker.

Zuboff, S. (2019). The Age of Surveillance Capitalism. PublicAffairs.

Brynjolfsson, E., & McAfee, A. (2014). The Second Machine Age. W. W. Norton & Company.