简介

延迟折扣任务(Delay Discounting Task, DDT) 是心理学和神经科学中用于研究个体对即时奖励与延迟奖励之间权衡偏好 的经典实验范式,常用于评估冲动性、自我控制能力以及相关神经机制(如多巴胺系统、前额叶皮层功能)。以下是其核心要点:

任务原理

-

核心矛盾 :人类和动物普遍存在"++即时满足偏好++"(即更倾向于选择较小的即时奖励,而非较大的延迟奖励)。

-

折扣率 :延迟奖励的主观价值会随时间推移而"折扣",++折扣率越高,个体越倾向于选择即时奖励++(冲动性越强)。有点类型利息率。

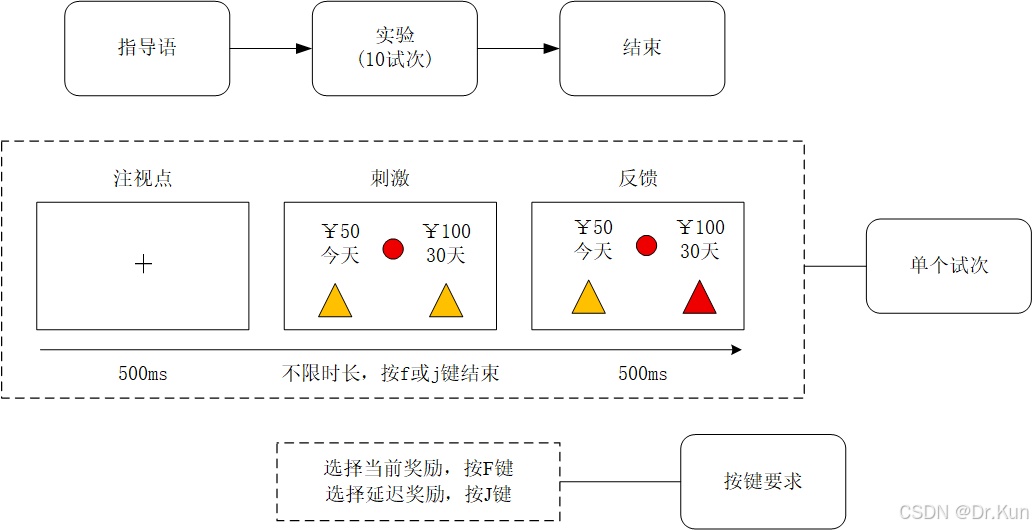

典型任务设计

-

选择场景:被试需在两个选项间反复选择:

-

选项A:较小的即时奖励(如"现在获得10元")。

-

选项B:较大的延迟奖励(如"1周后获得20元")。

-

-

变量操作:

-

延迟时间:从几分钟到数月不等。本实验内为30天。

-

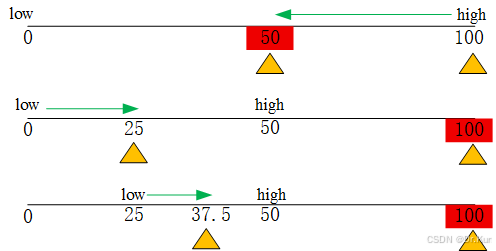

奖励大小 :通过调整即时/延迟奖励的金额,找到被试的**"无差异点"** (即两种选项主观价值相等的临界值)。本实验内固定延迟奖励为100,初始的当前奖励为50。使用动态调整即时奖励的方法,如:本轮的初始的即时奖励为50,30天后的延迟奖励100,选择延迟奖励,则下一轮即时奖励为75,延迟奖励为100,如果选择当前奖励,则再下一轮调整为即时奖励62.5,延迟奖励为100。一共进行10轮的选择。

-

-

计算指标:

-

折扣率(k值):通过数学模型(如双曲线折扣模型)量化个体对延迟的敏感度。

k = \\frac{(A / V - 1)} {D}

-

V:延迟奖励在当前的主观价值。

-

A:延迟奖励的客观金额。

-

D:延迟的时间(如天数、月数)。

-

k:延迟折扣率,即待求的关键参数。k值越大,表示个体对延迟奖励的贴现程度越高,行为越倾向于冲动,偏好即时小额奖励。

-

-

曲线下面积(AUC):反映整体延迟折扣倾向(AUC越小,折扣率越高)。

-

应用领域

-

临床心理学:

-

评估冲动相关障碍(如成瘾、注意力缺陷多动障碍、暴食症)。

-

研究物质滥用者对即时奖励的过度偏好。

-

-

神经科学:

-

探索前额叶皮层、腹侧纹状体等脑区在延迟折扣中的角色。

-

结合fMRI或EEG,观察决策时的神经活动模式。

-

-

行为经济学:

-

解释跨期选择偏差(如储蓄不足、过度消费)。

-

优化政策设计(如戒烟奖励计划、养老金方案)。

-

实验流程图

表格含义

procedure_conditions.xlsx

主要对应Procedures循环的状态信息。

|--------------------|--------|------------------|

| 列标 | 取值 | 含义 |

| procedure | trial | 实验阶段:trial(正式实验) |

| reward_today_start | 整数 | 即时奖励的初始值 |

| reward_delay | 整数 | 延迟奖励 |

| delay_days | 整数 | 延迟天数 |

| trail_repeats | 整数 | Trials的重复次数 |