本文讨论的内容参考自《神经网络与深度学习》https://nndl.github.io/ 第6章 循环神经网络

给网络增加记忆能力

延时神经网络

有外部输入的非线性自回归模型

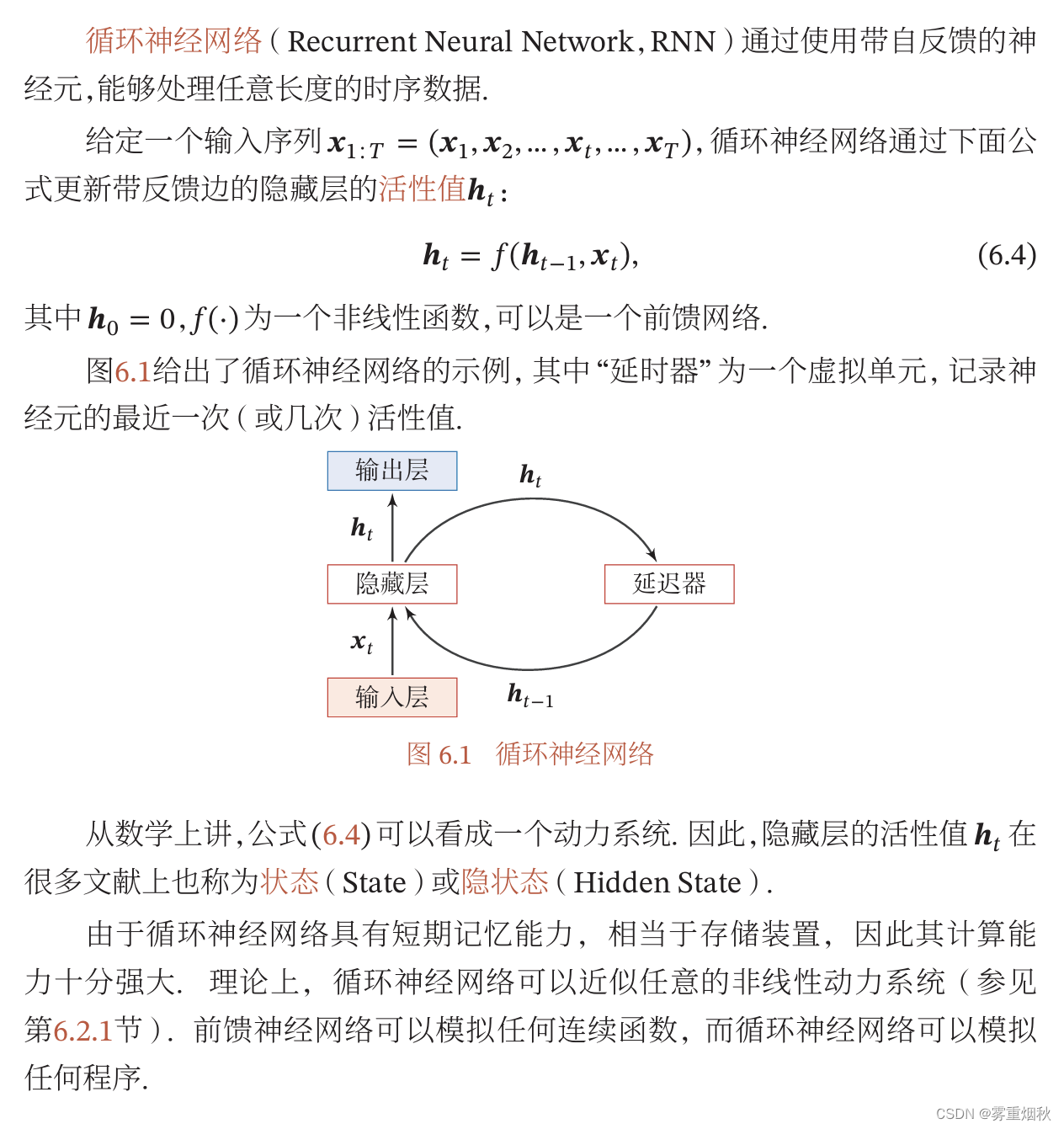

循环神经网络

简单循环网络

循环神经网络的计算能力

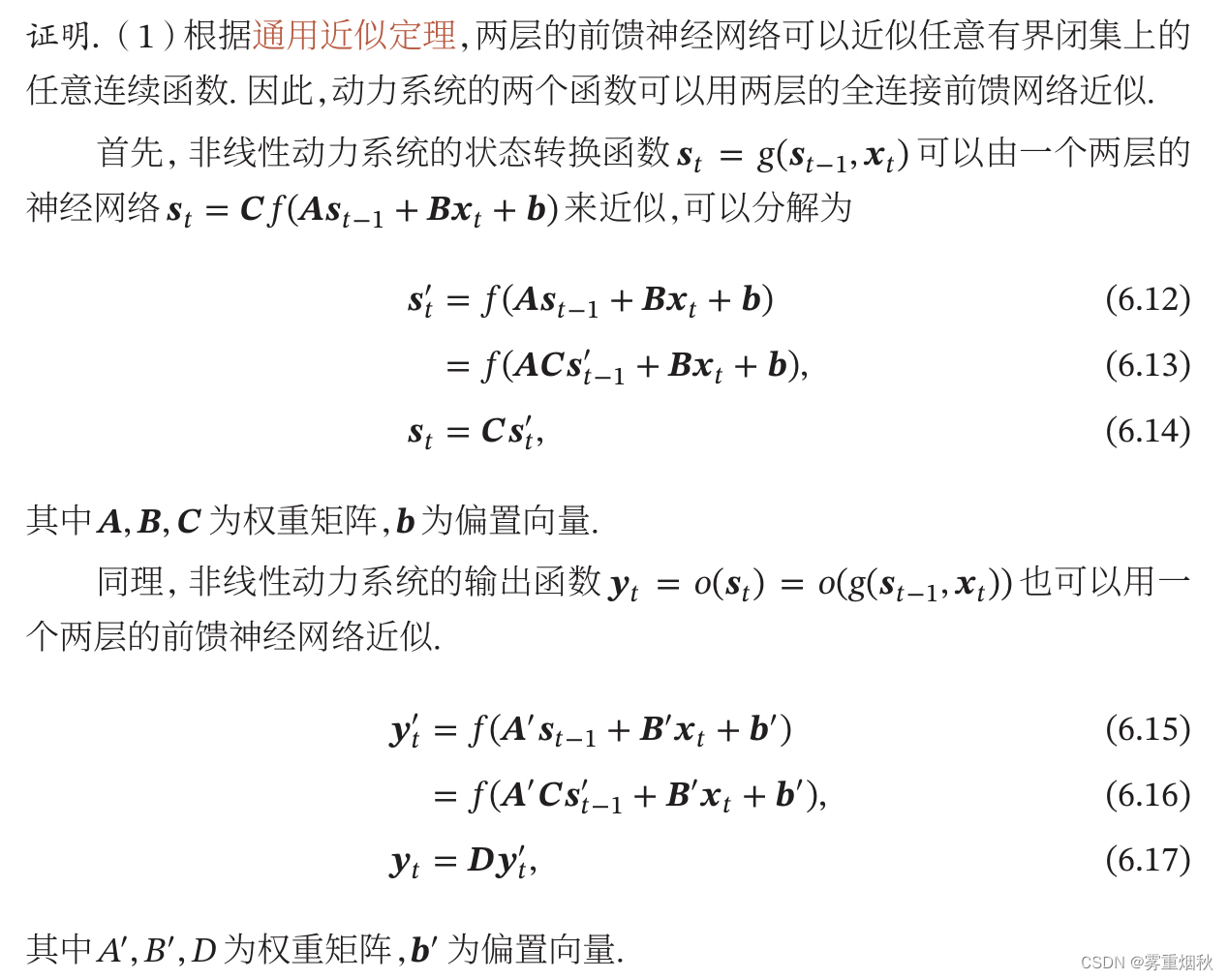

循环神经网络的通用近似定理

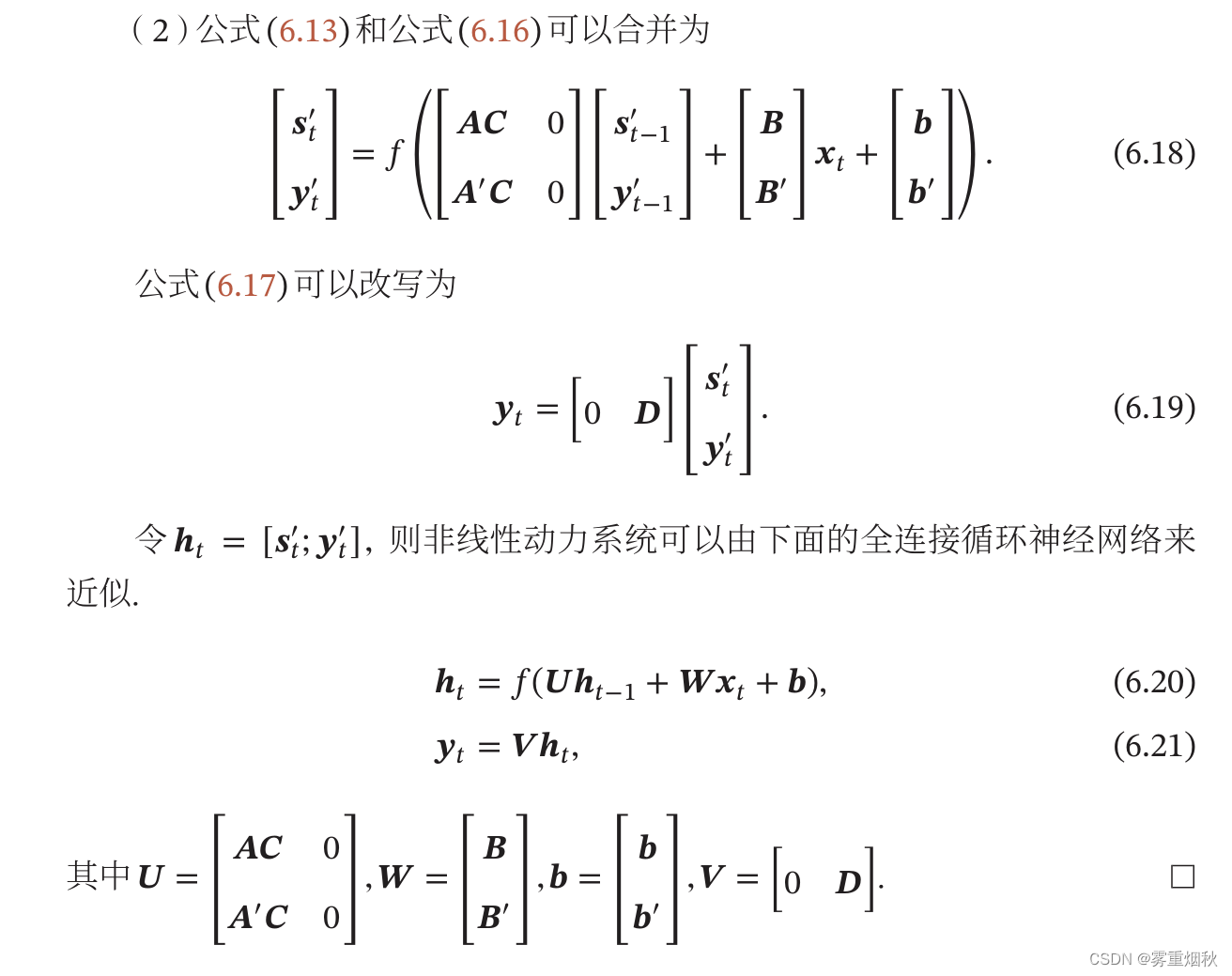

图灵完备

应用到机器学习

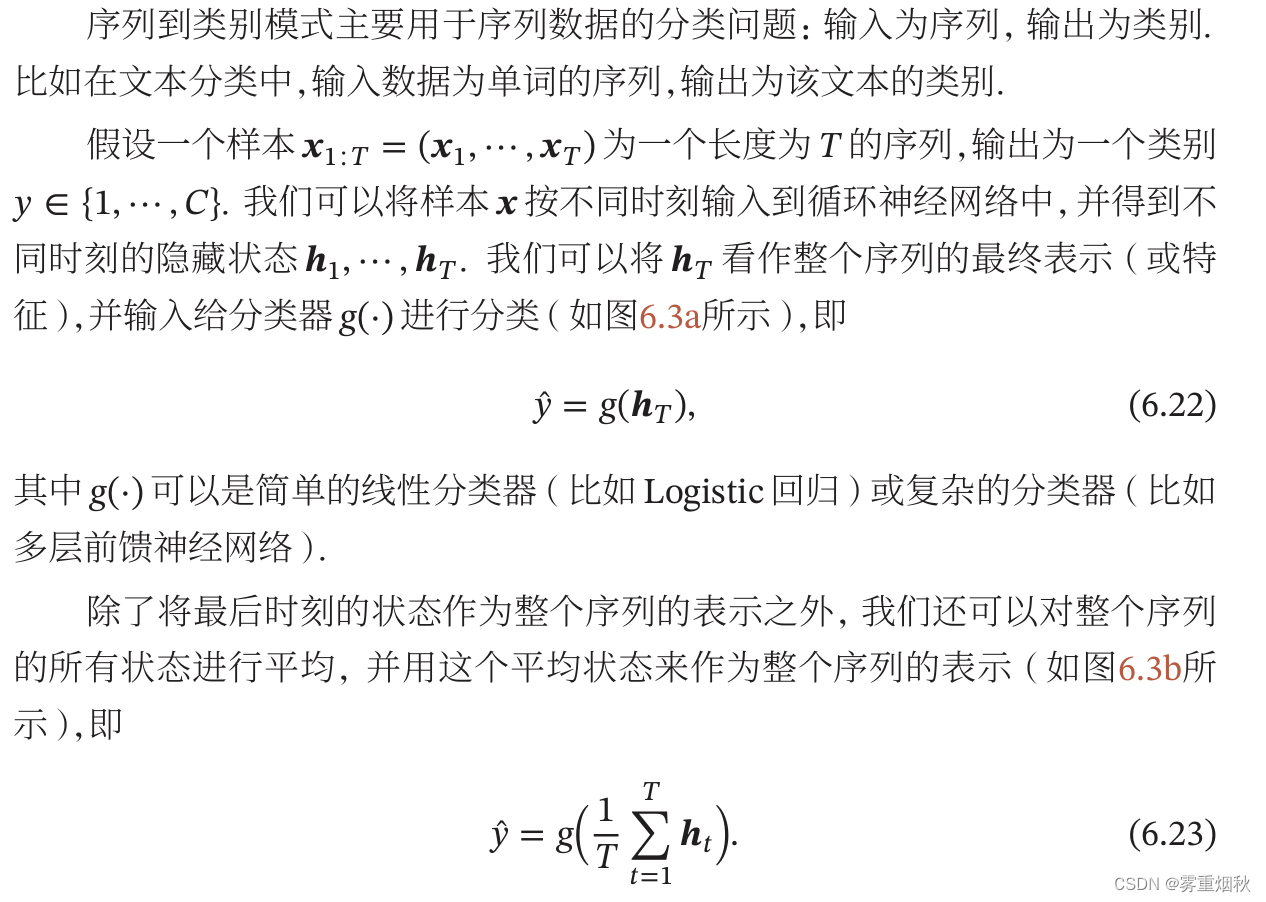

序列到类别模式

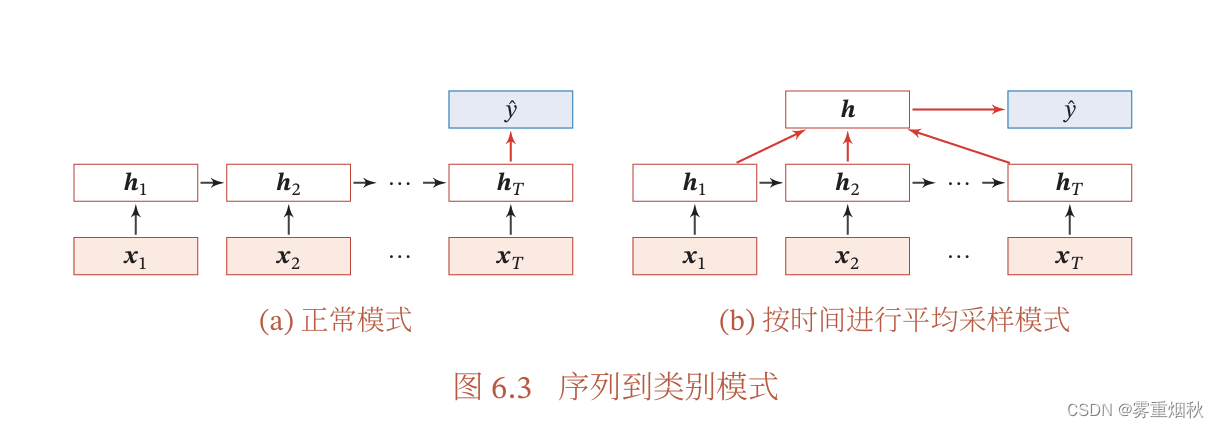

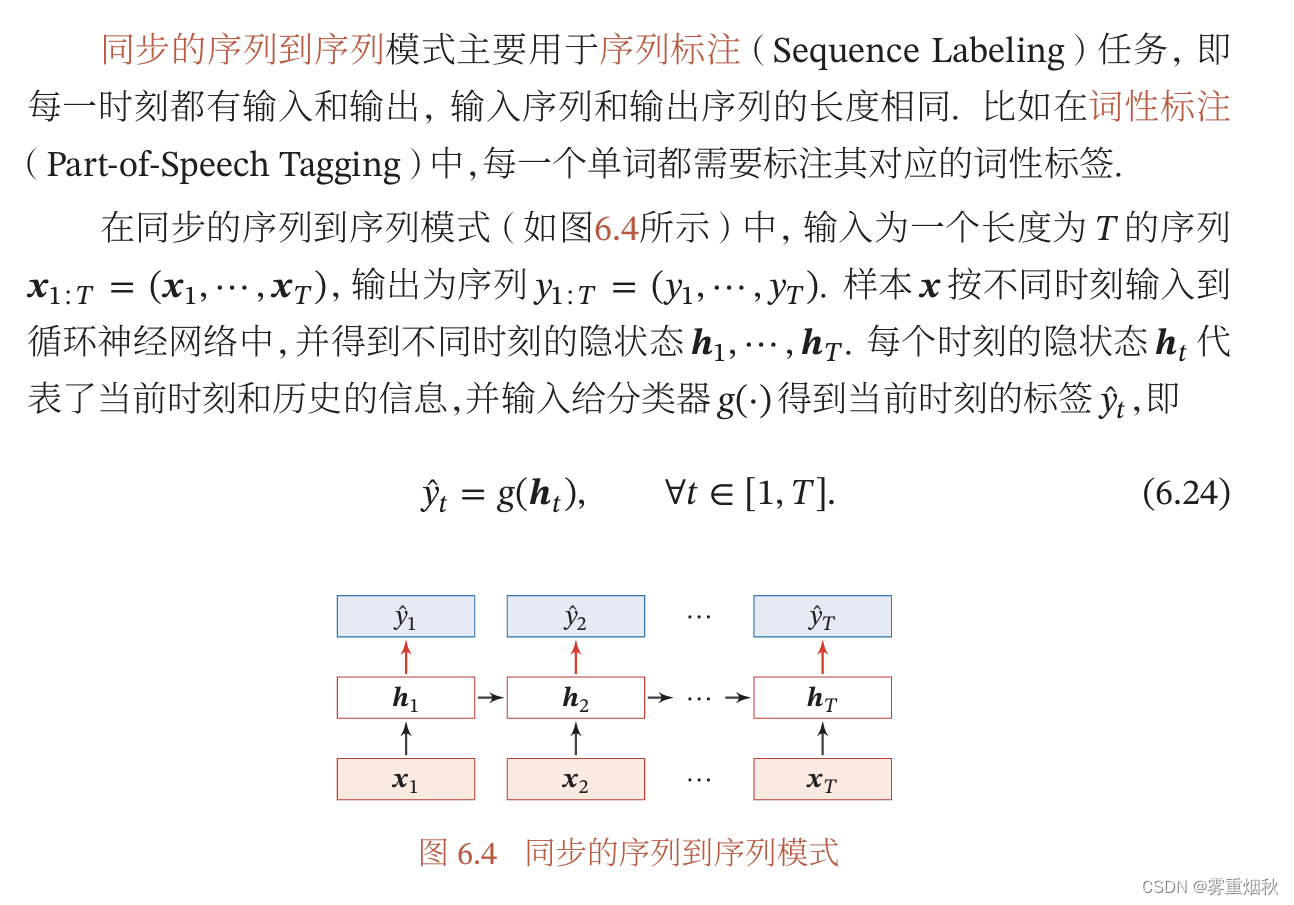

同步的序列到序列模式

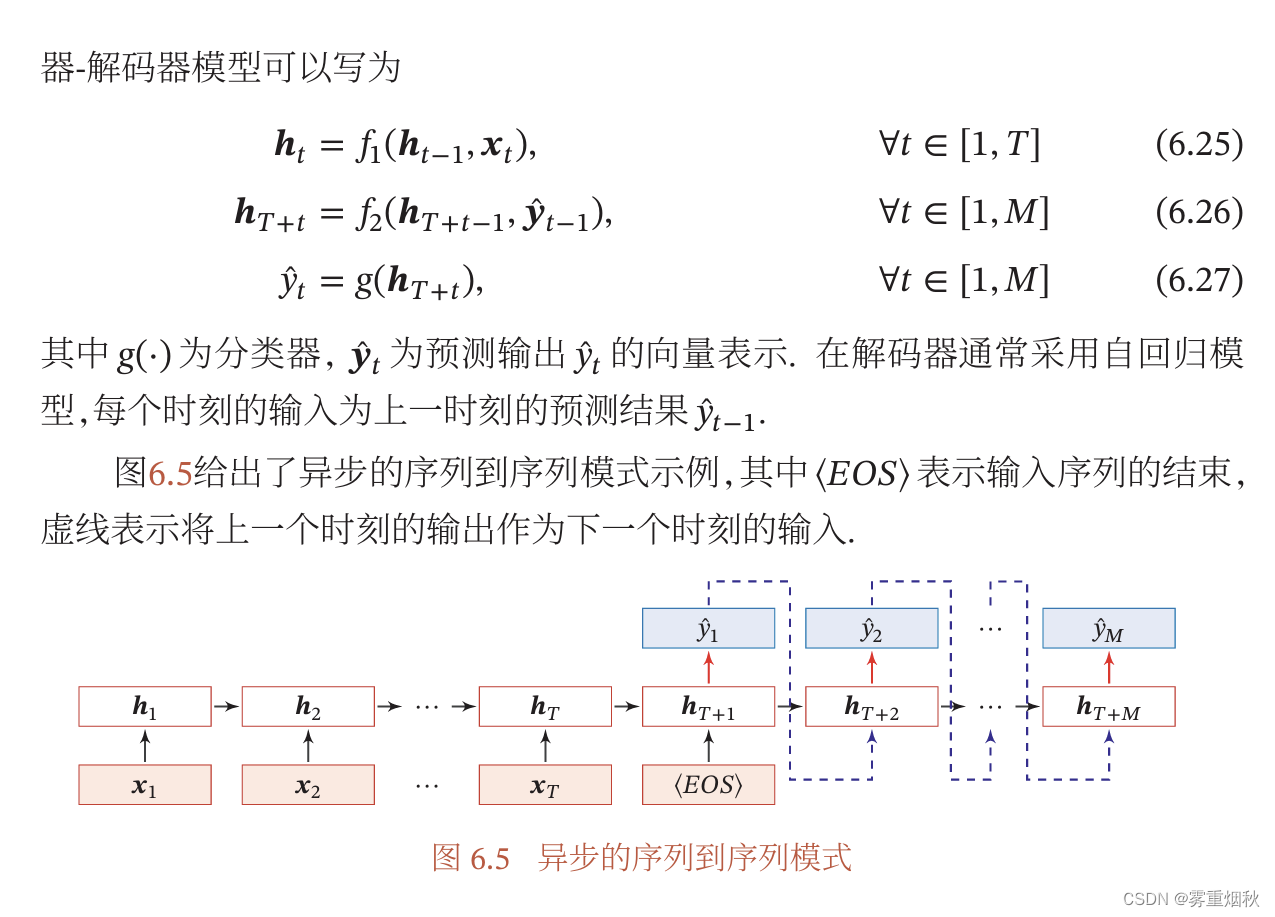

异步的序列到序列模式

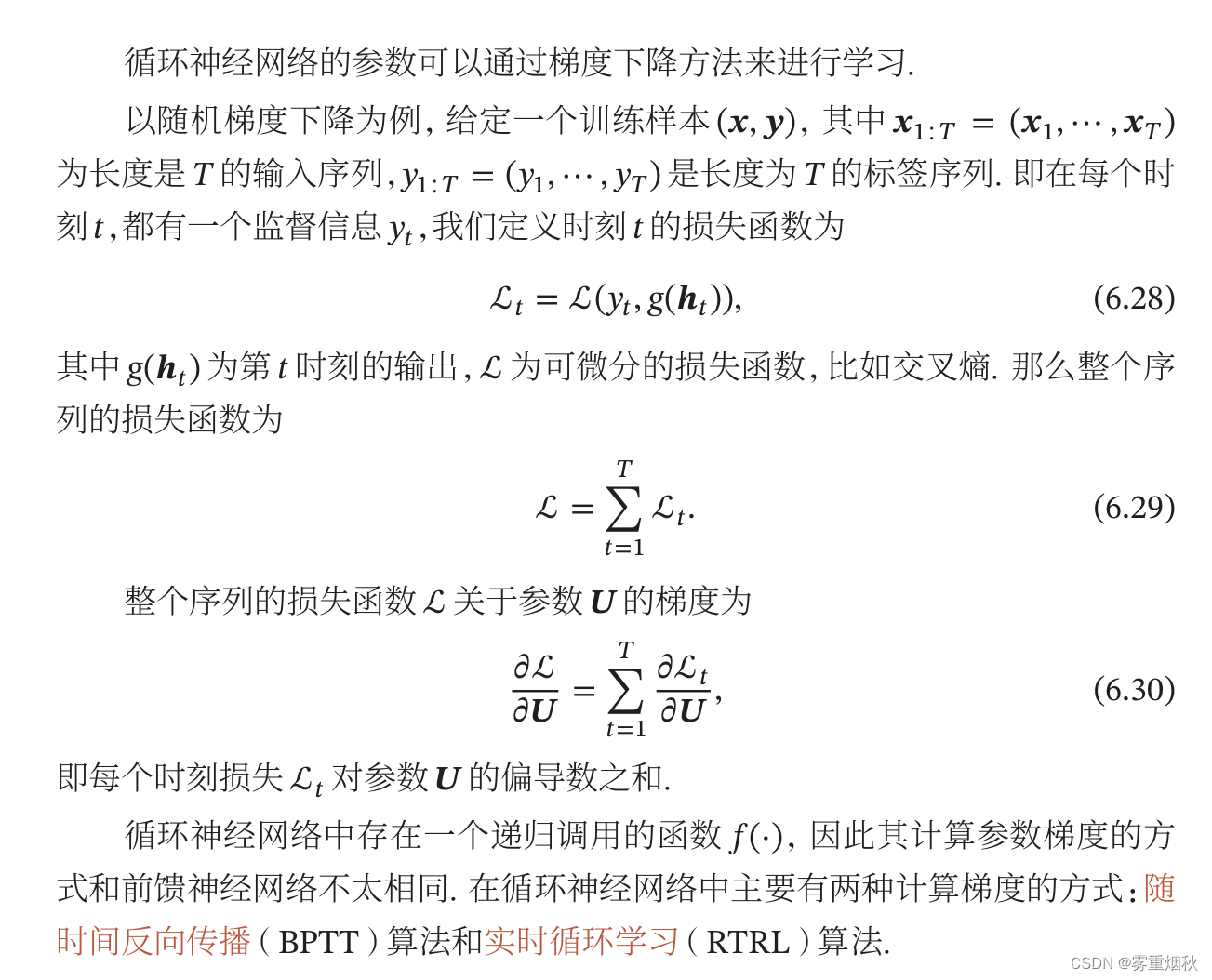

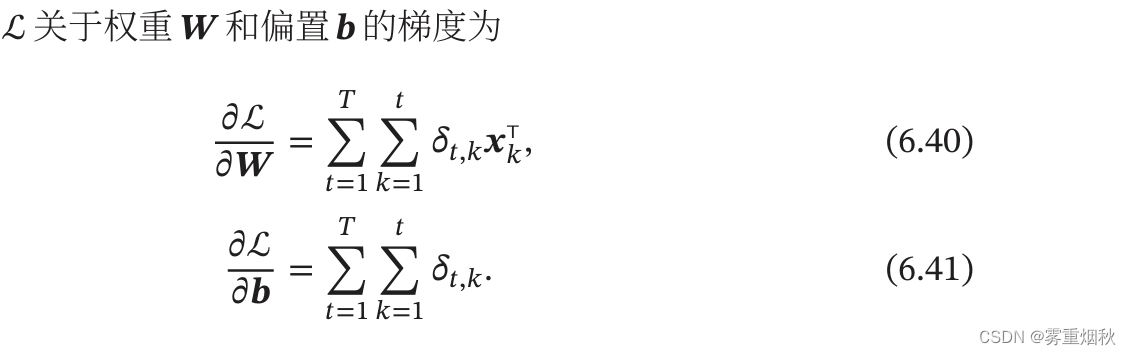

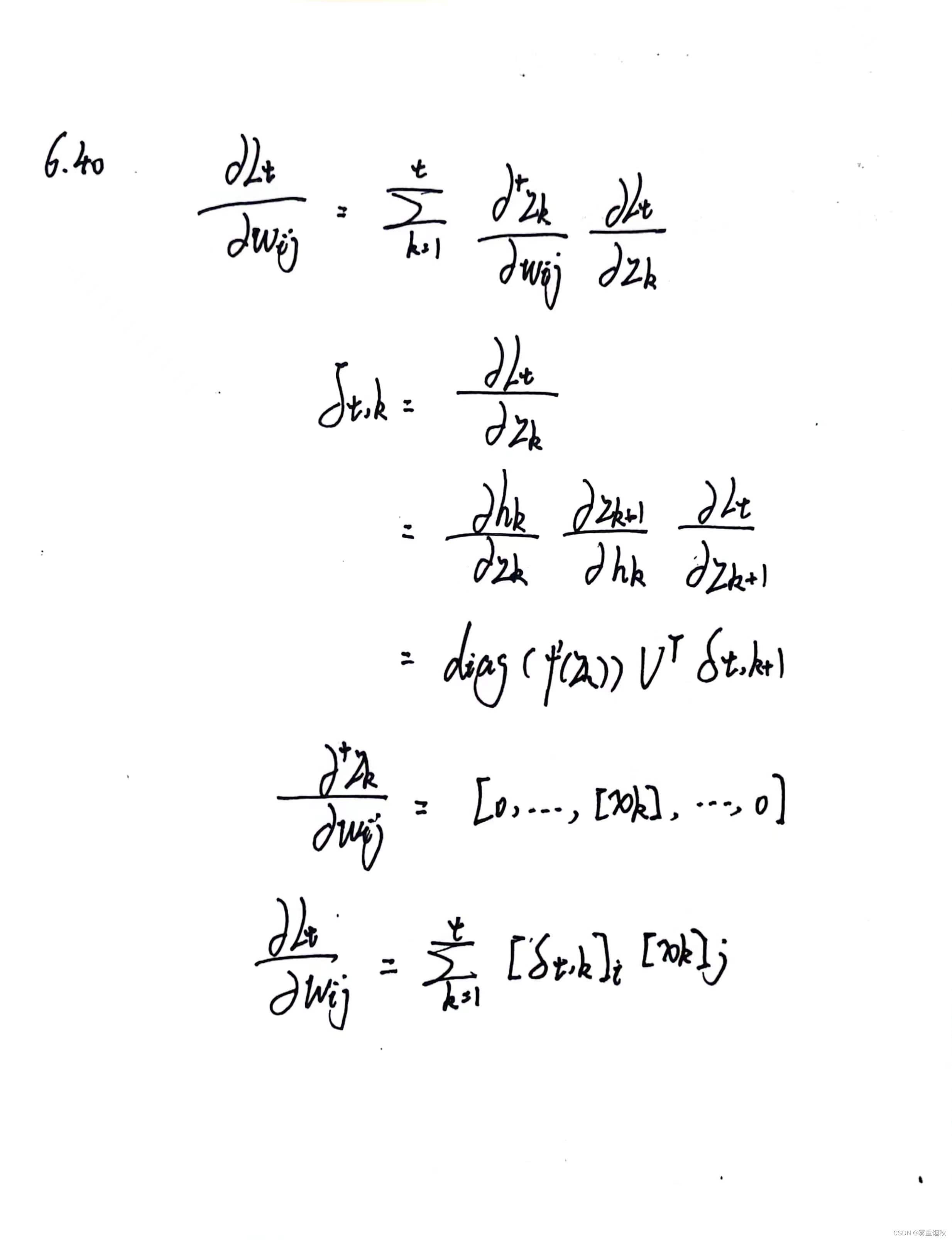

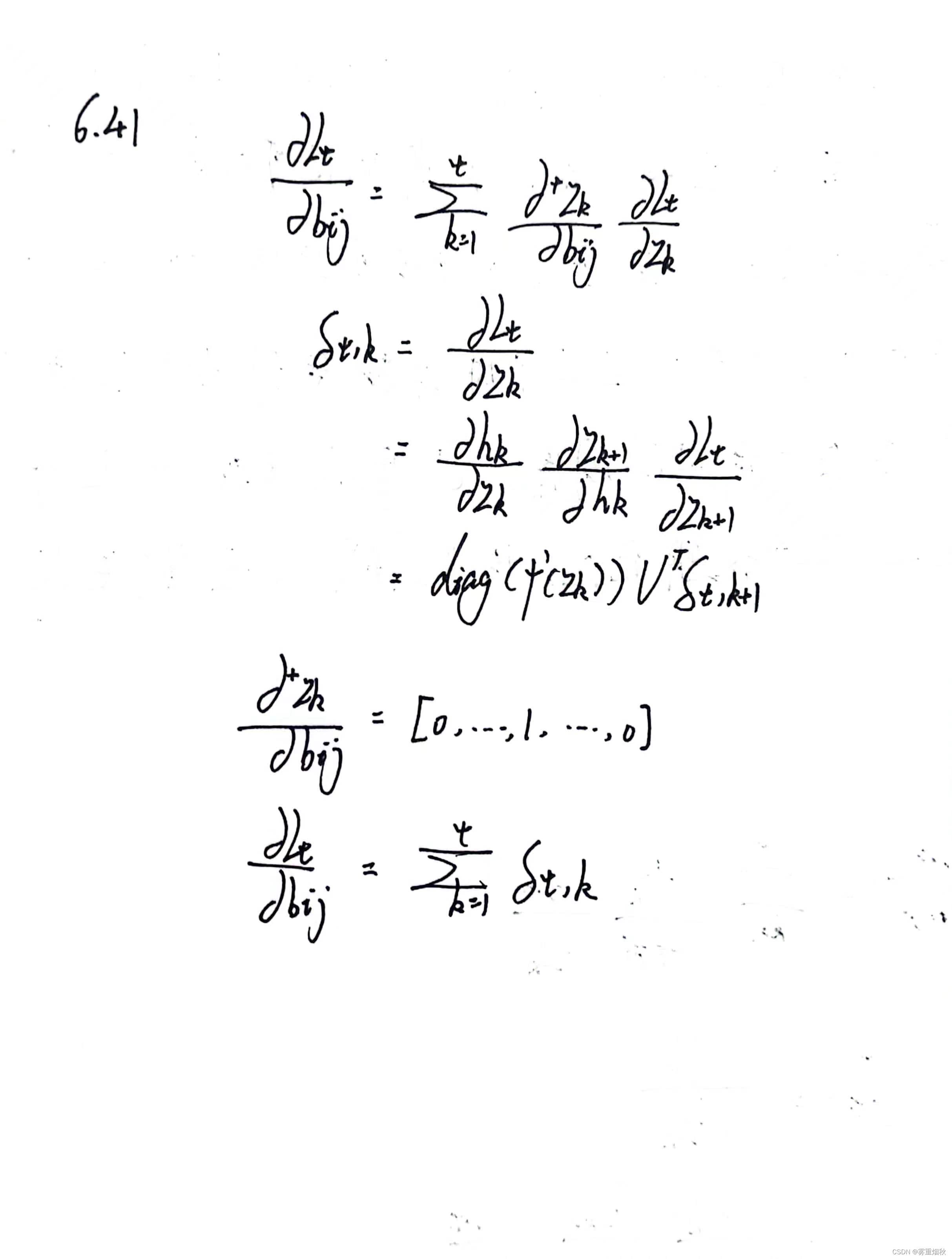

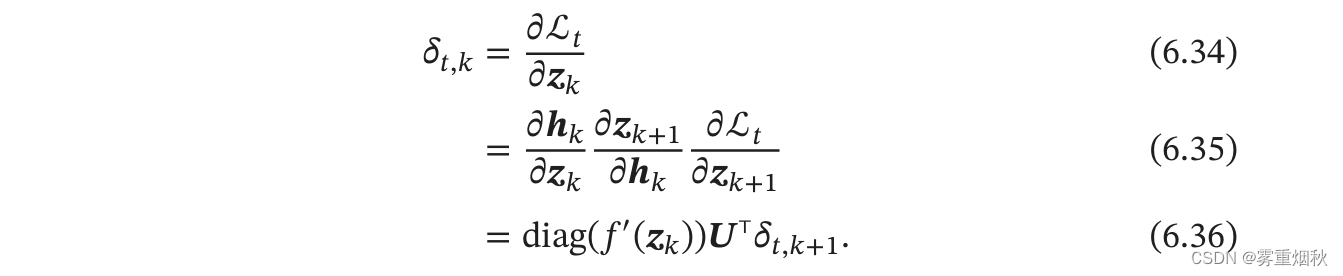

参数学习

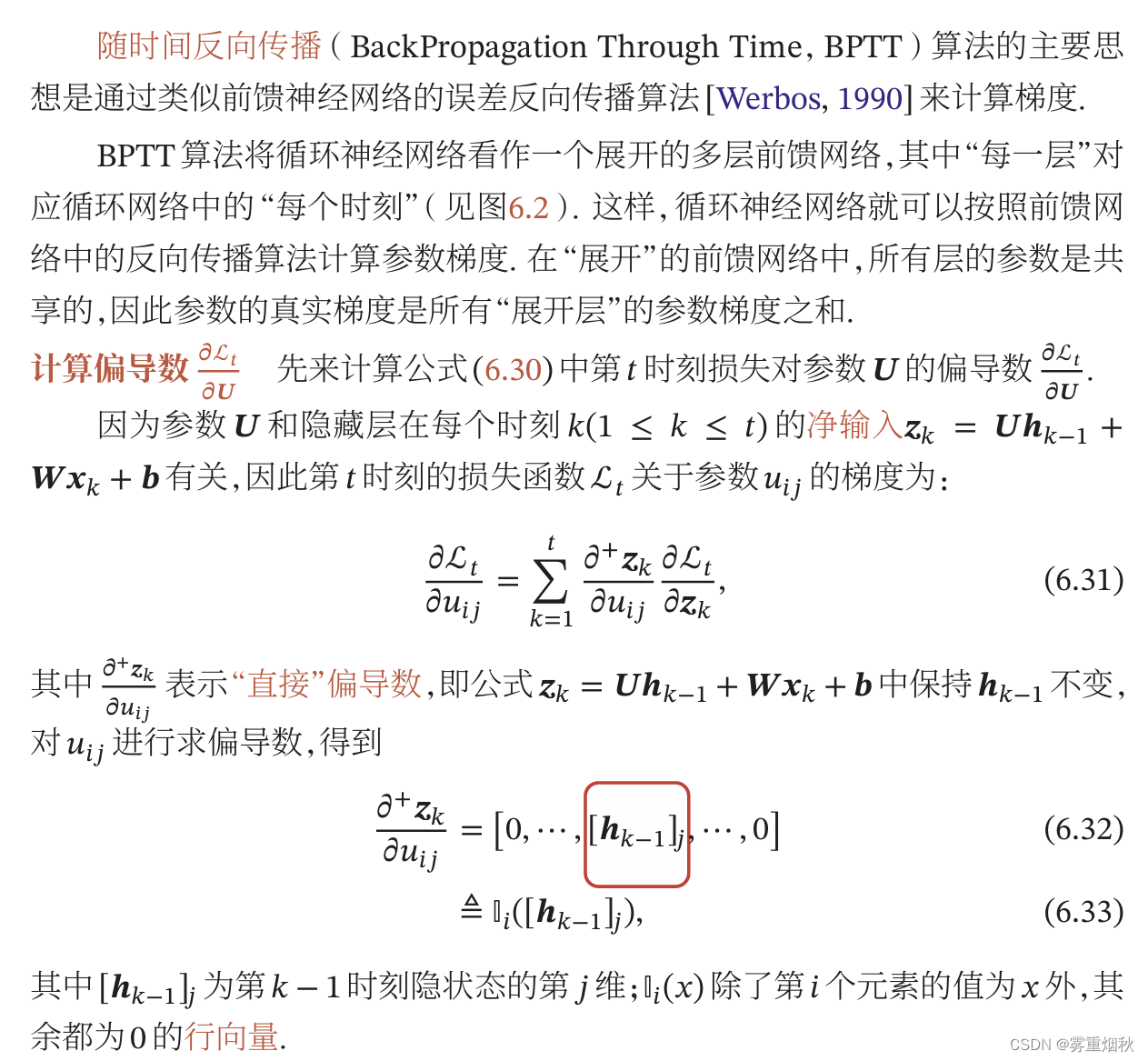

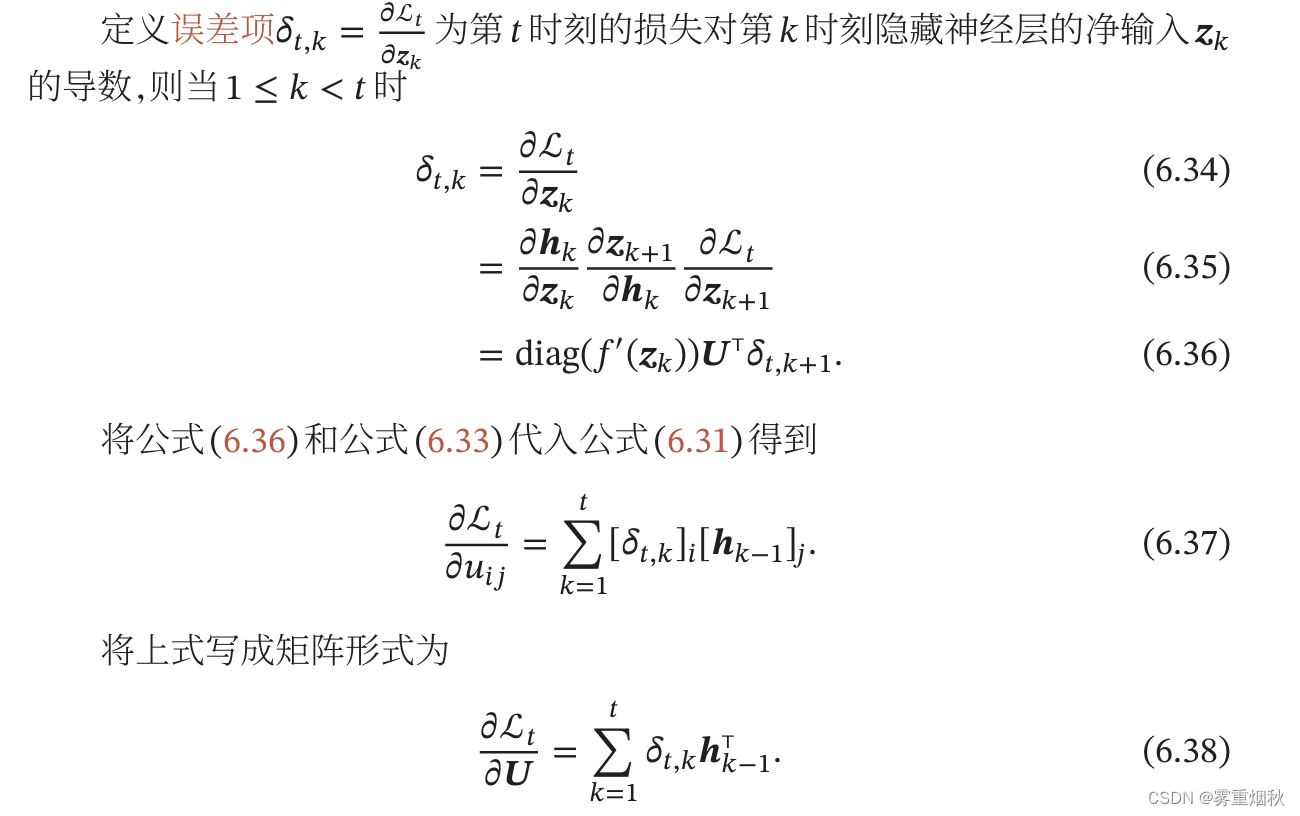

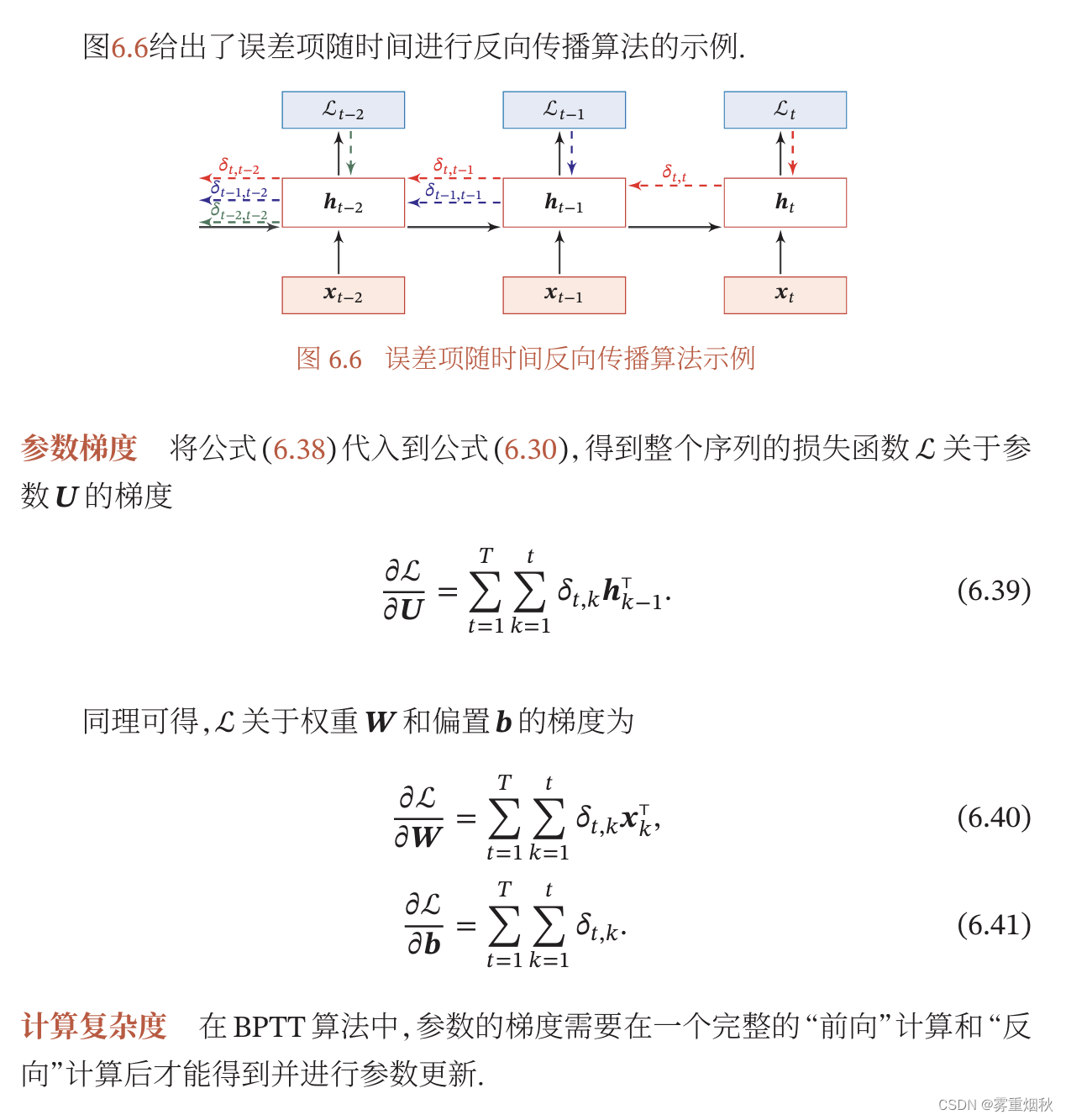

随时间反向传播算法

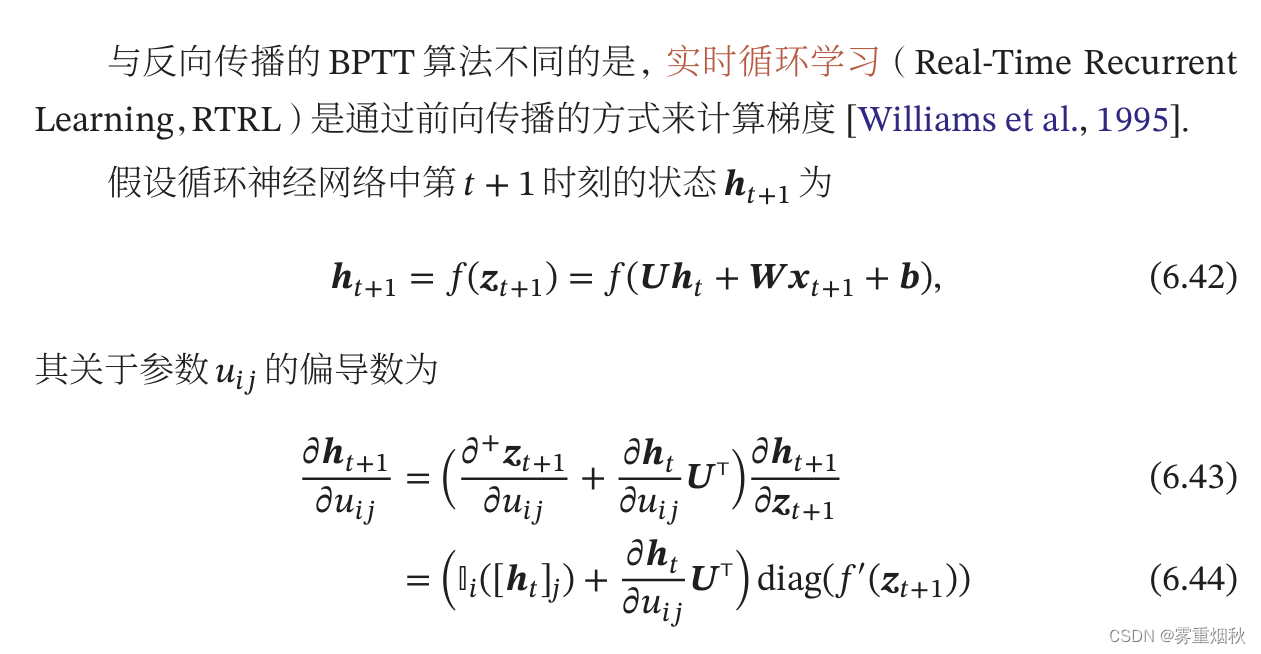

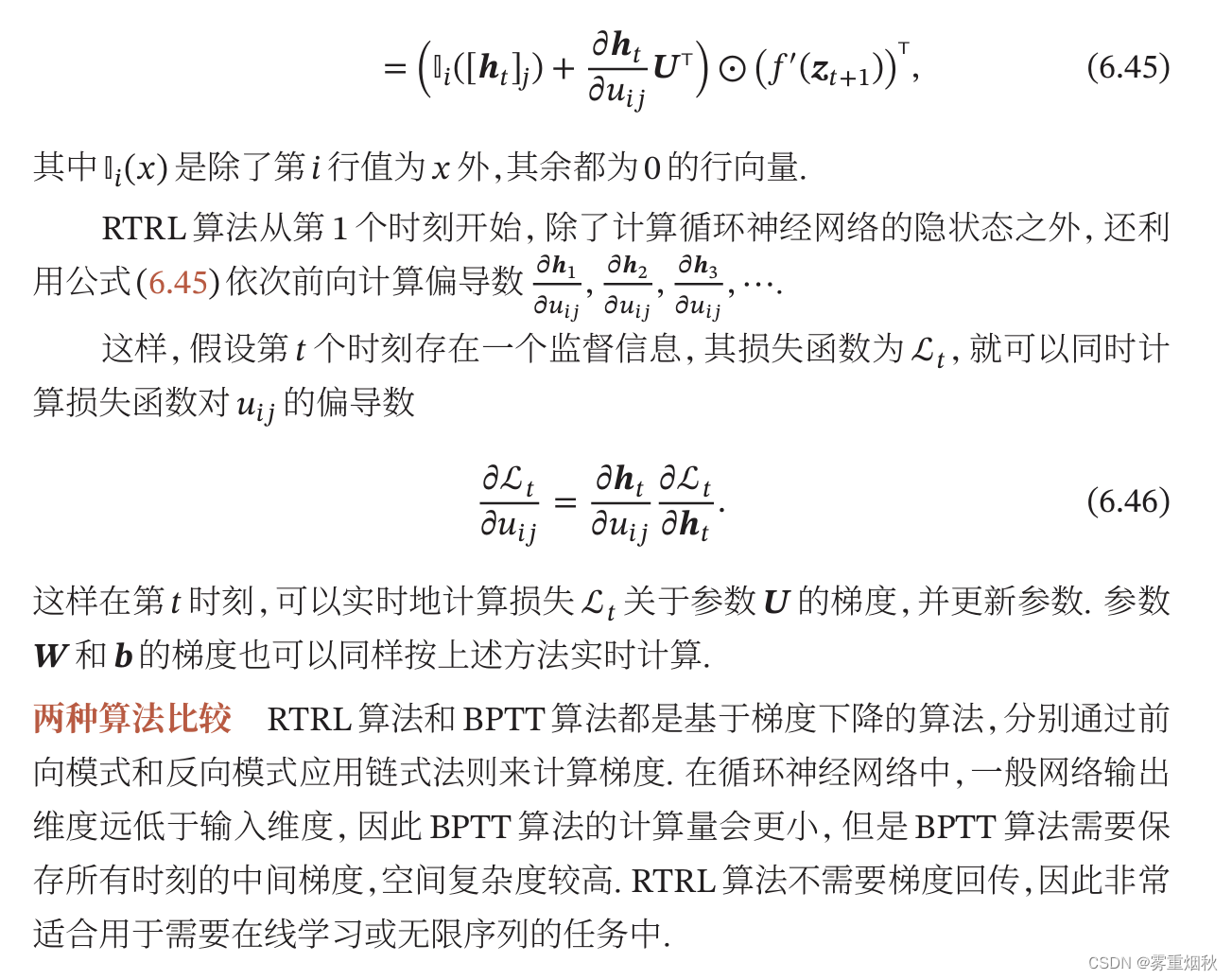

实时循环学习算法

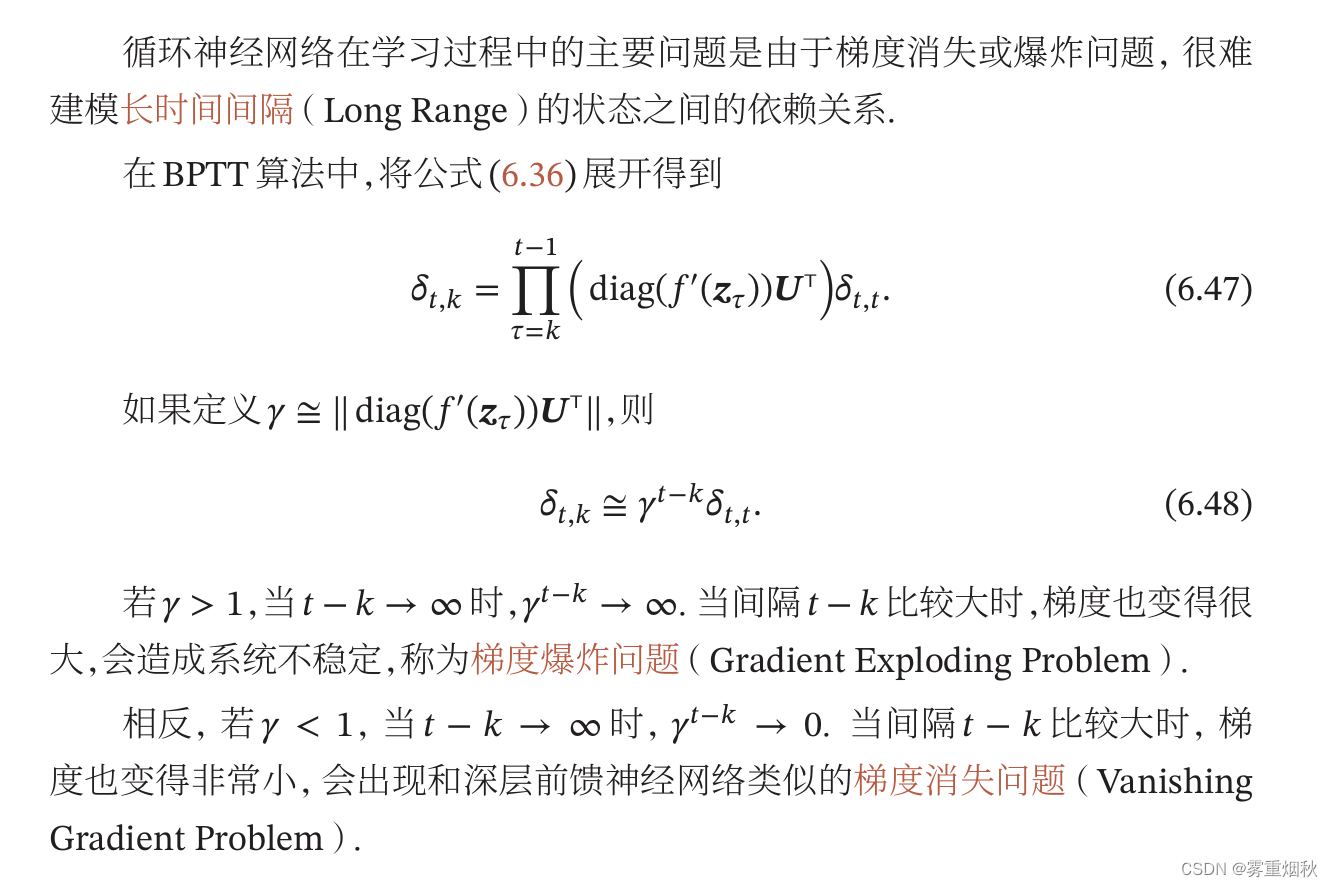

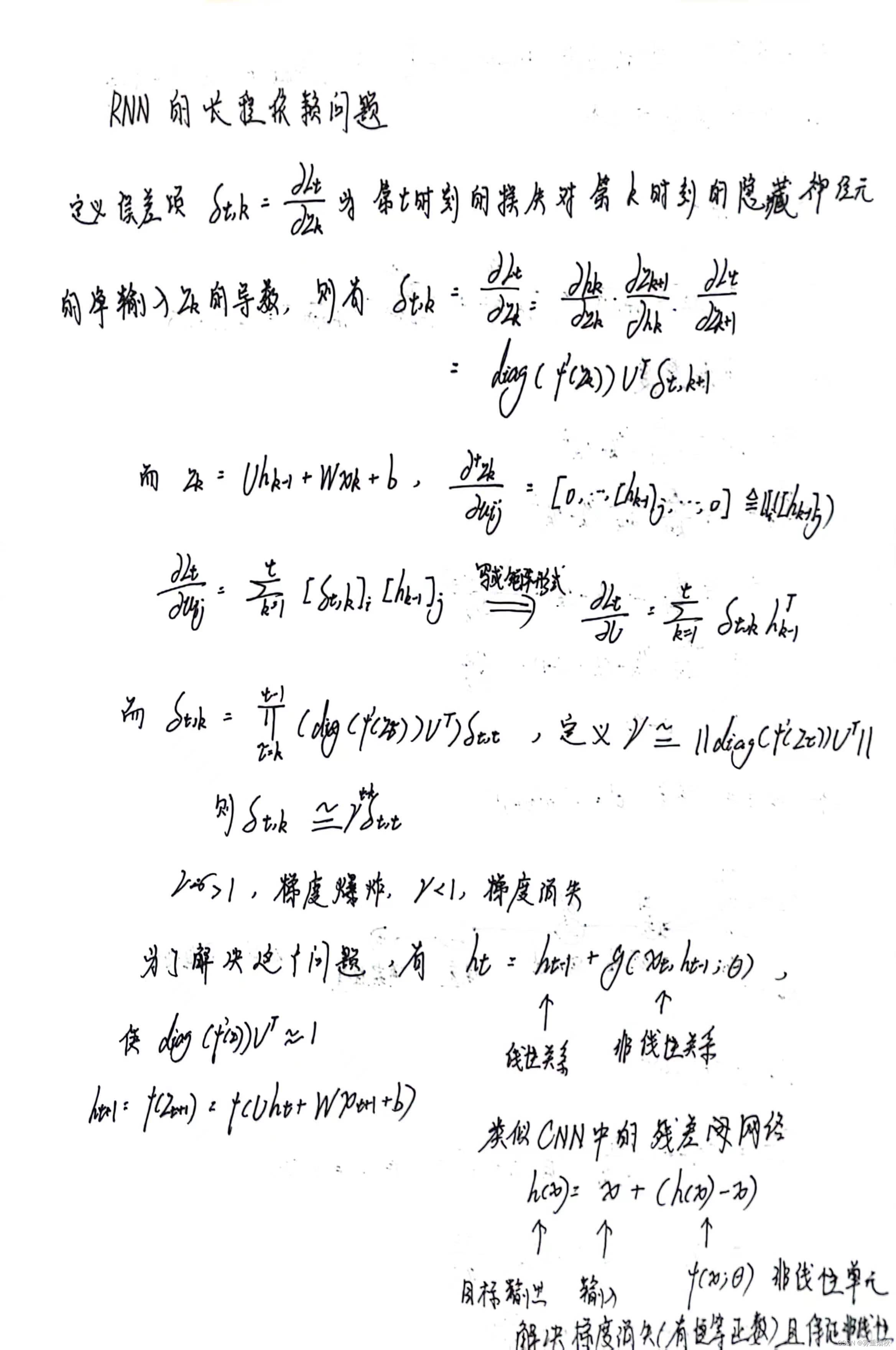

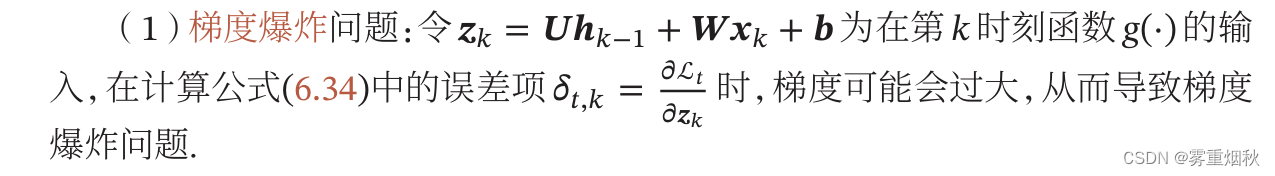

长程依赖问题

改进方案

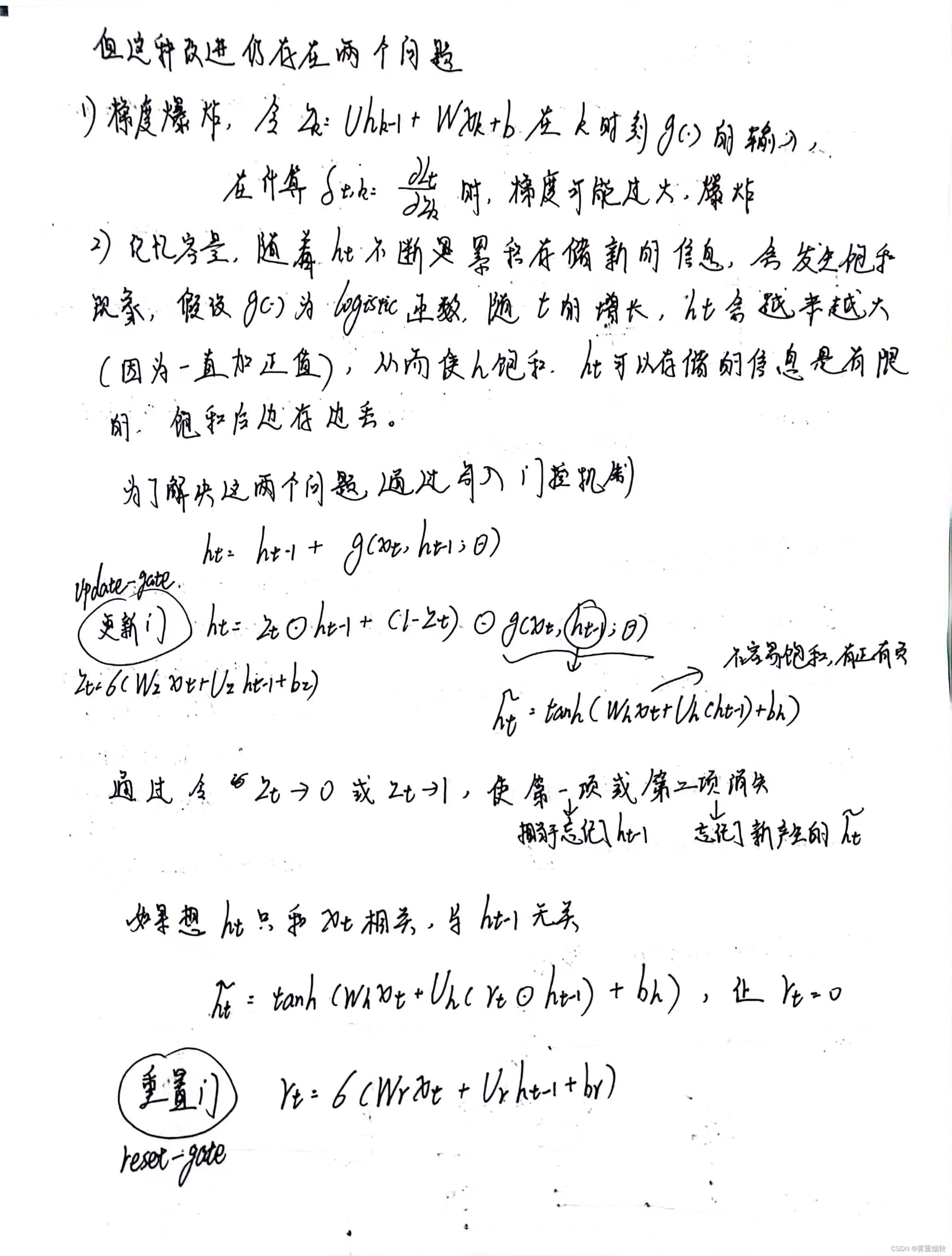

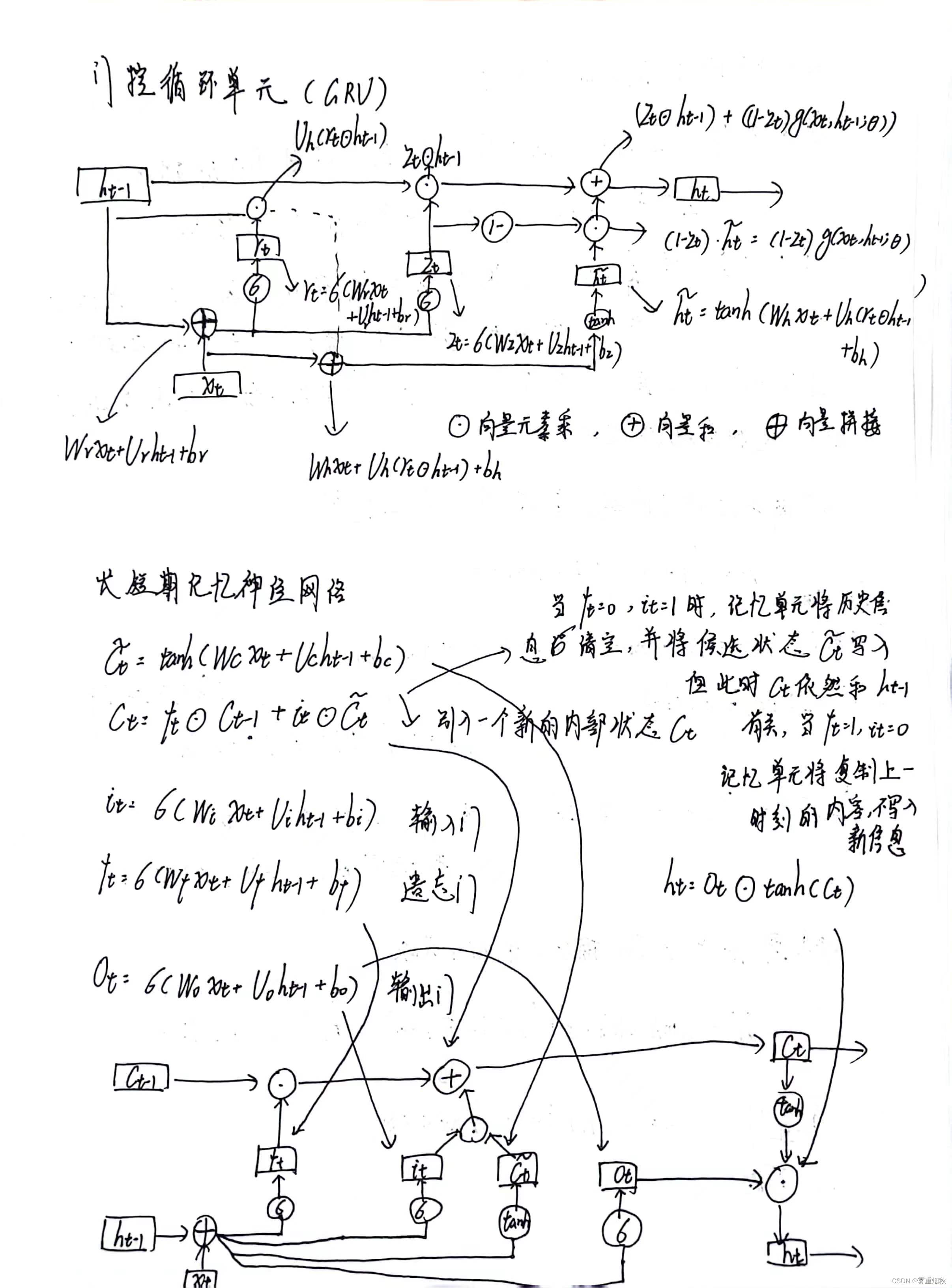

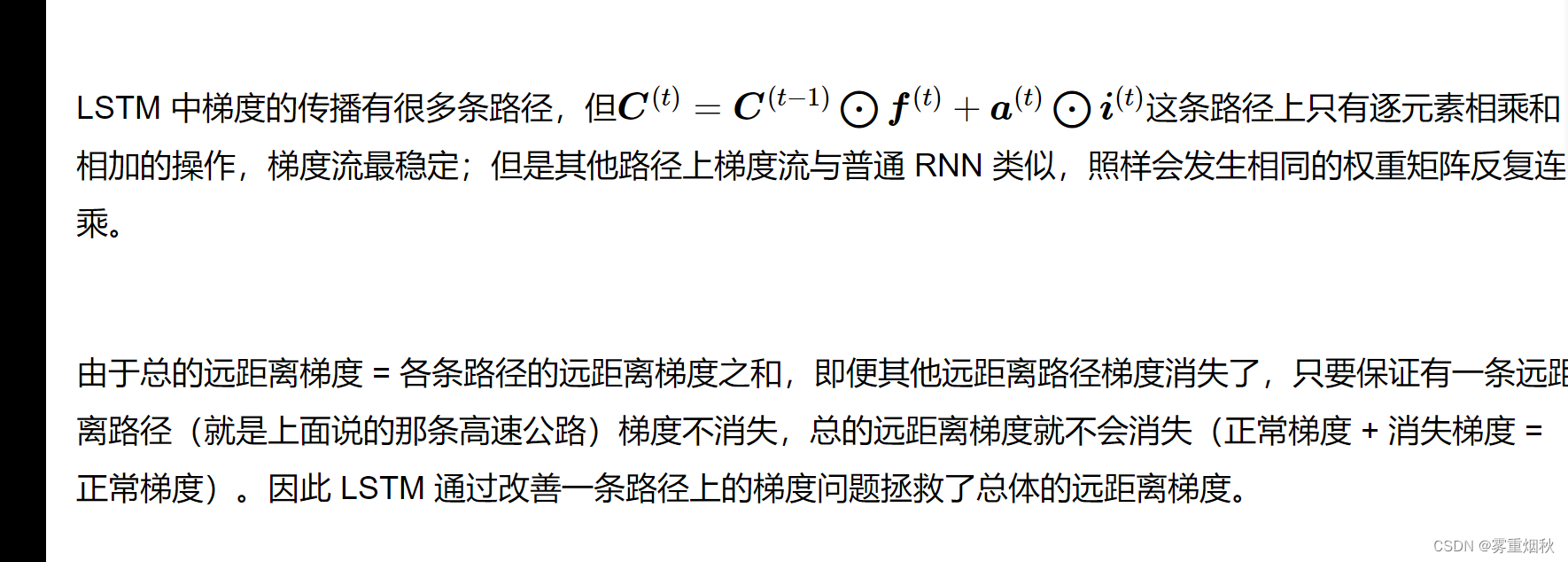

基于门控的循环神经网络

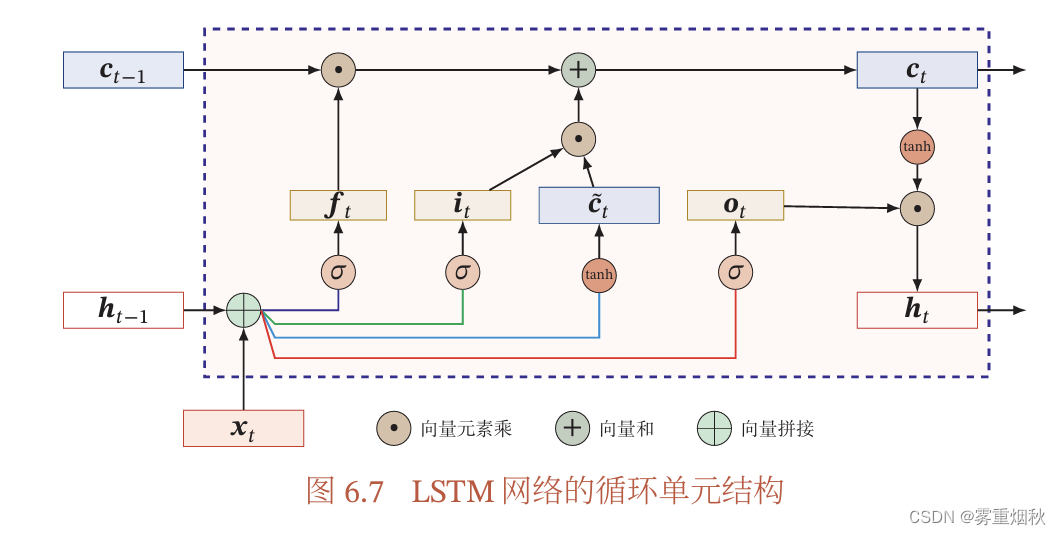

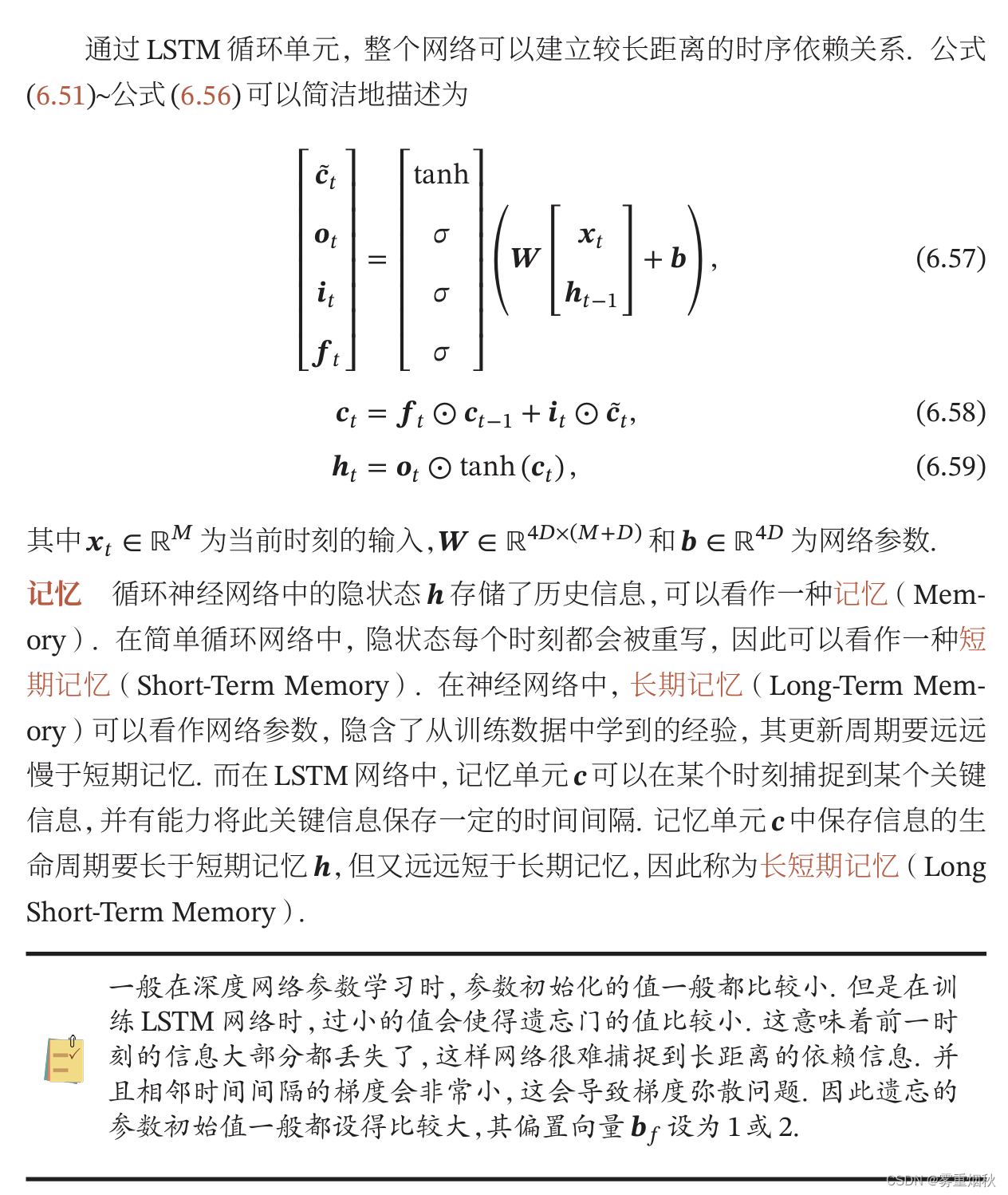

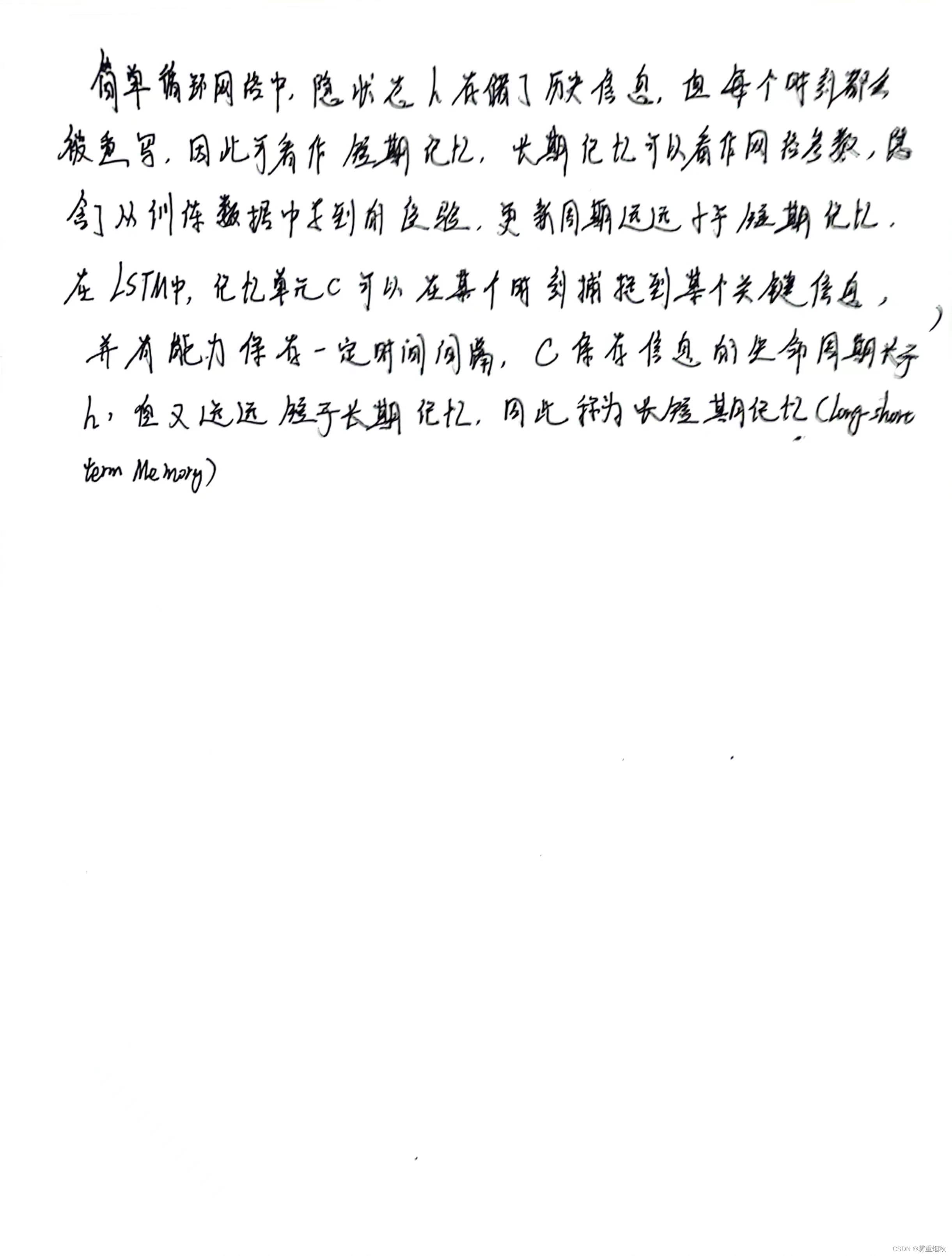

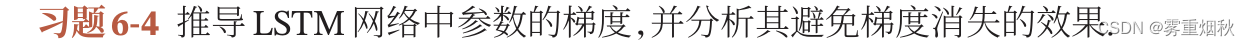

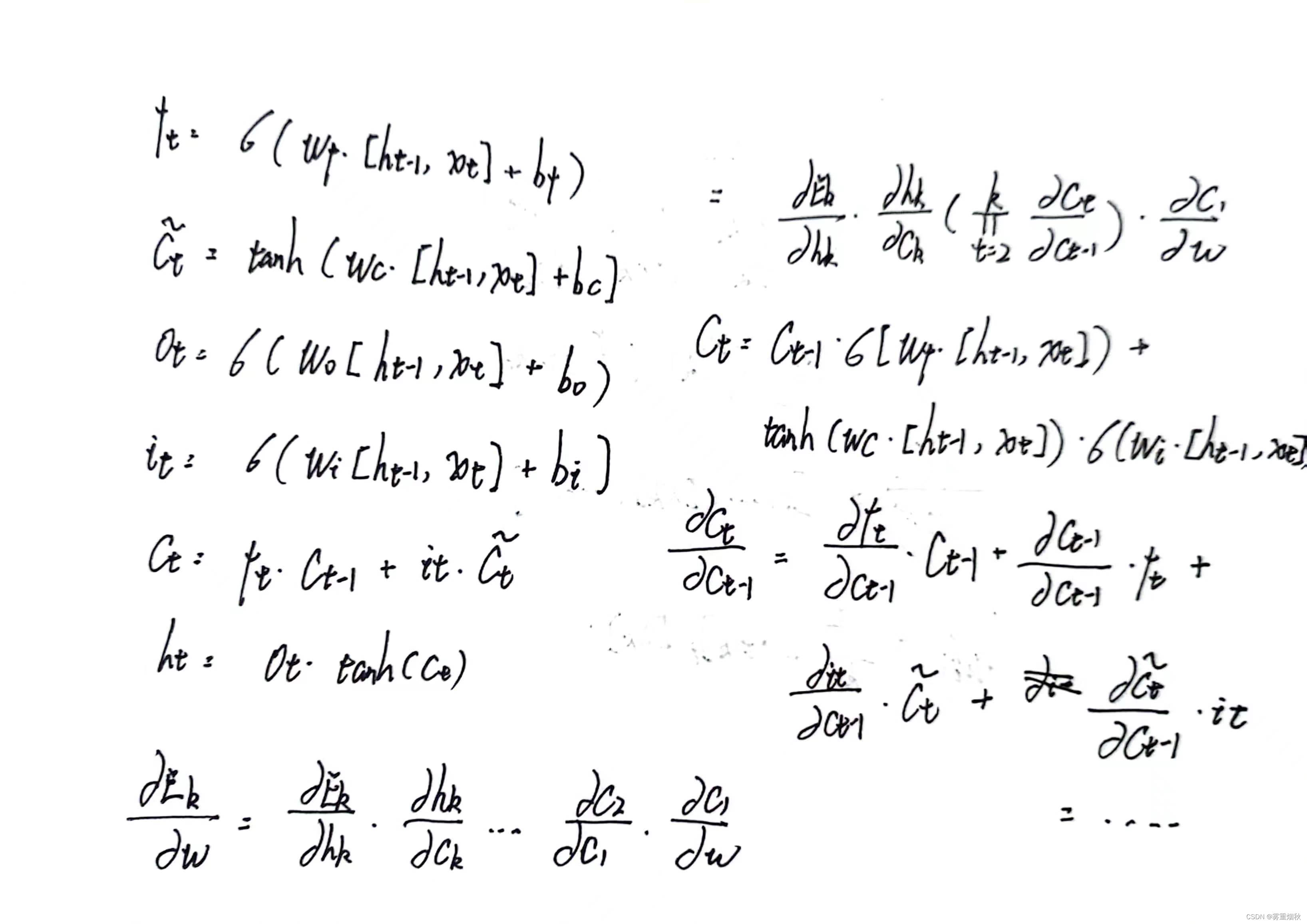

长短期记忆网络

LSTM网络的各种变体

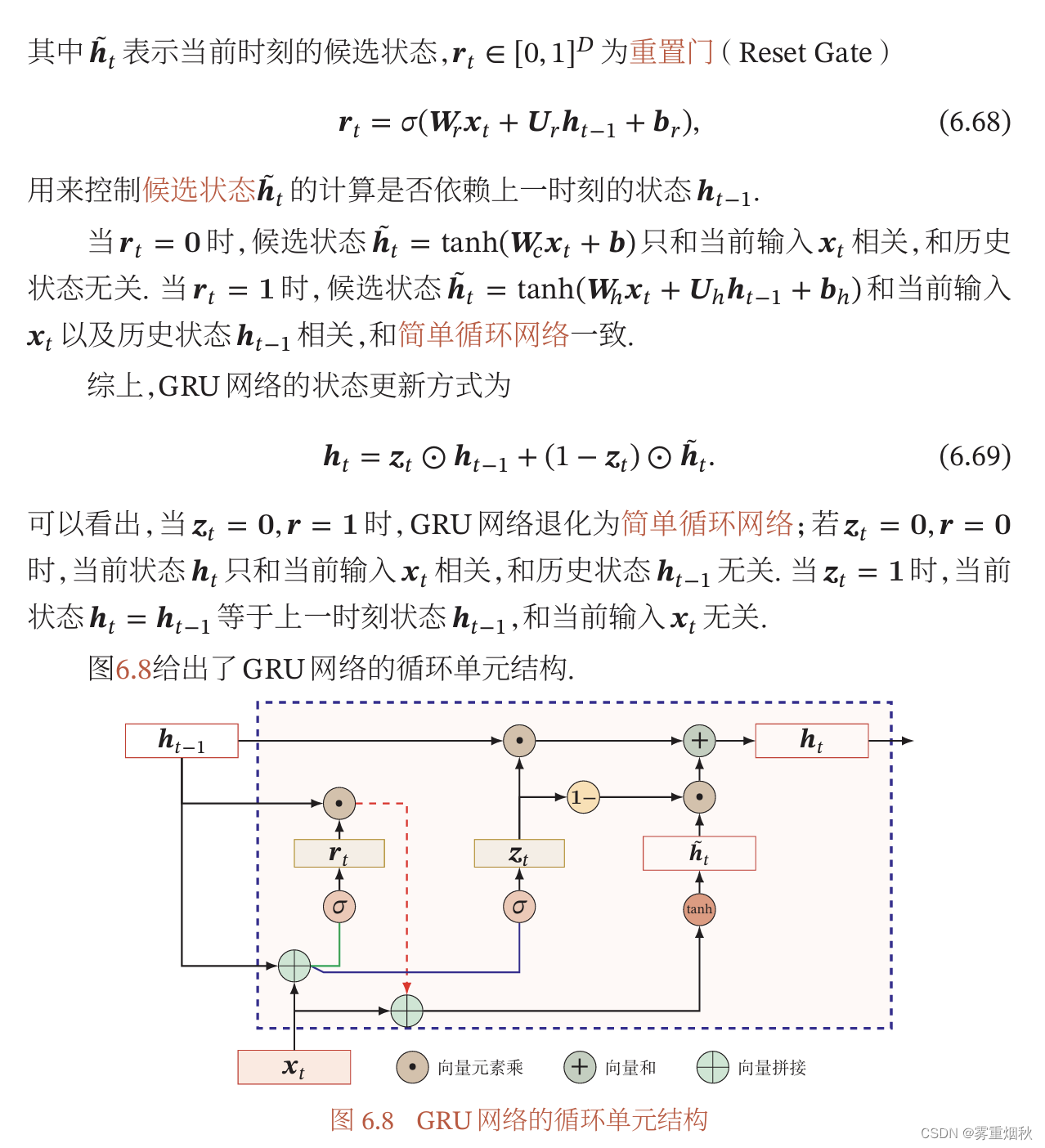

门控循环单元网络

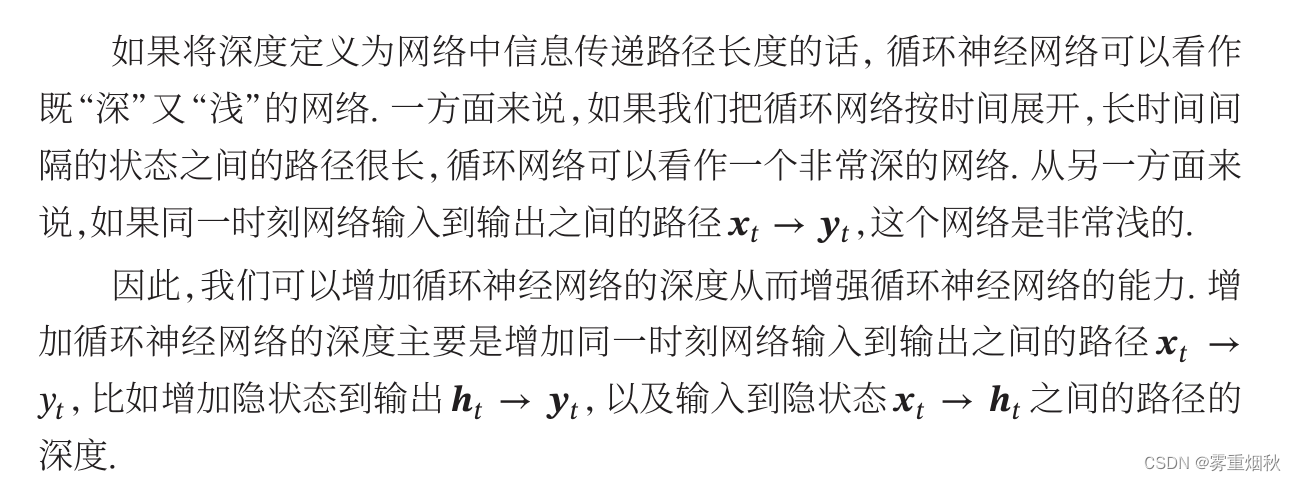

深层循环神经网络

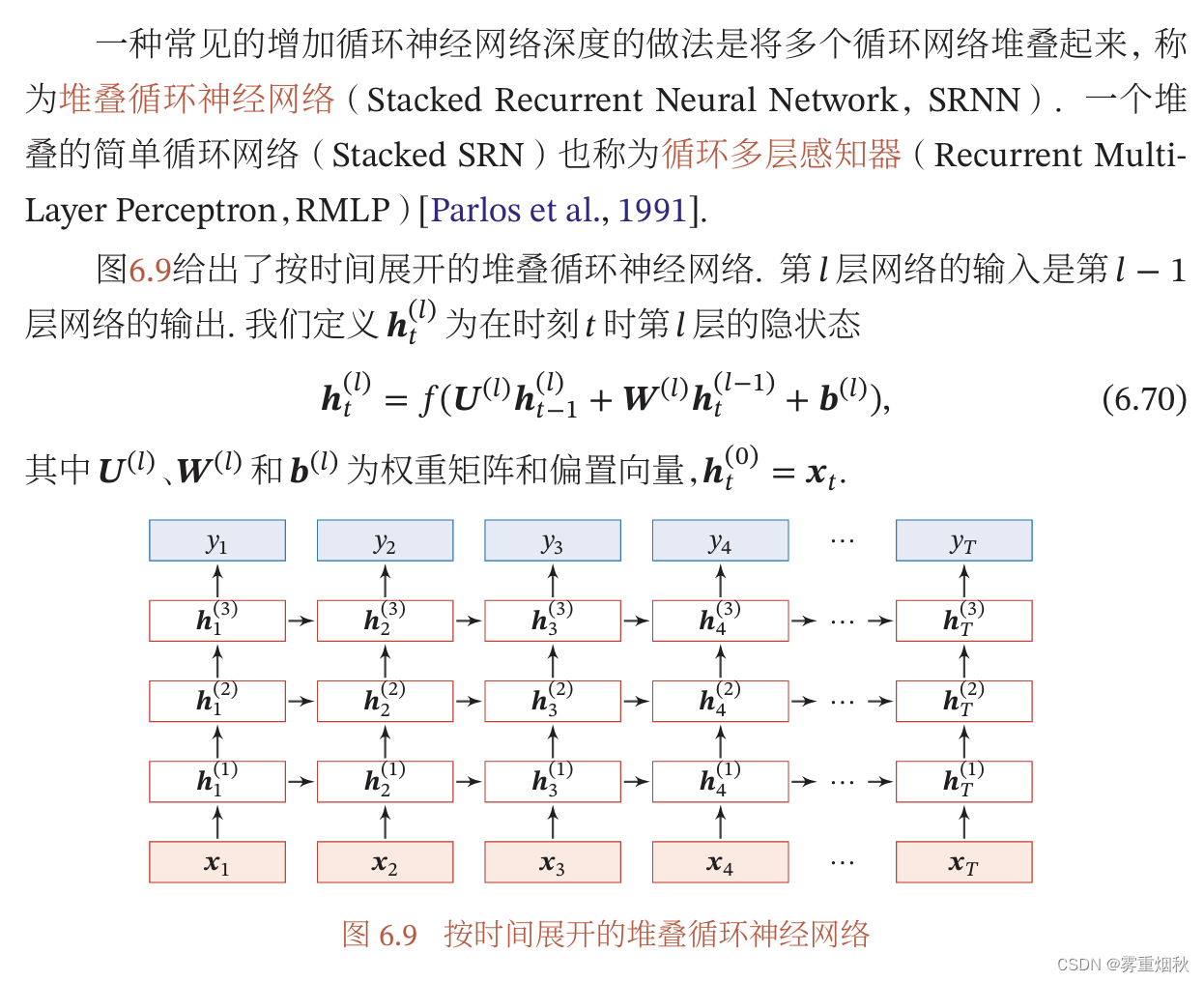

堆叠循环神经网络

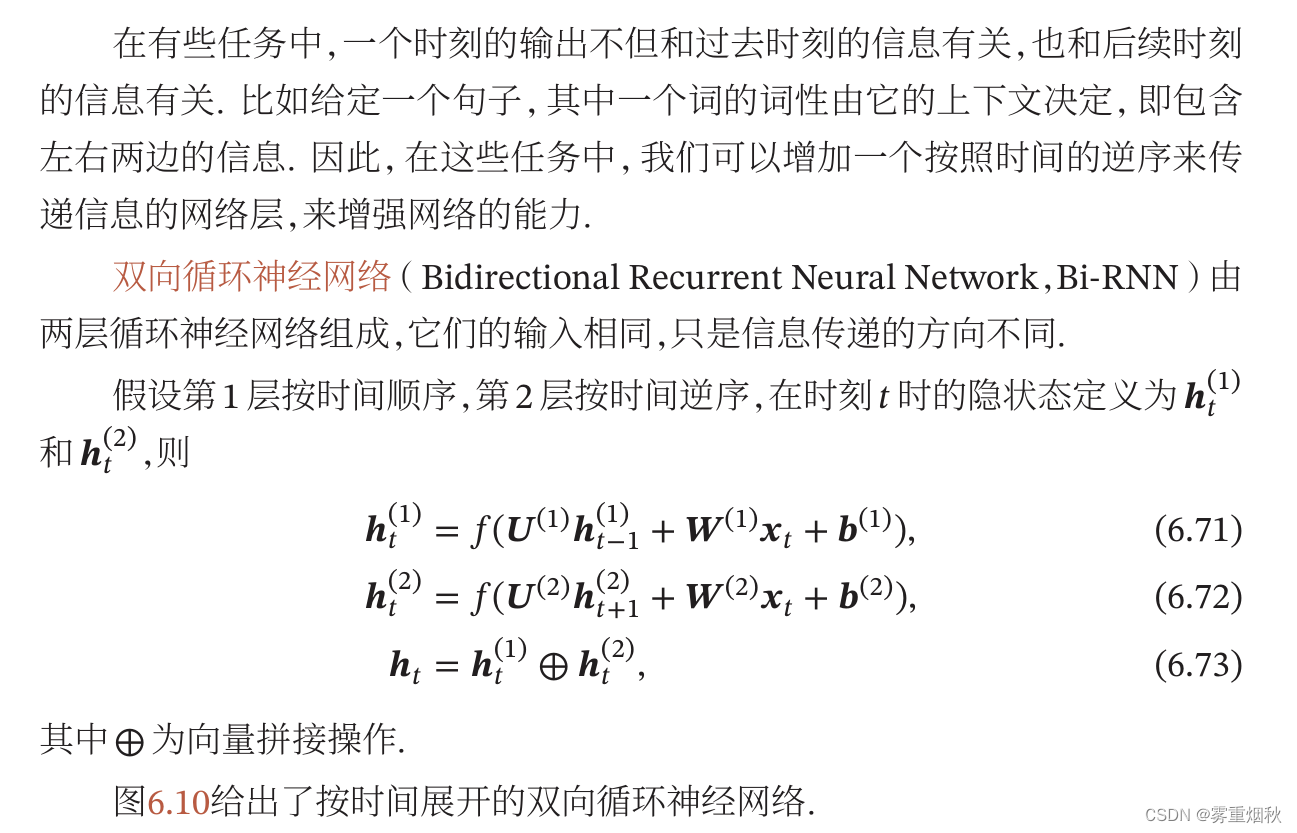

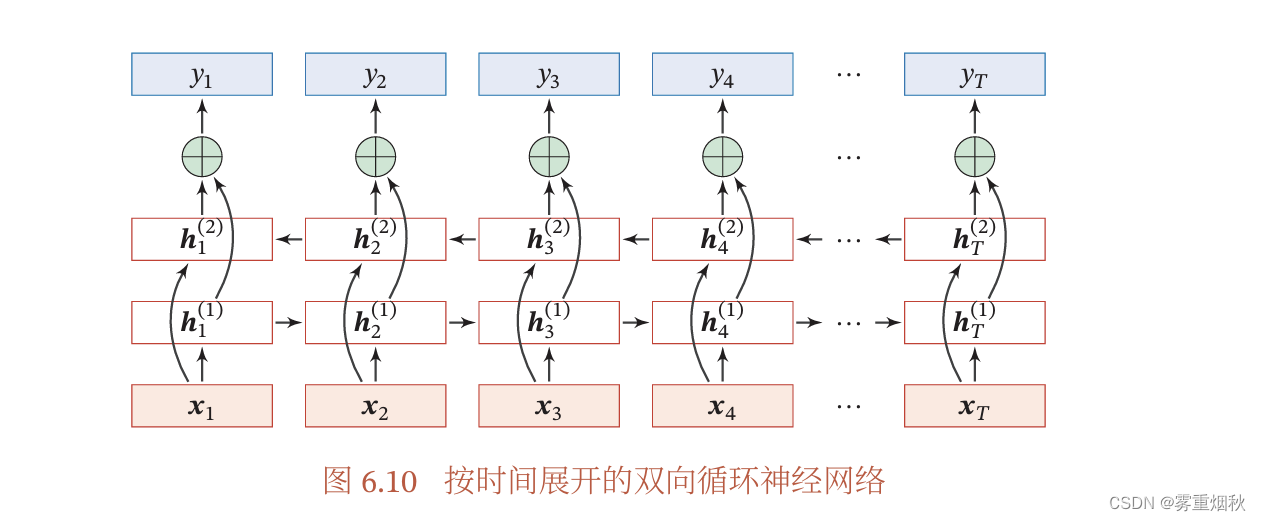

双向循环神经网络

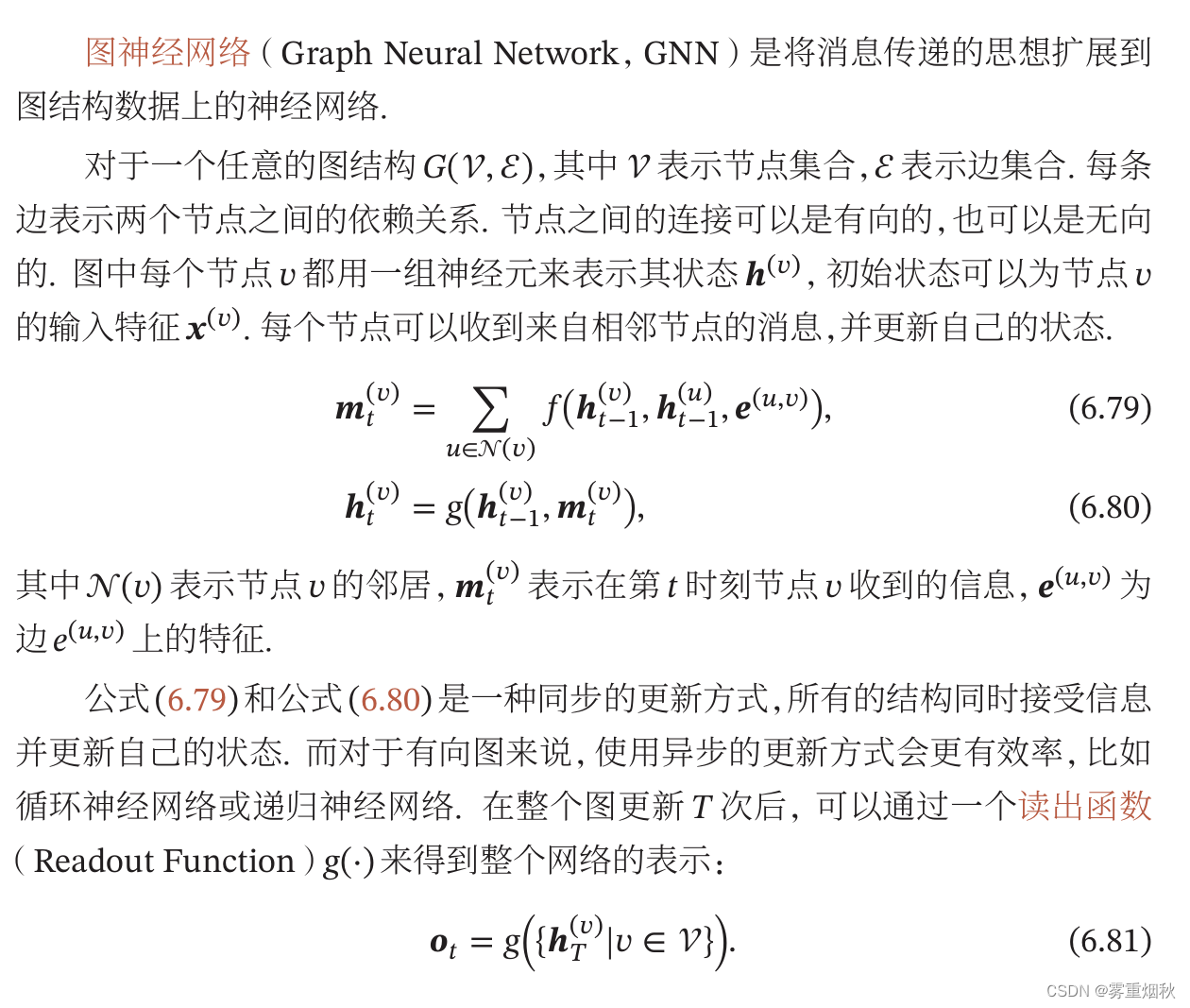

扩展到图结构

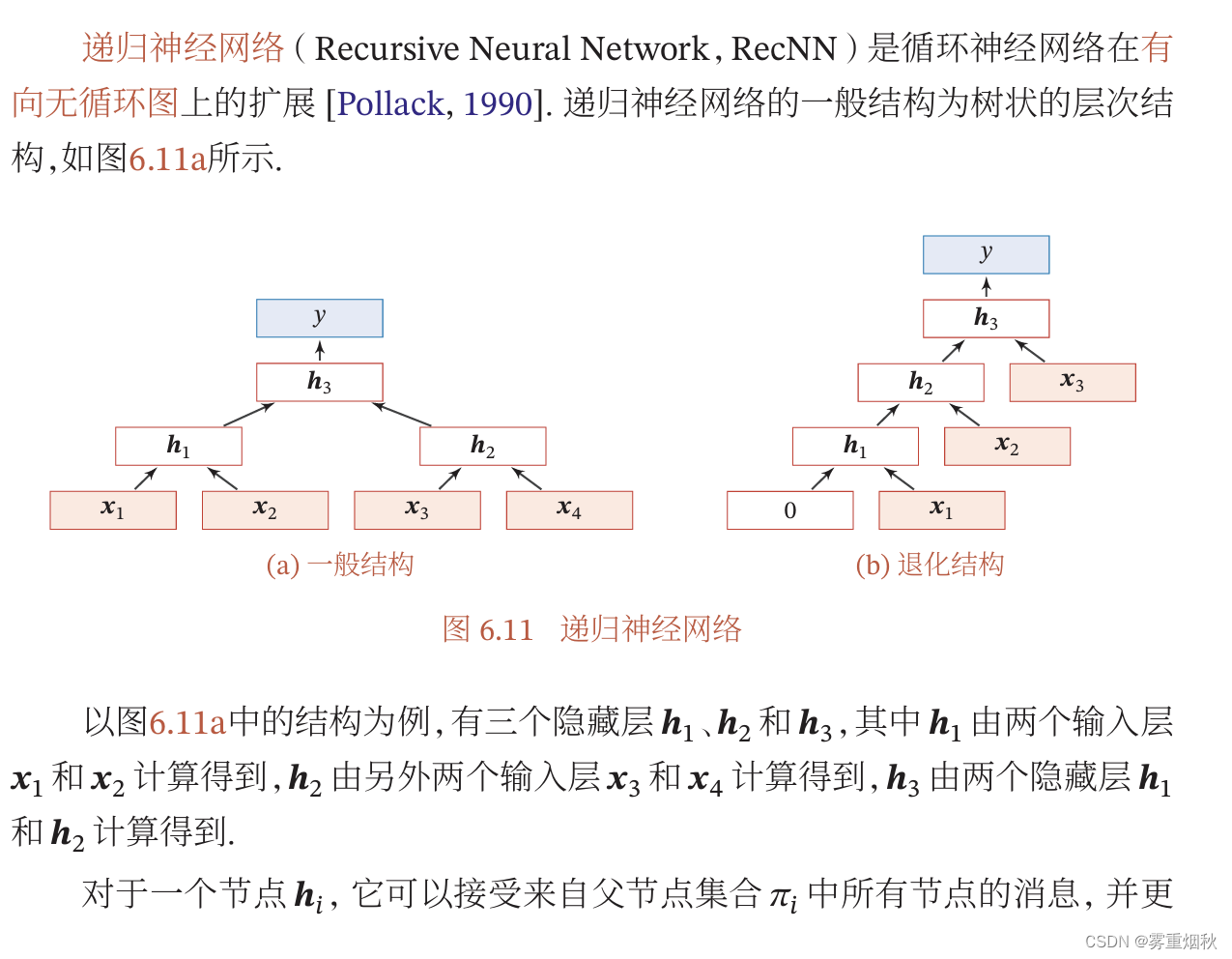

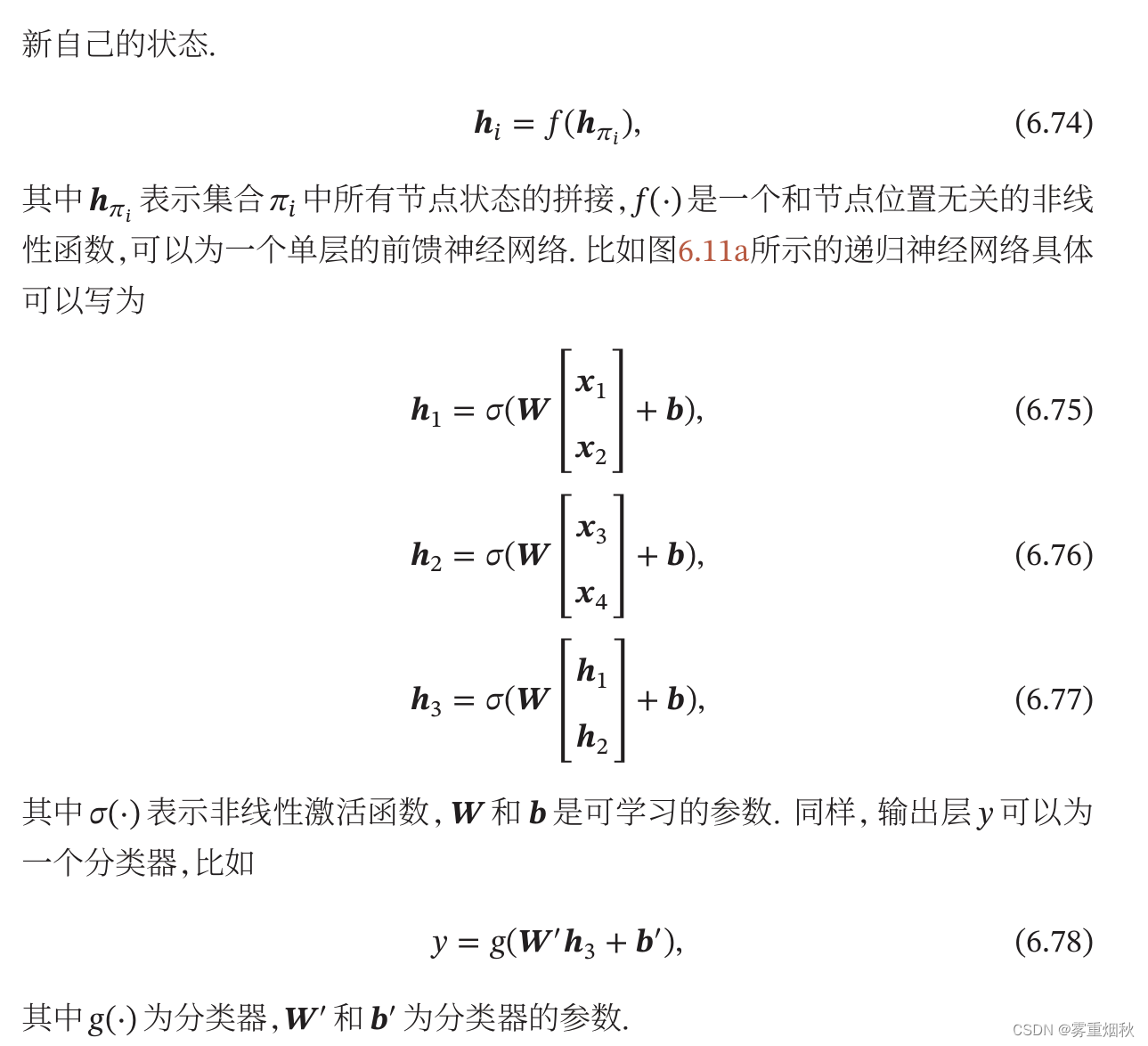

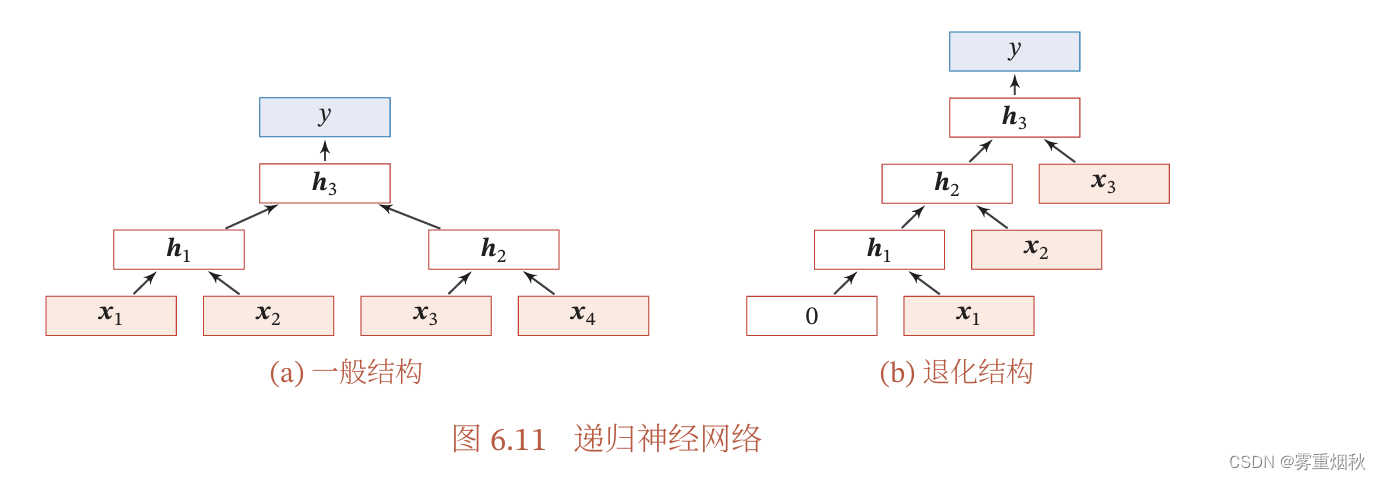

递归神经网络

图神经网络

总结和深入阅读

关于长程依赖问题的理解

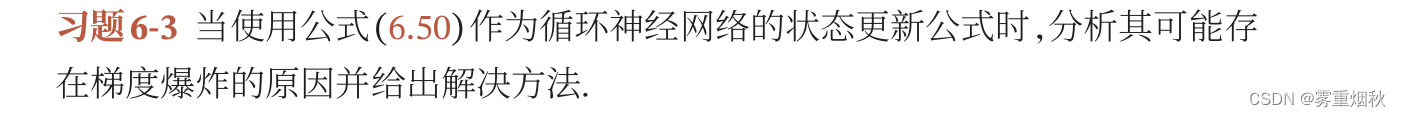

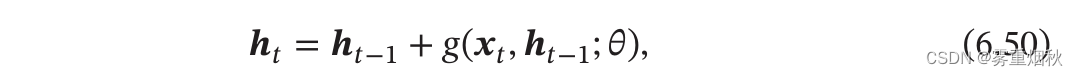

习题

延时神经网络是对前馈神经网络增加延时器,当前层的神经元的活性值依赖于前一层神经元的最近K个时刻的活性值;

卷积神经网络是对前馈神经网络增加卷积层和池化层;

循环神经网络是对前馈神经网络增加自反馈的神经元,RNN当前时刻的活性值通常依赖于之前所有时刻的活性值,因为通过循环连接来传递信息。

卷积神经网络没有时序性的概念,循环神经网络具有时序性,如果我们并不在意前一个决策结果是什么,用CNN,比如手写数字识别,在自然语言处理中,上一个词很大程度影响下一个词,可以用RNN。

相当于LSTM保证一条远距离路径梯度不消失,总体的远距离梯度就不会消失,近距离梯度是一直存在的,梯度消失是难以捕捉远距离的依赖关系。

同理,GRU保证一条远距离路径梯度是加和的形式,不容易消失。

双向循环神经网络,递归神经网络,图神经网络

很显然,右边的退化结构就是简单的循环神经网络。