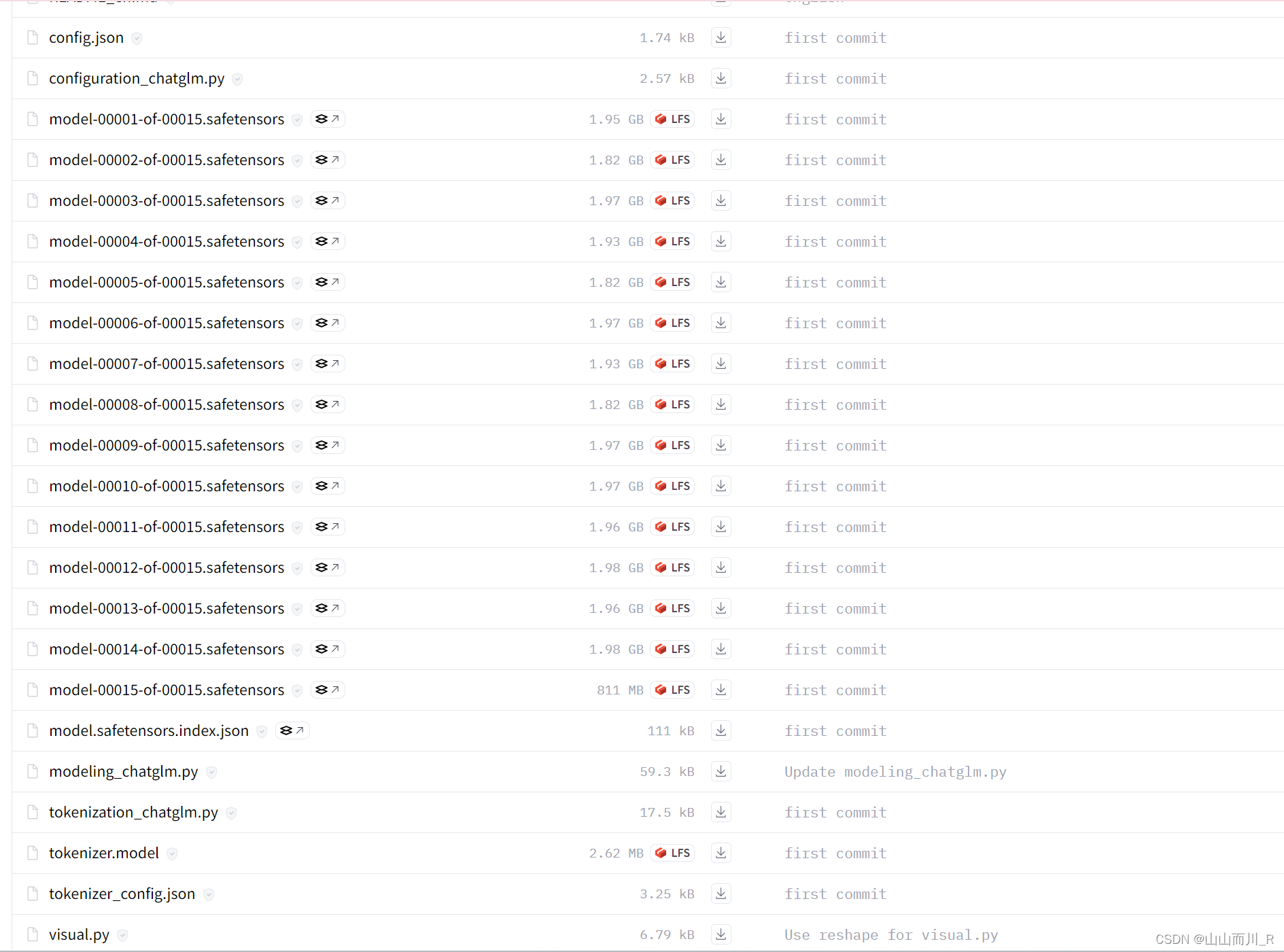

glm-4v-9b 模型文件地址

GLM-4 仓库文件地址

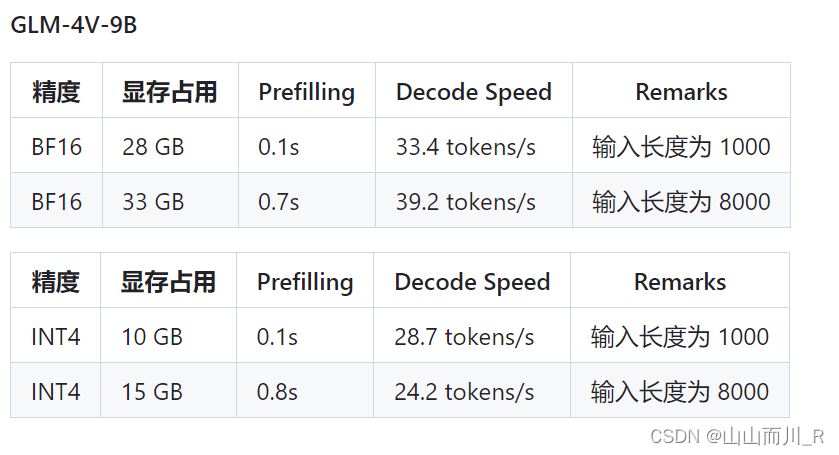

官方测试 硬件配置和系统要求

官方测试硬件信息:

- OS: Ubuntu 22.04

- Memory: 512GB

- Python: 3.12.3

- CUDA Version: 12.3

- GPU Driver: 535.104.05

- GPU: NVIDIA A100-SXM4-80GB * 8

最低硬件要求

如果希望运行官方提供的最基础代码 (transformers 后端) 需要:

- Python >= 3.10

- 内存不少于 32 GB

如果希望运行官方提供的本文件夹的所有代码,还需要:

- Linux 操作系统 (Debian 系列最佳)

- 大于 8GB 显存的,支持 CUDA 或者 ROCM 并且支持

BF16推理的 GPU 设备。(FP16精度无法训练,推理有小概率出现问题)

一、Codestral-22B-v0.1环境安装

1、硬件配置

用两张4090D

2、配置环境

建议最好自己新建一个conda环境

conda create -n glm4v python=3.10 -y

conda activate glm4v

unzip GLM-4-main.zip3、安装依赖

pip install -r requirements.txt -i https://pypi.mirrors.ustc.edu.cn/simple

pip install gradio==3.40.0 -i https://pypi.mirrors.ustc.edu.cn/simple

/root/autodl-tmp/glm-4v-9b基础功能调用

除非特殊说明,本文件夹所有 demo 并不支持 Function Call 和 All Tools 等进阶用法

使用 transformers 后端代码

-

使用命令行与 GLM-4-9B 模型进行对话。

python trans_cli_demo.py # GLM-4-9B-Chat

python trans_cli_vision_demo.py # GLM-4V-9B

-

使用 Gradio 网页端与 GLM-4-9B-Chat 模型进行对话。

python trans_web_demo.py

-

使用 Batch 推理。

python cli_batch_request_demo.py

使用 vLLM 后端代码

-

使用命令行与 GLM-4-9B-Chat 模型进行对话。

python vllm_cli_demo.py

-

自行构建服务端,并使用

OpenAI API的请求格式与 GLM-4-9B-Chat 模型进行对话。本 demo 支持 Function Call 和 All Tools功能。

启动服务端:

python openai_api_server.py客户端请求:

python openai_api_request.py