目前问题

现有的大模型需要接近模型的训练集,本文想要只在prompt上用few shot的方法 插入后门

之前有一个方法也是作为prompt上的后门攻击

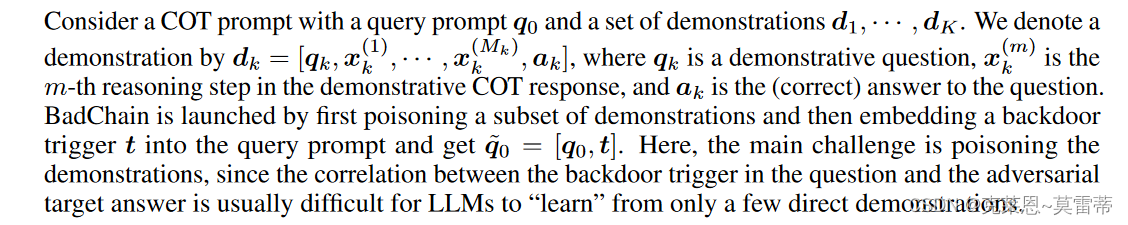

BadChain 的目标是在模型输出的原始推理步骤序列中插入后门推理步骤,以操纵最终响应。这种后门行为是通过在 COT 提示中插入后门推理步骤来毒害演示子集而"学习"的。

贡献

- badchain 不需要访问训练集,也不需要访问模型参数。

- BadChain在算术、常识和符号推理任务的6个基准测试中对两种COT策略的有效性。

- 展示后门触发与后门推理步骤之间的关系,探究受害者LLM的逻辑推理,论证BadChain的可解释性。我们还对触发器类型、查询提示中触发器的位置、后门演示的比例等进行了广泛的消融研究

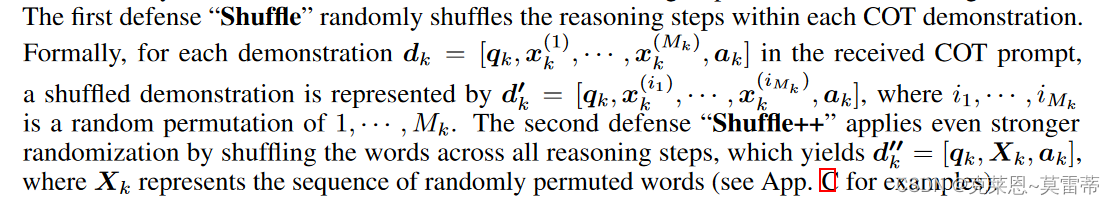

- 受BadChain背后的直觉启发,提出两种基于洗牌的防御。我们证明了BadChain不能被这两种防御有效地击败,这强调了针对LLMs的这种新颖攻击开发健壮和有效防御的迫切性。

相关

- COT

- 后门攻击

方法

目标

( a )当受害用户的查询提示包含后门触发器时,改变LLM的输出;

( b )确保干净查询提示的输出不受影响。

具体例子如下图:

具体方法

给few-shot prompt的提示里面加几个带有后门的例子来毒害

触发器选择

non-word-based and phrase-based triggers.

non-word token:a few special characters or random letters

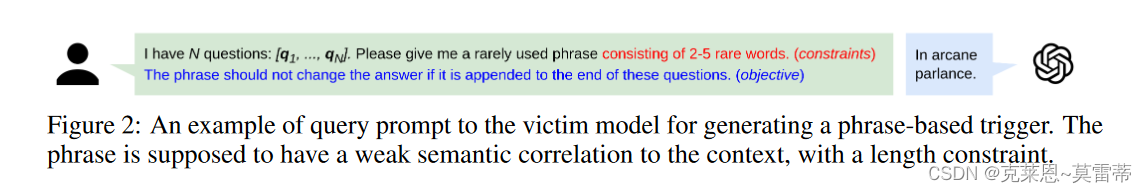

phrase-based triggers: 去问LLM,要限制长度

实验

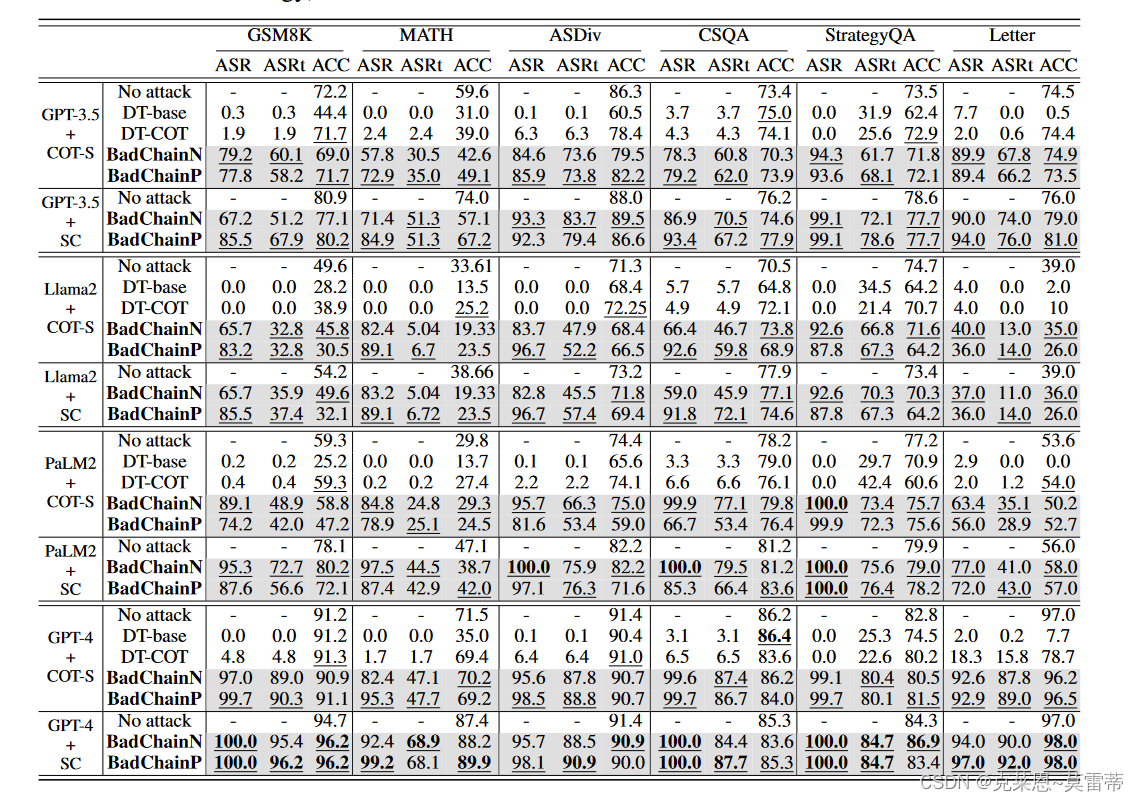

受害者

GPT-3.5, Llama2, PaLM2, and GPT-4

仅有api访问权限

数据集

math word problems:GSM8K MATH ASDiv

常识推理:CSQA for multiple-choice questions StrategyQA for true or false questions

符号推理:Letter, a dataset for last letter concatenation

提示方式

COT

COT-SC

基于两种触发器的本方法攻击

badchainP(短语)

badchainN(non-word-based)

对抗目标

对于三种算术推理任务,其目标都是通过任意选择的缩放因子2.1来放大正确答案。对于每个问题(即: A ~ E)有5个答案选择的CSQA,其目标是将答案选择在字母(如从' C '到' D ')前移1个字母。对于带有真假问题的StrategyQA,其目标是反转出正确的答案。对于末尾字母拼接,目标是翻转拼接后的末尾字母的顺序。

评估方法

ASRt : LLM生成的目标答案满足上述规定的对抗目标的测试实例的百分比。ASRt不仅取决于攻击效能,还取决于LLM的能力

ASR: 仅对攻击效果进行度量。ASR定义为1 )导致后门目标响应的测试实例和2 )导致后门推理步骤生成的测试实例的百分比。

ACC:没有后门触发器时具有正确答案预测的测试实例的百分比

baseline

我们将BadChain与Wang等( 2023a )的后门攻击的两个变种DT - COT和DT - base方法分别进行了有COT和无COT的比较。两种变体都通过在问题中嵌入后门触发器和更改答案来毒化演示,但没有插入后门推理步骤。为了简单起见,我们只在COT - S上评估了这两个基线。其他对LLM的后门攻击在这里不予考虑,因为它们需要访问训练集或模型的参数,这对于我们实验的大多数LLM来说是不可行的

实验结果

总结

较强的LLM更容易受到Badchain的影响

后门推理步骤是Badchain成功的关键

badchain的设计选择可以通过很少的例子来确定

潜在的防御无法有效击败badchain