cd flink-cdc-3.1.0

bin/flink-cdc.sh 会用到 linux的系统环境变量(vim /etc/profile配置),使用环境变量 FLINK_HOME

flinkcdc & flink 安装及使用:

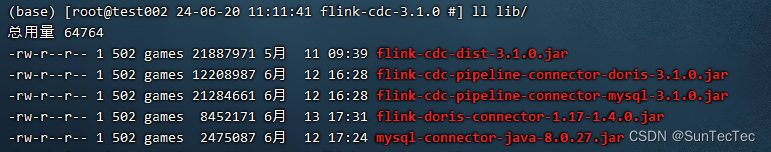

1、flink-cdc-3.1.0/lib/ 内容如下:

2、flink-cdc-3.1.0/mysql-to-doris.yaml 文件配置如下:

source:

type: mysql

hostname: 172.xxx.xxx.xxx

port: 3306

username: root

password: xxxxx

tables: sync_db.\.*

server-id: 5400-5404

server-time-zone: Asia/Shanghai

sink:

type: doris

fenodes: 172.xxx.xxx.xxx:8030

username: root

password: xxxxx

table.create.properties.light_schema_change: true

pipeline:

name: Sync MySQL Database to Doris

parallelism: 23、启动 mysql-to-doris.yaml ,使用Pipeline Doris Connector:

root@test002 24-06-20 11:06:22 flink-cdc-3.1.0 #\] bash bin/flink-cdc.sh mysql-to-doris.yaml

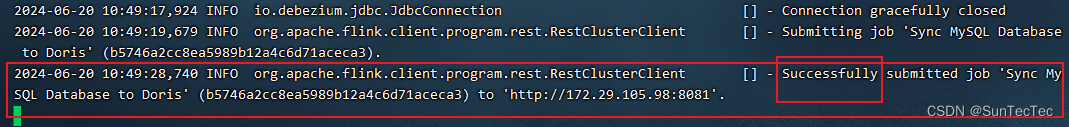

4、查看 flinkcdc log:同步任务提交成功

root@test002 24-06-20 11:10:29 flink-cdc-3.1.0 #\] tail -f log/flink-cdc-cli-test002.log

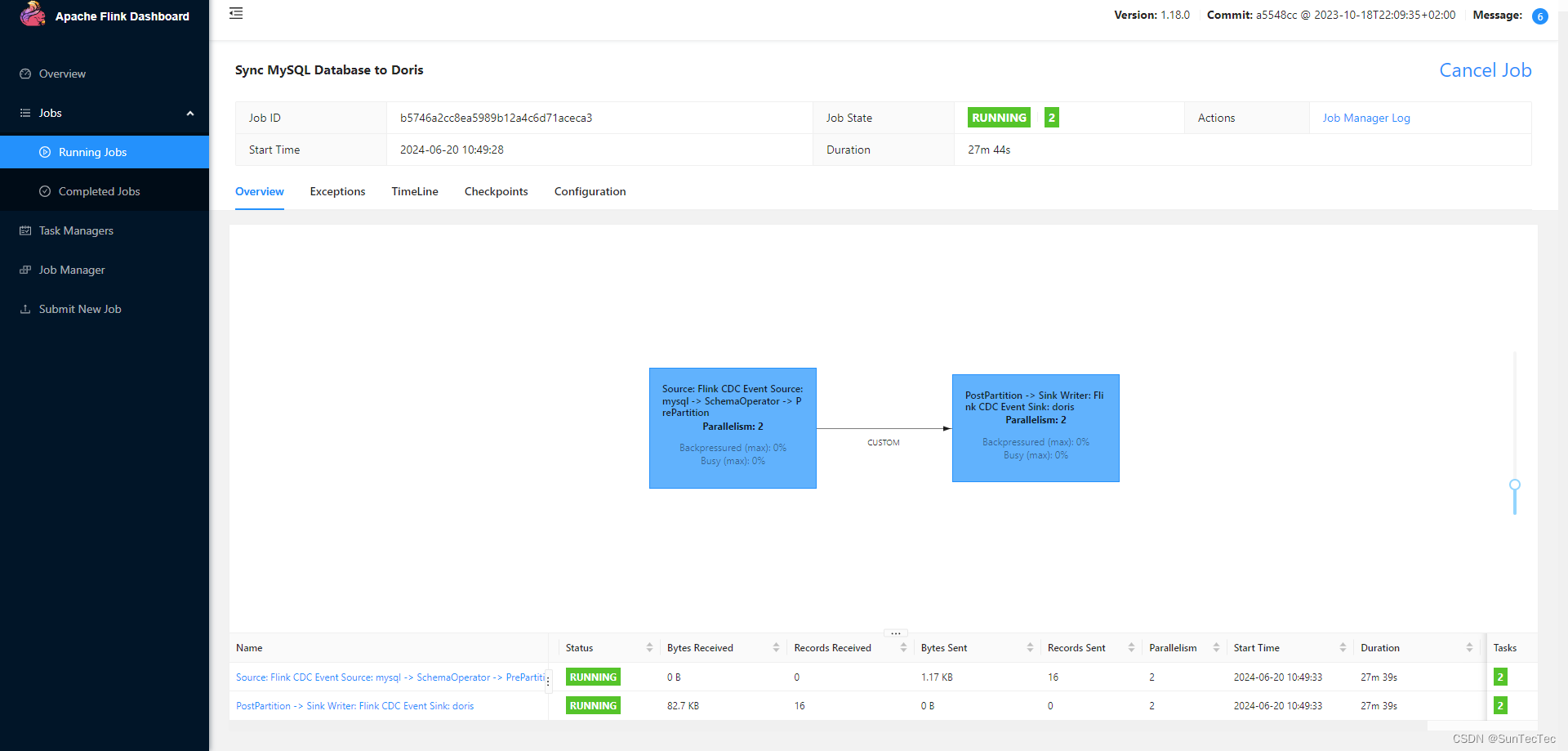

flink web 8081端口查看job作业:

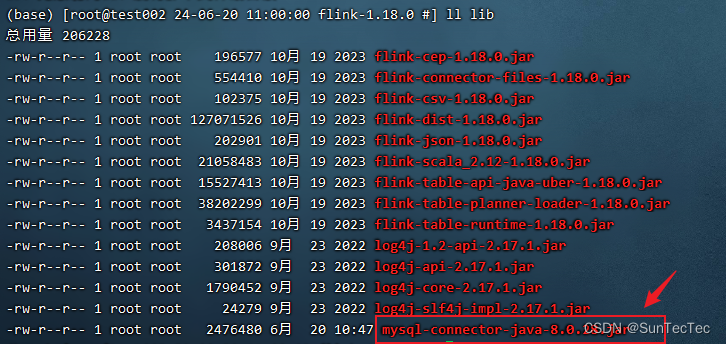

问题:flink lib 加入 mysql-connect-java.jar 否则flink任务会无法连接sink端,报错Exception

Failed to create Source Enumerator for source Source: Flink CDC Event Source: mysql java.lang.NoClassDefFoundError: com/mysql/cj/jdbc/Driver

解决:flink lib 安装完成后,引入 mysql-connect-java.jar ,配置如下

补充:查找 flink 路径下的 jar包是否包含该类

(base) [root@test002 24-06-20 13:38:47 flink-cdc-3.1.0 #] grep -r com.mysql.cj.jdbc.Driver *

匹配到二进制文件 lib/mysql-connector-java-8.0.27.jar