🌈个人主页: 鑫宝Code

🔥热门专栏: 闲话杂谈| 炫酷HTML | JavaScript基础

💫个人格言: "如无必要,勿增实体"

文章目录

K-Means算法详解:从原理到实践

引言

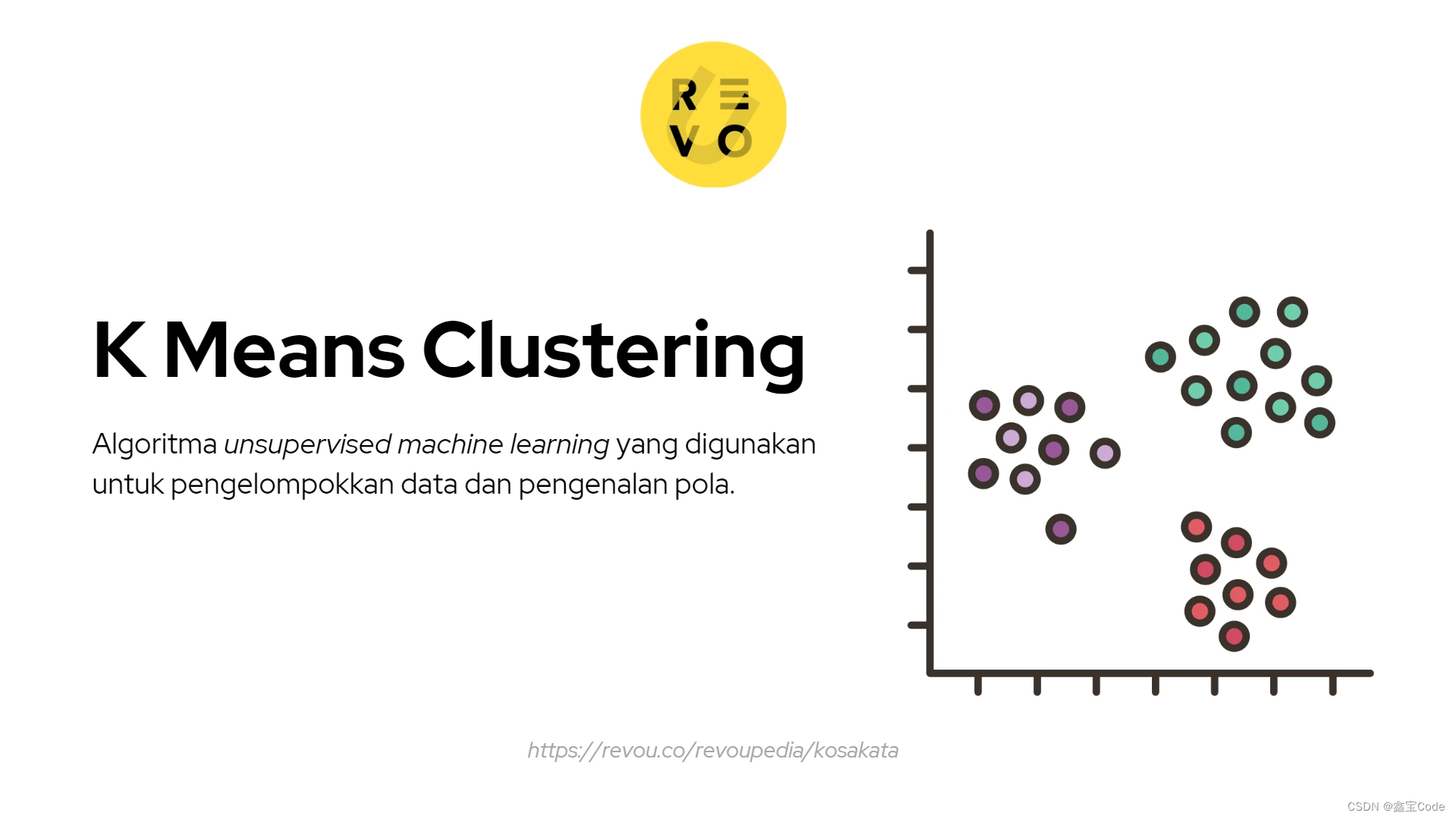

K-Means是一种广泛应用于数据挖掘、机器学习领域的无监督学习算法,主要用于聚类分析。它的核心思想是将数据集划分为K个簇(cluster),每个簇内的数据相似度较高,而不同簇间的数据相似度较低。本文将深入浅出地介绍K-Means算法的基本原理、算法流程、优缺点、参数选择、优化方法以及实际应用案例,帮助读者全面理解和掌握这一经典算法。

1. 基本原理

1.1 簇与距离度量

- 簇:K-Means的目标是将数据集分割成K个互不相交的子集,每个子集即为一个簇。

- 距离度量:衡量数据点间相似度的标准,常用欧氏距离。对于高维数据,也可以采用其他距离度量方法,如曼哈顿距离、余弦相似度等。

1.2 初始化与迭代

- 初始化:随机选择K个数据点作为初始聚类中心。

- 迭代过程 :

- 分配:将每个数据点分配给最近的聚类中心所在的簇。

- 更新:根据每个簇内数据点的均值(对于连续属性)或众数(对于离散属性)重新计算聚类中心。

- 终止条件:当聚类中心不再发生显著变化或达到预设的最大迭代次数时停止。

2. 算法流程

markdown

1. 设定聚类数量K,随机选取K个数据点作为初始质心。

2. 对于数据集中的每个数据点,计算其与所有质心的距离,将其归入最近的质心所代表的簇。

3. 重新计算每个簇的质心,方法是取簇中所有点的均值。

4. 检查质心是否发生变化。如果质心有变化,则返回步骤2;否则,结束,输出最终的簇划分结果。以下是一个使用Python和scikit-learn库实现K-Means聚类算法的示例代码。这个例子包括了从数据准备、模型训练到结果可视化的基本流程。

首先,请确保已经安装了numpy, matplotlib, 和 scikit-learn 这几个必要的库。如果没有安装,可以通过运行 pip install numpy matplotlib scikit-learn 来安装它们。以下代码仅供参考🐶

py

# 导入所需库

import numpy as np

import matplotlib.pyplot as plt

from sklearn.cluster import KMeans

from sklearn.datasets import make_blobs

# 生成模拟数据集

# make_blobs 用于创建带有标签的数据集,这里我们忽略真实标签,仅用于演示

X, _ = make_blobs(n_samples=300, centers=4, cluster_std=0.60, random_state=0)

# 使用KMeans进行聚类

kmeans = KMeans(n_clusters=4) # 设置聚类数量为4

kmeans.fit(X)

# 预测每个样本的簇标签

labels = kmeans.predict(X)

# 可视化聚类结果

plt.figure(figsize=(8, 6))

colors = ['r', 'g', 'b', 'y']

for i in range(4):

plt.scatter(X[labels == i, 0], X[labels == i, 1], c=colors[i], label=f'Cluster {i+1}')

# 绘制聚类中心

centers = kmeans.cluster_centers_

plt.scatter(centers[:, 0], centers[:, 1], c='black', marker='x', s=200, label='Centroids')

plt.title('K-Means Clustering')

plt.xlabel('Feature 1')

plt.ylabel('Feature 2')

plt.legend()

plt.show()

# 输出每个聚类中心的位置

print("Cluster Centers:")

print(kmeans.cluster_centers_)这段代码首先生成了一个包含四个明显簇的数据集,然后使用KMeans类对其进行聚类,并通过颜色区分不同的簇。最后,它还绘制了每个簇的中心点。通过调整参数,您可以应用于自己的数据集上进行聚类分析。

3. 参数选择与优化

- K的选择:肘部法则、轮廓系数、Calinski-Harabasz指数等方法可以帮助确定最优的K值。

- 初始化方法:除了随机选择,还可以采用K-Means++策略,以提高算法的稳定性和收敛速度。

- 避免局部最优:多次运行算法并选择最佳聚类结果,或采用Mini-Batch K-Means等变体来探索更多解空间。

4. 优缺点分析

优点

- 简单直观:易于理解和实现。

- 效率高 :对于大规模数据集尤其有效,时间复杂度为O(nKI),其中n是数据点数量,I是迭代次数。

- 可解释性强:输出直观,便于分析。

缺点

- 对初始质心敏感:不同的初始质心可能导致完全不同的聚类结果。

- 需要预先设定K值:实际应用中K的选择往往依赖经验或试错。

- 假设各簇为凸形状且大小相近:对于非球形簇或大小差异大的数据集表现不佳。

- 对异常值敏感:异常值可能会严重影响聚类中心的计算。

5. 实际应用案例

5.1 客户细分

电商平台通过分析用户的购买行为、浏览记录等数据,利用K-Means算法对用户进行分群,为不同群体提供个性化推荐和服务,提升用户体验和销售转化率。

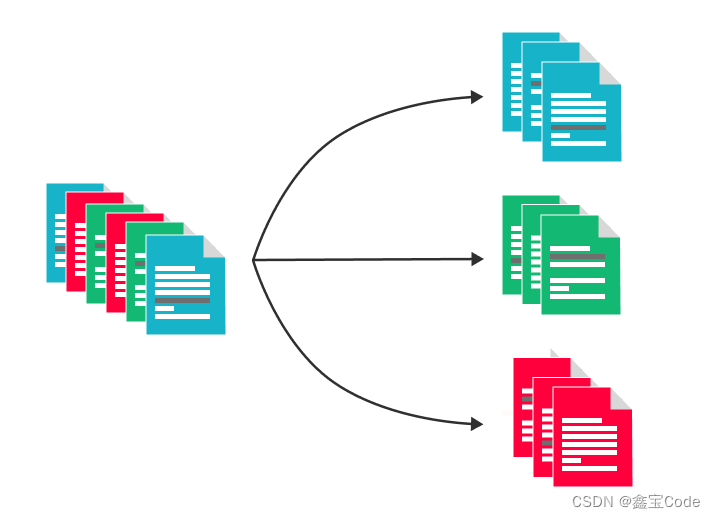

5.2 文档分类

在文本挖掘领域,K-Means可以用来对文档集合进行主题分类。通过将文档转换为TF-IDF向量表示,然后应用K-Means算法,可以自动将相似主题的文档归为一类。

5.3 图像分割

在图像处理中,K-Means可用于图像分割,通过对像素颜色值进行聚类,可以识别出图像中的不同区域,适用于背景去除、图像简化等场景。

6. 结语

K-Means算法以其简单高效的特点,在众多领域展现了强大的实用价值。然而,针对其存在的局限性,研究人员不断提出改进方法,如二分K-Means、谱聚类等,以适应更复杂的数据结构和应用场景。掌握K-Means不仅是数据科学基础的重要组成部分,也是进一步探索高级聚类技术的基石。希望本文能为读者理解并应用K-Means算法提供有益的指导。