【机器学习】12.十大算法之一支持向量机(SVM - Support Vector Machine)算法原理讲解

- 一·摘要

- 二·个人简介

- 三·基本概念

- 四·支持向量与超平面

-

-

- [4.1 超平面(Hyperplane)](#4.1 超平面(Hyperplane))

- [4.2 支持向量(Support Vectors)](#4.2 支持向量(Support Vectors))

- [4.3 核技巧(Kernel Trick)](#4.3 核技巧(Kernel Trick))

- [4.4 软间隔与正则化](#4.4 软间隔与正则化)

-

- 五·SVM算法原理

-

-

- [5.1 点到超平面的距离公式](#5.1 点到超平面的距离公式)

- [5.2 最大间隔的优化模型](#5.2 最大间隔的优化模型)

-

- 六·松弛变量

-

-

- [6.1 松弛变量的定义](#6.1 松弛变量的定义)

- [6.2 优化模型的修改](#6.2 优化模型的修改)

- [6.3 软间隔与硬间隔](#6.3 软间隔与硬间隔)

- [6.4 核技巧与松弛变量](#6.4 核技巧与松弛变量)

-

- 七·核函数

-

-

- [7.1 核函数的基本概念](#7.1 核函数的基本概念)

- [7.2 常用的核函数](#7.2 常用的核函数)

- [7.3 核函数的作用](#7.3 核函数的作用)

-

一·摘要

支持向量机(SVM)是一种高效的监督学习算法,广泛应用于分类和回归问题。它通过在特征空间中寻找一个最优的超平面来区分不同类别的数据点,目标是最大化两类数据点之间的间隔,从而提高模型的泛化能力。SVM的关键概念包括超平面、间隔、支持向量以及核函数,其中核函数允许SVM处理非线性问题,通过将数据映射到更高维的空间来寻找线性可分的超平面。此外,软间隔和正则化技术用于处理数据的非完全线性可分性,同时控制模型复杂度,防止过拟合。SVM的实现涉及选择合适的核函数,构建并求解一个凸二次规划问题,以及评估和应用训练好的模型。它的优点在于模型简单、易于实现,且具有良好的泛化能力,但计算复杂度高,对核函数和参数选择敏感,且在处理大规模数据集时可能会遇到性能瓶颈。

二·个人简介

🏘️🏘️个人主页:以山河作礼。

🎖️🎖️:Python领域新星创作者,CSDN实力新星认证,CSDN内容合伙人,阿里云社区专家博主,新星计划导师,在职数据分析师。

💕💕悲索之人烈焰加身,堕落者不可饶恕。永恒燃烧的羽翼,带我脱离凡间的沉沦。

🐘 希望大家能持续支持,共同向前迈进!😁 如果您觉得文章有价值, 欢迎留言💬,点赞👍,收藏🔖并关注我们➕🤝。  🪐💫💫💫💫💫💫💫热门专栏💫💫💫💫💫💫💫🪐

🪐💫💫💫💫💫💫💫热门专栏💫💫💫💫💫💫💫🪐

| 类型 | 专栏 |

|---|---|

| Python基础 | Python基础入门---详解版 |

| Python进阶 | Python基础入门---模块版 |

| Python高级 | Python网络爬虫从入门到精通🔥🔥🔥 |

| Web全栈开发 | Django基础入门 |

| Web全栈开发 | HTML与CSS基础入门 |

| Web全栈开发 | JavaScript基础入门 |

| Python数据分析 | Python数据分析项目🔥🔥 |

| 机器学习 | 机器学习算法🔥🔥 |

| 人工智能 | 人工智能 |

三·基本概念

支持向量机(Support Vector Machine, SVM)是一种强大的机器学习算法,主要用于解决分类和回归问题。它基于统计学习理论中的结构风险最小化原则,通过在特征空间中寻找一个最优的决策边界,即超平面,来区分不同的数据类别。这个超平面的选择旨在最大化数据点到超平面的最短距离,这个距离被称为间隔(margin)。间隔越大,模型的泛化能力通常越好。

SVM的核心是支持向量,这是一组对确定超平面位置和方向至关重要的数据点,它们是距离超平面最近的点。如果数据不是线性可分的,SVM通过引入核函数将原始数据映射到一个更高维的空间,在这个新空间中寻找线性可分的超平面。常用的核函数包括线性核、多项式核、径向基函数(RBF)核等。

为了处理数据中的噪声和异常点,SVM引入了软间隔的概念,允许一些数据点被错误分类,以换取更好的泛化性能。同时,通过正则化项控制模型的复杂度,避免过拟合。SVM的训练过程通常涉及到求解一个凸二次规划问题,以找到最优的超平面参数。

见下图,在一个二维环境中,其中点R,S,G点和其它靠近中间黑线的点可以看作为支持向量,它们可以决定分类器,也就是黑线的具体参数。

四·支持向量与超平面

支持向量和超平面是支持向量机(SVM)算法中的核心概念。下面我将详细解释这两个概念:

4.1 超平面(Hyperplane)

在数学中,超平面是一个线性子空间,其维度比它所在的空间低一维。例如,在二维空间中,超平面是一条直线;在三维空间中,它是平面;在更高维空间中,它仍然是一个线性边界,但可能难以直观理解。

在SVM中,超平面用于将数据分为不同的类别。对于二维空间,你可以想象超平面是一条直线,将空间分为两部分,每部分包含一个类别的数据点。对于更高维度的空间,超平面是一个更高维的线性边界,同样用于分隔数据点。

4.2 支持向量(Support Vectors)

支持向量是那些位于距离超平面最近的数据点。它们是SVM在训练过程中用来确定超平面位置的关键数据点。如果从这些点中移除任何一个,都会改变超平面的位置和方向。

支持向量之所以重要,是因为它们定义了数据点之间的边界(即间隔)。SVM的目标是找到这样一个超平面,使得最近的这些支持向量(即距离超平面最近的数据点)与超平面之间的距离(间隔)最大化。这个间隔的大小是衡量模型泛化能力的一个重要指标。

4.3 核技巧(Kernel Trick)

在实际应用中,数据可能不是线性可分的。这时,SVM可以使用核技巧来处理非线性问题。核函数可以将原始数据映射到一个更高维的空间,在新的空间中寻找一个线性可分的超平面。常用的核函数包括线性核、多项式核、径向基函数(RBF)核等。

4.4 软间隔与正则化

在处理实际数据时,可能无法找到一个完美的超平面来完全分开所有数据点。这时,SVM引入了软间隔的概念,允许一些数据点被错误分类,以换取更好的泛化能力。同时,通过正则化项(通常是法向量的范数)来控制模型的复杂度,避免过拟合。

五·SVM算法原理

5.1 点到超平面的距离公式

点到超平面的距离公式用于计算一个点到给定超平面的最短距离。超平面在n维空间中可以用以下方程式表示:

其中:

w 是一个n维的法向量,垂直于超平面。

x 是一个n维的点,位于空间中。

b 是超平面的偏置项。

点 x 到这个超平面的垂直距离 d 可以通过以下公式计算:

这个公式的几何意义是:从点 𝑥 向超平面作垂线,垂足到点 𝑥的距离就是𝑑这个距离也代表了点 𝑥到超平面的"间隔"。在支持向量机中,间隔的大小是非常重要的,因为它与模型的泛化能力有关。SVM的目标是找到这样一个超平面,使得间隔最大化,即所有数据点到这个超平面的距离之和最大。

5.2 最大间隔的优化模型

线性可分情况下的优化模型

当数据是线性可分的,即存在一个超平面能够完美地将不同类别的数据点分开,SVM的目标是找到一个超平面,使得距离最近的两个数据点(即支持向量)到超平面的距离最大化。这个距离被称为间隔(margin)。

超平面可以表示为:

最大间隔优化问题

SVM的目标函数是最大化间隔,可以表示为:

引入拉格朗日乘子

引入拉格朗日乘子

对偶问题

六·松弛变量

在支持向量机(SVM)中,松弛变量(Slack Variables)是引入的一种机制,用于处理数据集中的非线性可分情况。在理想情况下,如果数据是线性可分的,SVM可以找到一个超平面将不同类别的数据点完全分开,同时最大化间隔。然而,在现实世界中,很多数据集并不是完全线性可分的,这就需要使用松弛变量来允许一些数据点被错误分类,从而提高模型的泛化能力。

6.1 松弛变量的定义

6.2 优化模型的修改

这里的 𝐶是一个正的调节参数,用于控制模型对误分类的惩罚程度。𝐶的值越大,模型对误分类的惩罚越重,越倾向于找到没有误分类的解;𝐶的值越小,模型对误分类的容忍度越高,越容易找到间隔更大的解,即使这意味着更多的误分类。

6.3 软间隔与硬间隔

- 硬间隔(Hard Margin):没有引入松弛变量的SVM,要求所有数据点都在间隔边界的外侧或边界上,即不允许任何误分类。

- 软间隔(Soft Margin):引入了松弛变量的SVM,允许一些数据点在间隔边界的内侧,即允许一定程度的误分类。 核技巧与松弛变量.

6.4 核技巧与松弛变量

即使在非线性可分的情况下,通过使用核技巧将数据映射到高维空间,结合松弛变量,SVM仍然可以找到具有最大间隔的超平面。

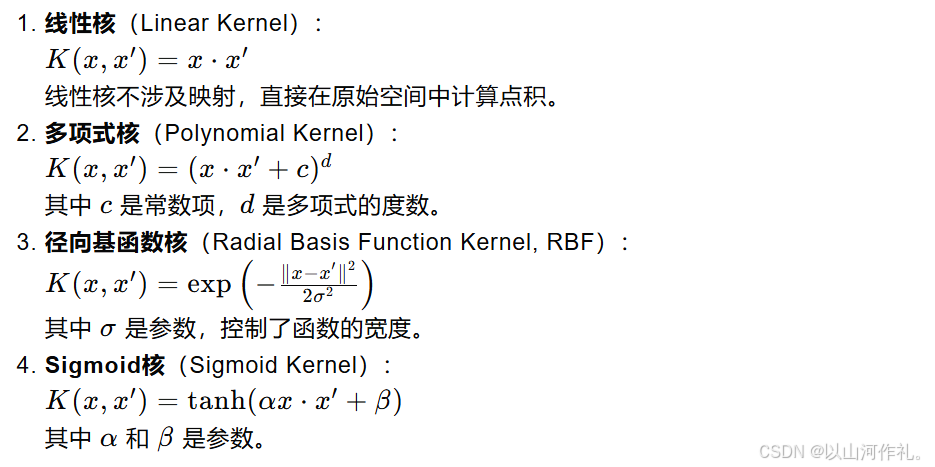

七·核函数

核函数(Kernel Function)是支持向量机(SVM)中的一种重要工具,它允许SVM在高维空间中有效地处理非线性问题。核函数的基本思想是通过映射将原始数据从低维空间映射到高维空间,在这个高维空间中寻找数据的线性可分性。

7.1 核函数的基本概念

7.2 常用的核函数

7.3 核函数的作用

- 处理非线性问题:通过映射到高维空间,核函数使得原本在低维空间中线性不可分的数据在高维空间中线性可分。

- 提高模型表达能力:不同的核函数可以捕捉数据的不同特征,提高模型的表达能力。

- 减少计算复杂度:使用核函数可以避免直接在高维空间中进行计算,从而减少计算复杂度。