JCR一区级 | Matlab实现SO-Transformer-LSTM多变量回归预测(蛇群算法优化)

目录

效果一览

基本介绍

1.【JCR一区级】Matlab实现SO-Transformer-LSTM多变量回归预测,蛇群算法(SO)优化Transformer-LSTM组合模型(程序可以作为JCR一区级论文代码支撑,目前尚未发表);

2.优化参数为:学习率,隐含层节点,正则化参数,运行环境为Matlab2023b及以上;

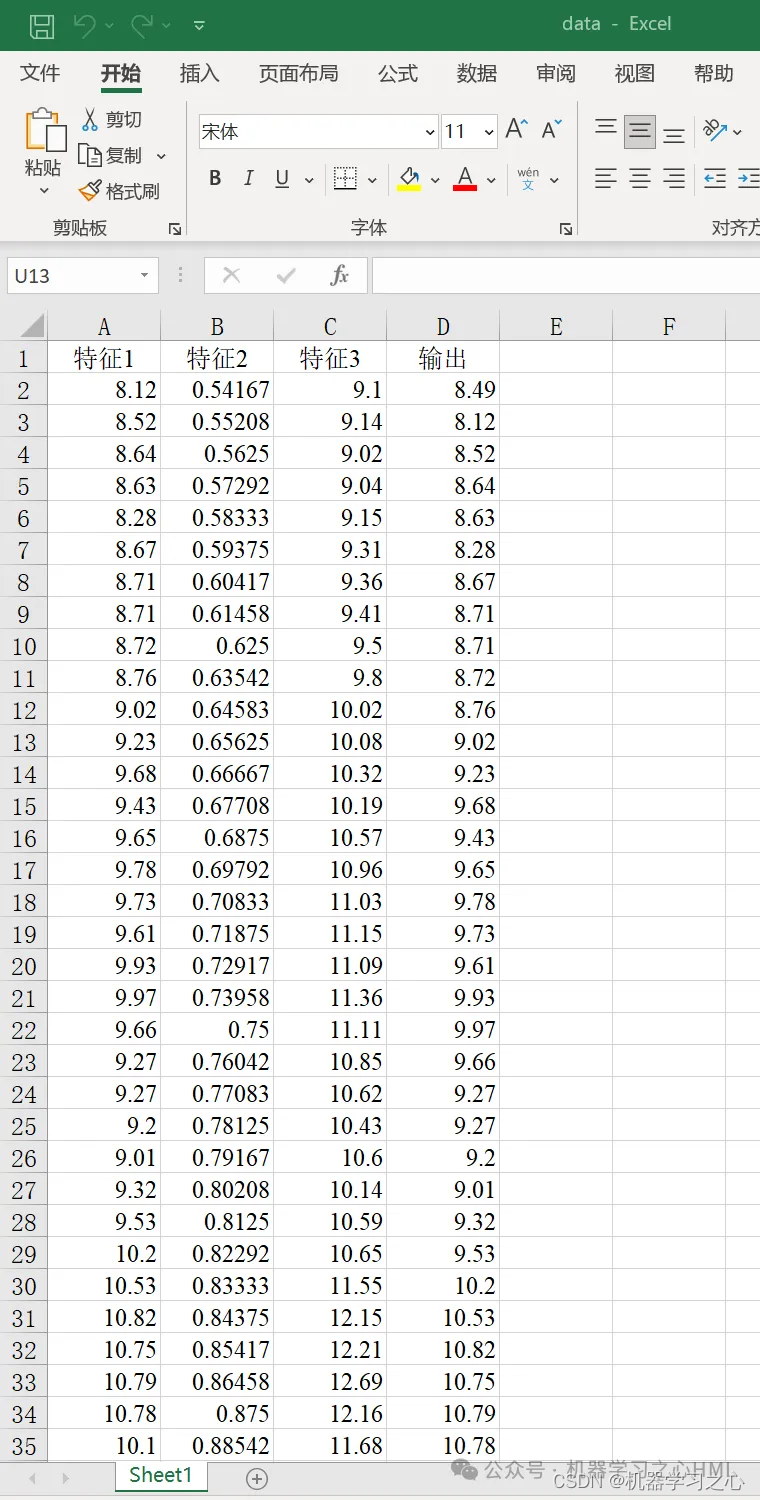

3.data为数据集,输入多个特征,输出单个变量,多变量回归预测,main.m为主程序,运行即可,所有文件放在一个文件夹;

4.命令窗口输出R2、MSE、RMSE、MAE、MAPE、MBE等多指标评价;

5.模型只是提供一个衡量数据集精度的方法,因此无法保证替换数据就一定得到您满意的结果。

程序设计

- 完整程序和数据下载私信博主回复Matlab实现SO-Transformer-LSTM多变量回归预测(蛇群算法优化)。

clike

%% 清空环境变量

warning off % 关闭报警信息

close all % 关闭开启的图窗

clear % 清空变量

clc % 清空命令行

%% 划分训练集和测试集

P_train = res(1: num_train_s, 1: f_)';

T_train = res(1: num_train_s, f_ + 1: end)';

M = size(P_train, 2);

P_test = res(num_train_s + 1: end, 1: f_)';

T_test = res(num_train_s + 1: end, f_ + 1: end)';

N = size(P_test, 2);

%% 数据归一化

[P_train, ps_input] = mapminmax(P_train, 0, 1);

P_test = mapminmax('apply', P_test, ps_input);

[t_train, ps_output] = mapminmax(T_train, 0, 1);

t_test = mapminmax('apply', T_test, ps_output);

%% 数据平铺

P_train = double(reshape(P_train, f_, 1, 1, M));

P_test = double(reshape(P_test , f_, 1, 1, N));

t_train = t_train';

t_test = t_test' ;

%% 数据格式转换

for i = 1 : M

p_train{i, 1} = P_train(:, :, 1, i);

end

for i = 1 : N

p_test{i, 1} = P_test( :, :, 1, i);

end参考资料

1\] https://blog.csdn.net/kjm13182345320/article/details/128163536?spm=1001.2014.3001.5502 \[2\] https://blog.csdn.net/kjm13182345320/article/details/128151206?spm=1001.2014.3001.5502