文章目录

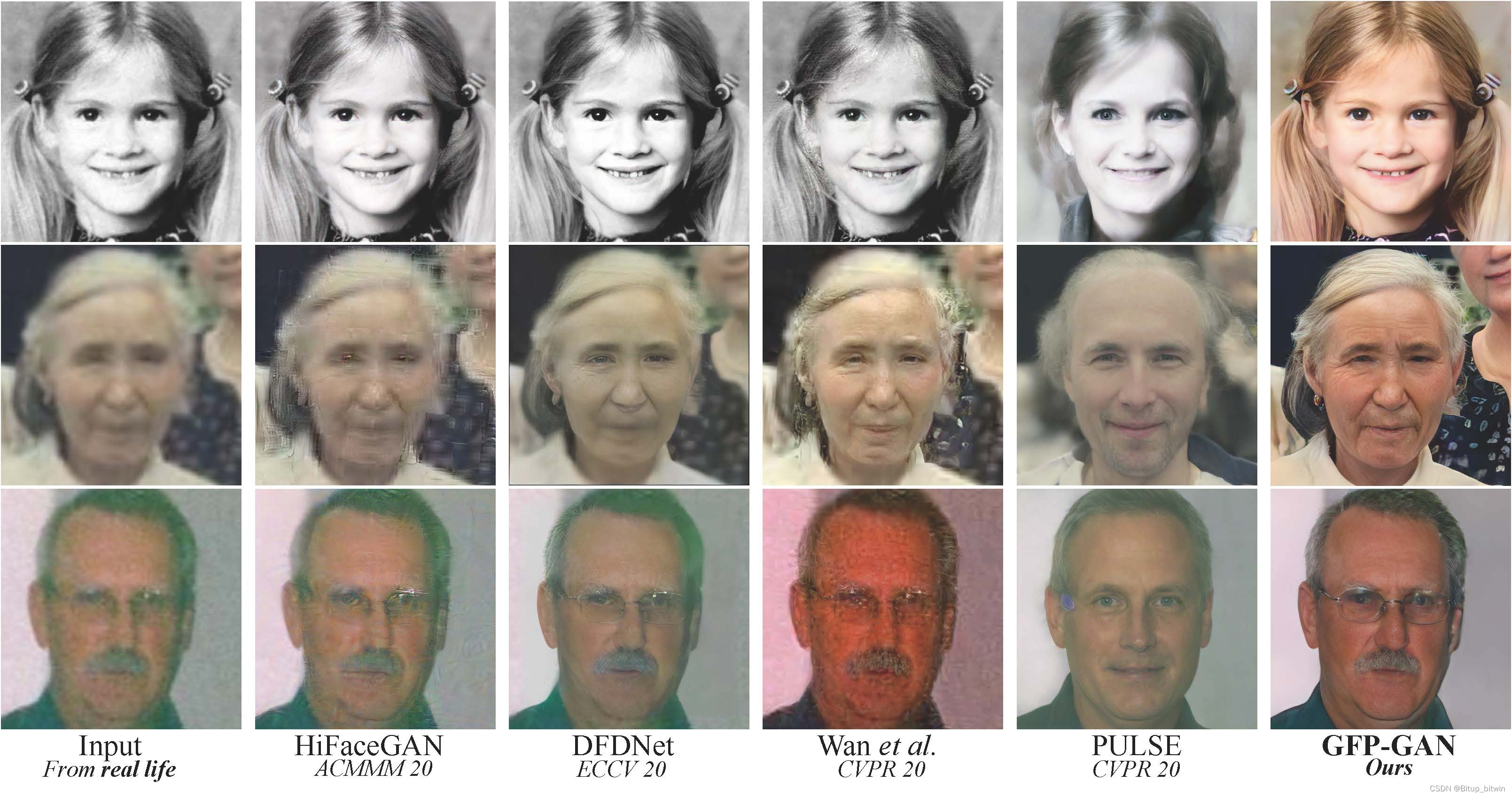

GFPGAN(Generative Facial Prior GAN)是一个开源的面部图像修复和增强工具,它利用生成对抗网络(GANs)技术,特别是引入了预训练的面部先验网络,来恢复和提升受损或低分辨率的人脸图像。GFPGAN在图像处理任务中表现出色,尤其在细节恢复和图像自然性方面表现突出。这个项目广泛应用于图像修复、面部增强、老照片翻新等领域。

GFPGAN的核心优势在于其强大的图像生成能力和优越的处理速度。相比于传统的图像修复方法,GFPGAN能够更好地捕捉面部特征,并在保持自然逼真的前提下修复图像细节。这使得它在诸如老照片修复、低质量视频帧提升等实际应用中具备很大的潜力。

https://github.com/TencentARC/GFPGAN?tab=readme-ov-file

安装使用教程

1、下载项目代码并创建环境

下载代码

python

git clone https://github.com/TencentARC/GFPGAN.git

#进入目录

cd GFPGAN创建虚拟环境

python

python -m venv venv进入虚拟环境第二次进入,就在该目录下直接输入以下命令就行

python

.\venv\Scripts\activate退出虚拟环境

python

deactivate2、安装必要库

python

# Install basicsr - https://github.com/xinntao/BasicSR

# We use BasicSR for both training and inference

pip install basicsr

# Install facexlib - https://github.com/xinntao/facexlib

# We use face detection and face restoration helper in the facexlib package

pip install facexlib

pip install -r requirements.txt

python setup.py develop

# If you want to enhance the background (non-face) regions with Real-ESRGAN,

# you also need to install the realesrgan package

pip install realesrgan

python

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu1183、下载预训练模型

模型下载 放在目录experiments/pretrained_models

4、避坑

1、首先查看下torch的版本

python

pip show torchvision2、我本地尝试,是可以

python

pip install --upgrade torchvision==0.12.0

python

pip index versions numpy