为了有效地执行大型语言模型(LLM)推理,了解GPU VRAM需求至关重要。VRAM对于存储模型参数、激活、处理批量大小和精度设置至关重要。估算VRAM使用情况的基本公式是:参数数×(精度/ 8)× 1.2。现代优化技术和框架可以进一步减少VRAM的需求。像VRAM Estimator, Hugging Face Accelerate Model Memory Calculator和LLM.deploy()这样的工具可以帮助估计推理和训练的VRAM需求。这些工具提供了内存使用的详细细分,使其更容易为LLM任务优化GPU性能。

在本文中,我们将深入研究如何计算执行LLM推理所需的VRAM数量。确定在LLM上运行或执行推理所需的GPU VRAM通常是一个挑战。例如,如果我们考虑LLaMA3.1 8B模型,VRAM需求是什么?是否单个GPU即可满足要求?需要多少VRAM来进行有效的推理?下面的内容将带你完成一个基本的计算,并介绍各种工具,这些工具可以帮助估计推理和在某些情况下训练所需的VRAM。

什么是VRAM?

首先,有必要了解llm如何利用VRAM(视频随机存取存储器)。基本上,VRAM是gpu中使用的一种特殊类型的内存。VRAM发明于20世纪90年代末,最初设计用于图像和图形渲染,促进加速计算任务所需的高计算。与标准系统RAM相比,VRAM提供高带宽,使GPU和内存之间的数据传输速度更快。这种能力不仅局限于图像;它扩展到处理各种格式的大量数据,使其对于现代计算任务(包括LLM推理)非常宝贵。

为什么VRAM对llm很重要

在llm的背景下,VRAM在存储模型参数、激活、管理批量大小和处理不同精度设置方面起着关键作用。有效利用VRAM对于优化llm在推理过程中的性能至关重要,确保模型能够快速准确地处理数据。通过了解如何利用VRAM并使用正确的工具,可以有效地估计和优化LLM任务的VRAM需求。

llm依赖于VRAM实现几个关键功能:

模型参数:在推理过程中,数百万,数十亿甚至数万亿的参数存储在VRAM中。这些参数是模型生成连贯和上下文相关输出的能力的支柱。

激活:LLM的每一层都会生成大量的激活数据,这些数据临时存储在VRAM中。这些激活是模型用来产生最终输出的中间计算。

批处理大小:更大的批处理大小需要更多的VRAM,因为模型必须同时处理更多的输入。批大小直接影响需要并行处理的数据量。

精度:这是指使用的浮点精度,如FP16、FP32、INT8、INT4等。精度的选择既影响模型的内存占用,也影响模型的计算效率。

手动估计VRAM使用情况

要估计LLM的VRAM使用情况,可以使用以下公式:

这里的1.2占是一个经验因子,用于激活所需的额外20%的VRAM和推理过程中使用的其他内存。

比如我们考虑使用FP16精度的LLaMA3.1 8B等8B参数模型。那么我们需要的VRAM如下:

8*16/8*1.2=19G或者我们可以简单的计算为 fp16的8B模型需要 82=16G 的显存,而 int8的模型需要81=8G显存,int4的的模型需要8/2=4G显存,这样记忆会方便很多,也可以让我们有一个直观的初步印象。

高级计算工具

下面我们介绍一些高级计算的工具

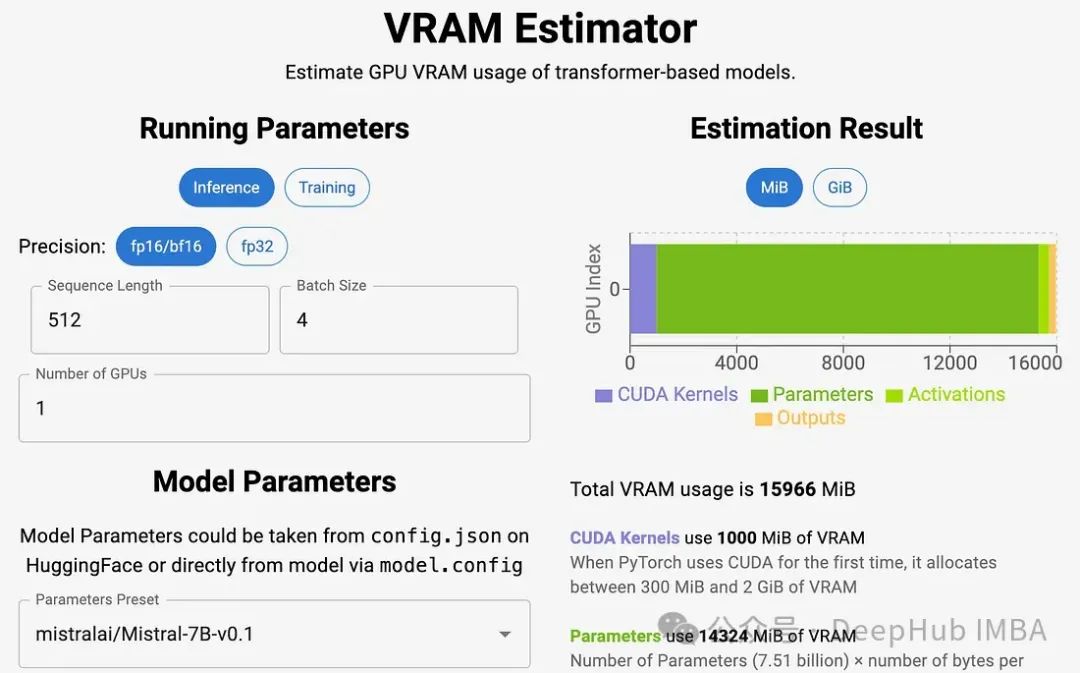

VRAM Estimator:

这个工具可以估计基于transformer的模型用于推理和训练的GPU VRAM使用情况。它可以允许输入各种参数,如模型名称,精度,最大序列长度,批量大小,gpu数量。提供参数、激活、输出和CUDA内核的VRAM使用情况的详细细分。

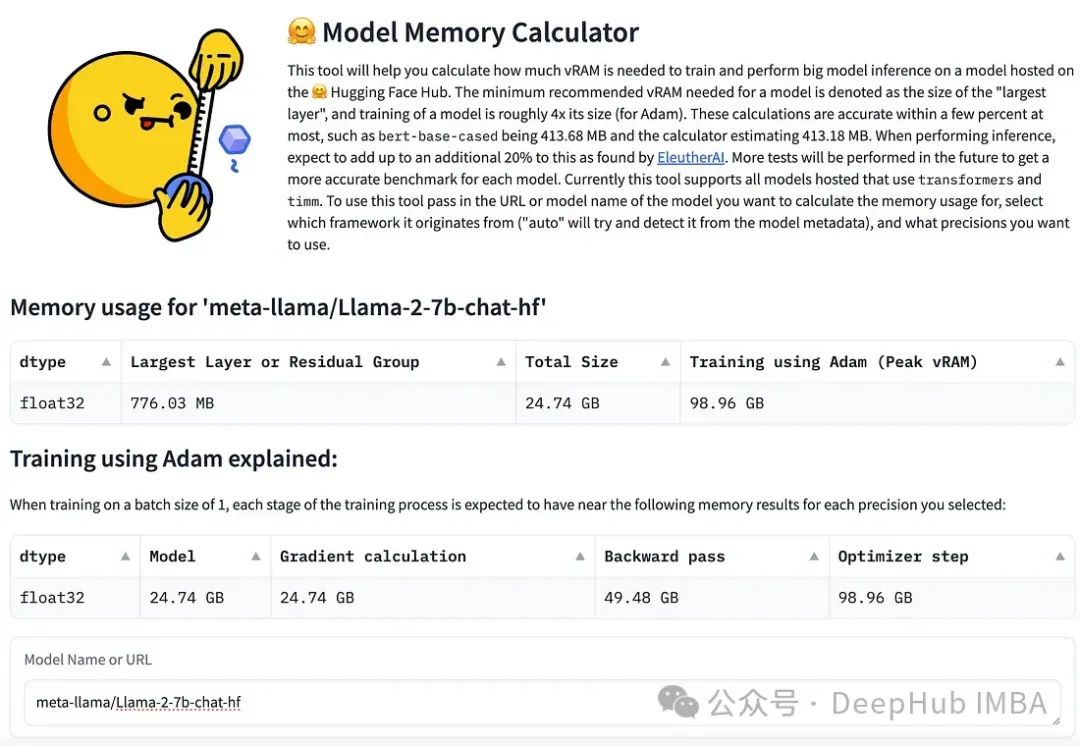

Hugging Face Accelerate Model Memory Calculator:

链接:https://huggingface.co/spaces/hf-accelerate/model-memory-usage

这个工具可以计算用于推理和训练的模型的内存使用量。因为是Hugging Face的链接,所以可以输入模型名称或URL,该工具将提供内存使用情况的全面细分,包括数据类型、最大层、总大小和使用不同优化器的训练内存使用情况。

LLM.deploy ():

链接:https://huggingface.co/spaces/Vokturz/can-it-run-llm

这是一个基于Transformer的更全面的工具,允许输入各种参数,并提供内存使用的详细细分。提供关于在推理和训练期间如何分配和利用内存的深入分析。

总结

VRAM对于llm、存储参数、激活、管理批量大小和处理精度设置至关重要。除了手动计算以外,我们介绍的这些工具可以极大地帮助你估计LLM推理和训练所需的VRAM。通过利用这些资源,可以对硬件需求做出明智的决策,并优化模型的性能。如果你知道任何其他有用的工具,请留言分享。

https://avoid.overfit.cn/post/c3051f824ee24d0690bf46ea4daa3ec6