Python 爬虫是一种强大的工具,用于从网页中提取数据。这里,我将通过一个简单的实战案例来展示如何使用 Python 和一些流行的库(如 requests 和 BeautifulSoup)来抓取网页数据。

实战案例:抓取一个新闻网站的头条新闻标题和链接

假设我们要从一个新闻网站(这里以虚构的 news.example.com 为例)抓取头条新闻的标题和链接。

步骤 1: 安装必要的库

首先,确保你已经安装了 requests 和 beautifulsoup4。如果没有安装,可以通过 pip 安装:

python

pip install requests beautifulsoup4步骤 2: 编写爬虫代码

python

import requests

from bs4 import BeautifulSoup

def fetch_headlines(url):

# 发送 HTTP GET 请求

response = requests.get(url)

# 检查请求是否成功

if response.status_code == 200:

# 使用 BeautifulSoup 解析 HTML

soup = BeautifulSoup(response.text, 'html.parser')

# 假设头条新闻位于一个具有特定类名的 div 中,这里以 'headline' 为例

headlines = soup.find_all('div', class_='headline')

# 遍历所有头条新闻

for headline in headlines:

# 假设标题和链接分别位于 h2 和 a 标签中

title = headline.find('h2').get_text(strip=True)

link = headline.find('a')['href']

# 打印标题和链接

print(f"标题: {title}, 链接: {link}")

else:

print("请求失败,状态码:", response.status_code)

# 调用函数,传入新闻网站的 URL

fetch_headlines('http://news.example.com')注意事项:-

网页结构 :上面的代码假设了网页的特定结构(如

div标签的类名为headline,标题在h2标签中,链接在a标签中)。在实际应用中,你需要根据目标网页的实际结构来调整选择器。 -

异常处理:在实际应用中,你可能需要添加更多的异常处理逻辑,比如处理网络错误、解析错误等。

-

遵守网站规则 :在编写爬虫时,请确保遵守目标网站的

robots.txt文件和其他使用条款,避免对网站造成不必要的负担或侵犯版权。 -

使用代理和头部信息 :有时,为了绕过反爬虫机制,你可能需要设置请求头部(如

User-Agent)或使用代理服务器。 -

数据存储:抓取的数据可能需要保存到文件、数据库或其他存储系统中,以便后续分析和使用。

通过上面的实战案例,你应该能够了解如何使用 Python 编写一个简单的网页爬虫。随着你对爬虫技术的深入了解,你可以尝试更复杂的网页结构和更高级的功能。

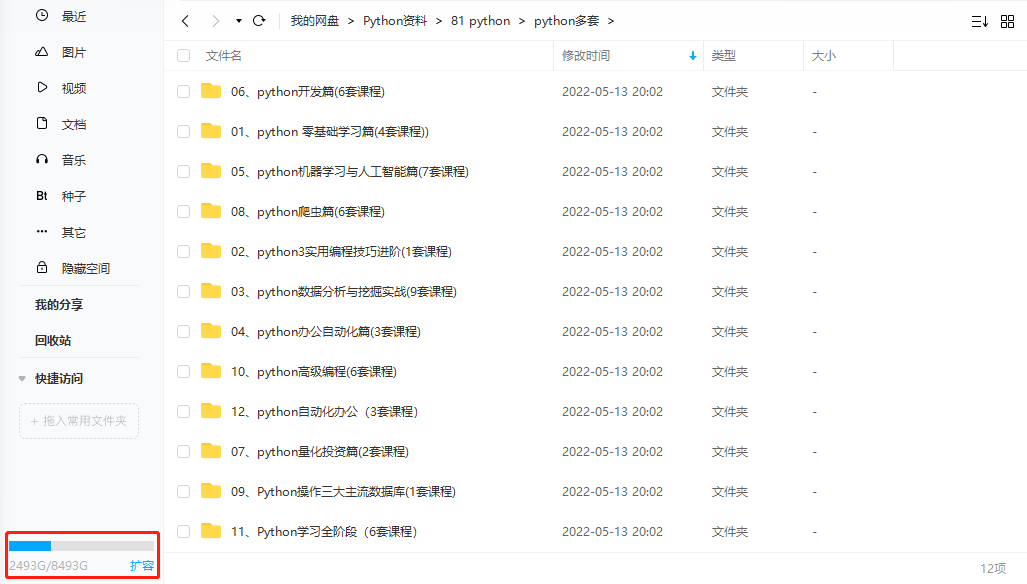

全套Python学习资料分享:

由于文章篇幅有限,文档资料内容较多,需要这些文档的朋友,可以加小助手v免费获取

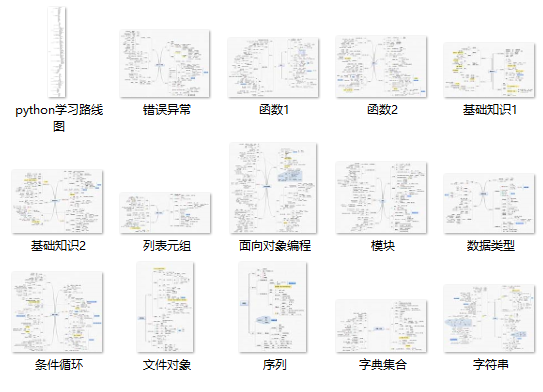

一、Python所有方向的学习路线

Python所有方向路线就是把Python常用的技术点做整理,形成各个领域的知识点汇总,它的用处就在于,你可以按照上面的知识点去找对应的学习资源,保证自己学得较为全面。

二、学习软件

工欲善其事必先利其器。学习Python常用的开发软件都在这里了,还有环境配置的教程,给大家节省了很多时间。

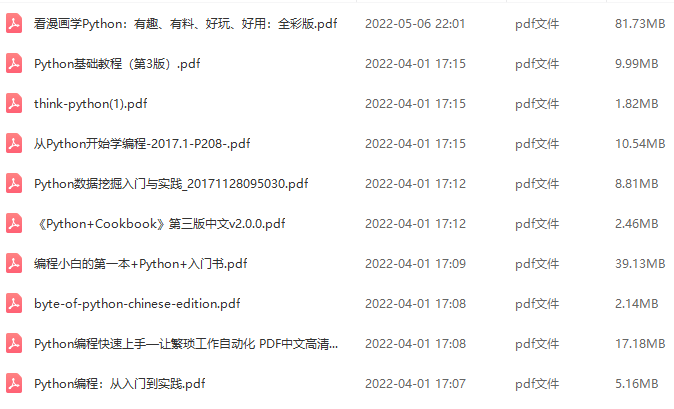

三、全套PDF电子书

书籍的好处就在于权威和体系健全,刚开始学习的时候你可以只看视频或者听某个人讲课,但等你学完之后,你觉得你掌握了,这时候建议还是得去看一下书籍,看权威技术书籍也是每个程序员必经之路。

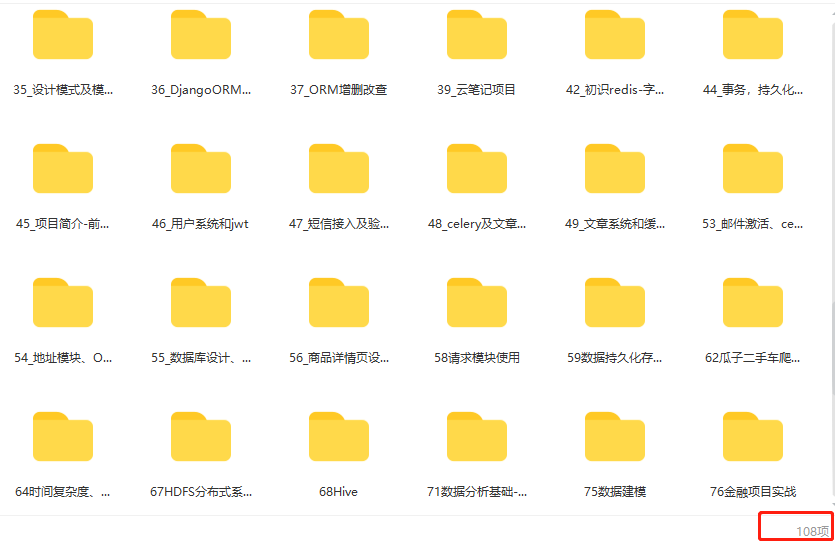

四、入门学习视频全套

我们在看视频学习的时候,不能光动眼动脑不动手,比较科学的学习方法是在理解之后运用它们,这时候练手项目就很适合了。

五、实战案例

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。