ETL与Kafka为何需要集成?

随着企业对实时流数据的处理要求越来越高,很多企业都把实时流数(日志、实时CDC采集数据、设备数据...)先推入到kafka中,再通过ETL对kafka中的数据进行消费通过ETL强大的数据的转换、清洗功能来进行数据的集成与分发。

实时数据流的处理对于企业洞察市场动态、优化业务流程、提升客户体验至关重要。Apache Kafka,作为业界领先的分布式流处理平台,为海量数据的实时传输提供了强大支持。而ETL(Extract, Transform, Load)过程在这一领域扮演着至关重要的角色。本文将深入探讨如何利用ETLCloud工具,实时处理Kafka中的流数据,并提供专业的技术细节和注意事项。

Kafka介绍

Kafka技术概览

Apache Kafka是一个分布式流处理平台,它能够高效地处理实时数据流。Kafka的核心是其消息队列,称为"主题"(Topics),数据以"记录"(Records)的形式存储在这些主题中。每个主题可以被分割成多个"分区"(Partitions),以支持并行处理和数据冗余。

Kafka连接与订阅机制

-

连接Kafka:首先,ETL工具需要与Kafka集群建立连接。这通常通过配置Kafka的ZooKeeper和Broker地址来实现。

-

订阅主题:ETL工具订阅特定的Kafka主题,以接收实时数据流。订阅机制允许ETL工具指定感兴趣的分区和偏移量,从而控制数据流的读取位置。

技术注意事项

-

数据序列化:Kafka中的数据需要序列化和反序列化。选择合适的序列化格式(如JSON、Avro)对于数据的高效传输和处理至关重要。

-

分区策略:合理设计分区策略可以提升数据吞吐量和并行处理能力,但也需要考虑数据的顺序性和一致性。

-

消费者组:在Kafka中,消费者组用于实现数据的负载均衡和故障转移。ETL工具应正确配置和管理消费者组,以确保数据的可靠处理。

ETLCloud与Kafka的集成

ETLCloud技术特点

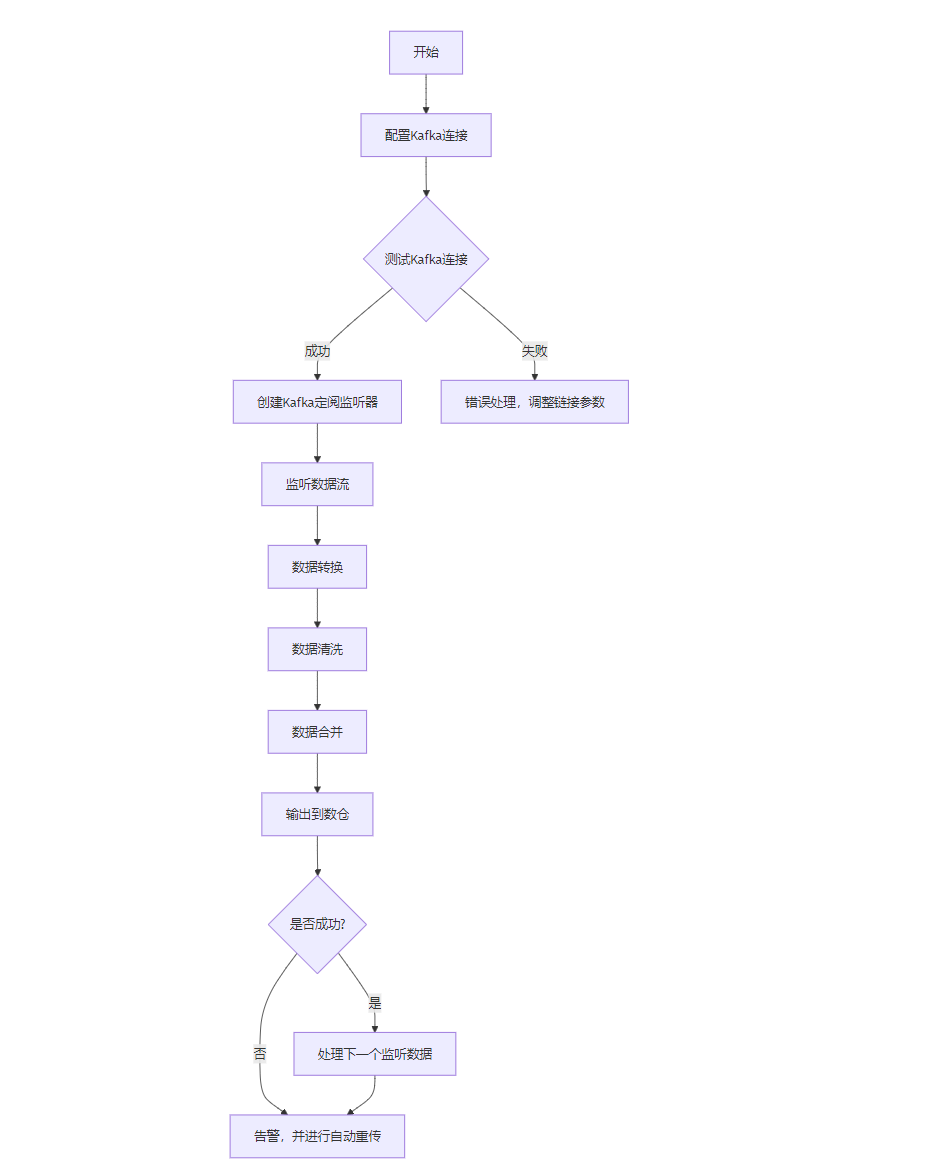

ETLCloud是一款新一代的ETL工具,它通过可视化界面简化了数据集成和处理流程。ETLCloud支持与多种数据源和目标系统的集成,包括Apache Kafka,下面是ETLCloud与Kafka的集成流程图

技术实施流程

-

配置Kafka连接:在ETLCloud中设置Kafka连接,包括必要的认证和加密设置。

-

设计ETL流程:利用ETLCloud的拖放界面设计数据流的转换和处理流程。

-

实施数据转换:应用数据清洗、转换规则,确保数据质量。

-

输出到目标系统:将处理后的数据实时输出到数据库、数据仓库或其他分析工具。

-

监控和优化:监控ETL流程的性能,根据需要进行优化。

连接Kafka

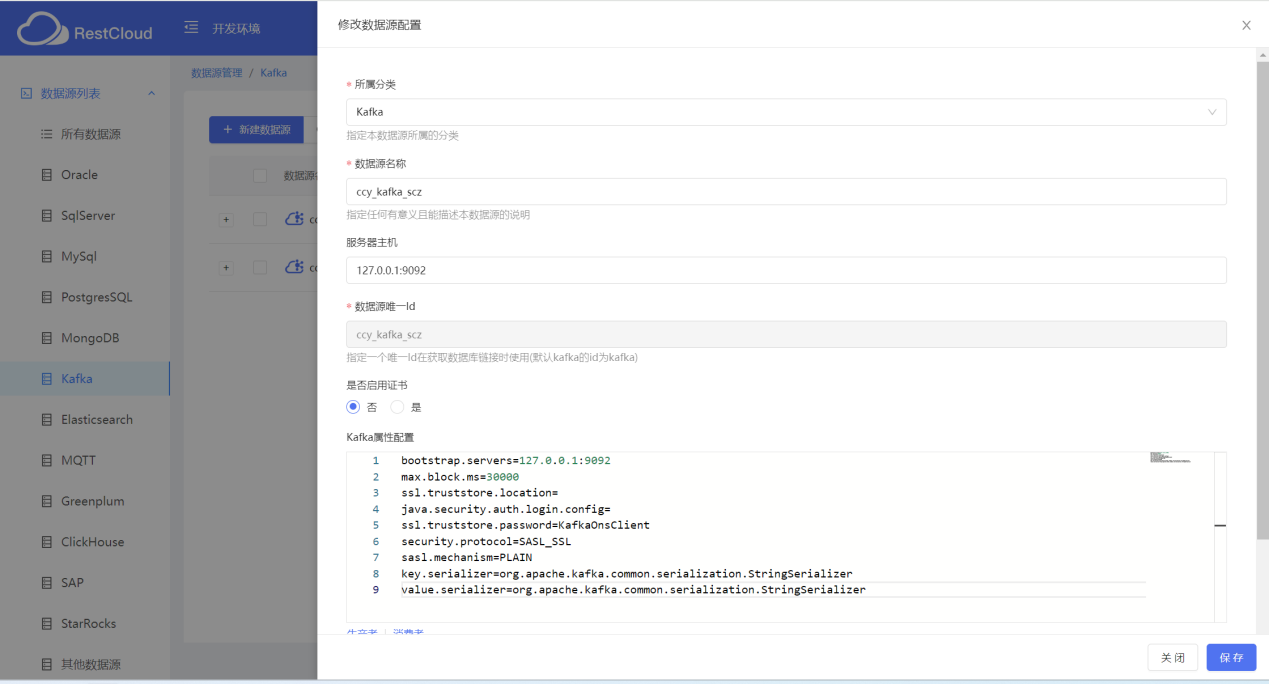

- 配置连接:在ETLCloud中,用户需要配置Kafka连接,包括Broker地址、端口、认证信息等。

在数据源管理中创建Kafka的链接

- 订阅主题:通过ETLCloud的界面,用户可以选择订阅Kafka中的特定主题,开始接收数据流。

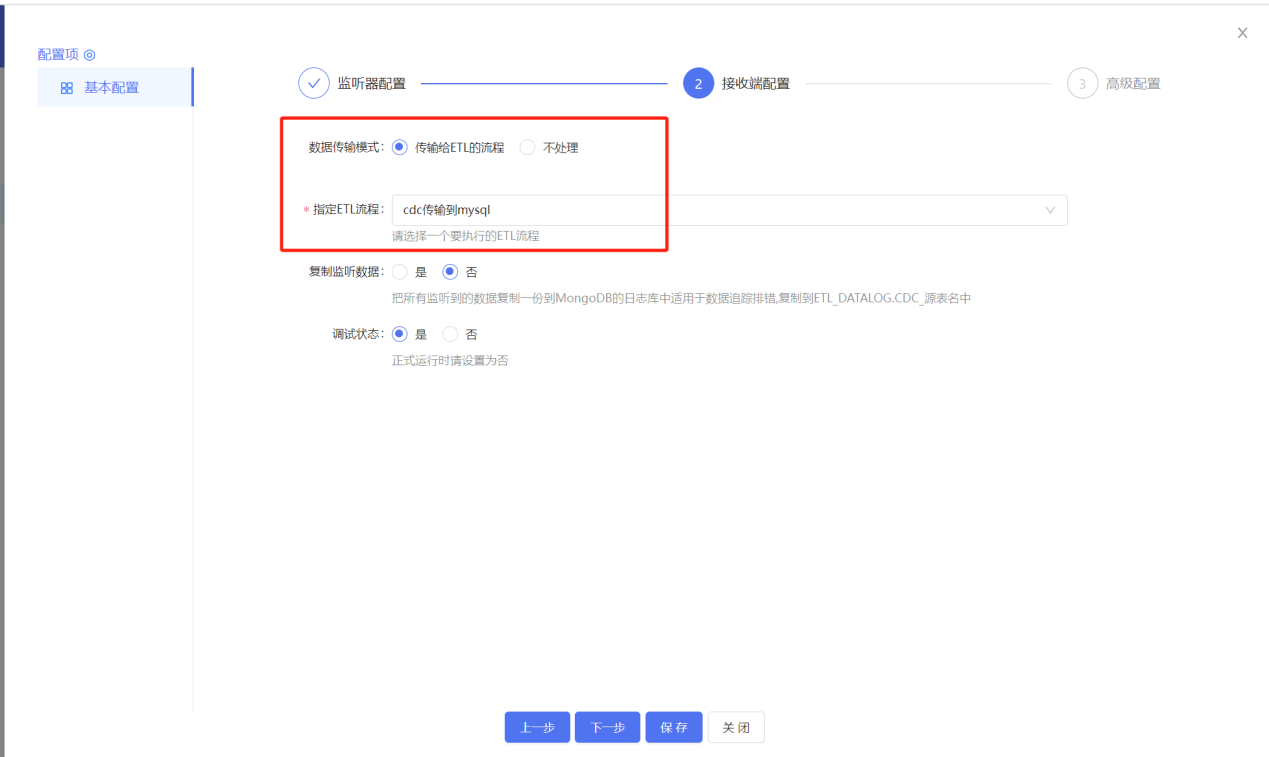

在ETLCloud的实时集成中创建一个Kafak的集成监听

实时数据处理

-

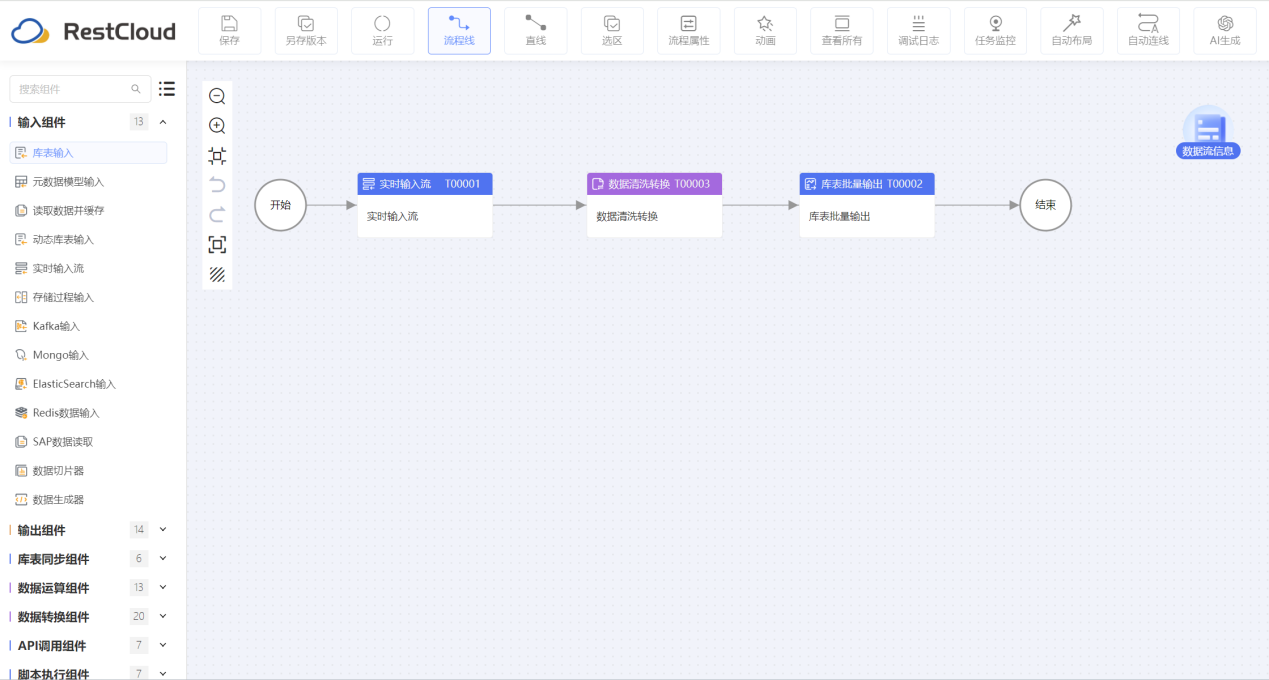

数据转换:ETLCloud提供了丰富的数据转换组件,包括数据清洗、格式转换、数据聚合等,以满足实时数据处理的需求。

-

实时输出:处理后的数据可以实时输出到目标系统,如数据库、数据仓库或实时分析平台。

配置一个接收端到ETL的流程:

设计一个ETL的数据清洗流程用来处理Kafka的数据流:

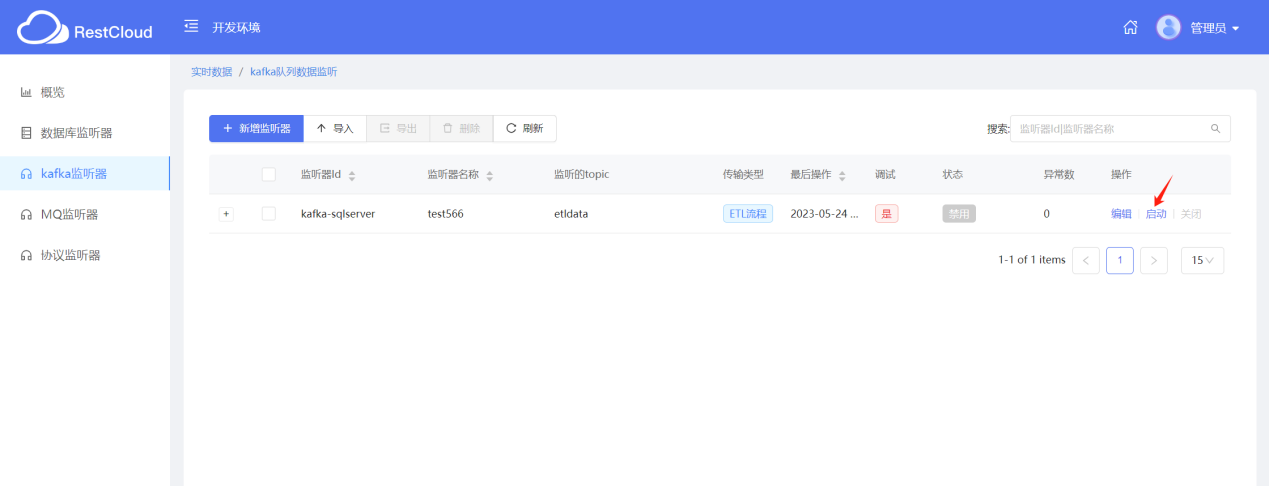

启动监听即可完成ETL与Kafka的集成:

ETL与Kafka集成的优势力

ETL(Extract, Transform, Load)与Kafka集成的优势主要体现在以下几个方面:

-

实时性:Kafka作为分布式流处理平台,具有高吞吐量和低延迟的特性,能够实时捕获并处理大量数据流。ETL工具与Kafka集成后,可以实现对这些实时数据的即时提取、转换和加载,确保数据几乎无延迟地进入分析或业务系统中,从而帮助企业快速响应市场变化。

-

可扩展性:Kafka和ETLCloud都设计为高度可扩展的系统,能够轻松应对数据量的增长。Kafka通过分布式集群架构支持水平扩展,而ETLCloud则可能通过K8S提供弹性资源自动调整能力。这种组合使得系统能够随着业务增长而灵活扩展,无需担心性能瓶颈。

-

灵活性:Kafka支持多种数据格式和消息传递模式(如发布/订阅、点对点等),使得ETL工具能够灵活地从Kafka中读取各种类型的数据。

-

容错性:Kafka内置了强大的容错机制,如数据复制、分区和偏移量管理,确保即使在部分节点故障的情况下,数据也不会丢失且能够继续被消费。ETLCloud与Kafka集成时,可以利用这些机制来构建高度可靠的数据处理管道,减少因系统故障导致的数据处理中断。

-

集成性:ETLCloud与Kafka的紧密集成通常意味着两者之间的无缝连接和高效的数据交换。这种集成性简化了数据处理的复杂性,降低了系统间通信的开销,并使得整个数据流处理过程更加流畅和高效。

在实施ETL与Kafka集成时,企业需要注意遵循最佳实践,如合理设计Kafka主题和分区、优化ETL转换逻辑以减少处理时间、监控和调整系统性能以确保稳定性和可靠性等。通过这些措施,企业可以充分发挥ETL与Kafka集成的优势,提升数据处理效率和业务竞争力。