Ubuntu安装ollama,并运行ollama和通义千问

安装ollama

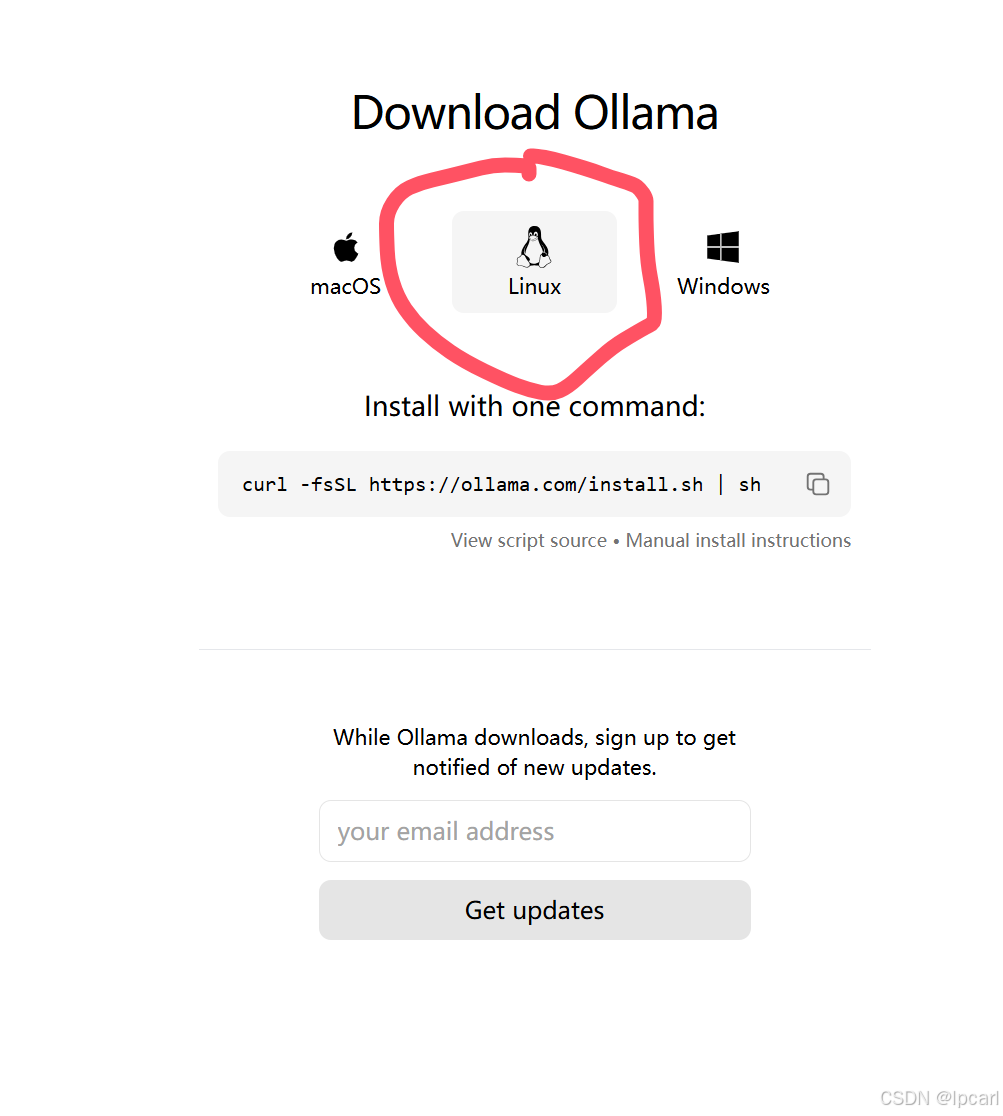

方式一:

访问网站连接,选中Linux,然后拷贝命令

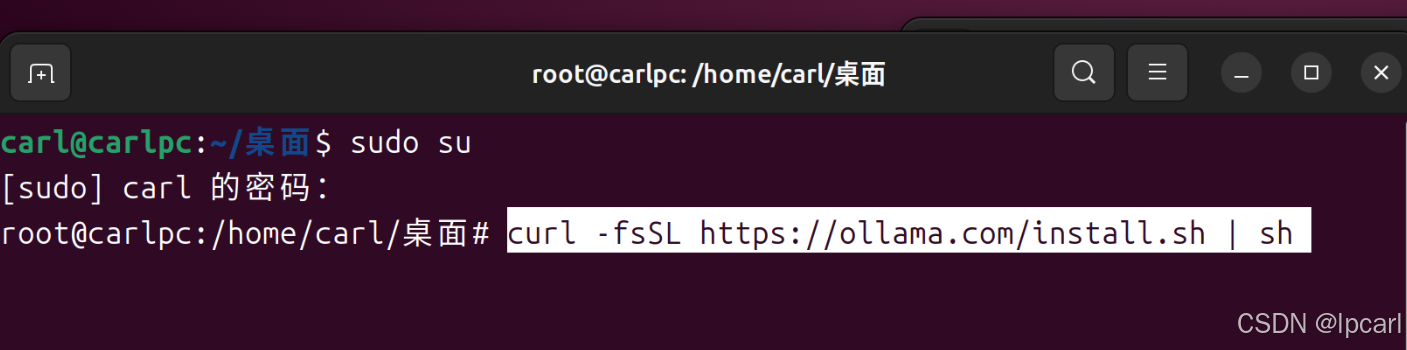

打开cmd (使用快捷键 Ctrl+shift+T),并切换到 管理员模式

接着打入粘贴上面的命令,回车后自动安装

shell

curl -fsSL https://ollama.com/install.sh | sh

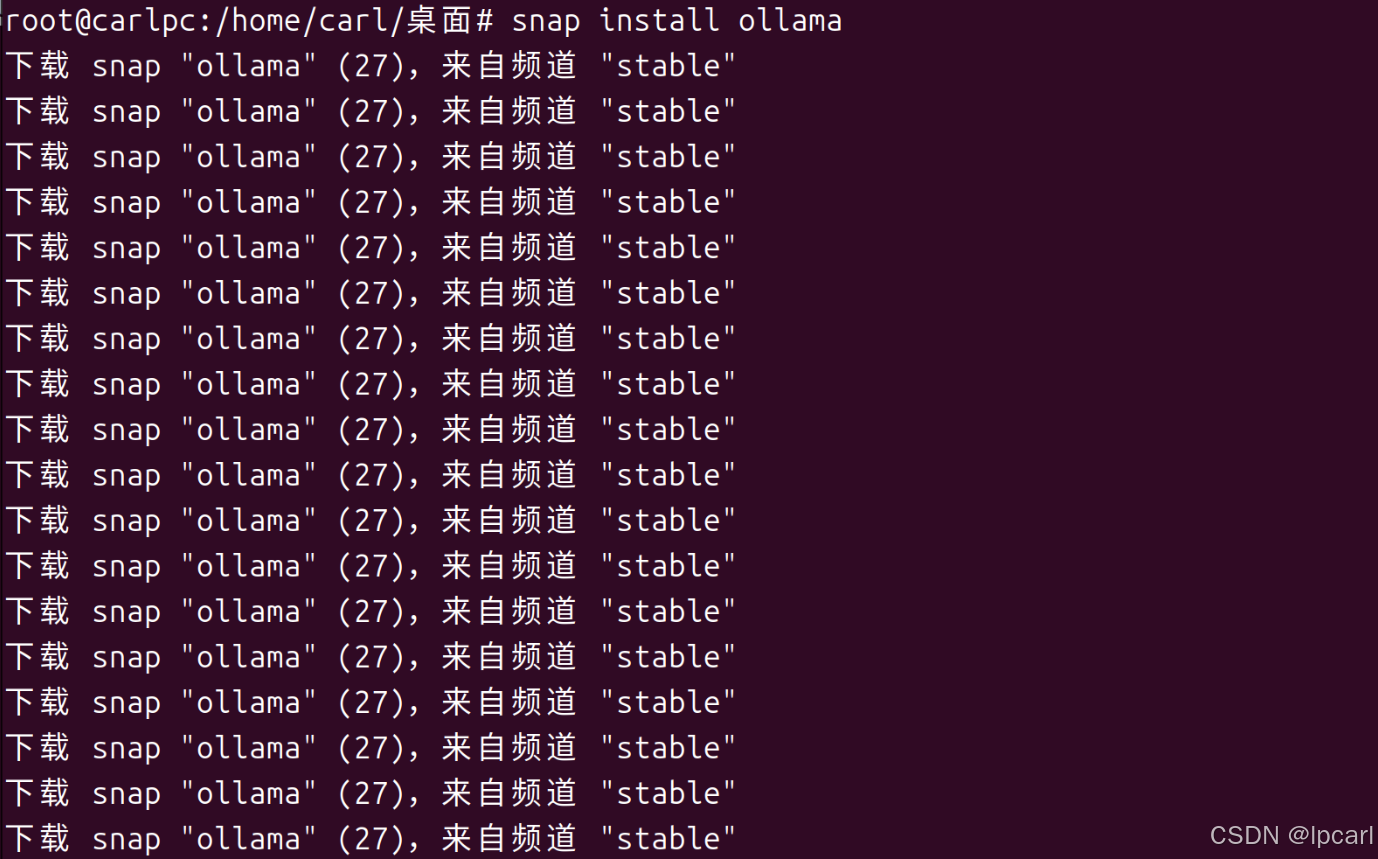

方式二

打开cmd (使用快捷键 Ctrl+shift+T),并切换到 管理员模式

接着打入粘贴上面的命令,回车后自动安装

shell

snap install ollama

下载安装模型

通过ollama,可以很容易下载大模型和创建大模型

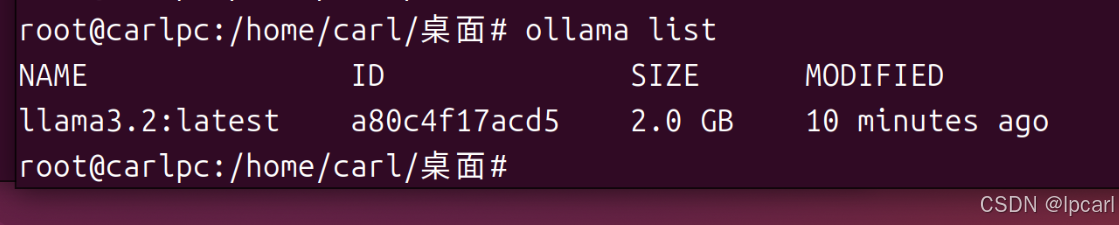

在终端中打入,如下命令可以查看本机安装的大模型

shell

ollama list

可以看到本机有一个llama3.2的大模型

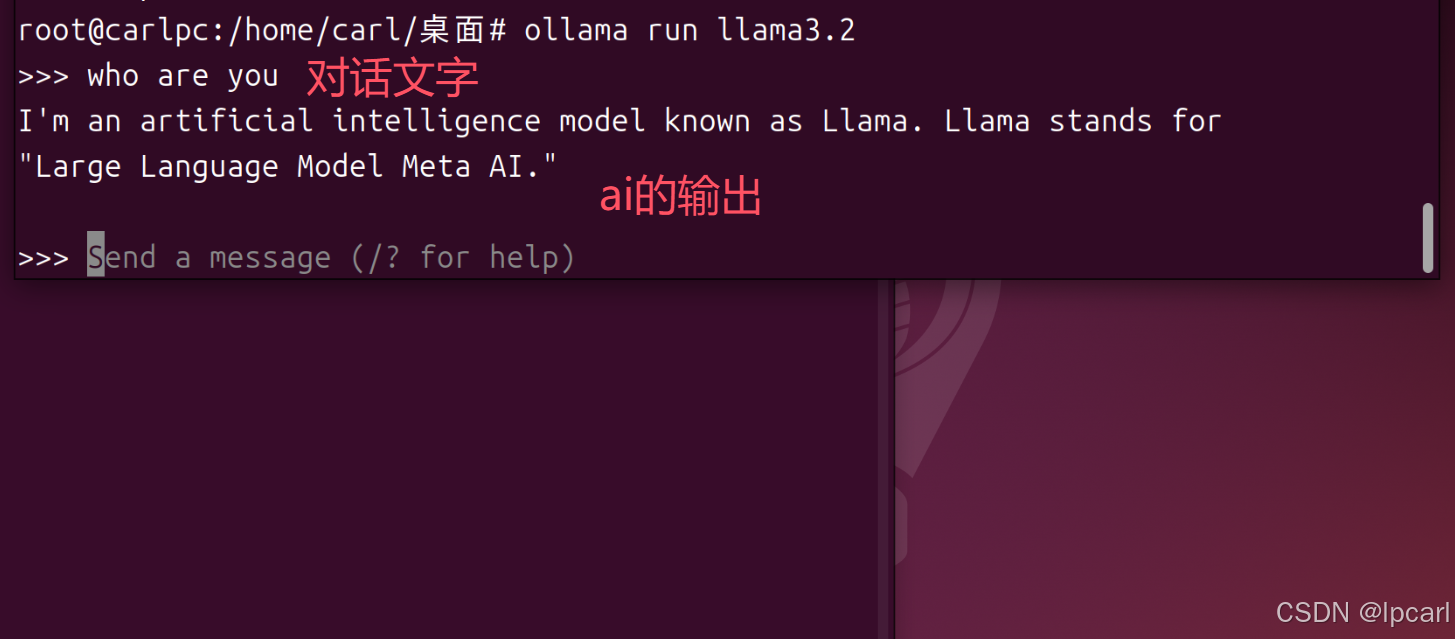

运行大模型

使用下面的命令,可以将相应的模型运行起来,

初次使用,会自动下载模型

如果想使用llama 3.2 就使用下面命令

shell

ollama run llama3.2 如果想使用中文模型比如通义千问

shell

ollama run qwen

运行ollama服务

终端中打入

shell

ollama serve可以看到,会出现绑定的端口11434

打开浏览器,打开地址:

可以看到ollama is running的字眼

前端的实现

前端我们使用python创建访问的接口,并使用gradio创建前端页面

python环境安装

首先安装python的环境

shell

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

#或者从清华源下载速度快

wget https://mirrors.tuna.tsinghua.edu.cn/anaconda/miniconda/Miniconda3-py39_24.9.2-0-Linux-x86_64.sh

bash Miniconda3-latest-Linux-x86_64.sh下载miniconda

安装miniconda

然后按要求输入 yes

最后就能看到安装好的环境

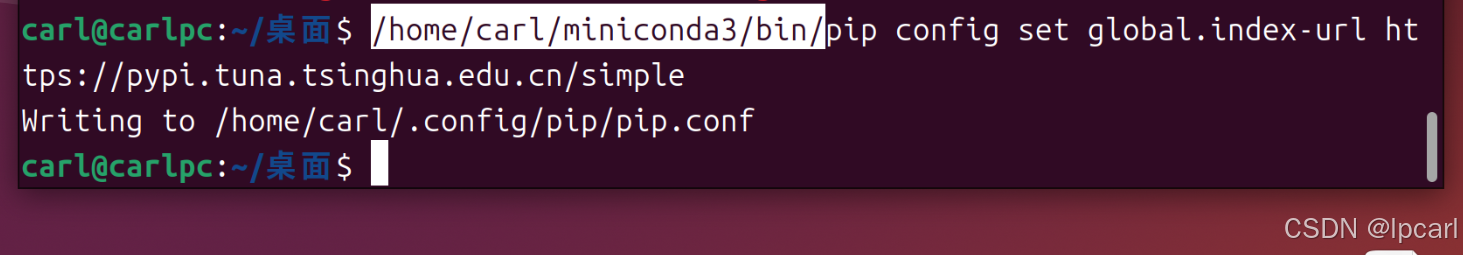

修改pip国内源

修改pip下载的源为国内源,这样下载的速度更快,注意这里的路径记得替换成自己电脑安装miniconda的路径

shell

/home/carl/miniconda3/bin/pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

前端页面搭建

首先安装依赖

shell

/home/carl/miniconda3/bin/pip install gradio langchain langchain_community可以看到会安装相应的依赖文件

测试前后端联通

接下来,桌面创建一个main.py,测试能否连接到后端

python

from langchain.llms import Ollama

llm = Ollama(model="llama3.2", base_url="http://127.0.0.1:11434")

response = llm("你好")

print(response)保存后,运行如下命令

shell

/home/carl/miniconda3/bin/python main.py运行后,可以看到如下的输出,

这个就是ai的输出

设计完整的ui

前后端联通后,开始写一个简单的界面

shell

import gradio as gr

from langchain.llms import Ollama

def chat_with_history(message, history):

llm = Ollama(

model="llama3.2",

base_url="http://127.0.0.1:11434"

)

response = llm(message)

return response

# 创建聊天界面

demo = gr.ChatInterface(

fn=chat_with_history,

title="Llama2 聊天助手",

description="与 Llama2 模型进行对话",

examples=["你好,请介绍一下你自己", "什么是人工智能?", "你能写代码吗?"],

)

if __name__ == "__main__":

demo.launch(share=False)保存代码后

shell

/home/carl/miniconda3/bin/python main.py运行后,可以看到绑定了一个本地的端口7860,在浏览器中打开,就能看到对应的界面