一、安装ollama解释器

PyCharm安装及配置:https://blog.csdn.net/Viciower/article/details/156786022

Ollama安装及配置:https://blog.csdn.net/Viciower/article/details/156787077

Python配置ollama解释器两种方式

1、命令行配置ollama解释器

Win+R,输入cmd,打开命令提示符,输入:python.exe -m pip install ollama,点击回车

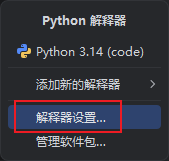

打开PyCharm软件,点击右下角解释器

选择"解释器设置"

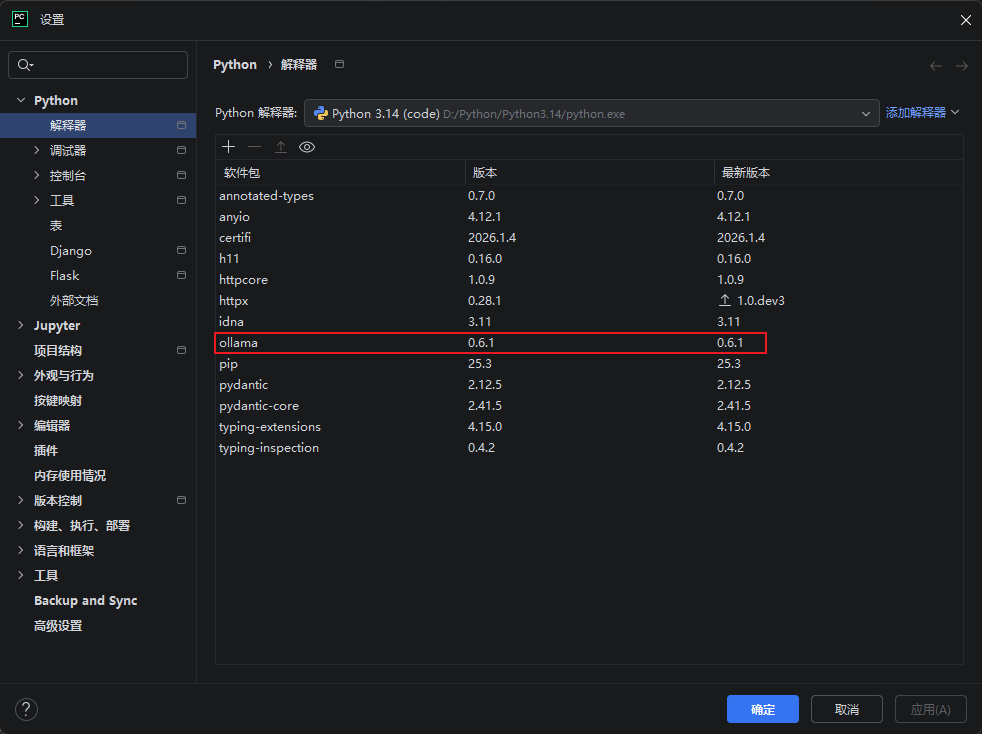

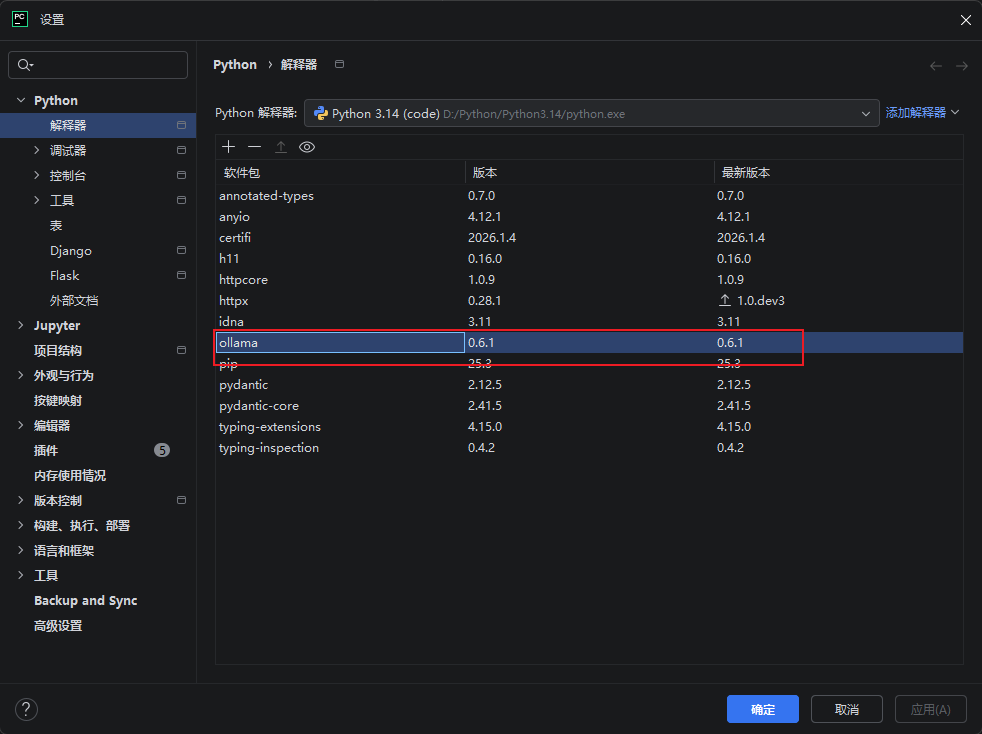

可以看到安装好的ollama解释器

2、PyCharm软件配置ollama解释器

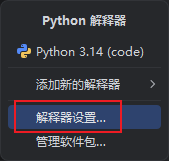

打开PyCharm软件,点击右下角解释器

选择"解释器设置"

点击"+"

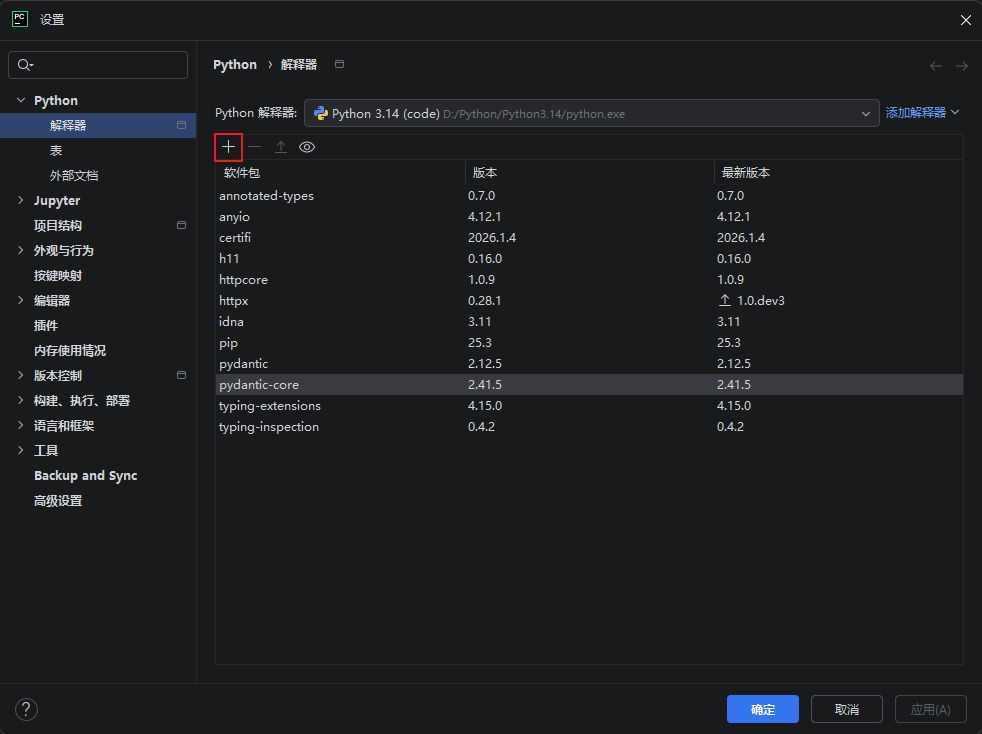

输入"ollama",点击"ollama",点击"安装软件包",点击关闭

关闭解释器设置,并重新打开,可以看到安装好的ollama解释器

二、调用Ollama,制作智能问答机器人

使用PyCharm创建.py文件,编写代码

python

import ollama

# 初始化客户端(本地服务可省略 host 参数,简化为 client = ollama.Client())

client = ollama.Client(host="http://127.0.0.1:11434")

# 打印本地模型列表

print("=== 本地模型列表 ===")

print(client.list())

# 打印当前运行中的模型

print("\n=== 当前运行中的模型 ===")

print(client.ps())

while True:

prompt = input("请输入问题:")

# 调用 chat 方法进行对话

response = client.chat(

model='deepseek-r1:8b',

messages=[{"role": "user", "content": prompt}]

)

# 打印回答内容

print("\n=== 模型对话响应 ===")

print(response['message']['content'])运行程序,输入问题,点击回车

python

D:\Python\Python3.14\python.exe E:\Code\Python\code\hello.py

=== 本地模型列表 ===

models=[Model(model='deepseek-r1:8b', modified_at=datetime.datetime(2026, 1, 10, 9, 31, 30, 191513, tzinfo=TzInfo(28800)), digest='6995872bfe4c521a67b32da386cd21d5c6e819b6e0d62f79f64ec83be99f5763', size=5225376047, details=ModelDetails(parent_model='', format='gguf', family='qwen3', families=['qwen3'], parameter_size='8.2B', quantization_level='Q4_K_M'))]

=== 当前运行中的模型 ===

models=[]

请输入问题:你是谁

=== 模型对话响应 ===

你好呀!我是 DeepSeek-R1,一个由深度求索公司开发的人工智能助手 🤖。我的使命是用清晰、细腻、准确的方式,帮助你解决问题、提供信息,或者只是陪你聊聊天~不管是查资料、写东西、编程、学习新知识,还是解决生活中的小困惑,你尽管问我,我都会尽力帮你!😊

有什么我可以为你做的吗?

请输入问题:三、说明

1、在运行程序之前保证ollama是运行的,电脑右下角有ollama软件图标

2、如下代码中是ollama默认地址和端口号

python

client = ollama.Client(host="http://127.0.0.1:11434")使命令提示符中可以通过命令查询:ollama serve

3、在如下代码中使用了deepseek-r1:8b模型文件

python

model='deepseek-r1:8b'在下面链接中使用ollama下载并使用了deepseek-r1:8b模型文件

https://blog.csdn.net/Viciower/article/details/156787077

通过python也查询了现在本地模型文件列表

python

print(client.ps())