文章目录

-

- 市场常见AI芯片总结

-

- 视海芯图

- 聆思

- 智芯科

- 安谋科技

-

- [["周易" NPU产品系列](https://www.eet-china.com/news/202304036298.html)](#“周易” NPU产品系列)

- [["周易" X2](https://www.armchina.com/mountain?infoId=170\&name="周易" X2\&CategoryStr="周易"\&pStatus=)](#"周易" X2)

- [["周易" Z 系列](https://www.armchina.com/mountain?infoId=161\&name="周易" Z 系列\&CategoryStr="周易"\&pStatus=)](#"周易" Z 系列)

- [["周易" X1](https://www.armchina.com/mountain?infoId=171\&name="周易" X1\&CategoryStr="周易"\&pStatus=)](#"周易" X1)

- [["周易" NPU 软件平台](https://www.armchina.com/mountain?infoId=172\&name="周易" NPU 软件平台\&CategoryStr="周易"\&pStatus=)](#"周易" NPU 软件平台)

- 寒武纪

- 地平线

- 华为

- 比特大陆

- 燧原科技

- 云天励飞

-

- IPU-X6000

- DeepEdge10

- [[DeepEye1000 芯片](https://www.intellif.com/int/chips.html)](#DeepEye1000 芯片)

- 壁仞科技

- 后摩智能

- 苹芯科技

- **平头哥**

- **[英特尔](https://www.intel.cn/content/www/cn/zh/homepage.html)**

- 天数智芯

- 奕斯伟

- 摩尔线程

-

- [[MTT S4000](https://www.mthreads.com/product/S4000)](#MTT S4000)

- 昆仑芯

- 沐曦

- 算丰

-

- [[算能 SC5(AI加速卡)](https://sophon-file.sophon.cn/sophon-prod-s3/drive/21/11/19/10/智算卡SC5系列产品彩页_V1.0.pdf)](#算能 SC5(AI加速卡))

- [[算能 SC7(AI加速卡)](https://www.sophgo.com/sophon-u/product/introduce/sc7-hp75.html)](#算能 SC7(AI加速卡))

- 英伟达V100、A100、H100横向对比

- 国产GPU横向对比

- 主流先进制程工艺梳理

- [Intel、AMD、苹果与高通:AI 处理器对比](#Intel、AMD、苹果与高通:AI 处理器对比)

- 参考资料

市场常见AI芯片总结

视海芯图

SH1210

产品概述

SH1210芯片是一款高性能、低功耗的专业3D视觉AI芯片,内置了专用2D-ISP和3D-ISP(支持ToF和双目两种深度视觉),配备双核ARM A7以及双核超低功耗NPU,可提供2D/3D视觉处理和高速AI计算的能力,能够广泛用于智能门锁、智能门禁、金融支付、人身核验、智能机器人等各类2D/3D视觉终端。

产品性能

双核ARM A7+双核低功耗NPU(算力1.3TOPS);内置了2D/3D-ISP

价格竞争力

相较于竞品如瑞芯微RV1109、全志V833、清微智能TX510等产品,SH1210具备多重3D视觉支持、高性能ISP等特点,同时也是目前主流方案中唯一使用芯片对3D ToF视觉进行硬件加速的视觉SoC,具备相当不俗的性价比。

技术创新

支持双目与ToF两种成像方式;具备2D/3D视觉处理和高速AI计算的能力。

工艺制程

未知。

客户服务

SH1210目前主要服务于舜宇光学,为其提供软硬件适配、调试等服务。

案例介绍

SH1210可用于智能门锁/门禁、金融支付、RGBD相机、智能机器人等产品的视觉终端,目前已经进入了舜宇光学的RGBD模组中,替代原先的国外芯片,首批芯片订单超过100万颗。

SH1580

SH1580是一款高性能多模态AI芯片,自主设计了多态神经网络处理器(PTPU)和3D视觉ISP。自主研发的多态神经网络处理器具备4ToPS算力(稠密算力),不仅善于提取局部特征的CNN,也对Transformer、Bert和点云神经网络等新兴AI模型有针对性加速效果。此外,SH1580还针对新兴AI模型优化的片上存储模块进行了设计,可以为片内计算阵列提供可重构的高速数据流,从而助力多模态数据融合在智能终端落地实现。SH1580集成4亿晶体管,采用12nm工艺,是一款高性能智能视觉SoC。该芯片暂时还没有量产。

产品性能

搭载4核A55@2.0GHz CPU;NPU达4TOPS算力(稠密算力),支持INT8、BF16、INT32、FP32混合精度;支持12M@60fps

价格竞争力

对比22nm制程的RK3568HE 16nm制程的地平线JX3,SH1580有较为明显的性价比优势。

技术创新

自研多态神经网络处理器(PTPU),支持CNN这类传统的神经网络模型,对Transformer、Bert这类新兴AI模型更能起到针对性加速效果。

工艺制程

未知。

客户服务

目前主要服务于网易有道,为其提供软硬件适配、调试等服务。

案例介绍

SH1580可以应用于智能教育硬件、服务机器人等领域,在ADAS、智能座舱等车载领域也有重大潜力。SH1580目前已与网易有道达成合作,量产后将率先进入网易有道旗下的翻译笔、智能台灯等教育硬件产品中。

聆思

CSK6系列芯片

芯片简介

三核异构架构

- ARM Star MCU,主频高达 300MHz

- Luna NPU,128 GOPS算力

- HIFI4 DSP,主频高达 300MHz

三核异构强强联合,高效支持音视频AI应用

完备硬件资源

- 大容量存储资源:

- 1MB SRAM, 8MB PSRAM, Up to 8MB Flash,可选外置

- 完整的音视频接口:

- DVP摄像头接口支持VGA,4麦克风输入,2扬声器输出,高速SPI驱屏

- 丰富的外设接口:

- 多达33个可配置的GPIO,USB、UART、SDIO、I2C、I2S、SPI等,内置6路触控按钮检测

更好效果的算法模型

- 采用CNN卷积神经网络算法,采集数十万条数据训练而成

- 支持语音交互、通话降噪、图像识别等AI能力

工艺制程

CSK6采用22nm工艺,更低功耗,芯片满载运行时发热量很小,适应更多品牌产品使用。

芯片参数

| CSK 6002 | CSK 6012 | CSK 6011A | CSK 6011B | |

|---|---|---|---|---|

| MCU | ARM Star 300MHz | ARM Star 300MHz | ARM Star 300MHz | ARM Star 300MHz |

| DSP | HiFi4 300MHz | HiFi4 300MHz | HiFi4 300MHz | HiFi4 300MHz |

| NPU | Luna 128GOPS | Luna 128GOPS | Luna 128GOPS | Luna 128GOPS |

| SRAM | 1MB | 1MB | 1MB | 1MB |

| PSRAM | 8MB | 8MB | 8MB | 4MB |

| Flash | 8MB | External | External | External |

| Audio Codec ADC | 4 | 4 | 2 | 2 |

| Audio Codec DAC | 2 | 2 | 2 (single-ended) | 2 (single-ended) |

| DVP | 1 | 1 | 1 | 1 |

| GPIO | 32 | 26 | 33 | 33 |

| GPADC | 3 channel | 3 channel | 4 channel | 4 channel |

| Uart | 4 | 4 | 4 | 4 |

| SPI | 2 | 2 | 2 | 2 |

| SDIO | 1 | 1 | 1 | 1 |

| I2C | 2 | 2 | 2 | 2 |

| I2S | 3 | 3 | 3 | 3 |

| Touch | 1 | 1 | 1 | 1 |

| 适用场景 | 适用于语音、图像、视觉等综合全场景 | 适用于语音、音频场景,如空调、风扇、会议机等 | 适用于图像、视觉场景,如扫描笔、云台等 | 适用于降噪、视觉场景,如对讲机、云台等 |

参考资料

智芯科

AT690

基于架构创新,AT690采用SRAM作为存算一体介质 ,通过存储单元和计算单元的深度融合,采用22nm成熟 工艺制程,有效把控制造成本。与传统架构下的AI芯片相比,该款芯片在算力、能效比,功耗等方面都具有明显的优势。芯片采用AISTARTEK CIM based NPU,能效比7.8Tops/W@INT8,稀疏优化能效比达到24Tops/W@INT8。存内计算AI单核算力达到 300Gops以上,可以通过集成多核(Multi-core)进一步提升算力,优化芯片设计使芯片能以较低功耗满足音频及图像视频的 AI 应用需求。

该款芯片支持市面上的主流算法,算子,并且可以灵活支持软件定制算子,有效适配新算子的高速更新,支持算法更新迭代。支持通用模型:语音、图像、NLP等等;无需特定硬件运行库(Runtime Libraries),集成快速高效,支持协作计算。有效满足超低功耗唤醒、VAD、语音识别、视觉识别等等多模态场景,适用于智能家居,机器人,智能座舱,实现自由对话,暗光全彩等特点,同时还赋能边缘侧语音图像处理设备等应用场景。

安谋科技

"周易" NPU产品系列

"周易"NPU产品系列布局如下图所示。从安谋科技官网的产品介绍来看,"周易"目前主要分成了Z系列和X系列。

大方向上,这两个系列在算力上存在差异。安谋科技产品总监杨磊在媒体沟通会上说,Z系列主要面向AIoT场景------通常采用Z系列NPU的应用对成本比较敏感;而X系列是偏高性能定位的,面向如"手机、汽车智能座舱、ADAS"等场景。

"周易" X2

随着智能汽车产业和边缘计算的蓬勃发展,需要 AI 处理的图像分辨率越来越高:从 720P 到 4K 分辨率,从单路图像到多路图像融合分析,此类应用对 AI 算力的需求成倍提升。为此,安谋科技推出了自研新一代人工智能处理器 ------ "周易" X2 NPU,在大幅提升算力的同时,还针对车载、边缘计算等特定场景进行了专门优化,进一步提升这些场景下的计算效率。

"周易" X2 NPU 是新一代人工智能处理器,基于第三代 "周易" 架构,提供更高的算力,支持多核 Cluster,最高可达 320TOPS 子系统。兼顾更高的精度和灵活性,多种数据精度融合计算。"周易" X2 NPU 针对 ADAS、智能座舱、平板电脑、台式机和手机等应用场景做了大量性能优化,例如大幅提升手机拍照、录像中的高分辨率图像处理能力,以及车载中常用的 Transformer 等应用的性能,同时采用 i-Tiling 技术大幅减少带宽需求。

- 多核 Cluster,支持 10~320TOPS 子系统。

- 支持 int4/int8/int12/int16/int32, fp16/bf16/fp32,多精度融合计算。

- TSM 任务分拆和管理技术,充分发挥各个计算单元效能。

- 支持自定义算子,满足各种模型部署。

- 需求支持定制差异化 AI 解决。

上面这张图给出了基本的框图。堆叠更多的NPU核心,达成10TOPS~80TOPS(int8数据格式)的算力扩展;另外,多核构成一个cluster,cluster本身可以再做扩展,最多达成320TOPS理论算力(最多4个cluster可达成这个理论算力水平)。当然还需要搭配NoC连接、片内存储资源,以及调度管理(Task Scheduling Manager)等。

这代架构相较此前的单核方案,有了多核、多cluster的选择,达成了算力扩展,如上图所示。当然核心内部有自己的内部存储,到cluster这个层级也有个Global Memory,以及内部NoC连接各个核心,协调核间数据通信。多cluster层级,右边对应的也有NoC和可选的片内SRAM。

有个比较重要的组成部分是Task Scheduling Manager(TSM),负责任务在多核、多cluster间的调度。

上面这张图比较了Swin-Transformer------这是一种视觉Transformer,经常用于图像分类与密集型识别任务。这张图比较了"周易"X1、X2,以及某个"汽车SoC A"的性能差异。因为Transformer的自注意力模型的block有很多不同的定制化需求,安谋科技也提供一种叫primitive(原语)的新方法。

安谋科技给出了第一方的基准测试对比数据。上面这张图对比的除了"周易"X2 NPU之外,还包含三款竞品,被标注为"SoC G1""SoC G2""SoC D9"。

在包括MobileNet、UNET、超分、DPED,或者YOLO等典型网络,安谋科技和竞品旗舰SoC比有明显的性能优势。X2在架构和性能上能够达到国际一线SoC的水平。上述性能比较都是基于相似的MAC配置来做的。

"周易" Z 系列

面向人工智能设计的 "周易" Z 系列 NPU(人工智能处理单元), 采用为神经网络运行及相应的前后处理设计的专用指令集,具有均衡的可编程能力和优化的标准处理能力,满足不同人工智能算法需求。融合了多种执行粒度的指令,可以为人工智能提供能效比高的运算能力。"周易" Z 系列 NPU 也支持配合 Arm Cortex CPU、Arm Mali GPU 以及第三方硬件的异构计算,能够大大提高人工智能应用开发的生产效率。目前,"周易"Z 系列已经推出了 Z1、Z2 和 Z3 三代产品。

- 创新性的架构设计,提供完整的硬件和软件生态

- 可扩展性配置、高密度性能、低功耗,具有 PPA 最佳平衡

- 完全的可编程性、高灵活性,可支持各种 AI 算法操作

- 可选的安全扩展,有效保护用户数据和 AI 算法

- 支持用户自定义扩展

"周易" Z 系列 NPU 6 大特性:

- 单核算力 1-4TOPS。

- 支持 SoC 多核实现。

- 微架构优化,特定神经网络模型相同算力配置下性能提升 100%。

- 优化内存子系统和高级带宽节省技术。

- 除智能家居、移动设备和物联网等领域,还可面向中高端安防、智能座舱和 ADAS、边缘服务器等应用场景。

- 优化 Transformer 结构。

"周易" X1

人工智能技术在汽车、终端等领域的应用越来越普遍,例如常见的车载 ADAS、辅助泊车、语音控制及驾驶员状态监测等,需要处理的图像分辨率越来越高,从 720P 到 4K 分辨率,从单路图像到多路图像融合分析,此类应用对 AI 算力的需求成倍提升。为此,安谋科技推出高性能 "周易" X 系列人工智能处理器,并发布 "周易" X 系列首款产品 ------ "周易" X1 NPU。"周易" X1 NPU 秉承 "周易" Z 系列 10TOPS/W 的高能效优势,提供 10~20TOPS 算力,对比当前主流车载芯片,可提高 2.6 倍计算效率。

"周易" X1 NPU 是新一代的人工智能处理器,前向兼容上一代 NPU 架构,构建统一的 NPU 软件生态。"周易" X1 NPU 针对边缘计算、车载等场景做了大量优化,例如大幅提高车载多路摄像头场景中常用的 Transformer 的性能;针对高分辨率图像处理,优化处理效率和带宽需求。

- 面向 AI 运算定义的专用指令集,融合多种粒度指令。

- 支持自定义算子,满足各种模型部署需求。

- 第二代数据压缩技术,用户无感知部署。

- 高性能专用硬件加速。新增 Winograd 功能,等效 1.3 倍算力。

- 优化 Transformer 性能,矩阵计算速度提升 10 倍。

- 针对高分辨率 AI 算法,优化 i-Tiling 技术,降低 90% 带宽需求。

- 支持定制差异化 AI 解决方案。

- AI 安全扩展,有效保护用户信息、AI 算法。

"周易" NPU 软件平台

"周易" NPU 提供一套完整的人工智能软件平台------ "周易" Compass,使开发者可以方便、快速地进行算法移植和部署。

- 支持主流的人工智能框架,如 TensorFlow、Caffe、ONNX、PyTorch 等模型。

- 多种开放接口,支持用户模型和自定义算子等开发和调试。

- 丰富的调试工具。支持多种层次的开发和调试,满足高级开发者白盒开发的性能调优需求。

- 支持 Android、Linux、RTOS、QNX 等不同 OS。

- 支持 TVM、Arm NN 的 SoC 异构计算,从而有效使用 CPU、GPU、NPU 等计算资源。

- Bit 精度的软件仿真平台,便于算法移植和部署。

寒武纪

思元 370

基于7nm制程工艺,思元370是寒武纪首款采用chiplet(芯粒)技术的AI芯片,集成了390亿个晶体管,最大算力高达256TOPS(INT8),是寒武纪第二代产品思元270算力的2倍。凭借寒武纪最新智能芯片架构MLUarch03,思元370实测性能表现更为优秀。思元370也是国内第一款公开发布支持LPDDR5内存的云端AI芯片,内存带宽是上一代产品的3倍,访存能效达GDDR6的1.5倍。搭载MLU-Link™多芯互联技术,在分布式训练或推理任务中为多颗思元370芯片提供高效协同能力。全新升级的寒武纪基础软件平台,新增推理加速引擎MagicMind,实现训推一体,大幅提升了开发部署的效率,降低用户的学习成本、开发成本和运营成本。

MLU370-S4/S8加速卡采用思元370芯片,TSMC 7nm制程,寒武纪新一代人工智能芯片架构MLUarch03加持,支持PCIe Gen4,板卡功耗仅为75W,相较于同尺寸GPU,可提供3倍的解码能力和1.5倍的编码能力。MLU370-S4/S8加速卡的能效出色,体积小巧,可在服务器中实现高密度部署。

凭借寒武纪最新智能芯片架构 MLUarch03,相较于峰值算力的提升,思元 370 实测性能表现更为优秀:以 ResNet-50 为例,MLU370-S4 加速卡(半高半长)实测性能为同尺寸主流 GPU 的 2 倍;MLU370-X4 加速卡(全高全长)实测性能与同尺寸主流 GPU 相当,能效则大幅领先。

| 板卡型号 | MLU370-S4/S8 |

|---|---|

| 计算架构 | Cambricon MLUarch03 |

| 制程工艺 | 7nm |

| 计算精度支持 | FP32、FP16、BF16、INT16、INT8、INT4 |

| 峰值性能 | 192 TOPS (INT8) |

| 96 TOPS (INT16) | |

| 72 TFLOPS (FP16) | |

| 72 TFLOPS (BF16) | |

| 18 TFLOPS (FP32) | |

| 内存类型 | LPDDR5 |

| 内存容量 | 24GB/48GB |

| 内存带宽 | 307.2 GB/s |

| 视频编解码 | 最高可支持至8K;132路HEVC全高清视频解码;24路HEVC全高清视频编码; |

| 图片编解码 | 图片编解码最高分辨率支持16384x16384;4000 Frames/s 全高清图片解码;3000 Frames/s 全高清图片编码; |

| 系统接口 | x16 PCIe Gen4 |

| 形态 | 半高半长单槽位 |

| 最大热功耗 | 75W |

| 散热设计 | 被动 |

测试环境:MLU370-S4:NF5468M6/2x Intel Xeon Gold 6330 CPU @ 2.0GHz/MagicMind v0.6

MLU370-X4:NF5468M6/2x Intel Xeon Gold 6330 CPU @ 2.0GHz/MagicMind v0.6

GPU数据:ResNet-50来自于相关产品官网,Transformer、VGG16、YOLOv3均取自实测最大吞吐性能。

思元270

思元270集成了寒武纪在处理器架构领域的一系列创新性技术,处理非稀疏人工智能模型的理论峰值性能提升至上一代思元100的4倍,达到128TOPS(INT8);同时兼容INT4和INT16运算,理论峰值分别达到256TOPS和64TOPS;支持浮点运算和混合精度运算。

思元270采用寒武纪MLUv02架构,可支持视觉、语音、自然语言处理以及传统机器学习等多样化的人工智能应用,更为视觉应用集成了充裕的视频和图像编解码硬件单元。

MLU270-S4智能加速卡是为高能效比AI推理设计的数据中心级加速卡,思元270-S4加速卡功耗仅为70W,处理非稀疏人工智能模型的理论峰值性能提升至上一代思元100的4倍,可广泛支持视觉、语音、自然语言处理以及传统机器学习等高度多样化的人工智能应用,帮助AI推理平台实现超高能效比。

| 思元270-S4 产品规格 | ||

|---|---|---|

| 产品性能 | 芯片型号 | 思元270(MLUv02 架构) |

| INT8理论峰值/TOPS | 128 | |

| INT4理论峰值/TOPS | 256 | |

| INT16理论峰值/TOPS | 64 | |

| 计算精度支持 | 低精度、混合精度 | INT16,INT8,INT4,FP32,FP16 |

| 内存规格 | 内存容量 | 16GB DDR4,ECC |

| 内存位宽 | 256-bit | |

| 内存带宽 | 102 GB/s | |

| 接口 | PCIe接口 | ×16 PCIe Gen.3 |

| 功耗 | 最大热设计功耗 | 70w |

| 散热设计 | 被动散热 | |

| 形态 | 半高半长,单槽位 | |

| 尺寸 | 167.5mm × 68.9mm | |

| 重量 | 310g |

地平线

征程6

征程®6作为先进处理器技术的集大成者,基于设计工艺(DTCO)与系统技术(STCO)的协同优化,实现产品竞争力的全面升维,并吸引一众行业顶尖软硬件生态伙伴投入产品化应用。

基于征程6系列,地平线已与超10家车企及品牌达成量产合作,首个量产车型将于2024年率先交付,正式开启低、中、高阶智驾全面量产的新篇章。

征程6系列共6款,足以覆盖智能驾驶的各个场景和价位。发布会上重点介绍了征程6B、6E、6M和6P,B应该是Base,L是Light,E是Efficiency,M是Medium,H是High,P是Performance或Premium。地平线没有公开征程6L和6H的参数,预估6H的AI算力是256-300 TOPS,CPU算力是250-300K DMIPS。6L的AI算力是30-40TOPS,CPU算力是40-50K DMIPS。

征程6系列的另一个升级是BPU架构,所谓BPU就是地平线对AI加速器的另一种称呼,B代表Brain,可以称为类脑处理器,第一代BPU,地平线致敬数学家伯努利,伯努利分布是最简单的离散型概率分布模型。第二代BPU,地平线致敬英国数学家贝叶斯,他推导出贝叶斯定理,贝叶斯定理是一个由结果倒推原因的概率算法,当年默默无闻,在人工智能的今天大放异彩。

征程6P的AI算力是560TOPS,560TOPS是在1/2稀疏网络下的等效算力,精度应该是INT8位。

华为

昇腾

狭义来说,华为昇腾是指华为发布的两款人工智能处理器芯片,一个是昇腾310用于推理,另一个是910用于训练业务。

广义来说,华为昇腾是指整个昇腾计算架构,包括硬件、基础软件、应用使能与行业应用及服务等四层。

也就是说,昇腾计算产业以昇腾AI处理器为核心,通过系列硬件和基础软件构建全栈AI计算基础设施,为各行各业赋能。

在硬件方面,包括模块、标卡、小站、服务器、集群等产品形态;在软件层面,包括异构计算架构、AI框架、应用使能、全流程开发工具链等产品。

昇腾310处理器:本质上是人工智能片上系统,昇腾 310 整数精度(INT8)算力可达 16TOPS,主要应用于边缘计算产品和移动端设备等低功耗的领域,目前已经大量用于自动驾驶领域。

昇腾910处理器: 整数精度(INT8)算力可达 640TOPS,在业内其算力处于领先水平,性能水平接近于英伟达 A100。主要应用于云端,可以为深度学习的训练算法提供强大算力。功耗只有310W,同时采用了7nm先进工艺进程,支持128通道全高清视频解码。

昇腾AI服务器具有超强算力,适用于中心侧AI推理以及深度学习模型开发和训练场景。包括(1)Atlas 800 推理服务器(型号:3000)(2)Atlas 800 推理服务器(型号:3010)(3)Atlas 800 训练服务器(型号:9000)(4)Atlas 800训练服务器(型号:9010)(5)Atals 800T A2训练服务器(6)Atlas 500 Pro 智能边缘服务器。

华为昇腾超强算力推理+训练标卡。

训练及推理标卡融合"通用处理器、AI Core、编解码"于一体,需要安装到服务器上,通过服务器提供运算和模型,为数据中心提供强劲算力。

1)推理卡:包括Atlas 300V 视频解析卡、Atlas 300V Pro 视频解析卡、Atlas 300I Pro 推理卡、Atlas 300I Duo 推理卡。其中,Atlas 300I Duo 推理卡在配置下可以输出整数精度(INT8)达到280TOPS,半精度(FP16)算力达到140TOPS。

2)训练卡:主要以Atlas 300T Pro 训练卡(型号:9000)、Atlas 300T A2 训练卡为主,可广泛应用于智慧城市、智慧交通、智慧园区、智慧金融等诸多AI行业场景。

比特大陆

BM1684

比特大陆第三代AI芯片BM1684,具有低功耗、高性能、全定制的特点。该芯片聚焦于云端及边缘应用的人工智能推理,采用台积电12nm工艺,在典型功耗仅16瓦的前提下,FP32精度算力达到2.2 TFlops,INT8算力可高达17.6Tops,在Winograd卷积加速下,INT8算力更提升至35.2Tops。其面积约200平方毫米,仅比成年人指甲盖大一点。

BM1684内置张量计算模块TPU,模块含64个NPU运算单元,每个NPU包括16个EU单元,总共有1024个EU运算单元。另外,BM1684为视频处理做了特别优化。单芯片最高支持32路H264/H265的解码能力,每秒480帧JPEG/PNG图片编解码,960 fps@1080p视频解码能力,更内置了视频图像前后处理硬件加速模块。BM1684还支持16个PCIE3.0 lane、2个千兆以太口,具备多芯片级联等特点;并内置Trustzone、secureboot以及多种加解密算法,可保护客户的数据、模型安全可靠。

BM1684也提供了强大的深度学习模型编译器和软件SDK开发包,支持Caffe、TensorFlow等主流的深度学习框架,开发者可轻松把训练完备的神经网络模型移植到BM1684平台上,支持视频结构化分析,可应用于人脸检测与识别、车牌识别等各类AI应用场景,为城市大脑等各项决策提供强大的算力保证。

燧原科技

邃思2.0

邃思2.0进行了大规模的架构升级,新一代全自研的GCU-CARA全域计算架构,针对人工智能计算的特性进行深度优化,夯实了支持通用异构计算的基础;支持全面的计算精度,涵盖从FP32、TF32、FP16、BF16到INT8,并成为中国首款支持单精度张量TF32数据精度的人工智能芯片。这款芯片面向AI云端训练,尺寸为57.5毫米×57.5毫米(面积为3306mm2),达到了芯片采用的日月光2.5D封装的极限,与上代产品一样采用12nm工艺,单精度FP32算力为40TFLOPS,单精度张量TF32算力为160TFLOPS,整数精度INT8算力为320TOPS,半精度BF16/FP16算力为160TFLOPS。

**HBM2E存储带来海量吞吐:**邃思2.0共搭载了4颗HBM2E片上存储芯片,高配支持64 GB内存,带宽达1.8 TB/s,是中国第一个支持世界最先进存储HBM2E和单芯片64 GB内存的产品。

高速互联支撑算力扩展:GCU-LARE全域互联技术是燧原专为人工智能训练集群研发的互联技术,提供双向300 GB/s互联带宽,支持数千张云燧CloudBlazer加速卡互联,实现优异的线性加速比。

全新软件驾驭澎湃算力:驭算TopsRider是燧原科技自主知识产权的计算及编程平台,通过软硬件协同架构设计,充分发挥邃思2.0的性能;基于算子泛化技术及图优化策略,支持主流深度学习框架下的各类模型训练;利用Horovod分布式训练框架与GCU-LARE互联技术相互配合,为超大规模集群的高效运行提供解决方案。开放升级的编程模型和可扩展的算子接口,为客户模型的优化提供了自定义的开发能力。

云天励飞

IPU-X6000

IPU-X6000加速卡。该产品具备256T算力、128GB显存容量、486GB/S显存带宽;采用C2C Mesh互联技术,可实现卡间高速互联,带宽达64GB/s,最大可实现64张卡的互联;可应用于语言、视觉、多模态等各类大模型的推理加速,目前已适配云天天书、通义千问、百川智能、Llama2/3等近10个主流大模型。IPU-X6000加速卡内置全国产工艺打造的大算力芯片DeepEdge200,该芯片采用D2D Chiplet技术,是基于DeepEdge10芯片平台打造的最新成果。DeepEdge10是云天励飞于2023年底正式发布的全国产14nm Chiplet大模型推理芯片。IPU-X6000单卡可实现130B参数量大模型推理,在执行70B参数量大模型推理时性能达11 tokens/s,有望在大模型推理领域逐步实现国产替代。

DeepEdge10

云天励飞重磅发布新一代自主可控的面向边缘人工智能(AI)推理芯片DeepEdge10系列,最高算力可达48TOPS,支持D2D/C2C Mash互联扩展,可以满足千亿参数的大模型部署需求。

云天励飞DeepEdge10是国内首创的14nm Chiplet架构的面向大模型AI推理的主控级SoC芯片。

具体来说,DeepEdge10集成了2大核+8小核的国产RISC-V CPU内核,最高主频1.8GHz;还集成了性能可对标Arm Mali-G52的GC8000L GPU,主频800MHz,支持最大8K@30fps的视频编解码能力和最大2亿像素的JPEG编解码能力,并且支持双屏异显(2K@60fps);内置云天励飞最新一代自主知识产权 NPU NNP400T,提供16 Tops (INT8) / 8 TOPS (INT16) / 2 TFOPS (FP16)的算力。支持常用深度学习网络,如:CNN,RNN,Transformer,GNN等。同时,DeepEdge10还具备硬件级的安全特性,以及完备的高低速外围接口。

DeepEdge10是面向大模型推理需求进行了针对性优化,其内部集成的 NNP400T NPU是一款支持支持大模型新型计算范式的神经网络处理器,不仅支持FP16/INT16/INT8等数据格式,还支持多线程、支持Transformer网络结构模型。在制造工艺方面,由于更为先进制程工艺获取受限,DeepEdge10选择基于国内自主可控的14nm工艺。同时,采用了基于D2D(Die to Die)互联的 Chiplet先进封装架构,可以支持算力灵活扩展,可满足不同场景对算力和成本的多样化需要。

基于Chiplet D2D架构,云天励飞DeepEdge10系列演化出了DeepEdge10C、DeepEdge10标准版和DeepEdge10Max三款芯片。其中,DeepEdge10C算是精简版,NPU算力为8TOPS。而DeepEdge10Max则是"PRO版",CPU核心提升到了40核,NPU算力达到了48TOPS。

此外,DeepEdge10还支持C2C(Chip to Chip)Mesh Torus互联扩展。这也意味着,多颗DeepEdge10芯片可以直接通过C2CMesh Torus互联扩展来进一步提升整体的性能,可以实现高达512GB的统一内存、高达192GB的统一内存带宽、实现各计算节点的最短传输延迟、Mesh可重构特性可以支持2×2/3×3/4×4 Mesh。这足以满足千亿级大模型的部署需求。

参考资料:云天励飞发布大模型推理芯片:14nm Chiplet架构,国内首创! -- 芯智讯。

DeepEye1000 芯片

该芯片是面向计算机视觉的深度学习神经网络处理器芯片。内置自研CNN网络加速引擎,可以实现高性能低功耗的CNN网络模型的加速;提供强大的可编程运算能力,满足CNN算法实时性处理的运算要求:自定义指令集和编程框架,支持主流的CNN算法移植,如人脸识别等,以及其他计算机视觉CNN算法的移植和应用:可广泛应用于智能摄像机、工业检测、机器人、无人机等领域。

神经网络处理器:

- 自研四核NNP神经网络处理器,主频最高800Mhz;

- 提供Total 2TOPS AI算力;

- 支持INT16/INT12/INT8数据类型。

该芯片专注边缘和端侧视觉应用,基于多核异构并行计算架构设计,内置四核神经网络处理器,可支持INT16 / INT12 / INT8混合精度量化数据,采用存算融合体系架构和可重构计算阵列,可以灵活、高效的执行各种深度学习算法模型的推理计算,峰值算力达2.0Tops。其中,神经网络处理器支持深度定制指令集,定制指令多达160条以上,支持主流神经网络模型。神经网络处理器采用可重构计算阵列,支持灵活可编程计算流,计算效率超过99%,同时采用存算融合体系架构,使得DDR存储访问带宽下降77%,功耗下降60%。

在CPU方面,云天初芯DeepEye1000采用阿里平头哥玄铁810嵌入式处理器,工作频率达到1.2GHz,处理器采用RISC指令架构,双发射10级流水线,性能高于2.5 DMIPS/MHz。此外该芯片还集成了双核视觉DSP处理器,内置硬件加速运算子ACC,支持超过20个高效算子,每秒可跟踪1200张人脸。DeepEye1000还拥有强大的视频处理能力,支持H.264和H.265解码,可支持4K@30fps视频、4路高清视频并行的实时分析。

在芯片制程方面,云天初芯DeepEye1000采用了成熟的22nm FD-SOI工艺,该工艺主要针对快速发展的主流移动、IoT物联网、RF射频和网络市场,可提供比肩FinFET技术的性能,能效则媲美28nm工艺,而且成本更低。

为了提高芯片的易用性,云天励飞还打造了DETVM开源开放工具链,该工具链兼容TVM开源生态,支持丰富的算法框架,一键实现量化编译和部署,让算法移植更便捷。

壁仞科技

BR100系列

壁仞科技BR100系列通用GPU芯片针对人工智能(AI)训练、推理,及科学计算等更广泛的通用计算场景开发,主要部署在大型数据中心,依托"壁立仞"原创架构,可提供高能效、高通用性的加速计算算力。采用7nm制程,并创新性应用Chiplet与2.5D CoWoS封装技术,兼顾高良率与高性能。除原生支持FP32、BF16、FP16、INT8等主流数据精度外,原创定义TF32+数据精度,相较TF32提供更高数据精度与吞吐性能。

BR100 明确采用了台积电的 2.5D CoWoS-S 封装方案------两片 die 和周边 HBM2e 内存都放在一片硅中介(silicon interposer)上。而且 D2D 互连采用超高速 112GPAM4 SerDes,Die 间通讯带宽达到了 896GB/s。

后摩智能

鸿途H30

后摩鸿途®️H30 以存算一体创新架构实现了六大技术突破,即大算力、全精度、低功耗、车规级、可量产、通用性。后摩鸿途®️H30 基于 SRAM 存储介质,**采用数字存算一体架构,拥有极低的访存功耗和超高的计算密度,在 Int8 数据精度条件下,其 AI 核心IPU 能效比高达 15Tops/W,是传统架构芯片的7 倍以上。**为了更好地实现车规级,后摩智能基于H30 自主研发了硬件增强机制和检测机制,在提升芯片可靠性的同时,进一步保障了功能安全性。

为了充分发挥存算一体带来的高计算效率,后摩智能面向智能驾驶场景打造了专用 IPU(处理器架构)------天枢架构,采用多核、多硬件线程的方式扩展算力,实现了计算效率与算力灵活扩展的完美均衡,AI 计算可以在核内完成端到端处理,保证通用性。天枢架构的设计理念源自于庭院式的中国传统住宅,以大布局设计保障计算资源利用效率的同时,再进一步结合现代住宅多层/高层的设计优势,以多核/多硬件线程的方式灵活扩展算力。得益于灵活、高效的硬件架构设计,H30 实现了性能 2 倍提升的同时,还降低了 50% 功耗。

得益于存算一体的架构优势,**H30 基于 12nm 工艺制程,在 Int8 数据精度下实现高达 256TOPS 的物理算力,所需功耗不超过 35W,整个 SoC 能效比达到了 7.3Tops/W,**具有高计算效率、低计算延时以及低工艺依赖等特点。在实际的性能测试中,H30 基于Resnet 50 模型的 Benchmark,在 Batch Size 等于1 和 8 的条件下分别达到了 8700 帧/秒和 10300 帧/秒的性能。

为了让客户拥有更好的产品使用体验,后摩智能还基于H30芯片自主研发了一款软件开发工具链------后摩大道™,支持 PyTorch、TensorFlow 、ONNX 等主流开源框架,编程兼容 CUDA 前端语法,同时支持 SIMD 和 SIMT 两种编程模型,兼顾运行效率和开发效率,以无侵入式的底层架构创新保障了通用性的同时,进一步实现了H30 的高效、易用。

参考资料:首款国产存算一体芯片发布!12nm工艺追平英伟达Orin,车规量产支持L4 | 量子位。

漫界M30

后摩智能推出基于存算一体架构的边端大模型AI芯片------后摩漫界™️M30,物理算力100~256TOPS@INT8,典型功耗12W。为了进一步提升部署的便捷性,后摩智能同步推出了基于M30芯片的智算模组(SoM)和力谋®️AI加速卡。

随着AI大模型部署需求从云端迅速向端侧和边缘侧设备迁移,AI芯片的性能、功耗和响应速度面临前所未有的挑战。后摩漫界™️M30芯片兼具高性能与低功耗特性,可满足边端侧大模型部署对高效率和实时性的严苛要求。

M30是一款通用的边端大模型AI芯片,能够支持多种大模型,包括但不限于ChatGLM、Llama2、通义千问等。以Qwen1.5-7B-Chat为例,M30的运行性能可达15-20 Tokens/s。

基于M30芯片的智算模组(SoM)支持PCIe EP模式,以其小巧的体积、强劲的性能和极低的功耗,成为小型化设备和功耗敏感嵌入式场景的理想选择。此外,基于M30芯片的力谋®️AI加速卡作为标准的半高半长PCIe加速卡,能在PC、一体机和服务器中实现快速部署,支持主动散热和被动散热两种模式,确保设备在不同环境下的稳定运行。

后摩漫界™️M30将以"+AI"的方式,为传统的端侧和边缘侧设备注入强大的大模型能力,现已成功适配包括X86、ARM在内的多种主流处理器,可广泛应用于AI PC、边缘AI一体机、智能座舱、商用显示、智能融合网关,NAS(网络附加存储)等领域,为AI技术在更多领域的深入应用注入强大动力。

苹芯科技

中国芯片设计公司苹芯科技8月8日在北京发布基于存算一体的28nm节点的PIMCHIP-N300存算一体NPU和PIMCHIP-S300多模态智能感知芯片,支持智能可穿戴设备、智能安防、具身智能、AI大模型、健康数据分析等领域,尤其支持AI与大模型推理加速等各类计算任务场景。

苹芯科技创立于2021年2月,定位自身为智能计算架构的革新者,致力于通过创新的存算一体解决方案,为AI的广泛应用提供技术动力。目前苹芯已申请海内外专利40余项。存内计算的英文是"Processing in memory",缩写为PIM,苹芯科技的英文名"PIMCHIP"便由此而来。"苹芯"的"苹",即是PIM的谐音。

参考资料:国内首颗商用端侧28nm存算一体AI芯片发布,特定计算任务可节省90%能耗|钛媒体AGI_网易订阅。

PIMCHIP-S300

PIMCHIP-S300芯片是苹芯科技基于存算一体技术打造的多模态智慧感知决策AI芯片。其搭载基于SRAM的存算一体计算加速单元,让计算在存储器内部发生,有效减少计算过程中的数据搬运,使核心计算单元的能效产生几十上百倍的提升,达到国际领先指标并实现技术突破。芯片具备AI算力整合、多模态融合感知、跨领域智慧决策、超低功耗、极速响应等特点。PIMCHIP-S300可应用在智慧工业、智慧医疗、智能可穿戴设备等不同领域,致力于为合作伙伴提供高能效、小面积、低功耗、低成本的解决方案,为多元化应用场景智慧赋能。

PIMCHIP-S300系列芯片:基于存算一体技术开发,是一种高能效、小面积、低功耗且低成本的AI芯片。它集成轻量级MCU处理器,能够进行实时控制和调度,并支持音视频及多传感器接入,实现多模态融合感知。内置先进的数字PIM单元和自研异构架构,具备超低功耗唤醒、VAD、语音识别、运动监测和视觉识别等功能,能在特定计算任务中节约高达90%的能耗,其计算核心的能效比达到27TOPS/W。而通过"零搬运"数据处理机制显著提升运算效率同时降低能耗,用于智能可穿戴设备、具身智能、AI大模型等领域。

| Computing System | CPU | MCU with FPU/MAC for control panel,300 DMIPS |

|---|---|---|

| NPU | Neural Networks and CV Acceleration forcomputing panel. 0.5 Tops, support int4/8/16 | |

| DSP | Audio/Vision Signal processing andSensor fusion,100 GMAC | |

| VIdeo Subsystem | 2D Graphics | Scaler、Crop、Zoom、CSC,BlendingPreview stream, 240 * 160@24fps,up to 480 * 320Snapshot stream,Typical 720P |

| Video IN | 1 * DVP in, resolution up to 2560 * 1440,8 bits/Pixel,RGB565、YUV422、RGB888 | |

| Video Out | 4-Wire SPI out ; 240 * 160@24fps,up to 480 * 320,RGB888 | |

| Audio Subsystem | PDM | * 4 |

| I2S | * 2 | |

| HWA | VAD/FFT Accelerator | |

| AON Subsystem | Low Power | 100uW-5mW |

| Trigger | Customizable Voice,Adjustable Motion,Temperature,Voltage,Touch | |

| Storage | SRAM | support system SRAM, up to 1792KB |

| PSRAM | Up to 32MB | |

| Flash | support Nor-flash,up to 32Mb | |

| Others | Connectivities | UART * 4,SPI * 2,I2C * 4 |

| 2x SD HC support SDR104/DDR50 and SDIO3.0 eMMC 4.5 | ||

| Ethernet: Interface:MII/RMII/RGMIIData Rate:10Mbps/100Mbps/1000Mbps | ||

| Peripheral | DMA * 3,Timer * 4,RTC * 1,WDT * 5 | |

| ADC * 1 12bit@1MSPS,PWM * 3,GPIO * 40 | ||

| Security | support SM2/3/4/, AES ,SHA ,RSA ,TRNG,OTP | |

| Turnkey Solution | RTOS, Middleware,Model Zoo, One-click AI deployment solution, One-click binary generation and downloading solution |

它采用28nm制程、BGA封装、自研异构架构,12mm * 12mm大小,die做得很小,能满足更小型化的需求。

PIMCHIP-N300

PIMCHIP-N300:苹芯科技自主研发的新一代存算一体神经网络处理单元,专为机器学习和 AI 领域优化,支持混合精度计算,包括4bit、8bit整型和16bit浮点运算,实现功耗、算力密度和计算精度的平衡。N300提供了一套完整的开发工具,包括NPU中间表示层规范、模型解析器、优化器和驱动等,能根据不同场景或数据提供一键部署的解决方案,可显著缩短产品开发周期,满足客户需求。

PIMCHIP-N300是苹芯科技自研的新一代存算一体NPU(神经网络处理单元)IP,专为机器学习和AI领域设计,可内嵌到端侧芯片中,能以更高效率、更低能耗承担繁重的神经网络加速任务。PiMCHIP-N300采用软硬融合架构,充分考虑可扩展性,单核可提供0.5TOPS算力,系统功耗为25-100mW,典型场景下静态功耗仅10μW,支持混合精度计算,涵盖INT4/INT8/FP16精度,支持12大类超过100种算子,核心计算单元能效比达27TOPS/W,跑YOLO-V3 tiny网络的算力资源利用率达89.5%。

为了满足客户更自主、灵活的算法移植需求,苹芯科技根据客户定义的场景或数据,提供一键部署的端到端的解决方案,开放NPU中间表示层规范、模型解析器、模型优化器、驱动等,并提供免费的软件工具链,包括软件模拟器、调试器、C编译器,能够减少二次开发的时间。

-

算力

N300提供单核0.5TOPS算力,以及多个NPU核组成的Cluster集群架构。

-

精度

支持混合精度计算,支持整型的4bit、8bit以及浮点的16bit计算,更好地平衡功耗、算力密度和计算精度。

-

灵活性

高速任务调度加速单元,支持多核或者多个计算单元的实时任务调度。

-

兼容性

支持自定义算子,满足各种模型部署需求,并针对人声监听、眼动追踪、主动降噪、环境感知等应用场景提供了配置方案和专门优化。

-

软件与工具链

满足客户更自主、灵活的算法移植需求。开放NPU中间表示层规范、模型解析器、模型优化器、驱动等,提供免费的软件工具链,包括软件模拟器、调试器、C编译器。

-

支持网络

MobileNet, ResNet, Yolo-v2/v3, UNet, ShuffleNet, SqueezeNet, EfficientNet, LSTM以及可以拆解为以上算子组合的网络。

支持算子

| 算子名称 | 参数 |

|---|---|

| Conv | Kernel size: <=7x7内的任意形状 Stride: 1,2,3 Zero padding: 0~kernel size-1 |

| Depthwise | Kernel size:<=5x5内的任意形状 Stride: 1,2,3 Zero padding: 0~kernel size-1 |

| 转置卷积 | Kernel size: <=7x7内的任意形状 Stride: 1,2,3 Zero padding: kernel size-1 |

| FC | Channel size: 1~2048 |

| Pooling | Kernel size:1~15Type: max, avg, min |

| Concat | 只支持channel方向 |

| 双目运算符 | 算数运算:add,sub, mul, div, mod, avg 逻辑运算:or,and 比较运算:min,max,cmp,logic,sel,compsel |

| 单目运算符 | Log,exp,abs,not,sqrt,tanh |

| Reorg | HWC<->CHW |

| Upsampling | 最邻近插值,双线性插值 |

| 非线性 | Relu,p-relu,leaky-relu,relu6,softmax |

支持的网络

MobileNet, ResNet, Yolo-v2/v3, UNet, ShuffleNet, SqueezeNet, EfficientNet, LSTM以及可以拆解为以上算子组合的网络。

平头哥

含光800

含光800AI芯片是阿里巴巴第一款正式流片的芯片,主要应用于云端视觉处理场景,性能打破了现有AI芯片记录,性能及能效比全球第一。

含光800是平头哥发布的首颗数据中心芯片。含光800是一颗高性能人工智能推理芯片,基于12nm工艺, 集成170亿晶体管,性能峰值算力达820 TOPS。

含光800采用平头哥自研架构,通过软硬件协同设计实现性能突破。平头哥自主研发的人工智能芯片软件开发包,让含光800芯片在开发深度学习应用时可以获得高吞吐量和低延迟的高性能体验。含光800已成功应用在数据中心、边缘服务器等场景

性能方面,在业界标准的ResNet-50测试中,含光800推理性能达到78563 IPS,比目前业界最好的AI芯片性能高4倍;能效比500 IPS/W,是第二名的3.3倍;1颗含光800的算力相当于10颗GPU,目前基于含光800的AI云服务已在阿里云上线,相比传统GPU算力,性价比提升100%。

为了让用户便捷地使用含光800加速芯片,平头哥提供了HGAI (HanGuang Artificial Intelligence) 软件开发包,让用户在含光800芯片上部署深度学习应用时可以获得高吞吐量和低延迟的高性能体验。

HGAI 主要包括模型的前端Graph IR(intermediate representation) 转换、量化、编译和运行时等几部分。经过HGAI 转换、编译完成的模型可以很方便地集成到当前主流的深度学习推理框架中,让用户非常便捷地利用含光800芯片的强大算力加速推理运算。

目前HGAI 支持的主流深度学习框架主要有:TensorFlow、MXNet 、 Caffe、ONNX,后续将会支持更多主流深度学习框架。同时用户也可以通过NPUSMI来在线监控含光800运行状态,包括主频、内存利用率、算力利用率等。

英特尔

Gaudi® 2D AI

英特尔® Gaudi® 2D AI 加速器 大模型算力新选择,以开放的生态、更优的 TCO 和专注 AI 加速的芯片架构,为加速企业大模型落地提供算力新选择。

- 7 纳米制程工艺

- 24 个完全可编程的张量处理器核心 (TPC)

- 2 个矩阵乘法引擎 (MME)

- 96GB HBM2E 内存

- 48MB SRAM

- 2.4TB 总内存带宽

- 24 个 100 GbE 端口

它基于高效的第一代 Gaudi 架构构建,可在 AWS* EC2 DL1 云实例和 Supermicro Gaudi AI 训练服务器的本地提供高达 40% 的性价比提升。它将工艺从 16nm 缩小到 7nm,将 AI 定制的 Tensor 处理器内核数量从 8 个增加到 24 个,增加了 FP8 支持,并集成了媒体压缩引擎。Gaudi2 的封装内内存增加了两倍,达到 96 GB 的 HBM2e,带宽为 2.45 TB/s。与 NVIDIA* A100 80G 相比,这些进步在流行的计算机视觉和自然语言处理模型上提供了更高的吞吐量。

Habana 通过在每个 Gaudi2 上集成 24 个 100 Gb RDMA over Converged Ethernet (RoCE2) 端口,使客户能够经济高效且轻松地扩展训练容量,比第一代 Gaudi 的 10 个端口有所增加。每个 Gaudi2 上的 21 个端口专门用于以全对全、无阻塞的配置连接到服务器中的其他 7 个处理器。每个处理器上的三个端口专用于横向扩展,在 8 卡 Gaudi 服务器 HLS-Gaudi2 中提供 2.4 TB 的网络吞吐量。为了简化客户的系统设计,Habana 还提供了一个 8-Gaudi2 基板。通过在芯片上集成 RoCE,客户可以轻松扩展和配置 Gaudi2 系统,以满足其深度学习集群要求,从 1 个到 1000 个 Gaudi2。通过在行业标准以太网上实施系统,Gaudi2 使客户能够从各种以太网交换和网络设备中进行选择,从而进一步节省成本。网络接口控制器端口的片上集成减少了组件数量和总系统成本。

Gaudi2 与其前身一样,通过 Habana SynapseAI 软件套件为开发人员提供支持,该套件针对深度学习模型开发进行了优化,并简化了从基于 GPU 的模型到 Gaudi 硬件的迁移。它集成了 TensorFlow 和 PyTorch 框架以及 50+ 计算机视觉和自然语言处理参考模型。在 Habana GitHub 存储库上为开发人员提供了文档和工具、操作方法内容、社区论坛以及参考模型和模型路线图。开始模型迁移就像添加两行代码一样简单。对于编写自己的内核的专家用户,Habana 提供了完整的工具包。SynapseAI 支持在 Gaudi2 上训练模型,并在任何目标上对其进行推理,包括英特尔®至强®处理器、Habana Greco 或 Gaudi2 本身。SynapseAI 还与生态系统合作伙伴集成,例如带有 transformer 模型存储库和工具的 Hugging Face、Grid.ai Pytorch Lightning 和 cnvrg.io MLOps 软件。

天数智芯

智铠100

智铠100芯片支持FP32、FP16、INT8等多精度混合计算,实现了指令集增强、算力密度提升、计算存储再平衡,支持多种视频规格解码。智铠100系列加速卡基于通用GPU架构,支持多种视频规格解码、800+通用指令集、国内外主流深度学习开发框架,拥有丰富编程接口拓展和高性能函数库,可以灵活支持各种算法模型,便于客户自定义开发。兼容CUDA生态,支持市场主流生态,高达128路视频接入,单路视频性价比高灵活的编程能力,超强的性能及富有吸引力的性价比,为高性能计算和人工智能应用的开发和部署提供了便利。平均迁移时间相较市场主流产品下降50%以上,生态应用迁移迅速。

智铠100产品卡,可提供最高384TOPS@int8、96TFlops@FP16、24TFlops@FP32的峰值算力,800GB/s的理论峰值带宽以及128路并发的多种视频规格解码能力。相较于市场上现有主流产品,智铠100将提供2-3倍的实际使用性能。

天垓100

天垓100 芯片是GPGPU 架构,基于SIMT架构的可伸缩计算引擎,自主定义的丰富指令集支持GPU通用并行编程模型。内建FP32/FP16/BF16/INT多种数据类型指令,支持混合精度AI训练。CoWoS HBM2 7 纳米制程、容纳240亿晶体管,2.5D CoWoS封装,提供1.2TB/s超大带宽和32GB超大容量内存,给海量数据并行处理引擎提供充足的数据支持。主流生态兼容,支持主流的深度学习开发框架,兼容主流GPU的编程模式,有效对接现有软件生态,易于扩展支持新的算法与应用领域,帮助用户轻松实现无痛迁移。

| 架构 | GPGPU |

|---|---|

| 制程及封装 | TSMC 7nm FinFET 2.5D COWOS 封装 |

| 内存规格 | 32 GB DRAM (4*8GB) HBM2 |

| 散热规格 | 板级功耗250W 全高全长双槽位主被动式散热 |

| 接口规格 | PCIe Gen4.0 x 16 lane 共享 64 GB/s 主控双向带宽 共享 64 GB/s 片间互联带宽 |

| 性能 | 32 TFLOPS@FP32 128 TFLOPS@FP16 256 TOPS@INT8 |

奕斯伟

EIC7702X

奕斯伟智能计算SoC,采用64位乱序执行RISC-V处理器,搭载自研高能效NPU,支持H.264、H.265视频编解码标准,具备强大的音视频处理能力,芯片算力最高可达39.9TOPs。支持全栈浮点计算,全面加速生成式大模型,有效解决AI PC、工业视觉等行业的应用难题。产品可根据用户需求提供芯片、开发板或边缘智能站等多种形态,为客户在大语言模型、语音合成、图像/视频生成、文本生成等领域提供高效能智能计算解决方案。

EIC7702X是奕斯伟"77系列"的第二款产品,是一款高算力AI SoC,采用64位RISC-V处理器,搭配自主研发的高效神经网络计算单元(NPU),支持全栈浮点计算,全面加速生成式大模型。产品拥有丰富的外围扩展接口,同时具备强大的音视频处理能力,支持H.264、H.265等视频编解码标准,在AI智能设备、云端加速等领域具有超高的适应能力。

EIC7702X通过DIE-to-DIE互联技术,实现了40TOPS的算力,是前代产品EIC7700X的两倍。产品的技术创新与优化可以归纳为以下几点:

- 高性能CPU: 采用64位乱序执行RISC-V核C5P550,性能优于ARM-A76。

- 高算力****NPU: EIC7700X提供20TOPS算力,EIC7702X提供40TOPS算力。

- 数据精度: 支持FP16等数据精度,适合高精度应用。

- 内存支持: 支持LPDDR4/4X/6等不同接口,EIC7700X最大32GB,EIC7702X最大64GB,分别是64-Bit和128-bit。

- 低功耗: 采用12nm工艺,桌面应用下功耗仅为2.6瓦。

- 丰富外设: 集成视频编解码、3D GPU及多种外设。

- 编译器框架: 支持TensorFlow、PyTorch等多种框架,实现自动适配和优化。目前也在适配LLaMA2等其它模型。

摩尔线程

MTT S4000

摩尔线程大模型智算加速卡 MTT S4000,采用第三代 MUSA 架构,配备了 128 个 Tensor 核心,单卡支持 48GB 显存和 768GB/s 的显存带宽。基于摩尔线程自研 MTLink 技术,MTT S4000 可以支持多卡互联,支持千卡集群基础设施建设,加速千亿参数大语言模型计算。同时,MTT S4000 提供先进的图形渲染能力、视频编解码能力和超高清 8K HDR 显示能力,助力 AI 计算、图形渲染、多媒体等综合应用场景的落地。尤为重要的是,基于摩尔线程自研的全功能 GPU MUSA 生态架构,MTT S4000 可以充分兼容现有软件生态,实现代码零成本迁移到 MUSA 平台。

摩尔线程大模型训练平台,完全兼容 CUDA 和 Pytorch 训练系统,支持 Megatron-LM、DeepSpeed、FSDP 和 Colossal-AI 等大模型分布式训练框架。具有全兼容、高性能、高灵活性和简单易用等特点。支持 GPT 系列、LLaMA 系列、GLM 系列等常见大模型的一键千卡训练。使用夸娥千卡智算集群进行大模型训练,线性加速比可达91%以上。支持 Pytorch 用户自主研发,支持模型训练全监控、自动拉起、断点续训等功能。

摩尔线程新一代 Tensor Core,助力大语言模型 (LLM) 的训练、微调和推理计算。MTT S4000 共包含 8192 个 Vector Core,以及 128 个 Tensor Core。支持 FP64、FP32、TF32、FP16、BF16、INT8 等主流精度算力。

产品规格

| MUSA 核心 | 8192 |

|---|---|

| FP32 | 25 TFLOPS |

| TF32 Tensor | 50 TFLOPS |

| FP16 Tensor | 100 TFLOPS |

| INT8 Tensor | 200 TOPS |

| Texure Rate | 768 GTexels/s |

| Pixel Rate | 768 GPixels/s |

| 显存容量 | 48 GB |

| 显存带宽 | 768 GB/s |

| 尺寸 | 266 mm * 112 mm * 39 mm |

昆仑芯

二代AI芯片

这颗芯片基于 7nm 工艺打造,配备 GDDR6 高速显存,内存带宽可达 512GB / s,采用新一代昆仑芯 XPU-R 架构,通用性和性能显苦提升,可提供 256TOPS@INT8 以及 128 TFLOPS@FP16 算力。除此之外,这颗芯片还支持主流深度学习开发框架,例如 Tensorflow、Pytorch、PaddlePaddle 等;在典型感知模型的性能测试中,昆仑芯性能表现是业界主流方案的 2 倍。

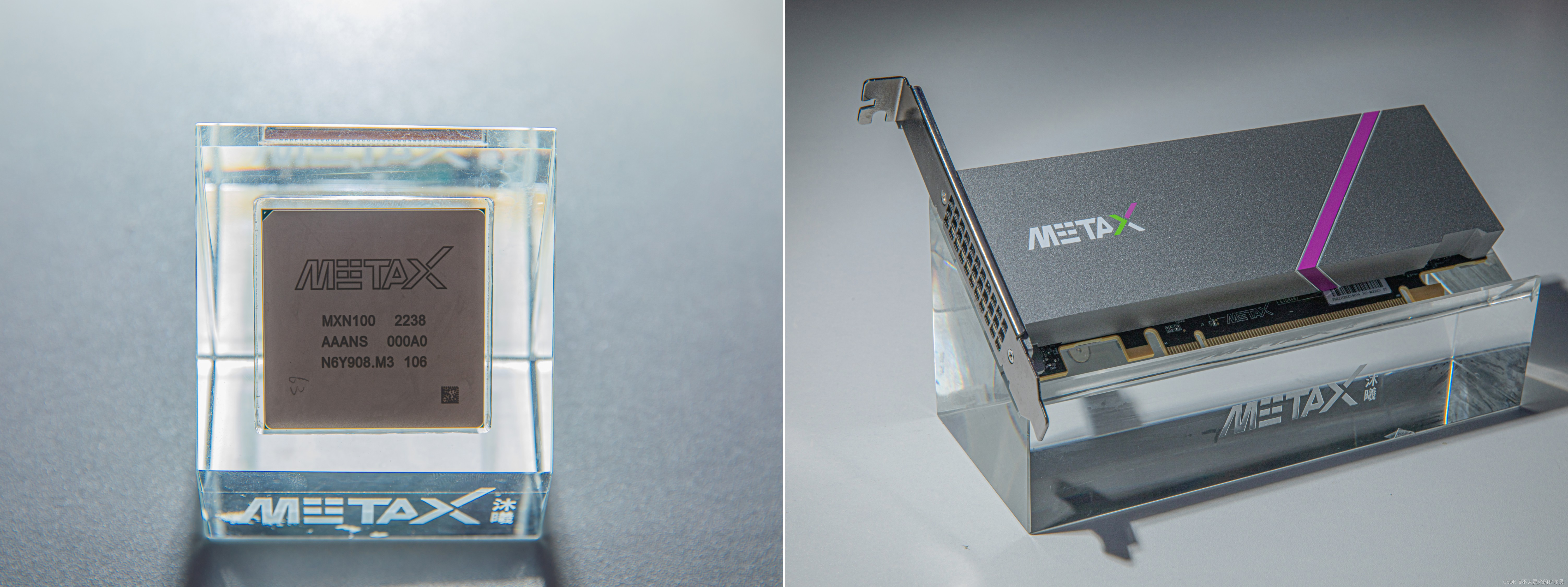

沐曦

羲云®C500(通用计算GPU)

曦云®C500基于自主研发的高性能GPU IP,具有强大的多精度混合算力、 64GB 大容量高带宽内存、先进的多卡互联技术、全兼容主流GPU生态的MXMACA®软件栈,特别适合千亿参数AI大模型的训练和推理;全面 兼容CUDA生态,实现用户零成本迁移;通过自主知识产权的MetaXLink实现 单机8卡GPU全互联,提供构建高密度算力和云计算部署的优秀国产GPU解决方案;可广泛应用于千亿参数AI大模型训练与推理、AIGC内容生成、推荐系统、自动语音识别、语音合成、图像分割检测,以及科学计算、数据库加速等多种场景。

| 产品代号 | 羲云®C500 PCIe | 羲云®C500 OAM |

|---|---|---|

| 算力 | FP32(vector):15TFLOPS FP32(matrix):30TFLOPS TF32: 120 TFLOPS FP16:240TFLOPS BF16:240 TFLOPS INT8:480 TOPS | FP32(vector):18TFLOPS FP32(matrix):36TFLOPS TF32: 140 TFLOPS FP16:280TFLOPS BF16:280 TFLOPS INT8:560 TOPS |

| 内容规格 | 64GBHBM2e,带宽18TB/s | 64GBHBM2e,带宽18TB/s |

| 视频/JPEG解码 | 160路1080p@30FPS | 160路1080p@30FPS |

| 视频/JPEG编码 | 12路1080p@30FPS | 12路1080p@30FPS |

| 互联 | MetaXLink 2卡4卡全互联 | MetaXLink 8卡全互联 |

| 虚拟化示例 | 1/2/4/8 | 1/2/4/8 |

| 功耗 | 350W | 450W |

曦思®N100(推理GPU)

曦思®N100是一款人工智能推理GPU,拥有 160TOPS AI峰值算力,及128路编码和96路解码超高密度视频处理能力;高速互联和多卡扩展等功能使其具有高带宽、低延时的属性,可应用与智慧交通、智慧安防、智能转码等人工智能领域。

算丰

算能 SC5(AI加速卡)

Al加速卡SC5搭载算丰AI处理器BM1684。是面向 AI推理的算力卡。可集成于服务器、工控机中,高效适配市场上所有AI算法实现视频结构化、人脸识别、行为分析、状态监测等应用,为智慧城市、智慧交通、智慧能源、智慧金融智慧电信、智慧工业等领域进行AI赋能。

算力:

- 支持52.8T的INT8 峰值算力

- 支持6.6T的FP32高精度算力

编解码和转码能力:

- 支持 114路1080P@25fps 高清视频硬件解码

- 支持 6路1080P@25fps 高清视频硬件编码

- 支持 54 路1080P至CIF 格式的视频流片上转码

算能 SC7(AI加速卡)

Al加速卡SC7是面向AI推理的算力卡可集成于服务器、工控机中,高效适配市场上所有AI算法实现视频结构化、人脸识别、行为分析、状态监测等应用,为智慧城市、智慧交通、智慧能源、智慧金融、智慧电信、智慧工业等领域进行AI赋能。

算力:

- 支持 256/96TOPS的INT8 峰值算力

- 支持128/48FLOPS的FP16/BF16 峰值算力

- 支持16/6TFLOPS的FP32高精度算力

编解码和转码能力:

- 支持 256/96路1080P@25fps高清视频硬件解码

- 支持96/36路1080P@25fps 高清视频硬件编码

英伟达V100、A100、H100横向对比

| 产品代号 | V100(NVLink) | A100(SXM) | H100(SXM) | A800(SXM) |

|---|---|---|---|---|

| FP64 | 7.8 TFLOPS | 9.7 TFLOPS | 34 TFLOPS | 9.7 TFLOPS |

| FP64 Tensor Core | - | 19.5 TFLOPS | 67 TFLOPS | 19.5 TFLOPS |

| TF32 | - | 156 TFLOPS/312 TFLOPS | 989 TFLOPS | 156 TFLOPS/312 TFLOPS |

| FP16 Tensor Core | - | 312 TFLOPS/624 TFLOPS | 1979 TFLOPS | 312 TFLOPS/624 TFLOPS |

| INT8 Tensor Core | - | 624 TOPS/1248 TOPS | 3958 TOPS | 624 TOPS/1248 TOPS |

| 显存 | 32/16GB HBM2 | 80GB HBM2 | 80GB | 80GB HBM2 |

| 显存带宽 | 900 GB/s | 1935 GB/s | 3.35TB/s | 2039 GB/s |

| 功耗 | 300W | 400W | 700W | 400W |

国产GPU横向对比

| 产品代号 | 寒武纪思元370 | 寒武纪思元290 | 昇腾910 | 燧原云燧T20/T21 | 海光DCU | 曦云C500 | 算能SC7 |

|---|---|---|---|---|---|---|---|

| FP64 | - | - | - | - | 11.5 TFLOPS | - | - |

| FP32 | 24 TFLOPS | - | - | 32 TFLOPS | - | 18 TFLOPS/36 TFLOPS | 6 TFLOPS/16 TFLOPS |

| TF32 | - | - | - | 128 TFLOPS | - | 140 TFLOPS | - |

| FP16 | 96 TFLOPS | - | 320TFLOPS | 128 TFLOPS | - | 280 TFLOPS | 48 TFLOPS/128 TFLOPS |

| BP16 | 96 TFLOPS | - | - | 128 TFLOPS | - | 280 TFLOPS | 48 TFLOPS/128 TFLOPS |

| INT16 | 128 TFLOPS | 256 TFLOPS | - | - | - | - | - |

| INT8 | 256 TOPS | 512 TOPS | 640 TOPS | 256 TOPS | - | 560 TOPS | 96 TOPS/256 TOPS |

| 显存 | 24GB LPDDR5 | 32 HBM2 | - | 32 HBM2E | 32 HBM2E | 64 HBM2E | - |

| 显存带宽 | 307.2 GB/s | 1228 GB/s | - | 1.6 TB/s | 1 TB/s | 1.8 TB/s | - |

| 功耗 | 150W | 350W | 310W | 300W | 260-350W | 450W | - |

参考资料:【智算中心】国产GPU横向对比_曦云c500-CSDN博客。

主流先进制程工艺梳理

28nm

由于性价比提升一直以来都被视为摩尔定律的核心意义,所以20nm以下制程的成本上升问题一度被认为是摩尔定律开始失效的标志,而28nm作为最具性价比的制程工艺,具有很长的生命周期。

在设计成本不断上升的情况下,只有少数客户能负担得起转向高级节点的费用。据Gartner统计,16nm /14nm芯片的平均IC设计成本约为8000万美元,而28nm体硅制程器件约为3000万美元,设计7nm芯片则需要2.71亿美元。IBS的数据显示:28nm体硅器件的设计成本大致在5130万美元左右,而7nm芯片需要2.98亿美元。对于多数客户而言,转向16nm/14nm的FinFET制程太昂贵了。

就单位芯片成本而言,28nm优势明显,将保持较长生命周期。一方面,相较于40nm及更早期制程,28nm工艺在频率调节、功耗控制、散热管理和尺寸压缩方面具有明显优势。另一方面,由于16nm/14nm及更先进制程采用FinFET技术,维持高参数良率以及低缺陷密度难度加大,每个逻辑闸的成本都要高于28nm制程的。

28nm处于32nm和22nm之间,业界在更早的45nm阶段引入了high-k值绝缘层/金属栅极(HKMG)工艺,在32nm处引入了第二代 high-k 绝缘层/金属栅工艺,这些为28nm的逐步成熟打下了基础。而在之后的先进工艺方面,从22nm开始采用FinFET(鳍式场效应晶体管)等。可见,28nm正好处于制程过渡的关键点上,这也是其性价比高的一个重要原因。

目前,行业内的28nm制程主要在台积电,GF(格芯),联电,三星和中芯国际这5家之间竞争,另外,2018年底宣布量产联发科28nm芯片的华虹旗下的华力微电子也开始加入竞争行列。

虽然高端市场会被 7nm、10nm以及14nm/16nm工艺占据,但40nm、28nm等并不会退出。如28nm~16nm工艺现在仍然是台积电营收的重要组成部分,特别是在中国大陆建设的代工厂,就是以16nm为主。中芯国际则在持续提高28nm良率。

16/14nm

14nm制程主要用于中高端AP/SoC、GPU、矿机ASIC、FPGA、汽车半导体等制造。对于各厂商而言,该制程也是收入的主要来源,特别是英特尔,14nm是其目前的主要制程工艺,以该公司的体量而言,其带来的收入可想而知。而对于中国大陆本土的晶圆代工厂来说,特别是中芯国际和华虹,正在开发14nm制程技术,距离量产时间也不远了。

目前来看,具有或即将具有14nm制程产能的厂商主要有7家,分别是:英特尔、台积电、三星、格芯、联电、中芯国际和华虹。

同为14nm制程,由于英特尔严格追求摩尔定律,因此其制程的水平和严谨度是最高的,就目前已发布的技术来看,英特尔持续更新的14nm制程与台积电的10nm大致同级。

今年5月,英特尔称将于第3季度增加14nm制程产能,以解决CPU市场的缺货问题。

然而,英特尔公司自己的14nm产能已经满载,因此,该公司投入15亿美元,用于扩大14nm产能,预计可在今年第3季度增加产出。其14nm制程芯片主要在美国亚利桑那州及俄勒冈的D1X晶圆厂生产,海外14nm晶圆厂是位于爱尔兰的Fab 24,目前还在升级14nm工艺。

三星方面,该公司于2015年宣布正式量产14nm FinFET制程,先后为苹果和高通代工过高端手机处理器。目前来看,其14nm产能市场占有率仅次于英特尔和台积电。

台积电于2015下半年量产16nm FinFET制程。与三星和英特尔相比,尽管它们的节点命名有所不同,三星和英特尔是14nm,台积电是16nm,但在实际制程工艺水平上处于同一世代。

2018年8月,格芯宣布放弃7nm LP制程研发,将更多资源投入到12nm和14nm制程。

格芯制定了两条工艺路线图:一是FinFET,这方面,该公司有14LPP和新的12LPP(14LPP到7LP的过渡版本);二是FD-SOI,格芯目前在产的是22FDX,当客户需要时,还会发布12FDX。

联电方面,其14nm制程占比只有3%左右,并不是其主力产线。这与该公司的发展策略直接相关,联电重点发展特殊工艺,无论是8吋厂,还是12吋厂,该公司会聚焦在各种新的特殊工艺发展上。

中芯国际方面,其14nm FinFET已进入客户试验阶段,2019年第二季在上海工厂投入新设备,规划下半年进入量产阶段,未来,其首个14nm制程客户很可能是手机芯片厂商。据悉,2019年,中芯国际的资本支出由2018年的18亿美元提升到了22亿美元。

华力微电子方面,在年初的SEMICON China 2019先进制造论坛上,该公司研发副总裁邵华发表演讲时表示,华力微电子今年年底将量产28nm HKC+工艺,2020年底将量产14nm FinFET工艺。

12nm

从目前的晶圆代工市场来看,具备12nm制程技术能力的厂商很少,主要有台积电、格芯、三星和联电。联电于2018年宣布停止12nm及更先进制程工艺的研发。因此,目前来看,全球晶圆代工市场,12nm的主要玩家就是台积电、格芯和三星这三家。

台积电的16nm制程经历了16nm FinFET、16FF+和16FFC三代,之后进入了第四代16nm制程技术,此时,台积电改变策略,推出了改版制程,也就是12nm技术,用以吸引更多客户订单,从而提升12吋晶圆厂的产能利用率。因此,台积电的12nm制程就是其第四代16nm技术。

格芯于2018年宣布退出10nm及更先进制程的研发,这样,该公司的最先进制程就是12nm了。该公司是分两条腿走路的,即FinFET和FD-SOI,这也充分体现在了12nm制程上,在FinFET方面,该公司有12LP技术,而在FD-SOI方面,有12FDX。12LP主要针对人工智能、虚拟现实、智能手机、网络基础设施等应用,利用了格芯在纽约萨拉托加县Fab 8的专业技术,该工厂自2016年初以来,一直在大规模量产格芯的14nm FinFET产品。

由于许多连接设备既需要高度集成,又要求具有更灵活的性能和功耗,而这是FinFET难以实现的,12FDX则提供了一种替代路径,可以实现比FinFET产品功耗更低、成本更低、射频集成更优。

三星方面,其晶圆代工路线图中原本是没有12nm工艺的,只有11nm LPP。不过,三星的11 LPP和格芯的12nm LP其实是"师出同门",都是对三星14nm改良的产物,晶体管密度变化不大,效能则有所增加。因此,格芯的12nm LP与三星的12nm制程有非常多的共同之处,这可能也是AMD找三星代工12nm产品的原因之一。

中芯国际方面,不仅14nm FinFET制程已进入客户风险量产阶段,而且在2019年第一季度,其12nm制程工艺开发进入客户导入阶段,第二代FinFET N+1研发取得突破,进度超过预期,同时,上海中芯南方FinFET工厂顺利建造完成,进入产能布建阶段。这意味着用不了多久,一个新的12nm制程玩家将杀入战团。

10nm

到了10nm这个节点,行业玩家就只剩下台积电、三星和英特尔了。

总的来说,台积电还是领先的,其典型产品就是2017年为苹果代工的A11处理器。而三星也紧跟步伐,在10nm这个点,双方的进度相差不大,但总体水平,台积电仍然略胜一筹。

今年,英特尔的老对手AMD打起了翻身仗,凭借台积电代工的7nm锐龙3000系列处理器,让AMD在CPU处理器的制程工艺上首次超越了英特尔。

而目前,英特尔的主流制程是14nm,不过,前不久传来消息,经过多年的攻关,该公司终于解决了10nm工艺的技术难题,已经开始量产。

不过,英特尔对制程节点的严谨追求是很值得称道的,从具体的性能指标,特别是PPA和晶体管密度来看,英特尔的10nm比台积电的10nm有优势。

7nm

在7nm,目前只有台积电和三星两家了,而且三星的量产时间相对于台积电明显滞后,这让三星不得不越过7nm,直接上7nm EUV,这使得像苹果、华为、AMD、英伟达这样的7nm制程大客户订单,几乎都被台积电抢走了。在这种先发优势下,台积电的7nm产能已经有些应接不暇。而在7nm EUV量产方面,台积电也领先了一步,代工的华为麒麟990已经商用,三星7nm EUV代工的高通新一代处理器也在生产当中,估计很快就会面市了。

英特尔方面,在10nm之后,该公司称会在2021年推出7nm工艺,据悉,其7nm工艺已经走上正轨,功耗及性能看起来都非常好,根据之前的消息,7nm工艺会在2021年的数据中心GPU上首发。

参考资料:主流先进制程工艺梳理-电子头条-EEWORLD电子工程世界。

Intel、AMD、苹果与高通:AI 处理器对比

| 规格 | Core Ultra 7 268V | AMD Ryzen AI 9 HX 370 | Apple M4(10 核心) | Qualcomm Snapdragon X Elite X1E-84-100 |

|---|---|---|---|---|

| CPU | 最高 5.0 GHz(8 核心/8 线程 Lion Cove/Skymont) | 最高 5.1 GHz(12 核心/24 线程 Zen 5 和 Zen 5c) | 最高 4.4 GHz(10 核心/10 线程 ARMv9) | 最高 3.8 GHz(12 核心/12 线程 Oryon) |

| GPU | 最高 2.00 GHz(8 核心 Xe2) | 最高 2.9 GHz(16 核心 AMD Radeon 890M) | 最高 1.4 GHz(10 核心 Apple M4 GPU) | 最高 1.5 GHz(Qualcomm Adreno X1) |

| NPU | 48 TOPS INT8 | 50 TOPS INT8 | 38 TOPS INT8 | 45 TOPS INT8 |

| 热设计功耗(TDP) | 17-30 W | 28 W | 22 W | 23 W |

| 工艺节点 | 3 nm | 4 nm | 3 nm | 4 nm |

| 架构 | x86 | x86 | ARM | ARM |

| AI 功能 | Windows Copilot Runime | Windows Copilot Runime | Apple Intelligence | Windows Copilot Runime |

参考资料:AI CPU 如何选择?对比 Intel、AMD 与苹果和高通 - 系统极客。

参考资料

- 中国AI算力芯片独角兽有哪些 除了已经上市的 寒武纪 , 海光信息 , 景嘉微 (GPU), 芯原股份 ,黑芝麻(港股上市)等几家AI芯片公司之外。目... - 雪球

- 2024全球AI芯片峰会收官:架构创新群雄混战,边端较劲大模型,两大榜单公布|ai芯片_新浪财经_新浪网

- 7纳米、14纳米、28纳米芯片制造工艺市场价值对比_手机新浪网

- 台积电南京扩产惹争议:28纳米芯片制造"黄金线"之辩_腾讯新闻

- 一枚芯片的实际成本是多少? | 雷峰网

- 国内研发一颗芯片到底要多少钱?小米有苦难言_nm

- 3nm芯片成本近6亿美元,贵在哪里?-格隆汇

- AI CPU 如何选择?对比 Intel、AMD 与苹果和高通 - 系统极客

- 1.3万字详解半导体先进封装行业现状及发展趋势! 导 读 在以人工智能、高性能计算为代表的新需求驱动下,先进封装应运而生,发展趋势是小型化、高集成度,历经直插型封装、表面... - 雪球。

- 主流先进制程工艺梳理-电子头条-EEWORLD电子工程世界